Ваш город: Москва

Обзор и тестирование супервидеокарты NVIDIA TITAN X: демонстрация превосходства

Предисловие

Предыдущая версия элитной видеокарты NVIDIA GeForce GTX TITAN X 12 Гбайт была выпущена в марте 2015 года и основывалась на графическом процессоре GM200 архитектуры Maxwell 2.0. В то время новинка отличалась колоссальным для игровых видеокарт объёмом видеопамяти, очень высокой производительностью и стоимостью ($999). Тем не менее, залихватская удаль GeForce GTX TITAN X поугасла уже спустя три месяца, когда публике была представлена столь же быстрая в играх GeForce GTX 980 Ti по куда более приемлемой стоимости ($649).

Похоже, что NVIDIA решила повторить этот путь анонсов в линейке топовых графических решений, который можно выразить последовательностью «GeForce GTX 980 –> GeForce TITAN X –> GeForce GTX 980 Ti», только теперь видеокарты основаны на ядрах GP104/102 архитектуры Pascal и выпускаются по 16-нм техпроцессу. C первой видеокартой – NVIDIA GeForce GTX 1080 – мы уже познакомились, как и с её оригинальными версиями. Теперь пришло время изучить самую новую и феноменально производительную видеокарту NVIDIA TITAN X.

Новинка стала стоить на 200 долларов дороже своей предшественницы – $1200, и, разумеется, по-прежнему позиционируется, как профессиональная видеокарта для исследований и глубинного обучения. Но, как вы наверняка понимаете, нас в первую очередь интересует её производительность в игровых приложениях и графических бенчмарках, поскольку все геймеры с нетерпением ждут анонса GeForce GTX 1080 Ti, последние признаки которого уже лишили сна особо явных адептов компании. Тем не менее, сегодня мы проверим NVIDIA TITAN X и в отдельных вычислительных бенчмарках, чтобы убедиться в её состоятельности в качестве профессиональной видеокарты.

1. Обзор супервидеокарты NVIDIA TITAN X 12 Гбайт

технические характеристики видеокарты и рекомендованная стоимость

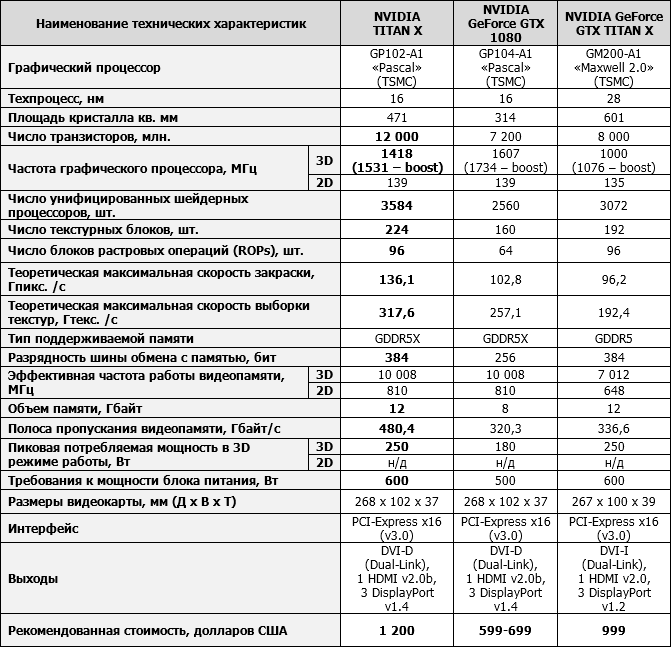

Технические характеристики и стоимость видеокарты NVIDIA TITAN X приведены в таблице в сравнении с эталонными NVIDIA GeForce GTX 1080 и старой версией GeForce GTX TITAN X.

упаковка и комплектация

Выпуск TITAN X компания NVIDIA оставила строго за собой, поэтому упаковка видеокарты стандартная: компактная коробка, открывающаяся вверх, и вставленная в её центр видеокарта в антистатическом пакете.

В комплекте поставки ничего нет, хотя один дополнительный отсек внутри есть. Напомним, что рекомендованная стоимость NVIDIA TITAN X составляет 1200 долларов США.

дизайн и особенности печатной платы

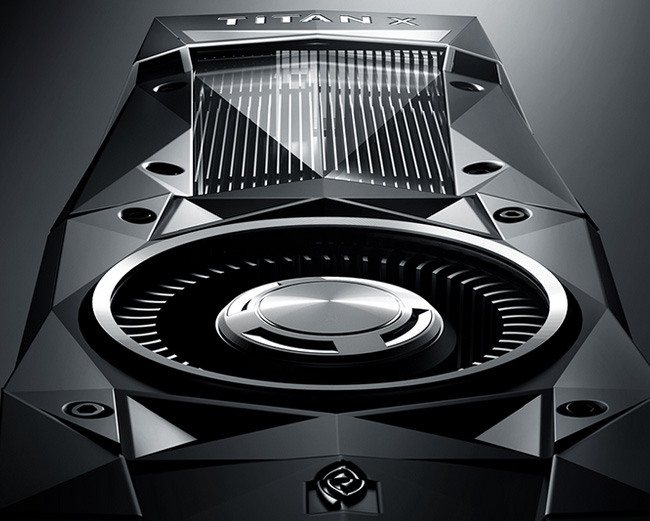

Дизайн новой NVIDIA TITAN X стал более дерзким или даже можно сказать агрессивным, нежели дизайн GeForce GTX TITAN X. Кожух системы охлаждения с лицевой стороны видеокарты наделили дополнительными гранями, бликующими под лучами света, а заднюю часть текстолита закрыли рифлёной крышкой, выполненной из металла.

Вкупе с хромированным ротором вентилятора и такой же надписью на лицевой стороне, выглядит видеокарта действительно стильно и привлекательно. Отметим, что на верхнем торце NVIDIA TITAN X оставлены светящиеся символы «GEFORCE GTX», хотя в самом названии видеокарты их уже нет.

Длина эталонной видеокарты составляет стандартные 268 мм, высота – 102 мм, а толщина – 37 мм.

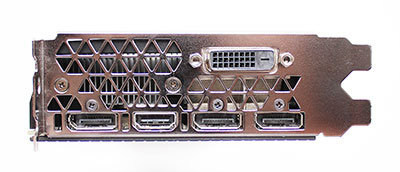

Видеовыходы на дополнительно перфорированной треугольными отверстиями панели, следующие: DVI-D, три DisplayPort версии 1.4 и один HDMI версии 2.0b.

В этом плане у новинки никаких изменений в сравнении с GeForce GTX 1080 нет.

Для создания разнообразных SLI-конфигураций на видеокарте предусмотрены два разъёма. Поддерживаются 2-way, 3-way и 4-way SLI варианты объединения видеокарт с использованием как новых жёстких соединительных мостиков, так и старых гибких.

Если эталонная GeForce GTX 1080 имеет только один восьмиконтактный разъём для дополнительного питания, то TITAN X получила в дополнение ещё и шестиконтактный разъём, что не удивительно, ведь заявленный уровень энергопотребления видеокарты составляет 250 ватт, как и у предшествующей ей модели GeForce GTX TITAN X. Мощность рекомендованного блока питания для системы с одной такой видеокартой должна составлять не менее 600 ватт.

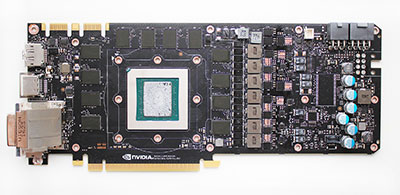

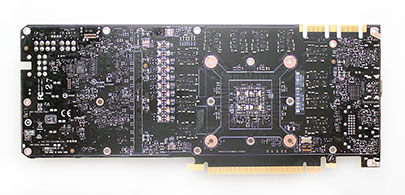

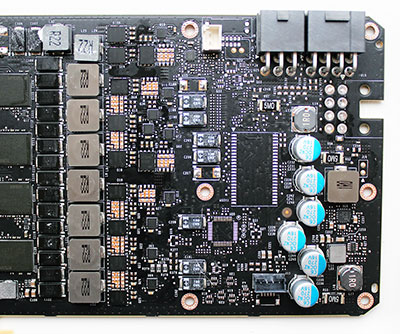

Эталонная печатная плата NVIDIA TITAN X намного сложнее чем плата GeForce GTX 1080, что вполне логично, учитывая возросшие требования по питанию, увеличенный объём видеопамяти и более широкую шину обмена с ней.

Система питания графического процессора пятифазная с использованием силовых элементов Dr.MOS и тантал-полимерных конденсаторов. Ещё две фазы питания отведены на видеопамять.

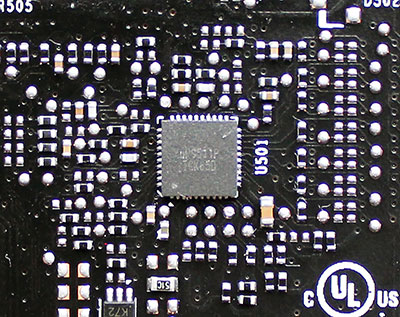

За управление питанием графического процессора отвечает контроллер uP9511P производства uPI Semiconductor.

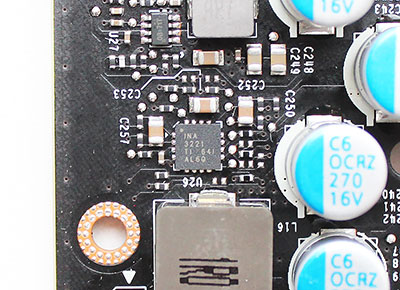

Обеспечение функций мониторинга осуществляет контроллер INA3221 производства Texas Instruments.

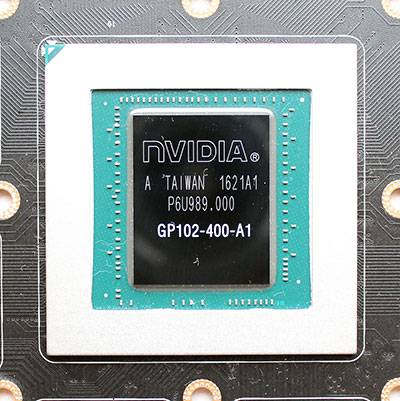

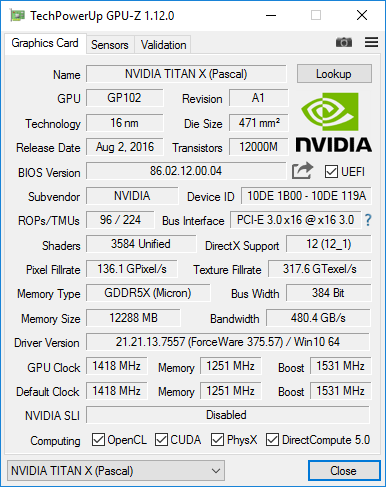

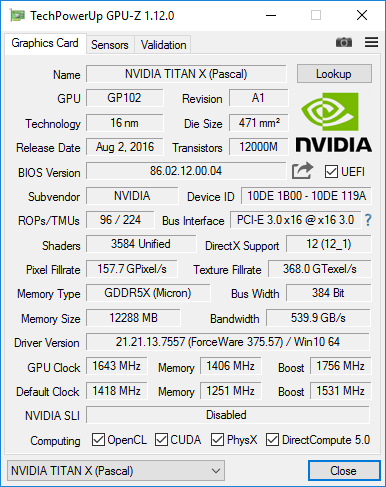

Выполненный по 16-нм нормам, кристалл графического процессора GP102 имеет площадь 471 мм2, выпущен на 21-й неделе 2016 года (конец мая) и относится к ревизии А1.

Не считая архитектурных улучшений линейки GPU Pascal, в сравнении с графическим процессором GM200 видеокарты NVIDIA GeForce GTX TITAN X в новом GP102 содержатся на 16,7% больше универсальных шейдерных процессоров, а их общее количество равно 3584. Преимущество по этому показателю над GP104 видеокарты GeForce GTX 1080 составляет впечатляющие 40%. Такой же расклад и по числу текстурных блоков, которых у нового TITAN X 224 штуки. Дополняют количественные показатели GP102 96 блоков растровых операций (ROPs).

Частоты графического процессора также выросли. Если у GeForce GTX TITAN X базовая частота GPU в 3D-режиме составляла 1000 МГц и могла форсироваться до 1076 МГц, то у новой TITAN X базовая частота равна 1418 МГц (+41,8%), а заявленная boost-частота – 1531 МГц. На деле, по данным мониторинга, частота графического процессора кратковременно возрастала до 1823 МГц, а в среднем составила 1823 МГц. Это очень серьёзный прирост в сравнении с предшественником. Добавим, что при переходе в 2D-режим частота графического процессора снижается до 139 МГц с одновременным снижением напряжения с 1,050 В до 0,781 В.

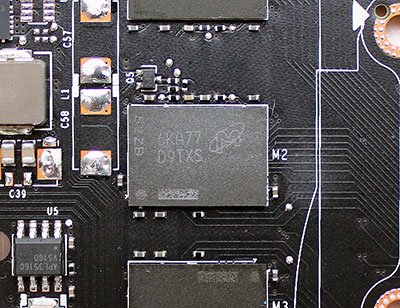

NVIDIA TITAN X оснащается 12 Гбайт памяти стандарта GDDR5X, набранными двенадцатью микросхемами производства компании Micron (маркировка 6KA77 D9TXS), распаянными только на лицевой стороне печатной платы.

В сравнении с предшествующей GeForce GTX TITAN X на GM200, частота памяти новой TITAN X на GP102 составляет 10008 МГц, то есть на 42,7% выше. Таким образом при не изменившейся ширине шины обмена с памятью, составляющей 384 бит, пропускная способность памяти TITAN X достигает внушительных 480,4 Гбайт/с, что лишь чуть меньше нынешнего рекордсмена в этой области – AMD Radeon R9 Fury X с её высокоскоростной HBM и 512 Гбайт/с. В 2D-режиме частота памяти снижается до 810 эффективных мегагерц.

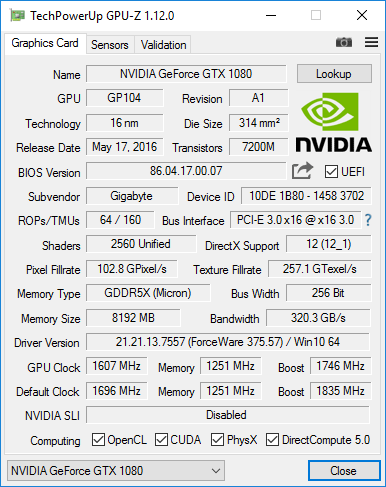

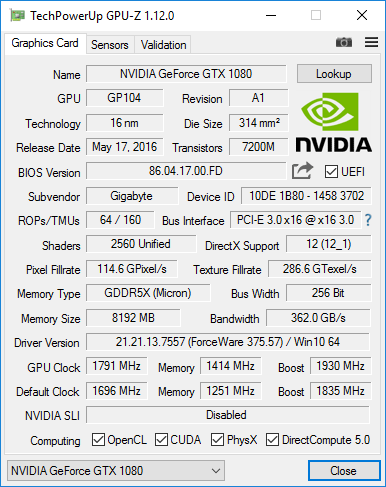

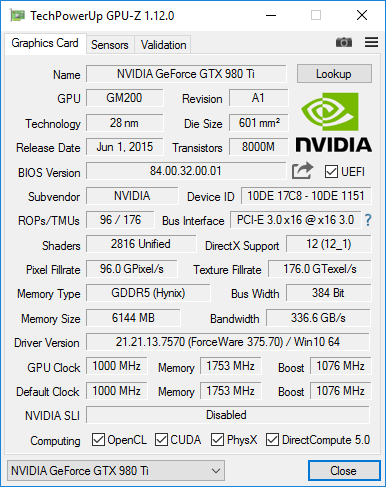

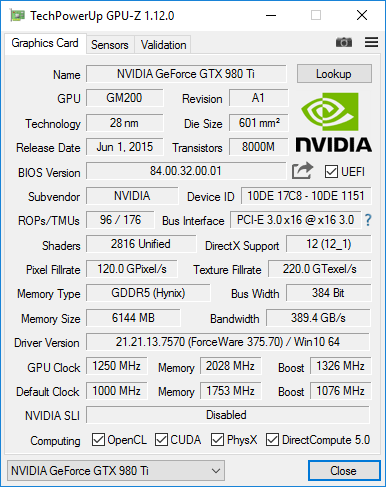

Итог обзору аппаратной части новой видеокарты подведёт информация из утилиты GPU-Z.

Выкладываем мы и BIOS видеокарты, считанный и сохранённый с помощью этой же утилиты.

система охлаждения – эффективность и уровень шума

Система охлаждения NVIDIA TITAN X идентична кулеру NVIDIA GeForce GTX 1080 Founders Edition.

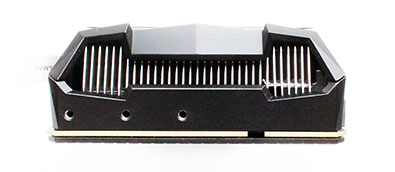

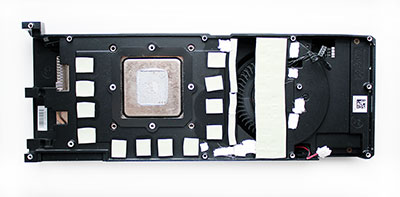

В её основе лежит никелированный алюминиевый радиатор с медной испарительной камерой в основании, который отвечает за охлаждение графического процессора.

По площади этот радиатор небольшой, а межрёберное расстояние не превышает двух миллиметров.

Таким образом не трудно предположить, что эффективность охлаждения графического процессора этим радиатором будет серьёзно зависима от скорости вращения вентилятора (что, собственно, и подтвердилось далее).

На охлаждение микросхем памяти и элементов силовых цепей отведена металлическая пластина с термопрокладками.

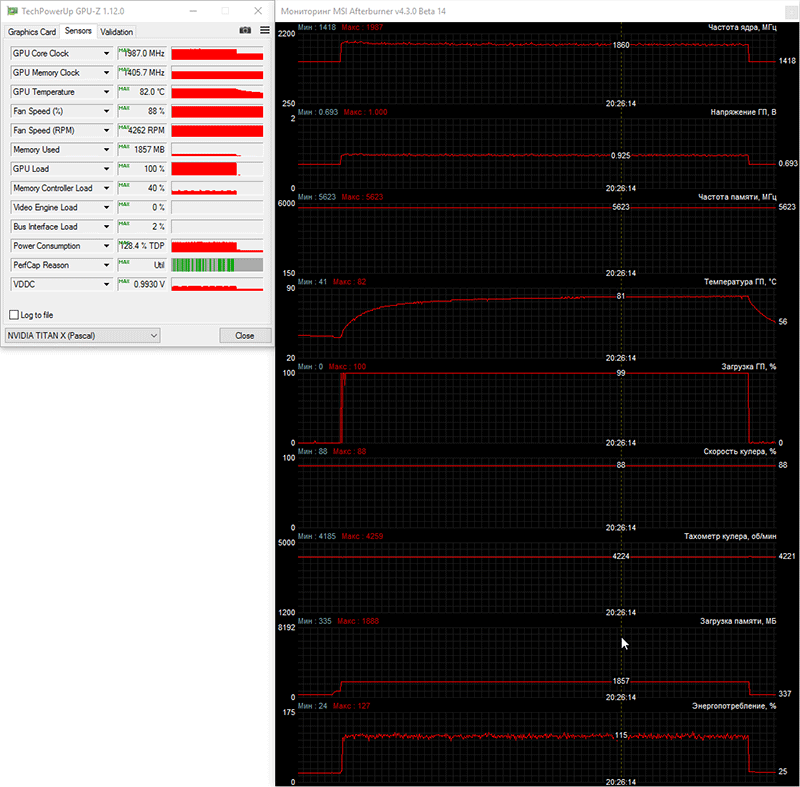

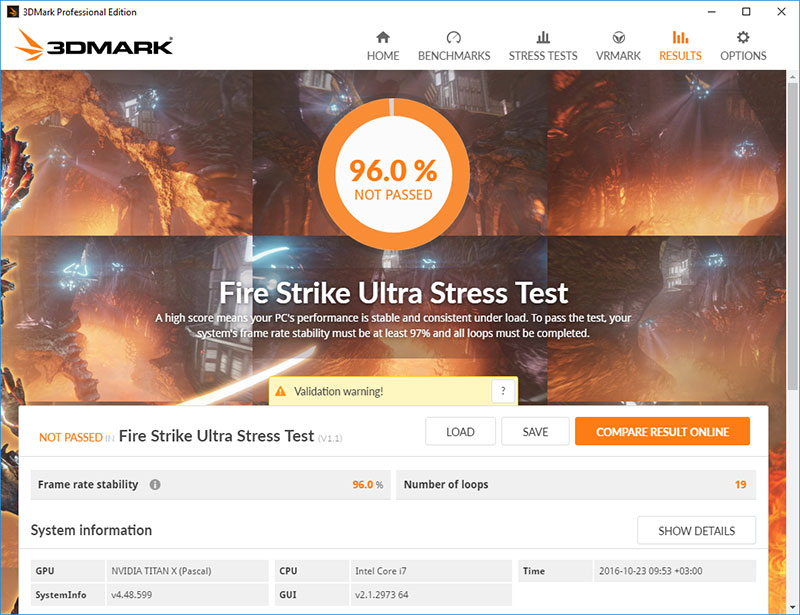

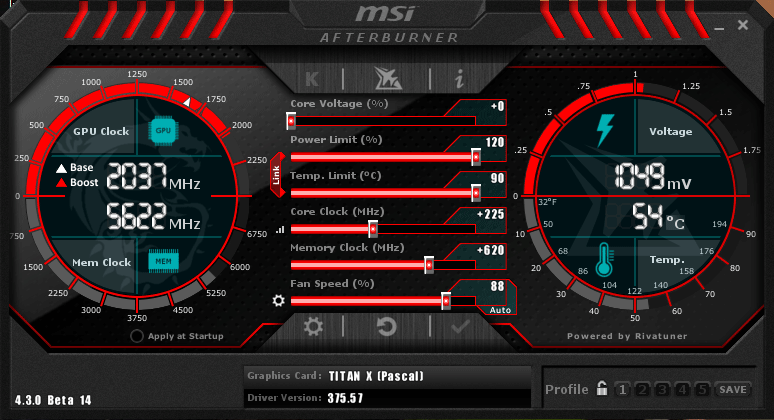

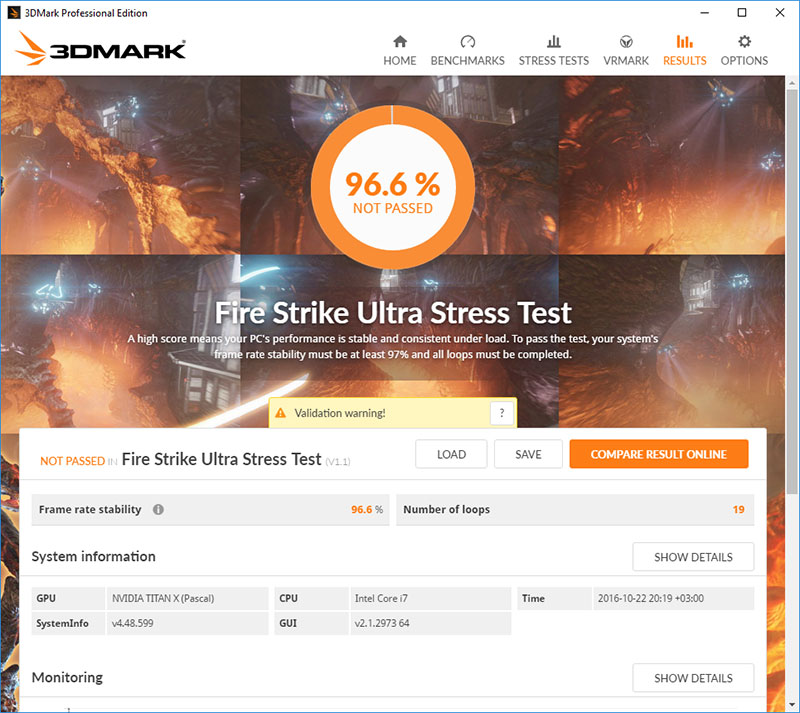

Для проверки температурного режима работы видеокарты в качестве нагрузки мы использовали девятнадцать циклов стресс-теста Fire Strike Ultra из пакета 3DMark.

Для мониторинга температур и всех прочих параметров применялась программа MSI Afterburner версии 4.3.0 Beta 14 и новее, а также и утилита GPU-Z версии 1.12.0. Тесты проводились в закрытом корпусе системного блока, конфигурацию которого вы сможете увидеть в следующем разделе статьи, при комнатной температуре 23,5~23,9 градусов Цельсия.

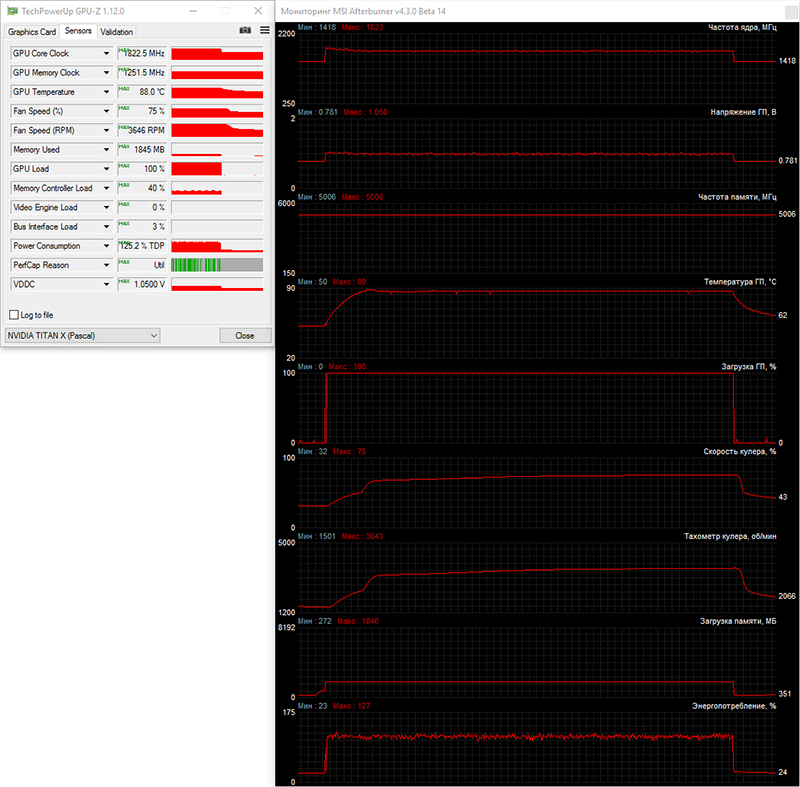

Прежде всего мы проверили эффективность охлаждения NVIDIA TITAN X и её температурный режим при полностью автоматической регулировке скорости вентилятора.

Как видим по графику мониторинга, температура графического процессора видеокарты NVIDIA TITAN X очень быстро добралась до отметки 88-89 градусов Цельсия, а затем, благодаря сравнительно резкому повышению скорости вентилятора с 1500 до 3500 об/мин, стабилизировалась на отметке 86 градусов Цельсия. Далее по ходу теста скорость вращения вентилятора ещё увеличилась до 3640 об/мин. Вряд ли кто из нас с вами ожидал от эталонной видеокарты с тепловым пакетом 250 ватт иных температурных показателей, которые практически не отличаются от GeForce GTX TITAN X.

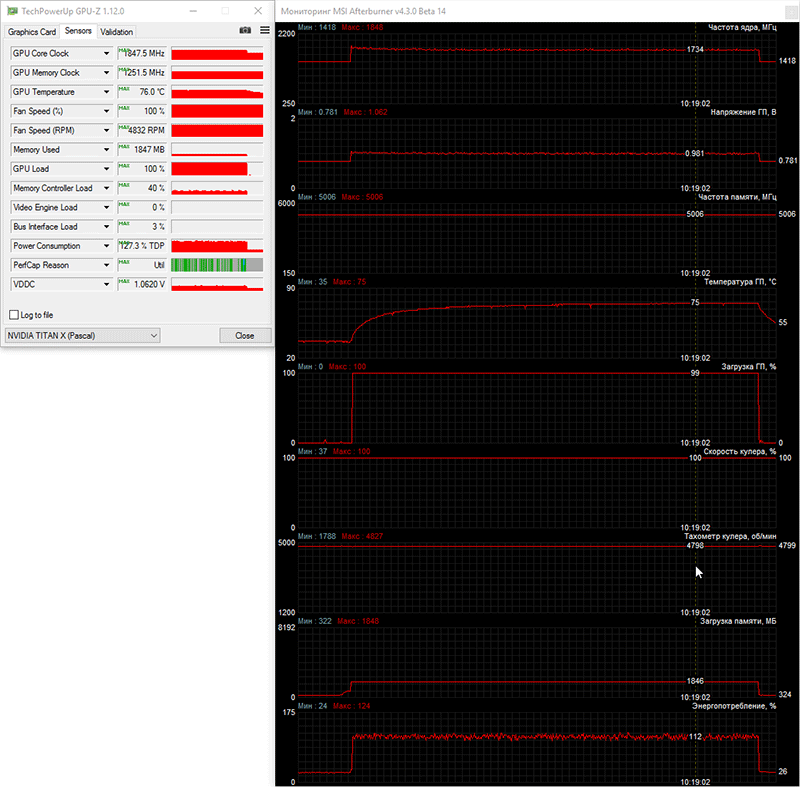

При максимальной скорости вентилятора температура графического процессора видеокарты NVIDIA TIAN X снижается на 12-13 градусов Цельсия в сравнении с режимом автоматической регулировки.

В обоих режимах работы вентилятора NVIDIA TITAN X является очень шумной видеокартой. К слову, NVIDIA не лишает владельцев этой модели видеокарты гарантии при замене эталонного кулера на альтернативные варианты.

оверклокерский потенциал

При проверке оверклокерского потенциала NVIDIA TITAN X мы увеличили предел по питанию на максимально возможные 120%, температурный предел повысили до 90 градусов Цельсия, а скорость вентилятора вручную зафиксировали на 88% мощности или 4260 об/мин. Спустя несколько часов тестов, удалось выяснить, что без потери стабильности и появления дефектов изображения базовую частоту графического процессора можно увеличить на 225 МГц (+15,9%), а эффективную частоту видеопамяти – на 1240 МГц (+12,4%).

В результате частоты разогнанной NVIDIA TITAN X в 3D-режиме составили 1643-1756/11248 МГц.

Ввиду значительного разброса частот GPU во время теста температурного режима разогнанной видеокарты, тест из пакета 3DMark вновь рапортовал о нестабильности TITAN X.

Несмотря на данный факт, все 19 циклов этого теста, а также все игры тестового набора были успешно пройдены, а по данным мониторинга частота ядра разогнанной видеокарты увеличивалась вплоть до 1987 МГц.

С учётом разгона эталонной NVIDIA TITAN X можно предположить, что оригинальные GeForce GTX 1080 Ti будут разгоняться ещё лучше. Впрочем, время покажет.

2. Тестовая конфигурация, инструментарий и методика тестирования

Тестирование видеокарт было проведено на системе следующей конфигурации:

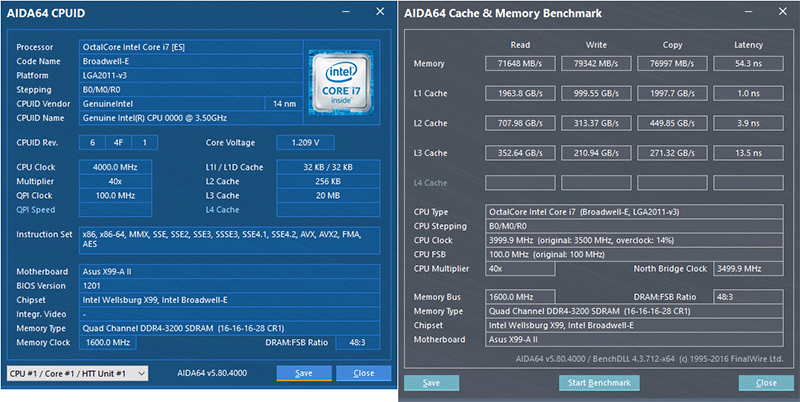

системная плата: ASUS X99-A II (Intel X99 Express, LGA2011-v3, BIOS 1201 от 11.10.2016);

центральный процессор: Intel Core i7-6900K (14 нм, Broadwell-E, R0, 3,2 ГГц, 1,1 В, 8 x 256 Kбайт L2, 20 Мбайт L3);

система охлаждения CPU: Phanteks PH-TC14PЕ (2 Corsair AF140, ~900 об/мин);

термоинтерфейс: ARCTIC MX-4 (8,5 Вт/(м*К));

оперативная память: DDR4 4 x 4 Гбайт Corsair Vengeance LPX 2800 МГц (CMK16GX4M4A2800C16) (XMP 2800 МГц/16-18-18-36_2T/1,2 В или 3000 МГц/16-18-18-36_2T/1,35 В);

видеокарты:

NVIDIA TITAN X 12 Гбайт 1418-1531(1848)/10008 МГц и с разгоном до 1643-1756(1987)/11248 МГц;

Gigabyte GeForce GTX 1080 G1 Gaming 8 Гбайт 1607-1746(1898)/10008 МГц и с разгоном до 1791-1930(2050)/11312 МГц;

NVIDIA GeForce GTX 980 Ti 6 Гбайт 1000-1076(1189)/7012 МГц и с разгоном до 1250-1326(1437)/8112 МГц;

диск для системы и игр: Intel SSD 730 480GB (SATA-III, BIOS vL2010400);

диск для бенчмарков: Western Digital VelociRaptor (SATA-II, 300 Гбайт, 10000 об/мин, 16 Мбайт, NCQ);

архивный диск: Samsung Ecogreen F4 HD204UI (SATA-II, 2 Тбайт, 5400 об/мин, 32 Мбайт, NCQ);

звуковая карта: Auzen X-Fi HomeTheater HD;

корпус: Thermaltake Core X71 (четыре be quiet! Silent Wings 2 (BL063) на 900 об/мин);

панель управления и мониторинга: Zalman ZM-MFC3;

блок питания: Corsair AX1500i Digital ATX (1500 Вт, 80 Plus Titanium), 140-мм вентилятор;

монитор: 27-дюймовый Samsung S27A850D (DVI, 2560 х 1440, 60 Гц).

Разумеется, прежних версий видеокарты TITAN X у нас остаться не могло, поэтому сравнивать новинку мы будем с двумя другими видеокартами, но вовсе не медленными. Первой из них будет оригинальная Gigabyte GeForce GTX 1080 G1 Gaming, которую мы протестировали на частотах эталонной NVIDIA GeForce GTX 1080, а также при разгоне до 1791-1930/11312 МГц.

Отметим, что пиковая частота графического процессора этой видеокарты при разгоне достигала отметки 2050 МГц.

Второй видеокартой тестирования является эталонная NVIDIA GeForce GTX 980 Ti, производительность которой мы протестировали как на номинальных частотах, так и при разгоне до 1250-1326(1437)/8112 МГц.

Поскольку при своём выходе GeForce GTX 980 Ti в играх продемонстрировала производительность, равную прежней GeForce GTX TITAN X, то такое сравнение вполне можно считать сравнением двух разных TITAN X. Добавим, что пределы по питанию и температуре на всех видеокартах были увеличены до максимально возможных, а в драйверах GeForce был выставлен приоритет максимальной производительности.

Для снижения зависимости производительности видеокарт от скорости платформы 14-нм восьмиядерный процессор при множителе 40, опорной частоте 100 МГц и активированной на третий уровень функции Load-Line Calibration был разогнан до 4,0 ГГц при повышении напряжения в BIOS материнской платы до 1,2095 В.

При этом 16 гигабайт оперативной памяти функционировали на частоте 3,2 ГГц с таймингами 16-16-16-28 CR1 при напряжении 1,35 В.

Тестирование, начатое 20 октября 2016 года, было проведено под управлением операционной системы Microsoft Windows 10 Professional со всеми обновлениями на указанную дату и с установкой следующих драйверов:

чипсет материнской платы Intel Chipset Drivers – 10.1.1.38 WHQL от 12.10.2016;

Intel Management Engine Interface (MEI) – 11.6.0.1025 WHQL от 14.10.2016;

драйверы видеокарт на графических процессорах NVIDIA – GeForce 375.57 WHQL от 20.10.2016.

Поскольку видеокарты в сегодняшнем тестировании весьма производительные, то от тестов в разрешении 1920 х 1080 пикселей было решено отказаться и использовалось только разрешение 2560 х 1440 пикселей. Разрешения ещё выше, к сожалению, имеющийся монитор не поддерживает. Впрочем, учитывая результаты в последних новинках, сожалеть о недоступности более высоких разрешений не приходится. Для тестов использовались два режима качества графики: Quality + AF16x – качество текстур в драйверах по умолчанию с включением анизотропной фильтрации уровня 16х и Quality + AF16x + MSAA 4х(8х) с включением анизотропной фильтрации уровня 16х и полноэкранного сглаживания степени 4x или 8x, в случаях, когда среднее число кадров в секунду оставалось достаточно высоким для комфортной игры. В отдельных играх, в силу специфики их игровых движков, были использованы иные алгоритмы сглаживания, что будет указано далее в методике и на диаграммах. Включение анизотропной фильтрации и полноэкранного сглаживания выполнялось непосредственно в настройках игр. Если же данные настройки в играх отсутствовали, то параметры изменялись в панели управления драйверов GeForce. Там же была принудительно отключена вертикальная синхронизация (V-Sync). Кроме указанного, никаких дополнительных изменений в настройки драйверов не вносилось.

Видеокарты были протестированы в одном графическом тесте, одном VR-тесте и пятнадцати играх, обновлённых до последних версий на дату начала подготовки материала. В сравнении с нашим предыдущим тестом видеокарт из тестового набора исключены старые и не ресурсоёмкие Thief и Sniper Elite III, но включены новые Total War: WARHAMMER и Gears of War 4 с поддержкой API DirectX 12 (теперь таких игр в наборе пять). Кроме того, в следующих статьях о видеокартах в списке появится ещё одна новая игра с поддержкой API DirectX 12. Так что, теперь список тестовых приложений выглядит следующим образом (игры и далее результаты тестирования в них расположены в порядке их официального выхода):

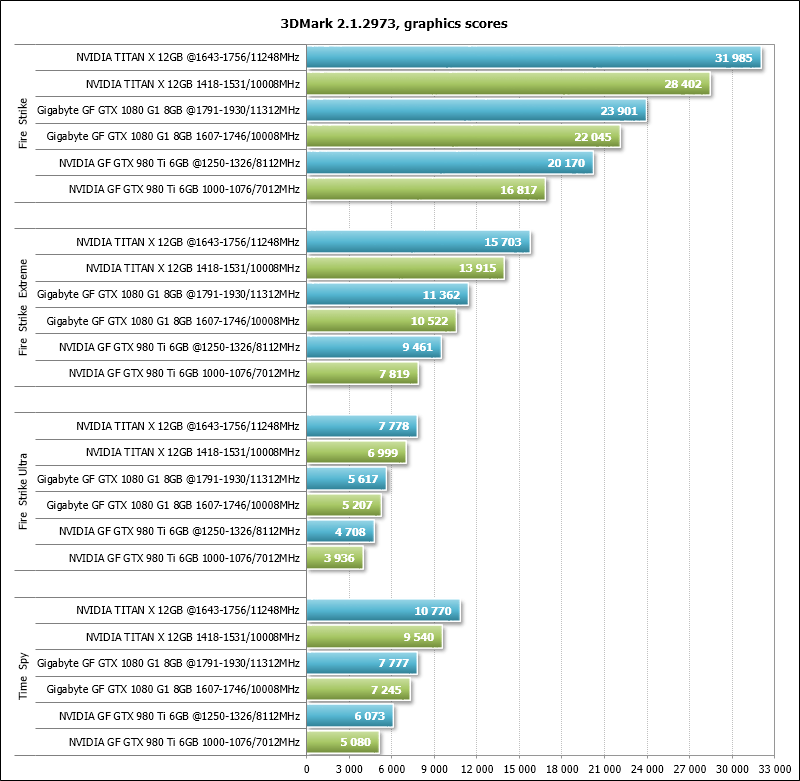

3DMark (DirectX 9/11) – версия 2.1.2973, тестирование в сценах Fire Strike, Fire Strike Extreme, Fire Strike Ultra и Time Spy (на диаграмме приведён графический балл);

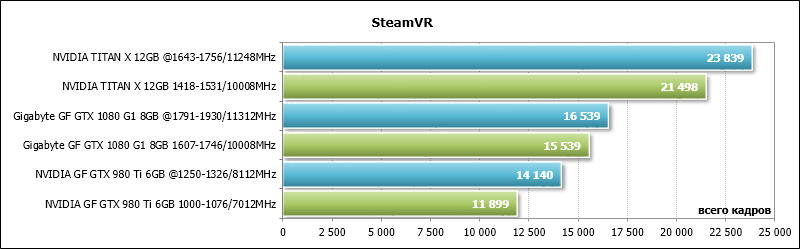

SteamVR – тест на поддержку «виртуальной реальности», за результат принималось число протестированных кадров за время теста;

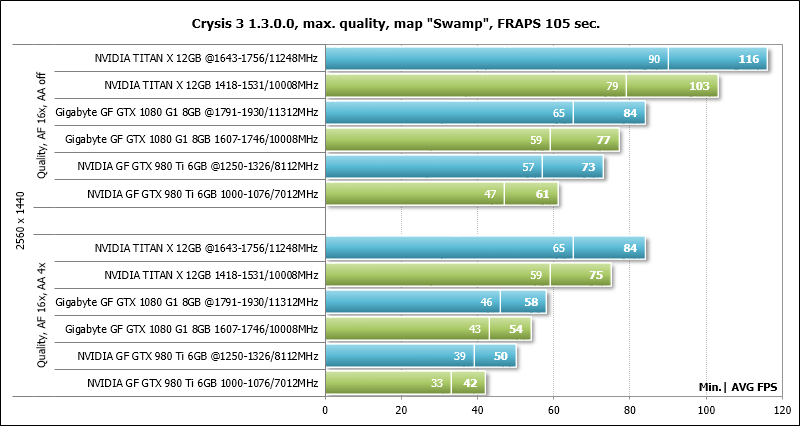

Crysis 3 (DirectX 11) – версия 1.3.0.0, все настройки качества графики на максимум, степень размытости средняя, блики включены, режимы с FXAA и с MSAA 4x, двойной последовательный проход заскриптованной сцены из начала миссии Swamp продолжительностью 105 секунд;

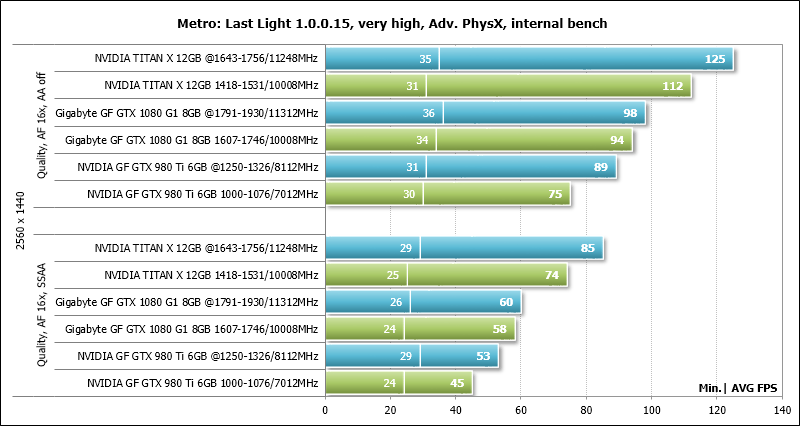

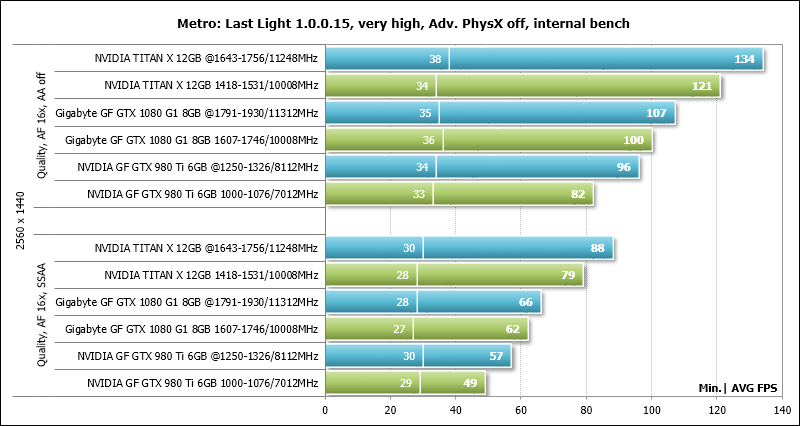

Metro: Last Light (DirectX 11) – версия 1.0.0.15, использовался встроенный в игру тест, настройки качества графики и тесселяция на уровне Very High, технология Advanced PhysX в двух режимах тестирования, тесты с SSAA и без сглаживания, двойной последовательный прогон сцены D6;

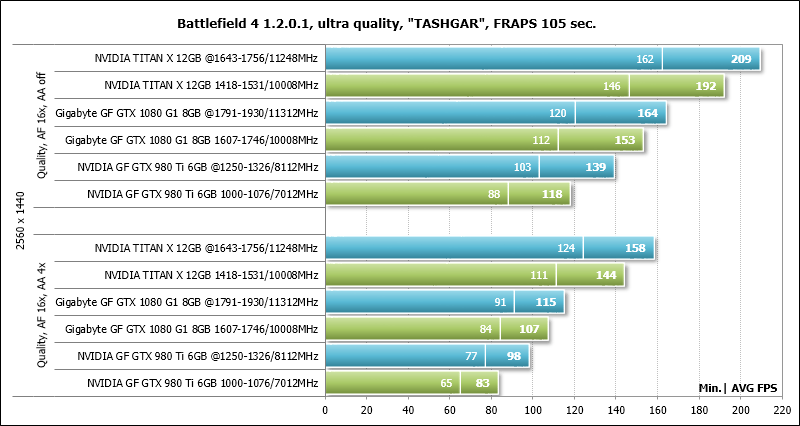

Battlefield 4 (DirectX 11) – версия 1.2.0.1, все настройки качества графики на Ultra, двойной последовательный прогон заскриптованной сцены из начала миссии TASHGAR продолжительностью 110 секунд;

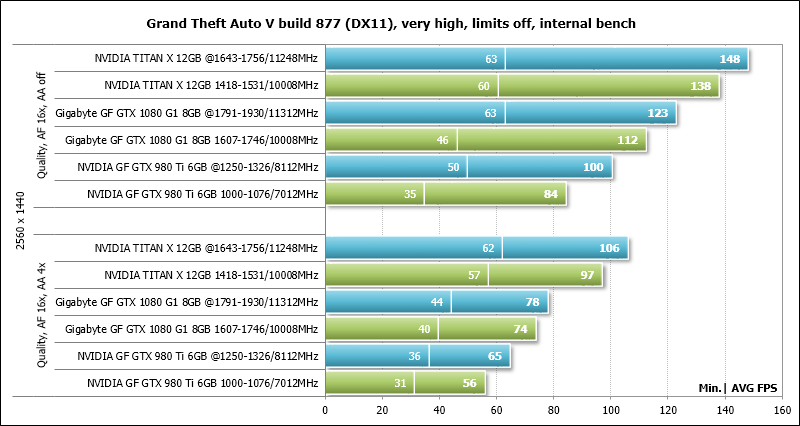

Grand Theft Auto V (DirectX 11) – build 877, настройки качества на уровне Very High, игнорирование предложенных ограничений включено, V-Synс отключена, FXAA активировано, NVIDIA TXAA выключено, MSAA для отражений выключено, мягкие тени NVIDIA;

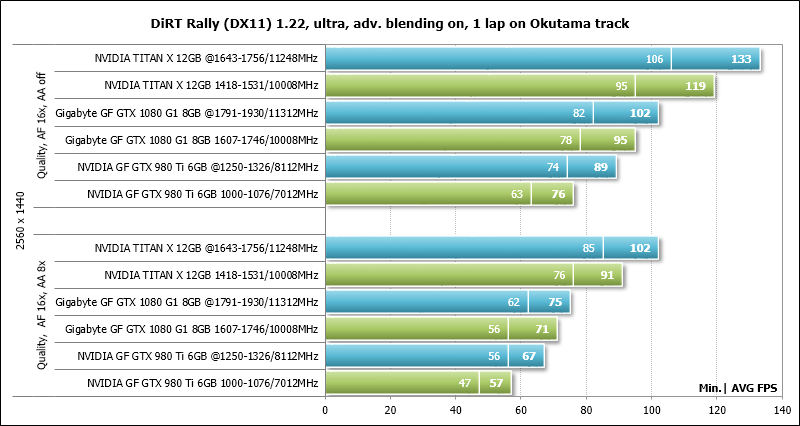

DiRT Rally (DirectX 11) – версия 1.22, использовался встроенный в игру тест на трассе Okutama, настройки качества графики на максимальный уровень по всем пунктам, Advanced Blending – On; тесты с MSAA 8x и без сглаживания;

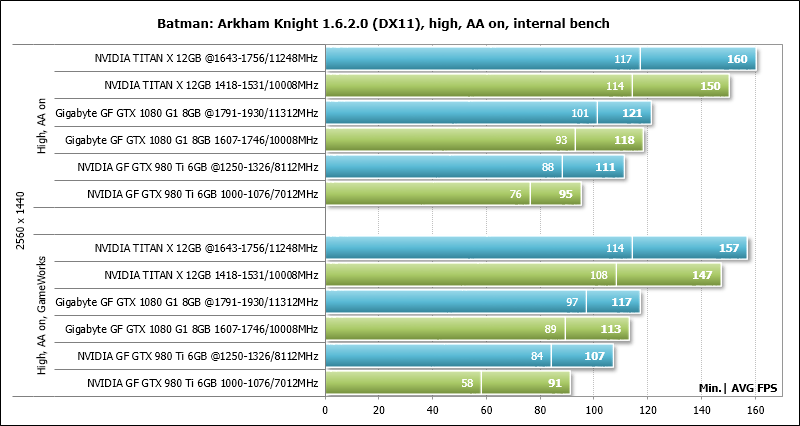

Batman: Arkham Knight (DirectX 11) – версия 1.6.2.0, настройки качества на уровне High, Texture Resolutioin normal, Anti-Аliasing on, V-Synс отключена, тесты в двух режимах – с активацией двух последних опций NVIDIA GameWorks и без них, двойной последовательный прогон встроенного в игру теста;

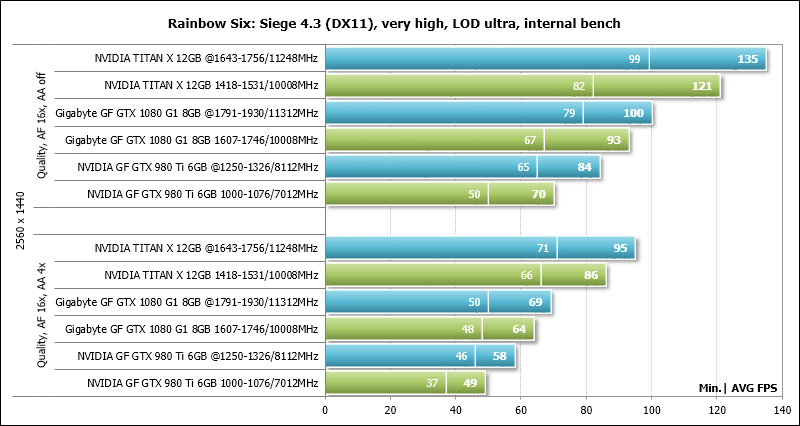

Tom Clancy's Rainbow Six: Siege (DirectX 11) – версия 4.3, настройки качества текстур на уровне Very High, Texture Filtering – Anisotropic 16X и прочие максимальные настройки качества, тесты с MSAA 4x и без сглаживания, двойной последовательный прогон встроенного в игру теста.

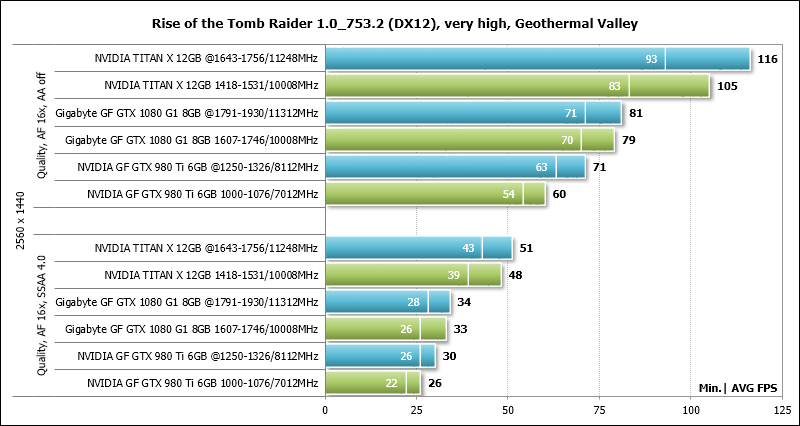

Rise of the Tomb Raider (DirectX 12) – версия 1.0 build 753.2_64, все параметры на уровень Very High, Dynamic Foliage – High, Ambient Occlusion – HBAO+, тесселяция и прочие методики улучшения качества активированы, по два цикла теста встроенного бенчмарка (сцена Geothermal Valley) без сглаживания и с активацией SSAA 4.0;

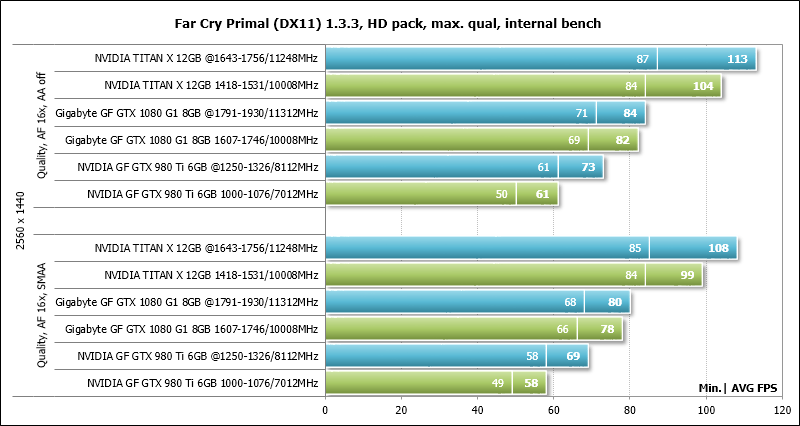

Far Cry Primal (DirectX 11) – версия 1.3.3, максимальный уровень качества, текстуры высокого разрешения, объёмный туман и тени на максимум, встроенный тест производительности без сглаживания и с активацией SMAA;

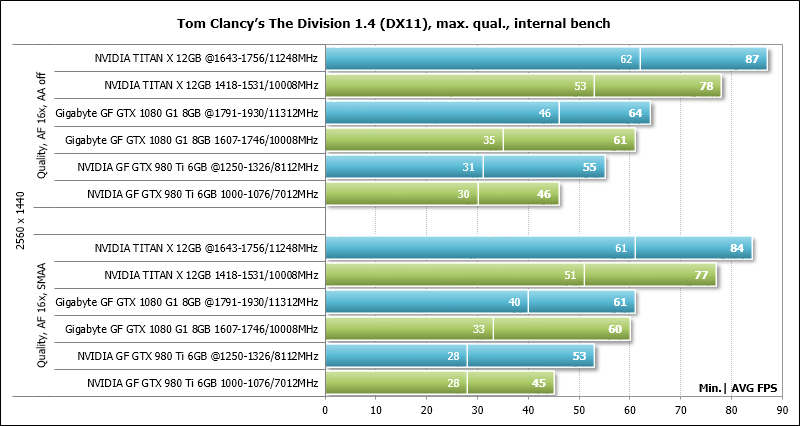

Tom Clancy’s The Division (DirectX 11) – версия 1.4, максимальный уровень качества, все параметры улучшения картинки активированы, Temporal AA – Supersampling, режимы тестирования без сглаживания и с активацией SMAA 1X Ultra, встроенный тест производительности, но фиксация результатов FRAPS;

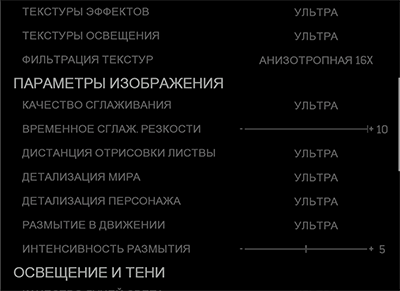

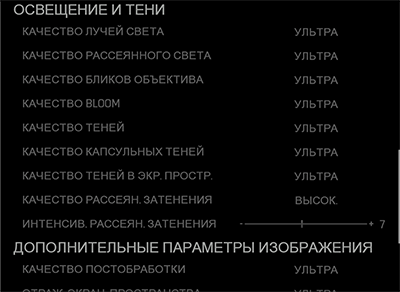

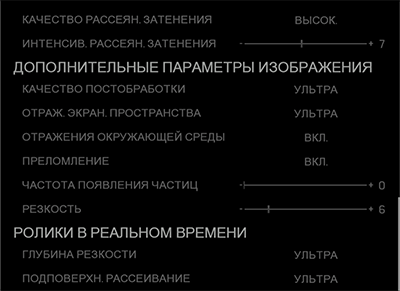

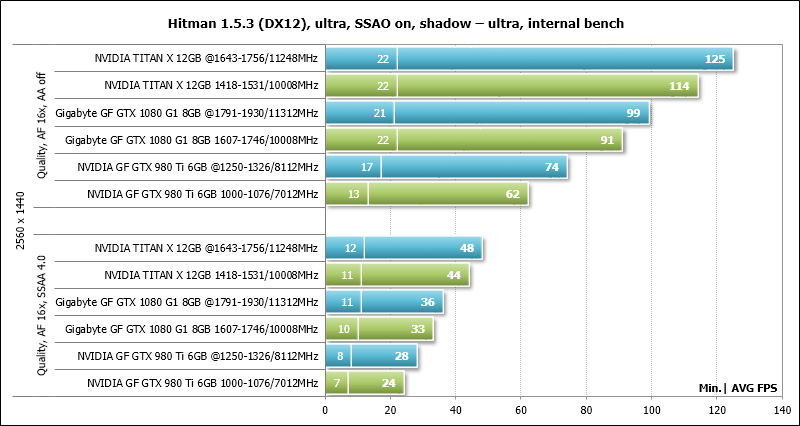

Hitman (DirectX 12) – версия 1.5.3, встроенный тест при настройках качества графики на уровне «Ультра», SSAO включено, качество теней «Ультра», защита памяти отключена;

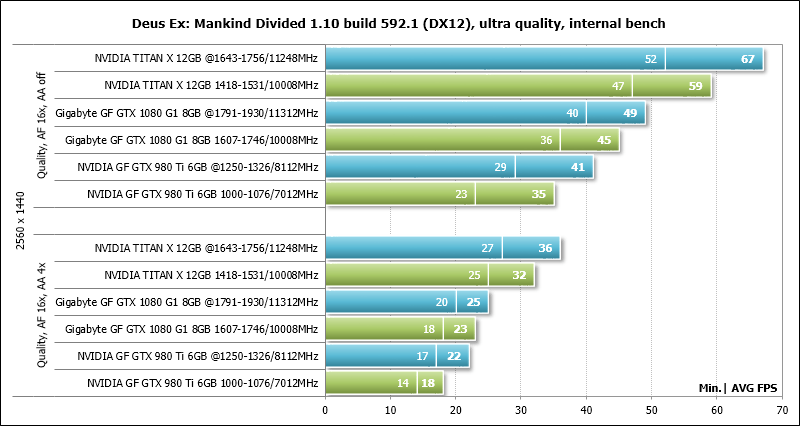

Deus Ex: Mankind Divided (DirectX 12) – версия 1.10 build 592.1, все настройки качества вручную выставлены на максимальный уровень, тесселяция и глубина резкости активированы, не менее двух последовательных прогонов встроенного в игру бенчмарка;

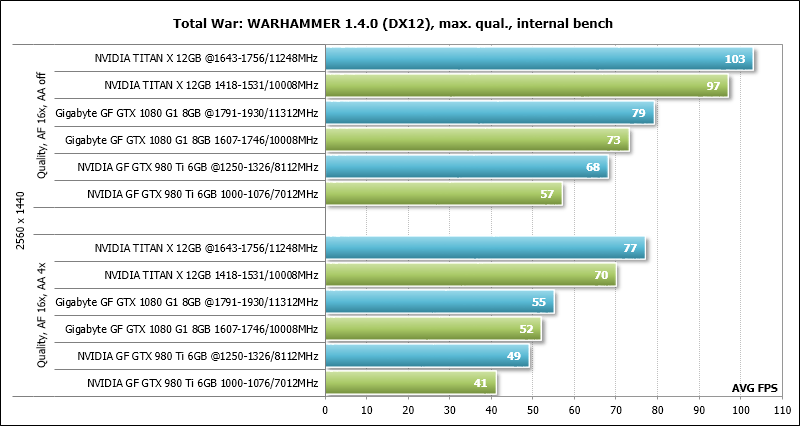

Total War: WARHAMMER (DirectX 12) – версия 1.4.0 build 11973.949822, все настройки качества графики на максимальный уровень, отражения включены, неограниченная видеопамять и SSAO активированы, двойной последовательный прогон встроенного в игру бенчмарка;

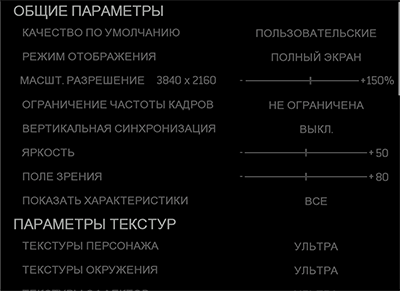

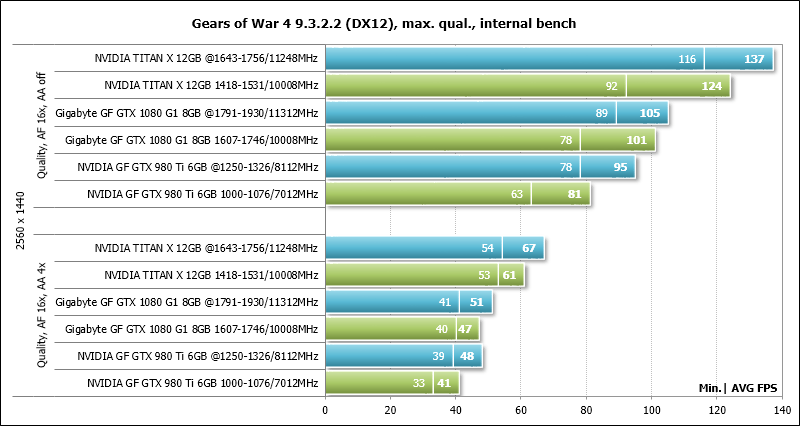

Gears of War 4 (DirectX 12) – версия 9.3.2.2, настройки качества на уровне Ultra, V-Synс отключён, все эффекты активированы, вместо не поддерживаемого игрой сглаживания использовалось масштабирование разрешения на 150% (до 3840 х 2160), двойной последовательный прогон встроенного в игру бенчмарка.

Если в играх реализована возможность фиксации минимального числа кадров в секунду, то оно также отражалось на диаграммах. Каждый тест проводился дважды, за окончательный результат принималось лучшее из двух полученных значений, но только в случае, если разница между ними не превышала 1%. Если отклонения прогонов тестов превышали 1%, то тестирование повторялось ещё как минимум один раз, чтобы получить достоверный результат.

3. Результаты тестов производительности

На диаграммах результаты тестирования видеокарт без разгона выделены зелёной заливкой, а при разгоне – тёмно-бирюзовым цветом. Поскольку все результаты на диаграммах имеют общую закономерность, то каждую из них отдельно мы комментировать не будем, а анализ проведём по сводным диаграммам в следующем разделе статьи.

3DMark

SteamVR

Crysis 3

Metro: Last Light

Battlefield 4

Grand Theft Auto V

DiRT Rally

Batman: Arkham Knight

Tom Clancy's Rainbow Six: Siege

Rise of the Tomb Raider

Far Cry Primal

Tom Clancy’s The Division

Hitman

Deus Ex: Mankind Divided

Total War: WARHAMMER

Так как Total War: WARHAMMER мы тестируем впервые, то приведём настройки, при которых данная игра будет тестироваться сегодня и в последующих наших статьях про видеокарты.

И далее результаты.

Gears of War 4

Также приведём и настройки новой игры Gears of War 4, впервые включённой в тестовый набор.

Результаты получились следующие.

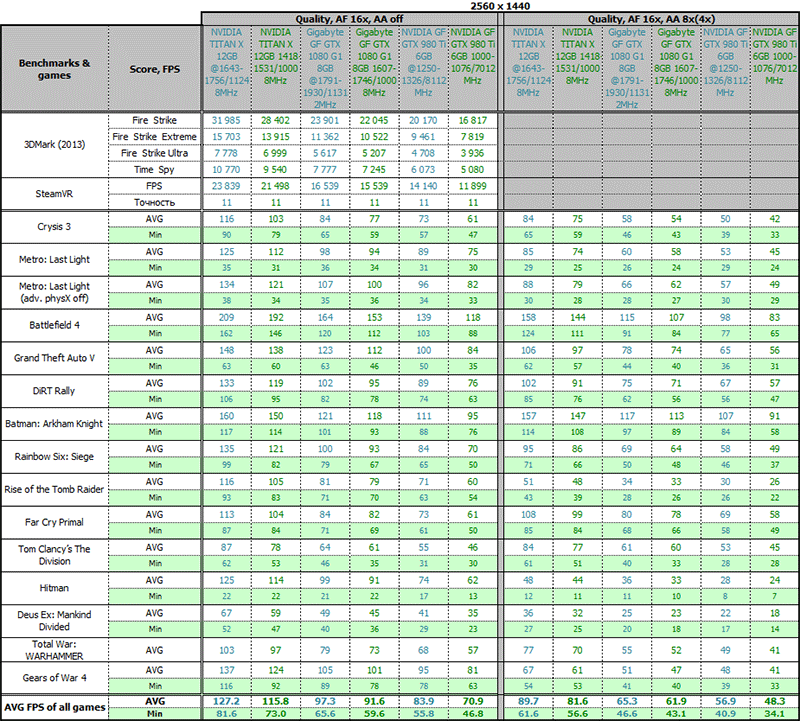

Дополним построенные диаграммы итоговой таблицей с результатами тестов с выведенными средним и минимальным значением числа кадров в секунду по каждой видеокарте.

На очереди – сводные диаграммы и анализ результатов.

4. Сводные диаграммы и анализ результатов

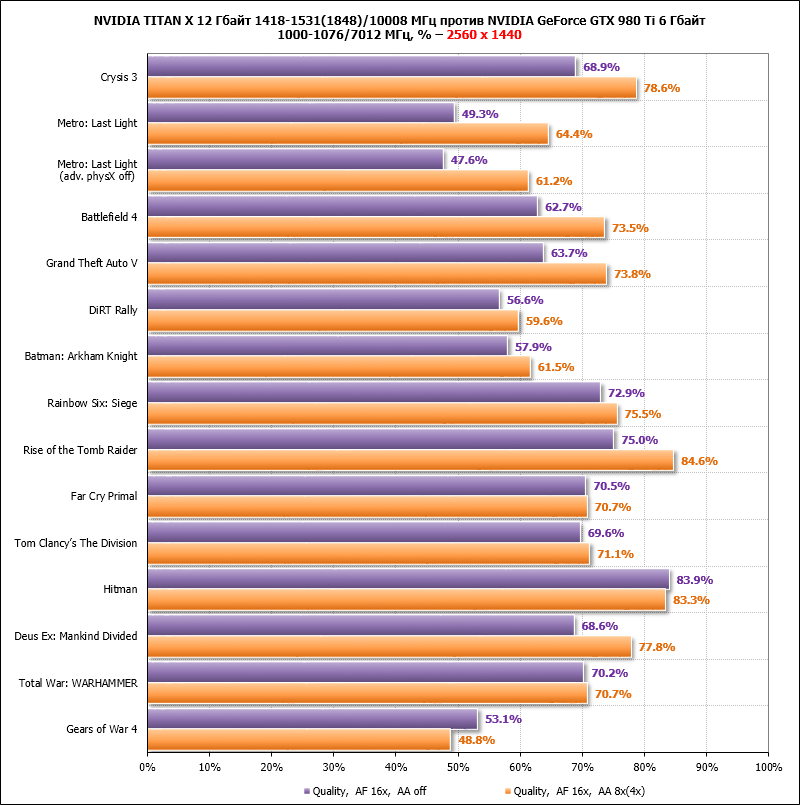

На первой паре сводных диаграмм мы предлагаем сравнить производительность новой NVIDIA TITAN X 12 Гбайт на номинальных частотах и эталонной NVIDIA GeForce GTX 980 Ti 6 Гбайт также на номинальных частотах. Результаты последней видеокарты приняты за начальную точку отсчёта, а средний FPS видеокарты NVIDIA TITAN X отложен в процентах от неё. Преимущество новой видеокарты, вне всяких сомнений, впечатляет.

В наших тестовых условиях и настройках NVIDIA TITAN X быстрее NVIDIA GeForce GTX 980 Ti, как минимум, на 48%, а максимальные значения её превосходства достигают ошеломляющих 85%! Учитывая, что GeForce GTX 980 Ti в играх была фактически равна прежнему GeForce TITAN X, то можно сказать, что NVIDIA TITAN X на столько же быстрее своего предшественника. Прогресс полноценного графического процессора Pascal невероятен, жаль, что пока всё это весьма дорого, но уже мерцающие на горизонте GeForce GTX 1080 Ti будут заметно доступнее (вопрос только в том, что именно в них урежут?). Итак, в среднем по всем играм в разрешении 2560 х 1440 пикселей NVIDIA TITAN X быстрее NVIDIA GeForce GTX 980 Ti на 64,7% в режимах без использования сглаживания и на 70,4% при активации различных алгоритмов сглаживания.

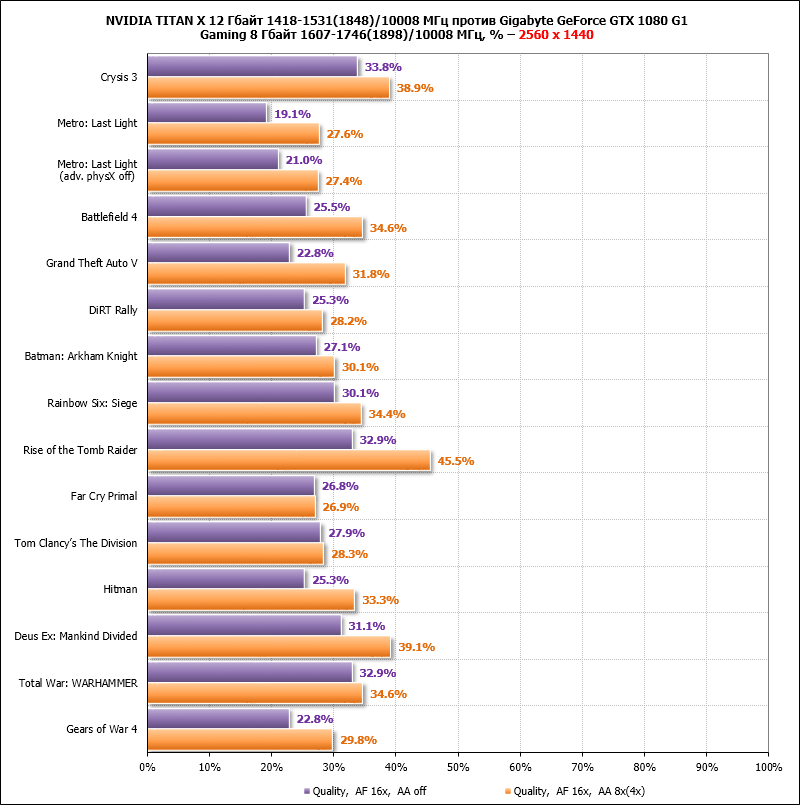

Теперь оценим на сколько NVIDIA TITAN X на номинальных частотах опережает Gigabyte GeForce GTX 1080 G1 Gaming с частотной формулой, приведённой под уровень эталонных версий GeForce GTX 1080.

И вновь очень приличный прирост производительности! Как минимум, новинка быстрее GeForce GTX 1080 на 19%, а в Rise of Tomb Raider её преимущество достигает внушительных 45,5%. В среднем по всем играм NVIDIA TITAN X быстрее на 27,0% в режимах без сглаживания и на 32,7% при его активации.

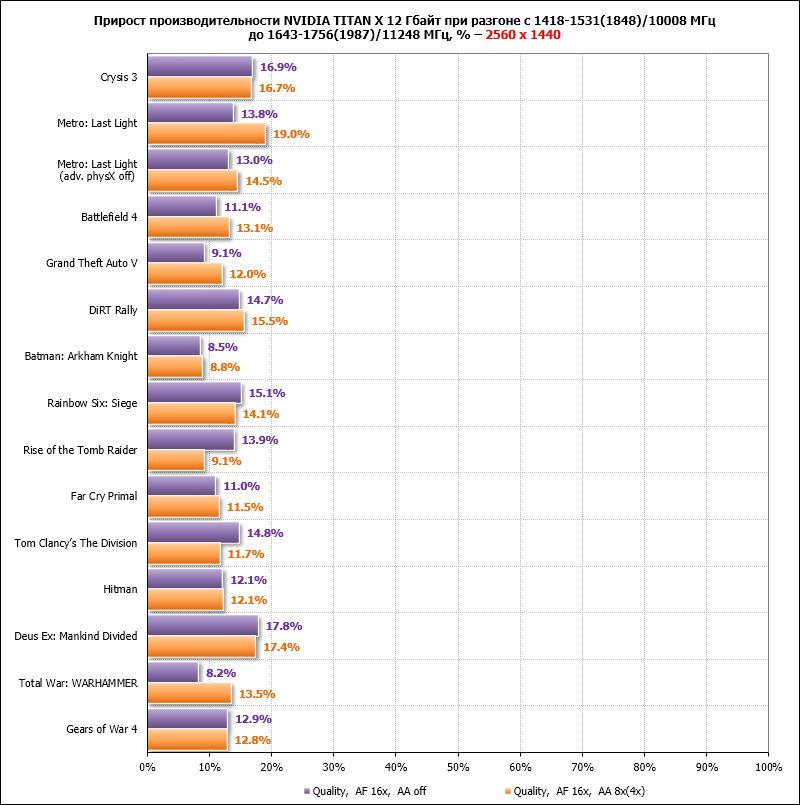

Теперь давайте помечтаем, что NVIDIA при выпуске GeForce GTX 1080 Ti не станет урезать топовый Pascal по числу блоков и количеству шейдерных процессоров, и одновременно её партнёры выпустят оригинальные версии с повышенными частотами. На сколько в таком случае ещё вырастет производительность флагмана? Ответ на следующей сводной диаграмме.

Разгон NVIDIA TITAN X на 15,9% по ядру и на 12,4% по видеопамяти ускоряет и без того умопомрачительно быструю видеокарту на 12,9% в режимах без сглаживания и на 13,4% при активации АА. Если вернуться к первой сводной диаграмме, то несложно предположить, что оригинальные GeForce GTX 1080 Ti могут оказаться вдвое быстрее эталонных GeForce GTX 980 Ti или GeForce GTX TITAN X. Конечно, такое сравнение не объективно, ведь все знают, что оригинальные GeForce GTX 980 Ti зачастую способны разгоняться до 1,45-1,50 ГГц по ядру, а значит преимущество потенциальных GeForce GTX 1080 Ti не будет столь высоким. Тем не менее, даже 60-70% прироста производительности к флагману предыдущего поколения не могут не впечатлять. Где у нас с вами подобный прирост в центральных процессорах или оперативной памяти? Нет там ничего подобного, даже в топовом сегменте. А у NVIDIA такие возможности уже есть!

5. Вычисления на GPU

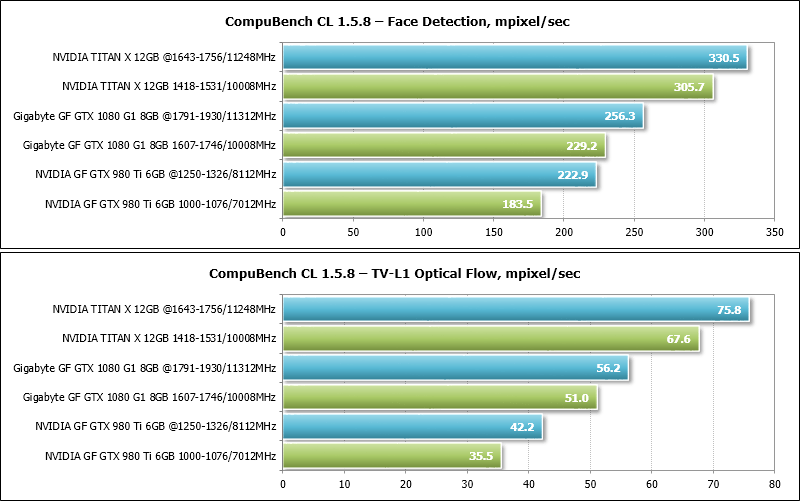

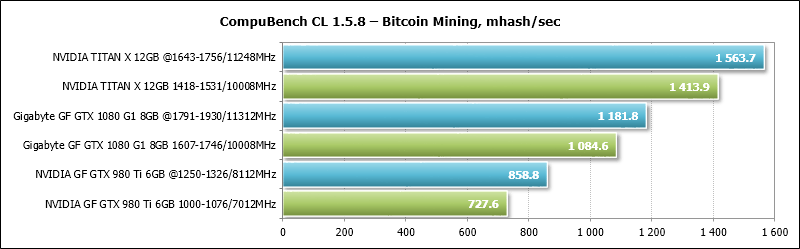

Сначала производительность новой видеокарты NVIDIA TITAN X мы протестируем в тесте CompuBench CL версии 1.5.8. Первые два теста – это распознавание лиц, основанное на алгоритме Виолы–Джонса, и базирующийся на вычислении вектора движения TV-L1 Optical Flow.

И вновь производительность NVIDIA TITAN X впечатляет. В номинальном режиме работы новинка опережает эталонную GeForce GTX 980 Ti на 66,6% в тесте Face Detection и на 90,4% в бенчмарке TV-L1 Optical Flow. Преимущество над GeForce GTX 1080 также довольно заметное, а разгон нового «Титана» ускоряет эту видеокарту ещё на 8,1-12,1%. Впрочем, примерно такой же прирост производительности и у двух других видеокарт тестирования при повышении частот.

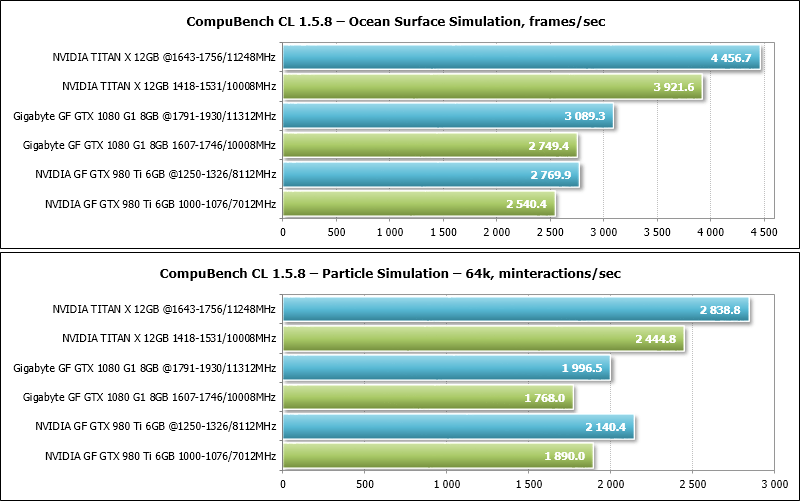

Далее у нас на очереди тест прорисовки движения волн водной поверхности по быстрому дискретному преобразованию Фурье – Ocean Surface Simulation, а также тест физической симуляции частиц Particle Simulation.

Отличительной особенностью этой пары тестов стала относительная близость результатов GeForce GTX 980 Ti и GeForce GTX 1080, похоже, что ядро Maxwell легко сдаваться не собирается. А вот перед новой TITAN X обе эти видеокарты пасуют, проигрывая от 42,6 до 54,4%.

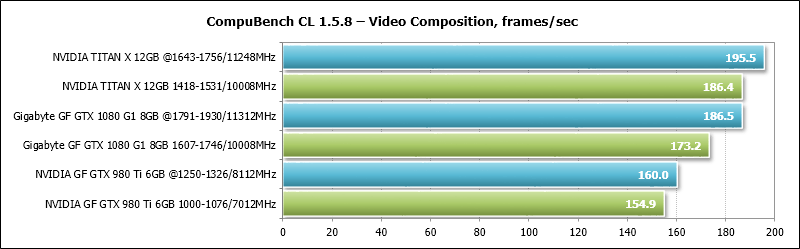

Намного плотнее результаты в тесте Video Composition.

Разогнанная Gigabyte GeForce GTX 1080 G1 Gaming даже умудряется догнать номинальную NVIDIA TITAN X, хотя последняя демонстрирует двадцатипроцентное преимущество над GeForce GTX 980 Ti.

Зато в симуляции майнинга криптовалюты Bitcoin мы вновь видим колоссальное преимущество NVIDIA TITAN X.

Новинка опережает GeForce GTX 980 Ti почти вдвое и на 30,4% быстрее Gigabyte GeForce GTX 1080 G1 Gaming на частотах эталонной NVIDIA GeForce GTX 1080. Такими темпами прироста производительности у NVIDIA и до видеокарт на графических процессорах AMD останется совсем чуть-чуть.

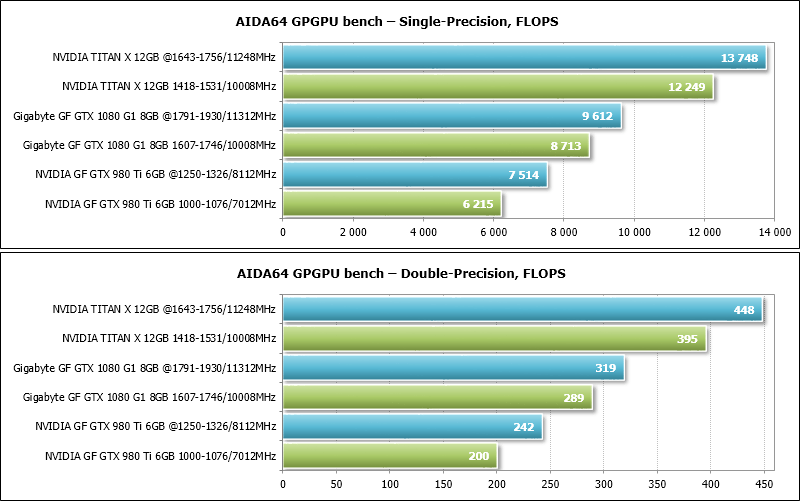

Далее у нас на очереди GPGPU тест из утилиты AIDA64 Extreme версии 5.75.3981 Beta. Из полученных результатов мы построили диаграммы по операциям с плавающей запятой с одинарной и двойной точностью.

Если ранее NVIDIA GeForce GTX TITAN X опережала в этих тестах первую версию GeForce GTX TITAN на 62%, то новая TITAN X на ядре Pascal превосходит предшественницу сразу на 97,5%! За любыми другими результатами теста AIDA64 GPGPU вы можете обращаться в тему обсуждения статьи в нашей конференции.

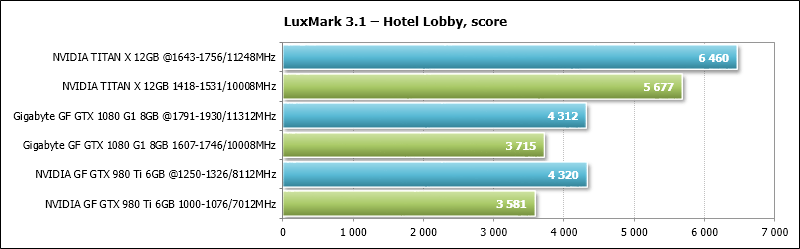

В завершении протестируем наиболее сложную сцену последнего LuxMark 3.1 – Hotel Lobby.

Отметим, что старенькая GeForce GTX 980 Ti «не даёт спуску» Gigabyte GeForce GTX 1080 G1 Gaming в этом тесте, но TITAN X опережает её сразу на 58,5%. Феноменальная производительность! Всё же жаль, что NVIDIA пока задерживает выпуск GeForce GTX 1080 Ti, и особо жаль, что её в этом никто пока не подгоняет.

6. Энергопотребление

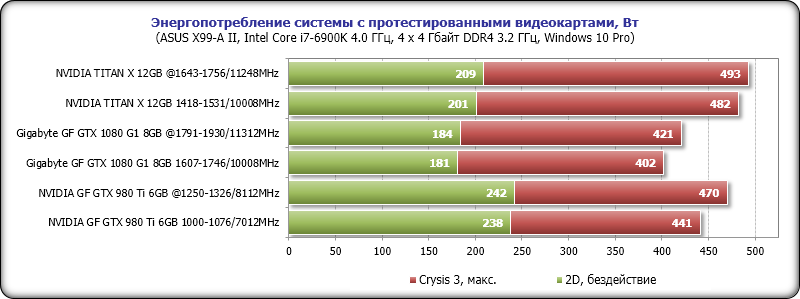

Измерение уровня энергопотребления проводилось с помощью блока питания Corsair AX1500i через интерфейс Corsair Link и одноимённую программу версии 4.3.0.154. Измерялось энергопотребление всей системы в целом без учёта монитора. Измерение было проведено в 2D-режиме при обычной работе в Microsoft Word или интернет-сёрфинге, а также в 3D-режиме. В последнем случае нагрузка создавалась с помощью четырёх последовательных циклов вступительной сцены уровня Swamp из игры Crysis 3 в разрешении 2560 х 1440 пикселей при максимальных настройках качества графики с использованием MSAA 4Х. Энергосберегающие технологии центрального процессора отключены.

Давайте сравним уровень энергопотребления систем с протестированными сегодня видеокартами на диаграмме.

Несмотря на колоссальный прирост производительности везде и всюду, компании NVIDIA удалось удержать тепловой пакет новой TITAN X с ядром Pascal в тех же пределах, что и у прежней версии TITAN X – 250 ватт, поэтому уровень энергопотребления систем с этими видеокартами отличается несущественно. Так, в номинальном режиме работы конфигурация с NVIDIA TITAN X потребляет на 41 ватт больше, чем с видеокартой NVIDIA GeForce GTX 980 Ti, а при разгоне обеих видеокарт эта разница сокращается до 23 ватт. Вместе с тем, отметим, что система с Gigabyte GeForce GTX 1080 G1 Gaming экономичнее обеих версий TITAN X, а на частотах эталонной GeForce GTX 1080 едва не укладывается в предел 400 ватт, и это с учётом того, что в конфигурации присутствует прилично разогнанный восьмиядерный процессор. Экономичнее новинка и в 2D-режиме.

Заключение

Поскольку на сегодняшний день видеокарты NVIDIA в лице GeForce GTX 1080 и GTX 1070 занимают единоличное лидерство по производительности в верхнем ценовом сегменте, то выпуск ещё более производительной TITAN X мы вполне можем считать самой что ни на есть демонстрацией своего технологического превосходства над единственным конкурентом. Причём, демонстрация эта в полной мере удалась, ведь, находясь в том же тепловом пакете, преимущество новинки над флагманской видеокартой NVIDIA предыдущего поколения в игровых тестах порой достигает 85%, а в среднем составляет около 70%! Не менее впечатляющим выглядит прирост производительности и в вычислениях, что, как мы знаем, первостепенно для видеокарт NVIDIA серии TITAN.

Разница в производительности с GeForce GTX 1080 немного скромнее и составляет 27-33%, зато прирост производительности от разгона у TITAN X выше (около 13% против 10% у GeForce GTX 1080), а значит при появлении GeForce GTX 1080 Ti на основе того же GP102 мы вправе рассчитывать на ещё более высокие частоты и, как следствие, прирост производительности. Отрицательным моментом в анонсе TITAN X является двухсотдолларовое повышение рекомендованной стоимости, однако, на наш взгляд, у потенциальных потребителей таких видеокарт 20-процентный рост стоимости не вызовет серьёзных проблем. Ну, а геймеры поскромнее с нетерпением ждут появления GeForce GTX 1080 Ti, как и её «красного» конкурента.

Кроме того, отметим, что, несмотря на ошеломляющую производительность в играх, сама NVIDIA позиционирует TITAN X, в первую очередь, как эффективный инструмент для обучения нейросетей и решения задач, связанных с алгоритмами Deep Learning (глубинное обучение). Эти алгоритмы сегодня активно используются в самых разных областях: распознавание речи, изображений, видео, составление гидрометеорологических прогнозов, постановка более точных медицинских диагнозов, составление высокоточных карт, робототехника, самоуправляемые автомобили и так далее. Поэтому можно сказать, что возможности новой видеокарты NVIDIA TITAN X безграничны и удовлетворят любых пользователей.

Благодарим компанию NVIDIA и лично Ирину Шеховцову

за предоставленную на тестирование видеокарту.

за предоставленную на тестирование видеокарту.