Ваш город: Москва

Тестирование SAS RAID-контроллера LSI MegaRAID SAS 8708EM2

Введение

Текущий выбор SAS RAID-контроллеров компании LSI включает в себя три серии: Entry Line, Value Line и Feature Line. Первая из них, MegaRAID SAS 82xx, является начальным уровнем не только по названию, но и по факту — в контроллерах этой серии нет ни выделенных собственных процессоров, ни буферной памяти, а в список поддерживаемых ими массивов не входит RAID6. В общем, эта серия является недорогим выбором для тех, кому не требуется высокой производительности и повышенной защищенности данных. Остальные две серии представляют собой уже полноценные контроллеры, но третья серия, 88xx, чуть более функциональна — в ней устанавливается больше буферной памяти и только в ней у моделей есть внешние разъемы, соответственно, она поддерживает большее количество устройств, подключаемых через экспандер. В наши же руки сегодня попал контроллер как раз из второй, основной серии — 8708EM2. Кстати, у этого контроллера, как и у многих других его собратьев по бренду, есть брат-близнец, существующий на прилавках под несколько другим логотипом — Intel SRCSASBB8I. Мы, конечно, свечку не держали, но сравните сами и убедитесь, что родство гораздо выше, чем «просто похожи».

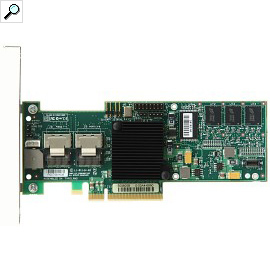

LSI MegaRAID SAS 8708EM2

Серия Value Line включает в себя на текущий момент четыре контроллера на чипах последнего поколения. Различаются модели количеством портов (восемь или четыре) и исполнением: модели EM2 короче, полностью соответствуют форм-фактору MD2 и используют интерфейс PCI-Express x8, в то время как модели ELP длиннее и довольствуются PCI-E x4.

О, компания сменила дизайн упаковки вслед за сменой общего своего стиля. На смену мрачной сине-черной гамме пришло жизнерадостное сочетание оранжевого и белого. Пожалуй, получилось даже излишне вызывающе, но зато взглядом точно не пропустишь.

Сердцем контроллера является фирменный ROC (Raid-On-Chip) процессор LSISAS1078, имеющий архитектуру PowerPC и работающий на частоте 500 МГц. Мда, после Adaptec ASR-5805 с его двухъядерным монстром с частотой 1,2 ГГц мощность кажется недостаточной, но, с другой стороны, тот же 3ware 9690SA-8I и на вдвое меньшей частоте весьма неплохо справлялся с массивами, пользуясь преимуществами своей архитектуры. В общем, поживем — увидим, что и к чему у нас со скоростью.

С памятью все тоже довольно скромно — в отличие от контроллеров серии 88xx, в нашем сегодняшнем участнике установлено не 512 МБ, и даже не 256 МБ, а всего 128 МБ DDR2, работающей на частоте 667 МГц.

Комплект поставки оригинальностью не отличается — в него входит привычной набор из краткой инструкции, диска с драйверами, сменной планки да двух шлейфов. Последние предназначены для подключения до четырех устройств на каждом к разъемам SFF-8087 на контролере.

Контроллеры двух старших серий LSI поддерживают весь джентлеменский набор типов массивов, существующий в настоящее время:

одиночный диск,

RAID0,

RAID1,

RAID5,

RAID6,

RAID10,

RAID50,

RAID60.

Все необходимое для организации работы в наличии, вряд ли для многих отсутствие RAID1E и RAID5EE (не говоря уж о еще более специфичных массивах) станет серьезным аргументом «против» при выборе.

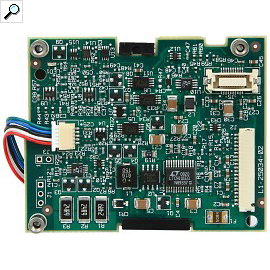

Как всегда, мы стараемся, по возможности, использовать контроллер с батареей резервного питания и рекомендуем всем не экономить на этом полезнейшем аксессуаре — право слово, данные и время, потраченное на их восстановление, обходятся значительно дороже.

В нашем случае использовалась LSIiBBU06, крепящаяся прямо на плату контроллера на трех маленьких стойках. Кстати, будьте внимательны, другие контроллеры серий 87xx и 88xx используют другие батареи.

Ну и в завершение несколько слов и программном сопровождении. С драйверами все отлично — на сайте перед нами разворачивается внушительный выбор под различные операционные системы. Там же можно скачать и сборки под различные ОС программы MegaCLI — фирменного приложения для работы с настройками контроллера и массивами из-под операционной системы. Ее функционал достаточно широк, чтобы вообще не заходить в BIOS контроллера, но вот удобство работы все же далеко от идеального: контекстное меню слишком уж зависит от контекста (простите за тавтологию), в результате далеко не сразу понимаешь, где искать пункт, ответственный за то или иное действие. Впрочем, это уже скорее вопрос привычки.

Методика тестирования

Во время тестирования использовались следующие программы:

IOMeter версии 2003.02.15;

WinBench версии 99 2.0;

FC-Test версии 1.0;

Тестовая система была следующей:

корпус Intel SC5200;

системная плата Intel SE7520BD2;

два процессора Intel Xeon 2,8 ГГц на 800-МГц системной шине;

2 х 512 МБ регистровой памяти DDR PC3200 ЕСС

жесткий диск IBM DTLA-307015 объемом 15 ГБ в качестве системного диска;

видеокарта — встроенное видео ATI Rage XL

операционная система Microsoft Windows 2000 Professional SP4

Kонтроллер во время тестов устанавливался в слот PCI-Express x8 на материнской плате. Для тестирования использовались жесткие диски Fujitsu MBA3073RC, установленные в штатные салазки корпуса SC5200 и закрепленные в них четырьмя винтами за нижнюю грань. Контроллер тестировался с использованием четырех и восьми жестких дисков в следующих режимах:

RAID0;

RAID10;

деградировавший восьмидисковый RAID10 без одного диска;

RAID5;

RAID5;

деградировавший восьмидисковый RAID5 без одного диска;

RAID6;

деградировавший восьмидисковый RAID6 без одного диска;

деградировавший восьмидисковый RAID6 без двух дисков.

Поскольку мы стараемся максимально полно охватить все возможные типы массивов, то включаем в тестирование и рассмотрение деградировавших массивов. Данным термином обозначаются массивы с избыточностью данных, в которых один или несколько дисков (в зависимости от типа массива) вышел из строя, но при этом массив все еще хранит все данные и является рабочим.

Для сравнения мы будем везде приводить результаты одиночного диска Fujitsu MBA3073RC, полученные на контроллере LSI SAS3041E-R, считая их неким базовым уровнем производительности. Сразу оговоримся, что у такого сочетания есть одна хорошо известная нам проблема: его скорость записи в «FileCopy Test» всегда очень мала.

По умолчанию, контроллер предлагает для массивов размер страйпа равным 64 кБ, то есть тот размер, который обычно используем и мы, так что по данному пункту у нас с LSI единодушие.

В контроллер была прошита самая последняя доступная нам на момент тестирования версия BIOS и использовались самые свежие драйвера. Соответственно, мы использовали прошивку 9.1.1-0013 и драйвера 2.20.0.32.

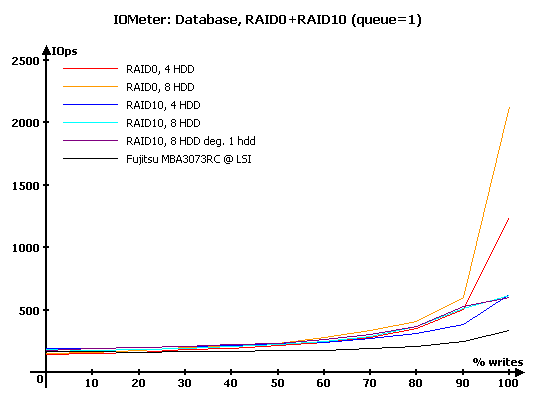

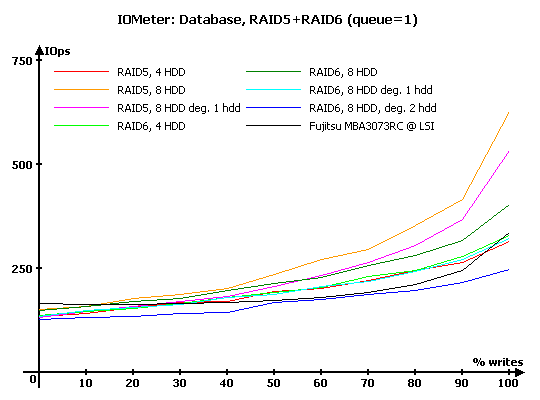

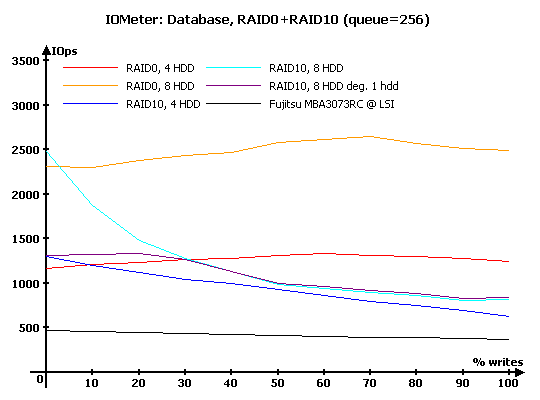

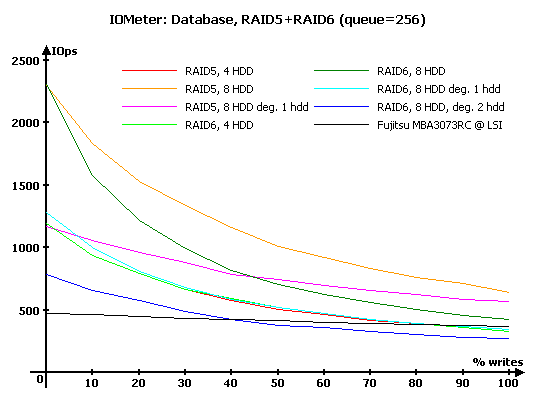

IOMeter: Database

Как всегда, начнем, пожалуй, с наиболее интересного с точки зрения нагрузки на контроллер теста — «Database», с помощью которого мы выясняем способность контроллеров работать с потоками запросов на чтение и запись 8-кБ блоков данных со случайной адресацией. В ходе тестирования происходит последовательное изменение доли запросов на запись от нуля до ста процентов (с шагом 10 %) от общего количества запросов и увеличение глубины очереди команд от 1 до 256.

Численные результаты измерений здесь и далее вы можете, при желании, увидеть в соответствующих таблицах, мы же будем работать с графиками и диаграммами.

Таблицы с результатами тестирования вы можете посмотреть по следующей ссылке:

Результаты IOMeter: Database, RAID1+RAID10

Результаты IOMeter: Database, RAID5+RAID6

На минимальной нагрузке все было бы вполне прилично, если бы не один момент: поведение восьмидисковых RAID10. И нормальный, и деградировавший массив демонстрируют неожиданно низкую производительность при 100 % запросов на запись — ровно столько же операций в секунду делает и RAID10 из четыре дисков, лишенный такого падения. Что происходит в контроллере — мы можем только догадываться.

У массивов с записью контрольных сумм тоже все в порядке. Малое время отклика используемых нами дисков и достаточная производительность контроллера обеспечивают массивам весьма неплохую производительность при большом количестве запросов на запись. Напомним, что у контроллеров прошлого поколения с SATA-дисками производительность не росла с увеличением количества запросов на запись, а наоборот, снижалась.

Если сравнить результаты с уже побывавшими у нас контроллерами, то можно заметить, что LSI весьма неплохо работает с деградировавшими массивами, а вот нормальные RAID5 и RAID6 из большого количества дисков ей удаются чуть хуже. Неужели процессора все же не хватает?

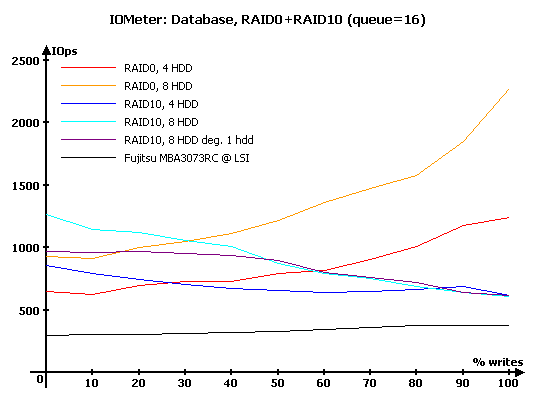

Увеличиваем нагрузку до 16 запросов в очереди и смотрим, как графики ползут вверх. У массивов RAID10 снова наблюдаем проблемы с записью — такое впечатление, что у них отключена отложенная запись. Зато у них же мы видим крайне эффективный поиск удачного диска в зеркальной паре — при преобладании операций чтения массивы RAID10 очень заметно превосходят RAID0 из такого же количества дисков.

Интересно следить и за деградировавшим массивом RAID10 — при преобладании записи он идет вровень с обычным, а вот на чтении закономерно отстает от полноценного, поскольку в одной из зеркальных пар возможности выбрать лучший диск уже нет. Впрочем, он по-прежнему на «чистом» чтении превосходит RAID0 — отличный результат.

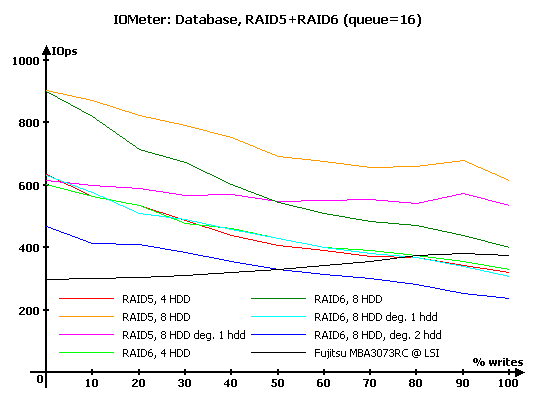

У массивов RAID5 и RAID6 с записью тоже не очень хорошо: на таких операциях производительность слишком мала, массивы из четырех дисков проигрывают одиночному диску — у конкурентов было получше.

При этом с чтением у них все в полном порядке. Обратите внимание, во что обходится потеря диска — 8-дисковые массивы, деградировавшие на один диск, на чтении соответствуют по скорости лишь 4-дисковым массивам.

Дальнейшее увеличение глубины очереди не в силах помочь массивам RAID10 — отложенной записи у них так и не появляется. Тяжело приходится деградировавшему массиву — из-за огромной нагрузки потеря одного из дисков фатально сказывается на его производительности на чтении.

При огромной глубине очереди массивы RAID5 и RAID6 рисуют очень аккуратные по форме графики, без каких-либо огрехов. Вот только производительность при преобладании операций записи все же несколько меньше того, что мы ожидали, зная результаты конкурентов. При этом мы видим весьма неплохие скорости на чтении с деградировавших массивов. Судя по всему, производительности процессора контроллеру вполне хватает, как и эффективности алгоритмов, а вот буферной памяти для организации отложенной записи ему все же маловато — у конкурентов её было побольше.

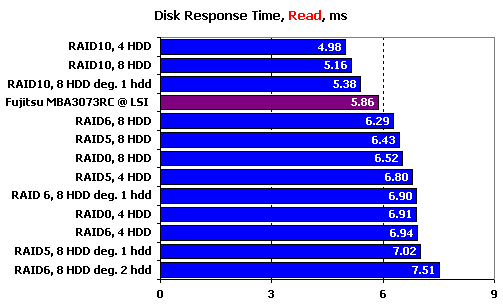

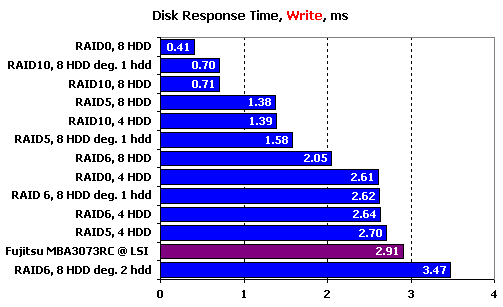

IOMeter: Disk Response Time

Для измерения времени отклика мы в течении десяти минут при помощи IOMeter отправляем на накопитель поток запросов на чтение или запись блоков данных по 512 байт при глубине очереди исходящих запросов, равной единице. Количество запросов, обработанных накопителем, превышает шестьдесят тысяч, так что мы получаем устоявшееся время отклика накопителя, не зависящее от объема буферной памяти.

Благодаря крайне эффективному чтению с зеркальных пар время отклика массивов RAID10 оказывается меньше, чем у одиночных дисков. Причем для 4-дискового массива выигрыш оказывается равен почти миллисекунде — при 6-мс отклике у одиночного диска это великолепный результат. Наши аплодисменты создателям прошивки. Но почему лучший результат у массива из четырех, а не из восьми дисков — непонятно.

Массивы других типов оказываются хуже одиночного диска: 8-дисковые несильно, 4-дисковые — побольше. Но это все в пределах нормы, совсем уж «бесплатным» с точки зрения времени отклика контроллер быть не может. Непонятно только одно — почему среди массивов разного типа максимальное время отклика мы видим у RAID0?

Теоретически, на записи время отклика определяется суммарным кэшем системы из контроллера и дисков — все запросы уходят сперва в буферную память, и лишь потом «разбегаются» по дискам. В данном случае все массивы полностью совпадают с теорией, за исключением RAID0 на 4 дисках — его отклик неожиданно слишком велик, он должен быть на уровне RAID10 из восьми дисков. Абсолютные значения времен отклика далеко не рекордны — сказывается то, что у конкурентов больше кэша на контроллере.

IOMeter: Random Read & Write

Оценим теперь зависимость производительности контроллеров в режимах чтения и записи с произвольной адресацией от размера используемого блока данных.

Результаты, полученные при работе со случайной адресацией данных, рассмотрим в двух вариантах, в соответствии с обновленной методикой. На блоках малого размера построим зависимости количества операций в секунду от размера используемого блока. А на больших блоках вместо количества операций возьмем в качестве критерия производительности скорость в мегабайтах в секунду. Такой подход позволяет оценить работу массивов сразу в двух типичных случаях нагрузки: работа малыми блоками характерна для баз данных и для нее более важно количество операций в секунду, чем привычная скорость; а вот работа большими и очень большими блоками близка к реальной работе с файлами малых размеров, и здесь уже на первый план выходит именно скорость в привычных мегабайтах в секунду.

Начнем с чтения.

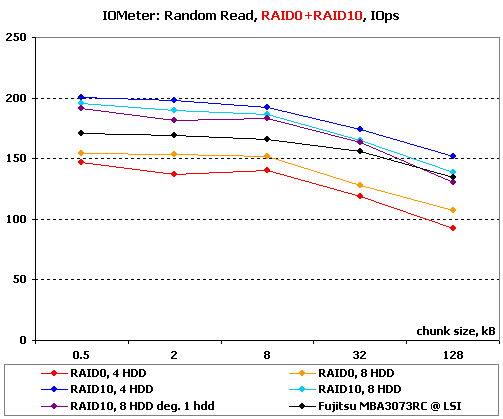

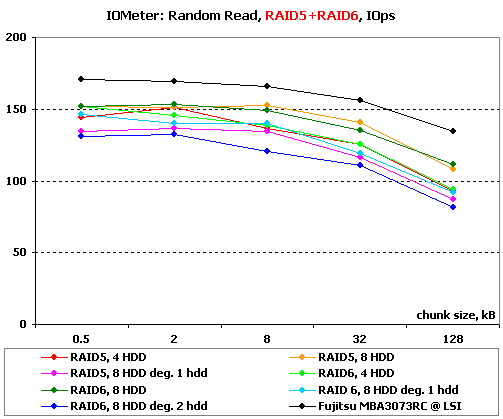

Результаты IOMeter: Random Read, операций/с

Результаты IOMeter: Random Write, МБ/с

На чтении малыми блоками снова приходится вспоминать про эффективное чтение с зеркальных пар — именно благодаря ему контроллер показывает на RAID10 до двухсот операций в секунду . И даже деградировавший RAID10 держится очень неплохо.

А вот у массивов с записью контрольных сумм мы видим какую-то чехарду: на 2-кБ блоках резко прибавляет в скорости RAID5 из четырех дисков, а на 8-кБ блоках особенно сильно страдает производительность деградировавшего RAID6 (без двух дисков). Обратите внимание, как с увеличением размера блока растет преимущество 8-дисковых массивов над остальными.

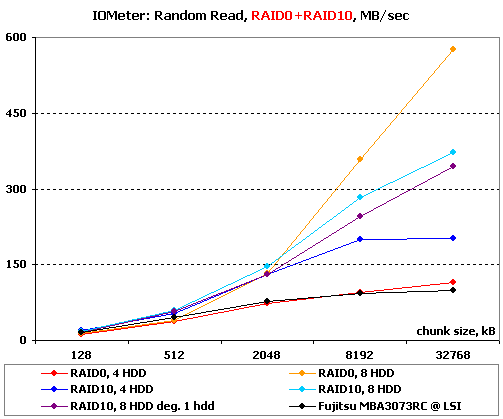

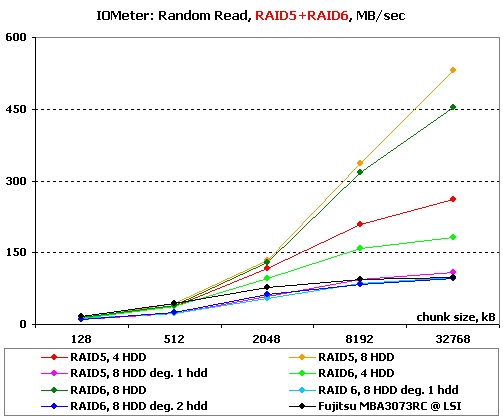

На больших блоках начинает играть роль еще и скорость линейного чтения. И тут начинаются странности: RAID0 из четырех дисков на всех блоках не может оторваться по скорости от одиночного диска, 8-дисковый RAID0 даже на 2-МБ блоках не отличается от остальных массивов, хотя должен быть уже чуть быстрее.

У полноценных массивов RAID5 и RAID6 со скоростью все в полном порядке — их производительность приятно радует взгляд. А вот все деградировавшие массивы идут практически вровень с одиночным диском — маловато будет!

Перейдем к операциям записи со случайной адресацией.

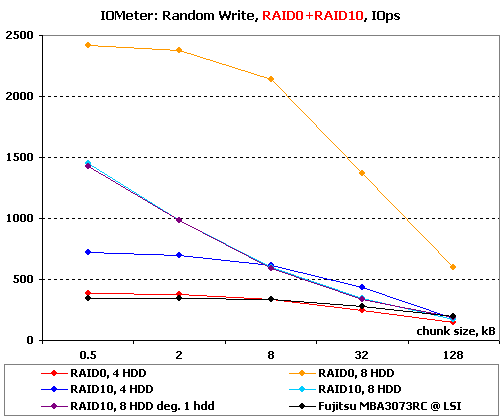

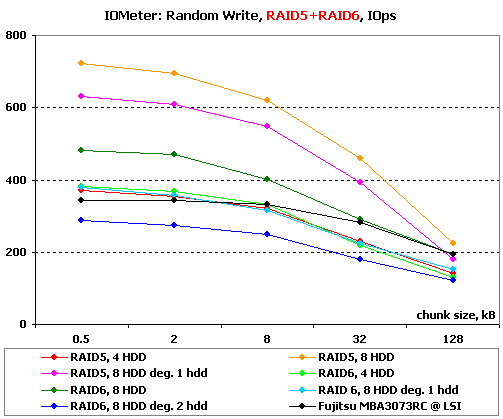

Результаты IOMeter: Random Write, операций/с

Результаты IOMeter: Random Write, МБ/с

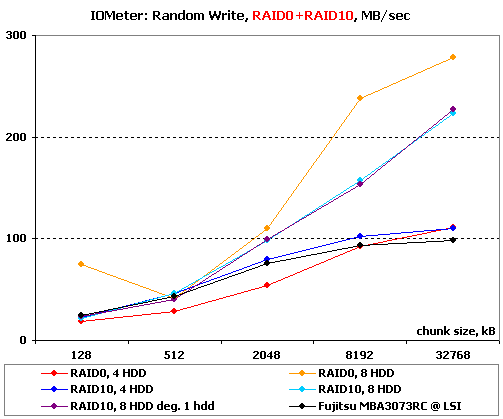

Обычно на этой диаграмме видишь откровенное масштабирование графиков по принципу «больше дисков — больше кэша — выше скорость». А у LSI все по-своему: 8-дисковые RAID10 демонстрируют крайне странное поведение, очень сильно снижая производительность на всех блоках малого размера, кроме самого маленького (512 байт). В результате они умудряются местами проигрывать массиву из четырех дисков! Впрочем, RAID0 из четырех дисков демонстрирует еще более худший результат — его скорость не превышает скорости одиночного диска. При этом RAID0 из восьми дисков и RAID10 из четырех ведут себя полностью как полагется.

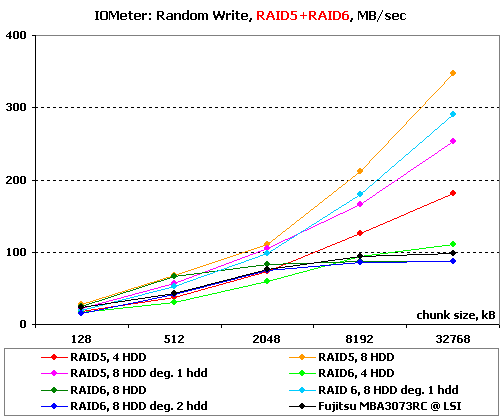

Вот, а у массивов с вращающейся четностью все в порядке — перед нами нормальные графики с полагающейся масштабируемостью производительности. Но контроллеру снова не хватает буферной памяти, чтобы на равных соревноваться с конкурентами.

На записи большими блоками мы продолжаем наблюдать странное поведение массивов. На этот раз RAID10 из восьми дисков (как полноценный, так и деградировавший) ведут себя прилично, а вот RAID0 из восьми дисков демонстрирует очень сильную зависимость скорости от размера блока, причем 512-кБ блоки ему крайне не нравятся. RAID0 из четырех дисков пишет даже медленнее, чем одиночный диск, да и RAID10 на том же количестве дисков не радует результатами.

К сожалению, на больших блоках вылезают на свет проблемы с записью у массивов RAID6 — скорость всех их крайне невысока, кроме, почему-то, деградировавшего на один диск массива.

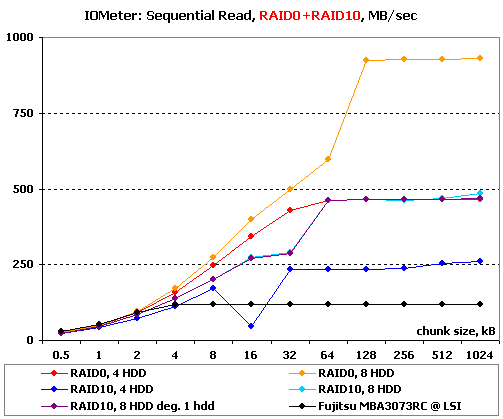

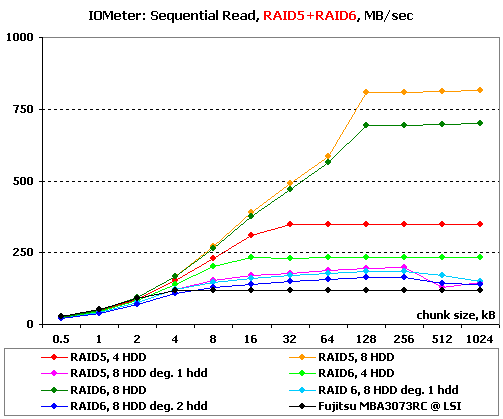

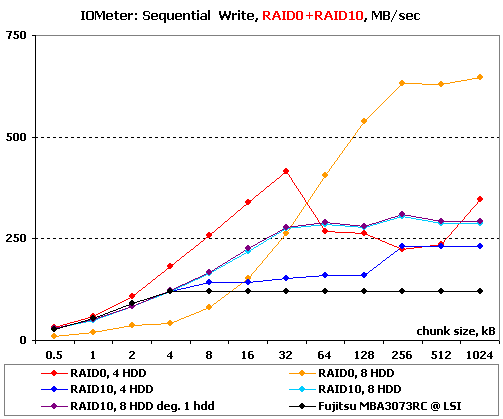

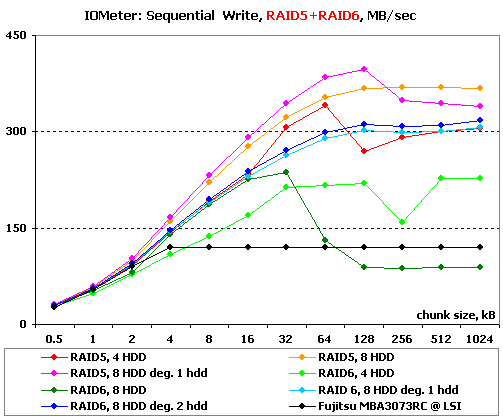

IOMeter: Sequential Read & Write

Ну что ж, пора оценить способности контроллеров в последовательных операциях. В данном тесте на накопители подается поток запросов с глубиной очереди команд, равной четырем. Раз в минуту размер блока данных увеличивается. В итоге мы получаем возможность проследить зависимость линейных скоростей чтения и записи массивов от размеров используемых блоков данных и оценить максимальные достижимые скорости.

Результаты IOMeter: Sequential Read

Результаты IOMeter: Sequential Write

8-дисковый RAID0 почти дотягивается до 1000 МБ/с на больших блоках — отличный результат. С масштабируемостью тоже все в полном порядке. Контроллер даже пытается читать одновременно с обоих дисков в зеркальных парах при блоках очень большого размера — но получается это у него не очень хорошо: прибавка в скорости очень мала. Практически без потерь скорости проходит этот тест и деградировавший RAID10.

Хорошо справляются с чтением и массивы с записью контрольных сумм — их скорости вполне соответствуют тому, что можно ожидать от массивов, зная их специфику и скорость одиночного диска. А вот все деградировавшие массивы показывают неожиданно низкие результаты — с восстановлением данных из контрольных сумм у этого контроллера не очень задалось.

Мда, а вот на записи у нас опять начались непонятные скачки скорости, причем на всех массивах. RAID10 из восьми дисков просто не выходит на теоретическую скорость, у RAID10 из четырех дисков проблемы на блоках среднего размера, а у такого же RAID0 — на больших. Неплоха максимальная скорость RAID0 на восьми дисках, но вот с маленькими блоками он работает медленнее всех остальных, что абсолютно необъяснимо.

У массивов RAID5 и RAID6 с записью тоже проблемы. В прошивке явно есть недоработки, потому что ничем иным объяснить превосходство деградировавших массивов над полноценными невозможно. Но особенно поражает крайне низкая скорость RAID6 из восьми дисков на больших блоках.

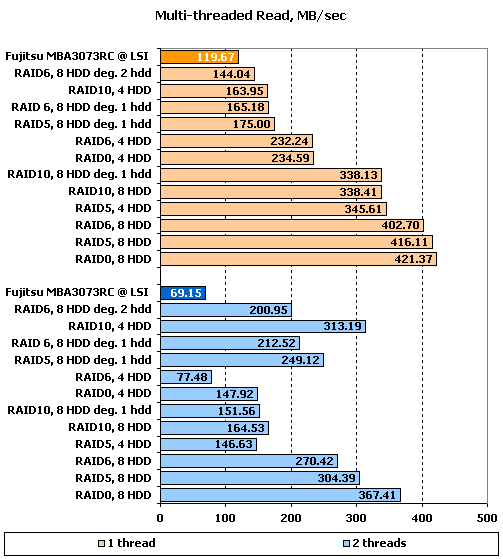

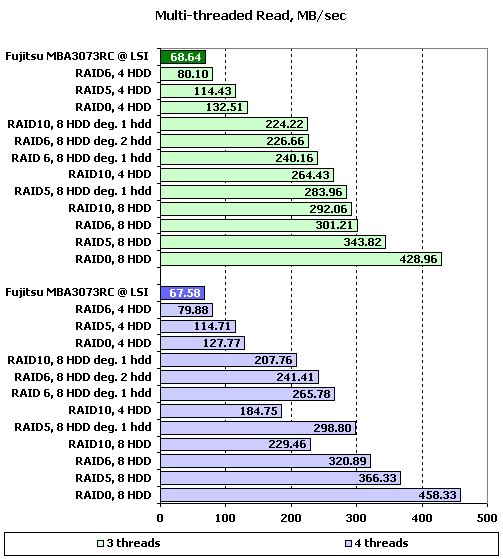

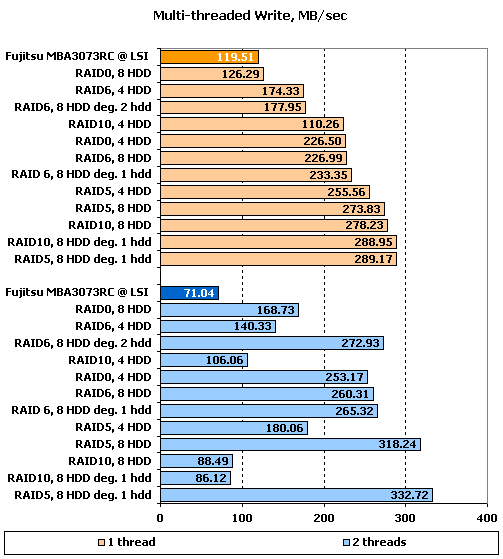

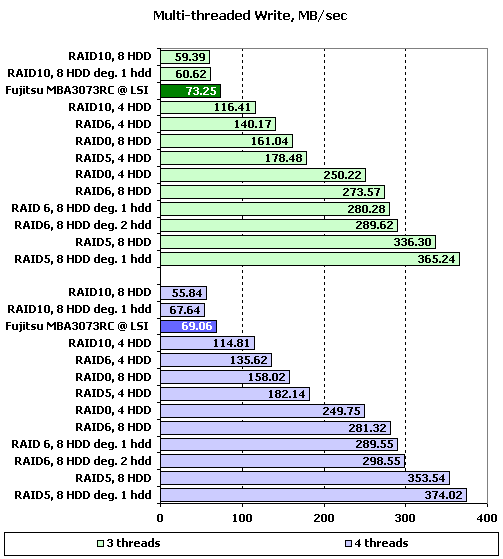

IOMeter: Multi-thread Read & Write

Данный тест позволяет оценить поведение контроллеров при многопоточной нагрузке. В ходе него эмулируется ситуация, когда с накопителем работает от одного до четырех приложений, причем количество запросов от них изменяется от одного до восьми, а адресные пространства каждого приложения, роли которых выполняют worker-ы в IOMeter, не пересекаются.

При желании, вы можете увидеть таблицы с результатами тестирования по соответствующим ссылкам, а мы же в качестве наиболее показательных, рассмотрим диаграммы записи и чтения для ситуаций с глубиной очереди в один запрос, поскольку при количестве запросов в очереди равном двум и более значения скоростей практически не зависят от количества приложений.

Результаты IOMeter: Multi-tread Read, RAID1+RAID10

Результаты IOMeter: Multi-tread Read, RAID5+RAID6

Результаты IOMeter: Multi-tread Write, RAID1+RAID10

Результаты IOMeter: Multi-tread Write, RAID5+RAID6

Как и другие контроллеры такого же класса на этих дисках, LSI 8708EM2 выходит на максимальные скорости лишь при глубинах очереди больше единицы. При одном потоке лучшими оказываются 8-дисковые массивы, за исключением RAID10. Добавление второго потока, как всегда, заметно меняет картину. Та же тройка массивов из восьми дисков сохраняет достаточно высокие скорости, но теперь с ними успешно спорит RAID10 на четырех дисках, увеличивший скорость почти в два раза. Что интересно, при этом он обогнал такой же массив из восьми дисков — тот скорость не увеличил, а наоборот, уменьшил почти в два раза. Вот и как тут с уверенностью сказать, умеет ли контроллер распараллеливать два потока на зеркальные пары? Видимо, все же умеет, но не всегда это делает.

Отлично пережили добавление второго потока деградировавшие массивы RAID5 и RAID6 — они не только не сбавили скорость, но даже увеличили. Похоже, что для них второй поток стал своеобразным способом увеличить очередь и оптимизировать, таким образом, свои операции.

На трех потоках «просыпается» RAID10 на восьми дисках и обгоняет своего собрата из четырех дисков. По-прежнему великолепно ведут себя деградировавшие массивы, а первое место занимает RAID0 из восьми дисков — для него увеличение числа потоков стало компенсацией глубины очереди, так что скорость сбавлять он не собирается.

На четырех потоках все массивы из восьми дисков кроме RAID10 (даже деградировавшие) лишь увеличивают скорость. Да, этот контроллер любит большую нагрузку и много дисков. А вот RAID10 неожиданно потеряли свою прыть — четыре потока оказались им не по зубам.

И в очередной раз контроллер демонстрирует странности на записи — при одном потоке в лидеры выходят деградировавшие массивы, а RAID0 из восьми дисков падает в самый низ.

Добавление второго потока приводит к очередным перестановкам, причем найти в них закономерность невозможно — часть массивов увеличивает свою скорость, а часть уменьшает. И все это происходит без каких-либо заметных «привязок» количеству дисков или типу массива.

Дальнейшее увеличение количества потоков несколько стабилизирует картину, так чтов ней можно попробовать разобраться. Лучше всего справляются с многопоточной записью массивы RAID5 и RAID6 из большого количества дисков. А вот крайне невзлюбили многопоточную запись массивы RAID10 — они пишут даже чуть медленнее, чем одиночный диск.

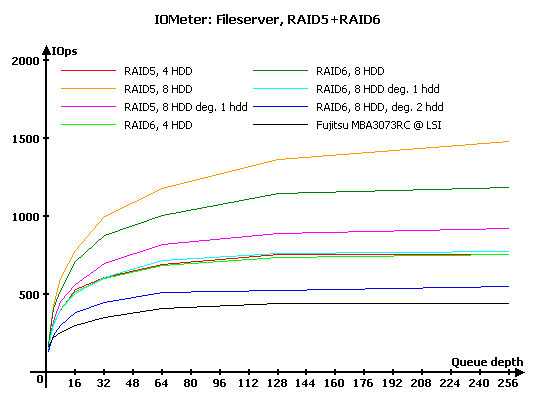

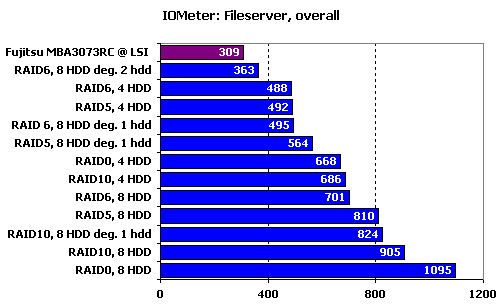

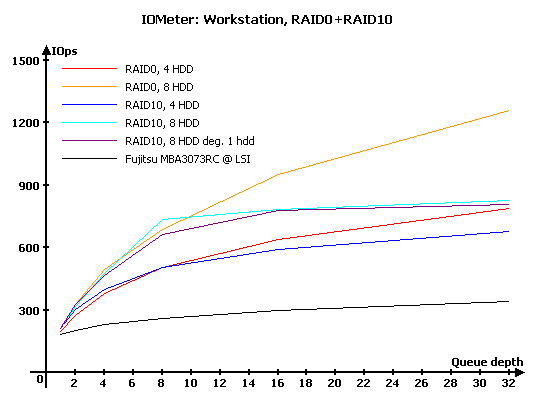

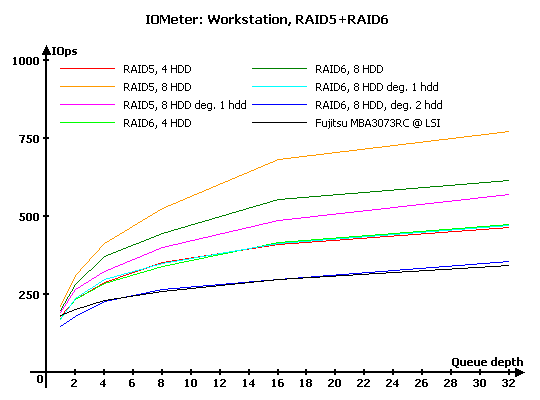

IOMeter: Webserver, Fileserver и Workstation

В данной группе тестов накопители тестируются под нагрузками, характерными для серверов и рабочих станций.

Напомню, что в «Webserver» и «Fileserver» эмулируется работа накопителя в соответствующих серверах, в то время как в «Workstation» мы имитируем работу накопителя в режиме типичной нагрузки для рабочей станции, с ограничением максимальной глубины очереди на уровне 32 запросов. Естественно, что «Webserver» и «Fileserver» — не более чем собирательные названия; первый будет весьма схоже эмулировать нагрузку любого сервера, работающего, фактически, только с запросами на чтение, а второй — сервера с преобладанием запросов на чтение, но при этом с определенной, заметно отличной от нуля долей запросов на запись.

Результаты IOMeter: Fileserver

Результаты IOMeter: Webserver

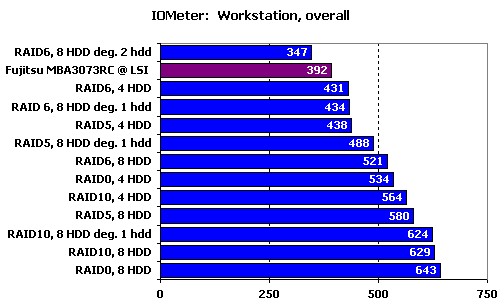

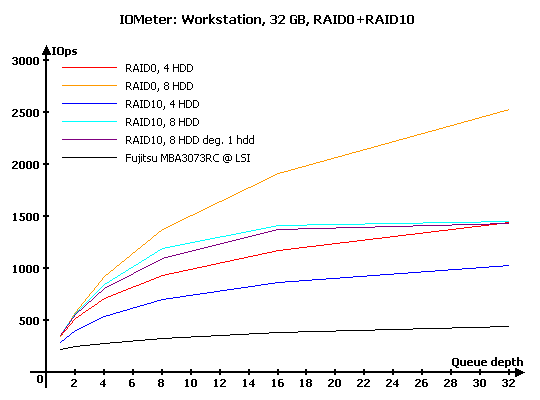

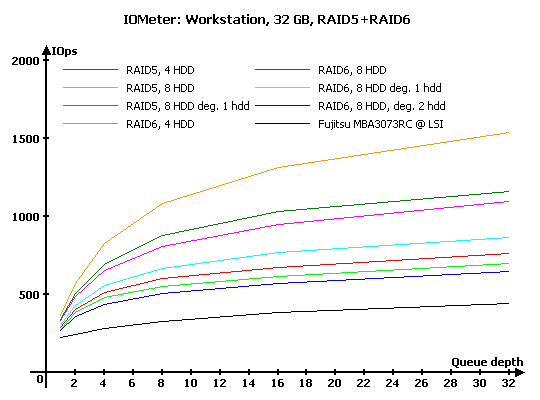

Результаты IOMeter: Workstation

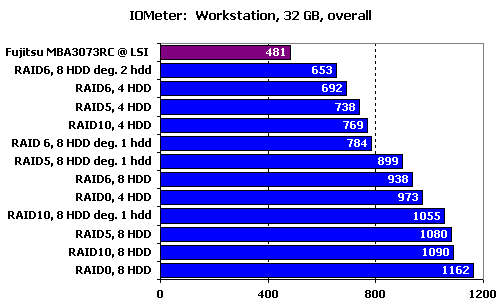

Результаты IOMeter: Workstation, 32 ГБ

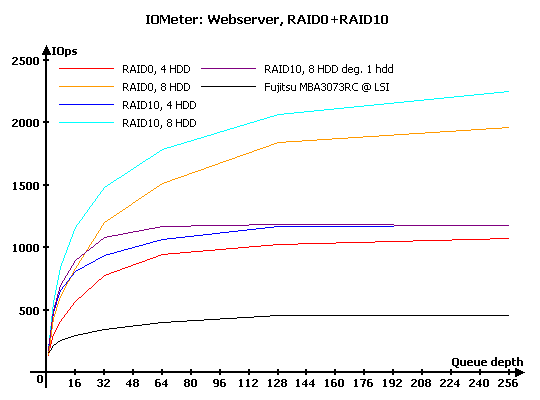

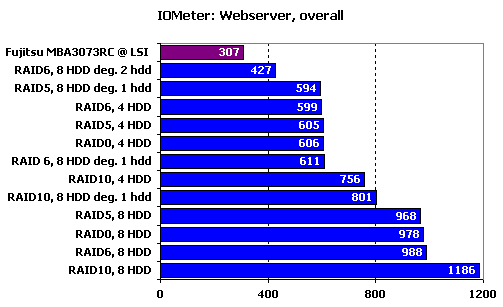

Нагрузка в виде исключительно запросов на чтение однозначно выделяет лидера, которым стал RAID10 — за счет очень эффективного чтения с зеркальных пар. Впрочем, обратите внимание, насколько сильно его портит потеря одного диска.

Массивы RAID5 и RAID6 идут практически вровень. Потеря одного из дисков обходится им в двукратное снижение производительности, а для RAID6 потеря еще одного диска выливается в повторное снижение скорости в два раза.

Итоговый рейтинг наглядно показывает, что при такой нагрузке количество дисков в массиве гораздо важнее типа массива. Но при прочих равных, стремясь к максимальной скорости, лучше все же выбирать RAID10.

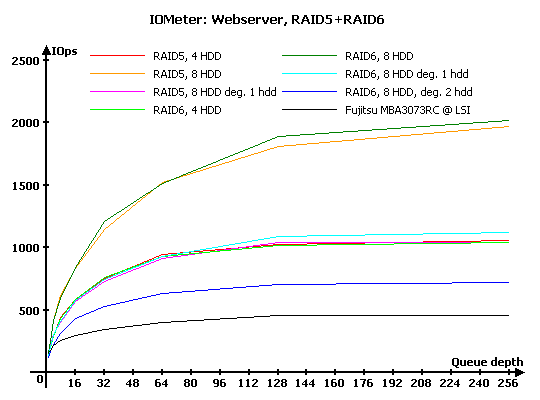

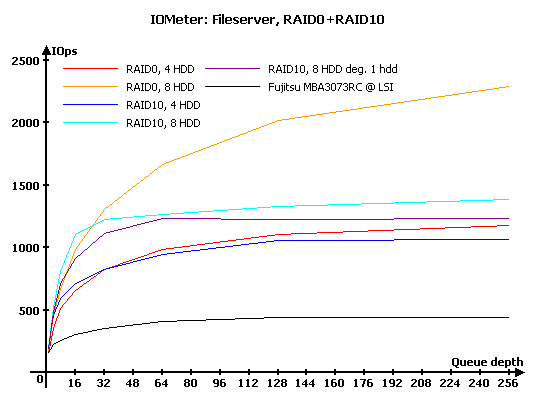

А вот появление запросов на запись снимает с RAID10 звание однозначного лидера. Он по-прежнему хорош на малых нагрузках, но на больших заметно проигрывает RAID0.

Если четырехдисковые RAID5 и RAID6 практически равны по производительности, то на восьми дисках RAID5 заметно опережает своего более надежного конкурента. Деградировавшие массивы заметно потеряли в скорости, но даже RAID6 без двух дисков держится сравнительно неплохо — часто такие массивы показывают заметно худшие результаты.

Даже больший вес результатов на малых глубинах очереди в нашем рейтинге не смог спасти RAID10 от значительного отставания по сравнению с RAID0. Массивам с записью контрольных сумм еще тяжелее — слишком уж «дорого» эти самые суммы им обходятся с точки зрения производительности.

На нагрузке, характерной для рабочих станций, массивы сохранили то же соотношение сил, что в и в сценарии «Fileserver». Чуть изменились положения лишь двух деградировавших массивов: RAID10 приблизился к полновесному массиву, а RAID6 без двух дисков — наоборот, «упал» до уровня одиночного диска.

Равномерно на меньшие места сползли все массивы RAID6. Впрочем, вряд ли кому-то придет в голову делать их основным накопителем высоконагруженной рабочей станции.

Уменьшение рабочей зоны дало эффект на результаты всех массивов, равномерно увеличив их превосходство над одиночным диском.

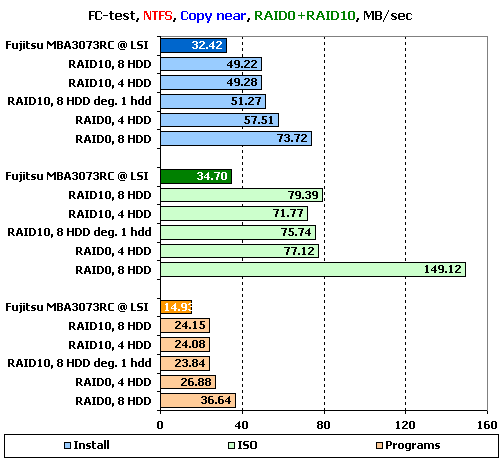

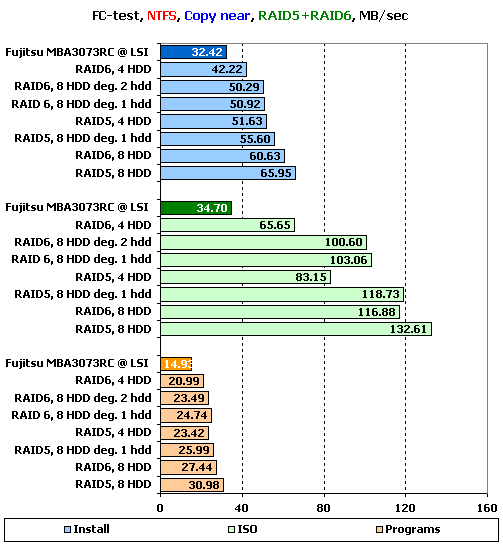

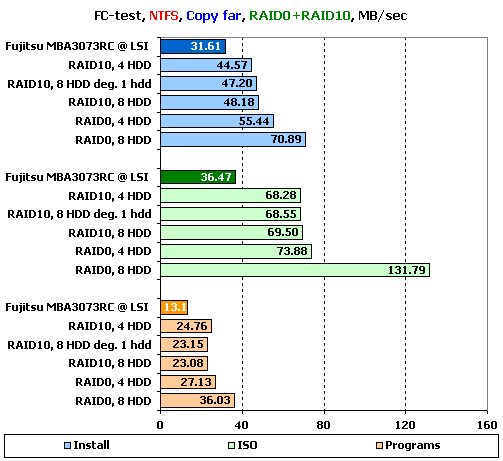

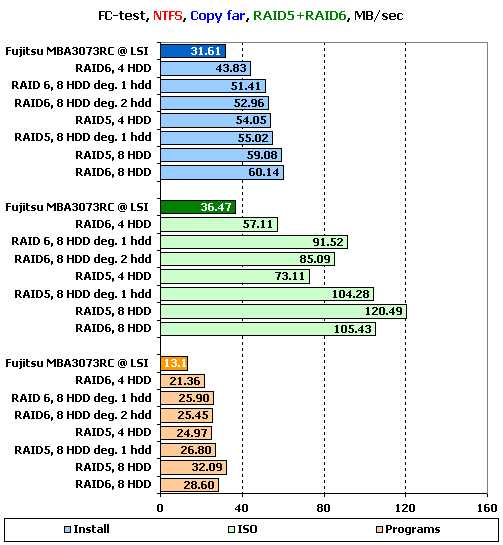

FC-Test

Следующим в нашей программе идет FileCopy Test. На накопителе создаются два раздела по 32 ГБ, размечаемые на двух этапах тестирования сначала в NTFS, а затем в FAT32, после чего на разделе создается определенный набор файлов, считывается, копируется в пределах раздела и копируется с раздела на раздел. Время всех этих операций фиксируется. Напомним, что наборы «Windows» и «Programs» включают в себя большое количество мелких файлов, а для остальных трех шаблонов («MP3», «ISO» и «Install») характерно меньшее количество файлов более крупного размера, причем в «ISO» используются самые большие файлы.

Не забывайте, что тест копирования не только говорит о скорости копирования в пределах одного накопителя, но и позволяет судить о его поведении под сложной нагрузкой. Фактически, во время копирования накопитель одновременно работает с двумя потоками, причем один из них на чтение, а второй — на запись.

Поскольку результатов получается много, то мы будем подробно рассматривать лишь значения, достигнутые на наборах файлов «Install», «ISO» и «Programs» в NTFS, являющихся более характерными для обычного использования массивов. Остальные результаты вы, при желании, можете узнать из таблиц ниже:

Результаты FC-Test: NTFS

Результаты FC-Test: FAT32

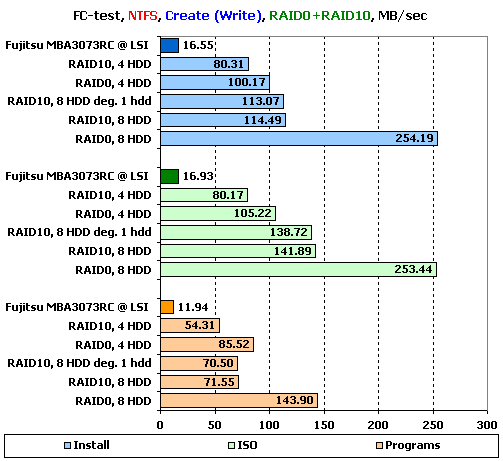

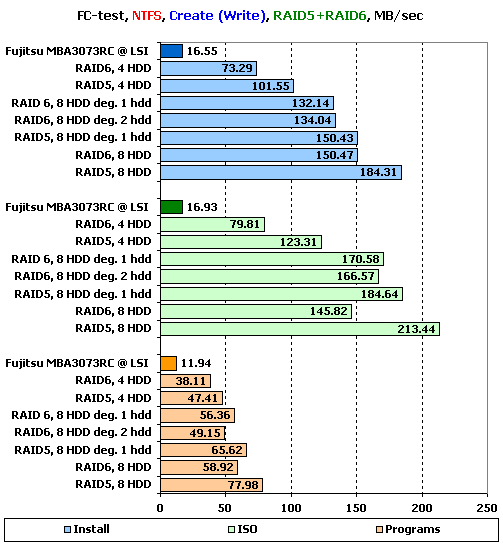

В принципе, расстановка сил на создании файлов вполне логичная, вот только скорости как-то слишком уж невелики. Конечно, 254 МБ/с у RADI0 радуют взгляд, но не забывайте, что это массив из восьми дисков, то есть, мы вправе здесь ожидать результата раза в три лучше.

Ту же картину мы видим и на втором наборе массивов: расстановка сил вполне закономерная, за исключением излишне скромных результатов RAID6 на восьми дисках, но все скорости явно недостаточны.

В общем, запись является откровенно слабой стороной этого контроллера, как минимум в текущей версии прошивки.

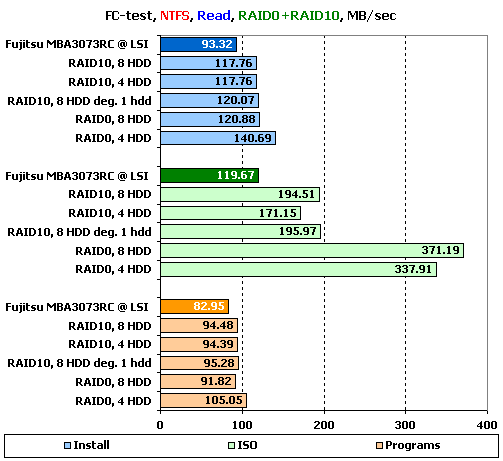

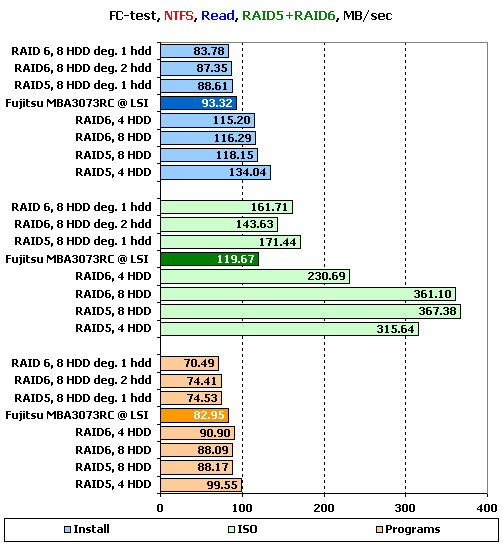

На чтении дело обстоит чуть лучше, но появляются странности. Так, RAID0 из восьми дисков в наборе «Install» проигрывает такому же массиву, но из четырех дисков. На том же наборе скорость всех массивов RAID10 оказывается одинаковой, что несколько странно.

Не лишено неожиданных моментов и чтение с массивов с записью контрольных сумм. Все на том же наборе «Install» лидирует RAID5 на четырех дисках, а не на восьми, как можно было бы ожидать.

Обратите внимание на интересный момент: на больших файлах в «ISO» деградировавшие массивы демонстрируют большую скорость, чем одиночный диск, а вот на малых файлах они ему уже проигрывают.

На копировании в пределах раздела больших файлов неожиданно очень хорошо проявил себя RAID0 из восьми дисков. Если скорость остальных массивов находится на примерно равном уровне и примерно такая же, как и у других контроллеров, то на данном сочетании нагрузки и массива мы видим вдвое больший результат.

Копирование в массивах RAID5 и RAID6 проходит без особых приключений. Все массивы демонстрируют радующие взгляд высокие скорости и располагаются в логичном порядке. Лишь RAID5 из четырех дисков в «ISO» несколько «притормозил».

Увеличение дальности копирования никаких серьезных изменений не принесло — все массивы снова очень неплохо справились с этой задачей.

WinBench 99

Ну и в завершение — привычные графики чтения в «WinBench 99». К сожалению, нам не удалось снять график для деградировавшего на два диска RAID6 — тест упорно выдавал ошибку.

График чтения одиночного диска Fujitsu_MBA3073RC на LSI SAS3041E-R

Графики чтения RAID-массивов на LSI 8708EM2:

График чтения RAID0, 4 диска

График чтения RAID0, 8 дисков

График чтения RAID10, 4 диска

График чтения RAID10, 8 дисков

График чтения RAID10, 8 дисков минус один

График чтения RAID5, 4 диска

График чтения RAID5, 8 дисков

График чтения RAID5, 8 дисков минус один

График чтения RAID6, 4 дисков

График чтения RAID6, 8 дисков

График чтения RAID6, 8 дисков минус один

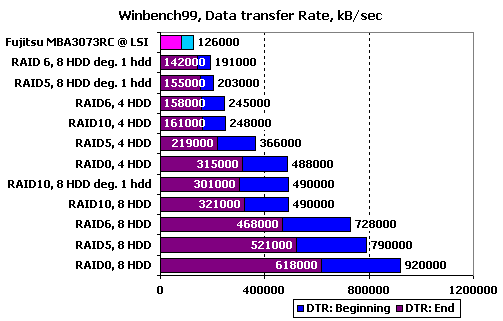

Сравним массивы по продемонстрированным скоростям чтения в начале и конце получившихся разделов:

Все на своих местах, никаких провалов нет, скорости от массива к массиву растут абсолютно предсказуемо с почти идеальной (RAID5 на восьми дисках чуть портит картину) масштабируемостью — любо-дорого посмотреть.

Подведение итогов

Каков же будет наш вердикт RAID-контроллеру LSI MegaRAID SAS 8708EM2? Его явным достоинством является очень неплохая работа на чтении, причем контроллер предпочитает выполнять тяжелые нагрузки на массивах из большого количества дисков. Особенно удался компании LSI выбор диска с меньшим откликом в зеркальных парах — его эффективность очень высока. Хорошо справился контроллер и с чтением с деградировавших массивов — его процессора вполне хватает на получение приличных скоростей даже с RAID6, лишившегося двух дисков. Да и с многопоточным чтением у него все на должном уровне. А вот в чем у этого контроллера слабость, так это в записи. Возможно, сказался меньший, по сравнению с конкурентами, объем буферной памяти, возможно — несовершенство прошивки, но факт остается фактом — если ваша нагрузка подразумевает большое количество операций записи, то этот контроллер не для вас.

Другие материалы по данной теме

Тестирование SAS RAID-контроллера Adaptec RAID ASR-5805

Тестирование SAS RAID-контроллера 3ware 9690SA-8I

Тестирование SAS RAID-контроллера Promise SuperTrak EX8650