Ваш город: Москва

Тестирование SAS RAID-контроллера HighPoint RocketRAID HPT4320

Введение

Мы продолжаем тестировать RAID-контроллеры с поддержкой SAS-дисков, и сегодня в наши руки попала продукция компании HighPoint. Как и остальные производители «первого эшелона», эта компания не пропустила переход SAS-накопителей из категории «уникальные быстрые диски» в сферу достаточно распространенных серверных решений и выпустила соответствующие контроллеры. Причем не одну серию, а сразу две: RocketRAID 43xx и 26хх. В первую вошли модели, несущие «на борту» буферную память и полноценный процессор, обеспечивающий расчет контрольных сумм в массивах RAID5 и RAID6. В серии же RocketRAID 26хх вышли модели попроще — в них все операции с контрольными суммами выполняются драйвером, то есть, они работают за счет вычислительных мощностей самого сервера. Грубо говоря, перед нами все те же уже хорошо известные контроллеры серии RocketRAID 26хх, только теперь поддерживающие диски как с интерфейсом SATA, так и с SAS. Любопытно, что все они довольствуются четырьмя линиями PCI-Express, в то время как все модели старшей серии 43хх используют восемь линий.

Поскольку в этой серии тестов мы, в некотором роде, являемся максималистами, то нам интересна как раз старшая серия, RocketRAID 43xx. Она стала логическим продолжением серии SATA-контроллеров RocketRAID 35хх — та же шина PCI-Express (о PCI-X и разговора не идет — этот интерфейс весьма быстро похоронили все производители), схожий дизайн. Но возросла частота процессора — с 800 МГц до 1,2 ГГц, причем процессор стал двухъядерным. Похоже, что закономерным образом возросло и тепловыделение — если раньше все модели довольствовались пассивным охлаждением, то в серии с поддержкой SAS-накопителей даже самая младшая модель имеет вентилятор. Правда, во время эволюционного развития произошли и потери — исчезли многопортовые комбинации, на текущий момент серия RocketRAID 43xx ограничена сверху восьмипортовыми моделями, в то время как в RocketRAID 35хх была 24-портовая модель. Хочешь не хочешь, а для подключения большого количества дисков необходимо использовать экспандеры.

HighPoint RocketRAID HPT4320

Попавший нам в руки HighPoint RocketRAID HPT4320 является моделью с восемью внутренними портами, то есть оснащен двумя разъемами SFF-8087. Также в серию входят еще две восьмипортовых модели (два внешних разъёма или один внешний и один внутренний) и две четырехпортовых (с внешним или внутренним разъёмом).

Комплект поставки контроллеров у компании HighPoint мало чем отличается от аналогичных наборов других производителей — помимо собственно контроллера, в него входит инструкция, диск с драйверами, два шлейфа, каждый из которых обеспечивает подключение до четырех устройств, да сменная низкопрофильная планка. Да, наш контроллер низкопрофильный — в этой серии они все такие, кроме модели с двумя внешними разъёмами.

Обращает на себя внимание сетевой разъем на торце контроллера. Он предназначен для удаленного управления контроллером и является приятным дополнением к стандартным средствами управления (BIOS при загрузке, специализированное программное обеспечение, удаленный доступ по сети через работающую на сервере ОС).

Если процессор у всех контроллеров серии одинаковый, то вот объем встроенной памяти разный. И модели RocketRAID4320 не повезло — ей достались «лишь» 256 МБ, как и четырехпортовым собратьям, а вот в восьмипортовых экземплярах с внешними разъёмами используются 512 МБ. Компания HighPoint стеснительно умалчивает скорость памяти, ограничиваясь описанием «DDR-II ECC», мы же будем подробнее — на контроллере установлены модули памяти Qimonda HYB18TS12160B2F-3S, согласно маркировке, работающие на частоте 667 Гц.

Все контроллеры серии RocketRAID 43xx поддерживают точно такой же набор возможных типов массивов, как и их предшественники, а именно:

одиночный диск,

RAID0,

RAID1,

RAID3,

RAID5,

RAID6,

RAID10,

RAID50.

В принципе, в этом списке не хватает RAID60 — страйпа из массивов RAID6. Ну да не велика потеря — столь своеобразная комбинация нужна лишь очень немногим. Зато есть RAID3 — редко встречающийся в текущее время тип массива. Он очень близок к RAID5 (если быть совсем точным — является его предком), отличаясь от него тем, что контрольные суммы в RAID3 не распределяются равномерно по всем дискам, как в RAID5, а записываются лишь на один определенный диск, причем все данные разбиваются на блоки по одному байту. Несложно понять, почему этот тип массивов пользуется малой популярностью — используемый тип разбиения данных приводит к проблемам со скоростью, а выделение одного диска под контрольные суммы гарантирует ему значительно более высокую нагрузку, чем всем остальным дискам массива.

К сожалению, контроллер попал к нам в руки без батареи резервного питания, но оказался столь любезен, что не стал по этой причине отключать механизмы кэширования. Мы же в очередной раз напоминаем, что информация (и время на ее восстановление) стоит очень дорого, так что не стоит использовать контроллеры без батареи питания — в случае сбоя в кэше может пропасть ощутимое количество данных, в том числе и служебных. То, что мы можем позволить себе во время теста использовать контроллеры без батареи, ни в коей мере не должно толкать здравомыслящих людей на подобный шаг в случае реальных серверов с реальными данными.

Методика тестирования

Во время тестирования использовались следующие программы:

IOMeter версии 2003.02.15;

WinBench версии 99 2.0;

FC-Test версии 1.0;

Тестовая система была следующей:

корпус Intel SC5200;

системная плата Intel SE7520BD2;

два процессора Intel Xeon 2,8 ГГц на 800-МГц системной шине;

2 х 512 МБ регистровой памяти DDR PC3200 ЕСС

жесткий диск IBM DTLA-307015 объемом 15 ГБ в качестве системного диска;

видеокарта — встроенное видео ATI Rage XL

операционная система Microsoft Windows 2000 Professional SP4

Kонтроллер во время тестов устанавливался в слот PCI-Express x8 на материнской плате. Для тестирования использовались жесткие диски Fujitsu MBA3073RC, установленные в штатные салазки корпуса SC5200 и закрепленные в них четырьмя винтами за нижнюю грань. Контроллер тестировался с использованием четырех и восьми жестких дисков в следующих режимах:

RAID0;

RAID10;

деградировавший восьмидисковый RAID10 без одного диска;

RAID5;

RAID5;

деградировавший восьмидисковый RAID5 без одного диска;

RAID6;

деградировавший восьмидисковый RAID6 без одного диска;

деградировавший восьмидисковый RAID6 без двух дисков.

Поскольку мы стараемся максимально полно охватить все возможные типы массивов, то включаем в тестирование и рассмотрение деградировавших массивов. Данным термином обозначаются массивы с избыточностью данных, в которых один или несколько дисков (в зависимости от типа массива) вышли из строя, но при этом массив все еще хранит все данные и является рабочим.

Для сравнения мы будем везде приводить результаты одиночного диска Fujitsu MBA3073RC, полученные на контроллере LSI SAS3041E-R, считая их неким базовым уровнем производительности. Сразу оговоримся, что у такого сочетания есть одна хорошо известная нам проблема: его скорость записи в «FileCopy Test» всегда очень мала.

Размер страйпа на массивах всех типов задается равным 64 кБ.

В контроллер была прошита самая последняя доступная на сайте производителя на момент тестирования версия BIOS и использовались самые свежие драйвера. Соответственно, мы использовали прошивку 1.2.12.11 и драйвера 1.2.19.4.

IOMeter: Database

Как всегда, начнем, пожалуй, с наиболее интересного с точки зрения нагрузки на контроллер теста — «Database», с помощью которого мы выясняем способность контроллеров работать с потоками запросов на чтение и запись 8-кБ блоков данных со случайной адресацией. В ходе тестирования происходит последовательное изменение процентного соотношения запросов на запись от нуля до ста процентов (с шагом 10 %) от общего количества запросов и увеличение глубины очереди команд от 1 до 256.

Численные результаты измерений здесь и далее вы можете, при желании, увидеть в соответствующих таблицах по ссылкам, мы же будем работать с графиками и диаграммами.

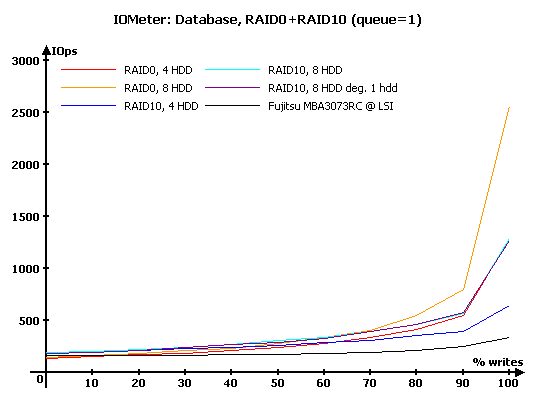

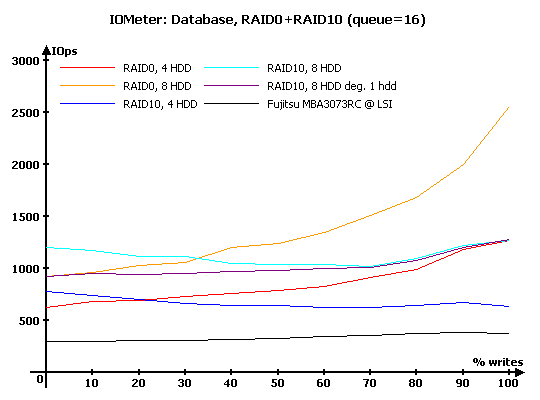

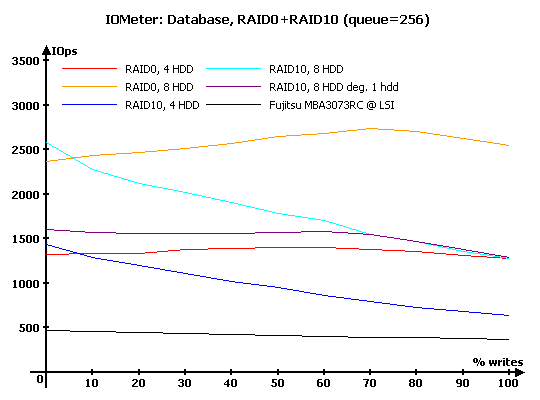

Результаты IOMeter: Database, RAID1+RAID10

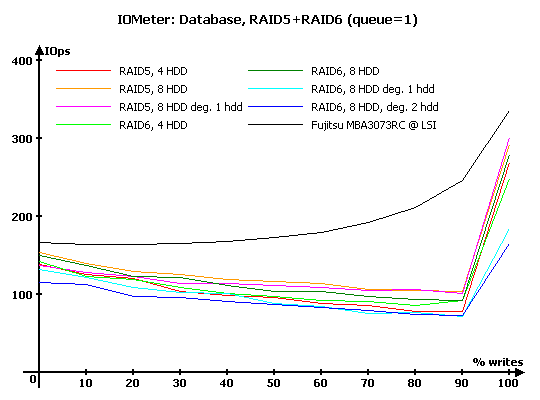

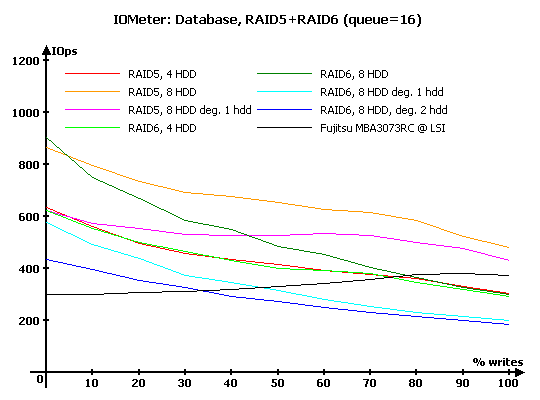

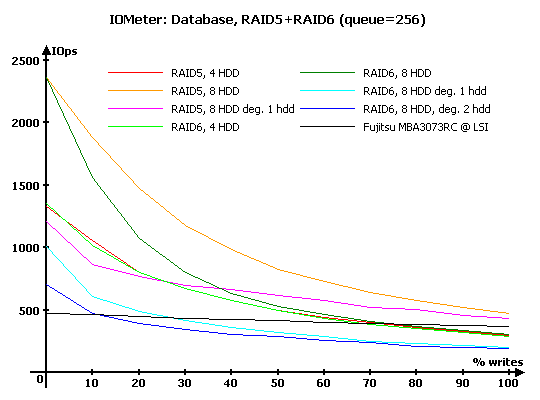

Результаты IOMeter: Database, RAID5+RAID6

На минимальной нагрузке у массивов RAID0 и RAID10 все в полном порядке — отложенная запись работает как и положено, поэтому массивы демонстрируют очень хорошую масштабируемость производительности на записи в зависимости от количества дисков в них. Напомним, что RAID10 с точки зрения операций записи должен быть равноценен по производительности RAID0 из вдвое большего количества дисков — каждая зеркальная пара дисков пишет данные синхронно.

А вот у массивов RAID5 и RAID6 при глубине очереди в один запрос явные проблемы с производительностью. Она весьма схожа у всех массивов, независимо от их типа (меньшими значениями выделяются разве что деградировавшие RAID6) — во всех случаях производительность меньше, чем у одиночного диска. Судя по всему, контроллер просто выполняет запросы, даже не озадачиваясь вопросами их кэширования. Но в таком случае, откуда столь резкий прирост производительности в ситуации, когда контроллер получает лишь запросы на запись, если до этого увеличение количества запросов на запись уменьшало производительность? Прошивка контроллера «просыпается» и пытается все же их кэшировать? Но тогда она все равно делает это как-то слишком неэффективно. Недоработка, причем серьезная.

С увеличением нагрузки до шестнадцати запросов в очереди контроллер демонстрирует вполне ожидаемый рост производительности и характерные особенности прошивки при работе с массивами разных типов. Так, можно с удовлетворением отметить, что контроллер умеет весьма эффективно выбирать в зеркальных парах диск, с которого он может быстрее считать данные. Именно эта особенность прошивки позволяет при преобладании операций чтения массивам RAID10 обгонять RAID0. А вот деградировавший RAID10 на такое не способен — потеря диска приводит к тому, что контроллер перестает вообще искать «удачные» диски в парах (а ведь мог бы, в тех парах, которые остались целыми).

Массивы с контрольными суммами с увеличением нагрузки поднимают свою производительность на чтении до нормального уровня, но вот с записью у них по-прежнему проблемы — скорости слишком малы, особенно у деградировавших массивов. Впрочем, полноценные RAID5 и RAID6 из восьми дисков также пишут недостаточно быстро для массивов из дисков со столь малым временем отклика, как у используемых нами Fujitsu MBA3073RC.

Увеличиваем нагрузку до 256 запросов. Деградировавший RAID10 на всех нагрузках, кроме чистой записи, превосходит RAID0 из четырех дисков — видимо, на столь больших глубинах очереди драйвер все же ищет «удачные» диски в оставшихся целыми зеркальных парах. И все же, падение производительности деградировавшего массива по сравнению с полноценным при превосходстве операций чтения очень и очень заметно.

Во второй группе массивов все деградировавшие варианты, что оба RAID6, что RAID5, выглядят весьма печально — их производительность крайне невысока как на чтении, так и на записи. Печалят и полноценные RAID6 — даже 8-дисковый массив справляется с записью хуже, чем одиночный диск.

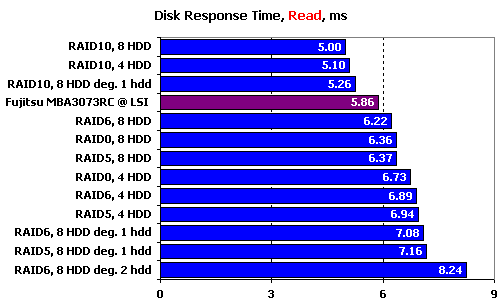

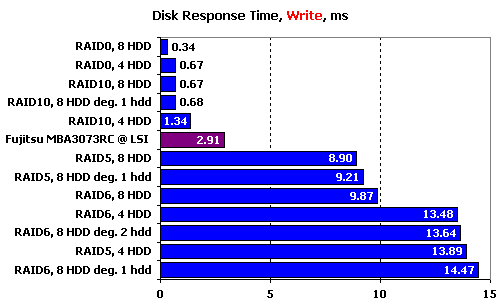

IOMeter: Disk Response Time

Для измерения времени отклика мы в течении десяти минут при помощи IOMeter отправляем на накопитель поток запросов на чтение или запись блоков данных по 512 байт при глубине очереди исходящих запросов, равной единице. Количество запросов, обработанных накопителем, превышает шестьдесят тысяч, так что мы получаем устоявшееся время отклика накопителя, не зависящее от объема буферной памяти.

Благодаря эффективному чтению с зеркальных пар, массивы RAID10 показывают меньшее время отклика на чтении, чем одиночный диск. Причем деградировавший массив лишь чуть хуже нормальных — данные он предоставляет за впечатляюще малое для жестких дисков время.

Все остальные массивы выстроились по убывающей вслед за одиночным диском — у 8-дисковых массивов отклик больше на полсекунды, 4-дисковые прибавляют еще столько же. Замыкают список деградировавшие массивы, а самым последним ожидаемо становится RAID6 без двух дисков — восстановление данных сразу из двух контрольных сумм ощутимо усложняет доступ к ним.

На записи масивы RAID0 и RAID10 ведут себя вполне ожидаемо — чем больше суммарного кэша у массива (читай, дисков или зеркальных пар), тем меньше время отклика. А вот у массивов с созданием контрольных сумм явные проблемы — они минимум втрое, а некоторые и впятеро, медленнее одиночного диска. Похоже, что мы видим другую сторону той проблемы, которую мы ранее наблюдали в тесте «Database» при минимальной глубине очереди.

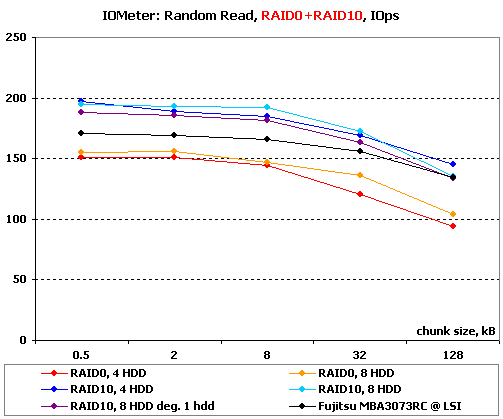

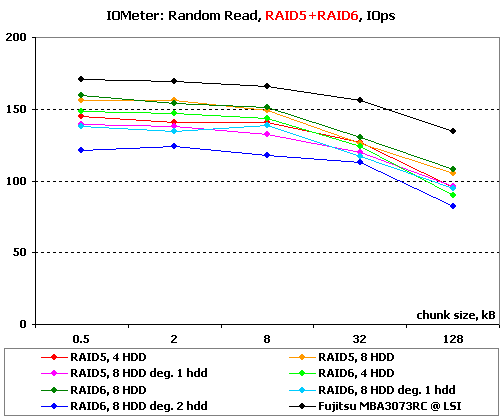

IOMeter: Random Read & Write

Оценим теперь зависимости производительности контроллеров в режимах чтения и записи с произвольной адресацией от размера используемого блока данных.

Результаты, полученные при работе со случайной адресацией данных, рассмотрим в двух вариантах. На блоках малого размера построим зависимости количества операций в секунду от размера используемого блока. А на больших блоках вместо количества операций возьмем в качестве критерия производительности скорость в мегабайтах в секунду. Такой подход позволяет оценить работу массивов сразу в двух типичных случаях нагрузки: работа малыми блоками характерна для баз данных, и для нее более важно количество операций в секунду, чем привычная скорость, а вот работа большими и очень большими блоками близка к реальной работе с файлами малых размеров, и здесь уже на первый план выходит именно скорость в привычных мегабайтах в секунду.

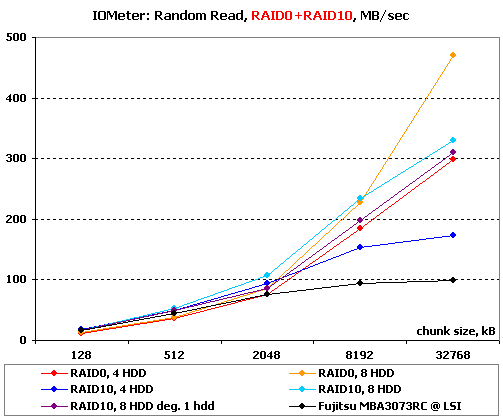

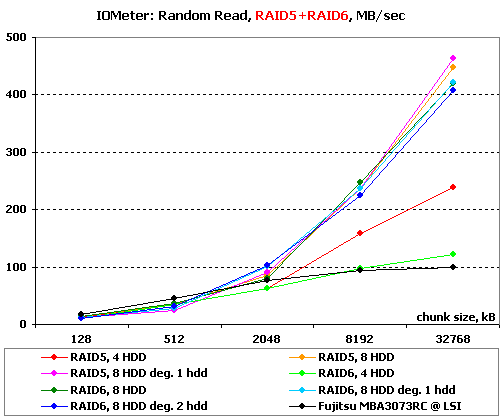

Начнем с чтения.

Результаты IOMeter: Random Read, операций/с

Результаты IOMeter: Random Write, МБ/с

На чтении малыми блоками мы видим лишь повторную демонстрацию эффективного поиска диска с меньшим временем отклика в зеркальных парах на RAID10.

Все массивы с записью контрольных сумм идут весьма плотной группой. Пожалуй, можно отметить лишь пару закономерностей — первой является то, что даже на чтении очень малых блоков (меньше размера страйпа) массивы с большим числом дисков чуть быстрее. Ну а вторым моментом снова является тот факт, что чтение с RAID6 без двух дисков заметно теряет в скорости — если вы предполагаете, что часто будете оказываться в такой ситуации, то лучше ориентироваться на массивы RAID10.

Обратите внимание, насколько долго держится RAID10 в лидерах — даже при размере блока 8 МБ (вполне себе размер документа, музыкального файла или хорошей фотографии) он умудряется на равных идти с массивом RAID0 из восьми дисков. Деградировавший же RAID10 стабильно оказывается чуть-чуть, но все же быстрее RAID0 из четырех дисков.

В случае с RAID5 и RAID6 все 8-дисковые массивы идут, что называется, нога в ногу, включая деградировавшие варианты. А вот 4-дисковый массив RAID6 огорчает — его скорость даже на очень больших блоках мало отличается от одиночного диска.

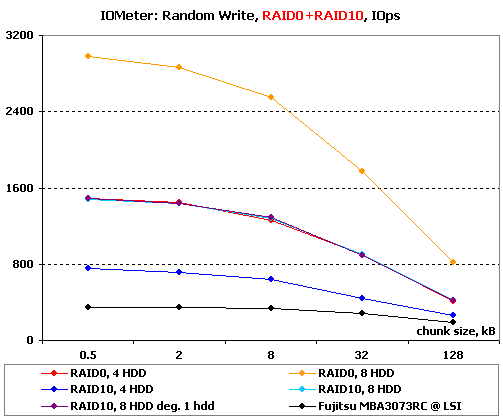

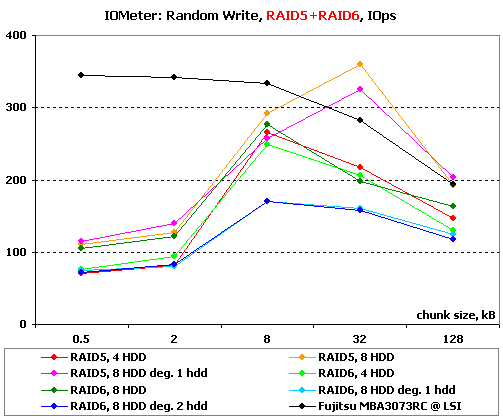

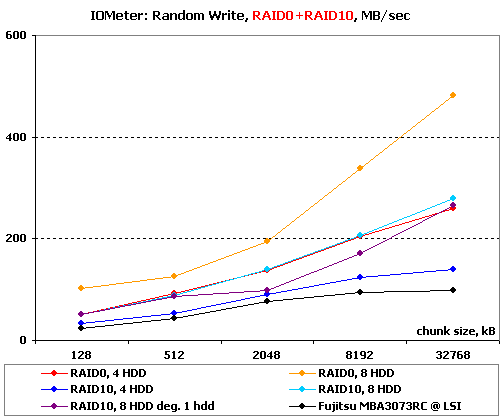

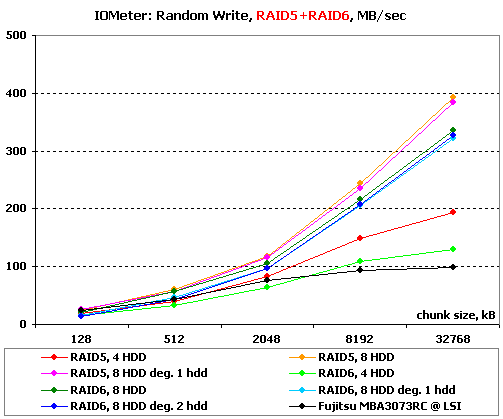

Перейдем к операциям записи со случайной адресацией.

Результаты IOMeter: Random Write, операций/с

Результаты IOMeter: Random Write, МБ/с

На мелких блоках в этой группе массивов все очень хорошо — перед нами почти идеальное масштабирование.

А вот про RAID5 и RAID6 такого не скажешь — у них на записи малыми блоками проблемы, причем очень ощутимые. Похоже, что мы видим объяснение как очень высокому времени отклика на записи, так и поведению в «Database». Ярче всего это видно на полноценных 8-дисковых массивах — при уменьшении размера блока до 8 кБ их производительность резко падает, более того, она продолжает дальше снижаться с уменьшением блока, хотя нормальным поведением для массивов является пусть небольшой, но все же рост. Особенно тяжко приходится и без того не блиставшим скоростью 4-дисковым и деградировавшим массивам. Мда, если в RAID3 у контроллера такое же поведение, то скорости должны быть и вовсе никакие.

На записи большими блоками в случае RAID0 и RAID10 мы видим некоторые необъяснимые флуктуации производительности, но все же они не настолько велики, чтобы считать их проблемными.

А вот с большими блоками на массивах RAID5 и RAID6 наш подопытный справляется очень хорошо. Более того, деградировавшие массивы очень слабо отличаются от своих полноценных собратьев. В общем, хранить большие файлы на этих массивах можно, а вот маленькие — не стоит.

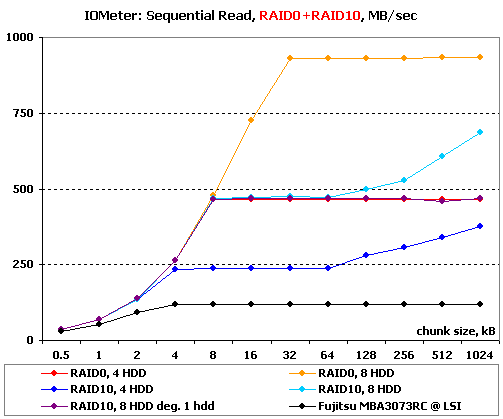

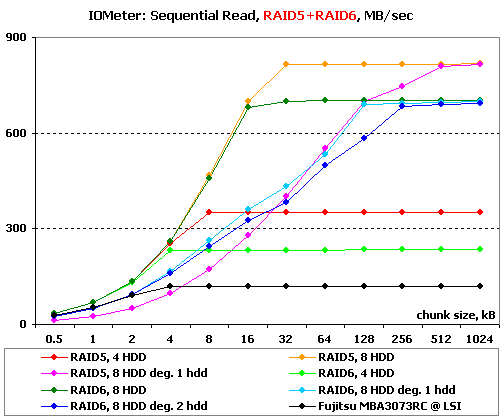

IOMeter: Sequential Read & Write

Ну что ж, пора оценить способности контроллеров в последовательных операциях. В данном тесте на накопители подается поток запросов с глубиной очереди команд, равной четырем. Раз в минуту размер блока данных увеличивается. В итоге мы получаем возможность проследить зависимость линейных скоростей чтения и записи массивов от размеров используемых блоков данных и оценить максимальные достижимые скорости.

Результаты IOMeter: Sequential Read

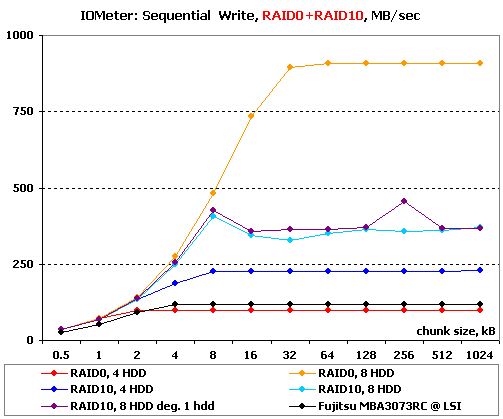

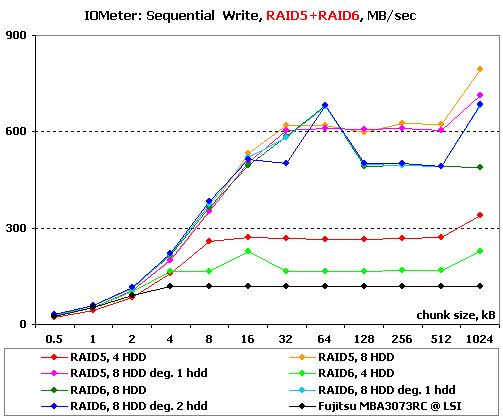

Результаты IOMeter: Sequential Write

Отличные графики чтения! Масштабируемость на месте, с малыми блоками все в порядке, и даже чтение сразу с двух дисков в зеркальных парах на больших блоках вполне себе заметно без лупы.

Такую же отличную ситуацию мы видим и в случае полноценных массивов RAID5 и RAID6. Интересно ведут себя деградировавшие массивы — в основном они проигрывают по скорости своим полноценным собратьям, но лишь из-за того, что выходят на максимальную скорость на блоках несколько большего размера. Зато по максимальной скорости они не отличаются от собратьев — не так уж и часто увидишь столь хороший результат.

А вот с линейной записью у массивов RAID0 и RAID10 чуть хуже, чем с чтением. Виной тому неожиданно низкая скорость массива RAID0 из четырех дисков и непонятные флуктуации скорости у восьмидисковых RAID10 — максимальная скорость на них выглядит не закономерностью, а случайным достижением.

Есть проблемы с записью и у массивов RAID5 и RAID6. У всех массивов мы видим явную «любовь» к большим блокам — даже мегабайтный блок им, судя по всему, кажется недостаточным для демонстрации максимальной скорости, а ведь полный страйп даже для восьми дисков набирается уже на 512-кБ блоке. Массивы RAID6 дополнительно демонстрируют еще и скачки производительности на отдельных блоках, говорящие о неидеальной работе алгоритмов прошивки.

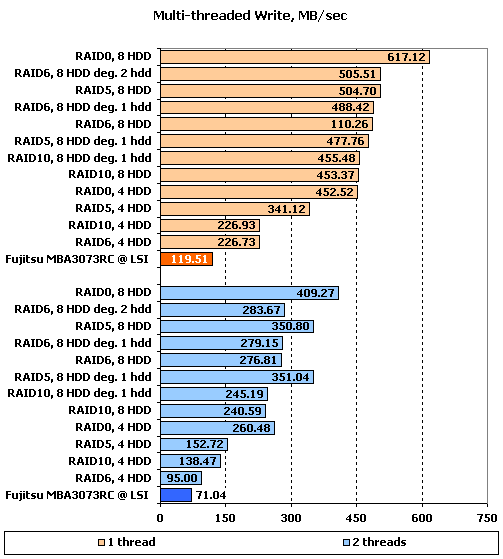

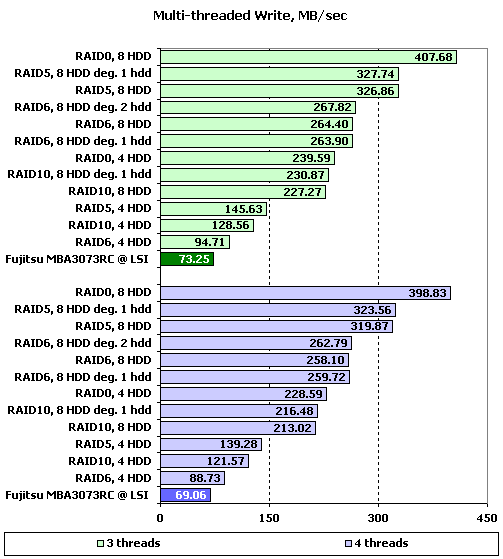

IOMeter: Multi-thread Read & Write

Данный тест позволяет оценить поведение контроллеров при многопоточной нагрузке. В ходе него эмулируется ситуация, когда с накопителем работает от одного до четырех приложений, причем количество запросов от них изменяется от одного до восьми, а адресные пространства каждого приложения, роли которых выполняют worker-ы в IOMeter, не пересекаются.

При желании, вы можете увидеть таблицы с результатами тестирования по соответствующим ссылкам, а мы же в качестве наиболее показательных рассмотрим диаграммы записи и чтения для ситуаций с глубиной очереди в один запрос, поскольку при количестве запросов в очереди, равном двум и более, значения скоростей практически не зависят от количества приложений.

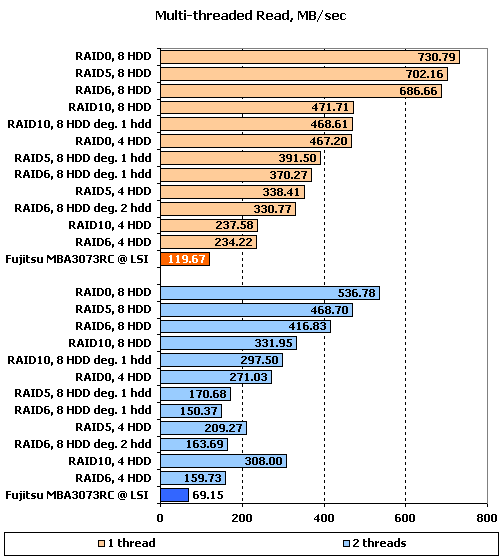

Результаты IOMeter: Multi-tread Read, RAID1+RAID10

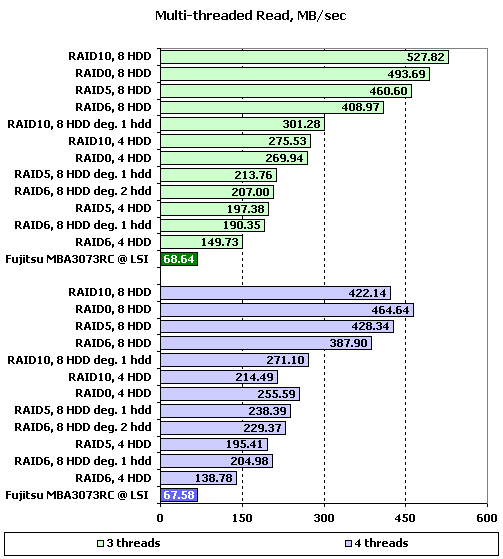

Результаты IOMeter: Multi-tread Read, RAID5+RAID6

Результаты IOMeter: Multi-tread Write, RAID1+RAID10

Результаты IOMeter: Multi-tread Write, RAID5+RAID6

Результаты чтения одного потока радуют — все массивы выстроились по производительности вполне логичным образом, а главное — значения скоростей приятно велики. Конечно, максимальные скорости и на этом контроллере, как и на ранее протестированных, можно увидеть лишь при глубине очереди, большей единицы, но все же результаты HighPoint RocketRAID4320 при минимальной очереди весьма неплохи.

Добавление второго потока привычно снижает скорости массивов всех типов. За одним исключением — судя по тому, что его скорость выросла, RAID10 на четырех дисках сумел распознать двухпоточность нагрузки и направить каждый поток на отдельный диск зеркальной пары. К сожалению, восьмидисковый RAID10 такого же поведения не демонстрирует — то ли контроллер не сумел распознать характер нагрузки, то ли что-то еще, но факт остается фактом: данный функционал прошивки работает несколько нестабильно.

Дальнейшее увеличение количества потоков приводит к забавным результатам: на трех потоках оба RAID10 выглядят просто великолепно, а вот четыре потока становятся для них проблемой, хотя, казалось бы, проще распараллеливать как раз четное число потоков.

Что же касается деградировавших массивов, то они во всех случаях достаточно неплохи по скорости, без каких-либо ужасающих провалов, хотя и работают заметно медленнее своих полноценных аналогов.

Запись одного потока также, как и чтение, проходит очень хорошо — массивы распределились по производительности вполне логичным и предсказуемым образом, а их скорости весьма высоки.

С увеличением количества потоков до двух мы видим, как большинство массивов равномерно уменьшают скорость. Но есть и приятно выделяющийся «белые вороны» — ими стали оба массива RAID0 и восьмидисковые RAID5, обычный и деградировавший.

Дальнейшее увеличение числа потоков ничего нового не приносит — все массивы понемногу снижают скорость, расстановка же сил не меняется.

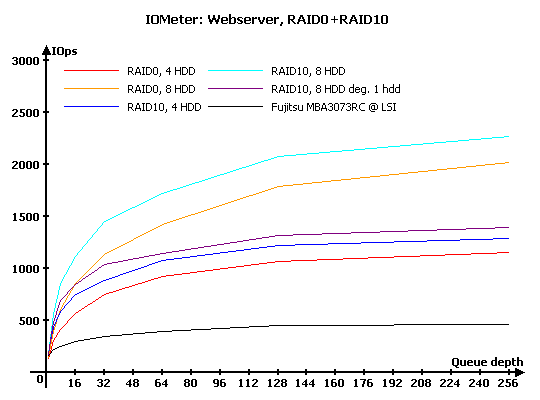

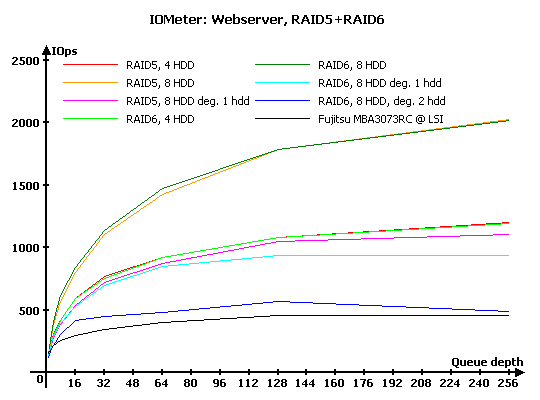

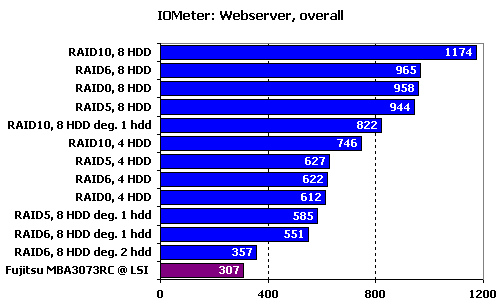

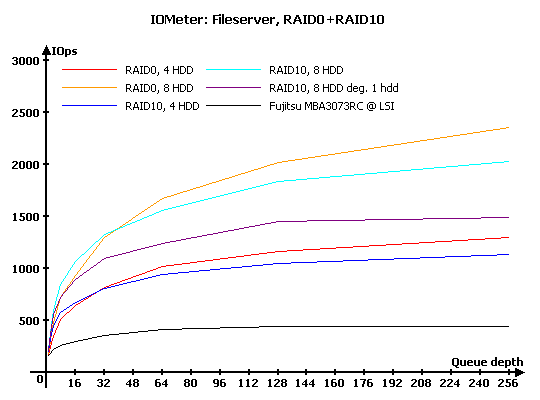

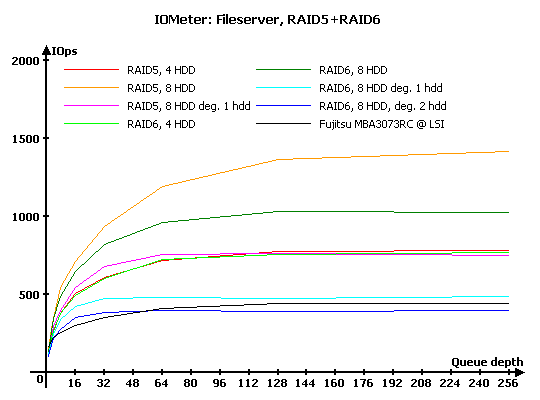

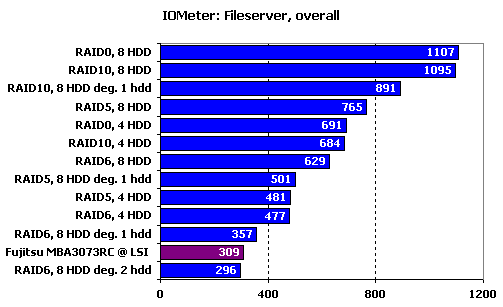

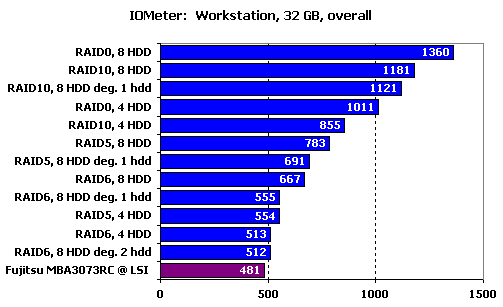

IOMeter: Webserver, Fileserver и Workstation

В данной группе тестов накопители тестируются под нагрузками, характерными для серверов и рабочих станций.

Напомним, что в шаблонах нагрузки «Webserver» и «Fileserver» эмулируется работа накопителя в соответствующих серверах, в то время как в «Workstation» мы имитируем работу накопителя в режиме типичной нагрузки для рабочей станции, с ограничением максимальной глубины очереди в 32 запроса. Естественно, что «Webserver» и «Fileserver» — не более чем собирательные названия; первый будет весьма схоже эмулировать нагрузку любого сервера, работающего, фактически, только с запросами на чтение, а второй — сервера с преобладанием запросов на чтение, но при этом с определенной, заметно отличной от нуля долей запросов на запись.

Результаты IOMeter: Fileserver

Результаты IOMeter: Webserver

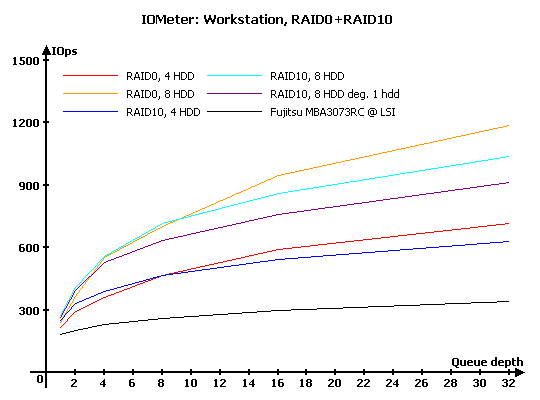

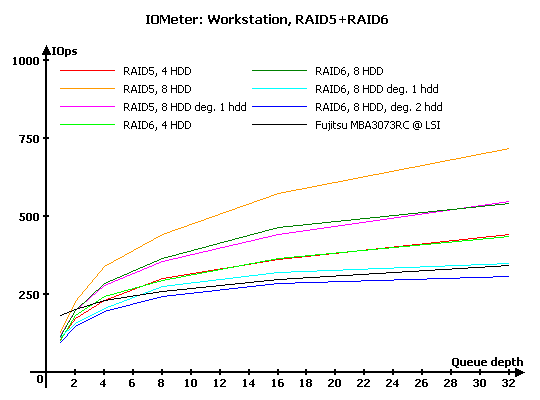

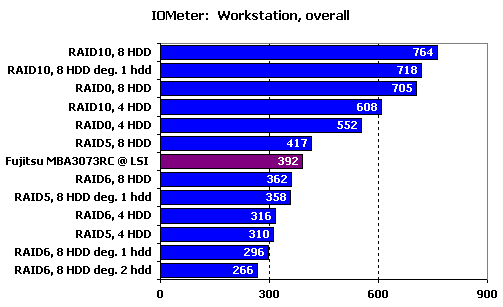

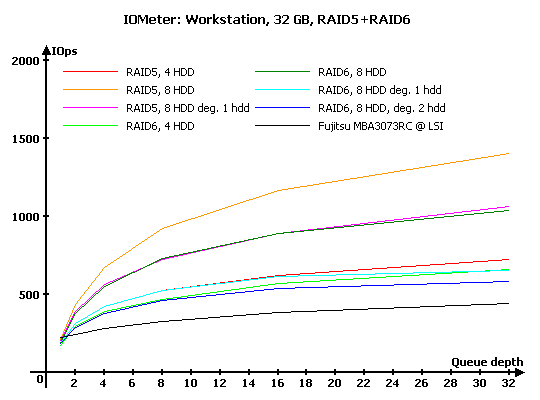

Результаты IOMeter: Workstation

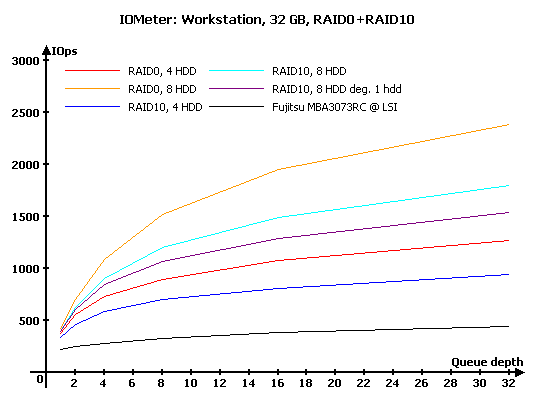

Результаты IOMeter: Workstation, 32 ГБ

Очень эффективный поиск более подходящего диска в зеркальных парах приводит к тому, что на нагрузке, состоящей исключительно из запросов на чтение, массивы RAID10 заметно выигрывают у RAID0 из такого же количества дисков. Деградировавший RAID10 снижает производительность, но и он во всех случаях лучше RAID0 из четырех дисков, а на малых нагрузках обгоняет и восьмидисковый RAID0.

В этой группе массивов на такой нагрузке все просто и понятно — чем больше дисков, тем выше производительность. А какой именно массив мы используем, RAID5 или RAID6, особой роли не играет (весьма занятный вывод, не правда ли?).

Интересно ведут себя деградировавшие массивы — без одного диска и RAID5, и RAID6 снижают скорость почти вдвое. А потеря второго диска в RAID6 приводит к тому, что его производительность падает почти до уровня одиночного накопителя.

Итоговый рейтинг в очередной раз наглядно показывает, что в случае нагрузки исключительно из операций чтения RAID10 имеет очень заметное преимущество над другими массивами из такого же количества дисков.

С появлением запросов на запись расстановка сил уже несколько меняется — на малых нагрузках по-прежнему лидируют RAID10, но вот с увеличением глубины очереди выше 32 запросов вперед выходят массивы RAID0.

Существенные изменения произошли и во второй группе массивов. Восьмидисковый RAID6 теперь заметно отстает от RAID5 с таким же количеством дисков, хотя среди четырехдисковых массивов по-прежнему наблюдается паритет. Изрядно упала и производительность деградировавшего RAID6 без одного диска.

За счет высоких результатов на малых нагрузках RAID10 в итоговом рейтинге лишь немного отстает от RAID0. А вот массивы RAID5 и RAID6 заметно просели по производительности.

Нагрузка, характерная для рабочих станций, то есть с весьма ощутимым количеством операций записи и существенно разнящимися размерами блоков, явно предпочитает массивы RAID0 — за RAID10 остается победа лишь на самых малых глубинах очереди.

В стане массивов с записью контрольных сумм особых изменений нет — расстановка сил почти такая же, как и в «Fileserver».

И все же наш рейтинг отдает предпочтение массивам RAID10.

Обратите внимание, что не только деградировавшие, но и все нормальные массивы, кроме RAID5 из восьми дисков, демонстрируют на такой нагрузке производительность ниже, чем у одиночного диска.

С уменьшением рабочей зоны теста всего до 32 ГБ все массивы ощутимо прибавляют в скорости — даже лишившийся двух дисков RAID6 немного, но все же опережает одиночный диск. Ну и стоит отметить теперь уже явное превосходство RAID0 над RAID10 — уменьшение рабочей зоны значительно снижает время доступа к данным, соответственно падает влияние алгоритмов поиска «удачного» диска в зеркальной паре.

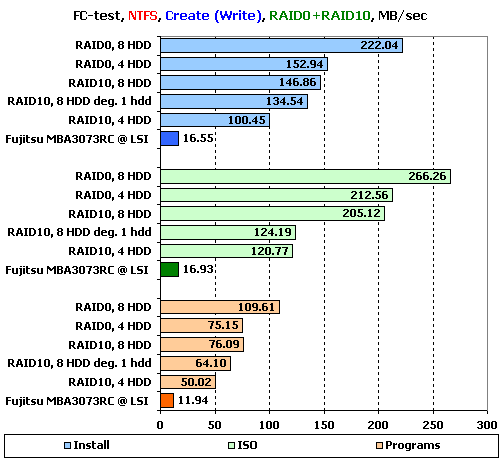

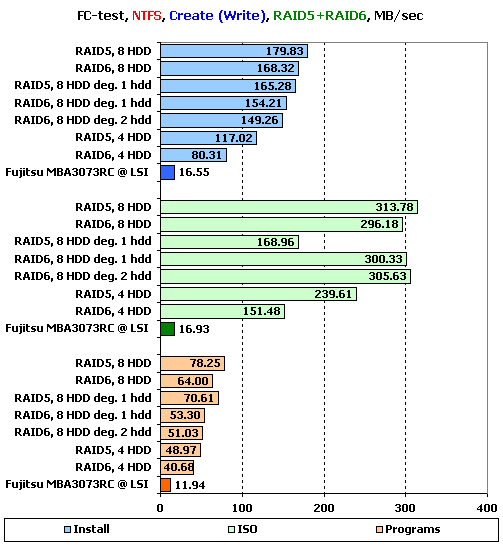

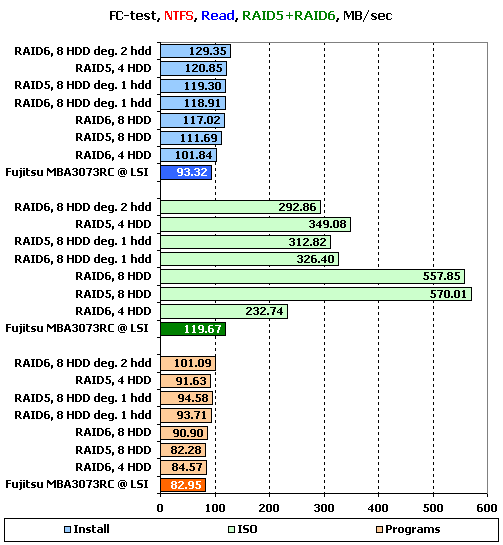

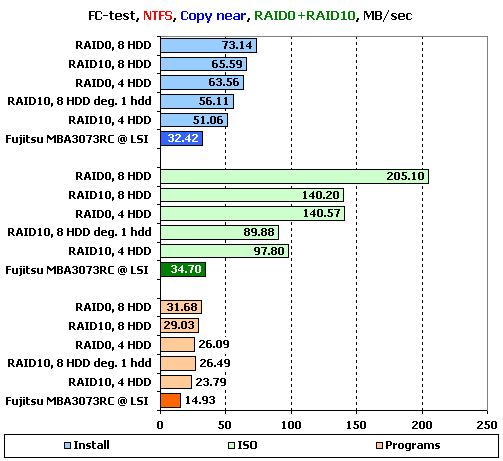

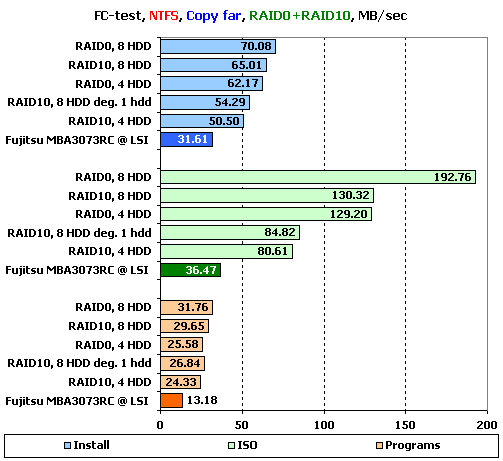

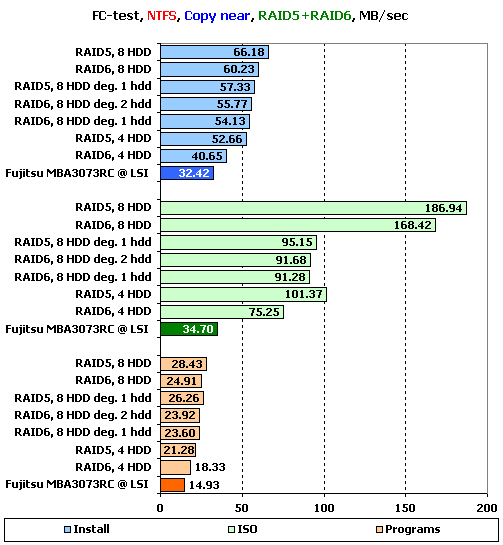

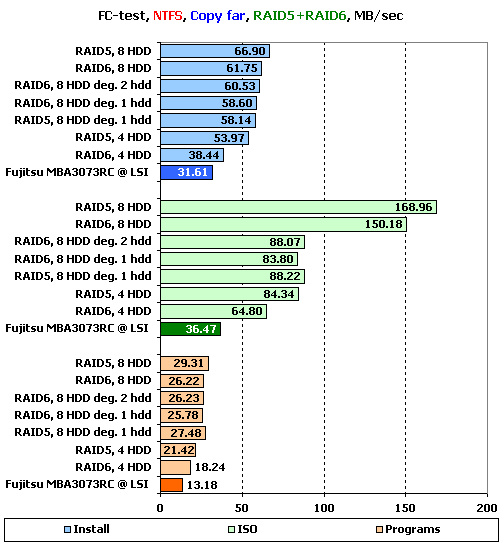

FC-Test

Следующим в нашей программе идет FileCopy Test. На накопителе создаются два раздела по 32 ГБ, размечаемые на двух этапах тестирования сначала в NTFS, а затем в FAT32, после чего на разделе создается определенный набор файлов, считывается, копируется в пределах раздела и копируется с раздела на раздел. Время всех этих операций фиксируется. Напомним, что наборы «Windows» и «Programs» включают в себя большое количество мелких файлов, а для остальных трех наборов («MP3», «ISO» и «Install») характерно меньшее количество файлов более крупного размера, причем в «ISO» используются самые большие файлы.

Не забывайте, что тест копирования не только говорит о скорости копирования в пределах одного накопителя, но и позволяет судить о его поведении под сложной нагрузкой. Фактически, во время копирования накопитель одновременно работает с двумя потоками, причем один из них на чтение, а второй на запись.

Поскольку результатов получается много, то мы будем подробно рассматривать лишь значения, достигнутые на наборах файлов «Install», «ISO» и «Programs» в NTFS, являющихся более характерными для обычного использования массивов. Остальные результаты, вы, при желании, можете узнать из таблиц по ссылкам:

Результаты FC-Test: NTFS

Результаты FC-Test: FAT32

На создании файлов расстановка сил вполне логична, за исключением одного момента — деградировавший RAID10 слишком уж отличается по скорости от полноценного массива, хотя особых причин для этого у него нет. Возможно, что он каждый раз пытается писать на «несуществующий» диск и каждый же раз ждет от него ответа. В целом скорости всех массивов находятся на том же уровне, что и у изделий конкурентов, и не радуют своими значениями: после теста на линейную запись ждешь несколько более высоких результатов.

Хм, интересная картина: массивы RAID5 и RAID6 демонстрируют на больших файлах скорость большую, чем RAID0 и RAID10, да и на остальных наборах вполне сравнимы. На удивление великолепно держатся деградировавшие массивы — в большинстве случаев их скорости мало отличаются от результатов полноценных массивов (неприятным исключением стал RAID5 без одного диска при работе с набором «ISO»).

О, а на чтении-то скорости заметно выше! Конечно, они все еще не дотягивают до того, что мы видели в тесте на последовательное чтение, но все же 585 МБ/с на больших файлах в RAID0 — это очень хороший результат (вы только вдумайтесь, полгигабайта в секунду — восемь секунд и образ DVD-диска прочитан). На удивление практически не демонстрирует снижения скорости деградировавший RAID10.

Весьма высокие скорости мы видим и при чтении больших файлов с RAID5 и RAID6. Но только на полноценных массивах — деградировавшие варианты уже заметно медленнее.

На маленьких файлах происходит что-то странное — лидерство достается как раз деградировавшим массивам, что не поддается логическому объяснению, за исключением банального «особенности прошивки».

Копирование что с раздела на раздел, что в пределах одного раздела проходит очень схоже — чем больше размер файлов, тем ощутимее выигрыш RAID0 у RAID10. Результаты деградировавшего RAID10 невысоки — вероятно, он упирается в посредственную скорость записи.

Во второй группе массивов копирование проходит тоже без особых открытий: восьмидисковые массивы на больших файлах явно заметно быстрее четырехдисковых, RAID5 быстрее RAID6 — все как полагается.

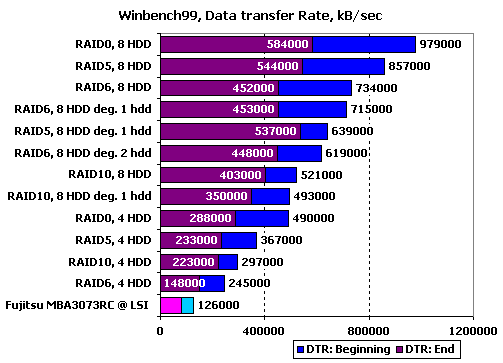

WinBench 99

Ну и в завершение — привычные графики чтения в WinBench 99.

График чтения 1 диска Fujitsu_MBA3073RC на LSI SAS3041E-R

Графики чтения RAID-массивов на HighPoint RocketRAID HPT4320:

График чтения RAID10, 4 диска

График чтения RAID10, 8 дисков

График чтения RAID10, 8 дисков минус один

График чтения RAID5, 4 диска

График чтения RAID5, 8 дисков

График чтения RAID5, 8 дисков минус один

График чтения RAID6, 4 дисков

График чтения RAID6, 8 дисков

График чтения RAID6, 8 дисков минус один

Сравним массивы по продемонстрированным скоростям чтения в начале и конце получившихся разделов:

На первый взгляд, все весьма культурно и опрятно. Правда, деградировавший RAID5 почему-то медленнее RAID6, лишившегося одного диска, причем исключительно на быстрой части раздела. Смотрим на график — и видим поразительно ровный график в левой части: что-то является сдерживающим фактором. Поскольку версии о пропускной способности отметаются сразу, то на выбор остаются два варианта: несовершенство прошивки в части алгоритмов восстановления данных из контрольных сумм, ведущая к недостатку мощности процессора, или тупик, вызванный самим фактом восстановления данных при помощи нескольких операций считывания. Честно говоря, мы склоняемся к первому варианту. Кстати, такую же наводящую на размышления горизонтальную полку мы видим и на графике RAID6 без двух дисков.

Подведение итогов

HighPoint RocketRAID4320 оставил о себе несколько неоднозначное впечатление, как, впрочем, и все его конкуренты, побывавшие у нас на тестах ранее — идеала нам пока не попалось, хотя мы тщательно его ищем. Сильными сторонами контроллера являются три момента. Во-первых, контроллер продемонстрировал очень хорошее чтение с зеркальных пар в массивах RAID10, причем как при выборе «удачного» диска с меньшим временем отклика, так и в одновременном чтении с обоих дисков в случае больших файлов. До идеальной работы с массивами этого типа контроллеру не хватает малого — уверенного распараллеливания многопоточной нагрузки. Во-вторых, у HighPoint RocketRAID4320 мы увидели очень хорошие результаты при работе с файлами в FC-Test — на больших файлах восьмидисковые массивы уверенно демонстрируют скорость в районе 500 МБ/с. Ну и наконец, контроллер весьма неплохо справляется с деградировавшими массивами.

Не обошлось и без ложки дегтя. Таковой для данного контроллера стала работа массивов RAID5 и RAID6 на записи. При минимальной нагрузке их производительность весьма невысока, к тому же, весьма неприятным дополнением служат проблемы с производительностью при записи малыми блоками на массивы этих же типов. Так что если данные варианты нагрузки для вас важны, то лучше выберите другой контроллер, а во всех остальных случаях HighPoint RocketRAID4320 будет весьма неплохой покупкой.

Тем временем, нам до полной коллекции (по одному от каждого производителя) SAS RAID-контроллеров осталось всего ничего — один контроллер, и он уже у нас на руках. А это значит, что скоро можно будет устроить очную ставку шести конкурентов, чтобы выяснить, кто же из них лучший.

Другие материалы по данной теме

Тестирование SAS RAID-контроллера LSI MegaRAID SAS 8708EM2

Тестирование SAS RAID-контроллера Adaptec RAID ASR-5805

Тестирование SAS RAID-контроллера 3ware 9690SA-8I