Ваш город: Москва

Тестирование SAS RAID-контроллера Areca ARC-1680ix-16

Введение

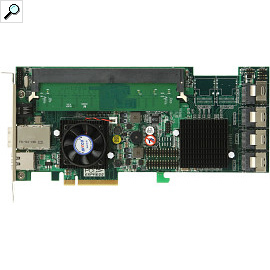

Почти три года прошло с того момента, когда нам в руки попался SATA RAID-контроллер ARC-1220 малоизвестной тогда компании Areca. Он был настолько хорош, что стал основой нашего стенда для тестирования дисков в составе массивов. И вот, в наших руках еще одно изделие этой компании, ARC-1680ix-16, построенное на более мощном процессоре и поддерживающее SAS-накопители.

Как и ее конкуренты, компания Areca выпустила сразу целое поколение продуктов с поддержкой SAS. Наиболее простыми являются контроллеры серии ARC-1300, имеющие от четырех до шестнадцати портов SAS, но полностью лишенные поддержки массивов. Более серьезными являются контроллеры ARC-1212 и ARC-1222, имеющие, соответственно, четыре или восемь внешних портов и поддерживающие все привычные типы массивов. Ну а самый максимальный набор функций достался контроллерам серии ARC-1680, один из которых и попал в наши руки.

Areca ARC-1680ix-16

В новой серии, как и полагается, есть контроллеры на любой вкус: с внешними портами, внутренними и с их комбинацией. Грубо все модели серии можно разделить на две группы: низкопрофильные и полноразмерные. В первую группу попали все модели с восемью портами в любых их комбинациях. Далее компания Areca несколько путается в показаниях, но похоже, что все модели этой группы оснащены чуть скромнее остальных – частота двуядерного процессора составляет 800 МГц, а объем памяти – 512 МБ DDR2 с частотой 533 МГц.

Полноразмерные модели, в чисто которых входит и попавший в наши руки 16-портовый экземпляр, несколько интереснее. И дело даже не в том, что частота процессора Intel IOP348 у них составляет 1,2 ГГц, а в том, что 512 МБ памяти на них не впаяно, а установлено самым обычным 240-контактным модулем памяти DDR2 с частотой 533 МГц и поддержкой коррекции ошибок ECC. Соответственно, при желании можно этот модуль заменить более объемным. По заверениям производителя, контроллеры поддерживают модули объемом до 4 ГБ. Мы не смогли найти 4-ГБ модуль с ECC но без буферизации (а буферизованная память у нас не заработала), но вот 2-ГБ модуль памяти вполне исправно работал. Получающийся в итоге контроллер по своим характеристикам уже полностью догоняет современные маломощные компьютеры. Впрочем, тестирование мы решили все же провести с базовыми 512 МБ.

Обращает на себя внимание и торец контроллера, на котором находится непривычно большое количество разъемов. Со средним все понятно сразу – это обычный SFF-8088, внешний SAS-разъем, поддерживающий четыре порта. Правее него расположен разъем RJ-45 при помощи которого можно организовать управление контроллером при помощи SNMP-агента. Приятное и более чем уместное для контроллера такого уровня дополнение к привычным средствам управления в виде настроек BIOS при загрузке сервера и сетевой панели управления. А самым левым является разъем RJ-11, который эмулирует порт RS-232 для модернизации прошивок SAS-экспандеров.

Комплект поставки несколько больше обычного – помимо привычного набора из диска с драйверами и ПО, инструкции и кабелей в него вошел кабель с разъемом RJ-11 на одном конце и RS-232 на другом. Да, это тот самый кабель, для модернизации прошивок SAS-экспандеров. Отдельного уважения заслуживает инструкция: обычно в бумажном виде предоставляется лишь достаточно краткая версия, в то время как полную можно найти лишь на диске в формате pdf. В нашем же случае в коробке с контроллером лежала 170-страничная «почти что книжка», в которой помимо всех особенностей функционирования контроллера можно почерпнуть и некоторые общие сведения о массивах как таковых.

Полный список типов поддерживаемых массивов внушителен и включает в себя все востребованные типы массивов, и даже такие редко встречающиеся варианты, как RAID30. Выглядит же он так:

одиночный диск,

JBOD,

RAID0,

RAID1,

RAID1E,

RAID3,

RAID5,

RAID6,

RAID10,

RAID30,

RAID50,

RAID60.

Естественно, что все контроллеры серии ARC-1680 поддерживают установку батареи питания буферной памяти. Как и нас, владельцев более ранних контролеров Areca, задумывающихся о модернизации дисковой подсистемы, порадует тот факт, что модель BBU не изменилась.

Как и полагается современным контроллерам, с сайта производителя можно скачать не только регулярно обновляемую прошивку для контроллера, но и драйвера и приложение для управления контроллером из-под операционной системы, причем список поддерживаемых ОС достаточно широк – помимо привычных Windows, Linux и FreeBSD в него входят Solaris и Netware. Там же можно забрать и расширение MIB (Management Information Base) – структуры хранения данных для организации работы по SNMP.

Методика тестирования

Во время тестирования использовались следующие программы:

IOMeter версии 2003.02.15;

WinBench версии 99 2.0;

FC-Test версии 1.0;

Тестовая система была следующей:

корпус Intel SC5200;

системная плата Intel SE7520BD2;

два процессора Intel Xeon 2,8 ГГц на 800-МГц системной шине;

2 х 512 МБ регистровой памяти DDR PC3200 ЕСС

жесткий диск IBM DTLA-307015 объемом 15 ГБ в качестве системного диска;

видеокарта – встроенное видео ATI Rage XL

операционная система Microsoft Windows 2000 Professional SP4

Kонтроллер во время тестов устанавливался в слот PCI-Express x8 на материнской плате. Для тестирования использовались жесткие диски Fujitsu MBA3073RC, установленные в штатные салазки корпуса SC5200 и закрепленные в них четырьмя винтами за нижнюю грань. Контроллер тестировался с использованием четырех и восьми жестких дисков в следующих режимах:

RAID0;

RAID10;

деградировавший восьмидисковый RAID10 без одного диска;

RAID5;

RAID5;

деградировавший восьмидисковый RAID5 без одного диска;

RAID6;

деградировавший восьмидисковый RAID6 без одного диска;

деградировавший восьмидисковый RAID6 без двух дисков.

Поскольку мы стараемся максимально полно охватить все возможные типы массивов, то включаем в тестирование и рассмотрение деградировавших массивов. Данным термином обозначаются массивы с избыточностью данных, в которых один или несколько дисков (в зависимости от типа массива) вышел из строя, но при этом массив все еще хранит все данные и является рабочим.

Для сравнения мы будем везде приводить результаты одиночного диска Fujitsu MBA3073RC, полученные на контроллере LSI SAS3041E-R, считая их неким базовым уровнем производительности. Сразу оговоримся, что у такого сочетания есть одна хорошо известная нам проблема: его скорость записи в «FileCopy Test» всегда очень мала.

Размер страйпа на массивах всех типов задается равным 64 кБ.

В контроллер была прошита самая последняя доступная нам на момент тестирования версия BIOS и использовались самые свежие драйвера. Соответственно, мы использовали прошивку 1.46 и драйвера 20.0.14.

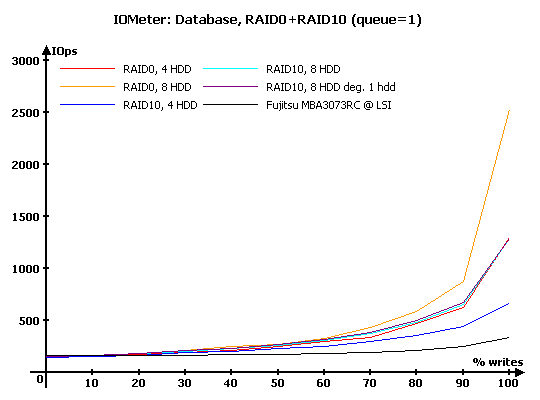

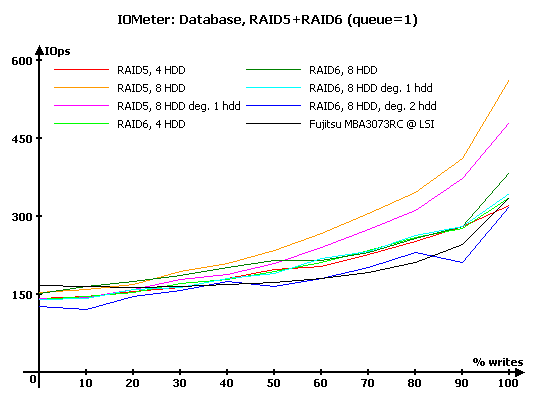

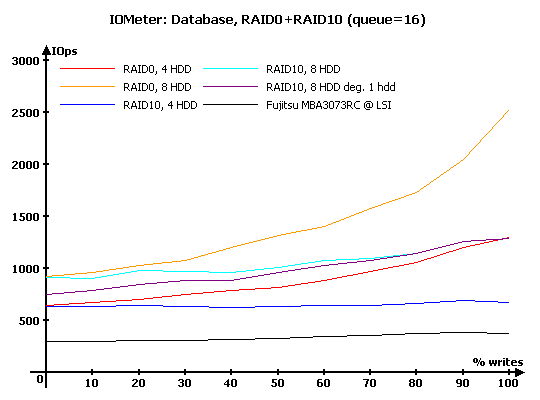

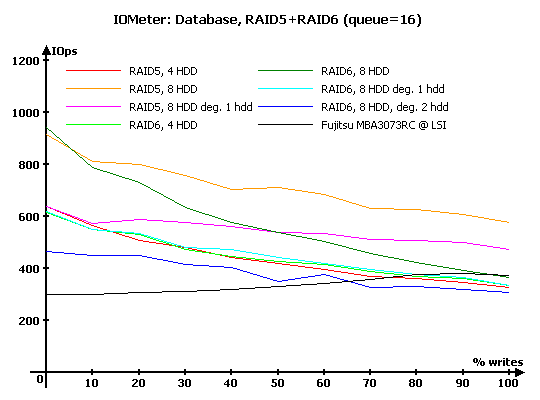

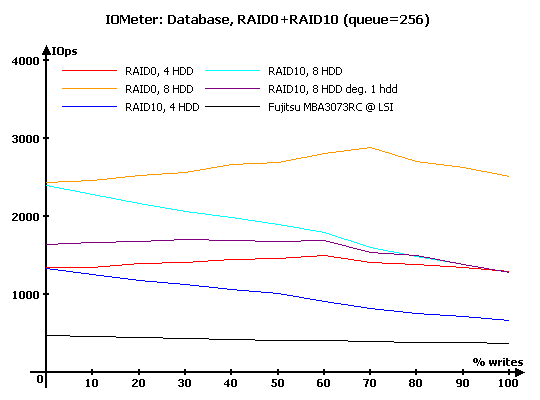

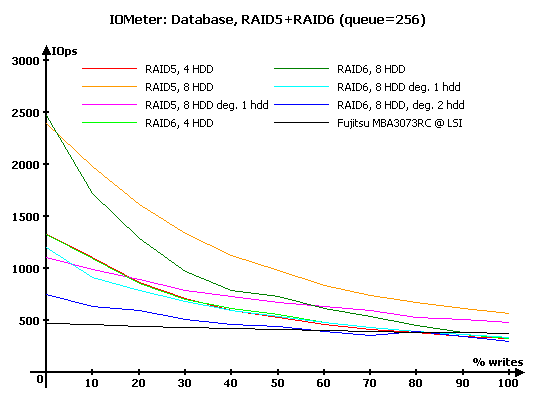

IOMeter: Database

Как всегда, начнем с, пожалуй, наиболее интересного с точки зрения нагрузки на контроллер, теста – "Database", с помощью которого мы выясняем способность контроллеров работать с потоками запросов на чтение и запись 8-кБ блоков данных со случайной адресацией. В ходе тестирования происходит последовательное изменение процентного соотношения запросов на запись от нуля до ста процентов (с шагом 10 %) от общего количества запросов и увеличение глубины очереди команд от 1 до 256.

Численные результаты измерений здесь и далее вы можете, при желании, увидеть в соответствующих таблицах, мы же будем работать с графиками и диаграммами.

Таблицы с результатами тестирования вы можете посмотреть по следующей ссылке:

Результаты IOMeter: Database, RAID1+RAID10

Результаты IOMeter: Database, RAID5+RAID6

На минимальной нагрузке в массивах RAID0 и RAID10 все проходит без неожиданностей – контроллер вполне ожидаемо масштабирует производительность на записи в зависимости от количества дисков. Причем RAID0 из четырех дисков практически совпадает с RAID10 из восьми – зеркальная пара на записи равноценна одному диску. Приятно, что деградировавший массив не демонстрирует никаких отклонений.

У массивов с записью контрольных сумм дела обстоят тоже сравнительно неплохо – заметно медленнее одиночного диска лишь RAID6, лишившийся сразу двух дисков, у остальных массивов поведение вполне укладывается в термин «нормальное». Разве что производительность записи у многодисковых массивов не так уж и высока, как можно было бы ожидать от контроллера с таким великолепным сочетанием быстрых дисков, большой памяти и мощного процессора. Впрочем, подробнее об этом мы будем говорить в нашей следующей статье, посвященной сравнению контроллеров между собой.

С ростом нагрузки, выражающейся в увеличении глубины очереди до шестнадцати команд, все массивы закономерно увеличивают скорость – активнее работает отложенная запись, начинает работать переупорядочивание запросов. В целом, расстановка сил между различными массивами ничего удивительного не приносит, хотя нельзя не отметить тот факт, что поиск «удачного» диска в зеркальных парах мог бы быть и поэффективнее – у конкурентов мы уже неоднократно встречались с ситуациями, когда RAID10 на чтении обгонял RAID0 из такого же числа дисков, а здесь они идут всего лишь вровень.

У массивов RAID5 и RAID6 мы видим некоторые проблемы с записью – производительность на этих сложных, с точки зрения контроллера, типах массивов явно могла бы быть и повыше, ведь мощности набортного процессора явно должно хватать (по крайней мере один раз, на примере Adaptec ASR-5805 мы в этом уже убеждались). Причем массивы RAID6, в которых необходимо вычислять сразу две контрольные суммы, закономерно страдают особенно сильно.

На еще больших нагрузках мы видим у массивов RAID0 любопытную особенность поведения – максимальная производительность достигается на нагрузках, в которых есть одновременно запросы и на запись, и на чтение. Если для отдельных жестких дисков такие нагрузки являются самыми сложными, то современные массивы именно на них демонстрируют лучшую производительность за счет сочетания эффективной перестановки запросов в огромной очереди команд и солиднейшего буфера отложенной записи. Правда, те, кто внимательно следят за нашим тестированием контроллеров, наверняка вспомнят, что «пик» производительности у разных контроллеров приходится на разные соотношения записи и чтения – ну так и подход производителей к балансировке прошивке под нагрузки тоже может быть разным. Кто-то выводит на первое место чтение, а кто-то отдает приоритет отложенной записи.

Неплохо держится деградировавший RAID10 – конечно, при превосходстве запросов на чтение он заметно отличается от своего полноценного собрата, но все же производительность массива и не падает до уровня RAID0 из четырех дисков.

На больших нагрузках в группе массивов RAID5 и RAID6 особых изменений не происходит – все они вполне успешно справляются с чтением, и весьма скромно ведут себя при преобладании запросов на запись. Среди деградировавших массивов неприятно удивил RAID5 без одного диска – его производительность на чтении снизилась как-то слишком уж сильно.

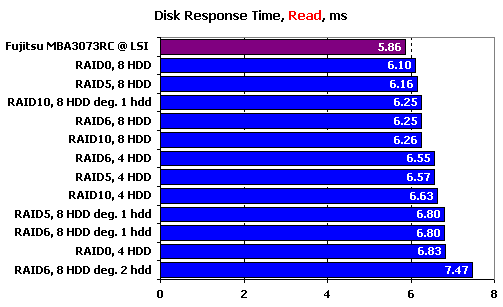

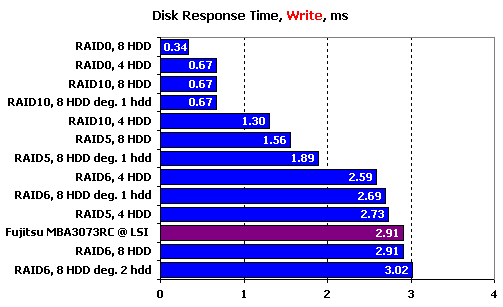

IOMeter: Disk Response Time

Для измерения времени отклика мы в течении десяти минут при помощи IOMeter отправляем на накопитель поток запросов на чтение или запись блоков данных по 512 байт при глубине очереди исходящих запросов, равной единице. Количество запросов, обработанных накопителем, превышает шестьдесят тысяч, так что мы получаем устоявшееся время отклика накопителя, не зависящее от объема буферной памяти.

По времени отклика на чтении мы видим довольно любопытную расстановку сил. В первую очередь, бросается в глаза то, что все массивы чуть хуже одиночного диска. В принципе, это вполне логично, поскольку пускай незначительные, но какие-то задержки контроллер должен вносить. Вот только RAID10 могли бы оказаться и лучше одиночного диска за счет выборки в зеркальных парах того диска, который сумеет быстрее отдать данные – примеры этого мы уже видели раньше. Все восьмидисковые массивы оказались быстрее четырехдисковых, которые, в свою очередь, уверенно обогнали все деградировавшие массивы. Последние, кстати, выступили весьма неплохо – восстановление данных из контрольных сумм серьезно сказалось лишь на отклике RAID6, лишенного сразу двух дисков: восстановление такого объема данных уже заметно снижает отклик дисковой подсистемы.

На записи вы видим странную картину. С одной стороны, расстановка сил массивов RAID0 и RAID10 полностью закономерна – чем больше суммарный кэш дисков и самого контроллера, тем меньше время отклика. А с другой, в стане массивов с записью контрольных сумм наблюдается непонятный разброд результатов. Так, RAID5 из четырех дисков проигрывает массиву RAID6 из такого же числа дисков, причем последний умудряется еще и обогнать RAID6 из восьми дисков.

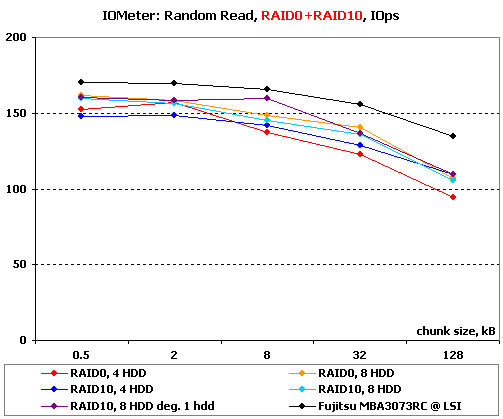

IOMeter: Random Read & Write

Оценим теперь зависимости производительности контроллеров в режимах чтения и записи с произвольной адресацией от размера используемого блока данных.

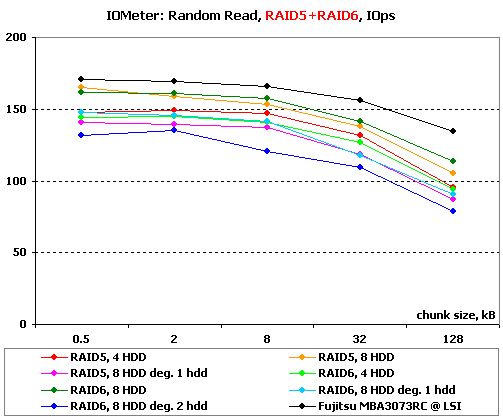

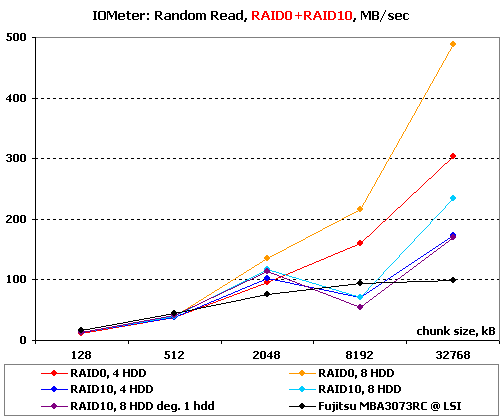

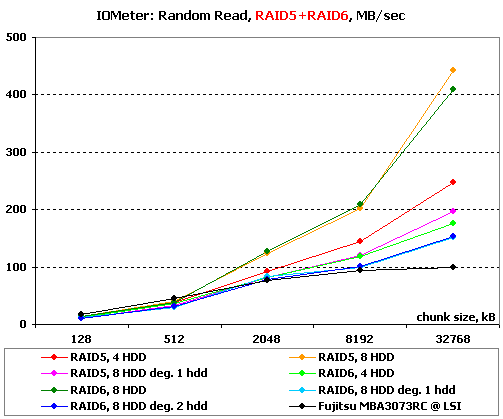

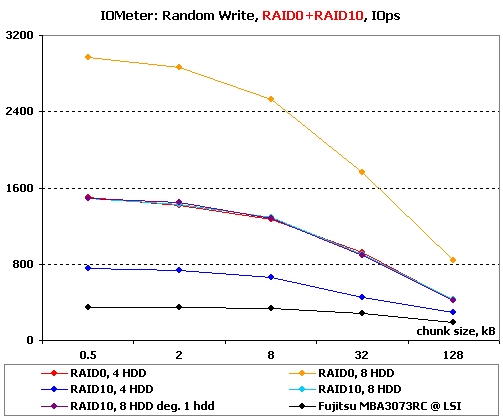

Результаты, полученные при работе со случайной адресацией данных, рассмотрим в двух вариантах. На блоках малого размера построим зависимости количества операций в секунду от размера используемого блока. А на больших блоках вместо количества операций возьмем в качестве критерия производительности скорость в Мегабайтах в секунду. Такой подход позволяет оценить работу массивов сразу в двух типичных случаях нагрузки: работа малыми блоками характерна для баз данных и для нее более важно количество операций в секунду, чем привычная скорость; а вот работа большими и очень большими блоками близка к реальной работе с файлами малых размеров и здесь уже на первый план выходит именно скорость в привычных мегабайтах в секунду.

Начнем с чтения.

Результаты IOMeter: Random Read, операций/с

Результаты IOMeter: Random Write, МБ/с

На чтении малых блоков со случайной адресацией в достаточно типичной картине графиков скрывается необъяснимое – деградировавший RAID10 умудряется опередить все остальные массивы на 8-кБ блоках.

В группе массивов RAID5 и RAID6 на чтении малых блоков никаких неожиданностей – все массивы проигрывают одиночному диску, но при этом массивы из большего числа дисков (в нашем случае – восьми) самые быстрые, а деградировавшие – самые медленные.

А вот на очень больших блоках у массивов RAID10 вылезли какие-то проблемы: так, на 8-МБ блоках скорость таких массивов оказалась ниже, чем у одиночного диска, да и на больших блоках явно меньше, чем можно было бы ожидать. Причем проблема в равной степени коснулась абсолютно всех массивов: и восьмидискового, и четырехдискового, и деградировавшего. Да, прошивка все же далека от идеала.

На том же чтении большими блоками массивы полноценные массивы RAID5 и RAID6 ведут себя очень хорошо, а вот все деградировавшие массивы демонстрируют весьма невысокие скорости. Особенно сильно потеря скорости чувствуется в случае RAID5.

Перейдем к операциям записи со случайной адресацией.

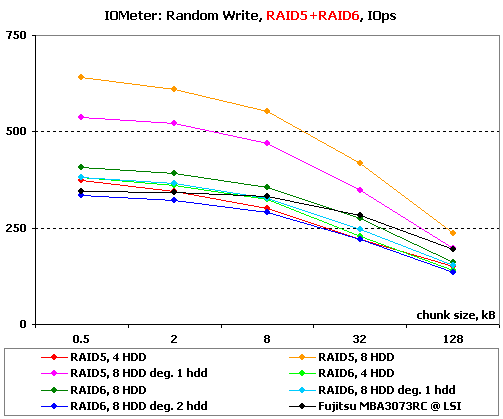

Результаты IOMeter: Random Write, операций/с

Результаты IOMeter: Random Write, МБ/с

На мелких блоках в группе массивов RAID0 и RAID10 с записью все очень хорошо — перед нами идеальное масштабирование производительности от количества дисков, а деградировавший массив ничем не отличается от нормального.

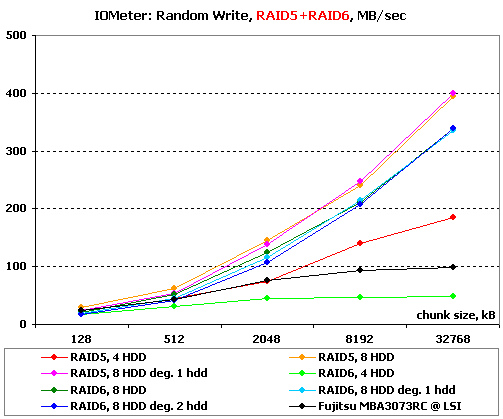

На записи в RAID5 и RAID6 количество дисков все еще имеет значение, но огромную роль оказывает необходимость расчета контрольных сумм. В случае RAID6, где таких сумм приходится вычислять и записывать две, разница в производительности массивов из восьми и из четырех дисков становится уже не так уж и велика. Заметно теряют в скорости все деградировавшие массивы – сказывается то, что для записи блока им необходимо считывать ранее записанные данные, которые порой приходится восстанавливать из контрольных сумм.

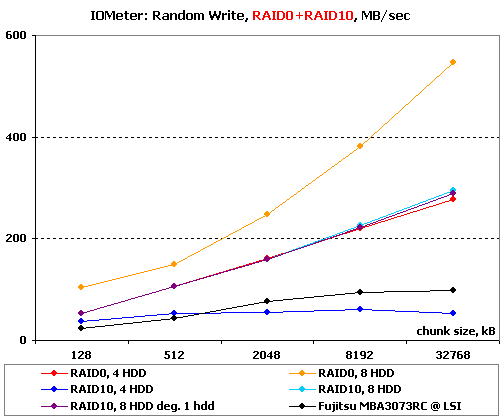

На записи больших блоков в этой группе массивов все было бы идеально, если бы не четырехдисковый RAID10, неожиданно потерявший скорость на очень больших блоках, причем настолько, что он стал проигрывать одиночному диску.

Также успешно справился с записью больших блоков наш подопытный и в случае массивов RAID5 и RAID6. Увеличившийся размер блоков позволил ему снизить число запросов к дискам: записывая полный страйп на массив контроллеру нет нужды что-либо считывать. В результате деградировавшие массивы вполную подтянулись к своим полноценным собратьям. Но и здесь не обошлось без ложки дегтя – RAID6 из четырех дисков повторил «подвиг» массива RAID10 и продемонстрировал крайне низкую скорость.

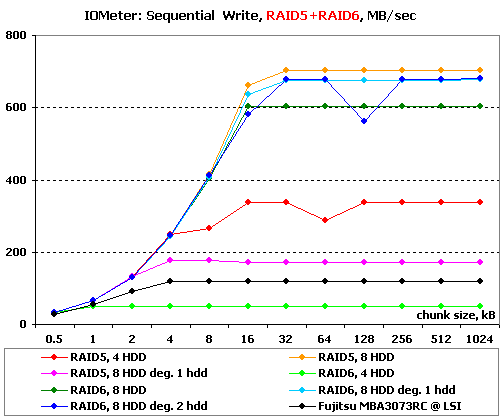

IOMeter: Sequential Read & Write

Ну что ж, пора оценить способности контроллеров в последовательных операциях. В данном тесте на накопители подается поток запросов с глубиной очереди команд, равной четырем. Раз в минуту размер блока данных увеличивается. В итоге мы получаем возможность проследить зависимость линейных скоростей чтения и записи массивов от размеров используемых блоков данных и оценить максимальные достижимые скорости.

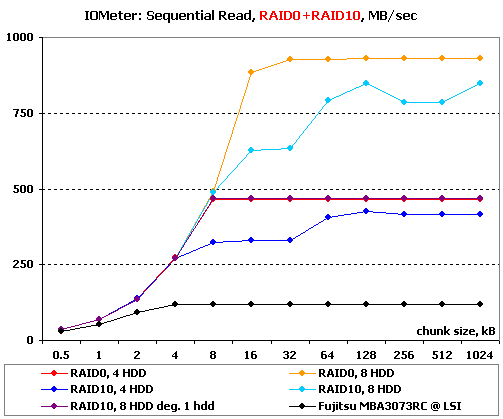

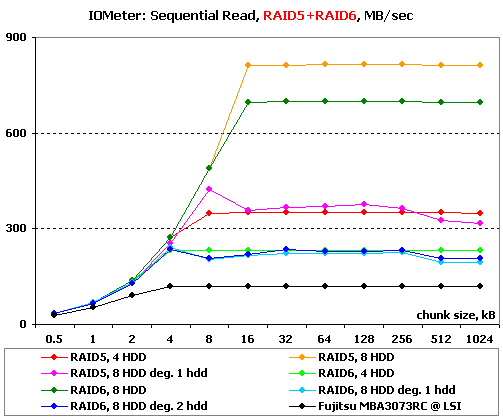

Результаты IOMeter: Sequential Read

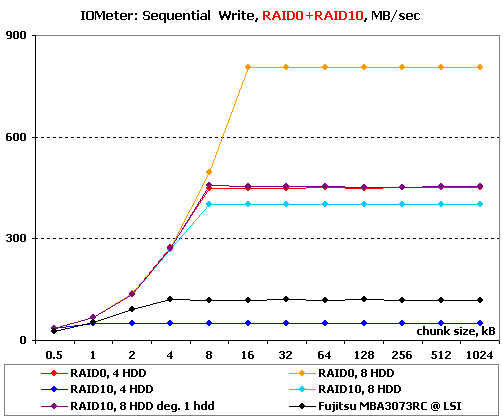

Результаты IOMeter: Sequential Write

Линейное чтение приятно радует своими высокими скоростями. Массивы RAID10 даже на блоках весьма небольших размеров стараются читать разные данные одновременно с обоих дисков в зеркальных парах, увеличивая таким образом свою скорость. До RAID0, они, конечно, так и не дотягиваются, но в целом результат заслуживает весомой похвалы – эффективность этой части прошивки весьма неплоха.

Обратите внимание, что при этом деградировавший RAID10 полностью совпадает по скорости с RAID0из вдвое меньшего количества дисков – судя по всему, контроллер просто перестает пытаться читать данные с зеркальных пар одновременно, причем со всех сразу, а не только с той, в которой диск вышел из строя.

Полноценные RAID5 и RAID6 также демонстрируют великолепные графики чтения, чего нельзя сказать об их деградировавших вариантах, скорость которых хороша на малых блоках, но явно недостаточна на больших.

На линейной записи массивы RAID10 ведут себя несколько странно. Так, RAID10 из четырех дисков неожиданно показывает крайне низкую скорость – видимо, его результаты в случайной записи больших блоков объяснялись этой особенностью. Странное, очень странное поведение. «Чудит» и восьмидисковый RAID10 – его скорость чуть ниже, чем у его деградировавшего аналога, который как раз ведет себя закономерно, совпадая по скорости с RAID0 из четырех дисков.

И снова проблемы со случайной записью большими блоками «переносятся» в этот тест – да, и тут крайне малой скоростью «отличился» RAID6 из четырех дисков. Остальные полноценные массивы демонстрируют вполне приличную работу, выражающуюся в аккуратных графиках.

Деградировавшие массивы ведут себя неоднозначно. Так, массивы RAID6 без одно и без двух дисков практически не отстают от своего полноценного аналога, причем даже на сравнительно небольших блоках, размер которых явно меньше полного страйпа. А вот RAID5 без одного диска напротив, очень сильно теряет в скорости.

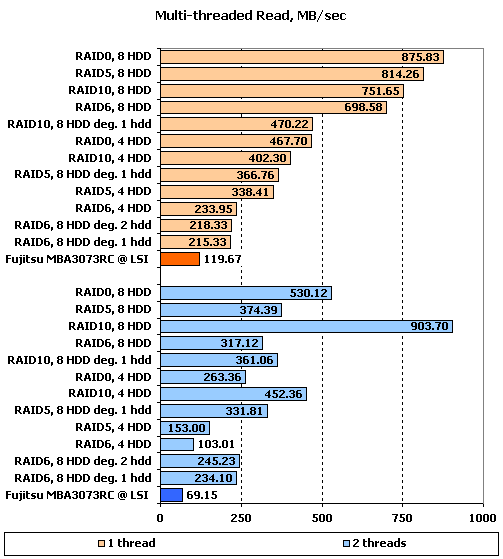

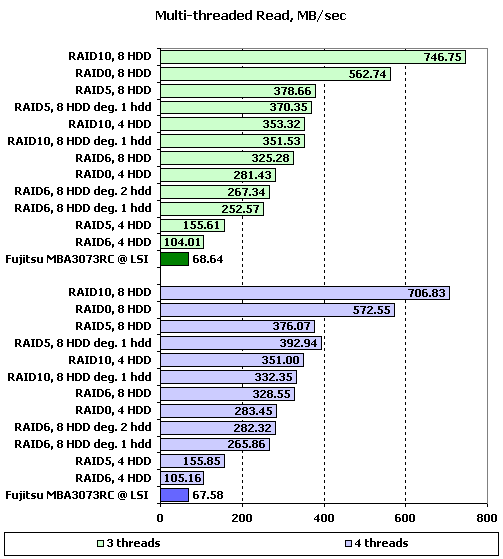

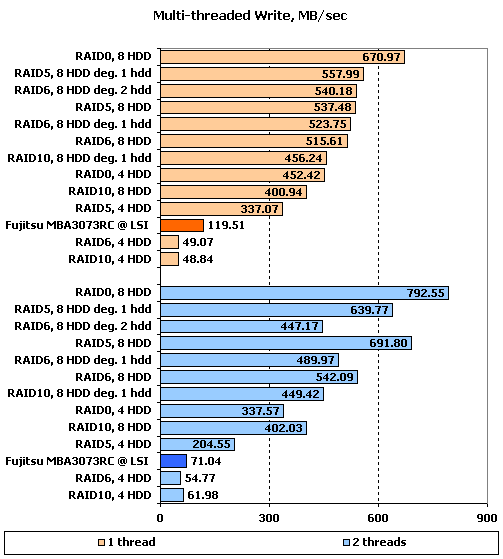

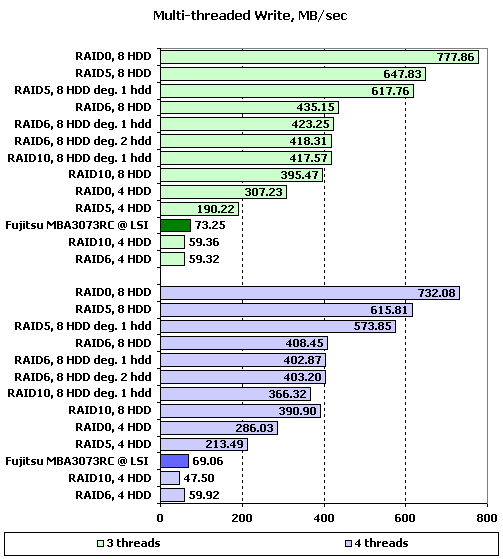

IOMeter: Multi-thread Read & Write

Данный тест позволяет оценить поведение контроллеров при многопоточной нагрузке. В ходе него эмулируется ситуация, когда с накопителем работает от одного до четырех приложений, причем количество запросов от них изменяется от одного до восьми, а адресные пространства каждого приложения, роли которых выполняют worker-ы в "IOMeter", не пересекаются.

При желании, вы можете увидеть таблицы с результатами тестирования по соответствующим ссылкам, а мы же в качестве наиболее показательных, рассмотрим диаграммы записи и чтения для ситуаций с глубиной очереди в один запрос, поскольку при количестве запросов в очереди равном двум и более значения скоростей практически не зависят от количества приложений.

Результаты IOMeter: Multi-tread Read, RAID1+RAID10

Результаты IOMeter: Multi-tread Read, RAID5+RAID6

Результаты IOMeter: Multi-tread Write, RAID1+RAID10

Результаты IOMeter: Multi-tread Write, RAID5+RAID6

На одном потоке скорости чтения массивов откровенно радуют своими высокими значениями. В то время как многие конкуренты этого контроллера выходят на максимальные скорости лишь при глубинах очереди больше единицы, Areca ARC-1680 отлично справляется с линейным чтением и на минимальных очередях.

С двумя одновременными потоками контроллер справляется уже не так успешно – у большинства массивов скорости снижаются примерно в полтора раза, а у восьмидисковых RAID5 и RAID6 снижение и вовсе более чем двукратное. Зато прекрасно чувствуют себя массивы RAID10 – их скорости даже возросли: контроллер явно сумел распознать характер нагрузки и направить по потоку на каждый из дисков в зеркальной паре. На удивление возросли и скорости деградировавших массивов RAID6, но это уже скорее особенность прошивки контроллера, чем прямая заслуга ее разработчиков.

Дальнейшее увеличение количества потоков приводит лишь к постепенному снижению скоростей, не вызывая резких перестановок сил. Крайне отрадно видеть, что контролер все также успешно справляется с разведением разных потоков нагрузки на разные диски зеркальных пар массивов RAID10.

С записью одного потока на минимальной глубине очереди контроллер справляется чуть хуже, чем со чтением, но все же значения скоростей достаточно высоки, чтобы не вызывать нареканий. Правда, мы снова видим уже знакомые нам проблемы с крайне низкими скоростями у массивов RAID10 и RAID6 из четырех дисков.

При увеличении количества потоков часть массивов ожидаемо несколько снижает скорость, а вот часть, наоборот, ее увеличивает. Среди последних особенно выделяются восьмидисковые RAID0 и RAID5, причем в случае последнего увеличением скорости отличился даже деградировавший массив.

Дальнейшее увеличение количества потоков на запись никаких качественных изменений уже не вызывает – все массивы лишь равномерно понемногу снижают свои скорости.

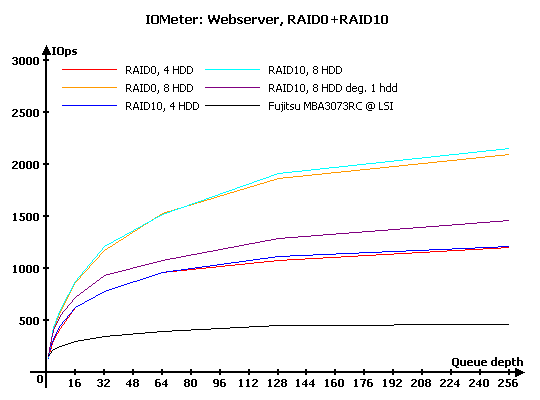

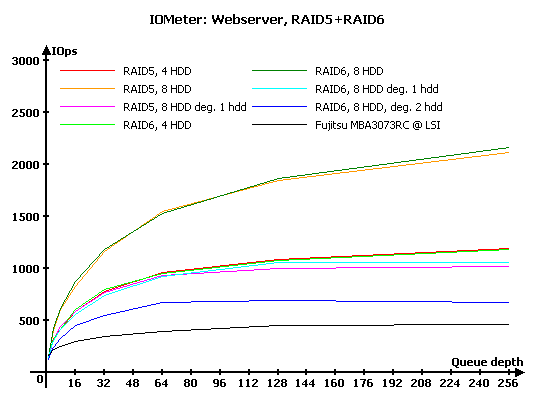

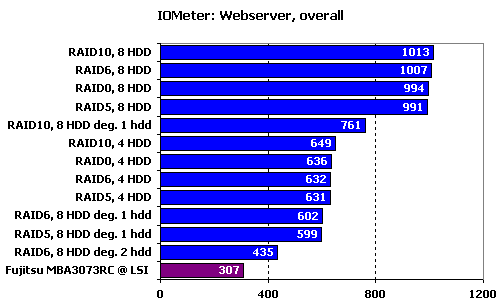

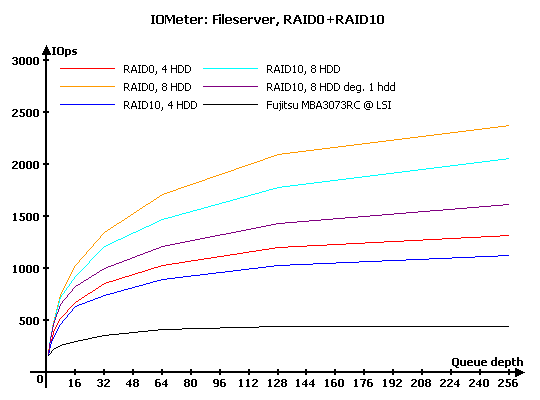

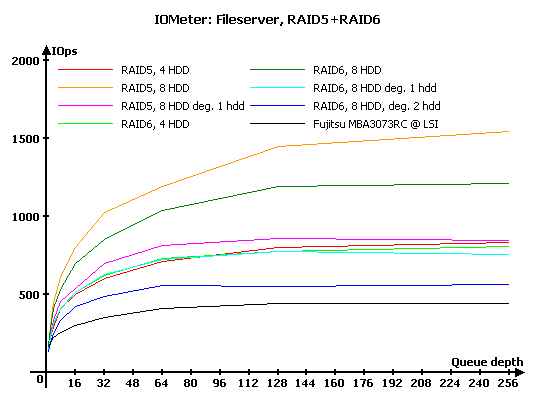

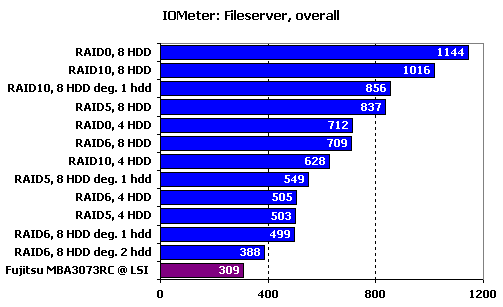

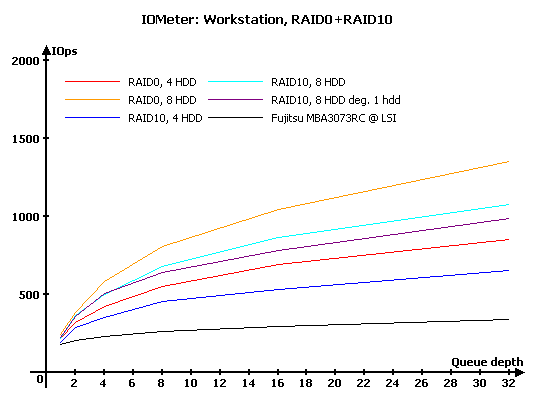

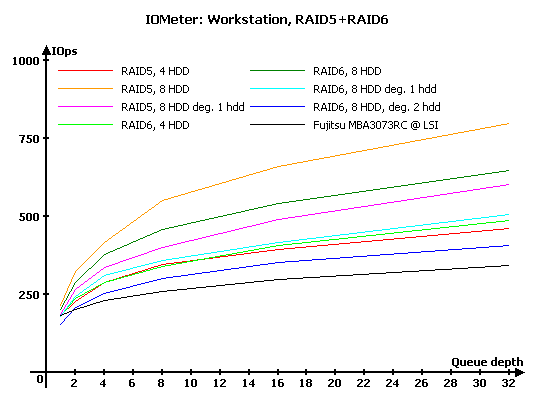

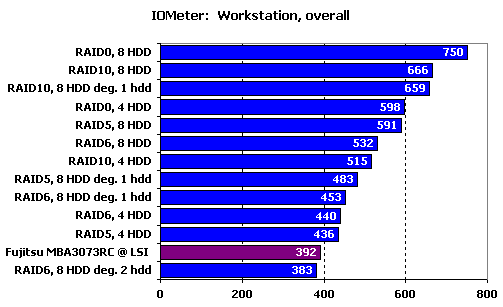

IOMeter: Webserver, Fileserver и Workstation

В данной группе тестов накопители тестируются под нагрузками, характерными для серверов и рабочих станций.

Напомню, что в "Webserver" и "Fileserver" эмулируется работа накопителя в соответствующих серверах, в то время как в "Workstation" мы имитируем работу накопителя в режиме типичной нагрузки для рабочей станции, с ограничением максимальной глубины очереди в 32 запроса. Естественно, что "Webserver" и "Fileserver" – не более чем собирательные названия; первый будет весьма схоже эмулировать нагрузку любого сервера, работающего, фактически, только с запросами на чтение, а второй – сервера с преобладанием запросов на чтение, но при этом с определенной, заметно отличной от нуля долей запросов на запись.

Результаты IOMeter: Fileserver

Результаты IOMeter: Webserver

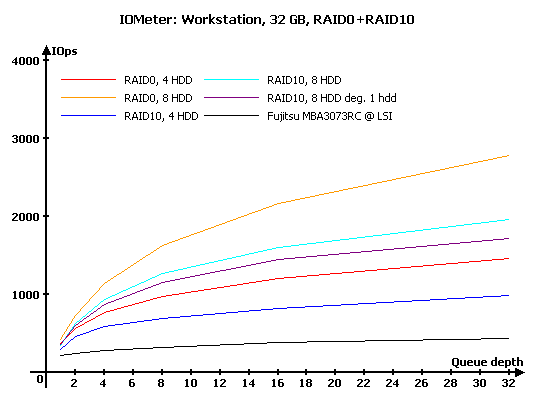

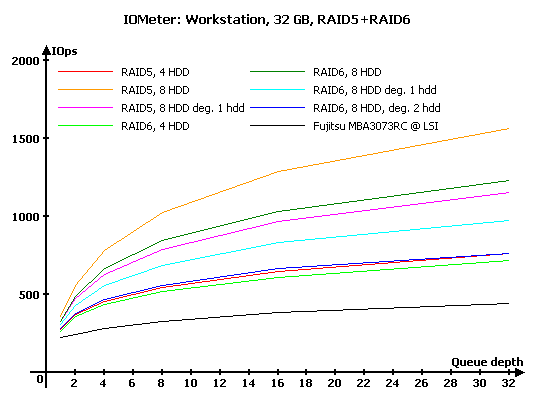

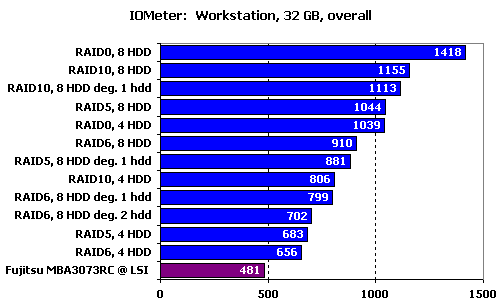

Результаты IOMeter: Workstation

Результаты IOMeter: Workstation, 32 ГБ

В случае, когда нагрузка на массив состоит лишь из запросов на чтение мы видим явный паритет между массивами RAID0 и RAID10 из одинакового количества дисков.

Схожая ситуация наблюдается и в случае массивов RAID5 и RAID6 – они идут практически вровень. Даже у деградировавших массивов графики почти сливаются.

Итоговый рейтинг наглядно демонстрирует, что в случае нагрузки, состоящей лишь из запросов на чтение, на этом контроллере решающее значение имеет лишь количество дисков в массиве, в то время как его тип не так уж и важен.

А вот появление в нагрузке сколько-нибудь существенного количества запросов на запись приводит к тому, что массивы RAID0 демонстрируют заметно большую производительность, чем RAID10. Впрочем, в случае последних даже деградировавший массив все же оказывается лучше, чем RAID0 из вдвое меньшего количества дисков, а значит часть оптимизационных алгоритмов контроллера все еще работает.

Точно так же на этой нагрузке массивы RAID6 уступают RAID5, ведь им приходится рассчитывать больше контрольных сумм. Да и среди деградировавших массивов обозначается заметная разница в производительности – восстанавливать данные сразу из двух контрольных сумм, чтобы осуществить запись, совсем уж «бесплатно» не получается.

Обратите внимание, насколько заметно массивы с записью контрольных сумм хуже, чем тот же RAID10, не говоря уж о RAID0.

Точно такую же, только более ярко выраженную, картину мы видим и в случае нагрузок, характерных для рабочих станций. Что и неудивительно, ведь здесь доля запросов на запись еще выше.

Теперь восьмидисковые RAID5 и RAID6 в силах соревноваться лишь с четырехдисковым RAID0, а их версии, построенные на четырех дисках, мало чем отличаются по производительности от одиночного диска. Ну а деградировавшие массивы и вовсе смотрятся весьма печально.

Очень схожую ситуацию мы видим и при уменьшении размера используемого раздела до 32 ГБ. Чуть больше возрастает производительность многодисковых массивов, за счет того, что рабочие области каждого диска становятся совсем узкими и головкам приходится перемещаться по минимуму, но принципиальных отличий это не вызывает.

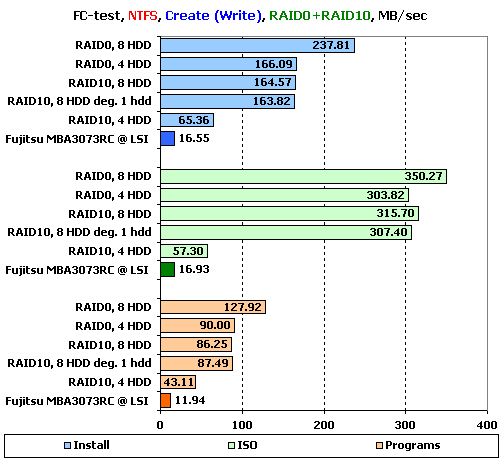

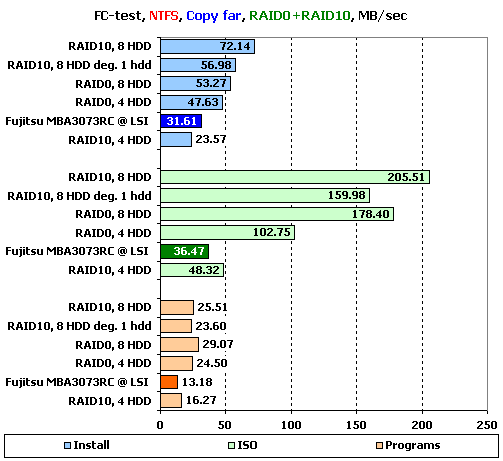

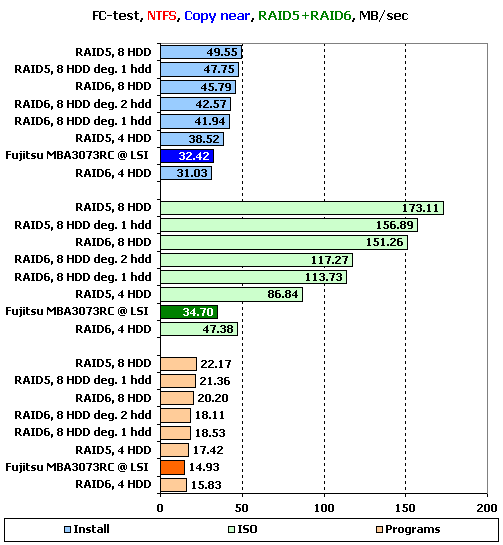

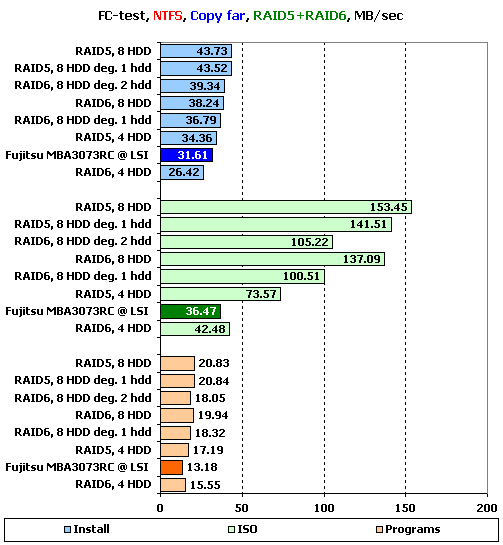

FC-Test

Следующим в нашей программе идет FileCopy Test. На накопителе создается два раздела по 32 ГБ, размечаемые на двух этапах тестирования сначала в NTFS, а затем в FAT32, после чего на разделе создается определенный набор файлов, считывается, копируется в пределах раздела и копируется с раздела на раздел. Время всех этих операций фиксируется. Напомним, что наборы "Windows" и "Programs" включают в себя большое количество мелких файлов, а для остальных трех паттернов ("MP3", "ISO" и "Install") характерно меньшее количество файлов более крупного размера, причем в "ISO" используются самые большие файлы.

Не забывайте, что тест копирования не только говорит о скорости копирования в пределах одного накопителя, но и позволяет судить о его поведении под сложной нагрузкой. Фактически, во время копирования накопитель одновременно работает с двумя потоками, причем один из них на чтение, а второй на запись.

Поскольку результатов получается много, то мы будем подробно рассматривать лишь значения, достигнутые на наборах файлов"Install", "ISO" и "Programs" в NTFS, являющихся более характерными для обычного использования массивов. Остальные результаты, вы, при желании, можете узнать из таблиц ниже:

Результаты FC-Test: NTFS

Результаты FC-Test: FAT32

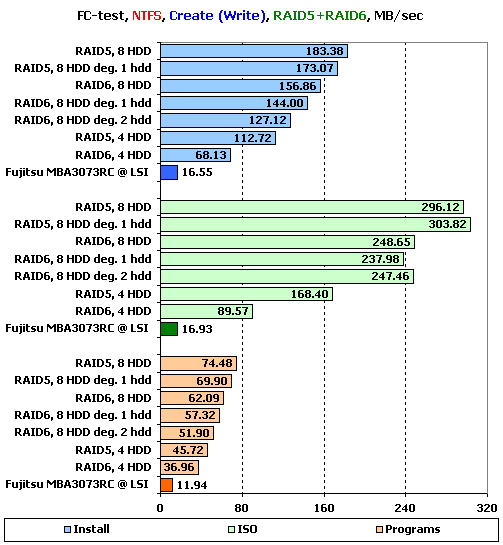

На создании файлов расстановка сил вполне логична и закономерна, пока дело касается файлов небольшого размера. Все неприятные моменты прячутся в наборе «ISO» -- здесь и крайне низкая скорость RAID10 из четырех дисков (все же, очень интересно, чем так провинился этот массив), и недостаточно высокая, относительно остальных, скорость RAID0 из восьми дисков. Но в целом, контроллер выступил весьма неплохо – большинство конкурентов не в силах продемонстрировать и 300 МБ/с даже в «ISO».

В случае записи на массивы RAID5 и RAID6 скорость еще несколько снижается. В целом, расстановка сил выглядит достаточно логичной, без малообъяснимых скачков производительности, но все же на восьмидисковых массивах хотелось бы видеть несколько большие скорости.

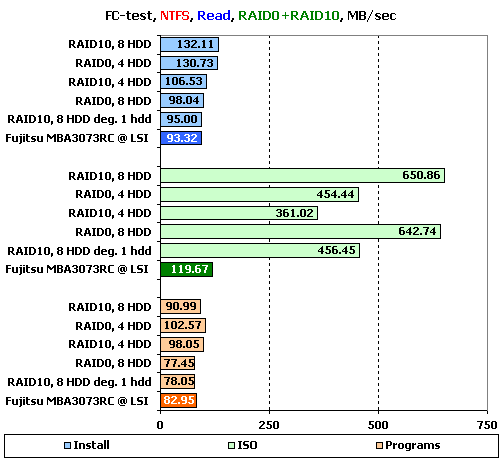

На чтении больших файлов в «ISO» мы снова видим великолепную эффективность контроллера при работе с файлами – 650 МБ/с является очень хорошим результатом, лучшим из виденного нами до сих пор. А вот на чтении наборов с файлами небольших размеров происходят какие-то маленькие странности – неожиданно весьма скромно выступает RAID0 из восьми дисков.

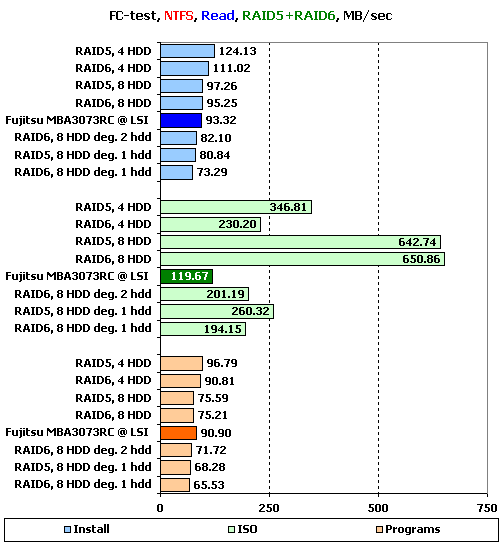

Похоже, что с файлами небольших размеров у контроллера действительно есть проблемы, хотя и не очень большие. В случае RAID5 и RAID6 мы снова видим как на наборах «Install» и «Programs» массивы из четырех дисков оказываются быстрее, чем их восьмидисковые аналоги. Зато на больших файлах в «ISO» восьмидисковые массивы «отрываются» на полную катушку, снова показывая нам скорость 650 МБ/с.

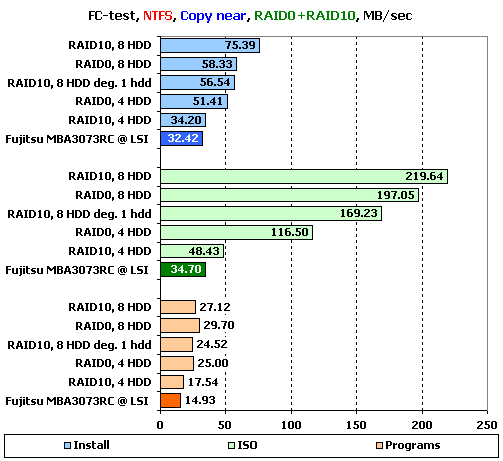

На копировании восьмидисковый RAID10 неожиданно обгоняет всех конкурентов, включая RAID0. Приятно радуют значения скоростей в «ISO», а вот наборах с файлами меньшего размера рекордных значений уже не видно. Впрочем, полноценно сравнивать контроллер с конкурентами мы все же будем в другой статье.

Без особых происшествий проходит копирование и на массивах с записью контрольных сумм. По-прежнему неплохо выглядят результаты контроллера на больших файлах, и достаточно тусклы его показатели на малых. Правда, приятно радует расстановка сил, являющаяся вполне предсказуемой.

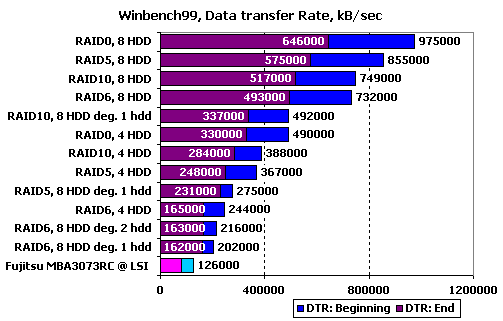

WinBench 99

Ну и в завершение – привычные графики чтения в «WinBench 99».

График чтения 1 диска Fujitsu_MBA3073RC на LSI

Графики чтения RAID-массивов на Areca ARC-1680ix-16:

График чтения RAID0, 4 диска

График чтения RAID0, 8 дисков

График чтения RAID10, 4 диска

График чтения RAID10, 8 дисков

График чтения RAID10, 8 дисков минус один

График чтения RAID5, 4 диска

График чтения RAID5, 8 дисков

График чтения RAID5, 8 дисков минус один

График чтения RAID6, 4 дисков

График чтения RAID6, 8 дисков

График чтения RAID6, 8 дисков минус один

График чтения RAID6, 8 дисков минус два

Сравним массивы по продемонстрированным скоростям чтения в начале и конце получившихся разделов:

Получившиеся результаты приятно радуют своей стройностью — все стоят на своих местах. Если посмотреть на сами графики, то они тоже приятно радуют малым количеством резких скачков скорости и отсутствием горизонтальных полок, даже деградировавшие массивы работают довольно ровно, за исключением, разве что RAID5.

Подведение итогов

В целом, компании Areca почти удалось удержать почетное и ко многому обязывающее звание производителя очень хороших контроллеров. Мы говорим «почти», поскольку нас немножко напрягли проблемы с записью у четырехдисковых массивов RAID10 и RAID6. Плюс у него эффективность выборки более удачного диска в зеркальных парах далека от идеальной, да и работа с мелкими файлами могла бы проходить чуть быстрее. Но мы будем надеяться, что производитель исправит эти недочеты в следующих версиях прошивки. Зато на стороне этого контроллера хорошая и предсказуемая работа под серверными нагрузками, а самое главное – ему нет равных по скорости работы с большими файлами. В достоинства следует записать и очень эффективное распараллеливание многопоточной нагрузки по дискам в зеркальных парах. В целом, Areca ARC-1680 оставил о себе впечатление, как о контроллере, который будет великолепным выбором для построения высоконагруженного файлового массива.

Другие материалы по данной теме

Тестирование SAS RAID-контроллера HighPoint RocketRAID HPT4320

Тестирование SAS RAID-контроллера LSI MegaRAID SAS 8708EM2

Тестирование SAS RAID-контроллера Adaptec RAID ASR-5805