Ваш город: Москва

SSD или 8 Гбайт памяти — ищем пути рационального апгрейда

Введение

Выбор комплектующих для домашнего или рабочего компьютера, как известно, проблема очень многогранная. Кто-то стремится собрать высокопроизводительную систему, кого-то в первую очередь заботит уровень шума, а кто-то хочет просто сэкономить. По мере своих сил мы пытаемся дать свои рекомендации и подкрепить их тестами. Однако порой читатели задают нам настолько изощрённые вопросы, что ответить на них без дополнительной подготовки бывает очень непросто. В результате проработки таких тем иногда появляются совсем уж нетипичные исследования, которые, тем не менее, зачастую представляются нам очень интересными и для более широкого круга читателей. Сегодня мы бы хотели рассказать как раз об изучении очередного «тонкого» вопроса, тестирований, способных помочь в ответе на который, на просторах глобальной сети не так уж и много (если они вообще есть).

Итак, представьте себе компьютер, в котором установлен достаточно мощный (или даже флагманский) центральный процессор и высокопроизводительная видеоподсистема, которая без каких либо нареканий справляется со всей накладываемой на неё нагрузкой. Однако владелец такого компьютера, вдохновленный неожиданно полученным гонораром или просто в силу нечаянного душевного порыва, хочет продолжить апгрейд своей системы. На что следует обратить взор в первую очередь в такой ситуации?

В общем-то, если отмести смену материнской платы, процессора и улучшение видеоподсистемы, то вариантов остаётся не так уж и много. Можно остановиться на приобретении какой-либо периферии, гаджетов или каких-то других сопутствующих устройств. Но можно заняться и «потрохами» компьютера — дисковой подсистемой или оперативной памятью. Именно на этих двух возможностях мы бы и хотели остановиться сегодня несколько подробнее.

В большинстве случаев усовершенствование дисковой подсистемы или подсистемы памяти происходит не в погоне за более высокой производительностью, а — по необходимости. Перестали помещаться данные на жёстком диске — покупается новый. Стали раздражать систематические обращения операционной системы к своп-файлу — наращивается объём оперативной памяти. Плановые же обновления этих подсистем, направленные чисто на улучшение общей эффективности и быстродействия компьютера — большая редкость. И случаются они в основном только тогда, когда сфера использования компьютерной системы специфична, и от какой-либо из этих подсистем сильно зависит скорость работы в конкретном случае.

Например, совершенно очевидно, что производительность работы файл-сервера или системы, занимающейся обработкой больших массивов данных, хранящихся на жёстком диске, может быть легко повышена заменой диска на более скоростной или установкой RAID-массива. Точно так же как компьютер, на котором обычно работает с десяток ресурсоёмких приложений, или, к примеру, несколько виртуальных машин, должен быть оснащён достаточным количеством оперативной памяти, и увеличение её объёма может серьёзно повысить быстродействие и отзывчивость системы. Но это — вполне очевидные ситуации, и пользователи, деятельность которых протекает в таких или подобных условиях, никогда не станут задавать вопросы о том, что им стоит апгрейдить в первую очередь — наверняка они всё знают и без наших советов.

Другое дело, если речь идёт о типичной общеупотребительной системе, которая, в общем-то, вполне сносно справляется с любыми возлагаемыми на неё задачами и не проявляет никаких явных узких мест. В этом-то случае и начинают появляться вопросы, что — дисковую подсистему или подсистему памяти — рациональнее усовершенствовать в первую очередь? Какое из этих двух направлений апгрейда даст больший практический эффект?

Казалось бы, установка более быстрого жёсткого диска — весьма разумный вариант. Тем более что сейчас в продаже доступны вполне приемлемые по цене твердотельные накопители, обладающие значительно более высокой производительностью, нежели традиционные накопители на магнитных дисках. Наш сайт, как и многие другие источники информации, предлагают огромные объёмы информации о тестированиях различных вариантов винчестеров, однако в большинстве случаев это — результаты, показываемые дисками в синтетических тестах. Что же касается реальных приложений, то в лучшем случае измеряется время, необходимое для загрузки операционной системы или каких-то избранных «тяжёлых» приложений. Однако следует понимать, что загрузка операционной системы и программ — это разовые мероприятия, которые, к тому же ускоряются современными операционными системами за счёт упреждающего кэширования данных (в Windows, например, эта технология называется SuperFetch). И, конечно, скоростной SSD может добавить скорости в процесс загрузки и увеличит отзывчивость системы, уменьшив томительные секунды ожидания старта программ и открытия файлов, но сможет ли он увеличить производительность повседневной работы в типичных приложениях?

Для ответа на этот вопрос мы замерили скорость выполнения характерных сценариев в тестовой системе, оснащённой принципиально разными по скорости носителями информации. Иными словами, мы попытались увидеть влияние жесткого диска не на результаты синтетических тестов, а на быстродействие в тех тестах, которыми мы обычно оцениваем комплексную производительность компьютерных систем.

Аналогично, мы попытались отследить и влияние на общую производительность увеличения объёма оперативной памяти. Ведь дополнительная память благодаря технологии SuperFetch позволяет уменьшить обращения к жёсткому диску, частично заменив их на взаимодействие с закэшированными в оперативной памяти данными. Поэтому на первый взгляд кажется, что увеличение объёма ОЗУ может вызвать эффект, аналогичный эффекту от установки в систему, например, того же SSD.

Тестовые компоненты — жёсткие диски и память

Влияние выбора жёсткого диска на общую производительности системы мы решили оценить, выбрав для экспериментов три принципиально различных жёстких диска:

медлительный энергоэффективный винчестер компании Western Digital, относящийся к серии Caviar Green (WD20EARS);

новый 600-гигабайтный скоростной дисковый накопитель Western Digital VelociRaptor (WD6000HLHX) со скоростью вращения шпинделя 10000 об/мин и 32-мегабайтным буфером;

один из самых распространённых SSD дисков Intel X25-M G2 (SSDSA2MH160G2), построенный на базе 34 нм NAND флэш-памяти.

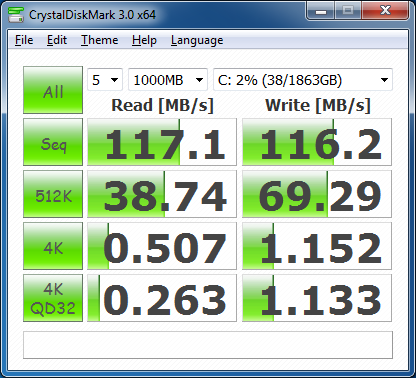

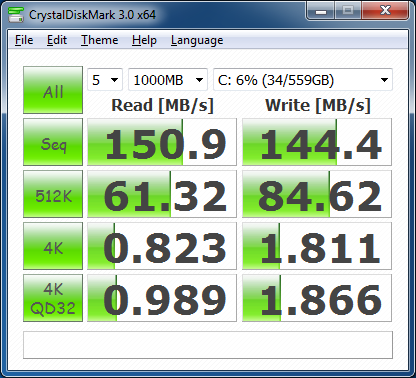

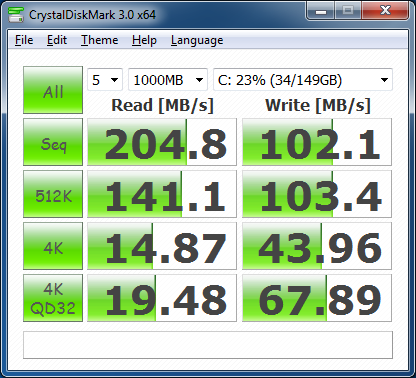

С подробными тестами этих накопителей вы можете ознакомиться в соответствующем разделе нашего сайта, мы же просто напомним их скоростные характеристики при помощи простенького синтетического теста CrystalDiskMark 3.0.

Western Digital Caviar Green (WD20EARS)

Western Digital VelociRaptor (WD6000HLHX)

Intel X25-M G2 (SSDSA2MH160G2)

Как видим, скорость работы данных у этих трёх дисков расходится кардинально, несмотря на то, что все их можно отнести к разряду современных. Впрочем, это и неудивительно — серия WD Green ориентирована на энергосбережение и покорение больших объёмов, диск WD Velociraptor — это скоростной рекордсмен среди магнитных дисков с интерфейсом SATA, а интеловский SSD — это просто хороший и быстрый накопитель на базе NAND флэш-памяти. При этом твердотельный диск вполне ожидаемо почти всегда оставляет своих конкурентов далеко позади за исключением одного случая — последовательной записи данных, а при тестировании скорости работы со случайными блоками его скорость превосходит быстродействие традиционных винчестеров в десятки раз. Накопители на основе магнитных дисков также демонстрируют весьма существенный разброс параметров, что вполне коррелирует с их конструктивными особенностями — скоростью вращения шпинделя, плотностью записи и физическим размером пластин.

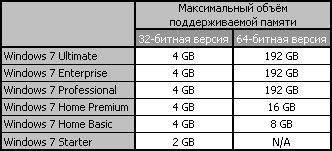

Что же касается объёма оперативной памяти, то на сегодняшний день стандартом для типовых настольных систем де-факто можно считать 4 Гбайта. Конечно, для использования такого объёма памяти в полной мере необходима 64-битная версия операционной системы, но это давно уже не является проблемой. Именно при таком объёме оперативной памяти самая распространённая на данный момент операционная система Microsoft Windows 7 чувствует себя наиболее комфортно, особенно если она нашпигована различным программным обеспечением. Именно поэтому как минимум уже пару лет мы оснащаем тестовые системы двумя модулями памяти по 2 Гбайта.

Между тем, распространение 64-битных версий Windows 7 и появление в продаже недорогих, но ёмких модулей DDR3 SDRAM привело к тому, что многие пользователи, задумывающиеся об апгрейде, морально готовы к расширению объёма оперативной памяти и до 8 Гбайт. Собственно, сама Windows 7 не чинит этому никаких препон — любая из 64-битных модификаций этой операционки 8 Гбайт ОЗУ поддерживает без проблем.

Таким образом, при использовании 64-битной операционной системы расширение подсистемы памяти до 8 Гбайт не вызовет никаких трудностей — нужны лишь подходящие для этой цели модули. Выигрыш же от увеличения объёма оперативной памяти будет заключаться в менее частых обращениях операционной системы к жёсткому диску, в результате чего система будет работать быстрее. Иными словами, увеличение объёма оперативной памяти можно рассматривать и как косвенный метод оптимизации дисковой подсистемы. Именно поэтому, тестируя влияние скоростных параметров накопителей на общую производительность компьютера, мы решили посмотреть и на то, что произойдёт при увеличении объёма оперативной памяти.

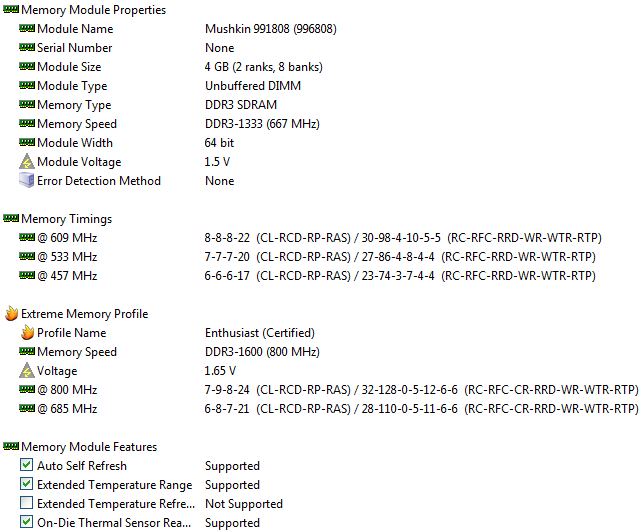

В настоящее время все основные производители памяти для энтузиастов готовы предложить комплекты, состоящие из пар 4-гигабайтных модулей — их создание не требует особых усилий, так как в обиход давно вошли чипы DDR3 SDRAM, имеющие объём 2 Гбита. Для данного тестирования такой комплект модулей предложила нам компания Mushkin, приславшая в адрес лаборатории DDR3-1600 память с артикулом 996808.

Это — пара двухсторонних 4-гигабайтных моделей DDR3-1600, рассчитанных на работу с таймингами 7-9-8-24 при напряжении 1.65 В. Комплект поддерживает технологию XMP, в профили занесено два режима — штатный DDR3-1600 и DDR3-1333 с агрессивными таймингами 6-8-7-21.

Модули оснащены фирменной системой охлаждения Ridgeback, состоящей из прилегающих к чипам алюминиевых пластин и небольшого радиатора сверху. Высота этой конструкции составляет ровно 40 мм, что существенно выше, чем обычные модули памяти.

Оверклокеры часто относятся к модулям с повышенной ёмкостью с некоторым недоверием, но в данном случае разгонные возможности комплекта Mushkin 996808 ничем не отличаются от возможностей привычных односторонних модулей ёмкостью по 2 Гбайта. Так что установка повышенного объёма оверклокерской памяти выглядит вполне достойным вариантом для апгрейда высокопроизводительной системы.

Впрочем, насколько хорош на тот или иной вариант на практике, должны показать тесты. К ним и перейдём.

Описание тестовой системы

Для тестирования был использован стенд со следующей конфигурацией:

Процессор: Core i7-870 (Lynnfield, 4 ядра/8 потоков, 2,93 ГГц, 8 Мбайт L3);

Материнская плата: ASUS P7P55D Premium (LGA1156, Intel P55 Express);

Память:

2 x 2 Гбайта, DDR3-1600 SDRAM, 9-9-9-27 (Kingston KHX1600C8D3K2/4GX);

2 x 4 Гбайта DDR3-1600 SDRAM, 9-9-9-27 (Mushkin 996808);

Графическая карта ATI Radeon HD 5870;

Жёсткие диски:

Western Digital Caviar Green (WD20EARS);

Western Digital VelociRaptor (WD6000HLHX);

Intel X25-M G2 (SSDSA2MH160G2).

Процессорный кулер: Thermalright Ultra-120 eXtreme с вентилятором Enermax Everest;

Блок питания: Tagan TG880-U33II (880 Вт);

Операционная система: Microsoft Windows 7 Ultimate x64;

Драйверы:

Intel Chipset Driver 9.1.1.1025;

ATI Catalyst 10.9 Display Driver.

Производительность

Общая производительность — SYSmark 2007

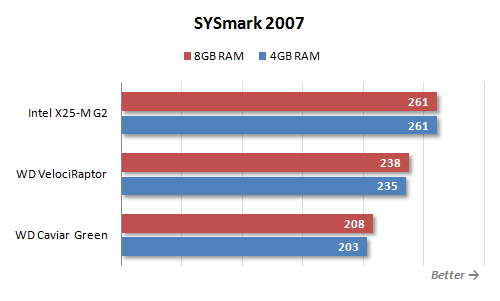

Тестирование в комплексных тестах, использующих реальные приложения, для наших целей подходит наилучшим образом. Например, SYSmark 2007 — он моделирует действия пользователя при решении различных практических задач и пытается воссоздать естественную нагрузку — открывает несколько приложений одновременно, активно переключается между ними, передаёт данные, используя буфер обмена.

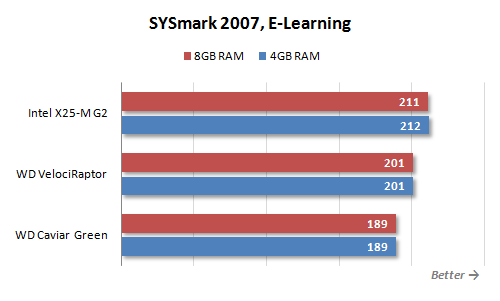

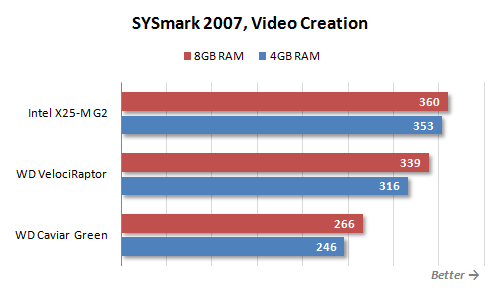

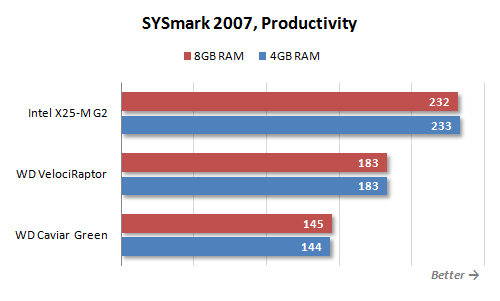

Как видно по результатам, влияние выбора жёсткого диска и объёма памяти на общую производительность не следует недооценивать. Разброс результатов на диаграмме доходит до 25 %, а это значит, что и в повседневной работе ощущения от работы с системой с быстрым диском и увеличенным объёмом памяти будут гораздо лучше. Естественно, ускорение в первую очередь достигается за счёт снижения задержек при дисковых операциях. Это хорошо прослеживается на «промежуточных» результатах SYSmark 2007.

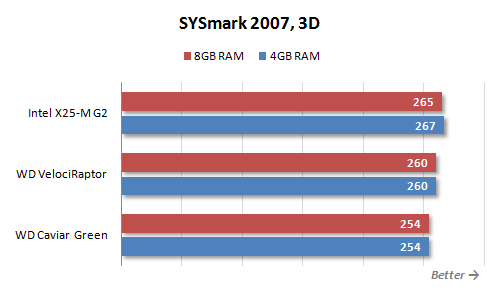

Наибольшая зависимость от скорости работы дисковой подсистемы проявляется в сценарии Productivity. Это вполне закономерно, в данном сценарии происходит типичная работа с документами Microsoft Office и с электронной почтой. Неудивительно, что тут использование быстрого SSD даёт 60-процентную прибавку в скорости. Существенным оказывается влияние диска и на скорость работы с цифровым контентом в сценарии Video Creation. Здесь оно оказывается таковым в первую очередь из-за включения в него Adobe Photoshop, который активно использует диск при обработке больших изображений. А вот в сценарии 3D, где упор делается на финальный рендеринг в пакетах 3D моделирования, скорость диска не играет особой роли, а первостепенное значение имеют вычислительные способности центрального процессора.

В то же время результаты тестов при использовании различного объёма памяти вызывают некоторое разочарование. Если смена дисковых накопителей сильно влияет на показания SYSmark 2007, увеличение объёма оперативной памяти приводит на их фоне лишь к незначительному увеличению производительности. Которое, кстати, наблюдается лишь в одном сценарии — Video Creation, очевидно, из-за того же Adobe Photoshop.

И уж совсем удручающим выглядит то, что увеличение объёма памяти до 8 Гбайт может привести даже к снижению производительности — это мы видим в тестах с твердотельным накопителем. Конечно, падение результата незначительно, но, тем не менее, оно имеет место в ряде тестов несмотря на то, что Windows 7 отключает технологию SuperFetch, если в системе установлен SSD.

Работа с цифровым контентом — Intel HDxPRT 2010

Intel HDxPRT 2010 (Intel High Definition Experience & Performance Ratings Test) — это ещё один комплексный тест, подобный SYSmark 2007. Однако если SYSmark 2007 ставит своей целью определение производительности системы при работе в общеупотребительных приложениях, то тест Intel HDxPRT 2010 — более узкоспециализирован. Он посвящён оценке быстродействия системы при типичной для домашних пользователей операциях по созданию, обработке и воспроизведению цифрового контента. Для определения производительности он использует набор приложений, состоящий из Cyberlink PowerDVD 9, Cyberlink PowerDirector 8, DivX Pro Codec 6.8.5, HDRsoft Photomatix 3, UnifiedColor HDR Photostudio v2.13.32, Adobe Flash Player v10.1, Apple iTunes 9.0.3 Adobe Photoshop Elements 8.0 и Windows Media Player 11. Тест включает три сценария: перекодирование снятого на видеокамеру HD-видео, обработку цифровых фотографий и подготовку аудио и видеофайлов для воспроизведения на портативных плеерах.

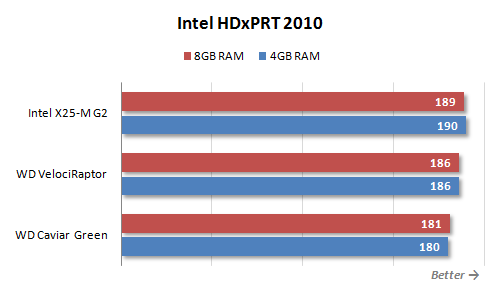

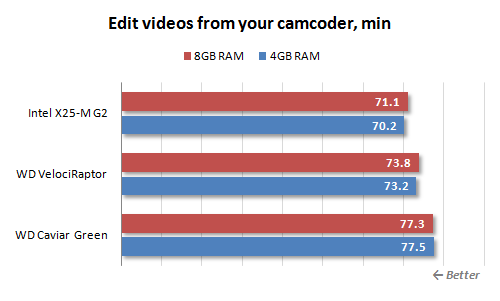

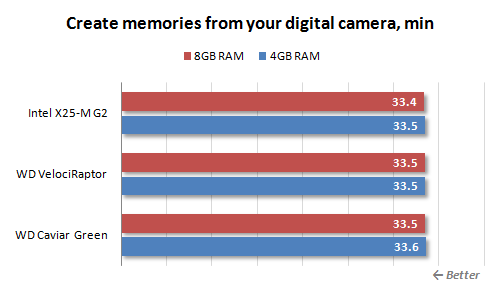

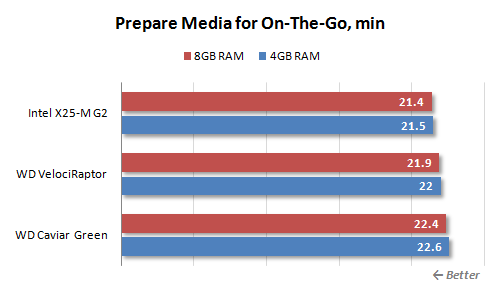

Влияние скоростных параметров диска видно и тут, но масштабы этого явления, прямо скажем, не впечатляют. Впрочем, это вполне закономерно. Данный тест оперирует медиафайлами преимущественно высокого разрешения, а при их обработке производительность упирается в вычислительные мощности, а не в скорость работы дисковой подсистемы. Увеличение же объёма оперативной памяти, если судить по результатам Intel HDxPRT 2010, и вовсе не даёт никакого эффекта. Очевидно, что типовая обработка звуковых и видеофайлов не требует задействования более стандартных 4 Гбайт оперативной памяти, прекрасно помещаются в такой объём памяти и фотографии, сделанные современными цифровыми камерами.

Детализация результатов тестов даёт ещё раз убедиться в том, что работа с медиаданными — это не тот случай, когда апгрейдом жёсткого диска или подсистемы памяти можно добиться впечатляющего эффекта.

Главное, как мы видим, это — не прибегать к применению чрезмерно медленных носителей информации. Так, разница между скоростью работы сценария, посвящённого редактированию и перекодированию видео, в системе с Western Digital Caviar Green и системе с SSD-диском достигает 10 %, а это — уже вполне осязаемое различие. Впрочем, в других сценариях такой разницы нет даже и близко.

Тестирование в приложениях

Положительное влияние применения быстрой дисковой подсистемы совершенно очевидно, если оценивать скорость загрузки приложений и данных из файлов. Собственно, это понятно даже без дополнительных тестов, достаточно посмотреть на результаты синтетических тестов. Поэтому, в рамках этого материала мы постарались отказаться от таких примитивных измерений, и основной упор сделали на тестирование скорости обработки данных в тех задачах, где быстродействие дисковой подсистемы может воздействовать на общую производительность.

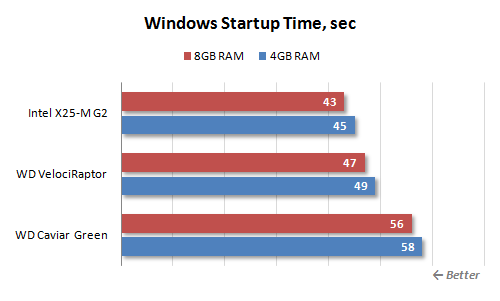

Впрочем, начать хочется с весьма ординарного измерения — скорости загрузки операционной системы Microsoft Windows 7 Ultimate x64. На диаграмме приводится время от нажатия на кнопку включения до момента, когда система начинает отвечать на действия пользователя.

Разница между системами с медленным механическим жёстким диском и с твердотельным накопителем доходит до 30 %. В то же время наращивание объёма памяти сказывается на скорости загрузки операционной системы весьма незначительно.

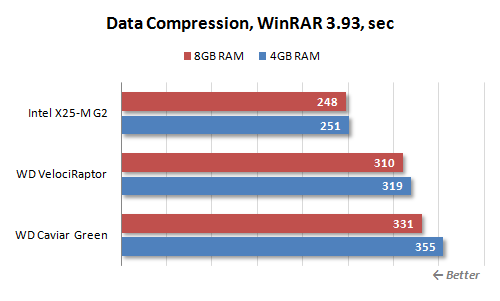

Очевидно, что выбор жёсткого диска может сильно повлиять на скорость работы в том случае, когда данные берутся непосредственно с носителя информации, а не из памяти. Хороший пример такой задачи — архивация. Как мы знаем, скорость сжатия данных в WinRAR существенно зависит от скорости работы центрального процессора и подсистемы памяти. Оказывается, не меньшее влияние способна оказать и производительность дисковой подсистемы.

Что интересно, тут наблюдается и существенный вклад в производительность и объёма оперативной памяти. Однако проявляется он не всегда, а только в том случае, когда дисковая подсистема не обладает достаточной скоростью. Так что, похоже, добавление дополнительных гигабайт памяти с целью увеличения быстродействия работы жёстких дисков имеет смысл лишь в том случае, когда они сами по себе не относятся к числу производительных.

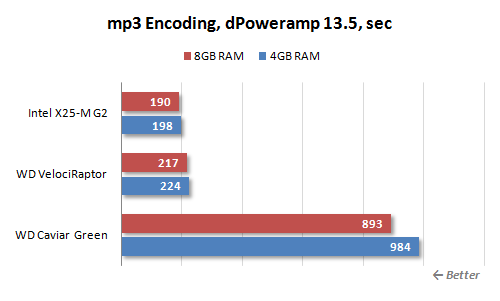

Сродни архивации и процесс перекодирования аудио-файлов в формат mp3. Однако следует иметь в виду, что многие утилиты-перекодировщики работают лишь в один-два вычислительных потока. И в этом случае скорости даже самого медленного винчестера с лихвой хватит для обеспечения такой утилиты необходимыми данными. Мы же выбрали для проведения тестирования конвертер dPoweramp, который эффективно задействует все доступные процессорные ядра, параллельно перекодируя по несколько файлов — по одному на каждое ядро. И в этом случае скорость винчестера начинает играть весьма существенную роль.

Мультипоточная запись данных — слабое место Western Digital Caviar Green, и этот тест он закономерно провалил. Western Digital VelociRaptor и SSD диск компании Intel оказались существенно быстрее, однако и между их скоростями есть заметное 15-процентное различие. Кстати, в данном тесте положительное влияние играет и объём оперативной памяти, но, конечно, говорить о том, что 8 Гбайт памяти может стать альтернативой быстрому диску, вновь не приходится.

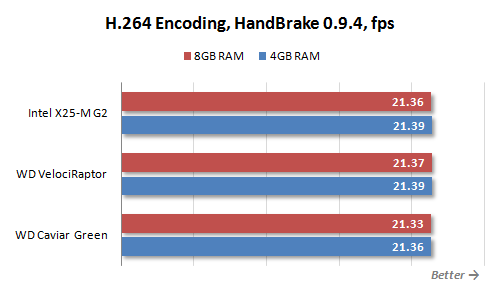

Ещё одна распространенная задача, связанная с обработкой подгружаемых в реальном времени данных — это перекодирование видео. Для целей тестирования мы воспользовались основанной на кодеке x.264 утилитой HandBrake посредством которой перекодировали 1080p MPEG-2 видеоролик в формат H.264.

И вот тут-то никакой зависимости ни от скорости дисков, ни от объёма видеопамяти уже не обнаруживается. Но это и вполне объяснимо — мощности быстродействующего процессора Core i7-870 не хватает для того, чтобы перекодировать видеофайлы быстрее, чем они читаются даже с самого медленного диска.

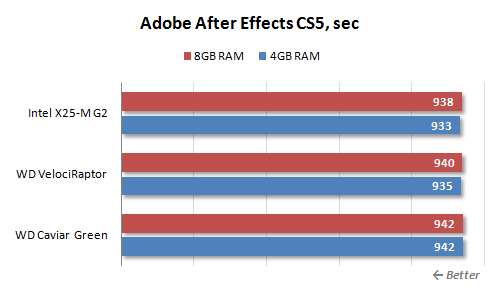

Причём, аналогичная картина наблюдается не только при простом перекодировании, но и при наложении на видео эффектов, например, в Adobe After Effects.

Вероятно для того, чтобы увидеть влияние производительности дисковой подсистемы на скорость обработки видеоданных высокого разрешения, стоит подождать роста скорости процессоров.

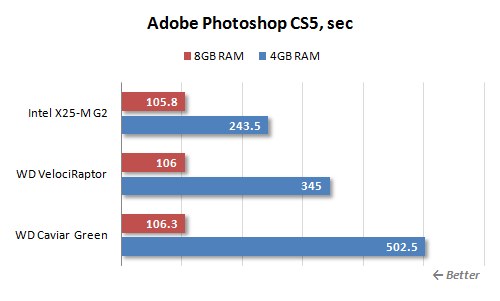

Другое дело — редактирование изображений в Adobe Photoshop. Конечно, ординарные изображения с цифровых камер с лихвой помещаются в 4 Гбайта. Однако особенность этого популярного графического редактора состоит в том, что при проведении операций с изображениями он сохраняет историю действий, и вот тут-то 4 Гбайт уже может не хватить. Собственно, при стандартных настройках — сохранении 20 последних состояний — графический редактор начинает активно использовать жёсткий диск, что и обуславливает зависимость производительности в нём от скорости работы дисковой подсистемы.

Как видим, скорость работы нашего тестового сценария, представляющего собой усовершенствованный Retouch Artists Photoshop Speed Test, включающий типичную обработку четырёх 10-мегапиксельных изображений, сделанных цифровой камерой, от скорости диска зависит более чем сильно. Разница в результатах, полученных на Western Digital Caviar Green и Intel X25-M G2, достигает двух раз. Но ещё лучшего эффекта можно достигнуть, нарастив оперативную память. Как следует из результатов, 8-гигабайтное ОЗУ позволяет обойтись вообще без кэширования данных на диск, в результате чего производительность возрастает колоссально.

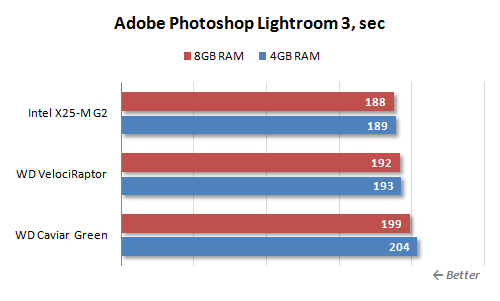

Впрочем, если говорить о работе с изображениями вообще, то Photoshop — это весьма нетипичный случай. Ведь прожорливость по отношению к памяти относится к особенностям конкретно этого редактора. Например, при пакетной обработке аналогичных изображений в Adobe Photoshop Lightroom влияние размера оперативной памяти на скорость работы оказывается минимальным.

Да и выбор жёсткого диска способен вызвать эффект, не превосходящий 10 %.

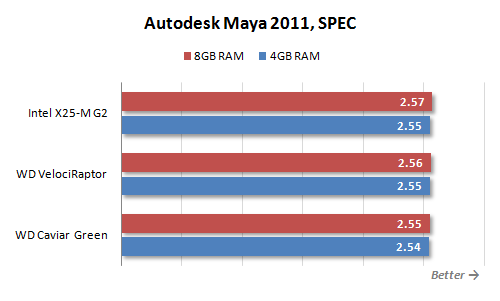

Интересным нам показалось посмотреть, есть ли зависимость от жёсткого диска и объёма памяти в современных пакетах 3D визуализации. Для примера был выбран Autodesk Maya, так как для этого пакета есть актуальный тест SPEC, оперирующий достаточно «тяжёлыми» моделями.

Впрочем, как показала практика, 4 Гбайта памяти для Maya вполне достаточно, да и от скорости дисковой подсистемы зависимость практически нулевая.

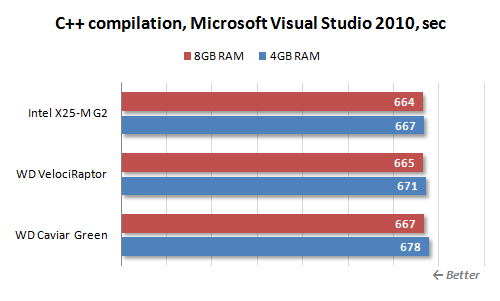

Также, мы надеялись увидеть положительное влияние быстрых дисков и увеличенного объёма оперативной памяти на скорость компиляции крупных проектов.

Однако в реальности эта зависимость оказалась незначительной. Хотя во время компиляции система и «шуршит» диском очень активно, добиться существенного ускорения этого процесса сменой носителя информации или увеличением объёма оперативной памяти не удаётся.

Тестирование в 3D играх

По поводу игр сразу же можно сказать практически то же самое, что и про работу в приложениях других типов. А именно, владельцы более быстрой дисковой подсистемы по меньшей мере имеют то преимущество, что на их компьютерах гораздо быстрее происходит загрузка игровых программ, новых уровней и сохранённых состояний. И тут вряд ли нужны какие-то комментарии — это вполне очевидное явление. Мы же, как и ранее, постараемся выяснить, оказывает ли влияние скорость винчестера и объём оперативной памяти непосредственно на игровой процесс — на наблюдаемое число кадров в секунду.

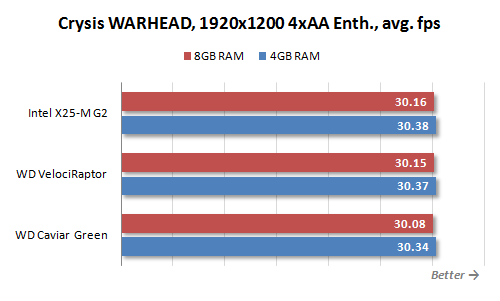

В первую очередь стоит отметить, что при подготовке данной статьи мы перепробовали много различных игр, но ни разу не столкнулись с такой, которой бы не хватало 4 Гбайт памяти. Иными словами, практически любые современные игровые приложения (если не все) не будут «уходить в своп» на типичной системе со стандартным объёмом ОЗУ. Говоря же языком цифр, картина почти всегда оказывается следующей.

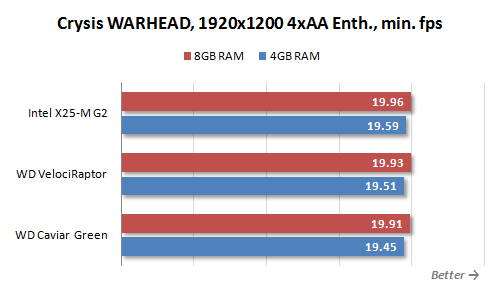

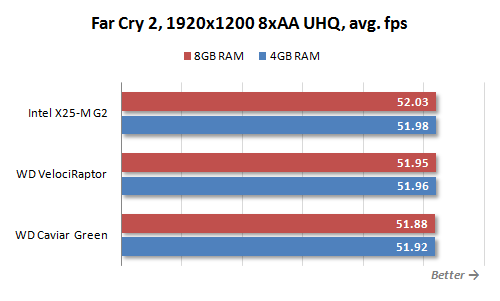

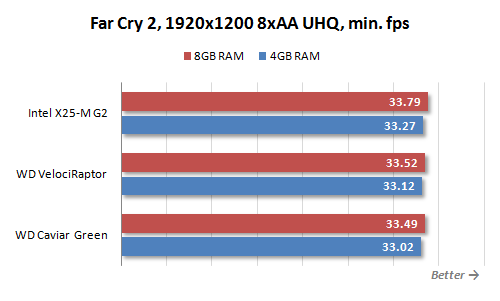

Как видим, ни от скорости жёсткого диска, ни от объёма памяти зависимости практически нет. Причём, почти постоянным оказывается как среднее число кадров в секунду, так и минимальное значение, что говорит о том, что все необходимые данные распрекрасно помещаются в память, и в процессе прохода игрового уровня никаких неожиданных подгрузок информации не происходит.

Однако при всём при этом плюсы более быстрого диска и большего объёма памяти ощутить в играх всё-таки возможно. Для этого нужно лишь немного изменить модель использования компьютера. Иными словами, если рассматривать систему в качестве простой игровой консоли, то, как мы убедились, острой необходимости в быстром диске и 8 Гбайтах оперативной памяти нет. Но если игры запускаются не в изолированной среде, а, что для многоцелевого персонального компьютера не такая уж и редкость, параллельно с какими-то другими ресурсоёмкими процессами, то ситуация может кардинально поменяться. Причём, качественные изменения наблюдаются даже в том случае, если игра с фоновым процессом прекрасно умещаются в имеющуюся оперативную память.

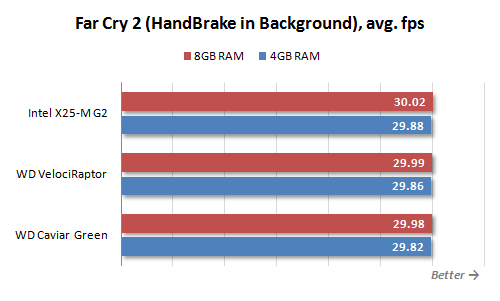

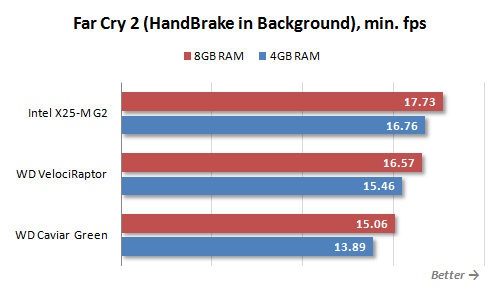

Для примера мы протестировали скорость в Far Cry 2, запущенном во время фонового перекодирования HD-видео в HandBrake. Обе эти программы вместе с операционной системой не вылезали за пределы 4 Гбайт, однако более быстрый диск или дополнительная память дала возможность ощутимо повысить минимальную скорость.

Хотя средневзвешенная производительность остаётся примерно одинаковой, фоновая дисковая активность может вызывать нежелательные подтормаживания в запущенной на переднем плане игре. Чтобы уменьшить данный отрицательный эффект, и требуется более быстрый диск и больший объём оперативной памяти.

Выводы

Несмотря на всю неочевидность поставленного в этой статье вопроса, проведённое исследование позволяет дать вполне однозначное заключение о предпочтительных направлениях апгрейда. Как показала проверка в реальных приложениях и комплексных тестах, такие приложения задействующих, наибольший эффект способно дать использование в системе скоростного SSD диска, а не увеличение объёма оперативной памяти свыше 4 Гбайт.

Банального размера памяти в 4 Гбайта сегодня хватает практически во всех типовых ситуациях, и, как показали тесты, превышение этого объёма не приносит бросающегося в глаза увеличения производительности. Небольшой положительный эффект от дополнительной памяти заметен разве только в том случае, если в системе используется совсем медленный жёсткий диск. Технология SuperFetch, использующая дополнительную память для упреждающего кэширования данных, в этом случае способна добавить системе отзывчивости. Однако инвестиции, необходимые для увеличения объёма памяти, гораздо логичнее перенаправить на совершенствование дисковой системы — результат будет куда весомее.

Надо отметить, что операционная система Windows 7, и в особенности её 64-битная версия, получила весьма продвинутый диспетчер памяти, позволяющий использовать имеющиеся в распоряжении системы гигабайты очень эффективно. В результате, при переходе с Windows Vista на более современную систему потребность в установке более 4 Гбайт ОЗУ оказывается ещё ниже, чем раньше. И даже если в Task Manager вы видите, что практически вся свободная физическая память исчерпана, скорее всего, это объясняется не её нехваткой, а, напротив, рациональным её использованием для кэширования данных с диска.

Основанная на использовании твердотельных накопителей быстрая дисковая подсистема в отличие от дополнительной памяти даст выигрыш в любом случае. Ведь возрастает не только скорость работы в приложениях, работающих с данными, подгружаемыми с диска. Улучшается и общее впечатление о работе платформы: она становится более отзывчивой на действия пользователя в целом. Операционная система и программы открываются быстрее, рабочие файлы загружаются не в пример проворнее. Влияние этих факторов на производительность труда пользователя, конечно, невелика. Но вот эмоциональный настрой благодаря услужливой готовности компьютера в считанные мгновения выполнить многие операции, ранее вызывавшие надоедливое шуршание дисками, способен сильно улучшиться.

При этом необходимо понимать, что апгрейд дисковой подсистемы — это всё-таки не совсем универсальное решение. Существует множество специфичных случаев, когда 8 Гбайт памяти могут оказаться куда полезнее, чем быстрый диск. Например, существуют приложения (в нашем тестировании таким оказался Adobe Photoshop), которые с лёгкостью могут загрузить своими данными и 8 Гбайт памяти. Большие объёмы памяти полезны при работе с виртуальными машинами, например с VMware и Oracle VM Virtual Box. В частности, если они будут получать в своё распоряжение достаточный объём ОЗУ, то пользователю не придётся останавливать одну машину, чтобы запустить другую — достаточно будет просто переключиться между ними. Впрочем, все подобные случаи относятся скорее к профессиональному использованию компьютера, а у профессионалов обычно не возникает вопросов о более рациональном апгрейде — они всё знают изначально и наверняка.

Так что наша рекомендация будет такова: если у вас действительно возникает вопрос, на какой апгрейд стоит направить свои силы, то мы советуем задуматься о совершенствовании дисковой подсистемы и о приобретении SSD дисков. Однако в том случае, если вы уже ощущаете нехватку оперативной памяти и сильно страдаете от задержек, связанных обращением операционной системы к своп-файлу, то ориентироваться в первую очередь стоит на наращивание объёма ОЗУ.

Другие материалы по данной теме

Какая память хороша для Phenom II X6?

Обзор девяти SSD Corsair

Десять SSD OCZ