Ваш город: Москва

2 Гбайта RAM: а нужно ли?

Введение

Сколько оперативной памяти достаточно для комфортной работы современной платформы? Большинство используемых сегодня систем оснащены 512 Мбайтами или 1 Гбайтом памяти. До недавнего времени этого количества вполне хватало при применении персонального компьютера в подавляющем большинстве приложений. Однако производители и продавцы памяти в последнее время начали кампанию по массовому убеждению пользователей в необходимости оснащения современных систем уже 2 Гбайтами SDRAM. Имеет ли реальные основания под собой это утверждение? Одни считают что – да, другие, что – нет, а разбираться придётся нам. В связи с тем, что комплекты памяти объёмом 2 Гбайта находят всё большее и большее распространение, мы решили провести тестирование, которое дало бы однозначный ответ на вопрос о том, есть ли необходимость установки в современные системы более 1 Гбайта RAM.

Данное тестирование мы решили проводить, используя платформу на базе процессора Athlon 64. Во-первых, такие системы имеют гораздо большее распространение среди энтузиастов, а во-вторых, именно гигабайтные модули DDR SDRAM вызывают на сегодня наибольший интерес. Дело в том, что они сильно отличаются по своим характеристикам от продуктов с ёмкостью 512 Мбайт. Объясняется это тем, что в их основе лежат принципиально разные микросхемы.

Кстати, до недавнего времени модули памяти объёмом в 1 Гбайт были достаточно редки и недёшево стоили. Но в последнее время ситуация изменилась: чипы, необходимые для производства модулей DDR SDRAM гигабайтного объёма стали более доступны. В результате, на рынке появились даже весьма скоростные гигабайтные оверклокерские модули DDR SDRAM. К сожалению, по своим характеристикам они не "дотягивают" до наиболее популярных среди энтузиастов модулей ёмкостью 512 Мбайт, но это не значит, что они не могут вызвать интереса среди оверклокеров. Конечно, 2 Гбайта памяти можно получить и при использовании четырёх модулей по 512 Мбайт. Но такое решение всегда будет работать медленнее, нежели система с парой модулей по 1 Гбайту (в первую очередь это касается Athlon 64 систем, но верно и для платформ, основанных на Pentium 4), а, кроме того, они и менее выгодно экономически. Впрочем, всякие утверждения нуждаются в проверке, а посему, перейдём к практике.

Как мы тестировали

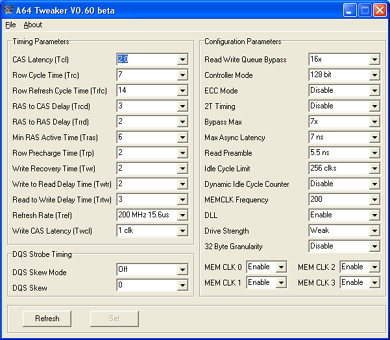

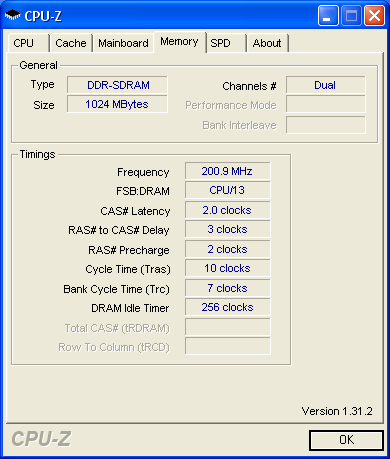

Итак, сравнение производительности систем, оснащённых различным объёмом памяти, выполнялось нами по достаточно простой схеме. В одной и той же тестовой платформе, построенной с использованием новейшего процессора AMD Athlon 64 FX-60 и видеокарты NVIDIA GeForce 7800 GT, мы попеременно устанавливали два модуля по 512 Мбайт и два модуля по 1024 Гбайт. Память в обоих случаях работала на частоте 400 МГц при 1T Command Rate, а чтобы сравнение было корректным, использовался и совершенно идентичный набор остальных таймингов.

Следует заметить, что установка наиболее агрессивных (и лучших с точки зрения производительности) задержек 2-2-2-10 при использовании даже лучших модулей DDR400 SDRAM объёмом 1024 Мбайта невозможно: все такие модули в данных условиях функционируют нестабильно. Именно поэтому, нам пришлось довольствоваться таймингами 2-3-2-10.

Параллельно с тестированием производительности пар модулей ёмкостью 512 и 1024 Мбайта, мы решили измерить быстродействие и при использовании в системе четырёх модулей DDR400 SDRAM по 512 Мбайт. Однако сразу следует отметить, что использование такой конфигурации подсистемы памяти неоптимально. Дело в том, что инсталляция четырёх двухсторонних модулей DIMM в Athlon 64 системах автоматически приводит к необходимости использования 2T Command Rate, что отрицательным образом сказывается на производительности.

Кроме того, есть и ещё один минус применения в системе четырёх DIMM моделей, касающийся темы нашего обзора лишь косвенно. Использование четырёх модулей памяти в Athlon 64 платформах ощутимо снижает их разгонный потенциал с точки зрения увеличения частоты шины. Например, большинство Socket 939 материнских плат при установке в них полного набора DIMM модулей редко оказываются способны поднимать частоту тактового генератора свыше 240-250 МГц. Простое же извлечение пары модулей при этом тут же отодвигает "порог стабильности" далеко за отметку 300 МГц.

В процессе тестовых испытаний нами был использован следующий набор комплектующих:

Процессор: AMD Athlon 64 FX-60;

Материнская плата: DFI LANParty UT NF4 Ultra-D (NVIDIA nForce4 Ultra);

Память:

2048MB DDR400 SDRAM (Corsair CMX1024-3500LLPRO, 2 x 1024 MB, 2-3-2-10);

2048MB DDR400 SDRAM (Corsair CMX512-3200XLPRO, 4 x 512 MB, 2-3-2-10);

1048MB DDR400 SDRAM (Corsair CMX512-3200XLPRO, 2 x 512 MB, 2-3-2-10);

Графическая карта: NVIDIA GeForce 7800 GT 256MB (PCI-E x16);

Дисковая подсистема: Maxtor MaXLine III 250GB (SATA150);

Операционная система Windows XP SP2.

2 Гбайта против 1 Гбайта: результаты тестов

Синтетические тесты: PCMark05, 3DMark06 и ScienceMark 2.0

В первую очередь для оценки производительности платформ, оснащённых памятью различного объёма, мы решили воспользоваться популярными синтетическими тестами.

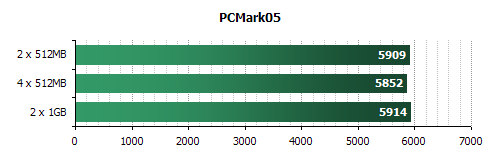

PCMark05 использует для оценки быстродействия систем те же алгоритмы, что и реальные приложения. Однако для его работы много памяти не требуется: платформы, оснащённые оперативной памятью объёмом 1 и 2 Гбайта, демонстрируют примерно одинаковые результаты.

В то же время несколько выделяется производительность системы, в который мы использовали четыре модуля DIMM по 512 Мбайт. Эта конфигурация работает чуть медленнее, нежели системы, в которых используется лишь две "плашки" памяти. Это отставание как раз и иллюстрирует снижение производительности при включении 2T Command Rate вместо используемого по умолчанию тайминга 1T. К сожалению, увеличение нагрузки на шину памяти Athlon 64 вследствие возрастания количества обслуживаемых банков требует активации менее агрессивных режимов работы контроллера памяти для поддержания стабильности системы. Таким образом, необходимо иметь в виду, что увеличение объёма памяти может приводить не только к росту производительности, но и к её уменьшению.

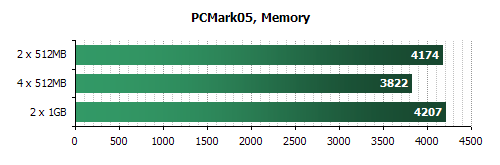

Тест PCMark05 содержит и отдельный бенчмарк подсистемы памяти. Давайте обратимся и к его результатам.

Очевидно, что этот подтест из PCMark05 также задействует менее 1 Гбайта памяти. Поэтому, существенной разницы в результатах платформ, оборудованных различным объёмом памяти, не заметно. Зато, отрицательное влияние увеличения задержки Command Rate до 2T при установке четырёх двухсторонних модулей DDR400 SDRAM видно очень хорошо.

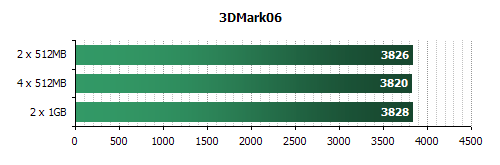

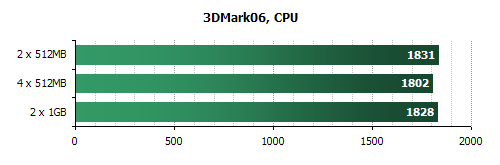

Недавно вышедший синтетический бенчмарк 3DMark06 в первую очередь позволяет оценить производительность графической подсистемы. Однако он позиционируется разработчиком как средство для оценки игровой производительности системы в целом, поэтому мы решили в данном материале воспользоваться и им.

Впрочем, показатели 3DMark06 зависимость от объёма оперативной памяти продемонстрировали крайне незначительную.

Результаты же, полученные в процессорном тесте из того же бенчмарка, основанные на измерении производительности систем при моделировании физики игровой среды и искусственного интеллекта игровых персонажей очень походят на результаты PCMark05. Как видим, и в данном случае 1 Гбайт оперативной памяти является вполне достаточным объёмом.

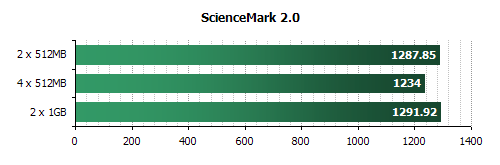

Последний синтетический тест, который мы решили задействовать для наших изысканий, это – ScienceMark 2.0. Он позволит нам получить представление о необходимости более 1 Гбайта памяти при типичных физических расчётах (преимущественно с использованием методов молекулярной динамики).

Та же картина. И это тестовое приложение не даёт возможности оценить плюсы большого объёма памяти. Зато минусы заполнения всех четырех слотов DIMM оно показывает хорошо.

Следует заметить, что одним из аргументов, который приводится производителями процессоров в пользу перехода на архитектуру x86-64, является возможность использования более 4 Гбайт памяти. Однако пока что мы не видим необходимости в применении даже 2 Гбайт RAM. Странно, не правда ли? Впрочем, по одним лишь синтетическим бенчмаркам делать какие-то выводы явно преждевременно, поэтому давайте взглянем на результаты тестов исследуемых платформ в реальных приложениях.

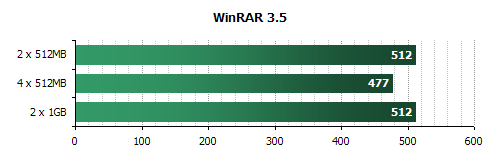

Скорость сжатия данных

Наличие 2 Гбайт памяти в системе может позволить архиваторам проводить сжатие данных при использовании словаря большего объёма, чем используется сегодня. Это, теоретически, способно повысить эффективность работы таких программ. Однако на данный момент современные распространённые архиваторы эту возможность не используют, что и приводит к отсутствию зависимости скорости сжатия данных от объёма оперативной памяти.

Зато большое влияние на скорость архивации оказывает латентность подсистемы памяти. Поэтому, по данным наших измерений, система с четырьмя модулями DIMM, использующая 2T Command Rate, отстаёт от аналогичной системы с двумя модулями памяти и таймингом 1T Command Rate более чем на 7%.

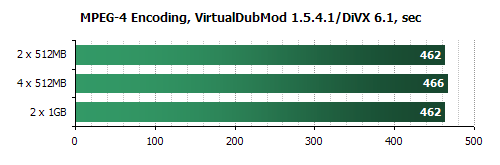

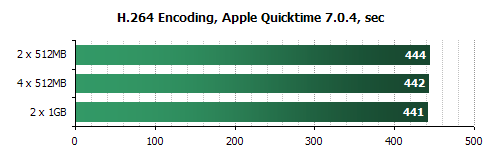

Кодирование видео

Скорость кодирования видео современными кодеками от параметров подсистемы памяти зависит незначительно. Это отмечалось нами и ранее. Поэтому, совершенно неудивительно, что изменение объёма установленной памяти и количества используемых модулей практически не сказывается на быстродействии.

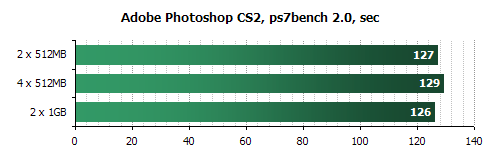

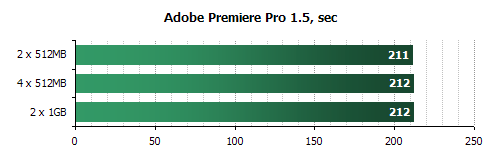

Обработка изображений и видео

Приложения, используемые для редактирования изображений и для нелинейного видеомонтажа, традиционно считаются весьма требовательными к аппаратным ресурсам. Однако давайте посмотрим, что изменится, если в их распоряжении окажется 2 Гбайта оперативной памяти.

В Adobe Photoshop СS2 наблюдается незначительное ускорение выполнения тестового скрипта при увеличении объёма оперативной памяти. Но при установке четырёх модулей DIMM вместо двух это преимущество полностью съедается увеличившимися задержками. Так что прирост в скорости существует, если только речь идёт об использовании двух модулей памяти по 1 Гбайту.

В то же время надо отметить, что при тестировании производительности систем в Photoshop мы использовали эталонное изображение, занимающее лишь 100 Мбайт в оперативной памяти. В отдельных же случаях, например, в полиграфии, может требоваться обработка гораздо больших по размеру изображений. И в этом случае, естественно, дополнительная память будет совсем не лишней. Однако такие случаи возникают в первую очередь при профессиональном применении PC и рядовых пользователей обычно не касаются.

Adobe Premiere Pro 1.5 и вовсе к объёму оперативной памяти остаётся совершенно безучастен. Это не та задача, которая может "съесть" сегодня под свои нужды более 1 Гбайта RAM.

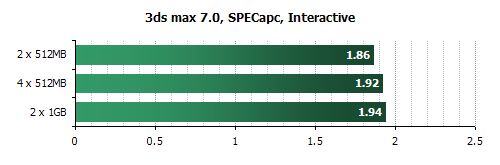

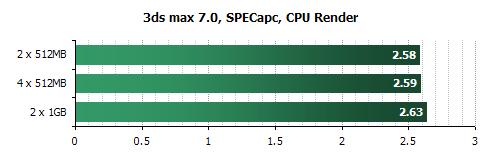

Быстродействие в 3ds max 7

Популярное профессиональное приложение для 3D моделирования и рендеринга, 3ds max 7, также не совершает качественного скачка в производительности при увеличении объёма оперативной памяти. В то же время, некоторый эффект от установки в платформу второго гигабайта RAM наблюдается.

Например, при работе в окнах проекции тест SPECapc показывает возрастание производительности на 3.2% в случае использования четырёх модулей DDR400 SDRAM ёмкостью по 512 Мбайт и на 4.3% - при применении двух модулей по 1 Гбайту. То есть, в этом случае положительный эффект от наличия дополнительной памяти оказывается даже сильнее отрицательного влияния включения тайминга 2T в случае заполнения всех слотов DIMM на материнской плате.

При финальном рендеринге в 3ds max 7 ситуация похожа, но дополнительная память даёт несколько меньший эффект. Превосходство платформы с двумя гигабайтными модулями DDR400 SDRAM над платформой с двумя модулями памяти по 512 Мбайт составляет всего лишь 1.9%.

Хотя мы, наконец, смогли зафиксировать прирост производительности, наблюдающийся при увеличении объёма оперативной памяти до 2 Гбайт, говорить о его решающем значении вряд ли возможно. Прирост скорости работы в 2-4% вряд ли может быть замечен обычным пользователем.

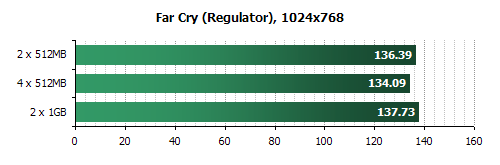

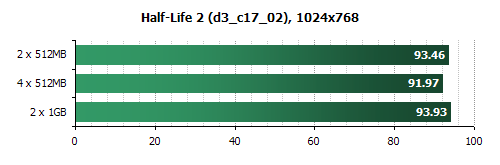

Игровые тесты

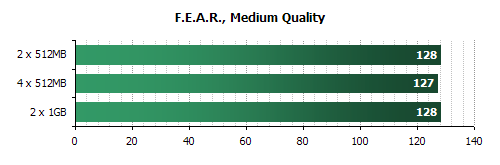

Игры прошлого поколения не отличаются особой требовательностью к объёму оперативной памяти. Добавление второго гигабайта RAM в систему не приводит к видимому увеличению производительности. Зато при установке в системе четырёх модулей памяти производительность снижается из-за включения 2T Command Rate. Величина такого падения быстродействия составляет 1-2%.

Глядя на результаты, полученные в тесте в новой игре F.E.A.R., можно сделать вывод о том, что и новейшим играм 1 Гбайта памяти, в принципе, хватает.

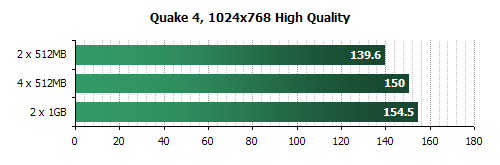

Однако измерение производительности в Quake4 предыдущий вывод не подтверждает. Здесь налицо видимый рост количества fps при добавлении в систему дополнительной RAM. В лучшем случае (при использовании гигабайтных модулей) прирост составляет 10%. Это – наибольший результат, зафиксированный нами в данном тестировании.

Производительность при многозадачности

В целом, ситуация с зависимостью производительности от объёма оперативной памяти, ясна. Большинству современных задач вполне хватает 1 Гбайта памяти. Какой-то выигрыш в скорости при установке 2 Гбайт RAM можно получить разве только в "тяжёлых" профессиональных приложениях и в наиболее современных играх, высококачественная графика которых требует хранения в оперативной памяти больших объёмов текстур.

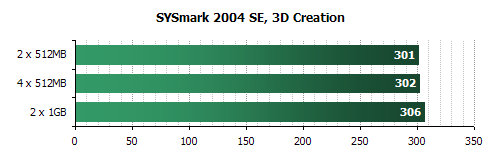

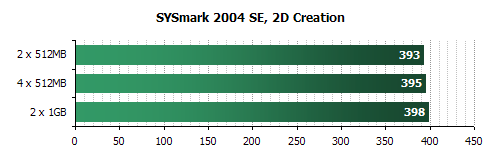

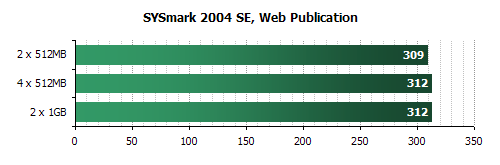

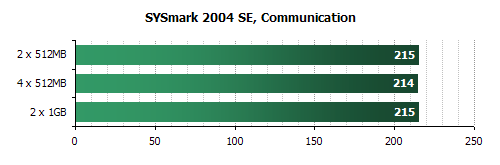

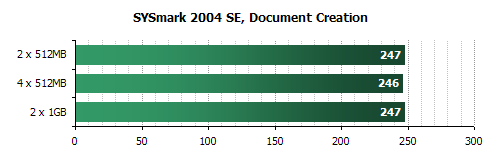

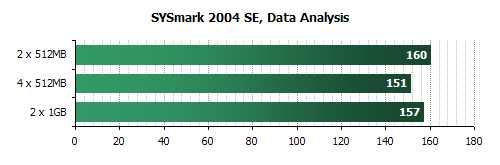

Впрочем, делать окончательные выводы мы пока не будем, а посмотрим, как повлияет объём оперативной памяти на скорость работы в многозадачной среде. Ведь, обычно, на персональном компьютере запущено несколько параллельных программ, которые в сумме могут задействовать более 1 Гбайта оперативной памяти. Для оценки быстродействия при наиболее типичных многозадачных моделях использования PC мы решили использовать тест SYSMark 2004 SE, который содержит шесть наиболее стандартных сценариев.

В этом тесте в пакете 3ds max 5.1 рендерится в bmp файл изображение, и, в это же время, пользователь готовит web-страницы в Dreamweaver MX. Затем пользователь рендерит в векторном графическом формате 3D анимацию.

Полученные же результаты показывают, что при параллельном использовании "тяжёлых" приложений второй гигабайт памяти может дать некоторое преимущество в производительности. Впрочем, в данном случае величина этого превосходства совсем мала.

В этом случае моделируется работа в Premiere 6.5 пользователя, который создает видео-ролик из нескольких других роликов в raw-формате и отдельных звуковых треков. Ожидая окончания операции, пользователь готовит также изображение в Photoshop 7.01, модифицируя имеющуюся картинку и сохраняя ее на диске. После завершения создания видео-ролика, пользователь редактирует его и добавляет специальные эффекты в After Effects 5.5.

Как и предыдущем случае, производительность платформ, оснащённых 2 Гбайтами памяти, превосходит быстродействие системы с 1 Гбайтом памяти. Однако вновь величина этого преимущества не превышает 2%.

Здесь гипотетический пользователь разархивирует контент веб-сайта из архива в zip-формате, одновременно используя Flash MX для открытия экспортированного 3D векторного графического ролика. Затем пользователь модифицирует его путем включения других картинок и оптимизирует для более быстрой анимации. Итоговый ролик со специальными эффектами сжимается с использованием Windows Media Encoder 9 для транслирования через Интернет. В конце концов, создаваемый веб-сайт компонуется в Dreamweaver MX, а параллельно система сканируется на вирусы с использованием VirusScan 7.0.

Данный сценарий показывает меньшую требовательность к объёму оперативной памяти. Впрочем, положительное влияние второго гигабайта памяти заметно и тут. Хотя, конечно, размер этого влияния никоим образом не соизмерим со стоимостью второго гигабайта RAM.

В данном случае моделируется работа пользователя, получающего письмо в Outlook 2002, которое содержит набор документов в zip-архиве. Пока полученные файлы сканируются на вирусы при помощи VirusScan 7.0, пользователь просматривает e-mail и вносит пометки в календарь Outlook. Затем пользователь просматривает корпоративный веб-сайт и некоторые документы при помощи Internet Explorer 6.0.

Данный сценарий использует сравнительно простой набор задач. Поэтому, совершенно неудивительно, что для его исполнения оперативной памяти объёмом 1 Гбайт оказывается предостаточно.

В данном бенчмарке гипотетический пользователь редактирует текст в Word 2002, а также использует Dragon NaturallySpeaking 6 для преобразования аудио-файла в текстовый документ. Готовый документ преобразуется в pdf формат с использованием Acrobat 5.0.5. Затем, пользуясь сформированным документом, создается презентация в PowerPoint 2002.

Про данный сценарий можно лишь повторить слова, сказанные про предыдущий график. В этом случае увеличенного объёма RAM не требуется.

Здесь модель работы такова: пользователь открывает базу данных в Access 2002 и выполняет ряд запросов. Документы архивируются с использованием WinZip 8.1. Результаты запросов экспортируются в Excel 2002, и на их основании строится диаграмма.

Подытоживая, следует отметить, что активность, связанная с работой в типичных офисных приложениях, вполне обходится 1 Гбайтом памяти, даже если речь идёт о параллельной работе пользователя в нескольких программах. В то же время обработка и создание цифрового контента, при котором обычно применяется несколько программных продуктов одновременно, может слегка выиграть от установки дополнительной памяти. Впрочем, если речь не идёт о работе с данными "со сверхвысоким разрешением", полученная выгода эфемерна: результаты SYSMark 2004 SE говорят о том, что прирост быстродействия в этом случае в среднем составляет 1-2%.

Тесты в пользу 2 Гбайт памяти

Практически все тесты, результаты которых приведены выше, говорят об одном: 1 Гбайта памяти для сегодняшних приложений хватает. Однако наверняка найдутся те, кто не согласится с этим тезисом. Именно таким нашим читателям мы и посвящаем этот подраздел, в котором мы попытаемся показать, что 2 Гбайта оперативной памяти лишними сегодня не будут. Дело в том, что несмотря на всё вышесказанное, существует множество ситуаций, в которых 1 Гбайта RAM может оказаться недостаточно.

Во-первых, большое количество оперативной памяти может потребоваться при использовании приложений, работающих со значительными объёмами данных. Об этой ситуации мы уже упоминали. Например, при редактировании крупных изображений полиграфического качества в Adobe Photoshop, 1 Гбайта может попросту не хватить для выполнения требуемых операций. Можно придумать и другие подобные примеры. Однако все они будут касаться профессионального использования PC и в обычной практике возникают нечасто. Высокопроизводительные же рабочие станции оборудуются 2 или 4 Гбайтами RAM уже давно.

Другой случай нехватки 1 Гбайта RAM для комфортной работы может возникнуть при использовании нескольких параллельно работающих с памятью задач. В настоящее время двухъядерные процессоры, позволяющие без проблем выполнять одновременно несколько вычислительных потоков, невзначай подталкивают нас к именно такому алгоритму работы с компьютером. Зачем дожидаться окончания кодирования видео или рендеринга ролика? Параллельно можно заняться чем-то иным, благо процессоры с двухъядерной архитектурой имеют достаточные возможности для нормального выполнения (без раздражающих подтормаживаний) приложений даже в том случае, если в фоновом режиме работает ресурсоёмкая программа.

Понятно, что, запуская таким образом в фоновом режиме всё новые и новые задачи, можно исчерпать всю доступную физическую оперативную память, что заставит диспетчер памяти Windows активно задействовать механизм виртуальной памяти. То есть, часть необходимых одновременно работающим приложениям данных будет периодически оказываться на жёстком диске в файле подкачки. Таким образом, в процесс работы CPU с памятью вмешается жёсткий диск, который с лёгкостью возьмёт на себя роль самого "узкого" места в системе.

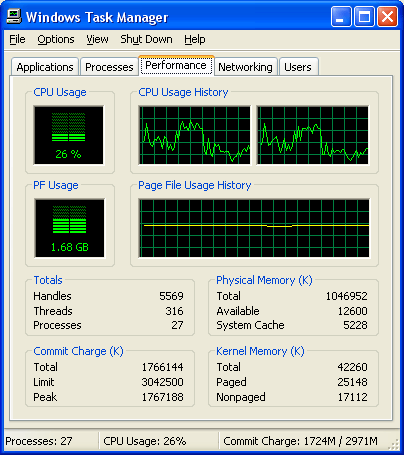

Поскольку обращения к жёсткому диску выполняются гораздо дольше, чем к оперативной памяти, процессор начнёт простаивать в ожидании подкачки новых данных, что обязательно снизит производительность систему. Вот, например, скриншот, показывающий загрузку CPU при параллельном запуске трёх копий архиватора 7-zip с 32-мегабайтным словарём.

В то время как две работающие копии этого архиватора без проблем занимают процессор на все 100%, запуск третьей копии приводит к активному использованию своп-файла. Результат налицо: загрузка процессора, а, следовательно, и производительность снижается примерно в четыре раза именно по причине недостаточного объёма RAM. Три четверти времени процессор попросту простаивает в ожидании прибытия необходимых для работы данных, которые оказываются в файле подкачки. Добавление в систему оперативной памяти, естественно, способно решить данную проблему. Впрочем, описанный выше случай скорее всего также следует отнести к экзотическим ситуациям. В обычной деятельности такие условия пока что встречаются нечасто. Поэтому, в защиту 2 Гбайт хочется привести какой-нибудь более весомый и серьёзный аргумент. И такой аргумент существует.

Это – современные игры последнего поколения. Хотя тесты на основе измерения среднего количества fps в предварительно записанном демонстрационном прогоне не показывают острой необходимости в большом количестве памяти, в действительности дело обстоит немного по-другому. Во время реальной игры текстуры подгружаются с жёсткого диска по мере необходимости. Соответственно, если в системе больше оперативной памяти, то такие обращения к жёсткому диску за новой порцией текстур выполняются много реже. Современные игры вроде Battlefield 2, Quake 4 или F.E.A.R. при установке высокого качества изображения с 1 Гбайтом оперативной памяти чувствуют себя неуютно. Обращения к винчестеру за текстурами в сложных сценах следуют одно за другим, и это вызывает неприятные подтормаживания, которые ухудшают и динамику игры, и банально мешают прицеливаться.

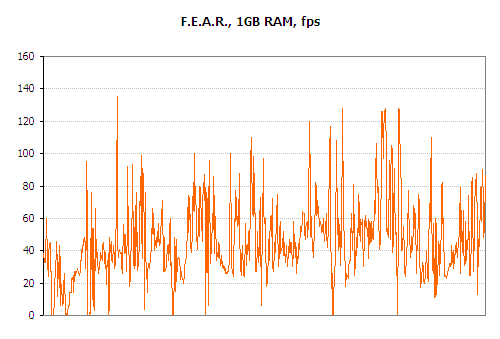

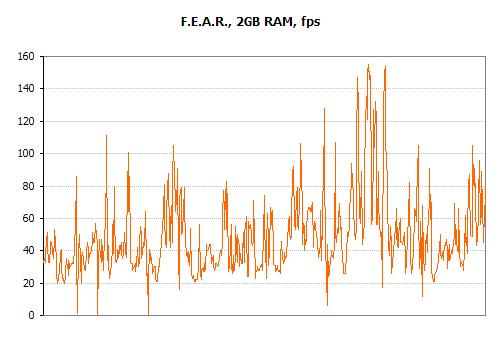

Чтобы проиллюстрировать вышесказанное, мы записали лог мгновенных fps при прохождении уровня Point of Entry (Interval 08 – Desolation) с различным количеством памяти. При этом были выставлены максимальные настройки графики с единственным послаблением: мы отключали "мягкие" тени.

Когда наша система была снабжена 1 Гбайтом памяти, мы столкнулись с неприятными задержками, особенно в самом начале уровня, где действие происходит на открытом пространстве.

Добавление в систему второго гигабайта памяти картину меняет в корне: большинство задержек пропадает, и даже в начале уровня движения выполняются с достаточной для комфортной игры плавностью.

Отметим, что в то время когда в системе был установлен 1 Гбайт памяти, уровень менее 20 кадров в секунду фиксировался в 8% случаев. Увеличение количества установленной памяти до 2 Гбайт позволяет уменьшить этот показатель до 1%. Причём, этот процент практически полностью формируется за счёт автосохранений в заранее предопределённых чекпоинтах, где эта дискретность совершенно не раздражает. То есть, играть в F.E.A.R. при максимальном качестве текстур с 1 Гбайтом RAM очень трудно.

Аналогичная картина наблюдается и в других современных играх, названия которых были упомянуты выше. Таким образом, геймеры, имеющие дорогие и производительные видеокарты последнего поколения, но всего 1 Гбайт оперативной памяти, уже в полной мере ощутили необходимость наращивания количества RAM. Именно эта категория пользователей (наряду с отдельными профессионалами) действительно сильно нуждается сегодня в 2-гигабайтной подсистеме памяти.

Выводы

Пора подвести итоги. А они таковы: на сегодня 1 Гбайта памяти хватит практически для любой средней системы. Такое количество памяти позволяет комфортно работать во всех современных приложениях. Вы даже сможете запускать параллельно несколько программ, не испытывая особых неудобств при переключении между ними. Игры прошлого поколения также не будут замедляться при максимальных установках качества, а свежие игры, вышедшие в конце прошлого года, смогут работать без проблем при среднем качестве используемых текстур.

Однако высокопроизводительные системы сегодня уже просто обязаны комплектоваться 2 Гбайтами RAM. Необходимость в таком количестве памяти в первую очередь испытывают на себе геймеры, желающие задействовать максимальный уровень качества в играх последнего поколения. Кроме того, 2 Гбайта памяти (или даже больше) будут полезны и некоторым профессионалам, сталкивающимся в своей деятельности с "тяжелыми" приложениями.

Таким образом, можно говорить о том, что надобность в 2-гигабайтных комплектах памяти для энтузиастов существует. И чем дальше, тем больше будет эта потребность. Поэтому, в нашей следующей статье, которая появится на сайте через несколько дней, мы протестируем несколько таких комплектов от ведущих производителей. Тем более, как показывают наши результаты, если уж вы решили установить в свой компьютер 2 Гбайта памяти, то сделать это лучше именно двумя гигабайтными модулями.