Ваш город: Москва

NVIDIA Multi-GPU Технология SLI – Новый подход к старым идеям

Вступление

Как известно, всё новое – хорошо забытое старое, а гениальные идеи витают в воздухе до тех самых пор, пока кто-то не решится претворить их в жизнь. В попытке закрепить за собой звание разработчика самых быстрых в индустрии графических карт потребительского класса NVIDIA Corp. пошла по наиболее, казалось бы, простому пути: компания предложила пользователям объединять пару графических карт на базе определенных чипов GeForce 6 в массив, чья производительность была бы непобедимой одночиповыми решениями конкурента ATI Technologies.

"Несложная" идея от NVIDIA с одной стороны давала пользователям некое ощутимое преимущество от перехода на платформы с шиной PCI Express, которые могли бы поддерживать две графические карты, однако, ставила перед покупателями ряд требований, такие как, специализированная материнская плата, мощный блок питания, а также, как потом оказалось, поддержку драйверами NVIDIA их любимых игр, чтобы избежать зависаний, артефактов и получить вожделенную добавку к скорости.

Воплощение плана по популяризации многочиповых решений сулит NVIDIA, помимо роста доходов, потенциального увеличения контролируемой доли рынка и всеобщего признания, дополнительную работу над драйверами, их заточку для массивов из графических карт, а также ряд других трудозатрат, вроде работы с разработчиками игр. Тем не менее, несмотря на все трудности, сегодня можно довольно уверенно сказать: Multi-GPU технология NVIDIA – Scalable Link Interface – имеет шансы завоевать рынок: соответствующие графические карты и материнские платы присутствуют на рынке и могут быть довольно легко приобретены, пусть и за довольно высокую цену.

Сегодня мы рассмотрим несколько примеров работы Multi-GPU массивов на базе NVIDIA GeForce 6, связанные с их использованием трудности, возможные проблемы, а также результаты тестирования в нескольких десятках популярных игр.

Взгляд в прошлое

SGI: Инструмент для профессионалов

История многопроцессорной компьютерной графики уходит своими корнями в достаточно глубокое для IT-индустрии прошлое. Еще в 1993 году компания SGI анонсировала линейку мощнейших по тем временам графических серверов Onyx.

Графическая подсистема этих машин состояла из блока расчета геометрии, генератора изображения, отвечающего за вывод информации на дисплей, и так называемого Raster Manager, на плечи которого была возложена работа с текстурами. Наиболее дешевый вариант такой системы, носивший название VTX, не очень интересен, хотя и в нем плата блока расчета геометрии несла 6 специализированных процессоров Intel i860XP. Гораздо более любопытной была система Reality Engine 2, позволявшая с целью увеличения производительности наращивать число плат Raster Manager с одной до четырех. Что интересно, в этом случае объем текстурной памяти не увеличивался, так как ее содержимое дублировалось для всех четырех плат, однако, объем кадрового буфера в максимальной конфигурации достигал 160 МБ – невероятно много по тем временам.

Таким образом, SGI Onyx, пожалуй, можно назвать первой коммерческой системой, оснащенной многопроцессорной графической подсистемой. Стоимость этих комплексов достигала $1 000 000, и неудивительно, что доступны они были лишь процветающим компаниям. Ни о каком игровом применении таких систем не могло быть и речи.

3dfx: Поделим кадр пополам

Спустя два года эпоха аппаратной трехмерной графики добралась и до обычных настольных ПК – в 1995 году компания 3Dfx Interactive, ныне поглощенная NVIDIA, представила на рынок первый ускоритель игрового класса – 3Dfx Voodoo Graphics. По тем временам это было абсолютно революционное решение, значительно улучшавшее качество графики и производительность.

Чипсет Voodoo Graphics состоял из двух микросхем – FBI (Frame Buffer Interface), отвечавшей за буфер кадра, и TMU (Texture Mapping Unit), осуществлявшей работу с текстурами. Уже тогда он содержал в себе возможность увеличения производительности путем добавления дополнительных TMU, число которых для одного FBI могло достигать трех. Впрочем, такие конфигурации нам неизвестны – большинство выпускавшихся карт Voodoo Graphics несли на борту 1 FBI, 1 TMU и 4 МБ видеопамяти, 2 из которых было отведено под буфер кадра, а остальное – под хранение текстур. Тем не менее, компания Obsidian3D, специализирующаяся на производстве мощных графических систем, выпустила карту Obsidian 100SB, которая объединяла в себе два чипсета Voodoo Graphics, работавших в режиме SLI. Тут необходимо сделать небольшое пояснение и расшифровать данный термин.

Одним из вариантов расшифровки буквосочетания SLI является Scan Line Interleave, то есть – чередование строк кадра. Это проливает свет на то, каким образом работала эта технология: один чипсет Voodoo Graphics отвечал за четные строки кадра, а другой – за нечетные; таким образом, нагрузка на ускорители делилась пополам, и общая производительность увеличивалась.

Obsidian 100SB не была массовой картой, и режим SLI для Voodoo Graphics оставался экзотикой, но в начале 1998 года 3Dfx представила на суд публики новый чипсет – Voodoo2, обладавший более высокой производительностью, и именно он стал первым массовым решением, официально поддерживающим возможность наращивания производительности путем объединения двух плат на его основе посредством технологии SLI.

Каждая Voodoo2 была оснащена специальным разъемом, через который две карты соединялись посредством специального гибкого шлейфа. Надо сказать, что по-настоящему популярной такая конфигурация так и не стала, причем, причина была ясна – очень высокая по тем временам стоимость подобной системы, ведь в 1998 году за одну плату Voodoo2 приходилось выкладывать более $300! Впрочем, истинные энтузиасты все-таки обзаводились двумя Voodoo2, ведь в то время такая связка обеспечивала непревзойденный уровень производительности и качества графики. Существовал и одноплатный вариант от Quantum3D – Obsidian2 X-24, обладавший даже несколько более высокой производительностью, нежели Voodoo2 SLI, но стоивший чрезвычайно дорого – в районе $650, а потому также не получивший широкого распространения.

Время шло, и весной 1999 года NVIDIA выпустила новый графический чип TNT2, который, в версии Ultra, вполне мог потягаться с Voodoo2 SLI, а, кроме того, умел работать с 32-битным цветом, чего продукты 3dfx были лишены напрочь. Карты Riva TNT2 Ultra хотя и стоили весьма значительных денег, но все же один такой видеоадаптер стоил дешевле, чем пара Voodoo 2 и не требовал для режима 2D отдельной видеокарты.

ATI Technologies: Рендерим два кадра одновременно

Объединить два чипа на одной плате и увеличить производительность попыталась и ATI Technologies, которой нечем было ответить на удар NVIDIA, представившей осенью 1999 года графический процессор GeForce 256. Подход, избранный ATI, был иным, нежели у 3dfx Interactive. Суть технологии MAXX, а именно такое название получила разработка ATI, заключалась в том, что два чипа, установленные на одной PCB, должны были одновременно отрисовывать разные кадры, а затем поочередно выводить их на экран. Другое название этой технологии, позволяющей двум чипам поочередно выводить на экран уже готовые кадры – AFR, или Alternate Frame Rendering.

По производительности новинка, получившая название Rage Fury MAXX, примерно соответствовала GeForce 256 SDR, а в 32-битном цвете и опережала ее, но ее погубила реализация технологии AFR, которая в исполнении ATI оказалась мало на что годной из-за массы серьезных недоработок. В частности, синхронизация работы двух графических чипов RAGE 128 PRO была полностью программной, реализованной в драйвере, что не могло не сказаться на задержках при переключении между чипами. В результате часто возникала ситуация, когда один чип не поспевал за другим, и происходила десинхронизация их работы, приводящая к резким скачкам производительности и рывкам изображения. Кроме того, особенности технологии MAXX не позволяли использовать Rage Fury MAXX в других системах, кроме Windows 98, что стало последним гвоздем в гроб этой карты. Очередная попытка вывести на рынок настольной графики мультипроцессорные решения опять потерпела крах.

Последняя попытка 3dfx

Между тем, 3dfx (компания сменила название) переживала далеко не лучшие времена – ее решения, еще недавно являвшиеся верхом совершенства, уступали конкурентам с архитектурной точки зрения, да и производительность их уже не казалась столь высокой. Непонятно почему, но компания вновь сделала ставку на многопроцессорность, хотя, казалось бы, уже стало ясно, что создание таких видеоадаптеров невыгодно, так как они получаются излишне сложными и чрезвычайно дорогими.

Итак, 15 ноября все того же, 1999 года, 3dfx анонсировала новый чип VSA-100, поддерживающий 32-битный цвет и умеющий работать в многопроцессорных конфигурациях. Такая возможность получила название VSA – Voodoo Scalable Architecture, то есть, масштабируемая архитектура Voodoo. Очередная инкарнация SLI была значительно усовершенствована – в частности, она позволяла объединять до 32 чипов VSA-100, каждый из которых мог обрабатывать определенную последовательность строк кадра, причем размер обрабатываемой полосы мог динамически меняться в зависимости от нагрузки. Из набора этих полос, предоставленных ведомыми (slave) чипами, ведущий чип и формировал затем финальный кадр.

Увы, реальные карты на базе VSA-100 появились в продаже слишком поздно, и на рынке уже прочно обосновалась NVIDIA со своими разработками в лице чипов GeForce 256 и GeForce2 GTS, которые были не только не менее производительны, но и более совершенны с технической точки зрения – они обладали аппаратным процессором TnL. Фактически, свет увидела лишь двухпроцессорная реализация VSA в лице карт Voodoo5 5000 и Voodoo5 5500. Четырехпроцессорный монстр Voodoo5 6000, требовавший подключения специального внешнего блока питания, был выпущен в весьма ограниченных количествах, и эти карты в наше время являются настоящим раритетом.

Дальнейших попыток компания 3dfx Interactive не предпринимала, хотя в ее планах и значились новые разработки, использующие многочиповые архитектуры. Этим планам так и не суждено было осуществиться, так как в конце 2000 года 3dfx была поглощена NVIDIA Corp., и мир надолго забыл о мультипроцессорных графических решениях бытового класса.

XGI: неудачный гибрид

Впрочем, 16 сентября 2003 года была предпринята еще одна попытка протолкнуть на рынок мультипроцессорные видеоадаптеры. Компания XGI, некогда бывшая графическим подразделением SiS, анонсировала целую линейку новых графических процессоров Volari, обладавших поддержкой DirectX 9.0 и способных работать в двухчиповых конфигурациях. На бумаге все выглядело отлично – два VPU, имевшие по 8 конвейеров рендеринга каждый, обещали многое, но, как всегда, подвела реализация. Дело в том, что XGI, не имеющая большого опыта в проектировании столь сложных систем, создала нечто среднее между технологиями 3dfx VSA и ATI MAXX. От первой она позаимствовала концепцию master-slave, а от второй сам метод увеличения производительности, при котором каждый чип занимается обработкой целого отдельного кадра. При этом, компания соединила процессоры шиной BitFluent с пропускной способностью всего 2.13 ГБ/сек., что автоматически создавало в системе из двух VPU Volari V5/V8 так называемое "бутылочное горлышко".

Помимо этого, сами чипы оказались настолько неудачными, что даже старшая модель, Volari Duo V8 Ultra, продемонстрировала нам производительность на уровне RADEON 9600 XT, а также ужасающее качество изображения, и это при цене почти в $500! Неудивительно, что попытка выйти на рынок с таким решением полностью провалилась, и линейка Volari Duo V5/V8 была предана забвению.

Исходя из написанного выше, историю потребительских многочиповых видеоадаптеров можно назвать историей провалов и поражений, так как ни одна из предпринятых попыток вывести на рынок такой продукт так и не возымела заметного успеха.

Казалось бы, идея использования нескольких графических процессоров в обычном настольном ПК навсегда похоронена, но, как оказалось, идея эта не только выжила, но и совсем недавно была реализована компанией NVIDIA на совершенно новом уровне.

NVIDIA SLI: принципы работы

Для начала следует сказать, что аббревиатура SLI в варианте NVIDIA означает отнюдь не Scanline Interleaving, как это было с реализацией мультичиповой технологии от 3dfx, а Scalable Link Interface, что говорит о кардинальных отличиях между этими двумя технологиями. Тем не менее, корни архитектуры VSA (Voodoo Scalable Architecture) просматриваются вполне отчетливо – к примеру, одна из карт, работающих в связке NVIDIA SLI, является ведущей, а вторая – ведомой, при этом, первая отвечает за сборку финального кадра и вывод его на экран монитора. Имеется, однако, и ряд существенных отличий: мультичиповая технология, разработанная NVIDIA, использует свои методы распределения нагрузки между видеоадаптерами, и эти методы сильно отличаются от метода 3dfx (чередование строк).

NVIDIA SLI предлагает 2 режима работы для увеличения производительности: Split Frame Rendering (SFR) и Alternate Frame Rendering (AFR). Для работы со старыми играми также предлагается т.н. режим совместимости, когда задействуется лишь одна графическая карта.

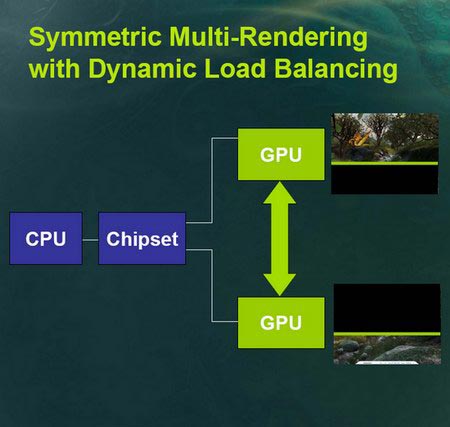

Split Frame Rendering (SFR) - Подтехнология NVIDIA SLI, которая подразумевает разделение кадра на две части, за рендеринг каждой из которых отвечает отдельный видеоадаптер. Изюминка здесь в том, что кадр может делиться по-разному – либо на две равные части, либо размер этих частей может варьироваться динамически в зависимости от сложности сцены. Второй режим представляет наибольший интерес, поскольку позволяет добиться лучшего КПД и обеспечить максимальный выигрыш в производительности, так как нагрузка на каждую карту в этом случае распределяется равномерно. NVIDIA называет этот режим Symmetric Multi-Rendering with Dynamic Load Balancing (SMR), то есть симметричный мультирендеринг с динамическим распределением нагрузки. Пока речь идет об объединении двух чипов NVIDIA, но в перспективе может планироваться поддержка четырех и более GPU.

Alternate Frame Rendering (AFR) – поочередный рендеринг кадров, подобный ATI MAXX.

Наибольший интерес все же представляет режим SMR. Если верить заявлениям компании, применение специальных высокоинтеллектуальных алгоритмов динамического распределения нагрузки позволяет получить в режиме SLI прирост производительности, достигающий 80-90%! Это очень смелое заявление, если учесть, что эффективность технологии Video Array, разработанной AlienWare, составляет от 40% до 70%. Есть, однако, у этой сияющей медали и обратная сторона – для того, чтобы достичь такого прироста производительности в режиме SLI, требуется очень тщательная оптимизация драйверов и приложений. Нечто похожее наблюдается и в мире систем с несколькими CPU, где выигрыш производительности зависит от того, насколько эффективно то или иное приложение умеет распределять потоки между разными центральными процессорами. Несколько отвлекаясь от темы, заметим, что количество такого ПО в недалеком будущем будет сильно зависеть от популярности мультиядерных CPU.

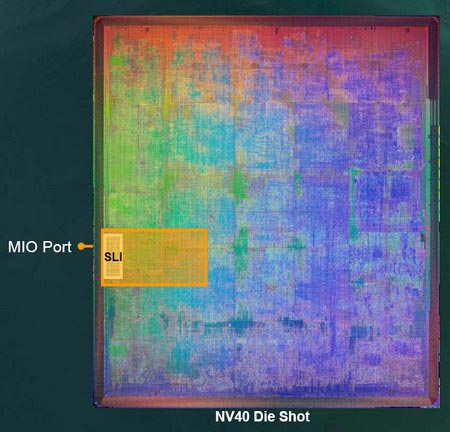

Вернемся, однако, к NVIDIA SLI. Насколько слова о почти двукратном увеличении производительности соответствуют действительности, мы расскажем чуть позже, а пока рассмотрим техническую сторону реализации мультичиповой технологии NVIDIA. В настоящее время, работу в режиме SLI поддерживают графические процессоры NV45 (GeForce 6800 Ultra/GT) и NV43 (GeForce 6600 GT). Кристалл каждого из этих процессоров содержит специальный блок MIO, отвечающий за связь и синхронизацию GPU.

Фактически, учитывая фантастическую пропускную способность интерфейса PCI Express, можно было ограничиться передачей нужных данных по этой шине, однако, NVIDIA решила выжать из технологии SLI все возможное и минимизировать возможные задержки и потери производительности, снабдив свои новые GPU соответствующим интерфейсом. С технической точки зрения, разъем MIO, расположенный на видеоадаптере, выглядит как небольшая контактная гребенка, шириной чуть меньше ширины гребенки PCI Express x1. Этот же разъем, скорее всего, отвечает и за поддержку функции Frame Lock, не позволяя проявляться такому явлению, как tearing, то есть, разрыв кадра в результате десинхронизации работы нескольких GPU. К слову, недорогой массовый видеоадаптер GeForce 6600 хотя и использует чип NV43, но поддержки SLI официально лишен – нужный разъем просто не разводится на PCB.

Когда карты установлены в системную плату, оснащенную двумя слотами конструктива PCI Express x16, их требуется соединить специальным переходником – небольшой текстолитовой платой, оснащенной двумя разъемами соответствующего типа.

Когда платы установлены в систему и соединены переходником, вся конструкция выглядит следующим образом:

Для корректной работы SLI и даже просто для того, чтобы этот режим включился, необходимо выполнить некоторые условия, о которых мы сейчас Вам и расскажем.

NVIDIA SLI: что нужно знать для задействования режима Multi-GPU?

Для того, чтобы режим SLI заработал, помимо наличия на системной плате двух слотов конструктива PCI Express x16, должны выполняться и некоторые другие условия – во-первых, должна поддерживаться конфигурация "16 линий + 8 линий", либо конфигурация "8 линий + 8 линий", а во-вторых, чипсет должен поддерживаться драйверами ForceWare. На данный момент этому критерию соответствуют только два набора системной логики – Intel i7525 "Tumwater" и NVIDIA nForce 4 SLI, причем последний является основной базой для постройки SLI-совместимых систем, так как Tumwater предназначен для создания мощных рабочих станций на базе Intel Xeon.

Вряд ли двухпроцессорная плата стоимостью $350-$500 заинтересует рядового покупателя, поэтому мы будем рассматривать технологию SLI только применительно к системам на базе наборов логики, разработанных NVIDIA. Теоретически, ничто не мешает функционированию связки из двух карт NVIDIA в режиме SLI и при конфигурации слотов PCI Express "16 линий + 4 линии", однако, в этом случае может наблюдаться небольшое падение производительности из-за пониженной пропускной способности второго слота.

Это не остановило некоторых производителей системных плат, которые выпустили соответствующие продукты на базе nForce 4 Ultra и даже i915P! К примеру, на плате Gigabyte GA-8I915P-SLI второй слот PCI Express, пригодный для установки видеоадаптера, организован путем сведения в него линий, ранее использовавшихся для отдельных слотов PCI Express x1, а плата DFI LANPARTY UT Ultra-D использует чипсет nForce 4 Ultra, официально не поддерживающий SLI-конфигурации. Таким образом, теоретически, круг чипсетов, способных работать с двумя видеоадаптерами NVIDIA, не ограничивается nForce 4 SLI и i7525. В принципе, возможна даже конфигурация PCI Express x16 + PCI Express x2, однако, падение производительности при этом будет уже вполне заметным, и о сбалансированности связки SLI придется забыть.

Появление плат, подобных вышеупомянутым, пришлось не по вкусу NVIDIA, и в настоящее время она вводит в новые версии ForceWare блокировку, не позволяющую использовать режим SLI, если конфигурация платы не соответствует нужным критериям. Понять причину гнева компании можно – системы такого типа обладают пониженным уровнем производительности, что может отрицательно сказаться на репутации новой технологии, а значит, и на ее популярности.

Помимо наличия соответствующей системной платы обязательным является использование двух одинаковых карт, то есть, двух GeForce 6800 Ultra/GT или двух GeForce 6600 GT; связка из GeForce 6800 Ultra/GT и GeForce 6600 GT работать в режиме SLI попросту не будет. Тем, кто планирует сборку системы с поддержкой SLI, NVIDIA рекомендует приобретать карты от одного производителя, во избежание возможных проблем с совместимостью.

Не стоит забывать и о том, что установка двух карт неизбежно приведет к увеличению энергопотребления, так что Вам может понадобиться новый, более мощный блок питания, обеспечивающий качественную стабилизацию выходных напряжений. К примеру, наша тестовая система отлично работала с блоком Cooler Master Real Power RS-450-ACLY даже при установке в нее двух GeForce 6800 Ultra. Также Ваш корпус должен быть достаточно просторным и обладать хорошей системой вентиляции, особенно, если Вы решитесь на покупку двух карт высшего класса.

В следующей главе нашего обзора мы расскажем Вам о процессе сборки и запуска SLI-совместимой системы на примере платы ASUS A8N-SLI Deluxe и двух комплектов видеоадаптеров GeForce 6800 Ultra и ASUS Extreme N6600 GT Series (GeForce 6600 GT), а заодно и познакомим Вас с этими продуктами.

Близкое знакомство c SLI: ASUS A8N-SLI Deluxe

Известный производитель аппаратного обеспечения, компания ASUSTeK Computer, предоставила нам на тестирование комплект, состоящий из двух видеоадаптеров ASUS Extreme N6600 GT Series и системной платы ASUS A8N-SLI Deluxe на базе чипсета NVIDIA nForce 4 SLI. О видеокартах мы расскажем ниже, а пока уделим более пристальное внимание системной плате – будущему сердцу нашей платформы SLI.

Скромная роскошь

Плата A8N-SLI Deluxe прибыла в лабораторию в розничном варианте, заключенная в простую черную коробку, на которой красовался лишь фирменный логотип производителя, символ технологии ASUS Proactive и название продукта. Никаких ярких картинок и прозрачных окон, никаких рекламных заявлений – все очень строго и стильно, как и полагается изделию высшего класса. Лишь на левом торце коробки обнаружился список, посвященный техническим характеристикам платы, кои выглядят весьма внушительно:

Содержащееся в названии продукта слово Deluxe звучало весьма многообещающе – как известно, платы ASUS серии Deluxe обычно имеют богатейшую комплектацию. Вскрыв коробку, мы получили возможность убедиться в этом сами. Вот что в ней находилось:

Системная плата ASUS A8N-SLI Deluxe

Руководство пользователя

Планка расширения Serial ATA (2 порта)

Планка расширения USB 2.0 (2 порта)

Планка расширения USB 2.0/Game (2 порта + 1 игровой порт)

Планка расширения FireWire (1 порт)

Планка расширения COM (1 порт)

Кабели Serial ATA (8 штук)

Переходники питания Serial ATA (4 штуки)

80-жильный шлейф ATA-133

40-жильный шлейф ATA-33

Шлейф для подключения дисковода

Заглушка ATX

Соединитель SLI

Компакт-диск с фирменным ПО ASUS

Компакт-диск InterVideo WinDVD Suite

Наклейка на корпус ПК

Наклейка на внутреннюю стенку с описанием джамперов

Наклейка ASUS Instant Music

За комплектацию изделию вполне можно поставить пять баллов – в комплекте присутствует все необходимое. Правда, продукт класса Deluxe мог бы, на наш взгляд, комплектоваться более качественными аэродинамическими ATA и Floppy-шлейфами, но по какой-то причине ASUS этого не сделала. Отсутствовал в комплекте и беспроводной сетевой адаптер, являющийся прерогативой плат ASUS Wireless Edition.

Взяв плату в руки

Далее, мы извлекли из антистатического пакета саму плату, чтобы познакомиться с ней поближе:

Сама плата выглядит отлично, вполне соответствуя заявленному статусу – при ее создании ASUS применила PCB, покрытую лаком темно-коричневого цвета, и это значительно улучшило внешний вид изделия. На плате установлено 7 слотов расширения – 2 x PCI Express x16, 2 x PCI Express x1 и три обычных PCI. Разъемы DIMM сгруппированы по 2, причем, первый разъем каждого канала окрашен в синий цвет, что облегчает установку памяти. Плата, отвечающая за переключение режимов PCI Express, носящая название EZ Selector, была уже установлена на плате в положение Dual Card, то есть, по умолчанию задействовался режим PCI Express 8x + PCI Express 8x. Если EZ Selector перевернуть и вставить в разъем другим концом, то верхний слот переключится в режим PCI Express x16, а нижний – в режим PCI Express x1, так как nForce 4 SLI поддерживает 20 линий PCI Express.

Помимо четырех стандартных для nForce 4 SLI портов Serial ATA-II и двух каналов ATA-133, на плате имеется дополнительный контроллер Silicon Image Sil3114C, обеспечивающий пользователя четырьмя дополнительными портами Serial ATA-150. Таким образом, к плате можно подключить до 8 устройств с интерфейсом Serial ATA, хотя вряд ли у кого-нибудь наберется хотя бы половина от этого числа, учитывая, что оптические приводы с этим интерфейсом до сих пор встречаются нечасто. Технология NVRAID поддерживается платой в полном объеме. Возможно создание массивов RAID0, 1, 0+1, 5, 10, а также JBOD.

Сетевая часть платы представлена двумя чипами Marvell, первый из которых, Marvell Yukon 88E801, представляет собой обычный однокристальный контроллер Gigabit Ethernet, функционирующий на шине PCI, а второй, Marvell Alaska 88E1111, является интерфейсом физического уровня (PHY) и работает совместно с контроллером NVIDIA Gigabit Ethernet, встроенным в чипсет. Кстати, технология ActiveArmor, представляющая собой аппаратный брандмауэр (файрволл) поддерживается этой версией nForce 4 в полной мере. Что касается встроенного звука, то он представлен кодеком AC'97 последнего поколения от Realtek – ALC850. Конечно, это не SoundBlaster Live 24-bit, установленный, например, на плате MSI K8N Diamond, и даже не Intel High Definition Audio, но все же большинству пользователей возможностей и качества звучания этого кодека будет вполне достаточно, тем более, что он может выводить звук и в цифровом виде, для чего на задней панели платы имеются разъемы S/PDIF Coaxial и Optical.

Первый слот PCI Express x16 окрашен в синий цвет, а второй, в который будет устанавливаться ведомый видеоадаптер – в черный. Эти слоты снабжены специальными защелками-фиксаторами. Между ними расположено два слота PCI Express x1, одним из которых Вам воспользоваться не удастся, если в системе установлена GeForce 6800 Ultra или любая карта, снабженная двухслотовой системой охлаждения. Над первым слотом установлен разъем типа Molex, маркированный как EZ_Plug. Он служит для подачи дополнительного питания на шину PCI Express в случае установки двух видеоадаптеров. Напомним, предельная нагрузочная способность этой шины равна 75 Ваттам, так что при установке двух карт подвод дополнительного питания явно не будет лишним. ASUS называет EZ Plug средством улучшения стабильности системы, и мы, пожалуй, с ним согласимся. Рядом с этим разъемом расположен красный светодиод, зажигающийся в том случае, если Вы забыли подключить дополнительное питание. Второй светодиод, зеленого цвета, расположен под слотами PCI; он сигнализирует о подаче на плату питающего напряжения.

Система питания процессора радует своей продуманностью – хотя замысловатых систем охлаждения Вы здесь не найдете, наиболее горячие элементы, то есть, силовые транзисторы, снабжены радиатором. Жаль, что многие производители забывают об их охлаждении вообще, а ведь именно эти детали напрямую отвечают за здоровье Вашего центрального процессора. Сам стабилизатор напряжения собран по трехканальной схеме.

Всего плата снабжена пятью трехконтактными разъемами для подключения вентиляторов, но к одному из них постоянно подключен вентилятор, охлаждающий чипсет, а еще один предназначен для подключения процессорного кулера, так что на долю пользователя остается три разъема, из которых два не поддерживают мониторинг оборотов. Технология Q-Fan позволяет управлять скоростью вентилятора, охлаждающего процессор, путем установки порогов температур, при которых он останавливается, стартует и раскручивается до максимальных оборотов.

Задняя панель платы достаточно стандартна и содержит все необходимые порты, за исключением COM, который вынесен на отдельную планку, а его место занимает разъем FireWire. В принципе, это верное решение, так как применение COM-порту в наше время найти трудно, зато периферия, использующая FireWire, встречается куда чаще. Всего плата поддерживает 2 порта FireWire, второй из которых также вынесен на отдельную планку. Число разъемов USB 2.0 на задней панели равно четырем, и еще четыре можно подключить при помощи дополнительных планок. Чипсет nForce 4 поддерживает 10 портов USB 2.0, поэтому к оставшемуся на PCB разъему USB можно подключить, например, устройство для работы с картами памяти или же просто вывести порты на переднюю панель корпуса.

С обратной стороны ASUS A8N-SLU Deluxe не представляет собой ничего интересного - там расположена только металлическая пластина, являющаяся частью крепления процессорного кулера.

Ничто не совершенно в этом мире

Хотя компоновка платы в целом не вызывает особых нареканий, все же у нее есть некоторые недостатки. В частности, расположение слотов PCI Express x1 не вполне удобно - при установке двух GeForce 6800 Ultra Вы неизбежно теряете доступ к одному из них, а также к первому слоту PCI. В Вашем распоряжении останется лишь 2 слота PCI, причем, во второй сверху мы рекомендуем не устанавливать ничего, так как это наверняка перекроет доступ воздуха к системе охлаждения нижнего видеоадаптера. 1 свободный слот PCI – много это или мало? Пожалуй, учитывая высокую степень интегрированности платы, не так уж и мало, но если Вы захотите использовать одновременно SLI, ТВ-тюнер и высококачественную звуковую карту, вряд ли это у Вас получится. Кроме того, любая длинная карта автоматически перекрывает нижние защелки всех слотов памяти. Гораздо лучше обстоит дело в случае двух GeForce 6600 GT – в этом случае Вам будут доступны не только оба слота PCI Express x1, но и два слота PCI.

Расположение самого чипсета также нельзя назвать удачным - он находится в районе между слотами PCI Express x16, и при установке двух GeForce 6800 Ultra/GT, оснащенных нестандартными системами охлаждения, не исключена возможность того, что нижняя карта упрется в кулер, отвечающий за охлаждение чипсета. Его радиатор также мешает пользоваться защелками слотов PCI Express x16, особенно, если в слот установлен GeForce 6800 Ultra или любой другой достаточно длинный видеоадаптер. Кстати, сам кулер также не вызвал у нас особого восторга – маленький радиатор с малым количеством ребер и крохотным вентилятором вызвали сомнение в их эффективности, которое, впоследствии, подтвердилось: в процессе работы радиатор нагревался очень сильно.

Вопрос с удобством подключения кабелей, идущих от БП, нами не рассматривался по одной простой причине: мы используем тестовые платформы вне корпуса ПК, что упрощает часто производимую в процессе тестирования смену видеоадаптеров. Думается, никаких проблем с кабелями БП возникнуть не должно, так как разъемы питания у ASUS A8N-SLI Deluxe расположены также, как и у MSI K8N Diamond, у которой с этим все в порядке.

Еще одна проблема с платой заключалась в том, что она отказывалась работать с картами ATI Technologies, но в версии BIOS 1002 Final это было исправлено, так что данная проблема более неактуальна. К сожалению, данная версия BIOS была получена уже после окончания работ над статьей, а потому результаты тестов карт с чипами ATI RADEON были получены на другой платформе.

В целом, новый продукт ASUS получился очень и очень удачным, если не считать недостатков, связанных с компоновкой элементов, но вообще-то это проблема многих, если не всех высокоинтегрированных плат на базе nForce 4 SLI, так как разместить на ограниченном пространстве PCB столь большое количество разнообразных компонентов действительно очень сложно. И основной проблемой таких плат является даже не столько неудобное взаимное расположение слотов, чипсета, разъемов памяти и т.д., а катастрофическая нехватка слотов расширения, в случае, если в системе установлено два видеоадаптера. Впрочем, на ASUS A8N-SLI Deluxe установлены практически все необходимые контроллеры, а компоновка такова, что даже в самом худшем случае, с двумя установленными GeForce 6800 Ultra, в Вашем распоряжении останется один свободный слот PCI Express x1 и один слот PCI.

ASUS A8N-SLI Deluxe: достоинства и недостатки

Достоинства:

Богатая комплектация

Богатая функциональность

Красивый внешний вид

Неплохие возможности расширения

Высокое качество изготовления

Наличие двух сетевых контроллеров

Охлаждаемая схема питания CPU

Поддержка функций разгона

Поддержка фирменных технологий ASUS

Недостатки:

Не вполне удачная компоновка

Возможна нехватка слотов расширения

Малоэффективная система охлаждения чипсета

Продолжаем знакомство: ASUS Extreme N6600 GT

Продолжим наше знакомство с компонентами будущей системы, способной работать в режиме NVIDIA Multi-GPU. В дополнение к системной плате A8N-SLI Deluxe, мы получили также пару видеоадаптеров ASUS Extreme N6600 GT, о которых вкратце сейчас и расскажем. В отличие от платы, видеоадаптеры прибыли в лабораторию в OEM-комплектации – запакованные в антистатические пакеты. Карты предназначались для обзора технологии SLI в целом, и поэтому комплектация в данном случае оказалась не очень важна. Вот как выглядит один из видеоадаптеров ASUS Extreme N6600 GT:

Новинка отличается от классического GeForce 6600 GT лишь цветом PCB – в данном случае он густо-синий; все остальные различия касаются лишь конструкции системы охлаждения. Кулер, примененный ASUS, имеет те же габариты, что и референсный, но на этом сходство между ними заканчивается. Радиатор в данном случае представляет собой медную пластину, в правой части которой находится оребреная область. Вентилятор, выполненный из прозрачного пластика, имеет большее количество лопастей – 9 против 7 у референсного, но сами лопасти тоньше. Против наших ожиданий, никакой подсветки лопастей здесь нет.

Вся конструкция прикрыта прозрачным аэродинамическим кожухом, так что поток воздуха, создаваемый вентилятором, прогоняется сквозь оребреную область радиатора и выбрасывается наружу, дополнительно охлаждая чипы памяти. В принципе, можно сказать, что перед нами уменьшенный и значительно упрощенный вариант системы охлаждения GeForce 6800 Ultra, только вентилятор здесь не канальный, а осевой. Шумит вся эта конструкция несильно – на фоне других компонентов ПК шум быстро теряется, даже вне корпуса.

В отличие от большинства других производителей, ASUS оснастила свой вариант GeForce 6600 GT радиаторами, отводящими тепло от микросхем памяти, так что мы не оговорились, упомянув про ее охлаждение. Всего этих радиаторов два, выполнены они также из меди, и каждый из них охлаждает свою пару чипов. Никаких хитроумных креплений здесь нет – радиаторы просто приклеены к корпусам микросхем посредством термоклея. Тот из них, что расположен ближе к задней стороне PCB, дополнительно обдувается потоком воздуха, исходящим из кулера. Наличие этих радиаторов вполне оправдано, ведь ASUS Extreme N6600 GT позиционируется компанией как изделие, способное заинтересовать компьютерных энтузиастов, занимающихся разгоном комплектующих.

Специально для них чипы GDDR3 имеют время доступа 1.6 наносекунды, а не 2.0, как на большинстве других GeForce 6600 GT. К сожалению, проверить наличие столь быстрой памяти мы не смогли по причине намертво приклеенных радиаторов, но косвенно ее наличие подтвердила попытка разгона, при которой память устойчиво заработала на частоте 600 (1200) МГц. Частоту GPU нам удалось поднять также до 600 МГц, так что слово Extreme присутствует в названии продукта неспроста – это звание вполне им заслужено.

Не разочаровало и качество 2D – карта выдала кристально четкую картинку во всех разрешениях, включая 1800х1440х75 Гц.

Нам видеоадаптеры ASUS Extreme N6600 GT достались в ОЕМ-варианте, но в розничную сеть эти карты будут поставляться в полной комплектации, и вряд ли она будет более бедной, чем у других продуктов компании. Графической карте ASUS Extreme N6600 GT смело можно поставить высший балл, так как нам не удалось найти у этого продукта сколько-нибудь заметных недостатков.

GeForce 6800 Ultra PCI Express: шум взлетающего авиалайнера?

NVIDIA Corporation любезно предоставила в наше распоряжение пару высокопроизводительных видеоадаптеров GeForce 6800 Ultra, о которых также следует сказать пару слов.

Внешне GeForce 6800 Ultra PCI Express отличается от GeForce 6800 GT только дизайном системы охлаждения – она, в отличие от последнего, двухэтажная и аналогична той, которая установлена на референсном экземпляре GeForce 6800 Ultra с интерфейсом AGP. Мы уже описывали эту систему в обзоре, посвященном анонсу NV40, поэтому повторяться нет смысла. Есть, правда, один небольшой, но довольно важный нюанс – радиатор, отбирающий тепло от кристалла GPU, в первоначальной версии кулера от NVIDIA был алюминиевым, но компания решила сменить материал на медь, чтобы улучшить эффективность охлаждения. По всей видимости, теперь в GeForce 6800 Ultra будет применяться медный радиатор.

Помимо модернизации системы охлаждения GPU была изменена и форма радиатора, охлаждающего элементы схемы питания карты – он стал больше, а количество ребер значительно увеличилось. Вероятно, радиатор старого типа оказался недостаточно эффективным.

Включив систему с двумя установленными GeForce 6800 Ultra, нам тут же захотелось очутиться от нее подальше – настолько высоким оказался уровень шума, издаваемый этими монстрами! Но самое неприятное ждало впереди – после загрузки ОС карты отказались снижать обороты вентиляторов, как это обычно делают GeForce 6800 Ultra/GT! Конечно, нам ничего не оставалось, как провести весь цикл тестов в таком режиме, но если подобная ситуация повторится у конечного пользователя, вряд ли это придется ему по вкусу. Как показала проверка при помощи RivaTuner, карты работали на частоте 437/1130 МГц, что значительно выше стандартных для GeForce 6800 Ultra значений.

Как оказалось, проблема с шумом и частотами проявляла себя только на платформе nForce 4 SLI, так как при поочередной установке этих карт в систему на базе i925X, они, как ни в чем не бывало, снижали обороты вентилятора при загрузке ОС, а также работали на номинальных частотах 400/1100 МГц. На момент тестирования плата ASUS A8N-SLI Deluxe использовала BIOS версии 1003-001 Beta от 11.30.2004, но после обновления до версии 1002 Final и установки последней версии драйверов ForceWare проблема не исчезла.

Мы не можем с уверенностью сказать, где лежат корни вышеописанной проблемы, но, надеемся, что конечным пользователям не придется с ней столкнуться. Вряд ли любитель компьютерных игр захочет играть, сидя перед компьютером в защитных наушниках.

NVIDIA SLI: собираем и запускаем систему

В этой части обзора мы расскажем нашим читателям о процессе сборки SLI-совместимой системы, а также опишем все шаги, необходимые для того, чтобы она корректно заработала. Итак, в нашем распоряжении есть все нужное:

Системная плата;

2 видеоадаптера NVIDIA, способных работать в режиме SLI;

Достаточно мощный блок питания.

Последний пункт нуждается в пояснении: согласно требованиям NVIDIA, мощность блока питания должна составлять не менее 350 Ватт, а для связки из двух GeForce 6800 Ultra рекомендуется блок питания с мощностью от 500 Ватт и выше. Мы использовали БП от Cooler Master мощностью в 450 Ватт – как показала практика, система отлично работала с ним. Итак, приступим к сборке.

Будем считать, что процессор и память уже установлены на плату, а сама плата установлена в корпус ПК или испытательный стенд, и займемся включением нужного режима PCI Express. В нашем случае планка селектора режимов уже была установлена в положение Dual Card, но если у Вас она стоит в другом положении, то ее необходимо перевернуть и вставить в слот другим концом, чтобы задействовать режим PCI Express x8 + x8.

В случае с A8N-SLI Deluxe, для того, чтобы перевернуть селекторную планку, нужно нажать на два фиксатора по бокам слота и потянуть свободный край планки на себя, после чего перевернуть, вставить в слот и нажать, чтобы фиксаторы защелкнулись. Плата готова к установке видеоадаптеров. Другие производители могут применять несколько иной механизм, или вообще использовать вместо селектора группу джамперов.

Далее, необходимо установить в слоты PCI Express x16 два одинаковых видеоадаптера, способных работать в режиме SLI. После их установки соедините контактные гребенки SLI при помощи специального переходника и подключите один из разъемов БП к гнезду EZ Plug. На других платах последнего шага может и не потребоваться, но мы рассматриваем процедуру установки применительно к ASUS A8N-SLI Deluxe. Прикрутите карты к корпусу ПК, предварительно установив специальную планку поддержки, которая не даст переходнику SLI выпасть. Этого может и не потребоваться, если планка отсутствует в комплекте. Подключите питание к самим видеоадаптерам, если это необходимо. Следует иметь в виду, что для двух GeForce 6800 Ultra потребуется четыре свободных разъема Molex, поэтому убедитесь в их наличии. Осталось лишь подключить кабель монитора к видеоадаптеру, установленному в верхний слот PCI Express x16, и сборка системы закончена.

После включения собранного ПК следует зайти в настройки BIOS, чтобы проверить опцию SLI Mode. В случае с A8N-SLI Deluxe она по умолчанию находится в положении Auto, то есть, плата сама определяет нужный режим, в зависимости от положения селектора режимов. Если Вы, по какой-то причине, решили отключить автоматическое определение, то убедитесь, что выбранная Вами опция соответствует режиму, заданному при помощи платы селектора.

Как только загрузится операционная система Windows XP, следует установить все необходимые драйверы, включая nForce Unified Driver и ForceWare. Лучше всего воспользоваться последними официальными версиями, скачав их с сайта NVIDIA.

Если все сделано правильно, то после перезагрузки системы иконка NVIDIA Settings, находящаяся справа на панели задач Windows, даст Вам знать о том, что система готова к включению режима SLI, показав всплывающий баллон с сообщением "SLI capable system":

Если в этот момент нажать на само сообщение, то Вы попадете в окно SLI multi-GPU:

Для включения режима multi-GPU достаточно поставить галочку в окошке Enable SLU multi-GPU, после чего перезагрузиться. Окошко Show GPU load balancing служит для включения индикатора, показывающего распределение нагрузки между видеоадаптерами. По умолчанию индикатор задействован, и если Вам не нужна зеленая полоса на экране, эту опцию следует отключить. В окно SLI multi-GPU можно попасть и другим способом, воспользовавшись кнопкой Advanced закладки Settings окна Display Properties:

После включения multi-GPU драйвер попросит Вас перезагрузить систему. Перезагрузите ее и зайдите в настройки драйверов снова, активировав на этот раз раздел Performance & Quality Settings и включив галочку Show Advanced Settings:

Сейчас мы объясним смысл переключателя SLI rendering mode. Он отвечает за поведение связки видеоадаптеров в случае, если запускается игра, отсутствующая в базе данных ForceWare. По умолчанию переключатель установлен в положение Single-GPU rendering, и, в случае запуска неизвестной драйверам игры, будет использоваться только один видеоадаптер. Если же установить режим Multi-GPU rendering, то система попытается использовать мультипроцессорный режим даже на неизвестных приложениях. В этом режиме Вы можете получить прирост производительности, а можете столкнуться и с нестабильностью системы и/или артефактами изображения. Какой режим использовать, решать Вам. После того как режим будет выбран, нажмите Apply, и Ваша система готова к работе.

Далее, мы расскажем Вам о конфигурации нашей тестовой платформы, настройках драйверов, а также приведем список игр, использованных в процессе тестирования.

Конфигурация тестовых платформ и методы тестирования

В процессе тестирования мы использовали три тестовые платформы со следующей конфигурацией:

Платформа nForce 4 SLI:

Процессор AMD Athlon 64 4000+ (2.40ГГц, 1МБ L2);

Системная плата ASUS A8N-SLI Deluxe;

Память OCZ PC-3200 Platinum EB DDR SDRAM (2x512МБ, CL2.5-3-2-8);

Жесткий диск Samsung SpinPoint SP1213C (Serial ATA-150, буфер 8МБ);

Звуковая карта Creative SoundBlaster Audigy 2.

Платформа PCI Express:

Процессор Intel Pentium 4 560 (Socket 775, 3.60ГГц, 1MB L2);

Системная плата Intel Desktop Board D925XCV;

Память DDR2 PC2-4300 (533МГц) SDRAM (Micron Technology, 2x512МБ);

Жесткий диск Samsung SpinPoint SP1213C (Serial ATA-150, буфер 8МБ);

Звуковая карта Creative SoundBlaster Audigy 2.

Платформа AGP:

Процессор AMD Athlon 64 4000+ (2.40ГГц, 1МБ L2);

Системная плата ABIT KV8 Pro;

Память OCZ PC-3200 Platinum EB DDR SDRAM (2x512МБ, CL2.5-3-2-8);

Жесткий диск Samsung SpinPoint SP1213C (Serial ATA-150, буфер 8МБ);

Звуковая карта Creative SoundBlaster Audigy 2.

Программное обеспечение:

Microsoft Windows XP Pro SP2, DirectX 9.0c;

ATI CATALYST 4.12;

NVIDIA ForceWare 66.93.

Нам пришлось использовать платформу Intel Pentium 4 для тестирования ряда графических карт на базе чипов ATI RADEON, оснащенных разъемом PCI Express, поскольку со старой версией BIOS плата ASUS A8N-SLI Deluxe отказывалась запускаться с ними.

Поскольку и платформа на базе NVIDIA nForce 4 SLI, и наш тестовый стенд на основе VIA K8T800 Pro использовали одинаковый процессор - AMD Athlon 64 4000+ - было решено сравнивать результаты конфигураций из двух графических карт PCI Express с результатами одиночных AGP 8x карт для оптимизации временных затрат. Мы считаем, что подобное сравнение вполне корректно на сегодняшний день.

Во избежание путаницы на графиках разные платформы отмечены соответствующими значками:

* - NVIDIA nForce4 SLI platform;

† - Intel 925X platform.

Помимо GeForce 6800 Ultra и GeForce 6600 GT, работающих в режиме SLI, в тестировании приняли участие следующие видеоадаптеры:

Видеоадаптеры AGP:

NVIDIA GeForce 6800 Ultra 256MB (400MHz/1100MHz);

NVIDIA GeForce 6600 GT AGP 128MB (500/900MHz);

ATI RADEON X800 XT Platinum Edition 256MB (520/1120MHz);

Видеоадаптеры PCI Express:

NVIDIA GeForce 6800 GT 128MB (350/1000MHz);

NVIDIA GeForce 6600 GT 128MB (500/1000MHz);

ATI RADEON X850 XT Platinum Edition 256MB (540/1180MHz);

ATI RADEON X700 XT 256MB (475/1000MHz);

Оптимизации ForceWare были включены, за исключением опции Anisotropic mip filter optimization. При этом использовался режим Quality. В случае с ATI CATALYST, опция CATALYST A.I. была установлена в положение Standard, а опция Mipmap Detail Level – в положение Quality. Опция VSync была принудительно отключена в обоих случаях. Если игра позволяла выставлять степени FSAA и анизотропной фильтрации, то мы использовали эти возможности, в противном случае, нужный режим форсировался из драйверов. Настройки качества графики в каждой игре были установлены на максимально возможный уровень, одинаковый для решений от ATI и NVIDIA.

Для платформы SLI использовался режим Multi-GPU Rendering, при котором SLI задействуется принудительно даже для тех игр, для которых этот режим не поддерживается драйверами ForceWare. Это позволило нам выяснить, насколько эффективно работает технология NVIDIA в таких случаях и работает ли вообще.

NVIDIA SLI: не все так гладко, как выглядит на бумаге

Первоначально мы планировали применить те же игры, которые использовались при написании статьи, посвященной обзору графического рынка за 2004 год. Тут-то нас и поджидал сюрприз – платформа NVIDIA SLI оказалась на редкость капризной и разборчивой. В частности, игры из нижеприведенного списка или работали нестабильно, периодически вызывая зависания системы, или не запускались вовсе:

Unreal Tournament 2004

FarCry

Shadow Ops: Red Mercury

Prince of Persia: Sands of Time

Max Payne 2: The Fall of Max Payne

Manhunt

Lock On

Colin McRae Rally 04

Справедливости ради отметим, что запустить вышеперечисленные игры на системе, оснащенной парой графических карт GeForce 6, всё же можно, но в таком случае рендерингом будет занята лишь одна из них. Это явно не то, чего принято ожидать от системы со стоимостью графической системы от $500.

Некоторые другие игры показали отсутствие прироста производительности в режиме SLI или даже ее падение по сравнению с одиночными картами, но система при этом функционировала стабильно, поэтому мы решили все-таки включить их результаты в наш обзор. Когда мы исключили неработающие или нестабильно работающие игры, список стал выглядеть следующим образом:

Трехмерные шутеры с видом от первого лица:

Call of Duty: United Offensive

Doom III

Halo: Combat Evolved

Painkiller

Half-Life 2

Трехмерные шутеры с видом от третьего лица:

Splinter Cell: Pandora Tomorrow

Hitman: Contracts

Thief: Deadly Shadows

Deus Ex: Invisible War

Симуляторы:

Il-2 Shturmovik: Aces in the Sky

Microsoft Flight Simulator 2004

FlatOut

Стратегические игры:

Command & Conquer Generals: Zero Hour

Warhammer 40.000: Dawn of War

Perimeter

Rome: Total War

Полусинтетические тесты:

Final Fantasy XI Official Benchmark 3

AquaMark3

Синтетические тесты:

Futuremark 3DMark 03 Build 3.5.0

Futuremark 3DMark 05 Build 1.1.0

Игры Counter-Strike: Source и Vampires the Masquerade: Bloodlines были исключены по причине низкой производительности на платформе PCI Express.

Вопреки всем ожиданиям, проблем с качеством изображения в режиме SLI мы наблюдали немного; фактически, артефакты изображения были замечены только в авиасимуляторе Il-2 Shturmovik:

Как видите, проблема явно связана с пиксельными шейдерами, имитирующими водную поверхность. Вероятно, это будет исправлено или в новой версии драйверов ForceWare или патче к игре от компании-разработчика, так как Il-2 – одна из тех игр, в которых преимущество от использования SLI проявляется наиболее ярко. Вне всякого сомнения, проблемы со стабильностью в ряде игр в скором времени также будут решены, но на момент нашего тестирования стабильность платформы NVIDIA SLI была далека от идеальной.

Игровые тесты: Call of Duty: United Offensive

Технология multi-GPU от NVIDIA в этой игре работать отказалась. Вернее, система работала отлично, и никаких проблем с качеством изображения мы не заметили, но прирост производительности от включения SLI оказался нулевым. Более того, на экране отсутствовал даже индикатор Load Balancing, хотя его показ был включен в драйверах.

Аналогичная картина наблюдалась и в режиме eye candy – прироста от включения SLI мы так и не получили.

Игровые тесты: Doom III

В Doom III технология NVIDIA показала себя отлично, хотя в низких разрешениях выигрыша от ее использования практически не наблюдалось, поскольку сцена, записанная на уровне Hellhole, включает в себя битву с множеством монстров. В этом случае производительность в большей степени зависит от характеристик центрального процессора, нежели от мощности видеосистемы. Первые признаки нормального функционирования SLI появились в разрешении 1280х1024, когда связка из двух GeForce 6600 GT показала производительность на уровне GeForce 6800 Ultra. С дальнейшим ростом разрешения проявила себя и система с двумя GeForce 6800 Ultra, хотя прирост производительности и не был двукратным.

При включении FSAA и анизотропной фильтрации эффективность NVIDIA Multi-GPU SLI заметно возрастает, так как в этом случае нагрузка на видеосистему выше, а влияние CPU, напротив, меньше. Связке из двух GeForce 6600 GT явно не хватает видеопамяти – дело в том, что содержимое памяти карт, работающих в режиме multi-GPU, дублируется, и общий ее объем остается прежним – то есть, равным 128 МБ, а не удваивается, как можно было бы надеяться. Мы тестировали игру в режиме высшего качества графики, поэтому относительно низкие результаты GeForce 6600 GT SLI могут быть обусловлены именно нехваткой видеопамяти. У GeForce 6800 Ultra SLI дела обстоят куда лучше, и прирост производительности от включения режима multi-GPU в высоких разрешениях достигает 75%.

Сцена, записанная на уровне d3dm4, куда проще – здесь отсутствуют монстры, хотя игрок время от времени стреляет из плазменной винтовки и ракетомета. Эффект от включения SLI виден даже в самом низком разрешении и растет по мере его увеличения, достигая 60%-65% в разрешении 1600х1200.

В режиме eye candy на результатах GeForce 6600 GT SLI вновь сказывается нехватка видеопамяти, и поэтому в разрешении 1600х1200 ее эффективность не превышает 60%, в то время как связка из двух GeForce 6800 Ultra демонстрирует 80%-85% превосходство над одиночной картой. Напоминаем, что результаты для одиночной GeForce 6800 Ultra получены на платформе VIA K8T800 Pro, поэтому сравнение может быть не вполне точным.

Игровые тесты: Halo: Combat Evolved

В Halo небольшой эффект от включения технологии multi-GPU от NVIDIA не слишком заметен в первых двух разрешениях для карт GeForce 6800 Ultra, так как в них игра упирается в производительность CPU. В то же время, для GeForce 6600 GT SLI выигрыш составляет от 20% до 40%. В разрешении 1600х1200, наконец, начинает проявляться и эффект от включения SLI для двух GeForce 6800 Ultra, хотя прирост производительности при этом далек от двукратного – все-таки данная игра достаточно процессорозависима. Стоит отметить, что лишь применение SLI позволяет добиться производительности на уровне ATI RADEON X850 XT Platinum Edition.

Игровые тесты: Painkiller

Технология увеличения производительности видеосистемы, разработанная NVIDIA, отказалась работать в Painkiller: хотя никаких проблем с качеством изображения и стабильностью системы не было, но не было и прироста производительности – связка из двух карт неизменно демонстрировала те же результаты, что и одиночный видеоадаптер того же типа.

Тот же эффект наблюдался и при одновременном включении FSAA и анизотропной фильтрации, однако, в разрешении 1600х1200 произошло чудо – связка GeForce 6600 GT SLI показала двукратное превосходство над одиночной GeForce 6600 GT, хотя в более низких разрешениях такого не наблюдалось.

Игровые тесты: Half-Life 2

Польза от включения SLI отчетливо видна и в Half-Life 2, хотя в низких разрешениях она менее заметна по причине относительно невысокой нагрузки на видеосистему. В высоких же разрешениях производительность в режиме SLI на 50%-60% выше, чем в случае с одиночными картами.

Еще эффективнее многопроцессорная технология NVIDIA работает в режиме eye candy – здесь выигрыш от ее использования может достигать 80%, однако действительно заметно обойти высокопроизводительные решения от ATI Technologies удается лишь в разрешении 1600х1200.

Вторая сцена Half-Life 2, используемая нами в тестировании, гораздо более процессорозависима, чем первая, и в ней эффект от применения SLI заметить куда сложнее, во всяком случае, в режиме чистой производительности.

В режиме с задействованными FSAA и AF, в разрешениях, начиная с 1280х1024, эффект виден намного более отчетливо, особенно, для системы, оснащенной двумя GeForce 6600 GT. Обойти RADEON X850 XT PE/RADEON X800 XT PE спарке GeForce 6800 Ultra удается лишь в разрешении 1600х1200, но NVIDIA SLI как раз лучше всего чувствует себя именно в таких тяжелых условиях.

Игровые тесты: Splinter Cell: Pandora Tomorrow

Прирост производительности отсутствует, впрочем, как и проблемы со стабильностью и качеством изображения.

Игровые тесты: Hitman: Contracts

Не работает multi-GPU режим и в Hitman: Contracts – хотя платформа SLI и показывает чуть лучшую производительность, но это, скорее всего, является следствием различий в конфигурации и архитектуре тестовых платформ NVIDIA nForce 4 SLI и VIA K8T800 Pro.

Игровые тесты: Thief: Deadly Shadows

Хотя никаких проблем с качеством изображения в этой игре мы не увидели, производительность в режиме SLI оказалась ниже, чем в случае одиночной карты. Система с двумя GeForce 6800 Ultra также показала очень низкий минимальный fps в разрешении 1600х1200, но, возможно, что такой показатель является следствием неточности при измерении, ведь все шутеры с видом от третьего лица мы тестируем в ручном режиме при помощи утилиты FRAPS.

Игровые тесты: Deus Ex: Invisible War

В отличие от трех предыдущих игр, в Deux Ex: Invisible War режим multi-GPU не только работает беспроблемно, но и, в случае использования двух GeForce 6600 GT, обеспечивает вполне заметный прирост производительности – до 40%.

Игровые тесты: Il-2 Shturmovik: Aces in the Sky

Ил-2 Штурмовик – одна из тех игр, которая вполне могла бы использоваться для демонстрации преимуществ технологии NVIDIA SLI, но, увы, именно в ней включение этого режима приводит к появлению проблем с качеством изображения. Страдает при этом, прежде всего, водная поверхность, и хотя включение мультипроцессорного режима приводит к почти двукратному росту производительности, играть с таким качеством изображения Вы вряд ли захотите. Скорее всего, эта проблема будет вскоре исправлена, но пока дело обстоит именно так.

Если не принимать во внимание проблемы с качеством картинки, то эффект от включения SLI просто потрясающ – комфортный fps обеспечивается даже в разрешении 1600х1200 при включенных FSAA и полноэкранном сглаживании! В Ил-2 ни одна одиночная карта, включая и ATI RADEON X850 XT PE, не может состязаться с реализацией мультичиповой технологии от NVIDIA.

Игровые тесты: Microsoft Flight Simulator 2004

Данный авиасимулятор также отличается процессорозависимостью, и поэтому какие-либо выводы о преимуществах SLI сделать трудно, по крайней мере, в режиме чистой производительности.

Данные, полученные в режиме eye candy, несколько более показательны – во всяком случае, если говорить о разрешениях 1280х1024 и 1600х1200. В этих случаях явно видно, что режим SLI работает корректно и привносит определенные скоростные преимущества.

Игровые тесты: FlatOut

К сожалению, данные, полученные во FlatOut в режиме чистой производительности, интереса не представляют, так как игра содержит лимитатор fps, ограничивающий производительность на уровне 100 кадров в секунду, и практически все современные видеоадаптеры, за редким исключением, легко достигают этого барьера.

Режим eye candy позволяет увидеть то, чего не видно в режиме чистой производительности, и здесь мы видим неплохой прирост от использования SLI, достигающий 50%.

Игровые тесты: Command & Conquer Generals: Zero Hour

Перед нами один из тех случаев, когда включение режима multi-GPU приводит к падению производительности.

Однако, включение FSAA и анизотропной фильтрации меняет картину, и в высоких разрешениях мы наблюдаем неплохой прирост производительности от мультипроцессорного рендеринга.

Несколько странно ведет себя GeForce 6600 GT AGP – она значительно отстает от варианта с разъемом PCI Express.

Игровые тесты: Warhammer 40.000: Dawn of War

Dawn of War – игра новая, но уже успевшая завоевать популярность среди любителей жанра RTS. Технология NVIDIA SLI в данном случае работает отлично, обеспечивая не только прирост производительности в районе 30%-50%, но и позволяя решениям NVIDIA опередить ATI RADEON X850 XT PE/X800 XT PE.

Отлично работает режим multi-GPU и в режиме eye candy, но лишь в случае использования двух GeForce 6800 Ultra. Если же вести речь о более дешевых GeForce 6600 GT, то связка из двух таких карт проигрывает одиночному GeForce 6800 Ultra, видимо, по той же причине, что и ранее – из-за недостаточного объема видеопамяти.

Игровые тесты: Perimeter

Эффективность, близкую к максимальной, демонстрирует новая технология и в одной из самых требовательных стратегических игр. Как известно, Perimeter всегда отдавала предпочтение картам ATI, но сегодня им пришлось уступить мощи двух процессоров NV45.

Эта же картина наблюдается и при включении FSAA и анизотропной фильтрации, но связка GeForce 6600 GT SLI вновь ощущает на себе последствия наличия на борту лишь 128 МБ памяти. Кроме того, две 128-битные шины все же не эквивалентны одной, но 256-битной – их суммарная эффективность обязательно будет несколько ниже по той же причине, по которой два видеоадаптера в режиме SLI быстрее одного не ровно в два раза.

Игровые тесты: Rome: Total War

Использование SLI не дает практически никакого эффекта в Rome: Total War – в режиме чистой производительности игра, как и большинство стратегий реального времени, в большей степени зависит от производительности центрального процессора, нежели видеосистемы.

Игра отличается крайней непредсказуемостью при тестировании, однако, похоже, какой-то эффект от включения SLI все же имеет место – в разрешении 1280х1024 производительность двух GeForce 6600 GT явно выше, нежели у одной.

Полусинтетические тесты: Final Fantasy XI Official Benchmark 3

В данном тесте включение SLI приводит к огромному падению производительности, хотя никаких проблем с качеством картинки не возникает.

Полусинтетические тесты: Aquamark3

Мультипроцессорная технология NVIDIA неплохо работает в данном тесте, хотя прирост производительности и далек от максимально возможного. Спарке 2 х GeForce 6800 Ultra даже удается несколько опередить высокопроизводительные карты ATI.

Традиционно карты ATI лучше всего проявляют себя в режиме eye candy. Так было и в Aquamark3, однако, использование режима SLI позволило добиться в этом режиме такой же производительности и решениям NVIDIA. Прирост производительности по отношению к одиночным картам составляет примерно 50% для GeForce 6600 GT SLI и 40%-45% для GeForce 6800 Ultra SLI.

Cинтетические тесты: Futuremark 3DMark03

Как и ожидалось, никаких проблем с тестами от Futuremark в режиме SLI не возникло, а полученные результаты вполне подтвердили эффективность этой технологии, позволив перешагнуть очередную отметку, на этот раз – в 20.000 очков. Отлично выступила и связка из двух GeForce 6600 GT, показав даже более высокую производительность, нежели одиночная GeForce 6800 Ultra.

Первый тест очень прост, поэтому в нем трудно ожидать большого эффекта от включения SLI, но, тем не менее, он есть, особенно в высоких разрешениях. Больше всего выигрывает связка из двух GeForce 6600 GT – прирост производительности в этом случае составляет до 30%-35%, а вот GeForce 6800 Ultra SLI выигрывает меньше – от 15% до 20%. Применение режима multi-GPU позволяет продуктам NVIDIA демонстрировать производительность более высокую, чем у решений ATI Technologies.

В режиме eye candy преимущества NVIDIA SLI видны гораздо четче – в разрешении 1600х1200 прирост производительности для GeForce 6800 Ultra SLI составляет около 75%, а для GeForce 6600 GT SLI – близок к 100%!

Во втором тесте реализация режима multi-GPU от NVIDIA смотрится еще более внушительно - карты, работающие в режиме SLI, превосходят одиночные решения практически в два раза, причем, во всех разрешениях.

Точно такая же картина наблюдается и в режиме eye candy, но связке из двух GeForce 6600 GT вновь не хватает видеопамяти – она несколько отстает от обычного GeForce 6800 Ultra.

В третьем игровом тесте пакета 3DMark03 преимущество от включения SLI не такое большое, но все же достаточно близко к максимально возможному.

В отличие от второго теста, в третьем при включении FSAA и анизотропной фильтрации GeForce 6600 GT SLI не отстает от GeForce 6800 Ultra – по всей видимости, нагрузка на видеопамять здесь не столь высока.

Карты ATI всегда лидировали в четвертом тесте, но на этот раз им пришлось потесниться – GeForce 6660 GT SLI продемонстрировала такую же производительность, а более мощная связка из двух GeForce 6800 Ultra стала однозначным лидером, причем эффективность многопроцессорной технологии NVIDIA также оказалась близка к теоретическому пределу.

В режиме eye candy SLI также показала себя великолепно, за исключением все той же нехватки памяти у спарки GeForce 6600 GT в высоких разрешениях, что привело к отставанию от RADEON X800 XT PE в разрешениях свыше 1024х768. GeForce 6800 Ultra SLI уверенно заняла первое место.

Cинтетические тесты: Futuremark 3DMark05

Включение режима SLI для двух GeForce 6600 GT приводит к двукратному росту производительности, и они оказываются в состоянии состязаться даже с RADEON X850 XT PE/X800 XT PE; эффективность GeForce 6800 Ultra SLI несколько меньше – порядка 85%-90%, что также является отличным результатом.

Для обоих комплексов SLI прирост производительности в первом тесте составляет около 90%-100%, что позволяет более дорогой системе с двумя GeForce 6800 Ultra лидировать, а менее дорогой на базе GeForce 6600 GT – практически не отставать от наиболее производительных карт ATI.

В режиме eye candy система с двумя GeForce 6600 GT отказалась работать в высоких разрешениях по причине нехватки видеопамяти, но даже в разрешении 1024х768 она несколько отстала от GeForce 6800 Ultra, что в очередной раз подтвердило востребованность больших объемов видеопамяти в современных приложениях. Что касается платформы GeForce 6800 Ultra SLI, то ее эффективность при работе с включенными FSAA и анизотропной фильтрацией падает по мере роста разрешения и в 1600х1200 она уже едва опережает RADEON X850 XT Platinum Edition.

Несколько более уверенно новая технология показывает себя во втором тесте, где производительность двух GeForce 6600 GT нисколько не уступает производительности RADEON X850 XT PE/X800 XT PE, а два GeForce 6800 Ultra в режиме SLI ровно в два раза быстрее одного такого видеоадаптера.

При включении FSAA и анизотропной фильтрации общая картина напоминает ту, что мы видели в первом тесте, однако, падение производительности для систем multi-GPU в высоких разрешениях здесь не столь велико, а эффективность их работы, в целом, выше.

Третий тест, в принципе, можно назвать самым сложным, так как в нем используются чрезвычайно комплексные пиксельные шейдеры. Здесь всегда побеждали видеоадаптеры от ATI Technologies, но сегодня новая реализация мультипроцессорности от NVIDIA отняла у них первое место – как видите, связка из двух GeForce 6800 Ultra примерно в полтора раза опередила RADEON X850 XT Platinum Edition. Две карты GeForce 6600 GT, работающие в режиме SLI, также показали великолепный результат – их производительность оказалась даже выше, нежели у одиночного видеоадаптера GeForce 6800 Ultra и примерно на уровне RADEON X800 XT Platinum Edition.

В режиме eye candy GeForce 6600 GT SLI уже не смогла выступить так уверенно, как в режиме чистой производительности, и слегка уступила GeForce 6800 Ultra, в то время как две GeForce 6800 Ultra еще один раз продемонстрировали двукратный прирост производительности по сравнению с одиночной картой.

В целом, результаты, показанные платформами SLI в обеих версиях 3DMark, вполне закономерны – эффективность технологии NVIDIA multi-GPU в этих тестах очень высока и порой достигает теоретического предела.

Заключение: есть ли будущее у технологий multi-GPU?

Итак, после долгого перерыва, технологии объединения нескольких графических процессоров с целью увеличения производительности видеосистемы, вновь готовы попытаться завоевать рынок настольной графики. Мы протестировали одну из таких технологий, разработанную и воплощенную в железо компанией NVIDIA Corp., и впечатления, оставшиеся после тестирования, оказались весьма противоречивыми.

NVIDIA Multi-GPU SLI: Мифы и реальность

Начнем с того, что режим SLI действительно позволяет добиться значительного прироста производительности; в отдельных случаях он даже достигал 100%, то есть, был двукратным! Инженеры-разработчики компании, судя по всему, проделали огромную работу, и им действительно удалось свести все возможные задержки и потери времени на синхронизацию работы двух видеоадаптеров к предельно возможному минимуму.

Таким образом, заявление NVIDIA о сверхвысокой эффективности технологии SLI можно было бы назвать истинным, если бы не одно "но" – такая радужная картина наблюдалась далеко не во всех играх. Во многих игровых приложениях, напротив, какой-либо прирост производительности отсутствовал или вовсе оказался отрицательным, а в некоторых случаях включение режима SLI приводило к нестабильности системы, зависаниям или невозможности запуска той или иной игры.

Еще одним недостатком SLI является ее зависимость от наличия соответствующих оптимизаций под конкретную игру в драйверах ForceWare – при их наличии прирост производительности может быть огромным, однако, если база данных не содержит нужной информации, очень высока вероятность того, что прироста скорости Вы не получите, или он окажется далек от заявленных 70-90%. Иными словами, за высочайшую эффективность многопроцессорной технологии NVIDIA приходится расплачиваться отсутствием универсальности, которая свойственна, например, системе Video Array, разработанной компанией Alienware.

Разработка NVIDIA также оказалась весьма щепетильной к устанавливаемым картам – нормально работали лишь два одинаковых видеоадаптера от одного производителя. Нам так и не удалось включить режим SLI при установке двух GeForce 6600 GT от разных производителей, несмотря на полное сходство их характеристик и наличие соответствующего разъема.

Все это не говорит о том, что технология NVIDIA SLI плоха или неудачна, а лишь свидетельствует о наличии так называемых "детских болезней", в той или иной мере присущих любой новаторской технологии. Кроме того, зрелостью на момент тестирования не могла похвастаться и сама платформа nForce 4 SLI – системная плата от ASUS использовала бета-версию BIOS, и такой же статус имели драйверы для нового чипсета NVIDIA. Все это не могло не сказаться (и, очевидно, сказалось) на стабильности работы новой платформы. Мы уверены, что в скором времени большинство недостатков, присущих NVIDIA SLI, будут искоренено, количество поддерживаемых игр возрастет, а режим Multi-GPU rendering будет функционировать более корректно.

Ценовой фактор

Есть еще один важный аспект, который нельзя не затронуть, говоря о системах, оснащенных несколькими графическими процессорами/видеоадаптерами. Именно он препятствует широкому распространению многопроцессорных графических технологий среди рядовых пользователей. Имя этому аспекту – цена. Давайте подсчитаем, в какую сумму может обойтись настоящему любителю компьютерных игр приобретение наиболее производительного варианта платформы nForce 4 SLI. Допустим, в его распоряжении уже имеется процессор, предназначенный для разъема Socket 939 и 2 модуля памяти PC3200 нужного пользователю объема, а также достаточно мощный блок питания. Остается лишь обзавестись платой, поддерживающей SLI, и двумя видеоадаптерами NVIDIA, способными работать в этом режиме.

Системная плата ASUS A8N-SLI/A8N-SLI Deluxe обойдется примерно в $200. За вариант GeForce 6800 Ultra, оснащенный разъемом PCI Express, придется выложить от $500, пара менее дорогих GeForce 6800 GT обойдется от $400 за штуку, по заявлениям NVIDIA. Итого, затраты на приобретение одних видеоадаптеров легко могут составить внушительную сумму в $800 - $1000, и это лишь в лучшем случае; в худшем любителю больших fps придется выложить еще больше, поскольку многие продавцы требуют за GeForce 6800 Ultra цены, превышающие рекомендованные. Если же сложить стоимость всех компонент системы, то общая цена приблизится к отметке в $4000 - $5000, что очень и очень много для домашней игровой системы даже высшего класса. Тем не менее, такая платформа все же найдет покупателя, хотя и редкого – компьютерные энтузиасты, не ограниченные бюджетом, вполне могут решиться на такую покупку. Если какая-либо игра не будет работать в режиме SLI, то всегда можно переключиться в режим Single-GPU rendering и получить производительность на уровне одиночного GeForce 6800 Ultra.

Совсем иначе обстоит дело с двумя GeForce 6600 GT – пара этих карт обойдется Вам в порядка $400, не считая стоимости системной платы, и, казалось бы, это вариант, вполне доступный многим любителям компьютерных игр. Если судить поверхностно, то можно подумать, что два видеоадаптера GeForce 6600 GT являются эквивалентом GeForce 6800 Ultra или RADEON X850 XT Platinum Edition как по количеству пиксельных и вершинных процессоров, так и по объему видеопамяти. Однако простая арифметика здесь работает плохо, и один плюс один далеко не всегда равняется двум. Поясняем эту мысль: помимо накладных расходов на синхронизацию двух карт и поддержки не всех существующих игр, объем видеопамяти связки из двух GeForce 6600 GT будет составлять вовсе не 256 МБ, а лишь 128, так как содержимое видеопамяти карт, работающих в режиме NVIDIA multi-GPU, дублируется. Такого объема явно недостаточно для высокопроизводительного решения, призванного работать в высоких разрешениях при включенном полноэкранном сглаживании. Это прекрасно подтвердили результаты, полученные нами в процессе тестирования – в ряде случаев при включении FSAA и анизотропной фильтрации производительность двух GeForce 6600 GT SLI падала ниже уровня GeForce 6800 Ultra и RADEON X850 XT Platinum Edition/X800 XT, а в Rome: Total War и 3DMark05 использование высоких разрешений и вовсе стало невозможным из-за нехватки видеопамяти. Вряд ли приобретение двух GeForce 6600 GT с целью их объединения в режиме SLI является целесообразным шагом – примерно за эту же сумму Вы можете приобрести GeForce 6800 GT или RADEON X850 XT, которые предложат Вам примерно такой же уровень производительности, но при этом не будут испытывать проблем с совместимостью и объемом видеопамяти.

Перспективы Multi-GPU

Окончательные выводы по технологии NVIDIA SLI делать пока еще рано, но и о провале говорить не приходится – все же, в случаях, когда не было проблем с совместимостью и стабильностью, данная технология показала очень высокую эффективность – добавление второго видеоадаптера и включение режима SLI могло поднять производительность в полтора-два раза, в то время как аналогичная технология от Alienware обеспечивала прирост всего на 40%-60% относительно одиночной карты.

Пожалуй, неудачным решением следует назвать именно GeForce 6600 GT SLI. Платформа, оснащенная двумя GeForce 6800 Ultra, все же может быть востребована в среде богатых компьютерных энтузиастов, а вот "недорогая" реализация мультипроцессорной технологии оказалась на практике не такой уж недорогой – ее цена оказалась сопоставимой с ценой одиночных карт высшего класса, но последние, при схожей производительности, продемонстрировали лучшую стабильность и совместимость с существующим игровым ПО.

Следует сказать, NVIDIA оказалась не одинокой в намерении выпустить на рынок многопроцессорное графическое решение, просто компания успела первой воплотить такое решение в "металле". Как известно, ATI Technologies планирует вскоре представить на суд публики свою реализацию multi-GPU, уже получившую название ATI Multi Rendering, или AMR. Как обещается, эта технология будет более гибкой, нежели NVIDIA SLI – она позволит использовать разные видеоадаптеры ATI, а также избавит пользователей от лишнего переходника – вся информация, нужная для синхронизации карт, будет передаваться через шину PCI Express. Аналогичное решение создается и в лабораториях S3 Graphics, так что вскоре выбор платформ multi-GPU будет более широким, нежели сейчас.

В целом, рассчитывать на то, что платформа NVIDIA SLI обретет большую популярность в кругах компьютерных игроков, не приходится. Это подтвердило и голосование, проведенное на нашем сайте – только 5% проголосовавших изъявили желание приобрести комплекс из системной платы и двух видеоадаптеров с поддержкой SLI сразу и еще 15% высказались за покупку только одного видеоадаптера, оставив приобретение второго на будущее. Тем не менее, заинтересованность пользователей в технологиях, позволяющих объединять несколько видеоадаптеров с целью увеличения производительности, довольно высока - 45% опрошенных, так или иначе, рассматривают вопрос о покупке системы, поддерживающей какую-либо реализацию multi-GPU. Именно поэтому новая инкарнация многопроцессорной потребительской графики не будет обречена на забвение.