Ваш город: Москва

Графический процессор нового поколения NVIDIA G70: шаг вперед?

Немного истории

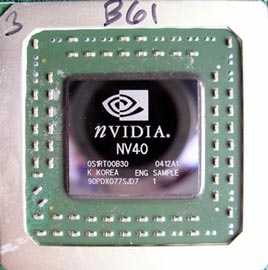

4 апреля 2004 года в мире трехмерной графики произошло крайне знаменательное событие – NVIDIA, до этого надолго уступившая корону лидерства своему главному сопернику, канадской компании ATI Technologies, анонсировала новый графический процессор NV40. Этот чип мгновенно вывел NVIDIA в технологические лидеры, так как в нем впервые в мире потребительской трехмерной графики был воплощен ряд революционных технологий, в частности, поддержка пиксельных и вершинных шейдеров следующего поколения (Shader Model 3.0), возможность работы с представлением цвета с плавающей запятой, а также ряд других нововведений.

В знак расставания с прошлым, NVIDIA отказалась от букв FX в названии видеоадаптеров на базе нового GPU, и, действительно, видеоадаптеры GeForce 6800 продемонстрировали отличные результаты во всех тестах, в одночасье лишив RADEON 9800 XT чемпионского титула. Но победа далась компании нелегко – чип получился очень сложным (222 миллиона транзисторов), в результате чего приемлемого выхода годных кристаллов удалось добиться лишь для частот 350-400 МГц. Кроме того, повышенное тепловыделение привело к необходимости использования громоздкой и шумной двухслотовой системы охлаждения, но все же, несмотря на некоторые недостатки, выпуск GeForce 6800 Ultra стал огромным шагом вперед как для NVIDIA, так и для индустрии в целом.

Вскоре после этого, 4 мая, ATI Technologies нанесла ответный удар, объявив о выходе в свет графического процессора R420 и соответствующих видеоадаптеров на его основе. В отличие от NVIDIA, подход ATI был, скорее, эволюционным, нежели революционным – RADEON X800, по сути, был значительно улучшенным RADEON 9800, нежели чем-то совершенно новым. Однако, на тот момент, такой подход оправдал себя в полной мере – R420 получился достаточно простым (160 миллионов транзисторов против 222 в NV40), и эта простота, а также применение новых диэлектрических материалов позволили ATI довести тактовую частоту своего нового решения до 520 МГц, добившись очень высокой производительности.

Фактически, основные технические характеристики NV40 и R420 были весьма схожими – каждый чип нес в себе по 16 пиксельных конвейеров и по 6 вершинных процессоров, однако, благодаря более высоким тактовым частотам, RADEON X800 XT сумел обойти GeForce 6800 Ultra в большинстве игр. Поддержка Shader Model 3.0 не помогла детищу NVIDIA, поскольку, на тот момент, в природе не существовало игр, способных воспользоваться преимуществами архитектуры NV40, и даже новый патч к FarCry, добавивший режим SM 3.0, не изменил ситуации, так как в нем же появилась и поддержка Shader Model 2.0b, реализованная в новых графических процессорах ATI.

Таким образом, NVIDIA очень недолго удерживалась на троне короля трехмерной графики; к тому же, проблемы с производством столь сложного чипа, как NV40, привели к тому, что видеоадаптеры GeForce 6800 Ultra почти сразу же попали в разряд дефицита, впрочем, ATI RADEON X800 XT/PRO также не вполне успешно завоевывали полки магазинов. В дальнейшем, ATI произвела разделение семейства RADEON X800 на две отдельные линейки – высокопроизводительную и массовую, с целью чего ею были разработаны два новых графических процессора – R480 (RADEON X850) для первой, и 0.11-мкм R430 для второй. В случае с R480, максимальная тактовая частота, на которой могли работать графические процессоры ATI достигла 540 МГц, в то время, как аналогичный показатель для решений NVIDIA, использующих чипы NV40 и NV45 остался на уровне 425 МГц для "специальных редакций" видеокарт от ряда производителей. Старшие модели видеоадаптеров NVIDIA по-прежнему уступали в производительности аналогичным по классу решениям от ATI Technologies.

Анонс мультичиповой технологии NVIDIA SLI позволил компании добиться более высокой производительности, нежели у ATI RADEON X850 XT Platinum Edition. Однако, решение, состоящее из двух видеоадаптеров GeForce 6800 Ultra/GT, получилось крайне дорогостоящим, громоздким, неэкономичным и требовало наличия специальной системной платы на базе чипсета nForce 4 SLI. Впрочем, любителям бескомпромиссной производительности по бескомпромиссной цене не было дела до обозначенных трудностей, и мульти-GPU технология NVIDIA стала достаточно популярной.

Таким образом, на середину 2005 года на стороне ATI были:

Самая быстрая графическая карта в мире – RADEON X850 XT Platinum Edition;

Самая широкая линейка высокопроизводительных графических процессоров (по пять моделей для AGP и PCI Express шин).

В то же время, NVIDIA также имела ряд преимуществ:

Самое быстрое графическое решение на планете – multi-GPU SLI.

Формальное технологическое лидерство: GeForce 6 поддерживал Shader Model 3.0, HPDR и т.п..

Явный успех GeForce 6600-серии в среднем ценовом сегменте рынка.

Иными словами, оба разработчика GPU имели в своем распоряжении по своему лучшие продукты, но ни один не мог похвастаться захватом соперника в т.н. маркетинговую вилку, предложив одновременно самый быстрый и самый богатый возможностями чип. Сегодня как NVIDIA, так и ATI, серьезно нуждаются в новом графическом процессоре, оружии, которое могло бы вернуть кому-либо корону абсолютного лидера, и такое оружие, наконец, появилось. Сегодня NVIDIA первой анонсировала графический процессор нового поколения, вынуждая ATI Technologies поторапливаться с выпуском на рынок соперника.

GeForce 7: Новая графическая архитектура?

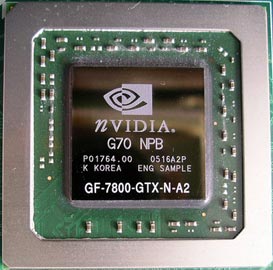

Новая графическая архитектура, что совсем неудивительно, получила название GeForce 7, а графический процессор, в котором она воплотилась, был наречен именем G70. По всей видимости, NVIDIA показывает этим, что перед нами – совершенно новая архитектура, а не просто усовершенствованная старая, GeForce 6. Так ли это на самом деле? Рассмотрим данный вопрос подробнее.

Начнем с того, что новый графический процессор NVIDIA по праву можно назвать самым сложным графическим процессором для ПК в мире – он состоит из 302 миллионов транзисторов. Для сравнения, NV40 состоит из 222 миллионов, а ATI R480 – всего лишь из 160 миллионов транзисторов. Ничего удивительного в этом нет, поскольку, новый GPU несет в себе 24 пиксельных конвейера и 8 вершинных процессоров, против 16 и 6 у решений теперь уже прошлого поколения. Однако, G70 не является просто "раскормленным" NV40 – NVIDIA в значительной степени переработала архитектуру пиксельных и вершинных процессоров, с целью увеличения их производительности. Об этом несколько ниже, а пока приводим список технических характеристик нового GPU в сравнении с моделями предыдущего поколения.

Итак, видеоадаптер на базе NVIDIA G70 получил название GeForce 7800 GTX.

С точки зрения технических характеристик, новинка выглядит более, чем внушительно, на голову опережая GeForce 6800 Ultra, и, тем более, RADEON X850 XT Platinum Edition. Лишь по одному параметру GeForce 7800 GTX уступает изделию ATI – тактовая частота G70 лишь на 30 МГц выше, нежели у GPU предыдущего поколения, NV40. Ничего удивительного тут нет – это расплата за высокую сложность чипа. Тем не менее, проблем с производством G70, похоже, не наблюдается – по словам NVIDIA, видеоадаптеры на базе нового GPU будут доступны к приобретению уже в день анонса. Очень разумный шаг, учитывая, что прошлогодний анонс NV40 оказался, фактически, формальным.

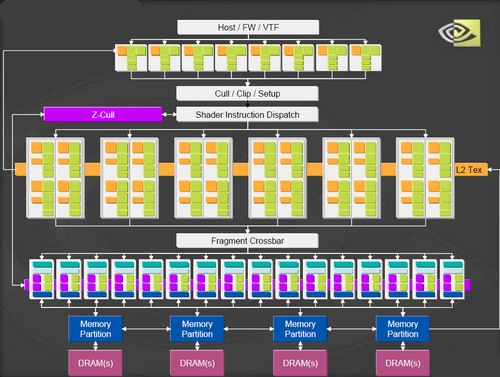

Поскольку, вышеприведенная таблица не дает ответа на вопрос об архитектурных особенностях G70, делающих его решением нового поколения, мы рассмотрим эти особенности отдельно. На первый взгляд, архитектура G70 подобна архитектуре NV40, за исключением количества пиксельных и вершинных процессоров:

Количество блоков растеризации (ROP) осталось прежним – их в чипе 16, поэтому, число текстурных выборок за проход по-прежнему равно 16 или 32 в случае обработки только значений Z. Иными словами, число 24 относится лишь к количеству пиксельных процессоров. Очевидно, что в общих чертах, архитектура GeForce 7800 весьма напоминает архитектуру GeForce 6800, однако, имеются и существенные отличия.

Когда пиксельный конвейер больше, чем просто конвейер

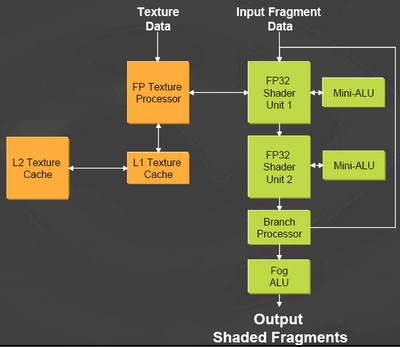

Как мы уже упоминали, NVIDIA тщательно переработала архитектуру пиксельных конвейеров с целью увеличения их производительности. С целью выявления узких мест предыдущей архитектуры разработчики смоделировали 1300 различных шейдеров, и в результате пиксельный конвейер G70 приобрел следующий вид:

Каждый из двух шейдерных блоков теперь имеет дополнительный мини-ALU (подобный подход был реализован еще во времена NV35, однако, в NV40 mini-ALU использованы не были), что увеличивает математическую производительность процессора, а, следовательно, и скорость исполнения пиксельных шейдеров. Каждый пиксельный процессор может выполнять 8 инструкций типа MADD (multiply/add) за такт, а суммарная производительность 24 таких процессоров на инструкциях такого типа достигает внушительной цифры в 165 Gflops, что более, чем в три раза превышает производительность GeForce 6800 Ultra, составляющую 54 Gflops. Циклы и ветвления, характерные для сложных пиксельных шейдеров версии 3.0 поддерживаются в полной мере.

Разумеется, в реальных условиях шейдеры состоят не только из инструкций типа MADD, но, в целом, по словам NVIDIA, производительность G70 при исполнении пиксельных шейдеров более, чем в два раза превышает производительность NV40. Насколько это заявление соответствует истине, мы расскажем в главе обзора, посвященной результатам теоретических тестов, но в целом, улучшенные пиксельные процессоры выглядят весьма многообещающе, и в современных играх, широко использующих пиксельные шейдеры, также следует ожидать немалого прироста производительности.

Вершинные процессоры

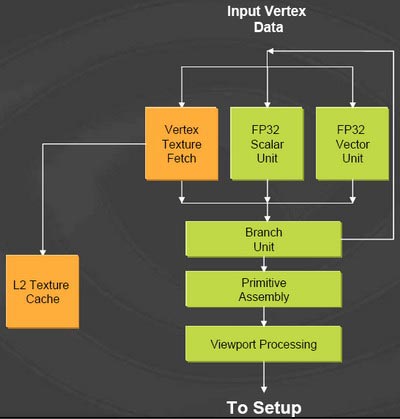

Схематически, вершинный процессор в G70 ничем не отличается от такого же процессора в NV40:

Повышенная производительность при обработке геометрии достигается за счет увеличенного количества вершинных процессоров (8 против 6 у NV40), а также, возможно, за счет усовершенствований в векторном и скалярном блоках.

По официальным данным, производительность скалярного блока по сравнению с NV40 выросла на 20%-30%, а инструкция типа MADD в векторном блоке теперь исполняется за 1 такт. Кроме того, эффективность операций cull и setup в фиксированном блоке геометрического конвейера увеличена на 30%. Насколько сильно это отразится на результатах реальных тестов, мы также расскажем в соответствующей главе обзора.

В целом же, новую архитектуру NVIDIA назвать революционной с точки зрения новых функций нельзя. Скорее, она представляет собой значительно улучшенную и доработанную архитектуру GeForce 6, являвшуюся до сегодняшнего дня самой совершенной в мире трехмерной потребительской графики. Теперь эстафету приняла архитектура GeForce 7, в очередной раз подтвердив технологическое лидерство NVIDIA.

HDR: значительное ускорение

Впервые поддержка формата OpenEXR, позволяющая выводить на экран изображение с расширенным динамическим диапазоном, была реализована в GeForce 6800 Ultra. Этот стандарт используется подразделением Lucasfilm, компанией Industrial Light & Magic при создании спецэффектов для современных киношедевров.

Увы, такой режим рендеринга оказался чрезвычайно ресурсоемким, хотя и обеспечивал гораздо лучшее качество изображения. Первой игрой, способной использовать HDR, стал популярный трехмерный шутер FarCry, в котором поддержка расширенного динамического диапазона появилась, начиная с версии 1.3. Тем не менее, поддержка HDR, по сути, стала лишь рекламной акцией, поскольку, комфортно играть в этом режиме было невозможно даже в разрешении 1024х768. К примеру, на уровне Training производительность составляла от 55 до 90 кадров в секунду в обычном режиме, в зависимости от разрешения, и лишь 15-30 кадров в секунду в режиме HDR. Соответственно, ни о какой-либо комфортабельной игре речи быть не могло. Появление технологии NVIDIA SLI повысило производительность в режиме HDR до более приемлемых значений, но достигалось это лишь в системе, оснащенной двумя GeForce 6800 Ultra/GT, а стоимость такой системы чрезвычайно высока.

С появлением G70 ситуация изменилась, и теперь HDR станет более доступным будущим владельцам этих видеоадаптеров. Если верить словам NVIDIA, то производительность GeForce 7800 GTX в этом режиме на 60% выше производительности GeForce 6800 Ultra, благодаря улучшенным текстурным блокам! По всей вероятности, даже имея лишь одну такую карту, можно будет наслаждаться красотой изображения с расширенным динамическим диапазоном в разрешениях вплоть до 1280х1024, а владельцы систем SLI смогут комфортно играть и в разрешении 1600х1200.

Новые режимы FSAA

При разработке нового графического процессора, NVIDIA не остановилась на увеличении производительности, но также уделила пристальное внимание и повышению качества изображения, и в GeForce 7800 GTX появились новые режимы полноэкранного сглаживания. Как известно, при использовании обычных режимов FSAA, будь то суперсэмплинг или мультисэмплинг, такие объекты, как проволочные заборы или, к примеру, листья на деревьях сглаживанию не подвергаются, в результате чего, выглядят не лучшим образом – на них отчетливо видны зазубрины, отнюдь не добавляющие картинке реалистичности.

С технологической точки зрения, объекты, подобные упомянутым выше, обычно представляют собой очень простые модели, состоящие из нескольких или даже одного полигона; сам же рисунок листьев или проволочной сетки создается при помощи соответствующей текстуры. Поскольку, пиксели, находящиеся внутри полигона, сглаживанию не подвергаются, включение FSAA никак не влияет на такие объекты, отчего они выглядят не лучшим образом. Новый режим сглаживания, примененный NVIDIA в GeForce 7800 GTX, позволяет использовать прозрачные пиксели в операциях блендинга, отчего качество изображения в соответствующих местах значительно повышается. Информация об областях текстуры, которые нужно подвергнуть сглаживанию, берется из альфа-канала текстуры.

Новый метод FSAA существует в двух инкарнациях – Transparency Adaptive Supersampling и Transparency Adaptive Multisampling; последний обеспечивает не такое высокое качество сглаживания, поскольку как для расчета subpixel values используется только один texel sample вместо четырех, но падение производительности при этом значительно меньше.

В сочетании с высокой производительностью GeForce 7800 GTX, применение новых методов полноэкранного сглаживания позволяет добиться практически идеального качества отображения даже мельчайших деталей.

PureVideo

Одной из самых интересных особенностей архитектуры GeForce 6 было наличие специального программируемого видеопроцессора PureVideo, призванного разгрузить центральный процессор системы в процессе работы с видеопотоками. Первая версия этого процессора, входившая в состав NV40, первоначально была отключена, по-видимому, из-за проблем с техпроцессом.

Затем, процессор был включен, но оказалось, что GeForce 6800 оснащена первой версией PureVideo, без поддержки ускорения WMV HD, а более продвинутая вторая версия входит в состав GeForce 6600. Процессор PureVideo второго поколения обладает следующими возможностями:

Аппаратное ускорение MPEG-2. Плавное воспроизведение MPEG-2 видео при минимальной загрузке центрального процессора, что позволяет ПК параллельно работать в других приложениях.

Аппаратное ускорение WMV-HD. Проигрывание видео в WMV-HD формате от Microsoft без потери кадров и снижения детализации. WMV-HD принят HD-DVD консорциумом в качестве нового HD формата и является частью Windows XP, что позволяет пользователям с легкостью редактировать и сохранять свои любимые видеозаписи.

Запись высококачественного видео в режиме реального времени. Полная функциональность записи видео без потери данных. Благодаря технологии NVIDIA PureVideo высококачественная запись сохраняет уровень детализации при использовании минимального размера памяти на жестком диске.

Передовой адаптивный деинтерлейсинг. Графические процессоры с технологией PureVideo поддерживают наиболее передовые видео алгоритмы на ПК для получения четких изображений, не уступающих домашним кинотеатрам высокого уровня, стоящим десятки тысяч долларов.

Покадровая коррекция 3:2. Восстанавливает оригинальный формат фильма для получения более точного воспроизведения видео и более высокого качества картинки.

Уменьшение окна VMR без появления мерцания. Поддерживает детализацию видео без раздражающего мерцания даже при уменьшении размера окна видео воспроизведения.

Гамма-коррекция монитора. Гарантирует то, что изображения не будут слишком темными, яркими или размытыми вне зависимости от видео формата или монитора.

Нечто похожее может предложить лишь S3 Graphics, но ее чипы DeltaChrome и GammaChrome не обладают достаточной для сегодняшнего дня производительностью в 3D. Вполне естественно, что видеопроцессор NVIDIA PureVideo второго поколения перекочевал и в G70, попутно обзаведясь несколькими новыми интересными возможностями, так что перед нами уже третье поколение программируемых видеопроцессоров NVIDIA. В дополнение к приведенному выше списку функций, теперь PureVideo поддерживает следующие возможности:

High-Definition Spatial-Temporal De-Interlacing.

Inverse 2:2 Pull-down Correction.

Seamless playback of high-definition ATSC and DVB MPEG-2 transport streams.

Все нововведения относятся к области работы с HDTV-контентом, что неудивительно, учитывая растущую популярность видеостандартов высокого разрешения.

Отметим, что для того, чтобы задействовать ускорение декодирования видео в формате WMV HD, необходимо будет воспользоваться заплаткой от Microsoft под номером 888656, скачать которую можно отсюда.

GeForce 7800 GTX: близкий взгляд

Пора, наконец, перейти от теории к практике и познакомиться с видеоадаптером GeForce 7800 GTX поближе. На первый взгляд, карта очень напоминает GeForce 6800 GT:

Такое сходство, не в последнюю очередь, является заслугой компактной однослотовой системы охлаждения, однако, и в общих чертах, компоновка PCB GeForce 7800 GTX весьма напоминает компоновку решений предыдущего поколения от NVIDIA. В основном, изменения коснулись задней части PCB, где расположены стабилизаторы напряжения и прочие элементы схемы питания видеоадаптера. Нельзя сказать, что схема стала проще, но количество электролитических конденсаторов уменьшилось, а силовые элементы теперь сгруппированы не в одну линию, как ранее, а в три ряда, и образуют небольшой прямоугольник, прикрытый алюминиевым радиатором с тонкими ребрами.

Изменения в компоновке схемы питания привели к заметному удлинению печатной платы GeForce 7800 GTX, так что новинка по праву может носить звание "самого длинного видеоадаптера".

С обратной стороны платы, помимо привычного кронштейна, являющегося элементом крепления кулера, расположена алюминиевая пластина. Она не является декоративным элементом, как может показаться на первый взгляд. Дело в том, что GeForce 7800 GTX имеет очень любопытную схему расположения чипов памяти. Так как, PCB видеоадаптера рассчитано на установку 512 МБ GDDR3, количество посадочных мест равно 16 – 8 на лицевой стороне платы, и 8 на обратной. Стандартный объем видеопамяти для GeForce 7800 GTX составляет 256 МБ, и все восемь чипов емкостью 256 Мбит можно было бы установить на лицевой стороне PCB, однако, NVIDIA пошла по иному пути, установив по четыре микросхемы с каждой стороны платы, таким образом, что посадочные места оказались занятыми через одно. Поэтому вышеупомянутая пластина не является декоративным элементом – она отводит тепло от четырех чипов GDDR3. Эффективность такого "радиатора" невысока, однако, память типа GDDR3 отличается пониженным тепловыделением; кроме того, отводить тепло требуется лишь от четырех микросхем.

В изделии используется память от Samsung со временем доступа 1.6 наносекунды, способная работать на частоте 600 (1200) МГц. На этой частоте память и работает. Отметим, что со времен GeForce FX 5900, NVIDIA располагает микросхемы памяти таким образом, чтобы длина дорожек, ведущих к GPU, была как можно меньшей. Это позволяет добиться стабильной работы на высоких частотах.

Мы демонтировали систему охлаждения, чтобы получить доступ к GPU:

Как видите, площадь кристалла G70 заметно больше площади NV40, даже, несмотря на меньший размер элемента – 0.11-мкм против 0.13-мкм у решения прошлого поколения. Это неудивительно, учитывая прибавку в 80 миллионов транзисторов. Поверхность G70 не полностью зеркальная, как у NV40, а слегка матовая, по всей видимости, из-за различия в техпроцессах: NV40/45 производится на мощностях IBM в East Fishkill, а G70 – на заводах TSMC. Форма кристаллов также различается, и G70 представляет собой квадрат, в то время, как NV40 – прямоугольник. Отдельный кристалл HSI отсутствует – G70 обладает поддержкой PCI Express изначально. Наш экземпляр был произведен на 16 неделе текущего года, то есть, приблизительно в конце апреля. Таким образом, данный экземпляр G70 существует уже более месяца, а значит, можно предположить, проблем с его производством NVIDIA не испытывает. Символы "A2" указывают, что перед нами – вторая ревизия чипа, что также позволяет надеяться на отсутствие проблем с массовыми поставками.

Отдельного рассказа заслуживает система охлаждения. Она представляет собой вариацию на тему кулера GeForce 6800 GT, однако, значительно модернизированную. Вентилятор бловерного типа прогоняет воздух последовательно сквозь два соединенных U-образной тепловой трубкой алюминиевых радиатора, заодно обдувая и радиатор, охлаждающий силовые стабилизаторы системы питания видеоадаптера. Тепловая трубка служит не только для передачи теплового потока от первого радиатора ко второму, но и для отбора тепла от игольчатой секции, соприкасающейся с чипами памяти. Сверху вся конструкция прикрыта пластиковой крышкой, хотя ранее NVIDIA применяла металлическую. Удивительно, но на референсных снимках NVIDIA отчетливо видно, что первый, самый главный радиатор, отводящий тепло непосредственно от ядра графического процессора, выполнен из меди, в то время, как на нашем экземпляре карты он был изготовлен из алюминия. В чем причина перехода на алюминий? Мы полагаем, что медными кулерами будут снабжаться более мощные версии видеоадаптеров на базе G70, оснащенные 512 МБ видеопамяти и работающие на более высоких частотах, а в текущем варианте GeForce 7800 GTX с охлаждением вполне справляется и алюминиевый радиатор.

Интересен также тот факт, что вентилятор подключен к плате не двумя проводами, как обычно, а четырьмя. Судя по всему, вентилятор снабжен таходатчиком, и система регулирования оборотов теперь является более совершенной и гибкой, нежели ранее. Насколько хороши ее шумовые характеристики, мы расскажем несколько позже.

Энергопотребление и тепловыделение

24 пиксельных конвейера, 302 миллиона транзисторов… Казалось бы, настолько сложный графический процессор должен потреблять море энергии, а ведь уже NV40 был настолько прожорливым, что GeForce 6800 Ultra требовал подключения сразу двух разъемов Molex, а NVIDIA рекомендовала владельцам таких плат обзавестись блоком питания мощностью не менее 480 Ватт. Правда, как оказалось, такая рекомендация была вызвана тем, что менее мощные и более дешевые блоки часто не обеспечивают должной стабильности выходных напряжений. На самом же деле, GeForce 6800 Ultra по уровню энергопотребления лишь незначительно превосходил ATI RADEON X800 XT Platinum Edition, потребляя под нагрузкой порядка 72 Ватт против 63 Ватт у изделия канадской компании.

Как же обстоят дела с энергопотреблением у GeForce 7800 GTX? Неужели она потребует еще более мощного блока питания, нежели GeForce 6800 Ultra? Эти опасения оказались беспочвенными – применение нового, более тонкого техпроцесса позволило NVIDIA не только удержать данный параметр на уровне NV40, но даже несколько его снизить. Для системы, оснащенной одной картой GeForce 7800 GTX, NVIDIA рекомендует блок питания мощностью не менее 350 Ватт, способный обеспечивать ток в 22 Ампера по линии 12 Вольт. Таким образом, потребности GeForce 7800 GTX в питании заметно скромнее, нежели у GeForce 6800 Ultra, и если Ваш блок питания попадает под вышеприведенные критерии, необходимости в его замене нет. Конечно, желающим заполучить в свое распоряжение систему с двумя GeForce 7800 GTX, потребуется более дорогой БП, мощностью не менее 500 Ватт, способный обеспечивать ток в 30 Ампер по линии 12 Вольт, но такие системы по определению относятся к высшему классу, и если Вы решились на приобретение двух GeForce 7800 GTX и соответствующей системной платы, у Вас наверняка найдутся средства и на качественный и мощный блок питания.

Наша лаборатория располагает специальным стендом, служащим для измерения потребления мощности видеоадаптеров с интерфейсом PCI Express. Он представляет собой специально модернизированную платформу со следующей конфигурацией:

Процессор Intel Pentium 4 560 (3.60ГГц, 1МБ L2);

Системная плата Intel Desktop Board D925XCV;

Память PC-4300 DDR2 SDRAM (2x512МБ);

Жесткий диск Samsung SpinPoint SP1213C (Serial ATA-150, буфер 8МБ);

Microsoft Windows XP Pro SP2, DirectX 9.0c.

Схема измерения потребляемой мощности устроена таким образом, что замеры производятся не только для внешней линии питания, но также для линий 12В и 3.3В, идущих через слот PCI Express x16. Это позволяет получить наиболее полные данные об уровне энергопотребления современных видеоадаптеров.

В качестве нагрузки был выбран третий, наиболее сложный тест пакета 3DMark05, запускавшийся в бесконечном цикле в разрешении 1600х1200. При этом были задействованы FSAA 4x и максимально возможная степень анизотропной фильтрации – 16х. Полученные результаты оказались довольно любопытными: GeForce 7800 GTX, состоящий из 302 миллионов транзисторов, содержащий 24 пиксельных процессора и работающий на частоте 430 МГц, потреблял под нагрузкой 80.7 Ватт, в то время, как заметно менее сложный GeForce 6800 Ultra – 77.3 Ватта. Таким образом, разница составила не более 3 Ватт! Применение 0.11-мкм техпроцесса действительно позволило NVIDIA сдержать уровень энергопотребления GeForce 7800 GTX на уровне решения предыдущего поколения. Для сравнения, RADEON X850 XT Platinum Edition под нагрузкой показал результат в 71.6 Ватта, что ненамного меньше показателей видеоадаптеров NVIDIA, однако, характер потребления у него был несколько иной – по внутренней линии 12В он потреблял заметно меньше GeForce 7800 GTX/GeForce 6800 Ultra (31 Ватт против 39-40 Ватт), а по линии 3.3В – напротив, значительно больше (5 Ватт против 2 Ватт). Уровень энергопотребления по внешней линии питания оказался приблизительно одинаковым у всех видеоадаптеров и колебался в районе 33-35 Ватт.

Любопытен тот факт, что сама NVIDIA, говоря об энергопотреблении GeForce 7800 GTX, приводит совсем другие цифры – 100-110 Ватт. Компания имеет в виду т.н. пиковое энергопотребление, когда в графическом процессоре задействованы абсолютно все транзисторы, что, конечно же, является чисто теоретической ситуацией, т.к. в реальных приложениях добиться такой нагрузки невозможно. Исходя из полученных нами данных, можно сделать вывод, что новый графический процессор NVIDIA обладает великолепной эффективностью – несмотря на огромное количество транзисторов, 24 пиксельных процессора и повышенную относительно предшественника тактовую частоту, он потребляет практически столько же энергии, не требуя наличия блока питания с мощностью сварочного аппарата. :) Это отличный результат, и мы вполне можем поздравить NVIDIA с успехом!

Итак, теперешние владельцы GeForce 6800 Ultra/GT, намеревающиеся приобрести GeForce 7800 GTX, могут не беспокоиться – уже имеющийся БП прекрасно подойдет и для решения нового поколения от NVIDIA. Точно также, энтузиасты-эскстремалы, использующие SLI-связку из двух GeForce 6800 Ultra, вполне могут использовать свой старый блок. Тем же, для кого GeForce 7800 GTX станет первым видеоадаптером, а также владельцам менее мощных карт семейства GeForce 6600 GT/RADEON X700 PRO мы рекомендуем приобрести качественный блок питания мощностью не менее 350 Ватт, а еще лучше – 400 Ватт. Внимание! Избегайте дешевых блоков от неизвестных производителей – они могут быть собраны по упрощенной схеме и не обеспечивать номинальной мощности при допустимом уровне колебаний питающих напряжений. Применение такого блока может привести не только к выходу из строя видеоадаптера, но и к повреждению других компонентов Вашей системы.

Шумность, разгон и качество 2D

При загрузке системы GeForce 7800 GTX ведет себя практически так же, как и ее предшественники – до загрузки операционной системы вентилятор системы охлаждения работает на максимальных оборотах, производя достаточно сильный шум, но как только система загружена, обороты автоматически снижаются, и уровень шума падает. Субъективно, карта ведет себя несколько тише, нежели GeForce 6800 Ultra/GT и работать при загруженной ОС можно вполне комфортно. Связка из двух GeForce 7800 GTX, конечно, работает более громко, но и в этом случае уровень шума остается в относительно комфортных пределах; во всяком случае, по сравнению с двумя GeForce 6800 Ultra. За все время тестирования система регулировки оборотов вентилятора ни разу не вывела его на максимальный режим, и это говорит о том, что усовершенствованный референсный кулер NVIDIA отлично справляется с задачей охлаждения видеоадаптера. Увы, любителям полной тишины пока не удастся установить на GeForce 7800 GTX какой-нибудь бесшумный кулер, вроде Arctic Cooling NV Silencer 5, так как чипы памяти, расположенные на обратной стороне PCB, в этом случае останутся без охлаждения. Следовательно, придётся ждать специальной версии устройства охлаждения.

На хороший разгон мы не рассчитывали – чип, состоящий из более, чем 300 миллионов транзисторов и выполненный по 0.11-мкм техпроцессу без использования специальных диэлектриков, теоретически, должен переносить процедуру разгона не лучшим образом. Косвенно это подтверждается результатами разгона RADEON X800 XL, который редко разгоняется до частот свыше 420-430 МГц. Тем не менее, наши пессимистичные прогнозы не оправдались – при первой же попытке нам удалось разогнать графический процессор до 490 МГц, то есть, прирост составил 60 МГц, вместо ожидаемых 20-30 МГц. Память разогналась гораздо хуже, лишь до 610 (1220) МГц, однако, это неудивительно для чипов со временем доступа 1.6 наносекунды, уже работающих на максимально возможной для них частоте. Второй экземпляр GeForce 7800 GTX разогнался почти также – до частот 480/620 (1240) МГц.

Что касается качества 2D, то оно, по обыкновению, оказалось отличным во всех разрешениях, вплоть до 1800х1440х75 Гц. Для проверки качества 2D мы использовали CRT-монитор Dell P1130 с диагональю 21", отличающийся от старого Dell P1110 лишь дизайном корпуса. Впрочем, мы и не ожидали плохого качества 2D от видеоадаптера высшего класса, каким, несомненно, является GeForce 7800 GTX.

Драйверы, настройки и конфигурация тестовой платформы

Тестовая платформа была сконфигурирована следующим образом:

Процессор AMD Athlon 64 4000+ (2.40ГГц, 1МБ L2);

Системная плата ASUS A8N-SLI Deluxe;

Память OCZ PC-3200 Platinum EB DDR SDRAM (2x512МБ, CL2.5-3-2-8);

Жесткий диск Samsung SpinPoint SP1213C (Serial ATA-150, буфер 8МБ);

Звуковая карта Creative SoundBlaster Audigy 2.

Microsoft Windows XP Pro SP2, DirectX 9.0c;

Видеоадаптеры:

NVIDIA GeForce 7800 GTX 256MB (430/1200MHz);

NVIDIA GeForce 6800 Ultra 256MB (400/1100MHz);

NVIDIA GeForce 6800 GT 256MB (350/1000MHz);

ATI RADEON X850 XT Platinum Edition 256MB (540/1180MHz);

ATI RADEON X800 XL 256MB (400/980MHz).

GeForce 7800 GTX и GeForce 6800 Ultra были также протестированы в SLI-конфигурациях.

Драйверы:

NVIDIA ForceWare 77.62;

ATI CATALYST 5.6.

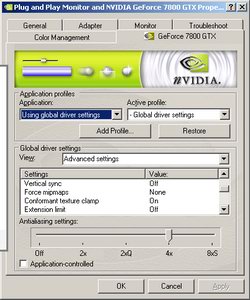

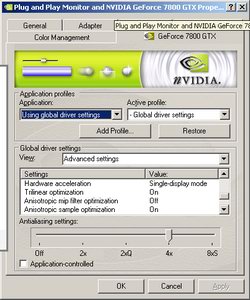

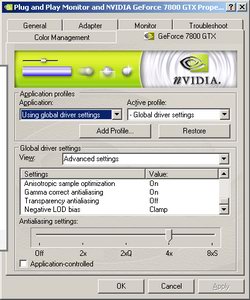

В процессе тестирования GeForce 7800 GTX мы использовали драйвер ForceWare 77.62, относящийся к новому поколению драйверов NVIDIA, так называемому ForceWare Release 75. Данная версия ForceWare является первой, поддерживающей новый графический процессор NVIDIA. От старого официального драйвера версии 71.89 она отличается лучшей поддержкой HDTV, большим количеством игровых профилей, полной поддержкой OpenGL 2.0, а также возможностью выбора режима работы технологии SLI. Дизайн панели управления новых драйверов несколько изменился и стал, пожалуй, чуть более удобным. Для тестов мы применили следующие настройки драйвера:

Опции Gamma correct antialiasing и Transparency antialiasing присутствуют только в том случае, если в системе установлен видеоадаптер GeForce 7800 GTX, для GeForce 6800 Ultra они отсутствуют. Все остальные настройки были выставлены идентичным образом. Для драйверов ATI CATALYST 5.6 использовался режим CATALYST A.I Standard, при этом, опция Mipmap Detail Level была установлена в положение Quality. Опция VSync была принудительно отключена в обоих драйверах.

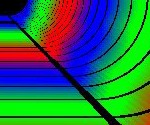

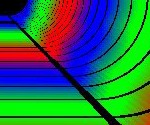

Качество анизотропной фильтрации

Перед началом тестирования мы решили выяснить, как обстоят дела у GeForce 7800 GTX с качеством анизотропной фильтрации. Для проверки использовалась соответствующая функция 3DMark05.

При использовании только трилинейной фильтрации никакой разницы в качестве между GeForce 7800 GTX и GeForce 6800 Ultra обнаружить не удалось. У RADEON X850 XT Platinum Edition характер фильтрации несколько иной – mip-уровни начинаются чуть дальше, а переходы между ними плавнее, чем можно наблюдать у видеоадаптеров NVIDIA.

При использовании анизотропной фильтрации разница между GeForce 6800 Ultra и GeForce 7800 GTX исчезающе мала, однако, если приглядеться, четкость текстур у последней в этом случае все же несколько выше. В данном случае, у RADEON X850 XT Platinum Edition mip-уровни также выглядят по-иному, нежели у GeForce 6/7 – они менее ярко выражены, и качество фильтрации, в целом, выше. Таким образом, можно заключить, что в области анизотропной фильтрации на GeForce 7800 GTX принципиальных изменений нет, но ее качество все же чуть выше, чем у GeForce 6800 Ultra. Разница исчезающе мала, и вряд ли это будет заметно в реальной игровой ситуации.

Качество Transparency Antialiasing

Для того, чтобы проверить, насколько способны улучшить качество изображения новые методы полноэкранного сглаживания, было решено снять скриншоты в двух наиболее известных сегодня шутерах – FarCry и Half-Life.

NVIDIA GeForce 7800 GTXATI RADEON X850 XT

Platinum Edition

no FSAAno FSAA

FSAA 4xS + TMSFSAA 4x

FSAA 4xS + TSS

FSAA 8xS + TMSFSAA 6x

FSAA 8xS + TSS

Увы, в FarCry нам так и не удалось найти заметных отличий в качестве изображения между обычным FSAA и FSAA с включенным Transparency Antialiasing. Разница, конечно, есть, но она настолько невелика, что заметить ее можно, лишь пристально вглядываясь в скриншоты.

NVIDIA GeForce 7800 GTXATI RADEON X850 XT

Platinum Edition

no FSAAno FSAA

FSAA 4xS + TMSFSAA 4x

FSAA 4xS + TSS

FSAA 8xS + TMSFSAA 6x

FSAA 8xS + TSS

Иное дело Half-Life 2 – улучшение качества изображения от включения Transparency Antialiasing здесь заметно намного лучше. Правда, это относится только к режиму Supersampling, а вот режим Multisampling обеспечивает менее впечатляющую картинку, хотя повышение качества изображения также налицо, особенно в сочетании с FSAA 8xS. Наиболее красивая картина наблюдается в режиме FSAA 8xS + Transparency Supersampling; в этом случае даже мельчайшие детали прорисовываются практически идеально. Итак, новая возможность GeForce 7800 GTX – Transparency Antialiasing действительно способна значительно улучшить качество прорисовки некоторых деталей изображения, особенно, в сочетании с режимом FSAA 8xS, но насколько сильно это скажется на производительности?

Падение производительности при использовании Transparency Antialiasing

Как оказалось, производительность в играх после включения TSAA падает крайне незначительно по сравнению с обычными режимами FSAA. Взгляните на диаграммы:

Как видите, включение Transparency Multisampling практически не влияет на производительность даже при использовании базового режима 8xS. Впрочем, эта разновидность TSAA не обеспечивает значительного улучшения в качестве изображения, в отличие от Transparency Supersampling, но даже и в этом случае производительность падает не более, чем на 5%. Следовательно, те, кто предпочитает играть с включенным полноэкранным сглаживанием, смогут использовать Transparency Antialiasing практически не теряя в скорости.

Производительность GeForce 7800 GTX в теоретических тестах

Мы провели полный цикл теоретических тестов, чтобы выяснить потенциал нового графического процессора NVIDIA. В процессе тестирования использовалось следующее программное обеспечение:

Marko Dolenc's Fillrate Tester;

Xbitmark v0.60;

3DMark 2001SE build 330;

3DMark03 build 360;

3DMark05 build 120.

Скорость заполнения сцены

По традиции, цикл открывает Marko Dolenc's Fillrate Tester.

Из диаграммы видно, что при небольшом количестве текстур GeForce 7800 GTX не сильно опережает GeForce 6800 Ultra, однако, как только количество накладываемых текстур возрастает до двух и более, графики начинают расходиться, и преимущество нового решения становится более очевидным. В случае с тремя и четырьмя текстурами производительность GeForce 7800 GTX в 1.5 раза превосходит производительность GeForce 6800 Ultra, что подтверждает наличие 24 пиксельных конвейеров.

Стоит отметить, что GeForce 7800 GTX демонстрирует результаты весьма далёкие от теоретического максимума, что можно объяснить относительно невысокой тактовой частотой памяти.

Аналогичная картина наблюдается и при отключении записи Z. В обоих случаях RADEON X850 XT Platinum Edition значительно уступает как GeForce 7800 GTX, так и GeForce 6800 Ultra.

В целом, поведение GeForce 7800 GTX аналогично поведению предшественника, однако, главный ограничивающий фактор производительности – память.

Поскольку GeForce 7800 GTX имеет 16 блоков ROP, а не 24, скорость заполнения при работе только с Z-буфером практически аналогична показателю GeForce 6800 Ultra. Небольшая разница в пользу решения нового поколения обусловлена более высокой тактовой частотой GPU – 430 МГц против 400 МГц у GeForce 6800 Ultra.

Справедливо отметить, что как GeForce 6800 Ultra, так и GeForce 7800 GTX показывают в данном тесте результаты, существенно превышающие теоретический максимум. Чем это объяснить – на сегодняшний день неизвестно.

Производительность при исполнении пиксельных шейдеров

Marko Dolenc's Fillrate Tester подходит также и для исследования производительности графического процессора при работе с пиксельными шейдерами версий 1.1 и 2.0. Мы воспользовались этой возможностью:

NVIDIA действительно удалось значительно повысить скорость обработки пиксельных шейдеров. В случае сложных пиксельных шейдеров, при помощи которых создается попиксельное освещение, G70 примерно в 1.5 раза быстрее, нежели NV40; на более простых шейдерах преимущество решения нового поколения еще более возрастает, хотя и не достигает двукратного. RADEON X850 XT Platinum Edition опережает GeForce 6800 Ultra в случае исполнения простых шейдеров, но GeForce 7800 GTX, оснащенный 24 пиксельными процессорами, не оставляет решению ATI ни единого шанса. Следует отметить, что даже новые пиксельные процессоры NVIDIA выигрывают от использования половинной точности для пиксельных шейдеров 2.0.

Отключение записи Z не меняет ситуации, и расклад сил остается прежним.

Наиболее интересная картина наблюдается при отключении записи цвета – в данном случае, на сложных пиксельных шейдерах GeForce 7800 GTX более, чем в полтора раза опережает GeForce 6800 Ultra, а вот в случае с простыми шейдерами разница в производительности куда более скромна. Очевидно, это связано с архитектурными особенностями GeForce 7800 GTX, которая имеет 24 пиксельных процессора, но лишь 16 блоков растеризации.

Таким образом, новый графический процессор NVIDIA больше всего выигрывает там, где задействуются сложные математические вычисления, а шейдеры, создающие попиксельное освещение, представляют собой именно такой случай.

GeForce 7800 GTX действительно великолепно справляется со сложными пиксельными шейдерами – это подтвердили результаты, полученные в новой версии Xbitmark, специальном тесте, служащем для детального изучения производительности современных графических процессоров при работе с шейдерами.

Как и было предсказано, ярче всего новинка проявляет себя там, где задействованы сложные математические расчеты: в шейдерах Dot Product Bump Mapping + Specular + Reflection, Factored BRDF + HDR, Metal + Phong, Wood и, особенно, обоих Dynamic Branching. Последние весьма сложны, поскольку состоят более, чем из 170 инструкций, но даже на этих шейдерах GeForce 7800 GTX без особых проблем обеспечивает производительность на уровне свыше 90 кадров в секунду. Эти шейдеры, а также NPR hatch 10textures PS3, написаны в рамках модели 3.0, поэтому на картах ATI они не запускаются.

На шейдерах, в которых упор делается, главным образом, на текстурную нагрузку, например, Cook Torrance + Texture + Fresnel или 27-Pass Fur, выполняемый, как видно из названия, за 27 проходов, преимущество GeForce 7800 GTX над GeForce 6800 Ultra не столь высоко – сказывается наличие лишь 16 ROP при 24 пиксельных процессорах. Несмотря на это, общая производительность новинки NVIDIA чрезвычайно высока, и она действительно является самым производительным видеоадаптером бытового класса на сегодня.

Данный тест нельзя отнести к разряду самых сложных – в нем используются пиксельные шейдеры версии 1.1. Заметная разница в производительности между GeForce 7800 GTX и GeForce 6800 Ultra наблюдается только в разрешении 1600х1200.

Пиксельные шейдеры, используемые в тесте Advanced Pixel Shader, более сложны, и здесь GeForce 7800 GTX примерно в 1.5 раза опережает GeForce 6800 Ultra и RADEON X850 XT Platinum Edition.

Еще более заметно преимущество GeForce 7800 GTX над решениями предыдущего поколения в соответствующем тесте пакета 3DMark03 – в высоких разрешениях выигрыш в производительности достигает 100%! Заявление NVIDIA о двукратном превосходстве GeForce 7800 GTX при обработке пиксельных шейдеров, похоже, соответствует действительности.

Столь же ярко видно преимущество новой архитектуры NVIDIA и в 3DMark05, причем, во всех разрешениях. Пиксельные шейдеры, используемые в этом тесте, наиболее сложны с математической точки зрения, и именно здесь G70 показывает себя с лучшей стороны.

Производительность при исполнении вершинных шейдеров

Если предположить, что никаких кардинальных улучшений в архитектуру вершинных процессоров, NVIDIA, скорее всего, не вносила, ограничившись увеличением их числа, то полученный результат не должен вызывать удивления, ведь 6 вершинных процессоров RADEON X850 XT Platinum Edition работают на частоте 540 МГц, в то время, как 8 процессоров GeForce 7800 GTX – лишь на частоте 430 МГц.

Иначе выглядит ситуация в аналогичном тесте 3DMark03 – здесь GeForce 7800 GTX опережает RADEON X850 XT Platinum Edition приблизительно на 15% и своего предшественника на более чем 30%.

Тест Simple Vertex Shader производит лишь трансформацию и освещение шести высокополигональных моделей, состоящих каждая из 1 миллиона вершин. Источник света в сцене только один. Нагрузка на вершинные процессоры достаточно велика, но используемые в тесте вершинные шейдеры очень просты; они вполне могли бы уложиться в Shader Model 1, поэтому тест и носит такое название. В данном случае наблюдается некоторое превосходство RADEON X850 XT Platinum Edition над новым флагманом NVIDIA. Причина все та же – высокая тактовая частота GPU.

Тест Complex Vertex Shader куда более сложен – здесь при помощи вершинных шейдеров создается целое море травы, причем, каждая травинка обрабатывается отдельно. Результаты, впрочем, аналогичны предыдущему тесту – GeForce 7800 GTX уступает RADEON X850 XT Platinum Edition, несмотря на большее число вершинных процессоров.

Тест на производительность вершинных процессоров, входящий в состав Xbitmark, во многом подобен тесту Simple Vertex Shader из пакета 3DMark05, поэтому и результаты в нем были получены аналогичные. Таким образом, новое детище NVIDIA проявило себя на поприще обработки геометрии не настолько хорошо, как в области обработки пиксельных шейдеров. Отставание от RADEON X850 XT Platinum Edition невелико, и вряд ли это отразится на производительности GeForce 7800 GTX в играх со сложной геометрией.

Эмуляция фиксированного TnL

Эти тесты, казалось бы, являются устаревшими, но, тем не менее, мы посчитали нужным включить их в обзор, поскольку современные видеоадаптеры эмулируют фиксированный блок трансформации и освещения при помощи вершинных шейдеров.

При наличии одного источника света все современные видеоадаптеры высшего класса демонстрируют примерно одинаковый результат, с небольшим перевесом в пользу RADEON X850 XT Platinum Edition.

При увеличении количества источников света до восьми GeForce 7800 GTX резко выходит вперед. Ситуация напоминает ту, которая сложилась в тесте Vertex Shader пакета 3DMark03. Вероятно, дело в том, что в обоих этих тестах используется несколько источников света, и именно при работе с ними архитектура G70 проявляет себя наилучшим образом.

В тесте на производительность при моделировании систем частиц GeForce 7800 GTX вновь уступает RADEON X850 XT Platinum Edition из-за низкой частоты GPU.

Наложение рельефа и другие тесты

При наложении рельефа методом EMBM GeForce 7800 GTX значительно опережает GeForce 6800 Ultra, но уступает RADEON X850 XT Platinum Edition. Исключением является разрешение 1600х1200, где видеоадаптер нового поколения от NVIDIA выходит в лидеры.

Графические процессоры NVIDIA всегда отлично справлялись с наложением рельефа методом Dot3, и NVIDIA G70 не стал исключением, опередив в этом тесте решения предыдущего поколения во всех разрешениях.

Тест Ragtroll служит для оценки сбалансированности связки "центральный процессор-драйвер-GPU". В нем используется физический движок Havok, вершинные шейдеры версии 1.1, и пиксельные шейдеры версии 1.4. График GeForce 7800 GTX практически параллелен графику RADEON X850 XT Platinum Edition, и оба видеоадаптера выглядят менее сбалансировано, нежели GeForce 6800 Ultra. Если же говорить о fps, то GeForce 7800 GTX выходит в этом тесте победителем.

Производительность при проигрывании видео

Для оценки производительности тестируемых видеоадаптеров при проигрывании различных форматов видео, мы использовали Windows Media Player 10 с установленным патчем, включающим Direct X Video Acceleration для WMV HD-контента. В качестве тестовых роликов использовались:

Ролик "Magic of Flight" в формате WMV HD, 1080p

Ролик в формате DivX, 640x480

DVD с фильмом "Blue Streak", PAL

О загрузке центрального процессора были получены следующие данные:

GeForce 7800 GTX действительно обеспечивает несколько меньшую загрузку CPU, нежели GeForce 6800 Ultra, однако, и RADEON X850 XT Platinum Edition показывает аналогичные результаты. По всей видимости, последнему удается так хорошо справляться с задачей благодаря высокой тактовой частоте графического процессора. Все же, 47% загрузки при работе с форматом 1080p – это очень и очень неплохо.

При проигрывании DivX-контента на первое место прочно выдвигается RADEON X850 XT Platinum Edition, в пике загружающий процессор лишь на 10%, в то время, как для решений NVIDIA это минимальный показатель, а максимальный составляет порядка 16%.

С DVD-диском GeForce 7800 GTX и RADEON X850 XT Platinum Edition справляются одинаково успешно, а вот GeForce 6800 Ultra показывает нам заметно более высокий уровень загрузки центрального процессора.

Судя по имеющимся результатам, GeForce 7800 GTX действительно разгружает CPU при проигрывании видео несколько лучше, чем его предшественник. В то же время, результаты новинки практически аналогичны результатам RADEON X850 XT Platinum Edition, так что никакого прорыва в этой области мы не наблюдаем. Тем не менее, благодаря поддержке адаптивных алгоритмов деинтерлейсинга, качество проигрывания DVD и другого видеоконтента, закодированного в чересстрочных форматах, на GeForce 7800 GTX выше. К сожалению, на этот раз нам не удалось получить соответствующие скриншоты, но мы постараемся исправить это досадное упущение как можно быстрее.

Заключение

Итак, мы завершили теоретическую часть обзора, посвященного новому графическому процессору NVIDIA и видеоадаптеру на его основе. Но действительно ли GeForce 7800 GTX является решением нового поколения с уникальной архитектурой? Судя по всему, дать на этот вопрос утвердительный ответ было бы некорректно, однако, и называть G70 простым наследником NV40 стало бы чрезмерным упрощением. Инженеры-разработчики NVIDIA действительно проделали огромную работу по улучшению архитектуры GeForce 6, и, благодаря их усилиям, архитектуру GeForce 7 можно назвать самой мощной в мире, особенно в области обработки пиксельных шейдеров.

24 усовершенствованных пиксельных процессора демонстрируют впечатляющую мощь, не оставляя никакого шанса решениям на базе GeForce 6800 или RADEON X850 там, где требуется интенсивная работа со сложными математическими расчетами. Наличие восьми вершинных процессоров позволило компенсировать недостаточно высокую тактовую частоту GPU, и по скорости обработки геометрии GeForce 7800 GTX практически не уступает наиболее высокочастотному на сегодняшний день решению – RADEON X850 XT Platinum Edition.

Более того, GeForce 7800 GTX перенял у своего предшественника эстафету технологического лидерства благодаря поддержке ряда технологий. NVIDIA по-прежнему является единственным разработчиком графических чипов, чьи решения поддерживают Shader Model 3.0 и HDR; ATI Technologies не предложит ничего подобного, по крайней мере, до момента выхода в свет R520 и решений на его основе.

Сам видеоадаптер GeForce 7800 GTX также получился вполне удачным решением – компактным и не слишком прожорливым. Единственным его недостатком, пожалуй, являются габариты – карта имеет слишком большую длину, и при ее установке в компактные корпуса могут возникнуть проблемы. С другой стороны, GeForce 7800 GTX – решение высшего класса, и вряд ли кто-то будет устанавливать ее в корпус типа microATX или barebone. "Участь" таких видеоадаптеров – огромные, просторные корпуса с хорошей вентиляцией и качественным блоком питания, на которые настоящие энтузиасты ПК обычно не скупятся.

Официальная стоимость новинки составляет $599, что не так уж много для решения, обладающего столь высоким уровнем производительности. Впрочем, окончательное решение выносить еще рано – сначала следует выяснить, насколько хорошо GeForce 7800 GTX проявит себя в современных играх. Именно этому и посвящена вторая часть нашего обзора нового графического процессора NVIDIA.