Ваш город: Москва

Энергопотребление видеокарт: весна 2010

Введение

Давно прошли времена, когда серьёзные — для своего времени — игровые системы довольствовались блоками питания мощностью 200—250 Вт. Сегодня графические адаптеры прочно укрепились на позициях наиболее прожорливых компонентов платформы РС, оставив далеко позади даже самые мощные центральные процессоры, занимающие, впрочем, в этой номинации почётное второе место. Время от времени происходит небольшой откат назад, вызванный массовым переходом AMD/ATI и Nvidia на новые техпроцессы, но, в целом, тенденция однозначна — уровень энергопотребления графических карт непрестанно растёт по мере возрастания их мощностей. Такова неизбежная расплата за прогресс в области 3D-технологий. Разумеется, острее всего вопрос выбора блока питания особенно актуален именно для любителей современных игр во всем их великолепии, то есть, с максимальными настройками детализации и включенным сглаживанием. В таком режиме наиболее мощные графические карты легко могут потреблять 200 Вт и более, но действительно точных данных по этой теме на просторах Всемирной Сети представлено сравнительно немного. Большинство обозревателей измеряют общий уровень энергопотребления системы в целом, но даже эти измерения содержат ряд погрешностей, о которых было рассказано в обзоре «Энергопотребление компьютеров: так сколько нужно ватт?».

Более сложная, но обеспечивающая куда более точные и полные результаты методика заключается в непосредственном измерении токов, протекающих по различным линиям питания графического адаптера. До недавнего времени мы использовали одну из разновидностей такого способа, заключавшуюся в установке измерительных шунтов в разрез всех цепей питания карты, включая силовые линии слота PCI Express. Однако такой способ неидеален — во-первых, он требует достаточно серьёзной модификации системной платы, во-вторых, сам процесс измерений не предусматривал каких-либо средств автоматизации измерений, и наконец, в-третьих, для создания нагрузки на GPU использовались окончательно устаревшие к настоящему времени приложения, такие, как тестовые пакеты Futuremark 3DMark06 и PCMark05. Хотя с помощью этого способа нам удалось накопить солидную базу данных по электрическим характеристикам различных графических карт, в 2010 году эта база по вышеописанной причине уже не представляет такой существенной ценности, как ранее — устаревшее программное обеспечение просто не в состоянии выжать все соки из современного графического адаптера, а значит, показатели уровня энергопотребления, полученные с применением нашей старой методики, в лучшем случае, будут серьёзно заниженными. Кроме того, за прошедшее время успели родиться новые поколения GPU, также представляющие интерес с точки зрения экономичности, благо, разработчики графических процессоров активно переходят на использование 40-нм техпроцесса.

В результате назрела необходимость нового обзора, целиком посвящённого уровню энергопотребления современных графических решений в различных режимах, и основанного на новой, более совершенной методике измерений. Поскольку мы уже располагаем такой методикой и активно её используем, дело было за малым — провести замеры по новому методу для всех имеющихся в тестовой лаборатории графических карт и свести полученные цифры в удобную для читателей форму, что и было исполнено. Данный обзор призван ознакомить наших читателей с самыми свежими данными об экономичности современных и не очень современных видеокарт, а также с некоторыми электрическими особенностями поведения популярных игровых GPU при разгоне. Кроме того, мы надеемся, что, ориентируясь на полученные данные, вы сможете лучше понять, какой именно блок питания потребуется вашей игровой платформе, в зависимости от её конфигурации.

Надеемся также, что эта статья скрасит вам ожидание результатов детального тестирования новейшей видеокарты NVIDIA — GeForce GTX 480, — которое прямо сейчас проходит в нашей лаборатории.

Методология тестирования

Как уже было рассказано в предыдущей главе сегодняшнего обзора, в настоящее время для исследования электрических характеристик современных графических карт в нашей лаборатории используется отдельный тестовый стенд, имеющий следующую конфигурацию:

Процессор Intel Core 2 Quad Q6600 (3 ГГц, 1333 МГц FSB x 9, LGA775)

Системная плата DFI LANParty UT ICFX3200-T2R/G (ATI CrossFire Xpress 3200)

Память PC2-1066 (2x2 ГБ, 1066 МГц)

Блок питания Enermax Liberty ELT620AWT (мощность 620 Вт)

Microsoft Windows 7 Ultimate 64-bit

CyberLink PowerDVD 9 Ultra/«Serenity» BD (1080p VC-1, 20 Мбит/с)

Crysis Warhead

OCCT Perestroika 3.1.0

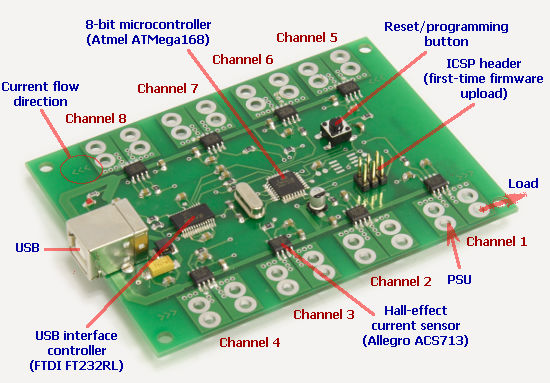

Сердцем и изюминкой данной тестовой платформы является специальная измерительная плата, построенная на базе токовых датчиков Allegro ACS713-30T и 8-битного микроконтроллера Atmel ATmega168:

Её конструкция была более детально описана в обзоре «Энергопотребление компьютеров: так сколько нужно ватт?». С помощью специально написанного под эту систему программного обеспечения в настоящее время и проводятся все измерения электрических характеристик графических карт. Применение данного измерительного комплекса позволяет предельно упростить сам процесс измерения, а также в значительной степени его автоматизировать. На момент проведения сводного тестирования были использованы следующие версии драйверов ATI и Nvidia:

ATI Catalyst 10.2 для карт ATI Radeon HD

Nvidia GeForce 196.21 WHQL для карт Nvidia GeForce

Как обычно, для создания нагрузки на видеоадаптер в различных режимах были использованы следующие тесты:

CyberLink PowerDVD 9: FullScreen, аппаратное ускорение включено

Crysis Warhead: 1600x1200, FSAA 4x, DirectX 10/Enthusiast, карта «frost»

OCCT Perestroika GPU: 1600x1200, FullScreen, Shader Complexity 8

Для каждого режима, за исключением симуляции предельной нагрузки в OCCT, замеры проводились в течение 60 секунд; во избежание выхода карты из строя вследствие перегрузки цепей питания, для теста OCCT: GPU время тестирования было ограничено 10 секундами.

Уровень энергопотребления современных графических карт

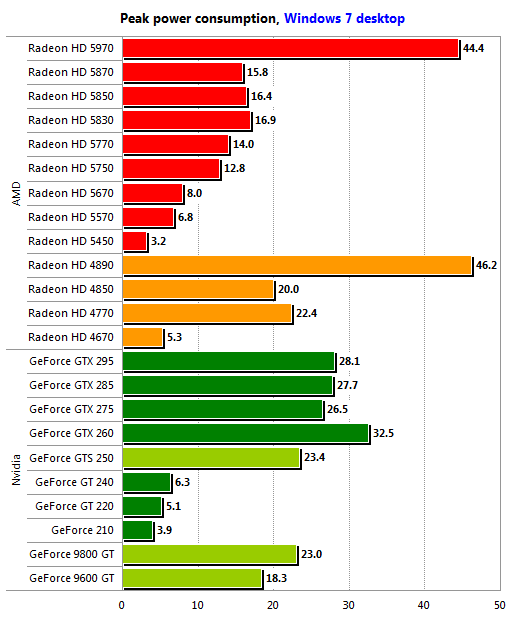

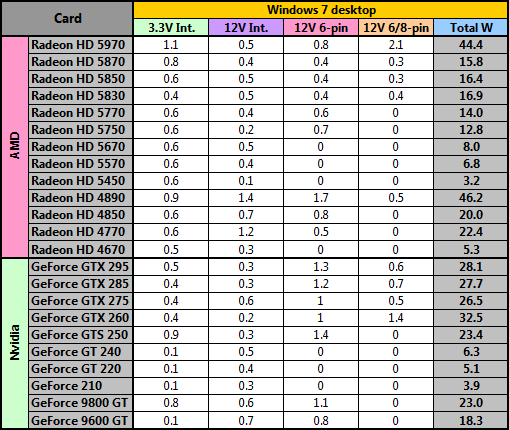

Начнём с самого банального теста — «рабочего стола» Windows 7. Заметим, что режим «Windows 7 desktop» не вполне корректно называть «режимом простоя», поскольку даже если пользователь ничем не занят, графический адаптер занимается отрисовкой интерфейса ОС, причём в случае с интерфейсом Windows Aero в этом задействована и 3D-часть видеокарты.

Здесь новым решениям Advanced Micro Devices нет равных — даже старшая однопроцессорная модель семейства, ATI Radeon HD 5870, потребляет лишь немногим более 15 Вт. Исключением из правила является Radeon HD 5970, но глупо предполагать, что для тех, кто приобретает этого двухголового монстра, вопросы экономичности играют значительную роль. Кроме того, даже он в режиме «рабочего стола» потребляет меньше, нежели одночиповый Radeon HD 4890, в отличие от собратьев по семейству Radeon HD 4000, действительно ведущий себя крайне неэкономично.

Среди решений Nvidia наилучшим образом смотрятся разработки на базе новых 40-нм графических процессоров — GeForce GT 240, 220 и 210. По части экономичности они вполне могут составить конкуренцию своим соперникам из стана AMD. А вот показатели решений на базе G200 оставляют желать лучшего — сказывается не самый оптимальный для такой сложности ядра техпроцесс. К счастью, GeForce GTX 295, похоже, умеет отключать в этом режиме одно из ядер, в результате чего, выглядит экономичнее Radeon HD 5970. Не блещут и представители поколения GeForce 9, что также закономерно. В целом, если вашей основной сферой использования компьютера является работа в офисных и прочих 2D-приложениях, имеет смысл ориентироваться на решения AMD. Стоит только помнить, что, по сообщениям некоторых источников, семейство Radeon HD 5000 иногда испытывает проблемы с ускорением 2D в среде Windows 7, поэтому для работы в «тяжёлых» 2D-приложениях, таких как AutoCAD, лучше остановить свой выбор на решениях Nvidia.

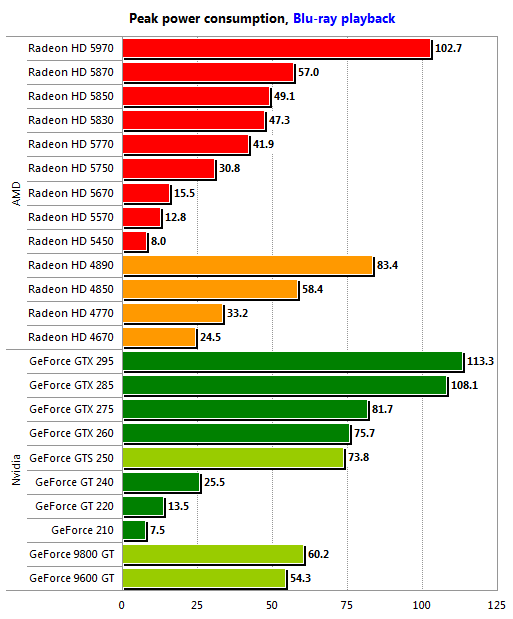

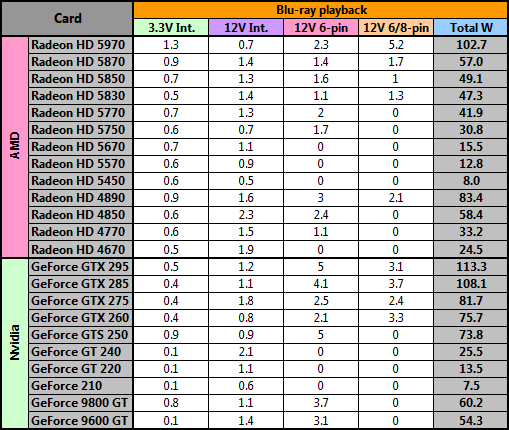

При проигрывании HD-видео пальма первенства однозначно принадлежит семейству ATI Radeon HD 5000, сочетающему неплохую экономичность с полноценной поддержкой HDMI 1.3a, включая передачу по HDMI многоканальных звуковых форматов высокого разрешения. Решения Nvidia на базе 55 и 65-нм ядер мало того, что довольно неэкономичны в этом режиме, но ещё и не поддерживают полностью аппаратное декодирование формата VC-1, перекладывая часть работы на плечи процессора. К счастью, GeForce GT 240, 220 и 210 этого недостатка лишены, но даже у них функциональность ограничена: эти карты не поддерживают Protected Audio Path, так что о Dolby TrueHD или DTS-HD Master Audio при работе с ними придётся забыть. Более подробно о мультимедийных возможностях недорогих решений AMD и Nvidia можно узнать, ознакомившись с недавно опубликованным обзором «ATI Radeon HD 5670, HD 5570 и HD 5450: мультимедийный идеал».

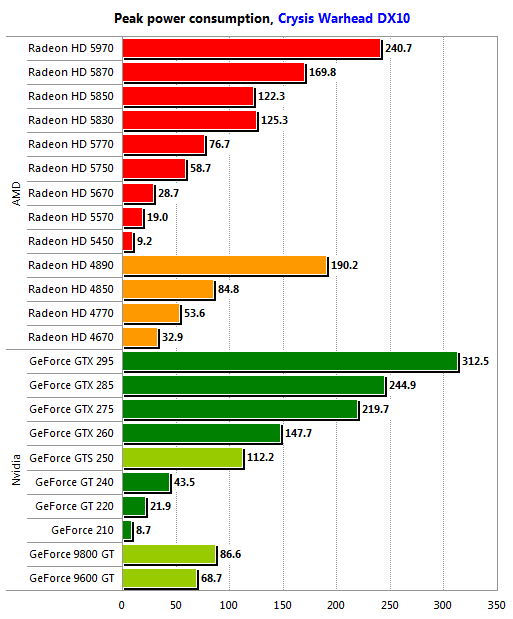

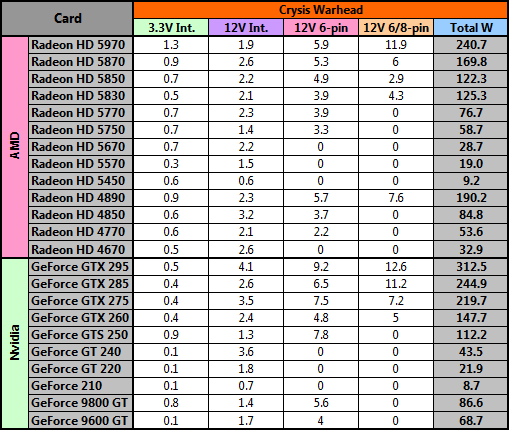

В играх семейство Radeon HD 5000 также лидирует — даже старший его представитель, двухпроцессорный Radeon HD 5970, потребляет существенно меньше, нежели Nvidia GeForce GTX 295. Даже использование 40-нм техпроцесса помогает Nvidia не слишком хорошо — GeForce GT 240 GDDR5 куда менее экономичен, нежели его прямой конкурент, Radeon HD 5670. Ну и не стоит забывать о том, что все ATI Radeon HD 5000 поддерживают DirectX 11, чего текущие решения Nvidia по определению лишены. Иными словами, выбор того, кто ориентируется главным образом на игры, очевиден.

Стоит, однако, отметить, что Radeon HD 5830 может оказаться менее выгодным приобретением, нежели Radeon HD 4890. Последний, хотя и не поддерживает DirectX 11, а также потребляет существенно больше энергии, демонстрирует в ряде случаев и более высокий уровень производительности. С другой стороны, в играх он оказывается даже менее экономичным, нежели более быстрый Radeon HD 5850, что является следствием повышенной частоты графического ядра — 800 против 725 МГц.

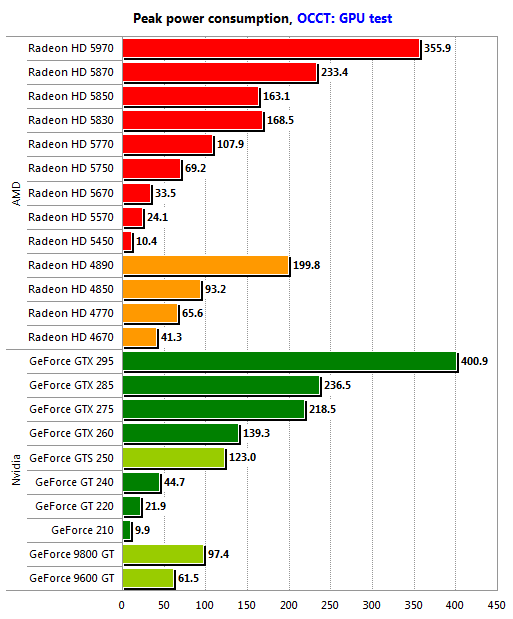

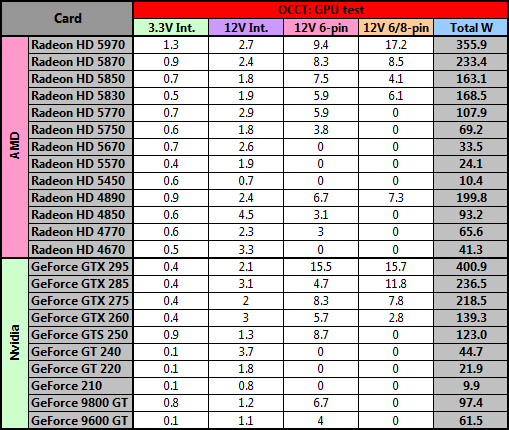

Данные, приведённые в этом разделе, представляют главным образом теоретический интерес. Мы не рекомендуем никому повторять наших опытов с OCCT: GPU, поскольку известны случаи не только срабатывания защиты блока питания, но и выхода из строя графических карт, система питания которых не выдерживала нагрузки, создаваемой этим синтетическим тестом. В общем-то, ничего нового полученные в OCCT: GPU результаты не говорят — наиболее экономичным на сегодняшний день по-прежнему является семейство ATI Radeon HD 5000, хотя разница между Radeon HD 5870 и GeForce GTX 285 сокращается здесь до минимума.

В целом, ситуация ясна: на сегодняшний день лучшим выбором для тех, кому важна экономичность системы, является один из представителей семейства Radeon HD 5000, за исключением двухпроцессорного Radeon HD 5970. Оптимальной, на наш взгляд, моделью, сочетающей приемлемый уровень энергопотребления с высокой производительностью в 3D, является Radeon HD 5850. Альтернативой ему является Nvidia GeForce GTX 275, которая в играх потребляет существенно больше, но в некоторых случаях именно эта карта может оказаться более предпочтительным выбором — в частности, при использовании приложений, серьёзно зависящих от качества реализации ускорения 2D, или же если пользователь планирует использовать CUDA. Среди моделей, не рассчитанных на игровое применение, хорошо смотрятся Radeon HD 5670 и 5570 — их, пожалуй, можно назвать лучшим выбором для мультимедийной платформы, рассчитанной на работу с видео и звуковыми форматами высокого разрешения. Помимо прочего, такая платформа получится весьма экономичной.

Зависимость уровня энергопотребления от разгона

Дополнительно было решено провести небольшое исследование, целью которого было поставлено выяснить, насколько сильно на уровне энергопотребления типового современного графического адаптера может отразиться разгон. В качестве наиболее типичных представителей сегодняшнего дня были избраны ATI Radeon HD 5850 и Nvidia GeForce GTX 275: карты, сочетающие высокую производительность с относительно разумной стоимостью, а потому весьма популярные среди покупателей.

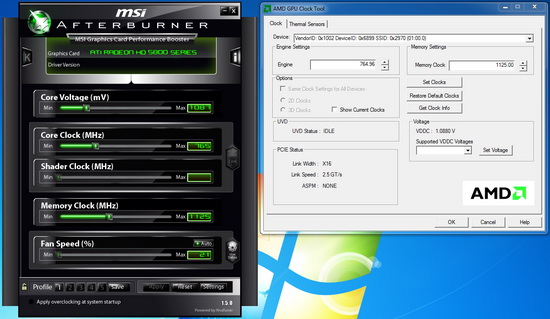

Поскольку старшие модели семейства Radeon HD 5800 оснащены контроллерами Volterra, они допускают программное управление напряжением питания GPU, так что для разгона мы воспользовались сочетанием утилит MSI Afterburner и AMD GPU Clock Tool.

Изначальное значение напряжения питания GPU для Radeon HD 5850 составляет 1,088 В, и его было решено поднимать только в том случае, если на заданных частотах карта потеряет стабильность. Во избежание перегрева и выхода карты из строя, система охлаждения Radeon HD 5850 была запущена на полную мощность.

C Nvidia GeForce GTX 275 всё оказалось сложнее. Эталонный дизайн этих карт использует контроллер VRM, не поддерживающий программного управления, поэтому, помимо аппаратного «вольтмода», способ поднятия напряжения питания на ядре GPU существует только один: модификация BIOS с помощью NiBiTor или любой другой программы, обладающей аналогичными возможностями, с последующей прошивкой этого BIOS в карту. По умолчанию, графический процессор GeForce GTX 275 работает при напряжении питания 1,05 В для режима 3D и 1,17 В для экстремального режима. С помощью NiBiTor оба значения можно увеличить до 1,18 В, но, к сожалению, не выше.

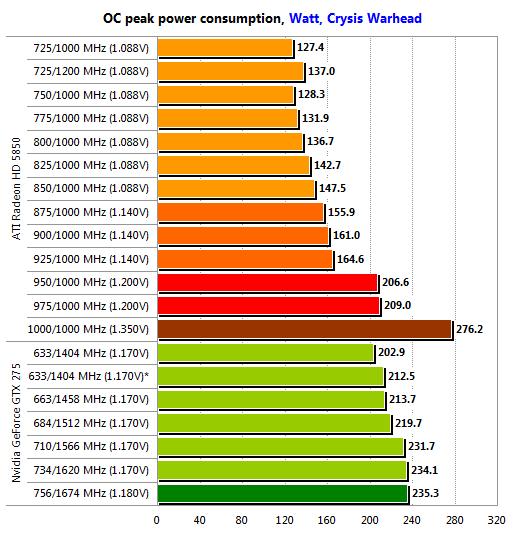

Поскольку наибольший интерес представляет именно поведение карты в играх, в качестве нагрузки мы выбрали всё тот же Crysis Warhead, запускаемый с настройками DirectX10/Enthusiast на карте «frost» в разрешении 1600х1200 с задействованным MSAA 4x. В результате, удалось получить следующие данные:

Во-первых, видно, что разгон памяти если и влияет на энергопотребление, то не слишком серьёзно: подняв частоту памяти Radeon HD 5850 c 1000 (4000) до максимально возможных без потери стабильности 1200 (4800) МГц, мы обнаружили, что уровень энергопотребления возрос примерно на 10 Вт. Аналогичная процедура, проделанная с GeForce GTX 275, память которого была разогнана с номинальных 1134 (2268) до 1250 (2500) МГц, показала те же 10 Вт прироста.

Дальнейший разгон Radeon HD 5850 с шагом 25 МГц по ядру успешно продолжался до частоты 875 МГц, при которой карта потеряла стабильность. В диапазоне 725—850 МГц прирост уровня потребления составил лишь около 20 Вт. Подняв напряжение питания ядра до 1,14 В, нам удалось покорить планку 925 МГц. Карта мгновенно стала заметно более прожорливой, но самое серьёзное испытание ожидало впереди: 950 МГц удалось покорить лишь при напряжении питания 1,2 В, что привело к мгновенному скачку уровня потребления со 165 до более чем 200 Вт. Вершина 1000 МГц долго оставалась непокорённой, пока мы не решили рискнуть и не подняли напряжение до весьма опасных 1,35 В. В результате планка была взята, карта успешно прошла тест, но пиковый уровень энергопотребления при этом возрос до 276 Вт! Вероятно, при водяном охлаждении карта способна проработать в таком режиме довольно длительное время, но перегрев не является единственным опасным фактором, возникающем при разгоне с применением средств повышения напряжения питания GPU — при напряжении питания, более чем на 30 % превышающем то, на которое процессор изначально рассчитан, чип может выйти из строя из-за электрического пробоя. Кроме того, перегружается и сама система питания графического адаптера, которая также не рассчитана на подобные нагрузки.

С GeForce GTX 275 всё оказалось куда спокойнее — сказалось отсутствие возможности сделать экстремальный вольтмод «из коробки». В результате карта заработала стабильно на частотах 734/1620 МГц без модификации BIOS и на частотах 756/1674 с оной. Похоже, это предел для имеющегося в нашем распоряжении экземпляра GeForce GTX 275 — все попытки поднять частоты GPU хотя бы ещё чуть-чуть не привели к успеху и каждый раз при запуске Crysis Warhead и начале тестового прохода происходил сброс и перезагрузка драйвера. Дельта уровня энергопотребления между минимальными и максимально достигнутыми частотами ядра составила всего 32,4 Вт — ничто на фоне 148,8 Вт у ATI Radeon HD 5850. Но и риска в случае с разгоном карты Nvidia также значительно меньше, если, конечно, не прибегать к аппаратной модификации цепей питания GPU.

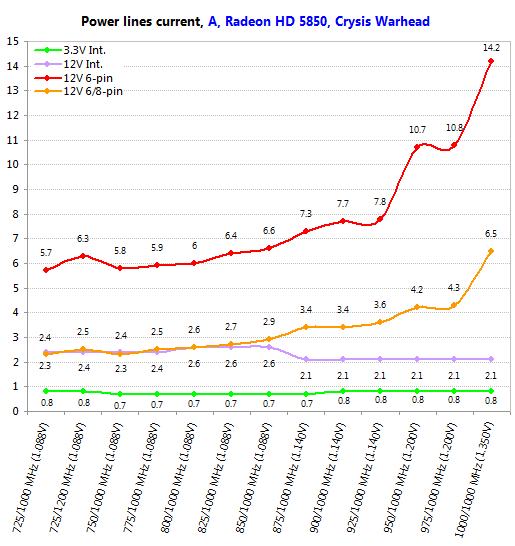

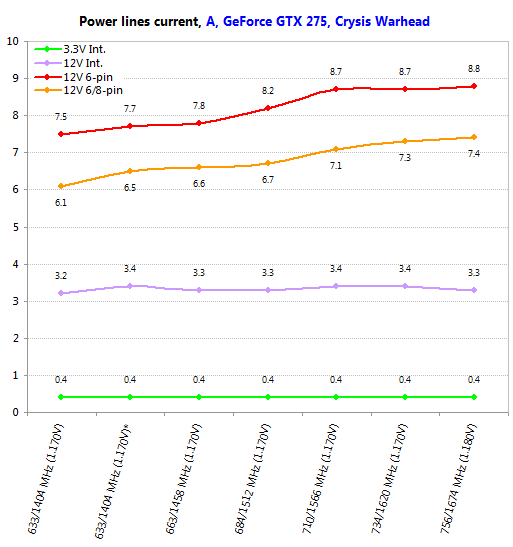

Раскладка по цепям питания даёт любопытную картину:

Линия +3.3 В, питающая, судя по всему, вспомогательные цепи видеоадаптера, практически не зависит от тактовых частот. Внутренняя линия +12 В от них зависит, но несколько странным образом — ток по ней медленно возрастал по мере разгона, но как только мы применили первый вольтмод, упал с максимально зафиксированных 2,6 А до 2,1 А, и оставался на этом уровне до завершения эксперимента. Линия, обозначенная на графике, как «12V 6/8-pin» была подключена к первому, верхнему разъёму питания Radeon HD 5850. На всём протяжении разгона она ведёт себя довольно спокойно — ток медленно растёт с 2,3 до 4,3 А, и лишь подъём напряжения питания GPU до экстремального значения 1,35 В приводит к резкому скачку до 6,5 А. Куда более агрессивно растёт нагрузка на нижний разъём питания — хотя при напряжениях питания GPU до 1,14 В график сравнительно пологий, уже при 1,2 В наблюдается резкий всплеск, а при 1,35 В ток, протекающий по этой линии, легко может достигать 14 и более ампер, а это около 170 Вт! Повторяем, не увлекайтесь такими экспериментами дома, особенно если ваш любимый видеоадаптер — единственный, и заменить его в случае скоропостижной кончины нечем.

Как уже было сказано, Nvidia GeForce GTX 275 при разгоне ведёт себя спокойнее — и вышеприведённый график это подтверждает. Токи по внутренним линиям питания практически не меняются, а по внешним — медленно растут, причём, второй, ближний к краю платы разъём питания нагружается заметно сильнее. Но таких экстремальных цифр, как в случае с Radeon HD 5850, нам не удалось получить и на нём — максимальный зафиксированный ток по этой линии составил лишь 8,8 А, то есть, нагрузка на разъём не превысила 106 Вт.

Заключение

Итак, мы протестировали 23 современных и не очень современных графических адаптера на предмет выяснения их уровня энергопотребления в различных режимах. Как и ожидалось, во всех категориях наилучшие результаты показали представители семейства Radeon HD 5000. Ничего удивительного — они используют наиболее совершенные на сегодняшний день графические процессоры потребительского класса. Младшим моделям на пятки наступают новые 40-нм решения Nvidia в лице GeForce GT 240, 220 и 210, но положение линейки в верхнем ценовом диапазоне может спасти только новая серия видеокарт, обзор старшей модели которой, GeForce GTX 480, мы опубликуем в ближайшее время. С учётом того, что сама эта линейка обещает быть весьма прожорливой, а также что модели на базе ядра G200b с её выпуском частично перекочуют в линейку GeForce 300, Nvidia ещё долго предстоит быть в аутсайдерах с точки зрения экономичности её продуктов.

С точки зрения потребителя наиболее сбалансированным решением смотрится, пожалуй, Radeon HD 5850: он и весьма экономичен в режиме 2D, и обладает высокой производительностью в играх, потребляя при этом чуть больше 120 Вт. Единственным его недостатком является цена: не каждый способен выложить более десяти тысяч рублей только за видеокарту. Вторым фаворитом является Radeon HD 5570, явно не предназначенный для игр, зато идеальный для тихой и экономичной платформы HTPC, ведь в основном для этих платформ режиме, проигрывании видео высокого разрешения, он потребляет лишь порядка 13 Вт. Да, в теории ему может составить конкуренцию GeForce GT 220, но он лишён полноценной поддержки звуковых форматов высокого разрешения. Общее положительное впечатление от семейства Radeon HD 5000 несколько портит Radeon HD 5830, который практически во всех режимах потребляет чуть больше, нежели Radeon HD 5850, а в играх по производительности может уступать даже карте предыдущего поколения, Radeon HD 4890.

Что касается решений Nvidia, то если по какой-то причине вам непременно нужно одно из них, можно обратить внимание на GeForce GTX 275, поскольку старший его собрат, GTX 285, стоит существенно дороже, а младший обеспечивает не столь высокую производительность в трёхмерных приложениях. Другое дело, что об экономичности в этом случае придётся забыть, как, впрочем, и о полноценной поддержке HD-видео. Впрочем, речь идёт лишь о невозможности полного аппаратного декодирования VC-1, что на практике, при достаточно мощном центральном процессоре, проблемой не станет. Если в сферу интересов игрока входят игры с поддержкой эффектов PhysX, то неплохим дополнением к GeForce GTX 275 может стать GeForce GT 220, используемый в качестве дискретного PPU. Говорить о линейке видеокарт GeForce GTX 400 здесь пока совсем рано: их цены, по крайней мере первое время, обещают быть весьма высокими, что отпугнёт большинство покупателей, да и, забегая вперёд, скажем, что экономичность их также оставляет желать лучшего.

Относительно выбора блока питания со всей очевидностью можно сказать следующее: действительно мощные модели могут по-настоящему потребоваться лишь тем, кто планирует оснастить свою игровую платформу решениями класса Radeon HD 5970, GeForce GTX 295, а в недалёком будущем — и GeForce GTX 400. В режиме максимальной нагрузки ток на некоторые линии питания этих видеокарт может достигать 17 А, что весьма серьёзно, поэтому к выбору БП в этом случае следует подойти максимально ответственно. Менее монструозные решения, вроде Radeon HD 5870, существенно скромнее в своих энергетических аппетитах, и им вполне хватит любого качественного блока питания мощностью 600—650 Вт, даже если в вашей системе стоит мощный процессор и полдюжины винчестеров. Это вполне согласуется с полученными ранее данными по общему уровню энергопотребления, которые показывают, что даже серьёзная игровая платформа легко укладывается в 500 Вт. Игровые системы среднего класса, оснащённые картами типа Radeon HD 5770, и вовсе без проблем обойдутся блоком питания мощностью 400 Вт, главное, чтобы сам блок был надёжным — качество не вредит никому, и рисковать всей системой, приобретая дешёвый блок питания, явно не стоит.

Эксперимент с разгоном показал, что серьёзно уровень энергопотребления растёт лишь при повышении напряжения питания графического ядра, что само по себе является небезопасным предприятием. Если же не прибегать к экстремальным мерам, то дельта между стартовыми частотами и максимальным разгоном без поднятия напряжения питания GPU составила всего 20 Вт для Radeon HD 5850 и 31 Вт для GeForce GTX 275. Необходимо отметить, что в первом случае при разгоне может отключиться часть энергосберегающих функций, в частности, карта не будет понижать частоты GPU и памяти в режиме 2D или при просмотре видео. Кроме того, повторимся, разгон редко приводит к действительно весомым результатам — чаще всего, там, где производительность была достаточной, она таковой и остаётся, и наоборот. Иными словами, разгон видеокарты — во многом вид спорта, местами не лишённый азарта и зрелищности, но практической пользы от него крайне немного, особенно от экстремальных вариантов, неизбежно сопряжённых с риском преждевременной «смерти» разгоняемых компонентов.

Другие материалы по данной теме

Энергопотребление разогнанных процессоров

Энергопотребление компьютеров: так сколько нужно ватт?