Ваш город: Москва

Nvidia GeForce GTX 580: рождённый быть первым

Введение

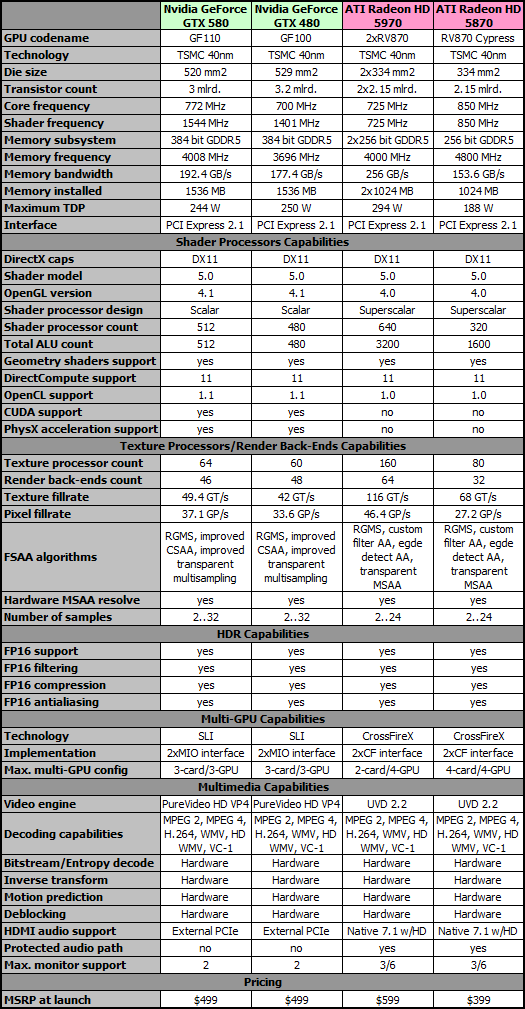

Путь новой графической архитектуры Nvidia Fermi на рынок игровых решений был долог и тернист. Первенец, предназначенный стать лидером среди одиночных видеоадаптеров, рождался буквально в муках — не учтя горького опыта с G200, компания вновь решила сделать ставку на «самый мощный в мире графический процессор», в результате чего количество транзисторов, составляющих новый чип, зашкалило за 3 миллиарда. Разумеется, даже с использованием 40-нм техпроцесса GF100 выходил огромным, сложным, неэкономичным и очень горячим. Изначально он должен был нести на кристалле 512 унифицированных поточных процессоров, 64 текстурных блока, 48 блоков растровых операций и общаться с локальным банком видеопамяти GDDR5 по широкой 384-битной шине. Но если с памятью и подсистемой RBE особых проблем не возникло, то добиться приемлемого выхода годных кристаллов при заданной сложности и имеющемся техпроцессе Nvidia так и не удалось, в результате чего флагманская модель нового семейства впервые увидела свет, будучи усечённой в конфигурации до 480 поточных процессоров и 60 текстурных блоков. Более того, хотя официальный анонс нового семейства состоялся 26 марта 2010 года, появляться на рынке новинки начали лишь месяц спустя, да и то в ограниченных количествах.

Производительность в современных игровых тестах новый GeForce GTX 480 показал неплохую, но, увы, для своего класса не выдающуюся: свою роль сыграла усечённая конфигурация и сравнительно невысокие тактовые частоты. В итоге, новинка не смогла потеснить с трона Radeon HD 5970, чему в немалой мере поспособствовала несбалансированность подсистемы текстурных процессоров: их было всего 60, рабочая частота была невысока даже на фоне G200, и они не умели выполнять полноскоростную обработку текстур формата FP16, довольно широко применяющихся в современных играх. Описываемое узкое место GeForce GTX 480 отметили все обозреватели. Понятное дело, что на руку Nvidia такое положение вещей отнюдь не сыграло и его надо было исправлять, чем компания и занялась. Впервые о грядущем наследнике GeForce GTX 480 стало известно в октябре.

Задолго до официального анонса преемника GF100 в сети стали появляться слухи о том, что новое флагманское ядро Nvidia получит не только 512 поточных процессоров, но и 128 блоков текстурных операций, что избавит архитектуру Fermi от главного узкого места и сделает её достойным оружием в грядущей битве с AMD Radeon HD 6900. Как уже было неоднократно отмечено нами в прошлом, сама по себе победа в такой битве не является определяющей — линкоры войну не выигрывают, а дорогие графические карты не делают основного объёма продаж. Наиболее масштабное сражение ведётся в секторе доступных карт стоимостью до 200 долларов, и они-то и являются «основными боевыми танками» AMD и Nvidia. Тем не менее, поединки супертяжеловесов несут в себе не менее важное значение — они свидетельствуют о способности компании к разработке и выпуску продвинутых решений, то есть, по сути, сообщают миру и покупателям о её технологическом лидерстве. Кроме того, такие поединки намного зрелищнее сражения в секторе бюджетных карт; как игроки, так и пресса уделяет им куда больше внимания, что, опять-таки, способствует росту популярности продукции победившей компании.

В итоге, на текущий момент, Nvidia успела нанести графическому подразделению Advanced Micro Devices упреждающий удар, выпустив GeForce GTX 580 до анонса нового семейства AMD Radeon HD 6900. Новый видеоадаптер высшего класса должен показать, что Nvidia не потеряла способности к созданию сверхмощных графических карт, могущих претендовать на абсолютное лидерство. В настоящем обзоре мы выясним, чего на самом деле следует ожидать от нового претендента в короли игровой трёхмерной графики.

Nvidia GeForce GTX 580: место в строю

Как уже было сказано, GeForce GTX 580 должен стать новым «линкором» Nvidia, флагманом всей линейки Fermi, доказательством технологического лидерства компании в области создания высокопроизводительных игровых графических карт, и, наконец, главным козырем в борьбе с грядущим AMD Radeon HD 6900. Для начала, рассмотрим, насколько улучшились тактико-технические характеристики новинки в сравнении с GeForce GTX 480.

Первое же, что бросается в глаза, это подросшие тактовые частоты — как ядра, так и памяти, что при прочих равных уже могло бы дать заметный прирост производительности. Уменьшение площади кристалла на 9 квадратных миллиметров не удивляет; это вполне нормальное явление с учётом оптимизаций, сделанных проектировщиками в процессе создания наследника GF100. А вот потеря целых 200 миллионов транзисторов, на первый взгляд, выглядит странно, ведь назвать это «иголкой в стоге сена» нельзя — эти 200 миллионов даже в теории должны составлять весьма солидную часть ядра. Однако, это не сенсация и, тем более, не повод для паники. Хотя все официальные источники рапортуют о 3,2 миллиарда транзисторов у GF100 и об «около 3 миллиардов» у GF110, и эти же значения показывают популярные диагностические утилиты, вроде GPU-Z, на самом деле, никто, кроме самих разработчиков, не может знать точных чисел, а программы всего лишь выводят заложенные в их базы данных официальные значения. Узнать точное количество транзисторов физически невозможно. Вполне вероятно, что GF110 действительно похудел в результате проделанных оптимизаций, но на деле это может вылиться в разницу типа «3,09 миллиарда транзисторов против 3,15 миллиарда у предшественника», что, конечно, гораздо реалистичнее потери 200 миллионов транзисторов разом при одинаковой архитектуре и количестве функциональных блоков GPU.

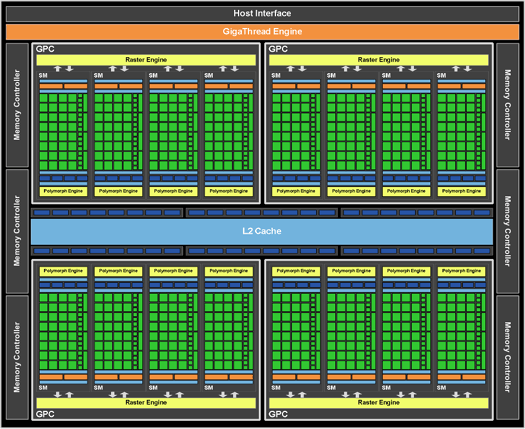

Далее, мы видим 512 активных ALU, то есть, столько же, сколько было в составе GF100 физически, но, как известно всем, часть блоков так никогда и не была активирована — это произошло только в GF110. Сама по себе, организация нового ядра не изменилась:

Каждый из четырёх кластеров графической обработки (GPC) включает в себя по четыре поточных мультипроцессора (SM), и, в свою очередь, каждый из этих мультипроцессоров состоит из 32 вычислительных ядер общего назначения. Кроме того, каждому мультипроцессору придано по четыре текстурных модуля. Изначально, как было отмечено выше, в Сети циркулировали многочисленные слухи о том, что Nvidia, располагая данными о несбалансированности текстурной подсистемы GF100, увеличит количество текстурных процессоров в составе GF110 до 128 штук, однако, эти слухи не подтвердились — текстурных модулей в новом ядре по-прежнему 64. Однако, и это не повод для беспокойства: разработчики GF110 проделали неплохую работу над ошибками и доработали архитектуру текстурных процессоров таким образом, чтобы они могли выполнять фильтрацию всех форматов текстур на полной скорости, в то время, как GF100 выполнял фильтрацию текстур формата FP16 на половинной скорости. Это напоминает ситуацию с текстурными процессорами G80 и G92: в первом случае на один блок выборки приходилось два блока фильтрации, а во втором — количество и тех, и других блоков было одинаковым, что давало G80 преимущество при выполнении анизотропной фильтрации. Вероятно, в случае с GF100 и GF110 всё несколько сложнее, но подробности конструкции текстурных процессоров Fermi нам неизвестны, а заниматься спекуляциями — занятие неблагодарное. Так или иначе, если GF110 умеет выполнять полноскоростную обработку всех форматов текстур, это уже даёт ему весомое преимущество перед предшественником в современных играх, где формат FP16 используется достаточно широко. Помимо доработки текстурных процессоров, Nvidia улучшила и алгоритмы отсечения невидимых поверхностей. Всё это вкупе с наличием 512 активных ALU, должно гарантированно обеспечить GeForce GTX 580 первое место в секторе наиболее мощных однопроцессорных графических карт, а может быть, даже и попытаться сместить с трона явно засидевшийся там двухпроцессорный ATI Radeon HD 5970.

Что касается тесселяции, то в этой области проблем не было и у GF100, и даже у GF104. По понятным причинам, GF110 будет несколько быстрее, ведь у него активны все 16 блоков обработки геометрии под фирменным названием PolyMorph Engine, против 15 у предшественника; к тому же, они работают на более высокой частоте. Сможет ли Advanced Micro Devices адекватно ответить на столь внушительную мощь, покажет лишь выпуск Radeon HD 6900, а пока первенство Nvidia в данной области неоспоримо. Хотя о ненужности и даже вреде избыточной тесселяции в настоящее время и ведутся активные споры, но лучше иметь возможность справляться и с такими сценами, как в H.A.W.X. 2, содержащими до 1,5 миллиона полигонов в кадре, нежели такой возможности не иметь. На фоне справляющегося с такой задачей решения все словесные аргументы «против» выглядят бледновато. С другой стороны, рекламные заявления Nvidia о двенадцатикратном превосходстве в скорости выполнения тесселяции тоже не следует принимать на веру слепо, без практической проверки, а игр, использующих эту возможность, на рынке пока не так уж и много.

Так или иначе, Nvidia GeForce GTX 580 выглядит хорошо сбалансированным решением высшего класса, а его рекомендованная стоимость равна стоимости GeForce GTX 480 на момент анонса, и составляет 499 долларов. Это делает новинку существенно более привлекательной, нежели Radeon HD 5970, который до сих пор невозможно найти в продаже по цене ниже 20 тысяч рублей.

Nvidia GeForce GTX 580: дизайн печатной платы

Внешне все современные производительные видеоадаптеры выглядят одинаково, или, во всяком случае, очень похоже. Не является исключением и новый Nvidia GeForce GTX 580, выглядящий абсолютно стандартно:

Однако, небольшие отличия от предыдущего флагмана есть: во-первых, у GeForce GTX 580 отсутствует прорезь в кожухе системы охлаждения, сквозь которую у GeForce GTX 480 проглядывала очень сильно нагревающаяся в процессе работы металлическая крышка радиатора, а, во-вторых, за габариты кожуха не выступают тепловые трубки, поскольку новинка использует иную конструкцию системы охлаждения. Нет дополнительной прорези под вентилятором и в печатной плате. Похоже, Nvidia возлагает на новую компоновку системы охлаждения самые радужные надежды, однако при установке двух GeForce GTX 580 в тандем SLI вентилятор верхней карты явно начнет испытывать проблемы с забором воздуха, будучи практически полностью блокированным нижней платой. Вряд ли спасёт ситуацию даже хвалёный дизайн кожуха, «оптимизированный для SLI», поскольку вся оптимизация заключается в наличии небольшого уступа в районе расположения вентилятора.

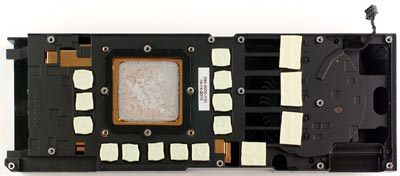

Как обычно, самое интересное скрывается под системой охлаждения, которую в процессе изучения GeForce GTX 580 нам пришлось демонтировать:

В дизайне печатных плат GeForce GTX 580 и GeForce GTX 480 имеется довольно большое сходство: при создании новой платы разработчики скопировали некоторые элементы старой целиком. Это логичный ход, поскольку при такой сложности разработка печатной платы с нуля привела бы к большим затратам времени и ресурсов. Однако, пустующая хвостовая часть платы, где ранее были дополнительные воздухозаборные прорези, говорит о том, что GeForce GTX 580 можно было бы сделать и короче. Правда, особой нужды в этом нет: верхнее расположение разъёмов питания исключает проблему с подключением кабелей в корпусе с укороченной базой, а в самые компактные корпуса видеоадаптеры такого класса вообще никем не устанавливаются.

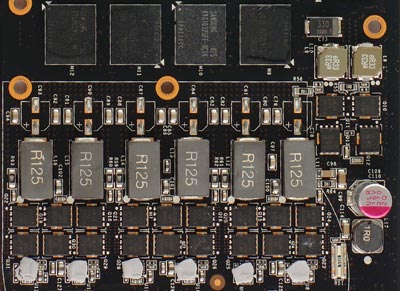

Внешне подсистема питания GeForce GTX 580 не претерпела никаких изменений. Она всё так же выполнена по схеме «6+2», в которой мощный шестифазный стабилизатор питания графического ядра управляется контроллером CHL8266 производства CHiL Semiconductor, расположенным на обратной стороне платы.

Ниже на плате имеется посадочное место под чип схожих габаритов, однако его назначение неизвестно. Nvidia сообщает о наличии на борту GeForce GTX 580 продвинутой системы мониторинга подсистемы питания, однако на слайдах указывает другое место, в котором можно разглядеть лишь два крошечных чипа, маркированных как A219.

В подсистеме питания памяти есть отличие: вместо хорошо известного нашим читателям контроллера uP6210, за управление соответствующим стабилизатором отвечает микросхема APW7088 производства Anpec Electronics; найти на неё документацию не так-то просто — на официальном веб-сайте компании она отсутствует, но всё же поиск в Google приносит свои плоды. Питание к плате подключается посредством двух разъёмов: шести- и восьмиконтактного. Даже с учётом заявленного улучшения экономичности, наличие последнего не выглядит лишним.

Микросхемы памяти используются те же, что и в GeForce GTX 480, а именно Samsung K4G10325FE-HC04. Эти чипы GDDR5 ёмкостью 1 Гбит (32Мх32) способны работать на частоте 1250 (5000) МГц. Как и в случае с предшественницей, использование столь быстрых микросхем является стрельбой из пушки по воробьям, хотя частота работы памяти в GeForce GTX 580 и выросла до 1002 (4008) МГц. Всего на плате установлено 12 чипов памяти, что при их параметрах даёт банк локальной видеопамяти объёмом 1536 МБ, связанный с графическим ядром 384-битной шиной доступа. На указанной частоте его пиковая пропускная способность составляет весьма внушительные для однопроцессорной графической карты 192.4 ГБ/сек. Лишь двухпроцессорный Radeon HD 5970 демонстрирует больше, и только за счёт наличия двух раздельных банков видеопамяти с 256-битным доступом. В энергосберегающих режимах частота памяти может понижаться до 162 (648) МГц или до 68 (270) МГц. Популярная утилита MSI Afterburner при этом рапортует о 2004, 324 и 135 МГц, соответственно.

Графический процессор имеет ревизию А1, в его маркировке присутствует тот же «частотный код», что и у GF100 — 375. По всей видимости, этим числом маркируются экземпляры GPU Nvidia, прошедшие наиболее строгий частотный отбор. Габаритами GF110 не отличается от GF100, и, по всей видимости, процессоры поконтактно совместимы. Данный экземпляр сошёл с конвейера производителя на 38 неделе 2010 года, то есть, в промежутке между 19 и 27 сентября. С учётом небольшого номера ревизии ясно, что сколько-нибудь серьёзных проблем при создании GF110 удалось благополучно избежать.

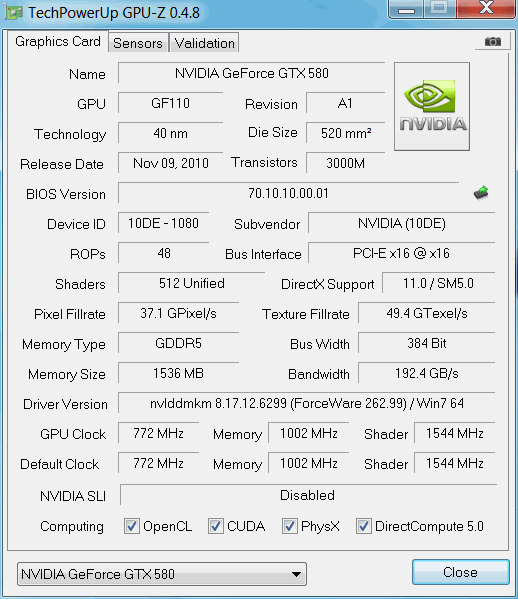

Утилита GPU-Z в версии 0.4.8 умеет работать с GF110, однако, как уже было сказано, не всем выводимым ей на экран данным следует доверять безоговорочно, поскольку такие параметры, как площадь кристалла и количество транзисторов она попросту берёт из встроенной базы данных, а на деле эти значения могут довольно существенно отличаться от указанных. В остальном, параметры ядра определились верно: частота основного домена действительно составляет 772 МГц, а шейдерный блок работает на удвоенной частоте, составляющей 1544 МГц. Количество ALU и процессоров растровых операций соответствует официальным спецификациям: 512 и 48, соответственно. Что касается количества текстурных процессоров, то информацию об их количестве GPU-Z не выводит, но значения texture и pixel fillrate указаны верно и соответствуют официальным спецификациям Nvidia. На деле, повторимся, в составе GF110 работает 64 текстурных процессора, способных обрабатывать текстуры любого распространённого формата на полной скорости, в то время, как в GF100 обработка формата FP16 выполнялась на половинной скорости.

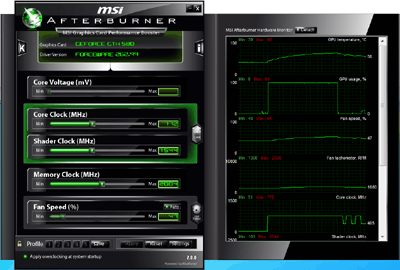

Что касается MSI Afterburner, то основные частоты утилита определяет верно, но для памяти выводит 1/2 от эффективного значения частоты GDDR5, а не обычную 1/4. Управление напряжением питания GPU в версии 2.0.0 не поддерживается, а вот функции мониторинга работают вполне корректно. С их помощью можно видеть, как частота ядра снижается в режиме простоя до 51/101 МГц, а в несложных задачах, вроде декодирования видео высокого разрешения поднимается до 405/810 МГц. Лишь при запуске 3D-приложения ядро запускается на полную мощность.

Крепёжная планка GeForce GTX 580 не претерпела никаких изменений: её первый этаж всё так же занимает пара портов DVI-I вкупе с портом mini-HDMI, требующим использования переходника для подключения стандартного кабеля HDMI. Весь второй этаж планки отдан под вентиляционные прорези, сквозь которые система охлаждения избавляется от нагретого воздуха. Поддержки Display Port не предусмотрено. Поддержка более чем двух мониторов требует подключения второй карты в режиме SLI, для чего на верхней стороне платы имеется пара стандартных «гребёнок» интерфейса MIO. В целом, это обычный набор для решений Nvidia, который на фоне богатства коммутационных возможностей, предоставляемых картами ATI Radeon, выглядит несколько бледновато.

Nvidia GeForce GTX 580: конструкция системы охлаждения

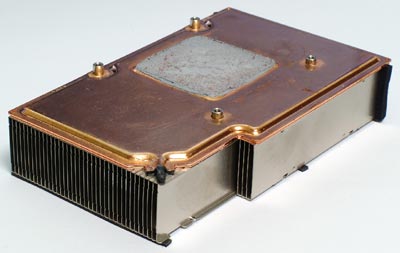

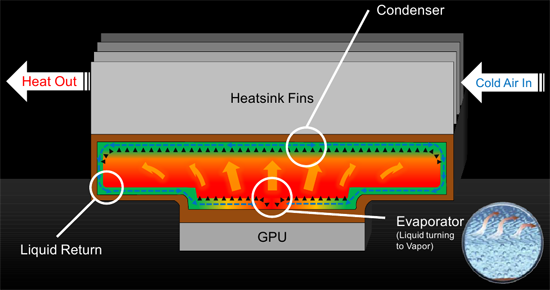

Что касается системы охлаждения, то её конструкция, в отличие от дизайна печатной платы, была переработана кардинально. Как уже упоминалось, из кожуха не торчит никаких тепловых трубок, что с учётом сопоставимого с GeForce GTX 480 уровня тепловыделения, поначалу выглядит странно. Однако, разгадка проста. Даже без снятия кожуха и демонтажа радиатора очевидно, что в новой конструкции Nvidia перешла на использование вакуумной испарительной камеры:

Компания не является пионером в этой области, поскольку ATI использовала испарительную камеру ещё в системе охлаждения Radeon HD 4870 X2, где ей был оснащён один из двух радиаторов. Впоследствии, испарительная камера больших размеров была использована в конструкции системы охлаждения Radeon HD 5970, где она обслуживала сразу два ядра RV870. В использовании испарительных камер была замечена и компания Sapphire с её серией графически карт Vapor-X.

Аналогичным образом устроен и радиатор GeForce GTX 580:

Он, конечно, меньше радиатора Radeon HD 5970, однако, всё же достаточно велик, чтобы эффективно охлаждать столь горячий чип, как GF110. На вышеприведённом снимке хорошо видна испарительная камера, являющаяся основанием радиатора, набранного из тонких алюминиевых пластин. В правом нижнем углу можно видеть запаянное отверстие, через которое на этапе изготовления осуществлялась заливка камеры жидкостью-теплоносителем и откачка из рабочей полости воздуха.

Принцип работы испарительной камеры предельно прост. По сути, она представляет собой одну большую плоскую тепловую трубку. Теплоноситель испаряется в месте контакта подошвы камеры с крышкой графического процессора, конденсируется в верхней части камеры, передавая тепло рёбрам радиатора, а затем, стекает вниз по специальным капиллярным поверхностям, после чего, процесс повторяется. За счёт вакуумирования рабочей полости температура кипения хладагента существенно понижается, а благодаря минимальному расстоянию между поверхностями теплосбора и теплосброса, процесс теплопередачи протекает максимально быстро. Кроме того, важным преимуществом испарительной камеры является её компактность, ведь в этом случае нет нужды разводить довольно громоздкий пучок толстых тепловых трубок, как это было сделано в конструкции системы охлаждения GeForce GTX 480.

К недостаткам данной компоновки можно причислить разве что менее эффективный прогрев верхней части ребёр радиатора, поскольку к ним ничто не подводит тепловой поток непосредственно, однако, это с лихвой может компенсироваться более высокой эффективностью работы самой камеры, что, впрочем, нуждается в практической проверке.

Уровень энергопотребления, тепловой режим, шумность и разгон

В рекламных материалах Nvidia заявляет о возросшей энергоэффективности GeForce GTX 580 по сравнению с предшествующим ему флагманским решением, и даже указывает меньший уровень TDP. Разумеется, мы не могли пройти мимо и не проверить, насколько эти заявления соответствуют истинному положению вещей. Попавший к нам в руки экземпляр карты разделил участь всех своих предшественников и был подвергнут испытаниям на специально предназначенном для этого стенде со следующей конфигурацией:

Процессор Intel Core 2 Quad Q6600 (3 ГГц, 1333 МГц FSB x 9, LGA775)

Системная плата DFI LANParty UT ICFX3200-T2R/G (ATI CrossFire Xpress 3200)

Память PC2-1066 (2x2 ГБ, 1066 МГц)

Блок питания Enermax Liberty ELT620AWT (мощность 620 Вт)

Microsoft Windows 7 Ultimate 64-bit

CyberLink PowerDVD 9 Ultra/«Serenity» BD (1080p VC-1, 20 Мбит/с)

Crysis Warhead

OCCT Perestroika 3.1.0

Данная платформа оснащена специальным измерительным модулем, описанным в обзоре «Энергопотребление компьютеров: так сколько нужно ватт?». Его использование позволяет получить наиболее полные данные об электрических характеристиках современных графических карт в различных режимах. Как обычно, для создания нагрузки на видеоадаптер в различных режимах были использованы следующие тесты:

CyberLink PowerDVD 9: FullScreen, аппаратное ускорение включено

Crysis Warhead: 1600x1200, FSAA 4x, DirectX 10/Enthusiast, карта «frost»

OCCT Perestroika GPU: 1600x1200, FullScreen, Shader Complexity 8

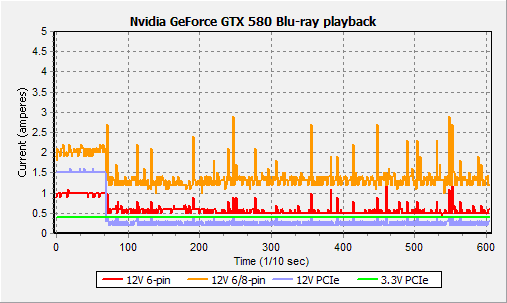

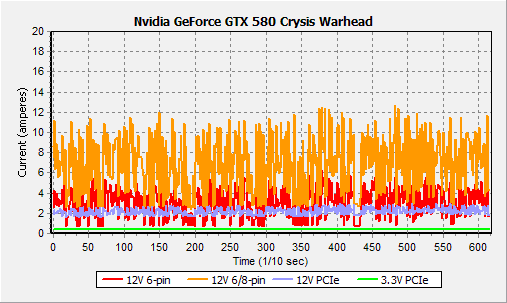

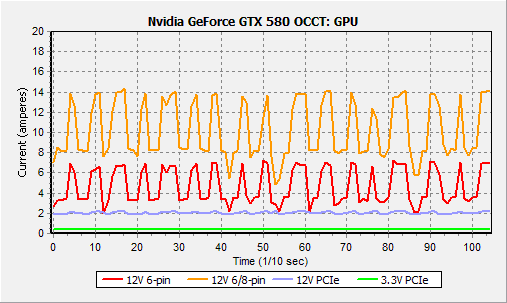

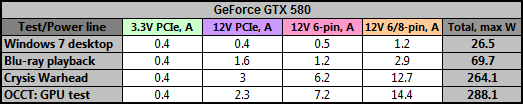

Для каждого режима, за исключением симуляции предельной нагрузки в OCCT, замеры проводились в течение 60 секунд; во избежание выхода карты из строя вследствие перегрузки цепей питания, для теста OCCT: GPU время тестирования было ограничено 10 секундами. В результате проделанных измерений были получены следующие результаты:

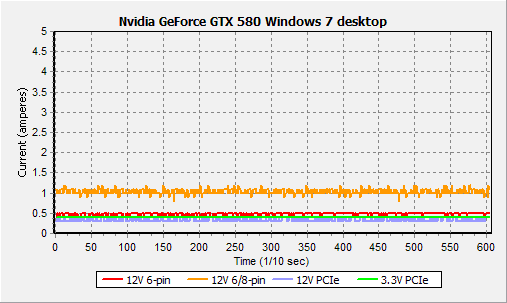

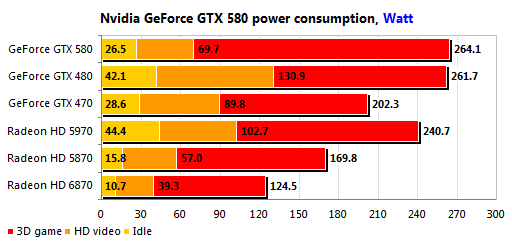

Нет, пиковый уровень энергопотребления GeForce GTX 580 в режиме 3D не снизился, да и трудно было этого ожидать с учётом большего количества активных блоков, работающих на более высоких тактовых частотах. Однако, сам факт того, что этот показатель удалось удержать в рамках GeForce GTX 480 уже является чудом, достойным упоминания. Относительно нагрузки на различные линии питания можно лишь сказать, что восьмиконтактный разъём на плате присутствует не зря: под нагрузкой через него может протекать ток до 13—15 А, что в пересчёте на мощность выходит за рамки максимально рекомендованных для данного разъема 150 Вт. Также заслуживает упоминание поведение карты в тесте OCCT: GPU. График энергопотребления наглядно демонстрирует работу заявленной Nvidia системы защиты GeForce GTX 580 от перегрузки в стресс-тестах типа OCCT или FurMark, создающих не встречающуюся в реальных условиях нагрузку, способную необратимо повредить карту. Тактовые частоты при этом не меняются; по всей видимости, работает некий аналог технологии Thermal Throttling, заставляющий GPU пропускать такты. В пользу этого предположения говорит и дёрганое, неравномерное вращение пресловутого «мохнатого бублика» при запуске OCCT: GPU на GeForce GTX 580 в полноэкранном режиме.

В остальных режимах электрические характеристики GeForce GTX 580 также удалось существенно улучшить. Более того, 70 Вт в режиме декодирования видео высокого разрешения с диска Blu-ray не следует считать окончательной цифрой: как видно из графика энергопотребления, карта сбрасывает тактовые частоты не сразу, и зафиксированное измерительным модулем пиковое значение приходится на первую его часть; впоследствии уровень энергопотребления падает, в среднем, до 30—35 Вт. Показатели в режиме простоя также улучшены, хотя добиться экономичности решений AMD, оснащённых более продвинутой системой энергосбережения PowerPlay, так и не удалось. Впрочем, на фоне Radeon HD 5970 новое решение Nvidia в этом смысле выглядит великолепно.

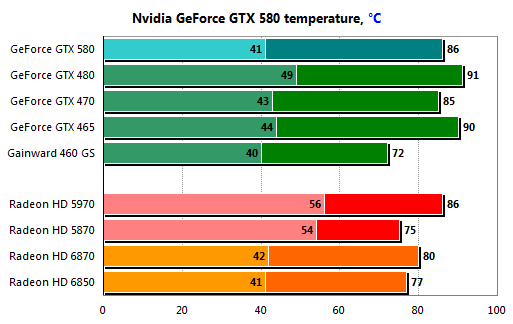

Новая система охлаждения также показывает себя с наилучшей стороны. Несмотря на повышенные тактовые частоты и наличие 512 активных ALU, она легко удерживает температуру ядра GeForce GTX 580 в пределах 86 градусов Цельсия, в то время как GPU менее производительного GeForce GTX 480 легко нагревается в тех же условиях до 91 градуса, несмотря на мощный радиатор с пятью тепловыми трубками и технологией «прямого контакта». Испарительная камера явно работает более эффективно при меньших габаритах системы охлаждения в целом. В режиме простоя температурные показатели также улучшились, но это заслуга оптимизации системы управления энергопотреблением.

В целом, температурные показатели эталонной версии GeForce GTX 580 не оставляют желать лучшего, особенно с учётом того, что данный продукт является самым мощным в линейке видеокарт Nvidia.

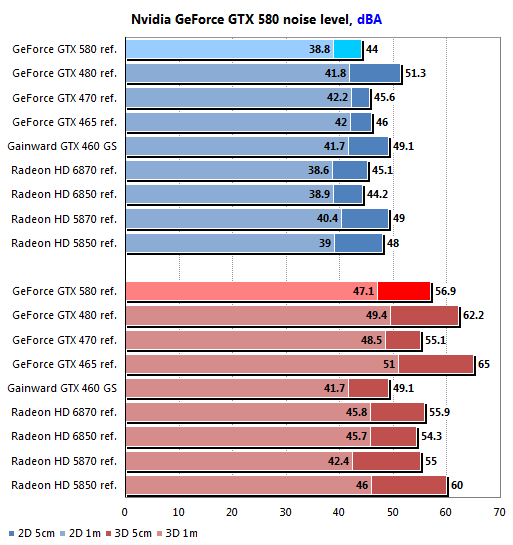

Высокая эффективность радиатора с испарительной камерой позволила сделать акустические характеристики системы охлаждения GeForce GTX 580 существенно более комфортными по сравнению с предшествующей ей конструкцией. В режиме 2D карта работает практически бесшумно. Во всяком случае, при фоновом шуме работающей системы, составляющем 38 дБА, GeForce GTX 580 просто теряется среди шумов, издаваемых другими компонентами, такими, как корпусные вентиляторы, вентилятор в блоке питания, шпиндели жёстких дисков и т.п. Скорость вращения вентилятора карты при этом примерно равна 1300 оборотов в минуту, по данным MSI Afterburner. Разумеется, в режиме 3D обороты турбины увеличиваются — сделать полностью бесшумным решение такого класса вообще вряд ли возможно, ведь для его нормального функционирования необходимо отвести и рассеять более 250 Вт тепла. По мере «прогревания» скорость вращения вентилятора возрастает до 2940 об/мин. Растёт и уровень шума, однако, даже в самом тяжёлом случае, при длительном «прогреве» с помощью теста OCCT: GPU уровень шума на расстоянии 1 метра от работающей системы остаётся достаточно комфортным и лишь немного превышает аналогичные показатели GeForce GTX 470 и Radeon HD 6870. В плане акустической комфортности эталонная система охлаждения GeForce GTX 480 остаётся далеко позади.

Иными словами, GeForce GTX 580 демонстрирует отличную сбалансированность электрических, тепловых и шумовых характеристик. Осталось лишь выяснить, чего можно ожидать от новинки в плане производительности в современных играх.

Конфигурация тестовых платформ и методология тестирования

Тестирование Nvidia GeForce GTX 580 в условиях, максимально приближенных к «боевым», было проведено на универсальной тестовой платформе, имеющей следующую конфигурацию:

Процессор Intel Core i7-975 Extreme Edition (3,33 ГГц, 6,4 GT/s QPI)

Кулер Scythe SCKTN-3000 «Katana 3»

Системная плата Gigabyte GA-EX58-Extreme (Intel X58)

Память Corsair XMS3-12800C9 (3x2 ГБ, 1333 МГц, 9-9-9-24, 2Т)

Жесткий диск Samsung Spinpoint F1 (1 ТБ/32 МБ, SATA II)

Блок питания Ultra X4 850W Modular (мощность 850 Вт)

Монитор Dell 3007WFP (30”, максимальное разрешение 2560x1600@60 Гц)

Microsoft Windows 7 Ultimate 64-bit

Использовались следующие версии драйверов AMD Catalyst и Nvidia GeForce:

AMD Catalyst 10.10c (with hotfix) для AMD Radeon HD

Nvidia GeForce 262.99 WHQL для Nvidia GeForce

Сами драйверы были настроены следующим образом:

AMD Catalyst:

Anti-Aliasing: Use application settings/Standard Filter

Morphological filtering: Off

Texture Filtering Quality: High Quality

Surface Format Optimization: Off

Wait for vertical refresh: Always Off

Anti-Aliasing Mode: Quality

Остальные настройки: по умолчанию

Nvidia GeForce:

Texture filtering — Quality: High quality

Vertical sync: Force off

Antialiasing — Transparency: Multisampling

CUDA — GPUs: All

Set PhysX configuration: Auto-select

Ambient Occlusion: Off

Остальные настройки: по умолчанию

В состав тестового пакета вошли следующие игры и приложения:

Трехмерные шутеры с видом от первого лица:

Aliens vs. Predator (1.0.0.0, Benchmark)

Battlefield: Bad Company 2 (1.0.1.0, Fraps)

Call of Duty: Modern Warfare 2 (1.0.182, Fraps)

Crysis Warhead (1.1.1.711, Benchmark)

Far Cry 2 (1.03, Benchmark)

Metro 2033 (Ranger Pack, 1.02, Benchmark)

S.T.A.L.K.E.R.: Call of Pripyat (1.6.02, Fraps)

Трехмерные шутеры с видом от третьего лица:

Just Cause 2 (1.0.0.1, Benchmark/Fraps)

Lost Planet 2 (1.1, Benchmark)

RPG:

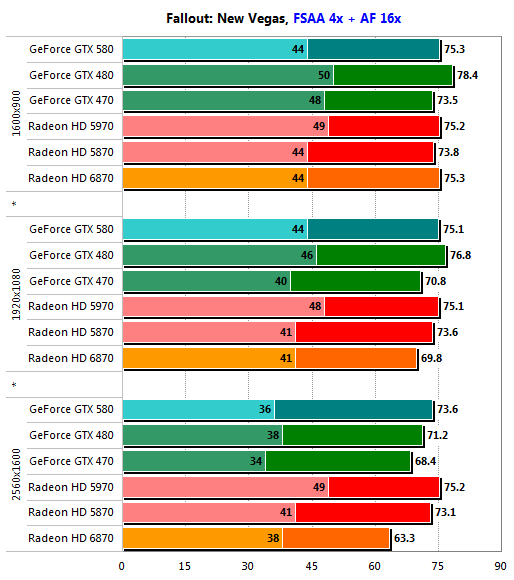

Fallout: New Vegas (1.01, Fraps)

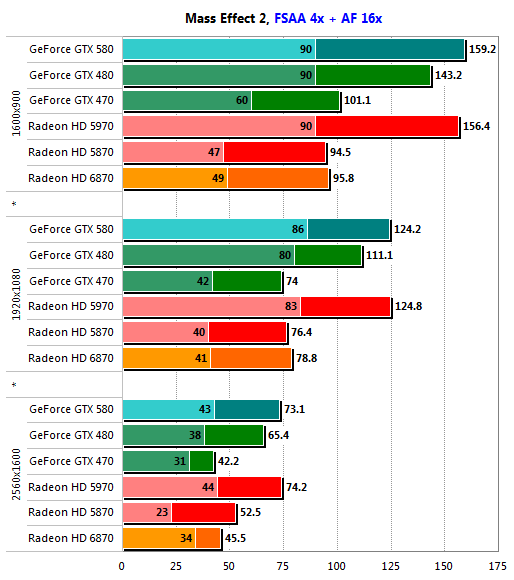

Mass Effect 2 (1.01, Fraps)

Симуляторы:

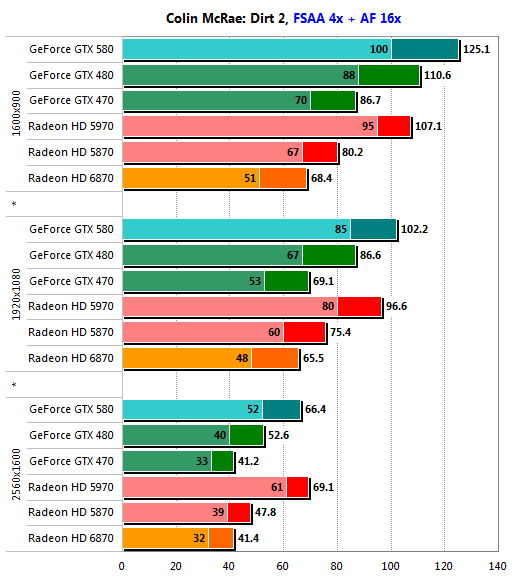

Colin McRae: Dirt 2 (1.1, Benchmark)

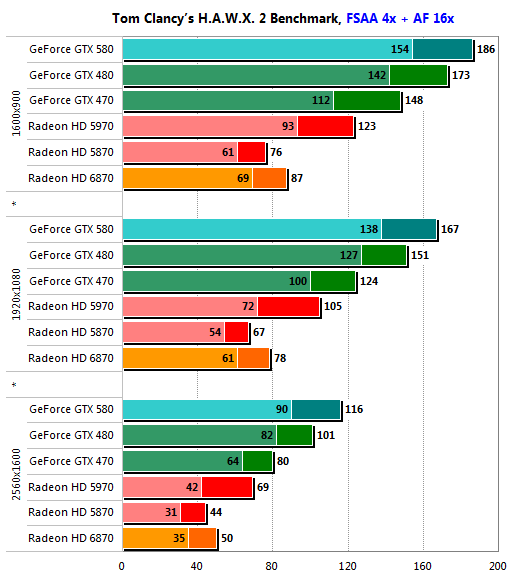

Tom Clancy's H.A.W.X. 2 (1.01, Benchmark)

Стратегические игры:

BattleForge (1.2, Benchmark)

StarCraft II: Wings of Liberty (1.0.2, Fraps)

Полусинтетические и синтетические тесты:

Futuremark 3DMark Vantage (1.0.2.1)

Final Fantasy XIV Official Benchmark (1.0.0.0, Fraps)

Unigine Heaven Benchmark (2.1)

Каждая из входящих в набор тестового программного обеспечения игр была настроена таким образом, чтобы обеспечивать максимально возможный уровень детализации. В приложениях, поддерживающих тесселяцию, эта возможность была задействована.

Принципиальный отказ от ручной модификации каких-либо конфигурационных файлов означает, что для настройки использовались исключительно средства, доступные в самой игре любому непосвящённому пользователю. Тестирование проводилось в разрешениях 1600х900, 1920х1080 и 2560х1600. За исключением отдельно оговоренных случаев, стандартную анизотропную фильтрацию 16х дополняло сглаживание MSAA 4x. Активация сглаживания осуществлялась либо средствами самой игры, либо, при их отсутствии, форсировалась с помощью соответствующих настроек драйверов AMD Catalyst и Nvidia GeForce.

Помимо GeForce GTX 580, в тестировании приняли участие следующие графические карты:

Nvidia GeForce GTX 480

Nvidia GeForce GTX 470

ATI Radeon HD 5970

ATI Radeon HD 5870

AMD Radeon HD 6870

Для получения данных о производительности использовались встроенные в игру средства тестирования с обязательным применением оригинальных тестовых роликов, а также, по возможности, фиксацией данных о минимальной производительности. В случае отсутствия вышеупомянутых средств применялась утилита Fraps 3.2.3 в ручном режиме с трёхкратным тестовым проходом, фиксацией минимальных значений и последующим усреднением финального результата.

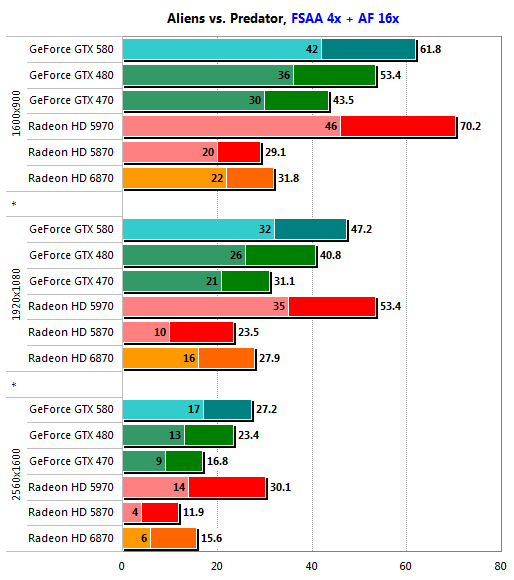

Игровые тесты: Aliens vs. Predator

Первый подход к снаряду — и отличный результат, с практической точки зрения лишь немногим уступающий результату Radeon HD 5970. Во всяком случае, в разрешении 1920х1080 GeForce GTX 580 уступает двухпроцессорному монстру ATI не сильно, а субъективный уровень комфорта обеспечивает такой же. В 2560х1600 оба решения бессильны удержать приемлемый уровень минимальной производительности, однако, результат GeForce GTX 580 существенно лучше.

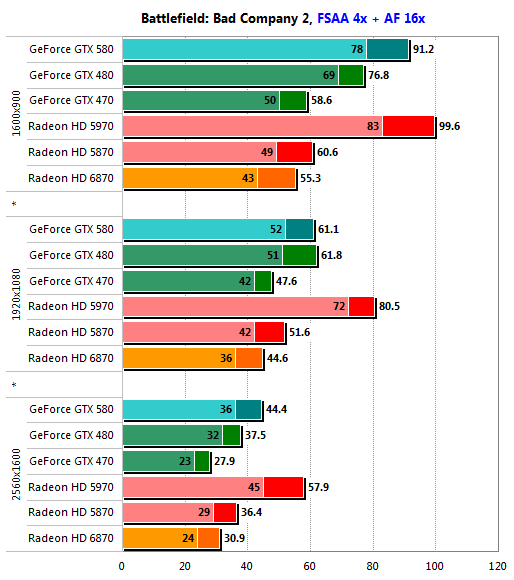

Игровые тесты: Battlefield: Bad Company 2

Бороться с двумя ядрами RV870, работающими в единой связке, сложно до сих пор, несмотря на то, что впервые этот графический процессор ATI увидел свет ещё в сентябре прошлого года. Однако, с учётом того, что Radeon HD 5970 до сих пор стоит в розничной продаже более 600 долларов, у GeForce GTX 580 просто нет конкурентов. В своём ценовом классе он неоспоримый лидер, обеспечивающий великолепную производительность в Bad Company 2 во всем диапазоне разрешений. Интересно, что в режиме Full HD преимущества перед GeForce GTX 480 не наблюдается; возможно, это флуктуация, обусловленная несовершенством ручного метода тестирования с помощью Fraps.

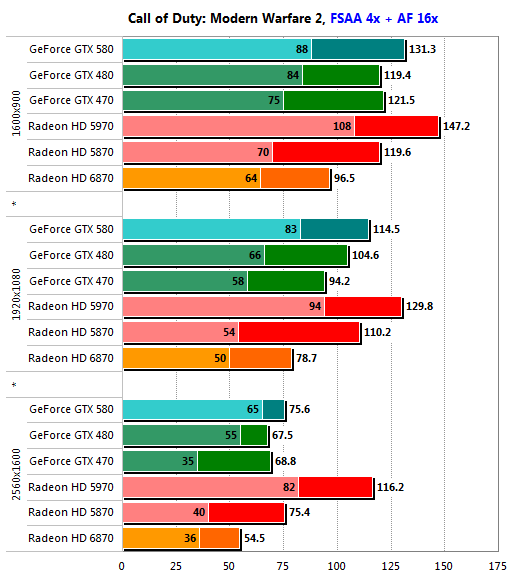

Игровые тесты: Call of Duty: Modern Warfare 2

Новинке нет равных и в Modern Warfare 2, причём, в разрешениях до Full HD включительно она несильно уступает и Radeon HD 5970. Но даже при серьёзном отставании в 2560х1600, минимальная производительность GeForce GTX 580 не падает ниже 60 кадров в секунду, а значит, использование более дорогого, горячего и шумного Radeon HD 5970 малоосмысленно. Особенно с учётом того, что неплохой уровень комфорта в этой игре обеспечивает даже Radeon HD 6870.

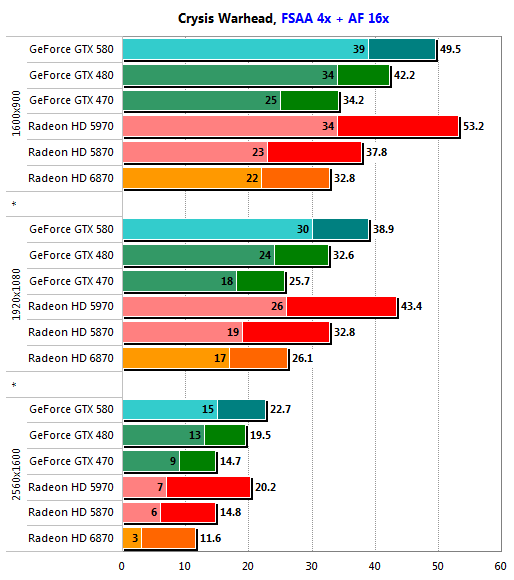

Игровые тесты: Crysis Warhead

Crysis Warhead уже нельзя назвать новой игрой, однако, до сих пор не существует одиночных графических карт, способных при использовании максимальной детализации обеспечить в ней приемлемый уровень производительности в разрешении 2560х1600, хотя новый GeForce GTX 580 и сделал серьёзные шаги в этом направлении. В более низких разрешениях он также является предпочтительным выбором перед Radeon HD 5970 из-за более высокой минимальной производительности. Последние сомнения отпадают, если добавить к этому меньшую цену и более комфортные акустические характеристики новинки Nvidia.

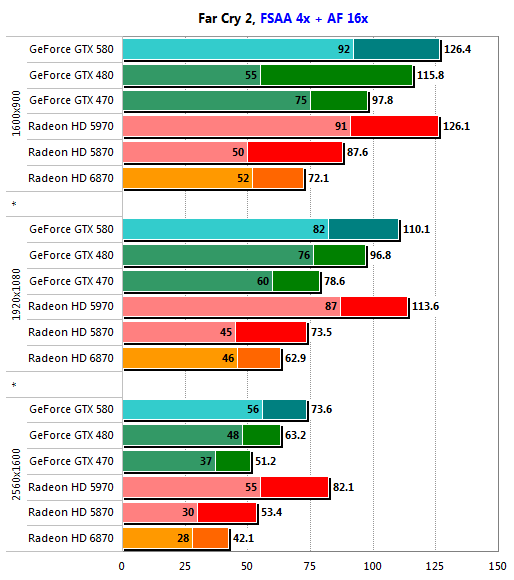

Игровые тесты: Far Cry 2

Новинке впервые удаётся добиться паритета с Radeon HD 5970, правда лишь в разрешении 1600х900. В более ресурсоёмких режимах она вновь начинает уступать «двухголовому дракону» ATI, правда, лишь в средней скорости, и то не слишком существенно. Минимальные показатели GeForce GTX 580 и Radeon HD 5970 остаются одинаковыми во всём диапазоне стандартных разрешений. Поскольку Far Cry 2 не Crysis Warhead, даже разрешение 2560х1600 использовать без опасения, что скорость упадёт ниже минимально комфортного уровня.

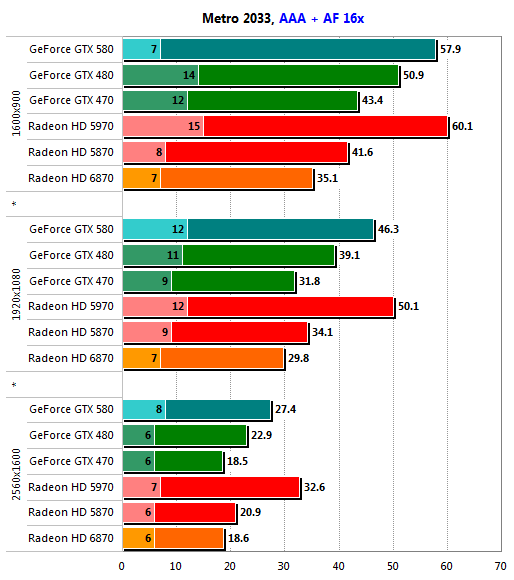

Игровые тесты: Metro 2033

Эта игра тестируется без форсирования сглаживания, но с включенной тесселяцией.

Даже наличие 16 блоков обработки геометрии и повышенные частоты не позволяют GeForce GTX 580 поддерживать приемлемый уровень минимальной производительности при включенной тесселяции, хотя средний показатель новинки лишь немногим хуже аналогичного показателя Radeon HD 5970. Так или иначе, GeForce GTX 580 задаёт новый стандарт производительности среди однопроцессорных графических карт высшего класса.

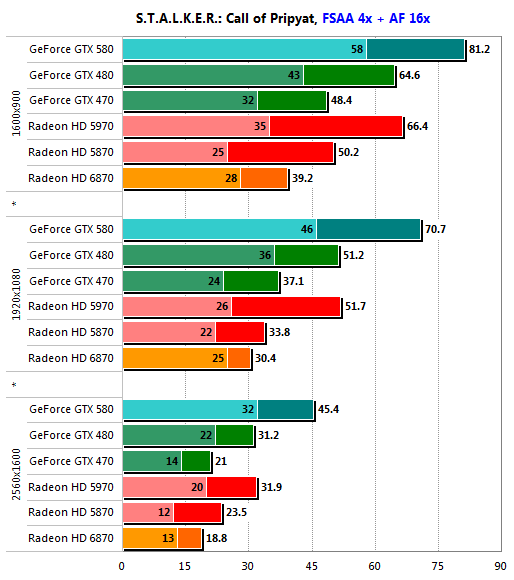

Игровые тесты: S.T.A.L.K.E.R.: Call of Pripyat

Игра тестируется с включенной тесселяцией.

GeForce GTX 580 резко уходит в отрыв, оставляя далеко позади даже Radeon HD 5970! Признаться, такой прыти от новинки мы не ожидали, но факт остаётся фактом: прирост производительности относительно GeForce GTX 480 в этом тесте составил от 25 % до 45 %, в зависимости от разрешения. По всей видимости, во многом это заслуга одновременно и большего количества шейдерных процессоров, работающих на повышенной частоте, и усовершенствованных текстурных процессоров, способных выполнять обработку формата FP16 на полной скорости.

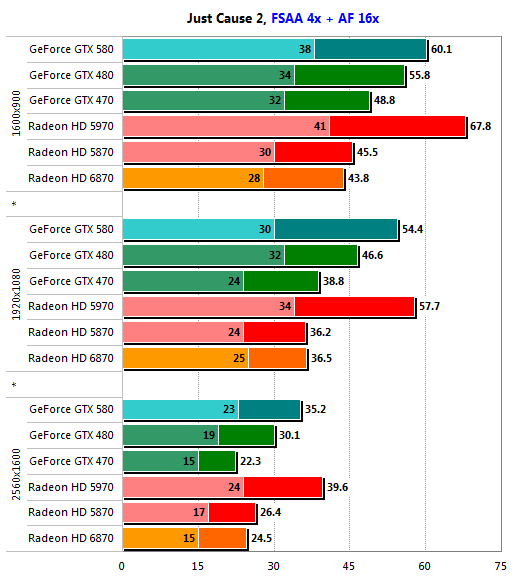

Игровые тесты: Just Cause 2

Новому GeForce GTX 580 почти удаётся догнать Radeon HD 5970 в разрешении 1920х1080, да и в 2560х1600 отставание невелико, а если рассматривать минимальную производительность этих решений, то разница составляет 1—4 кадра в секунду, в зависимости от разрешения. Как следствие, обе карты можно использовать с одинаковым успехом, но находиться с работающим под нагрузкой Radeon HD 5970 куда менее приятно для слуха.

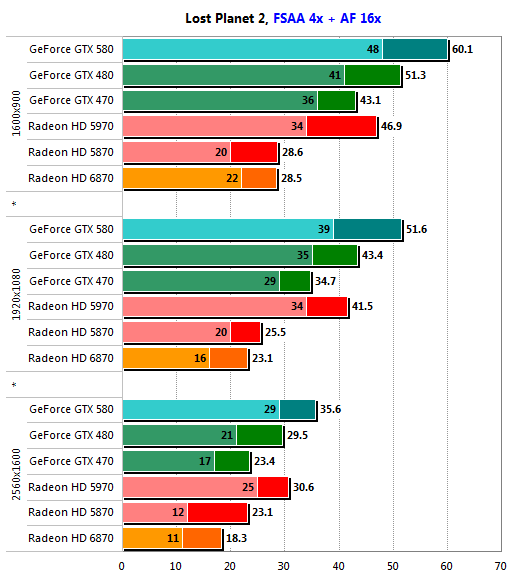

Игровые тесты: Lost Planet 2

Ситуация напоминает виденную в Call of Pripyayt — GeForce GTX 580 лидирует с солидным отрывом, оставляя далеко позади Radeon HD 5970. Справедливости ради надо сказать, что в этой игре с двухпроцессорным флагманом AMD справляется и предшественник новинки, GeForce GTX 480, а всё за счёт более высокой производительности блоков тесселяции. Переломить или хотя бы просто улучшить ситуацию сможет только Radeon HD 6900, оснащённый ещё более совершенным блоком тесселяции, нежели Radeon HD 6800, но даже ему будет крайне тяжело тягаться с шестнадцатью блоками PolyMorph Engine, входящими в состав Nvidia GF110.

Игровые тесты: Fallout: New Vegas

Как и предшествующие игры серии Fallout 3, New Vegas не отличается существенными аппетитами по части графической подсистемы. При максимальной детализации, подразумевающей также использование MSAA 4x, ему достаточно и Radeon HD 6870, причём, показатели более мощных графических карт отличаются от показателей вышеупомянутого решения несущественно даже в разрешении 2560х1600. В сущности, монстрам вроде GeForce GTX 580 в этой игре делать нечего и их внушительный потенциал остаётся невостребованным.

Игровые тесты: Mass Effect 2

В этом тесте полноэкранное сглаживание форсируется с использованием методики, описанной в обзоре Contemporary Graphics Accelerators in Mass Effect 2.

Внесённых в новинку усовершенствований оказалось достаточно, чтобы GeForce GTX 580 смог выйти на уровень Radeon HD 5970 во всех разрешениях, включая 2560х1600. С учётом меньшей цены и не столь шумного нрава, решение Nvidia выглядит намного более выгодным приобретением, как, впрочем, по результатам остальных тестов.

Игровые тесты: Colin McRae: Dirt 2

Игра тестируется с включенной тесселяцией.

В двух разрешениях из трёх GeForce GTX 580 сумел вырвать первенство из рук Radeon HD 5970, а в 2560х1600 хоть и уступил последнему, но всего лишь около 4 % при сохранении общего высокого уровня производительности. Иными словами, господству Radeon HD 5970 в секторе дорогих игровых карт если и не пришёл конец, то занимать эту нишу ему в гордом одиночестве более не получится — придётся делить её с GeForce GTX 580.

Игровые тесты: Tom Clancy's H.A.W.X. 2 Preview Benchmark

Данный тест активно использует тесселляцию для отрисовки поверхности земли. Количество полигонов в кадре может достигать полутора миллионов.

Можно спорить об эффективности использования экстремальной тесселяции, при которой размер полигона может составлять менее 16 пикселей (в данном случае, 6 пикселей), однако, как уже упоминалось в начале обзора, лучше иметь возможность справиться даже с такой нагрузкой практически, нежели пытаться бороться с ней словесно. Первое у GeForce GTX 580, вооружённой мощностью всех 16 блоков PolyMorph Engine, получается великолепно, и решениям AMD за новинкой просто не угнаться. Однако, во-первых, Radeon HD 5970 и Radeon HD 6870, несмотря на своё отставание от решений на базе архитектуры Fermi, демонстрируют вполне приемлемые показатели даже в разрешении 2560х1600, а во-вторых, не следует забывать, что данный бенчмарк пока ещё не является полноценной игрой и в финальной версии H.A.W.X. 2 расстановка сил может существенно измениться.

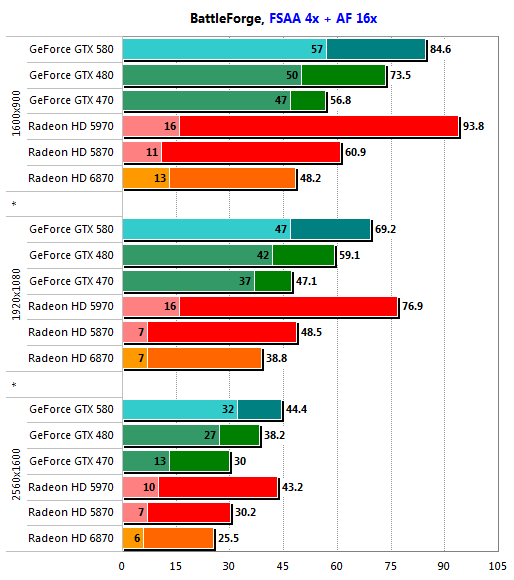

Игровые тесты: BattleForge

Нельзя сказать, что GeForce GTX 580 идёт на абсолютный рекорд. Как и в большинстве других тестов, ему не удалось опередить Radeon HD 5970, однако, в этой игре основное преимущество решений Nvidia заключается в более высокой минимальной скорости, и здесь новой карте Nvidia нет равных, особенно в высоких разрешениях. В этом жанре провалы мгновенной производительности не столь страшны, как в жанре FPS; по крайней мере, судя по субъективным ощущениям, играть, используя решения ATI Radeon HD, вполне можно, но всё же с появлением GeForce GTX 580 для приобретения Radeon HD 5970 не остаётся никаких причин.

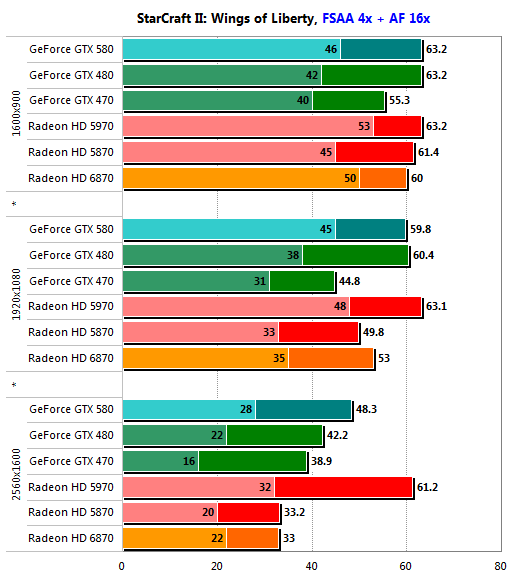

Игровые тесты: StarCraft II: Wings of Liberty

Главным достижением GeForce GTX 580 стало поднятие планки минимальной производительности в разрешении 2560х1600 до 28 кадров в секунду, что сделало возможной конкуренцию с Radeon HD 5970. Отставание в средней производительности составляет порядка 20 %, но на практике заметить его достаточно сложно. Возможно, оно может сыграть какую-то роль для профессиональных киберспортсменов, но рядовой любитель StarCraft II разницу вряд ли почувствует, зато его уши прекрасно ощутят разницу в уровнях и характере шума систем охлаждения GeForce GTX 580 и Radeon HD 5970.

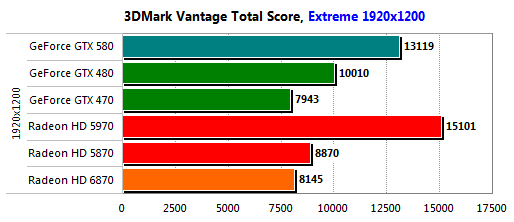

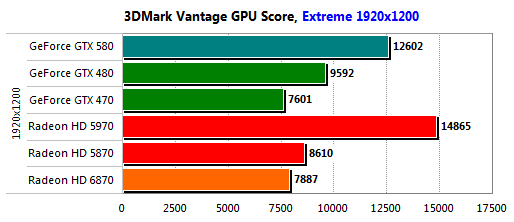

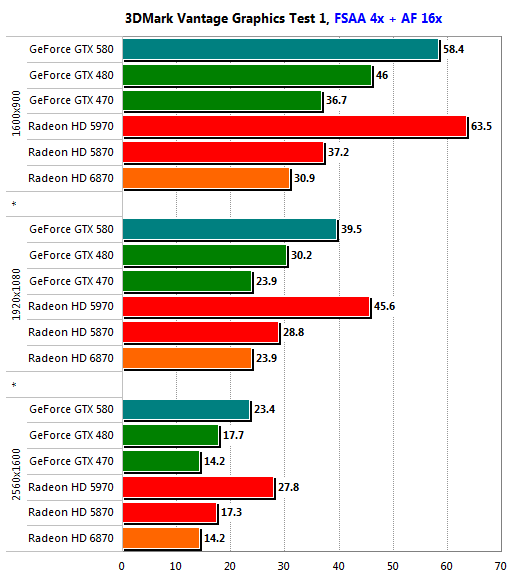

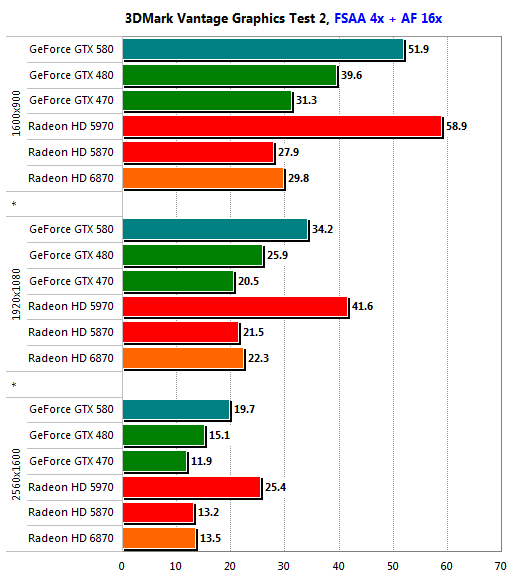

Полусинтетические и синтетические тесты: Futuremark 3DMark Vantage

Чтобы минимизировать влияние центрального процессора, при тестировании в 3DMark Vantage применяется профиль «Extreme», использующий разрешение 1920х1200, FSAA 4x и анизотропную фильтрацию. Для полноты картины производительности, результаты отдельных тестов снимаются во всем диапазоне разрешений.

Планка на уровне 13000 очков покорилась GeForce GTX 580 без особого труда, однако, рекорд, поставленный Radeon HD 5970 и составляющий свыше 15000 очков, так и остался непобитым. Не так-то просто побить в этом тесте двухпроцессорное решение.

Результаты отдельных тестов 3DMark Vantage не показывают ничего экстраординарного: всюду GeForce GTX 580 серьёзно опережает GeForce GTX 480, но уступает Radeon HD 5970. Во втором графическом тесте это отставание несколько больше, и, в зависимости от разрешения, составляет 12—22 % против 8—16 % в первом.

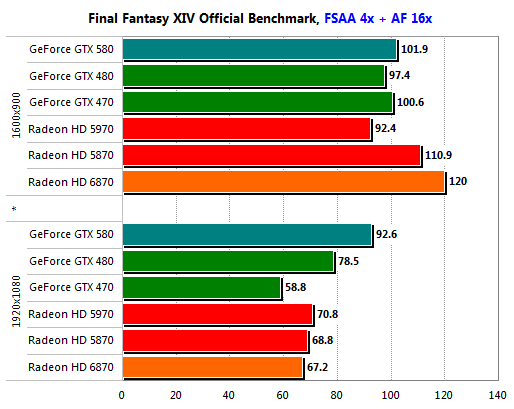

Полусинтетические и синтетические тесты: Final Fantasy XIV Official Benchmark

Тест поддерживает только разрешения 1280х720 и 1920х1080.

Несмотря на всю мощь GeForce GTX 580, в разрешении 1280х720 лидирует скромный Radeon HD 6870, и лишь в 1920х1080 новому флагману Nvidia удаётся вырваться вперёд. В этом разрешении преимущество новинки над предшественником достигает ощутимых 18 %.

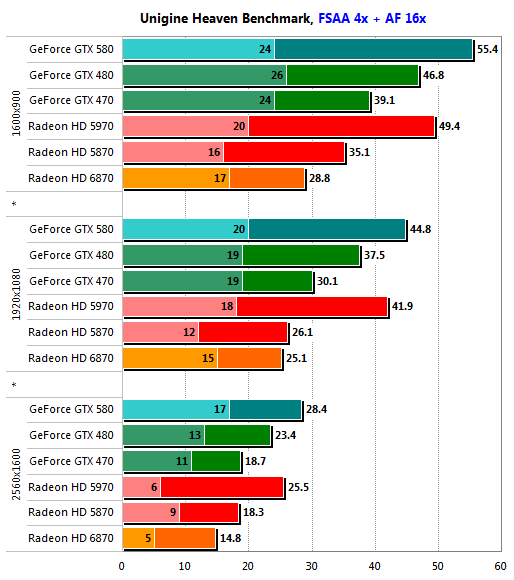

Полусинтетические и синтетические тесты: Unigine Heaven benchmark

В тесте используется режим тесселяции «normal».

Несмотря на слабые блоки тесселяции, Radeon HD 5970 уступает GeForce GTX 580, вооружённому аж 16 модулями обработки геометрии, совсем немного, не более 7-10 %, однако, в разрешении 2560х1600 минимальная производительность нового детища Nvidia существенно выше. Это не играет особой роли, поскольку тест синтетический и не является игрой, однако, полученные в нём результаты ещё раз доказывают, что GeForce GTX 580 будет весьма и весьма силён в будущих играх, активно использующих тесселяцию.

GeForce GTX 580: достоинства и недостатки

Достоинства:

Лучшая производительность в своём классе

Может на равных соперничать с Radeon HD 5970

Высокая производительность при выполнении тесселяции

Широкий выбор режимов FSAA

Улучшенное качество CSAA/TMAA

Минимальное влияние FSAA на производительность

Поддержка CUDA и PhysX

Полноценная аппаратная поддержка декодирования HD-видео

Качественный постпроцессинг и масштабирование HD-видео

Низкий уровень шума

Высокая эффективность системы охлаждения

Недостатки:

Серьёзных не обнаружено

Заключение

Итак, что же такое являет собой новый флагман Nvidia, GeForce GTX 580? По сути, таким с самого начала должен был быть GeForce GTX 480, однако, по ряду причин на момент анонса GF100 компания была вынуждена существенно урезать его конфигурацию, несмотря на физическое наличие на кристалле 512 поточных процессоров и 64 текстурных блоков. Выпуск GF110 можно назвать достойной «работой над ошибками», поскольку новое ядро получило 512 активных ALU и 64 TMU, а архитектура самих TMU была доработана таким образом, чтобы они могли выполнять обработку текстур всех форматов на полной скорости. Вкупе с оптимизацией самого ядра, позволившей поднять его тактовые частоты, это избавило GF110 от всех узких мест, присущих его предшественнику, GF100. В итоге, GeForce GTX 580 получился весьма сбалансированным игровым решением высшего класса, лишённым каких-либо видимых недостатков, и демонстрирующим великолепный уровень производительности в современных играх. Это хорошо иллюстрируют сводные диаграммы.

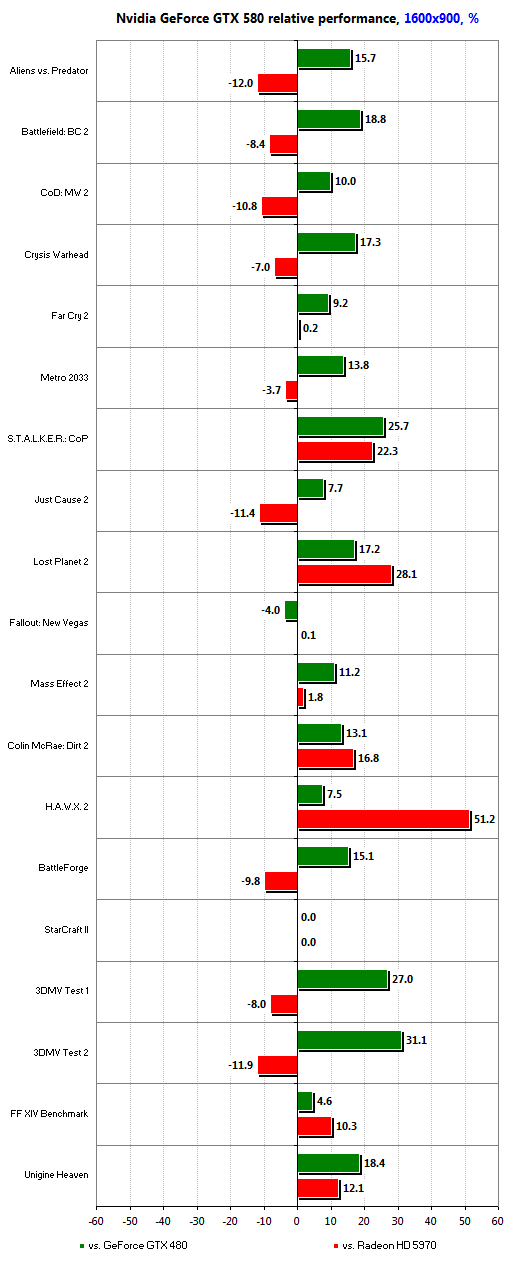

Разрешение 1600х900 редко используется владельцами графических карт стоимостью около 500 долларов, поскольку в нём им, как правило, сложно показать себя во всей красе, так как производительность лимитируется другими факторами. Однако уже здесь GeForce GTX 580 опережает своего предшественника в среднем на 14 %. Двухпроцессорному монстру в лице ATI Radeon HD 5970 он проигрывает в девяти тестах из девятнадцати, причём более чем на 10 % — лишь в четырёх, включая второй графический тест 3DMark Vantage. Крепкая ничья, а с учётом разницы в цене флагманских решений AMD и Nvidia, такой результат можно даже назвать победой последней.

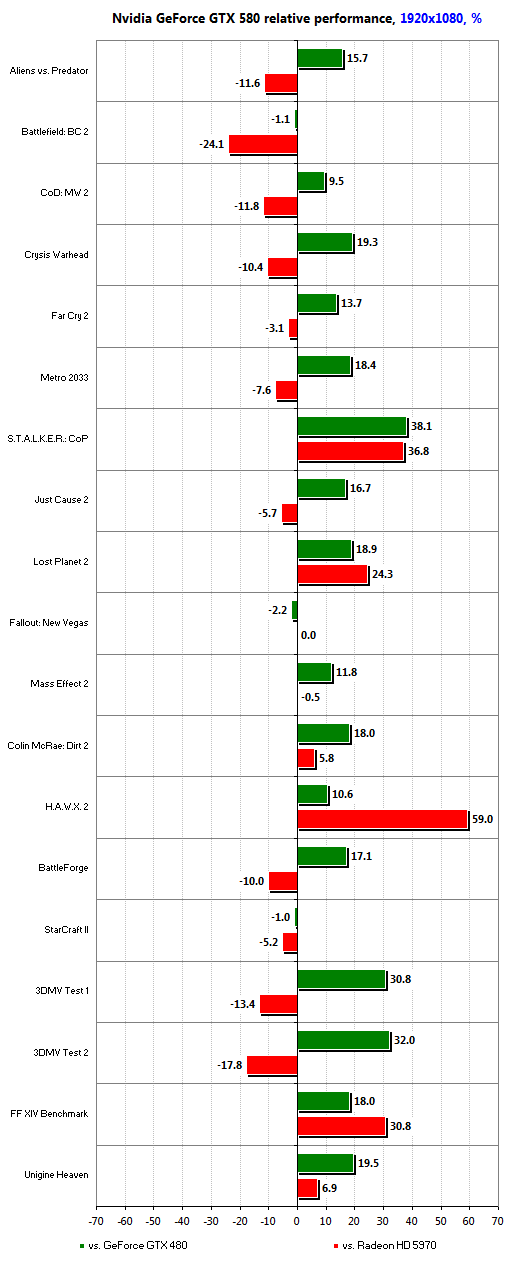

Разрешение 1920х1080, соответствующее стандарту Full HD, весьма распространено в наши дни, и большинстве мониторов игрового класса установлена именно такая матрица. Здесь GeForce GTX 580 также есть, чем похвастаться: максимальное превосходство над предшественником достигло внушительных 38 %. Правда, количество тестов, проигранных Radeon HD 5970, выросло до десяти, но лишь в Battlefield: Bad Company 2 отставание достигло весомых 24 %. И, разумеется, во всех представленных в обзоре играх, включая вечный камень преткновения современных графических карт, Crysis Warhead, GeForce GTX 580 смог обеспечить весьма комфортный уровень производительности. Исключением стал шутер Metro 2033 — при включенной тесселяции ни одно из существующих игровых решений, за исключением, может быть, систем 3-way SLI и 4-way CrossFire, не в состоянии поддерживать в нём минимальную скорость хотя бы на уровне 25 кадров в секунду.

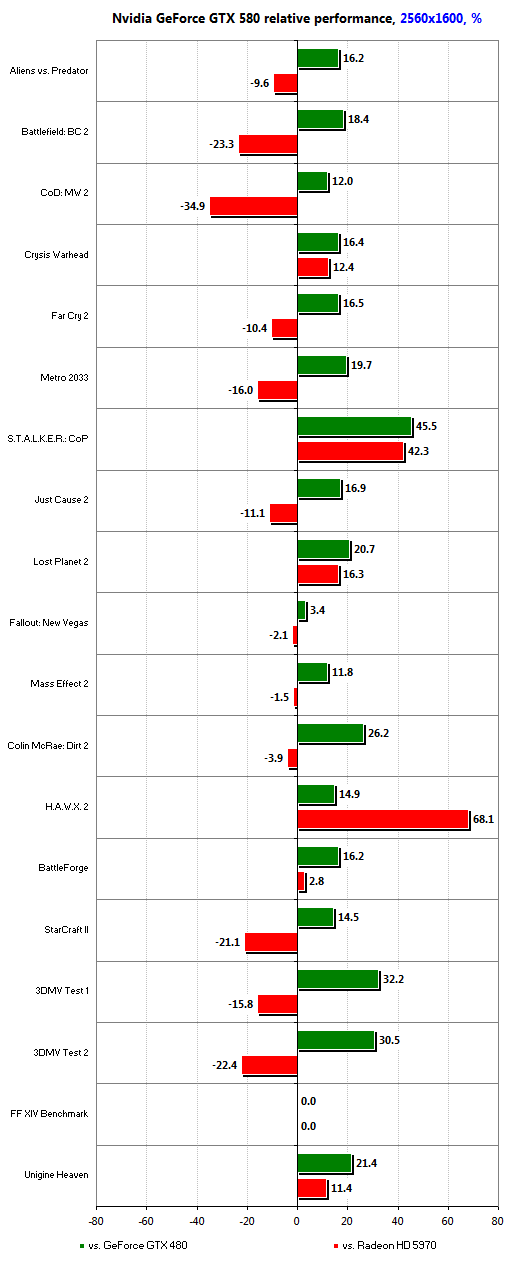

Владельцев мониторов, поддерживающих разрешения свыше 1920х1080, не так много, и зачастую такие мониторы используются больше для серьёзной работы, нежели для игр, однако, владельцы панелей с диагональю 30" c большой вероятностью могут приобрести и GeForce GTX 580. Надо сказать, что новинка их не разочарует, хотя и не во всех современных играх она сможет обеспечить комфортную производительность при максимальной детализации и включенном сглаживании. К числу таких игр относится ряд шутеров с видом от первого лица — Aliens vs. Predator, Crysis Warhead и Metro 2033. Здесь будущим владельцам GeForce GTX 580 придётся пожертвовать, как минимум, сглаживанием, а в случае с Metro 2033 — тесселяцией, эффект от использования которой в этой игре не слишком-то заметен. Во всех остальных случаях мощности новинки вполне достаточно для обеспечения приемлемой производительности, даже в таких требовательных играх, как S.T.A.L.K.E.R.: Call of Pripyat или Lost Planet 2.

В целом, Nvidia GeForce GTX 580 является весьма сбалансированным для своей цены решением, на деле доказавшим своё право называться самой мощной однопроцессорной графической картой. Более того, ему удалось потеснить безраздельно царивший в своей экологической нише Radeon HD 5970, а с учётом более низкой стоимости новинки, речь вскоре пойдёт о вытеснении, по крайней мере, до появления нового поколения двухпроцессорных карт ATI Radeon HD. Что немаловажно, по уровню акустического комфорта GeForce GTX 580 также оставляет монстра AMD далеко позади, и лишь уровень энергопотребления нового флагмана Nvidia оказывается выше. Но даже в этом случае следует вспомнить, что GeForce GTX 580 демонстрирует одинаковую с GeForce GTX 480 экономичность в режиме 3D при более высокой производительности, и существенно лучшую экономичность в энергосберегающих режимах, в которых он опережает и Radeon HD 5970.

Иными словами, GeForce GTX 580 можно назвать новой мечтой любителя компьютерных игр, готового отдать за быструю графическую карту 500 долларов. Массовым решением эта новинка Nvidia по очевидным причинам стать не способна, однако, своё право на титул лучшей игровой видеокарты высшего класса она завоевала в честном бою. Посмотрим, долго ли ей удастся удерживать этот титул, ведь уже на подходе ATI Radeon HD 6900...

Другие материалы по данной теме

Fallout: New Vegas и современные видеокарты

Простая арифметика: видеокарты AMD Radeon HD 68xx в CrossFireX-режимах

AMD Radeon HD 6800: поколение Next?AMD Radeon HD 6800: поколение Next?