Ваш город: Москва

Nvidia GeForce GTX 560 Ti: герой нашего времени

Введение

Как известно всем, кто хоть в какой-то мере интересуется новинками рынка дискретной компьютерной графики, "роды" GeForce GTX 480 были трудными, и первенец новой архитектуры NVIDIA Fermi появился на свет не в полной конфигурации. Лишь ближе к концу 2010 года компания завершила работу над ошибками, явив на суд публики улучшенную версию ядра GF100 — GF110. Доработанный и усовершенствованный наследник, наконец, смог стать тем, чем должен был стать GF100 с самого начала, и решения на его основе, GeForce GTX 580 и GeForce GTX 570, завоевали наши симпатии, великолепно проявив себя в игровых тестах.

Но с самого начала было понятно, что этим NVIDIA не ограничится, и процесс замены семейства GeForce 400 семейством GeForce 500 будет продолжаться и дальше. Следующим кандидатом в этой цепочке закономерно стал GeForce GTX 460. Надо сказать, что решения на базе GF104 изначально вышли более удачными, нежели старшие модели GeForce 400, использовавшие GF100. Во-первых, сам чип был более простым и более дешёвым в производстве, а, во-вторых, он умел выполнять фильтрацию текстур FP16 на полной скорости.

Всё это позволило ему на долгое время стать "основным боевым танком" NVIDIA, способным успешно сражаться с врагом и побеждать его. В ценовой категории "199-229" долларов GeForce GTX 460 768MB и GeForce GTX 460 1GB долгое время не имели себе равных, а присутствие на рынке большого количества моделей с серьёзным заводским разгоном свидетельствовало о высоком потенциале GF104. Однако, и у этого ядра был свой "тёмный секрет" — из восьми имеющихся в его составе мультипроцессоров активно было только семь, что давало 336 ALU и 56 текстурных блоков, в то время, как физических их было 384 и 64, соответственно.

Вряд ли GF104 страдал теми же "детскими болезнями", что и GF100, просто NVIDIA, по всей видимости, пыталась выпустить на рынок новое массовое графическое ядро как можно быстрее, обеспечив при этом максимальный выход годных кристаллов. Многие обозревательские ресурсы предполагали, что вслед за усечённой версией GF104 может увидеть свет полная, однако, при жизни семейства GeForce 400 этого так и не произошло.

Это случилось только сегодня, 25 января, когда NVIDIA представила миру наследника GF104 — ядро GF114, а также новую графическую карту класса "performance-mainstream" на его основе. В терминологии NVIDIA класс доступных, но высокопроизводительных игровых видеокарт называется "Hunter", но мы предпочитаем сравнение с современными боевыми танками. В этой перспективе флагманские модели стоимостью более 250 долларов представляются мощными, тяжёлыми и отлично вооружёнными моделями танков, которые, однако, в силу своей относительной малочисленности не могут создать перевеса по всему фронту. Эта тяжёлая и неблагодарная работа ложится на плечи более массовых боевых машин, сочетающих в себе простоту с приемлемыми тактико-техническими характеристиками.

Новой боевой машиной NVIDIA такого класса и стал GeForce GTX 560 Ti, анонсированный сегодня. Признаться, возврат к использованию приставок в названиях графических нас удивил. "Ti", очевидно, означает "Titanium", что должно намекать на великолепные потребительские качества новинки, однако, использование всевозможных приставок и суффиксов разрушает стройную систему наименований и возвращает нас в далёкий 2001 год, когда вышеупомянутая приставка была впервые использована в названии одной из моделей GeForce 2. На наш взгляд, можно было бы ограничиться названием GeForce GTX 560 и не создавать потенциальной путаницы в умах покупателей.

Так или иначе, новый GeForce GTX 560 Ti здесь, и мы собираемся познакомиться с ним поближе, дабы выяснить, на что способен новый массовый "танк" NVIDIA на поле боя.

NVIDIA GeForce GTX 560 Ti: архитектура

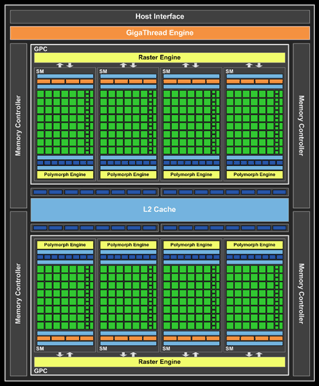

Как и в случае с GeForce GTX 580/570, организация нового ядра не изменилась. По сути, GF114 представляет собой полностью активный GF104, оптимизированный для достижения более высоких тактовых частот при сохранении уровня энергопотребления в разумных пределах.

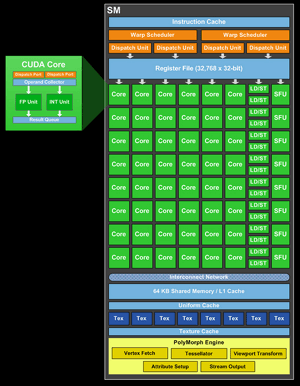

Два кластера GPC включают в себя по четыре мультипроцессора, каждый из которых, в свою очередь, несёт в своём составе по 48 универсальных поточных ядер, и, соответственно, общее количество этих ядер равно 384. Каждый мультипроцессор обслуживается восемью блоками текстурных операций, так что общее количество активных TMU в новом чипе составляет 64. Архитектура текстурных процессоров не изменилась со времён GF104. Они способны выполнять полноскоростную фильтрацию текстур формата FP16, наряду с традиционным форматом INT8. А вот фильтрация текстур в формате FP32 осуществляется в четыре раза медленнее. Объём кэша второго уровня, как и в GF104, составляет 512 КБ.

Кроме того, каждый мультипроцессор включает в себя и блок PolyMorph Engine, что ставит GF114 на голову выше любого решения AMD в области обработки геометрических данных и тесселяции. Даже два блока тесселяции третьего поколения в составе Cayman вряд ли смогут поспорить на равных с восемью блоками GF114. Конфигурация растровой подсистемы GF114 осталась прежней и включает в себя 32 блока RBE. Поскольку эта подсистема напрямую связана с подсистемой памяти, последняя по-прежнему состоит из четырёх 64-битных контроллеров, так что общая ширина шины, связывающей GPU с банком локальной памяти составляет 256 бит.

Что касается мультимедийных возможностей, то здесь заметных нововведений не замечено, но они, в сущности, и не нужны: уже GF104 умел всё, необходимое по современным меркам, включая полное аппаратное декодирование и масштабирование видео высокого разрешения в форматах H.264 и VC-1, а также защищённый вывод многоканального звука в форматах Dolby TrueHD и DTS-HD Master Audio посредством Protected Audio Path. Единственное весомое преимущество, которым в этой сфере может похвастаться AMD, это поддержка аппаратного декодирования DivX.

В целом, GF114 прекрасно соответствует принципу "разумной достаточности" — он поддерживает все современные графические и мультимедийные технологии, но не содержит в себе каких-то редко востребованных излишеств, вроде возможности одновременного подключения шести мониторов. По сути, новый массовый графический процессор NVIDIA являет собой не более чем закономерное эволюционное развитие идей, нашедших воплощение в GF104. Рассмотрим, как решение на его основе выглядит на фоне соперников, предшественников, и старших собратьев.

NVIDIA GeForce GTX 560 Ti: место в строю

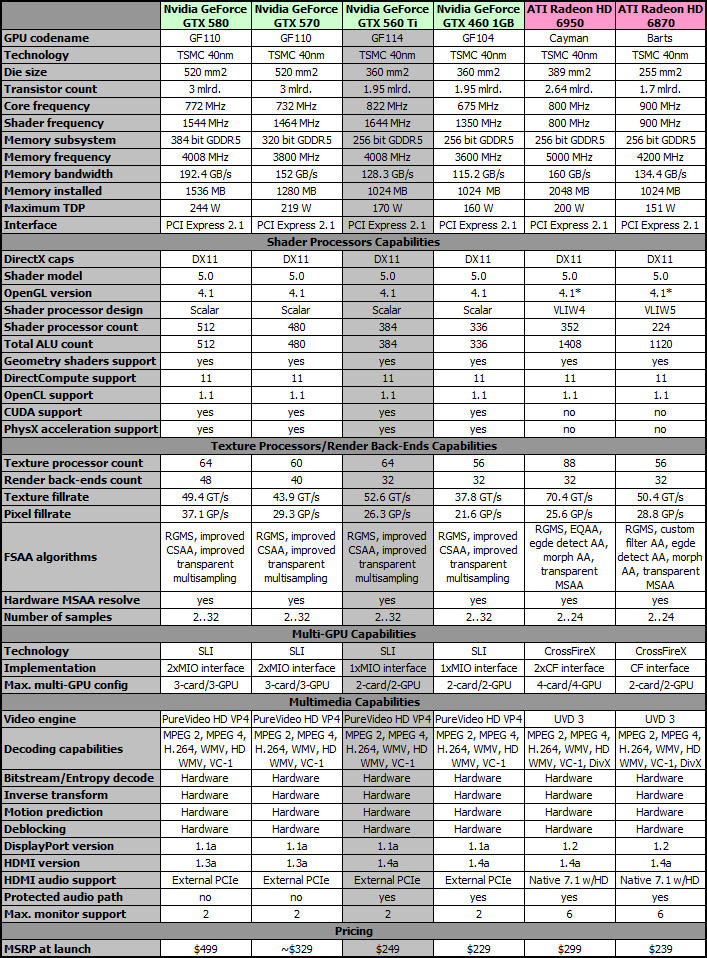

Как GF110 является "правильной" версией GF100, так и новый GF114 стал тем, чем с самого начала должен был стать GF104. В результате проделанной работы над ошибками команде разработчиков NVIDIA удалось добиться стабильной работы нового ядра в полной конфигурации с восемью активными мультипроцессорами, дающими в сумме 384 универсальных ALU, причём, на более высоких тактовых частотах, нежели в случае с GF104. Впрочем, гораздо лучше такие вещи познаются в сравнении:

* начиная с Catalyst 10.12

Итак, очевидно, что новый GeForce GTX 560 Ti по отношению к GeForce GTX 460 1GB является тем же, чем GeForce GTX 580 и 570 стали по отношению к GeForce GTX 480 и GeForce GTX 470, соответственно. Иными словами, это очередная "старая сказка на новый лад", однако, ничего плохого в этом нет, поскольку сама по себе архитектура Fermi очень удачна, за исключением, пожалуй, не слишком производительной в сравнении с решениями конкурента текстурной подсистемы.

В первую очередь, бросаются в глаза существенно возросшие тактовые частоты ядра - свыше 800 МГц для основного домена и более 1.6 ГГц для вычислительного. Для решений NVIDIA, с учётом их архитектурных особенностей, это очень серьёзное достижение. Ранее такие частоты покорялись разве что отдельным моделям GeForce с заводским разгоном, но отныне AMD следует начать беспокоиться всерьёз, поскольку даже основной домен GF114 работает быстрее, нежели всё ядро Radeon HD 6950. К тому же, последнее имеет всего 352 универсальных процессора VLIW4 против 384 скалярных ALU у GF114.

При этом известно, что графическая архитектура ATI/AMD достигает максимальной производительности отнюдь не всегда, а новая её инкарнация в лице Cayman, к тому же, потеряла выделенный ALU для комплексных операций, и в случае необходимости их выполнения вынуждена задействовать четыре простых ALU, тем самым теряя в "тяговооружённости". Отсюда следует, что в наиболее неудобном для архитектуры AMD Cayman случае, Radeon HD 6950 будет серьёзно уступать GeForce GTX 560 Ti с её 384 поточными процессорами, работающими на частоте свыше 1600 МГц. Как будут обстоять дела в реальных приложениях, покажут тесты. Про Radeon HD 6870 не приходится и говорить — он уступает GeForce GTX 560 Ti по всем показателям, включая производительность текстурной подсистемы.

Характеристики подсистемы памяти GeForce GTX 560 Ti несколько улучшились, однако, 128 ГБ/сек на фоне показателей AMD Cayman и даже Barts отнюдь не выглядят откровением. Не вполне понятно, что помешало разработчикам NVIDIA довести частоту видеопамяти новинки хотя бы до 1125 (4500) МГц. У решений на базе GF110 есть оправдание: добиться стабильной работы памяти на таких частотах при 320-битной или даже 384-битной шине доступа — настоящее искусство, однако, GF114, имеющий, как и его предшественник, 256-битную шину памяти, этого ограничения лишён, и ничто не мешало бы использовать в конструкции GeForce GTX 560 Ti более производительные микросхемы GDDR5, по крайней мере, в теории. Тем не менее, пиковая пропускная способность подсистемы видеопамяти не является сильной стороной GeForce GTX 560 Ti, и по этому параметру новинку оставляет позади даже Radeon HD 6870, не говоря уж о Radeon HD 6950.

Что касается производительности текстурной подсистемы, то с разблокировкой восьмого мультипроцессора и поднятием тактовой частоты ядра до 820 МГц, это часто критикуемое ранее узкое место архитектуры Fermi стало во многом надуманным. С 64 активными TMU пиковая скорость обработки текстур достигает 52.6 гигатекселей в секунду, что даже больше аналогичных показателей старших моделей семейства GeForce 500. AMD Cayman с его 96 текстурными процессорами (88 в случае с Radeon HD 6950) способен и на большее, но во многом это стрельба из пушки по воробьям: как показывают результаты тестов, GeForce GTX 580 и GeForce GTX 570 отнюдь не страдают от нехватки производительности TMU, а новый GeForce GTX 560 Ti, как уже было сказано, опережает их в этой области.

Показатели подсистемы растровых операций также находятся на высоте за счёт повышенной частоты ядра. Пиковая скорость заполнения сцены у нового GeForce GTX 560 чуть ниже аналогичного показателя Radeon HD 6870, чьё ядро работает на частоте 900 МГц, но выше показателя более совершенного архитектурно Radeon HD 6950. Нехватки производительности не должно наблюдаться даже в высоких разрешениях при использовании сглаживания.

Остальные возможности GeForce GTX 560 Ti остались прежними; стоит лишь отметить, что в результате проделанных разработчиками GF114 оптимизаций, TDP вырос всего на 10 Ватт по сравнению с предшественником. Повторимся, в том, что новинка представляет собой улучшенный вариант GeForce GTX 460 1GB с восемью активными поточными мультипроцессорами и более высокими тактовыми частотами GPU и памяти, нет ничего плохого. Предшественник GeForce GTX 560 Ti был и продолжает оставаться весьма удачным решением и отличным выбором для игрока, не желающего тратить более 250 долларов на приобретение графической карты. Наследник перенял у него всё лучшее и довел до логического совершенства, подорожав всего на 20 долларов.

При официальной рекомендуемой цене на уровне 249 долларов, новый GeForce GTX 560 Ti автоматически попадает в промежуток между Radeon HD 6870 и Radeon HD 6950, будучи при этом в состоянии состязаться с ними обоими, и что-то подсказывает нам, что у него есть все шансы на победу. Рассмотрим новое решение NVIDIA в деталях. На этот раз первой в нашу тестовую лабораторию попал образец с эталонным дизайном NVIDIA.

NVIDIA GeForce GTX 560 Ti: конструкция и технические характеристики

Новый GeForce GTX 560 Ti примерно на 2 сантиметра длиннее своего предшественника, GeForce GTX 460 1GB, по крайней мере, в эталонном исполнении. Длина новинки составляет 23 сантиметра, что позволит без проблем установить её в большинство мало-мальски просторных корпусов.

Некоторые проблемы могут возникнуть в корпусах с укороченной базой, поскольку разъёмы питания у GeForce GTX 560 Ti расположены с торцевой стороны платы. Если с эталонным дизайном GeForce GTX 460 это не представляло особой проблемы, то здесь лишняя пара сантиметров может стать решающей. Перед покупкой GeForce GTX 560 Ti не помешает убедиться, что в корпусе есть для неё достаточно места.

Демонтаж системы охлаждения не явил нашему глазу каких-то особенных откровений, разве что порадовал крепёж с помощью обычных крестовых винтов, а не вызывающих закономерное раздражение Torx T2, как в конструкции GeForce GTX 570. Надеемся, что он будет использоваться и дальше.

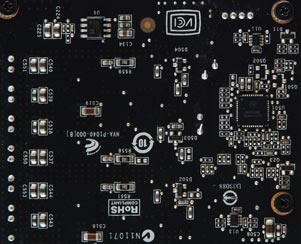

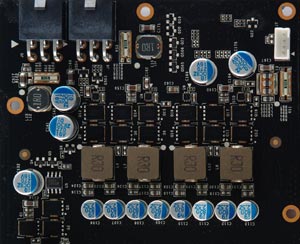

Нельзя сказать, что компоновка печатной платы GeForce GTX 560 Ti претерпела существенные изменения. Один из чипов памяти по-прежнему гордо занимает место по левую сторону от графического процессора, в то время, как остальные семь расположены традиционной буквой "L" сверху и справа. По всей видимости, при разводке новой платы были использованы существенные части эталонного дизайна PCB от GeForce GTX 460. Наибольшие изменения затронули подсистему питания, которая теперь построена по схеме "4+1". С учётом повышенных частот GF114, усиление стабилизатора питания GPU является закономерным шагом со стороны разработчиков.

Сердцем стабилизатора питания графического ядра по-прежнему является контроллер NCP5388 производства ON Semiconductor. За управление питанием памяти отвечает скромный чип Richtek RT8101, расположенный над дросселями основной силовой системы. Как и его предшественник, GeForce GTX 560 Ti использует для подключения к блоку питания два шестиконтактных разъёма PCIe 1.0 с максимальной рекомендуемой нагрузочной способностью 75 Ватт. Места для установки восьмиконтактного разъёма питания PCIe 2.0 в эталонном дизайне не предусмотрено.

В конструкции NVIDIA GeForce GTX 560 Ti использованы широко распространённые чипы производства Samsung Semiconductor серии K4G10325FE. Их можно встретить хотя бы на борту GeForce GTX 580, а также множества других графических карт. Эти микросхемы GDDR5 имеют ёмкость 1 Гбит (32Мх32), а суффикс HC04 указывает на номинальную частоту 1250 (5000) МГц. В энергосберегающих режимах частота памяти может понижаться сперва до 324 (1296) МГц, а затем, в режиме простоя, до 135 (540) МГц. Память связана с графическим процессором 256 битной шиной и работает на частоте 1002 (4008) МГц, что обеспечивает неплохую пиковую пропускную способность всей подсистемы — 128.3 ГБ/сек.

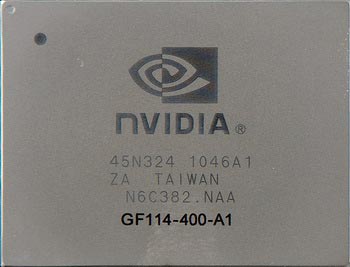

Внешне новый чип ничем не отличается от GF104 и имеет такие же габариты. По официальным данным NVIDIA, площадь самого кристалла осталась прежней, и составляет 360 квадратных миллиметров, но возможности взглянуть на него нет, поскольку кристалл традиционно для мощных решений этого разработчика прикрыт защитной крышкой-теплораспределителем. Маркировка сообщает, что данный экземпляр, имеющий ревизию А1, был выпущен ещё на 46 неделе прошлого года, в середине ноября, то есть, уже тогда ядро GF114 было поставлено на поток. Средняя цифра 400 свидетельствует о том, что чип прошёл наиболее жёсткий частотный контроль, что естественно, ввиду того, что ядро GeForce GTX 560 Ti должно работать на частотах свыше 800/1600 МГц.

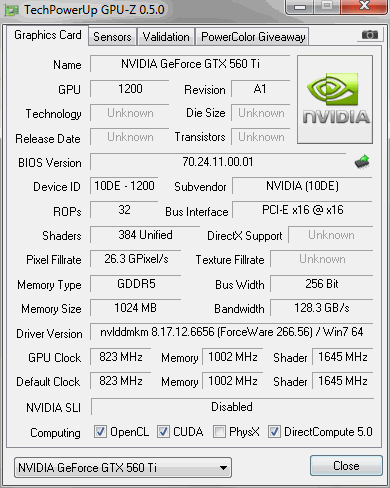

Последняя на момент написания данного обзора версия популярной утилиты GPU-Z пока не очень дружит с GeForce GTX 560 Ti. По понятным причинам она не может отобразить такие параметры, как техпроцесс, площадь кристалла, число транзисторов и дату официального анонса, но пустыми остаются также и поля "DirectX Support" и "Texture Fillrate", а самая нижняя строка ошибочно рапортует об отсутствии поддержки PhysX. Но наиболее важные параметры, такие, как число ALU и тактовые частоты, определяются верно; 1 МГц разницы с официальным значением не следует принимать во внимание.

Дополним сведения тем, что в составе GF114 имеется 64 текстурных процессора, способных на полной скорости осуществлять фильтрацию текстур в формате FP16, поскольку в каждом TMU на один блок адресации текстур приходится четыре блока фильтрации. Правда, такими же возможностями в области работы с текстурами обладал ещё предшественник новинки, чип GF104. Как и у других решений NVIDIA, в режиме декодирования видео высокого разрешения частоты ядра падают до 405/810 МГц, а в режиме простоя опускаются до 51/101 МГц, поэтому в таких режимах от GeForce GTX 560 Ti следует ожидать экономичности на уровне GeForce GTX 460.

Эталонный дизайн GeForce GTX 560 Ti не предусматривает наличия разъёма DisplayPort, хотя сам по себе этот интерфейс чипом поддерживается. Конфигурация разъёмов такая же, как и у старших собратьев по семейству: два порта DVI-I и порт HDMI 1.4a. Весь второй этаж крепёжной планки отдан под прорези для выброса нагретого воздуха за пределы корпуса системы. Количество разъёмов интерфейса MIO ограничено одним, так что собрать конфигурацию SLI более чем с двумя GeForce GTX 560 Ti не получится — это прерогатива старших моделей семейства GeForce 500.

В сравнении с Radeon HD 6000 такой набор коммутационных возможностей смотрится бледно, но, положа руку на сердце, спросим — а многим ли пользователям нужна поддержка одновременно 6 мониторов или возможность подключения дисплеев "цепочкой" по DisplayPort? Основная масса игроков использует один, редко два монитора с интерфейсом DVI, а панели с большой диагональю подключаются по HDMI. С этой точки зрения GeForce GTX 560 Ti действительно можно назвать соответствующим принципу "разумной достаточности". Сам по себе чип поддерживает DisplayPort 1.1, и в будущем, ряд моделей GeForce GTX 560 с нестандартным дизайном наверняка будет оснащён соответствующим разъёмом.

К сожалению, в конструкции эталонной системы охлаждения GeForce GTX 560 Ti команда разработчиков NVIDIA решила не повторять удачную находку с испарительной камерой, столь хорошо зарекомендовавшей себя в системах охлаждения GeForce GTX 580 и 570. В данном же случае используется более консервативная конструкция с круглым центральным радиатором, напоминающим радиаторы боксовых кулеров Intel. С помощью трёх тепловых трубок центральная секция соединяется с двумя дополнительными дугообразными радиаторами. Обдув последних осуществляется за счёт того, что обычный осевой вентилятор дует не только вниз, но и в стороны. Отметим, что часть нагретого воздуха при такой компоновке будет выбрасываться вправо, во внутреннее пространство корпуса.

Основание системы охлаждения выглядит вполне обычно. Алюминиевая рама служит теплоотводом для микросхем памяти и силовых элементов подсистемы питания, для чего в соответствующих местах предусмотрены выступы, снабжённые эластичными термопрокладками. В месте контакта медного основания главного радиатора с крышкой GPU нанесён слой густой серой термопасты.

На наш взгляд, такая конструкция системы охлаждения выглядит странно, особенно с учётом чрезвычайно удачных кулеров, которым оснащаются старшие модели семейство GeForce 500. Мы не представляем, что могло помешать инженерам NVIDIA применить испарительную камеру и в кулере GeForce GTX 560 Ti, возможно, более высокая себестоимость такой системы. Тем не менее, следует воздержаться от необоснованной критики и проверить, как описанная конструкция поведёт себя на практике.

Уровень энергопотребления, тепловой режим, шумность и разгон

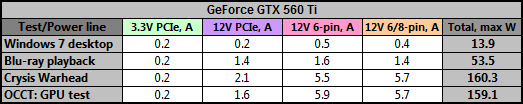

Несмотря на существенно возросшие тактовые частоты GF114, NVIDIA заявляет лишь о незначительном повышении TDP — со 160 до 170 Ватт. Исходя из того, что уровень тепловыделения напрямую зависит от уровня энергопотребления, логично было бы предположить, что и уровень энергопотребления GeForce GTX 560 Ti если и повысился, то столь же незначительно. Мы не преминули проверить это предположение на практике, проведя стандартный цикл электрических испытаний новинки на хорошо знакомом нашим читателям стенде, имеющем следующую конфигурацию.

Процессор Intel Core 2 Quad Q6600 (3 ГГц, 1333 МГц FSB x 9, LGA775)

Системная плата DFI LANParty UT ICFX3200-T2R/G (ATI CrossFire Xpress 3200)

Память PC2-1066 (2x2 ГБ, 1066 МГц)

Блок питания Enermax Liberty ELT620AWT (Номинальная мощность 620 Ватт)

Microsoft Windows 7 Ultimate 64-bit

CyberLink PowerDVD 9 Ultra/"Serenity" BD (1080p VC-1, 20 Мбит)

Crysis Warhead

OCCT Perestroika 3.1.0

Данная платформа оснащена специальным измерительным модулем, описанным в обзоре "Энергопотребление компьютеров: так сколько нужно ватт?". Его использование позволяет получить наиболее полные данные об электрических характеристиках современных графических карт в различных режимах. Как обычно, для создания нагрузки на видеоадаптер в различных режимах были использованы следующие тесты:

CyberLink PowerDVD 9: FullScreen, аппаратное ускорение включено

Crysis Warhead: 1600x1200, FSAA 4x, DirectX 10/Enthusiast, карта "frost"

OCCT Perestroika GPU: 1600x1200, FullScreen, Shader Complexity 8

Для каждого режима, за исключением симуляции предельной нагрузки в OCCT, замеры проводились в течение 60 секунд; во избежание выхода карты из строя вследствие перегрузки цепей питания, для теста OCCT: GPU время тестирования было ограничено 10 секундами. В результате проделанных измерений были получены следующие результаты:

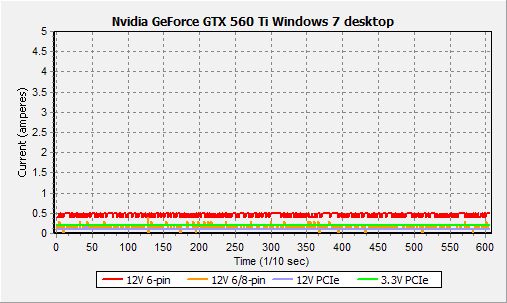

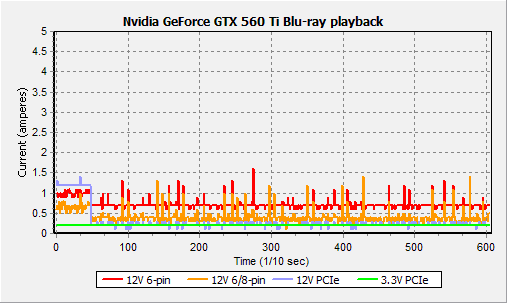

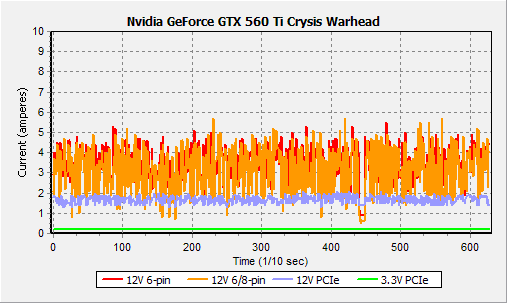

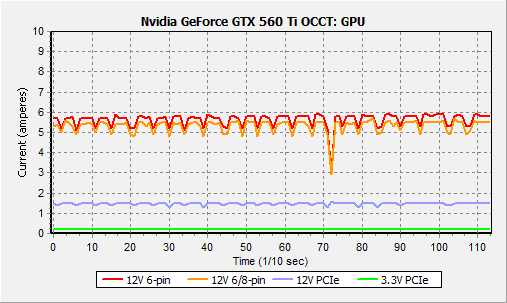

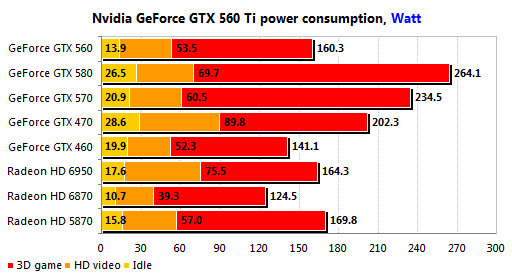

Разумеется, даром увеличение количества активных функциональных блоков и существенный прирост тактовых частот не прошли, и в режиме 3D пиковый уровень энергопотребления GeForce GTX 560 Ti вырос до 160 Ватт, в то время, как аналогичный показатель GeForce GTX 460 1GB составлял около 140 Ватт. Однако, это приемлемая плата за столь серьёзное улучшение технических характеристик. А в режиме "рабочего стола" экономичность новинки даже выросла. Как обычно, в случае, когда задействован видеопроцессор, карта снижает тактовые частоты не сразу, но тестовая установка фиксирует пиковый результат, в то время, как средний составляет примерно 18-25 Ватт. Отдельно надо отметить, что при одновременном подключении двух мониторов с разными разрешениями, GeForce GTX 560 Ti не переходит во второй экономичный режим с частотами ядра 51/101 МГц, а ограничивается первым, в котором они составляют 405/810 МГц.

Интересно, что в экономичных режимах основная нагрузка приходится на нижний разъём, обозначенный на диаграммах, как "12V 6-pin", а вот при использовании всех мощностей графического процессора нагрузка выравнивается, и через каждый разъём протекает ток порядка 5.5-5.9 Ампер. Иными словами, при напряжении 12 Вольт нагрузка на разъёмы питания не превышает 70 Ватт, так что необходимости использования в конструкции GeForce GTX 560 Ti восьмиконтактных разъёмов питания PCIe 2.0 с повышенной нагрузочной способностью действительно нет.

Как и старшие модели семейства, эталонная версия GeForce GTX 560 Ti умеет отслеживать протекающий по 12-вольтовым линиям питания ток, и в случае обнаружения аномально высоких показателей, характерных для таких тестов, как OCCT: GPU или FurMark, защищает сама себя от выхода из строя путём перевода графического процессора в режим пониженной производительности. Эта система опциональна, и в версиях GeForce GTX 560 Ti, использующих отличный от эталонного дизайн печатной платы, может не использоваться. Работа защитного механизма хорошо видна на вышеприведённой диаграмме потребления в тесте OCCT:GPU — график демонстрирует характерную "гребёнку", хотя и менее глубокую, нежели в случае с GeForce GTX 580 или GeForce GTX 570.

Мы считаем использование таких защитных механизмов оправданным шагом со стороны производителей, поскольку нереалистичные сценарии нагрузки, создаваемые тестами типа FurMark, действительно могут вывести графическую карту из строя, и такие случаи нам известны. Любителям стресс-тестов можно лишь порекомендовать на свой страх и риск воспользоваться специальными опциями, как, например, в GPU-Z; наверняка, разработчики этой утилиты реализуют аналогичную возможность и для GeForce GTX 560 Ti.

В целом, новый GeForce GTX 560 Ti в плане энергопотребления в различных режимах смотрится вполне конкурентоспособно на фоне соперников. Конечно, он не столь экономичен, как Radeon HD 6870, однако, он обещает быть и существенно быстрее в играх. Более того, новинка весьма достойно выглядит даже в сравнении с Radeon HD 6950, так что разработчиков GF114 остаётся лишь похвалить за проделанную работу. С точки зрения экономичности GeForce GTX 560 Ti продолжает добрую традицию, заложенную с выпуском GeForce GTX 580, заключающуюся в значительном увеличении производительности при несущественном повышении уровня энергопотребления.

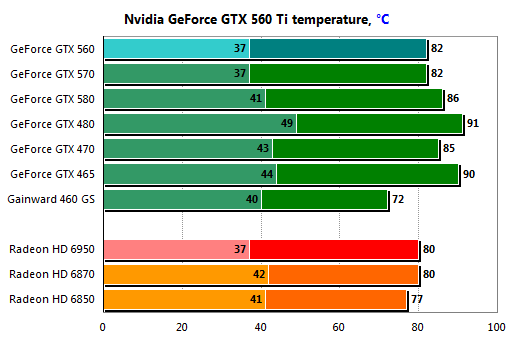

Для проверки температурного режима мы использовали второй эталонный экземпляр GeForce GTX 560 Ti, не подвергавшийся разборке, и, следовательно, сохранивший оригинальный термоинтерфейс. При температуре воздуха в помещении тестовой лаборатории, составлявшей 25-27 градусов Цельсия, новинка продемонстрировала такие же тепловые показатели, как и GeForce GTX 570. Под нагрузкой температура графического процессора не превысила 78 градусов Цельсия. С учётом тактовых частот GeForce GTX 560 Ti, это является весьма впечатляющим показателем, доказывающим, что использованная разработчиками конструкция системы охлаждения хорошо справляется со своей работой.

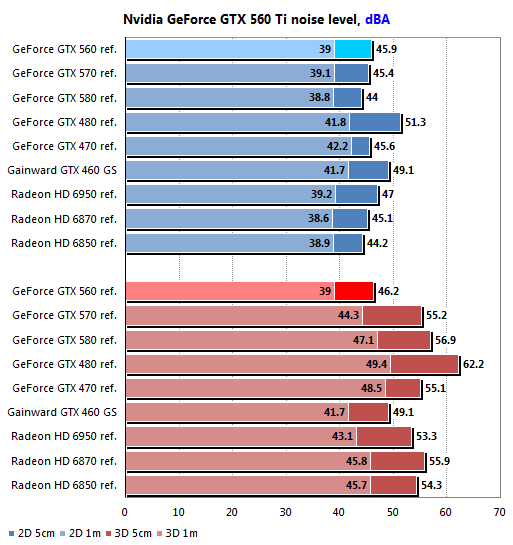

К счастью, первоначальные опасения насчёт повышенного уровня шума не подтвердились. В режимах 2D и 3D карта шумит практически одинаково, поскольку в первом случае вентилятор работает на 40 % от максимальной скорости, а во втором скорость не растет выше 45 %, несмотря на использование в качестве нагрузки Crysis Warhead. Шумомер едва фиксирует изменения в уровне шума, да и то, лишь на расстоянии 5 сантиметров от работающей системы. На расстоянии 1 метра уровень шума лишь на 1 дБА превышает эталонный показатель, в наших условиях составляющий 38 дБА. При таких шумовых характеристиках неудивительно, что карту не слышно на фоне шума, издаваемого другими компонентами работающей тестовой системы. Надо сказать, что наша тестовая платформа не относится к числу самых тихих, так что в иных условиях GeForce GTX 560 Ti может вести себя и не столь бесшумно. Но, в любом случае, новинка обладает тихим нравом, что особенно оценят игроки, любящие, когда на звуковое сопровождение игры не накладываются посторонние шумы.

Как и его старшие собратья по семейству, GeForce GTX 560 Ti продемонстрировал великолепную сбалансированность электрических, акустических и тепловых характеристик. Теперь перед ним стоит самая сложная задача: достойно показать себя в боевых условиях.

Конфигурация тестовых платформ и методология тестирования

Тестирование GeForce GTX 560 Ti в современных играх было проведено на универсальной тестовой платформе, имеющей следующую конфигурацию:

Процессор Intel Core i7-975 Extreme Edition (3.33 ГГц, 6.4 GT/s QPI)

Кулер Scythe SCKTN-3000 "Katana 3"

Системная плата Gigabyte GA-EX58-Extreme (Intel X58)

Память Corsair XMS3-12800C9 (3x2 ГБ, 1333 МГц, 9-9-9-24, 2Т)

Жесткий диск Samsung Spinpoint F3 (1 ТБ/32 МБ, SATA II)

Блок питания Ultra X4 850W Modular (Номинальная мощность 850 Ватт)

Монитор Dell 3007WFP (30”, максимальное разрешение 2560x1600@60 Гц)

Microsoft Windows 7 Ultimate 64-bit

Использовались следующие версии драйверов ATI Catalyst и NVIDIA GeForce:

ATI Catalyst 11.1a hotfix для ATI Radeon HD

NVIDIA GeForce 266.56 для NVIDIA GeForce GTX 560 Ti

Сами драйверы были настроены следующим образом:

ATI Catalyst:

Anti-Aliasing: Use application settings/4x/Standard Filter

Morphological filtering: Off

Tesselation: Use application settings

Texture Filtering Quality: High Quality

Enable Surface Format Optimization: Off

Wait for vertical refresh: Always Off

Anti-Aliasing Mode: Adaptive Multi-sample AA

Остальные настройки: по умолчанию

NVIDIA GeForce:

Texture filtering – Quality: High quality

Vertical sync: Force off

Antialiasing - Transparency: Multisampling

CUDA - GPUs: All

Set PhysX configuration: Auto-select

Ambient Occlusion: Off

Остальные настройки: по умолчанию

В состав тестового пакета вошли следующие игры и приложения:

Трехмерные шутеры с видом от первого лица:

Aliens vs. Predator (1.0.0.0, Benchmark)

Battlefield: Bad Company 2 (1.0.1.0, Fraps)

Call of Duty: Black Ops (1.04, Fraps)

Crysis Warhead (1.1.1.711, Benchmark)

Metro 2033 (Ranger Pack, 1.02, Benchmark)

S.T.A.L.K.E.R.: Call of Pripyat (1.6.02, Fraps)

Трехмерные шутеры с видом от третьего лица:

Just Cause 2 (1.0.0.1, Benchmark/Fraps)

Lost Planet 2 (1.1, Benchmark)

RPG:

Fallout: New Vegas (1.20, Fraps)

Mass Effect 2 (1.01, Fraps)

Симуляторы:

F1 2010 (1.01, Fraps)

Стратегические игры:

BattleForge (1.2, Benchmark)

StarCraft II: Wings of Liberty (1.0.2, Fraps)

Полусинтетические и синтетические тесты:

Futuremark 3DMark Vantage (1.0.2.1)

Futuremark 3DMark 11 (1.0.0)

Final Fantasy XIV Official Benchmark (1.0.0.0, Fraps)

Unigine Heaven Benchmark (2.1)

Tom Clancy's H.A.W.X. 2 Benchmark (1.01, Benchmark/Fraps)

Каждая из входящих в набор тестового программного обеспечения игр была настроена таким образом, чтобы обеспечивать максимально возможный уровень детализации. В приложениях, поддерживающих тесселяцию, эта возможность была задействована.

Принципиальный отказ от ручной модификации каких-либо конфигурационных файлов означает, что для настройки использовались исключительно средства, доступные в самой игре любому непосвящённому пользователю. Тестирование проводилось в разрешениях 1600х900, 1920х1080 и 2560х1600. За исключением отдельно оговоренных случаев, стандартную анизотропную фильтрацию 16х дополняло сглаживание MSAA 4x. Активация сглаживания осуществлялась либо средствами самой игры, либо, при их отсутствии, форсировалась с помощью соответствующих настроек драйверов ATI Catalyst и NVIDIA GeForce.

Помимо NVIDIA GeForce GTX 560 Ti, в тестировании приняли участие следующие графические карты:

NVIDIA GeForce GTX 460 1GB

NVIDIA GeForce GTX 570

ATI Radeon HD 6950

ATI Radeon HD 6870

Для получения данных о производительности использовались встроенные в игру средства тестирования с обязательным применением оригинальных тестовых роликов, а также, по возможности, фиксацией данных о минимальной производительности. В отдельных случаях для получения информации о минимальной производительности дополнительно применялась тестовая утилита Fraps 3.2.7. В случае отсутствия вышеупомянутых средств применялась эта же утилита в ручном режиме с трёхкратным тестовым проходом, фиксацией минимальных значений и последующим усреднением финального результата.

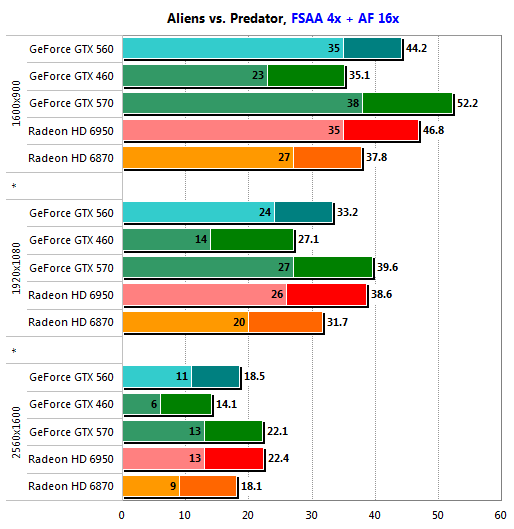

Игровые тесты: Aliens vs. Predator

Новинка начинает с того, что оставляет позади Radeon HD 6870 в низких разрешениях, и там же уступает Radeon HD 6950 лишь около 5 %. В разрешении 1920х1080 отставание от Radeon HD 6950 возрастает до 14 %, а средняя производительность становится практически такой же, как у Radeon HD 6870. Однако, тут обнаруживается приятный для поклонников продукции NVIDIA нюанс — минимальная производительность у GeForce GTX 560 Ti не опускается ниже 24 кадров в секунду, поэтому играть в режиме Full HD можно ничуть не хуже, нежели используя более дорогой Radeon HD 6950, причём, при заметно меньших затратах на покупку видеокарты.

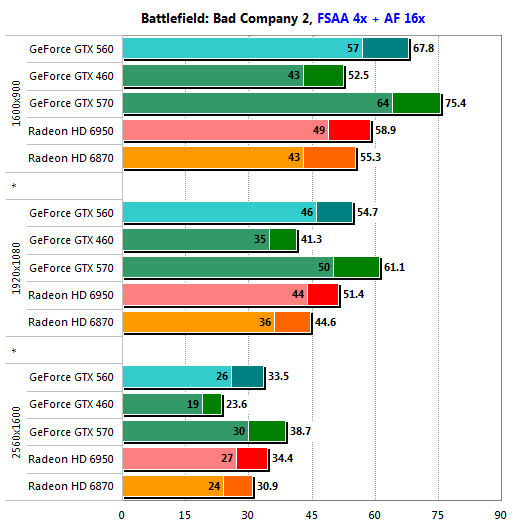

Игровые тесты: Battlefield: Bad Company 2

Уже во втором тесте GeForce GTX 560 Ti на равных сражается с Radeon HD 6950, причём, весьма успешно. Новинка добивается паритета в разрешении 2560х1600, а в более низких разрешениях даже опережает своего соперника из более тяжёлой "весовой категории". Что немаловажно, ей удаётся поддерживать комфортный уровень производительности во всех режимах.

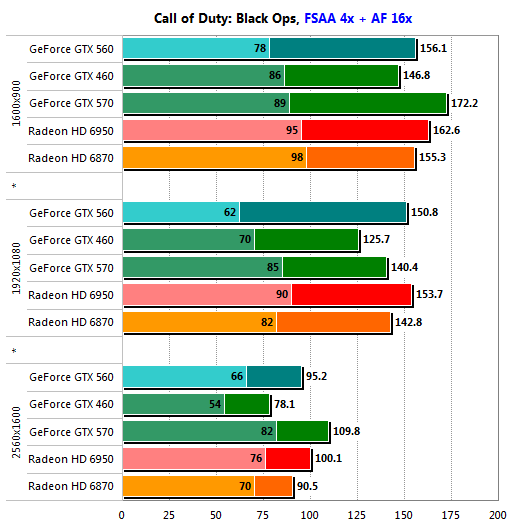

Игровые тесты: Call of Duty: Black Ops

Интересно, что с использованной в тестировании версией драйверов AMD Catalyst, показали Radeon HD 6950 ненамного выше, нежели у Radeon HD 6870, что отчасти может быть обусловлено и меньшей эффективностью шейдерных процессоров Cayman, имеющих архитектуру VLIW4. Так или иначе, GeForce GTX 560 Ti легко может составить конкуренцию обоим соперникам из стана AMD, уступая им, разве что, в минимальной производительности, да и то не фатально — 66 кадров в секунду хватит даже самому требовательному игроку.

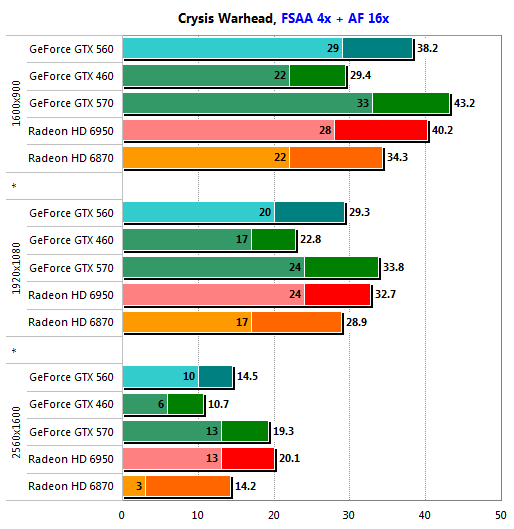

Игровые тесты: Crysis Warhead

А вот и первое разочарование. Поражением это назвать нельзя, особенно, учитывая разницу в цене с Radeon HD 6950, однако, факт остаётся фактом: в разрешении 1920х1080 новый GeForce GTX 560 Ti уже не может обеспечить приемлемого уровня минимальной производительности, хотя и опережает по этому показателю Radeon HD 6870. Зато, в отличие от последнего, новинка отлично выглядит в разрешении 1600х900. Здесь с ней действительно может поспорить лишь более дорогой Radeon HD 6950.

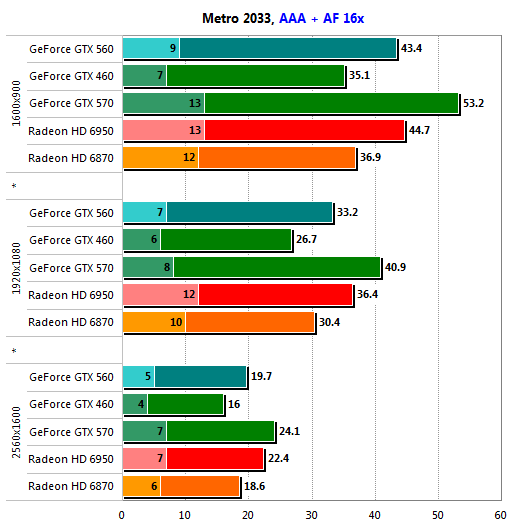

Игровые тесты: Metro 2033

Игра тестируется с включенной тесселяцией.

Наличие восьми блоков тесселяции не спасает GeForce GTX 560 Ti от поражения при сравнении минимальной производительности, однако, средние показатели новинки лишь немногим хуже, нежели демонстрируемые Radeon HD 6950, и заметно лучше результатов, показанных в этом тесте Radeon HD 6870. Наиболее сильный отрыв от соперника наблюдается в разрешении 1600х900, но в более ресурсоёмких режимах решению AMD удаётся сократить отставание до минимума. Возможно, это заслуга более производительной подсистемы памяти.

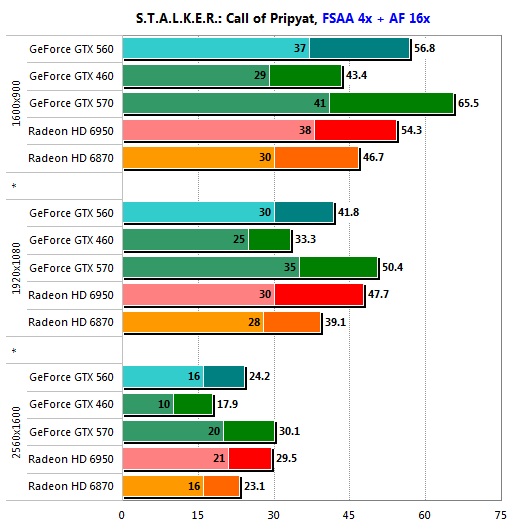

Игровые тесты: S.T.A.L.K.E.R.: Call of Pripyat

Игра тестируется с включенной тесселяцией.

Теоретически, у GeForce GTX 560 Ti есть преимущество при выполнении тесселяции, но, по крайней мере, в данном тесте, два блока тесселяции третьего поколения на борту Radeon HD 6950 показывают себя не хуже. Но не стоит забывать о цене: будучи почти на 50 долларов дешевле, новое решение NVIDIA легко спорит на равных с Radeon HD 6950 в разрешении 1600х900 и обеспечивает сопоставимый уровень субъективного комфорта в разрешении 1920х1080. Свою цену GeForce GTX 560 Ti отрабатывает сполна.

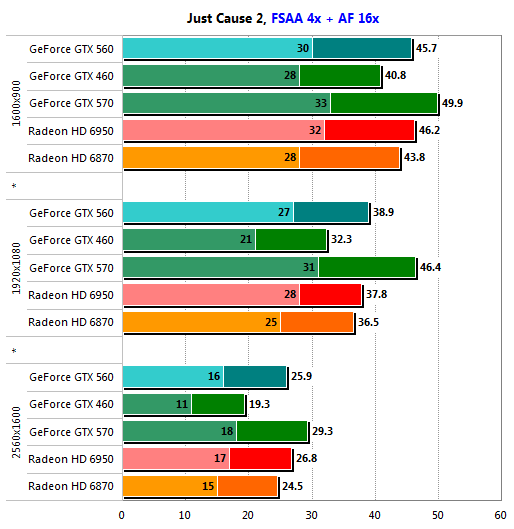

Игровые тесты: Just Cause 2

Разница в производительности между двумя поколениями Radeon HD 6000 вновь минимальна, и GeForce GTX 560 Ti успешно конкурирует с обоими, обеспечивая комфортную производительность в разрешениях вплоть до 1920х1080 или 1920х1200 включительно. А вот для игры в 2560х1600 понадобится уже решение уровня GeForce GTX 580, имеющее совсем другую цену.

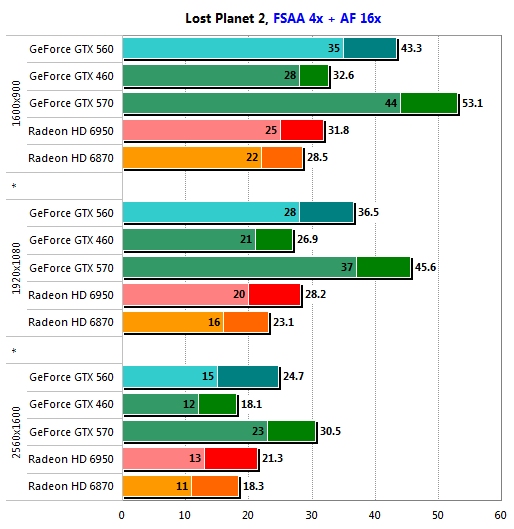

Игровые тесты: Lost Planet 2

Radeon HD 6950 разгромлен более дешёвым GeForce GTX 560 Ti наголову. Если в разрешении 2560х1600 решение AMD ещё пытается сопротивляться за счёт резервов в производительности текстурной подсистемы и подсистемы памяти, то в менее критичных к этим параметрам режимах преимущество новинки NVIDIA может достигать 30-36%! Что более важно, производительность GeForce GTX 560 Ti достаточно высока для использования разрешения 1920х1080, несмотря на требовательность данной игры.

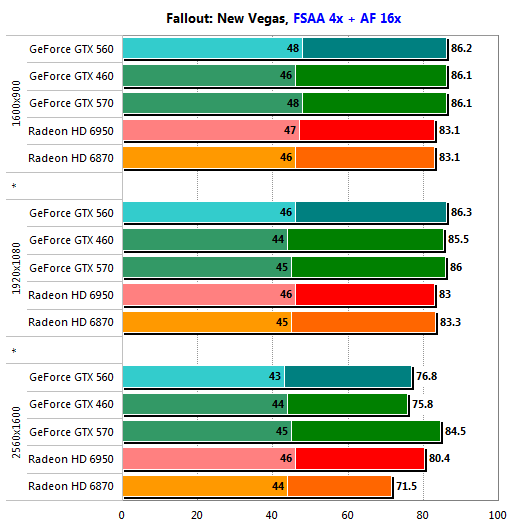

Игровые тесты: Fallout: New Vegas

Сказать что-либо о производительности GeForce GTX 560 Ti в Fallout: New Vegas сложно. Игра слишком проста для любой достаточно мощной современной графической карты. Можно лишь отметить несущественное отставание от Radeon HD 6950 и столь же несущественное превосходство над Radeon HD 6870 в разрешении 2560х1600.

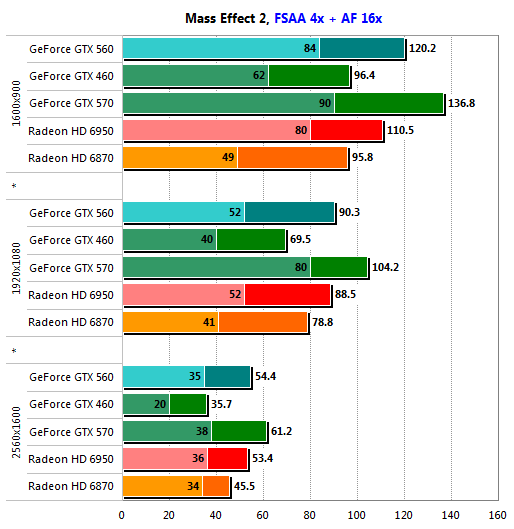

Игровые тесты: Mass Effect 2

В этом тесте полноэкранное сглаживание форсируется с использованием методики, описанной в обзоре Игра Mass Effect 2 и современные видеокарты.

Победа новинки не столь убедительна, как в Lost Planet 2, но в разрешении 1600х900 GeForce GTX 560 Ti доминирует над обоими моделями Radeon HD 6000, участвующими в сегодняшнем тестировании. В более высоких разрешениях герой данного обзора, как минимум, не уступает более дорогому Radeon HD 6950, так что AMD остаётся только обеспокоиться и всерьёз задуматься о снижении цен на решения на базе ядра Cayman.

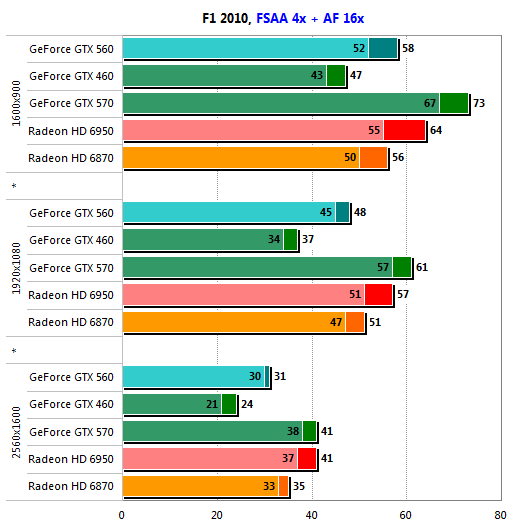

Игровые тесты: F1 2010

Нельзя быть победителем во всём, и GeForce GTX 560 Ti подтверждает этот тезис. В данном тесте новинка конкурирует только с Radeon HD 6870. Но, во-первых, именно на конкуренцию с Radeon HD 6870 это решение NVIDIA и нацелено изначально, во-вторых, заметное отставание наблюдается только в разрешении 2560х1600, и, наконец, в третьих, даже в этом разрешении производительность остаётся достаточно комфортной, хотя требовательным любителям жанра гоночных автосимуляторов 30 кадров в секунду может оказаться недостаточно.

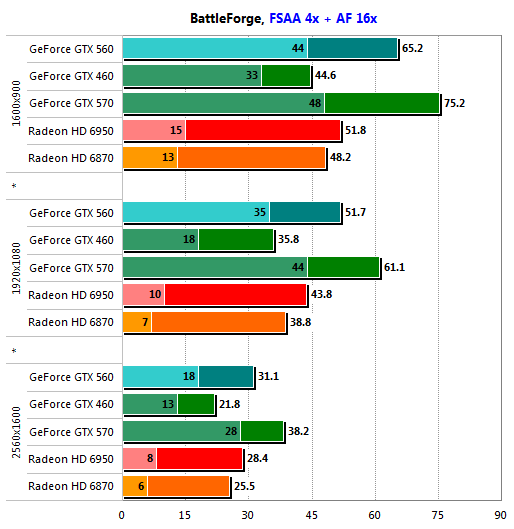

Игровые тесты: BattleForge

Пополнение семейства GeForce 500 поддерживает традицию обеспечения высокой минимальной производительности. Правда, с разрешением 2560х1600 GeForce GTX 560 Ti справляется уже не так хорошо, как GeForce GTX 570, однако, на фоне показателей Radeon HD 6870 или Radeon HD 6950 и 18 кадров в секунду выглядят настоящим откровением, тем более, что по субъективным ощущениям, в эту игру можно играть даже при низкой минимальной производительности.

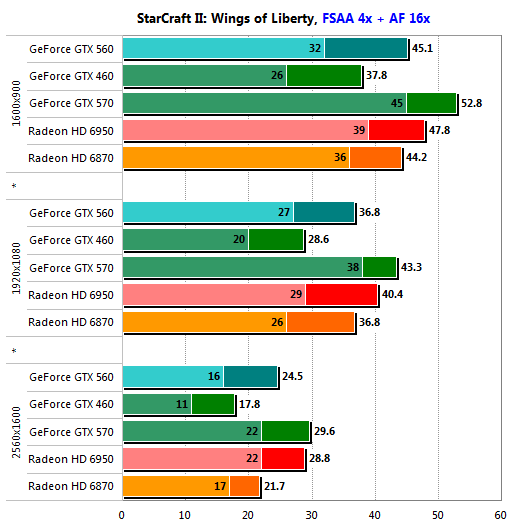

Игровые тесты: StarCraft II: Wings of Liberty

В StarCraft II новинке NVIDIA не хватило сил достойно справиться с разрешением 2560х1600, но в средней производительности она всё же опередила своего прямого соперника в лице Radeon HD 6870. Надо сказать, что и Radeon HD 6950 в этом режиме не хватает с неба звёзд, но всё же, уровень субъективного комфорта, обеспечиваемый им, существенно выше. Правда, за большую цену. В более низких разрешениях GeForce GTX 560 Ti проявил себя очень хорошо. Если ваш монитор поддерживает разрешение до 1920х1200 включительно и вы любите StarCraft II, переплачивать за Radeon HD 6950 нет никакого смысла.

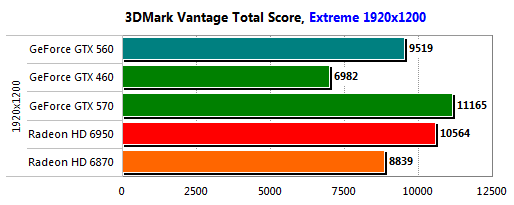

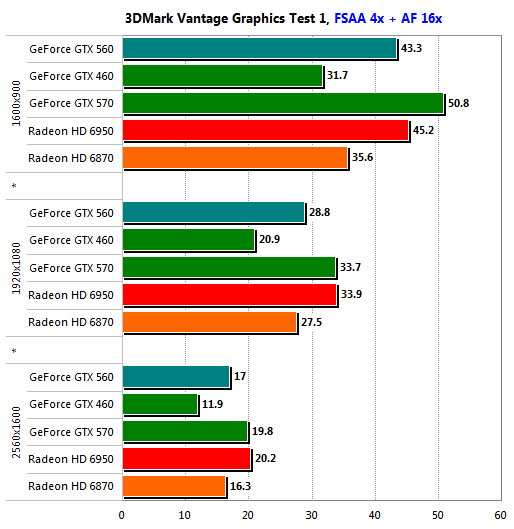

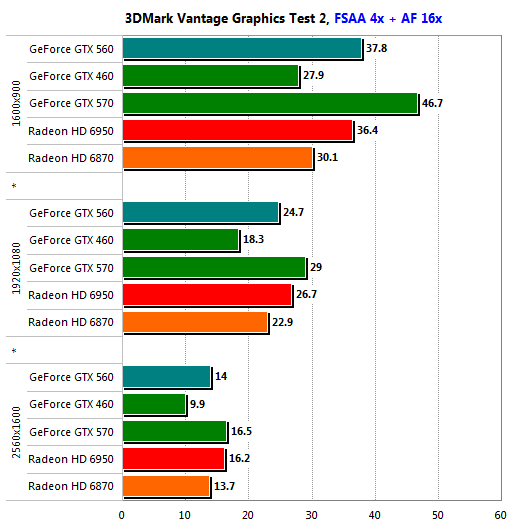

Полусинтетические и синтетические тесты: Futuremark 3DMark Vantage

Чтобы минимизировать влияние центрального процессора, при тестировании в 3DMark Vantage применяется профиль “Extreme”, использующий разрешение 1920х1200, FSAA 4x и анизотропную фильтрацию. Для полноты картины производительности, результаты отдельных тестов снимаются во всем диапазоне разрешений.

Как и ожидалось, GeForce GTX 560 Ti опередил Radeon HD 6870, но ему не хватило 1045 очков до уровня Radeon HD 6950. Для ценовой категории, к которой относится новинка, 9519 очков — очень хороший показатель.

В отдельных тестах видно, что в разрешении 1600х900 новый GeForce GTX 560 Ti если и уступает Radeon HD 6950, то совсем незначительно, но с ростом разрешения последний берёт реванш за счет более производительных подсистем текстурных процессоров и видеопамяти. Radeon HD 6870 новинка не проиграла ни разу.

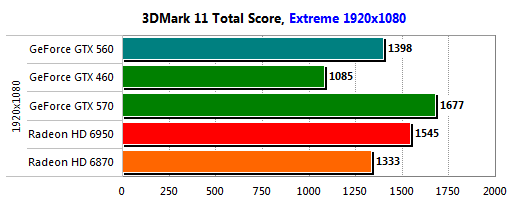

Полусинтетические и синтетические тесты: Futuremark 3DMark 11

В новом тестовом пакете Futuremark мы также применяем профиль "Extreme", однако, в отличие от 3DMark Vantage, в 3DMark 11 он использует разрешение 1920х1080.

Примерно такая же картина, как в 3DMark Vantage, наблюдается и в 3DMark 11, за исключением того, что сам порядок величин в новой версии 3DMark другой. Своему прямому сопернику GeForce GTX 560 Ti не уступил, а состязаться на равных в синтетических тестах с более дорогим Radeon HD 6950 он и не обязан.

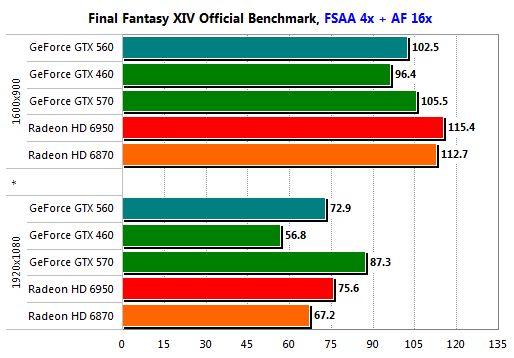

Полусинтетические и синтетические тесты: Final Fantasy XIV Official Benchmark

Тест поддерживает только разрешения 1280х720 и 1920х1080.

Результат Radeon HD 6950 в разрешении 1280х720 неожиданно низок. В этом можно винить как новую архитектуру шейдерных процессоров, так и недоработки в драйверах. GeForce GTX 560 Ti выступает достойно в обоих разрешениях, демонстрируя показатели на уровне Radeon HD 6950.

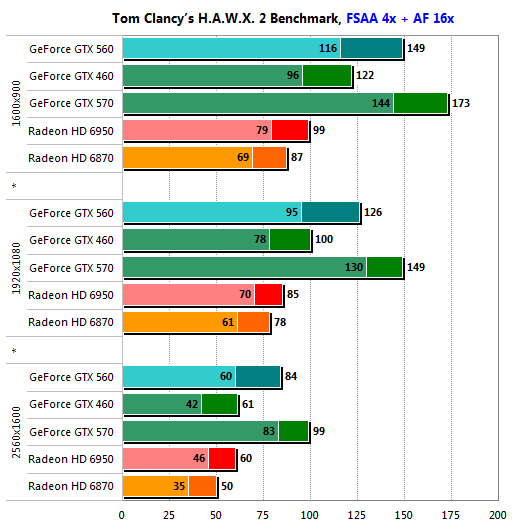

Полусинтетические и синтетические тесты: Tom Clancy's H.A.W.X. 2 Preview Benchmark

Данный тест активно использует тесселляцию для отрисовки поверхности земли. Количество полигонов в кадре может достигать полутора миллионов.

Ещё один тест, где архитектура Fermi чувствует себя, как дома. Состязаться с GeForce GTX 560 Ti могут лишь старшие собратья по семейству, но не Radeon HD 6950 или даже Radeon HD 6970. Вероятно, ситуацию сможет переломить лишь Radeon HD 6990, но если это и случится, то победа будет поистине пирровой, ибо о разнице в ценах между ним и GeForce GTX 560 Ti страшно даже подумать.

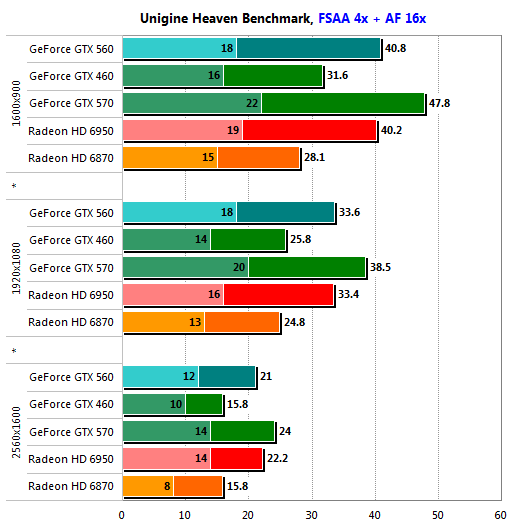

Полусинтетические и синтетические тесты: Unigine Heaven benchmark

В тесте используется режим тесселяции "normal".

Производительность на уровне Radeon HD 6950 — отличный результат для GeForce GTX 560 Ti, особенно с учётом ценовой категории, к которой последний относится, но всё же, в этом тесте, активно использующем тесселяцию, от GF114, вооружённого восемью движками PolyMorph, мы ожидали большего.

Заключение

Новый NVIDIA GeForce GTX 560 Ti не разочаровал: его вполне можно назвать достойным пополнением семейства GeForce 500. Более того, титул "оружие массового поражения", на наш взгляд, неплохо характеризует новинку. И неудивительно — при том, что рекомендуемая цена GeForce GTX 560 Ti cоставляет всего 249 долларов, он способен бороться на равных не только с Radeon HD 6870, против которого изначально и был нацелен, но и с более мощным и дорогим Radeon HD 6950!

По сути, новый GeForce GTX 560 Ti сделал то же самое с GeForce GTX 470, что ранее GeForce GTX 570 сделал с GeForce GTX 480. Что при этом произойдёт с GeForce GTX 460 1GB, пока точно сказать невозможно. Не исключено, что он будет заменён новым решением на базе GF114 с усечённой конфигурацией и без приставки "Ti" в названии, а на смену GeForce GTX 460 768MB придёт GeForce GTS 550 на базе ядра GF116.

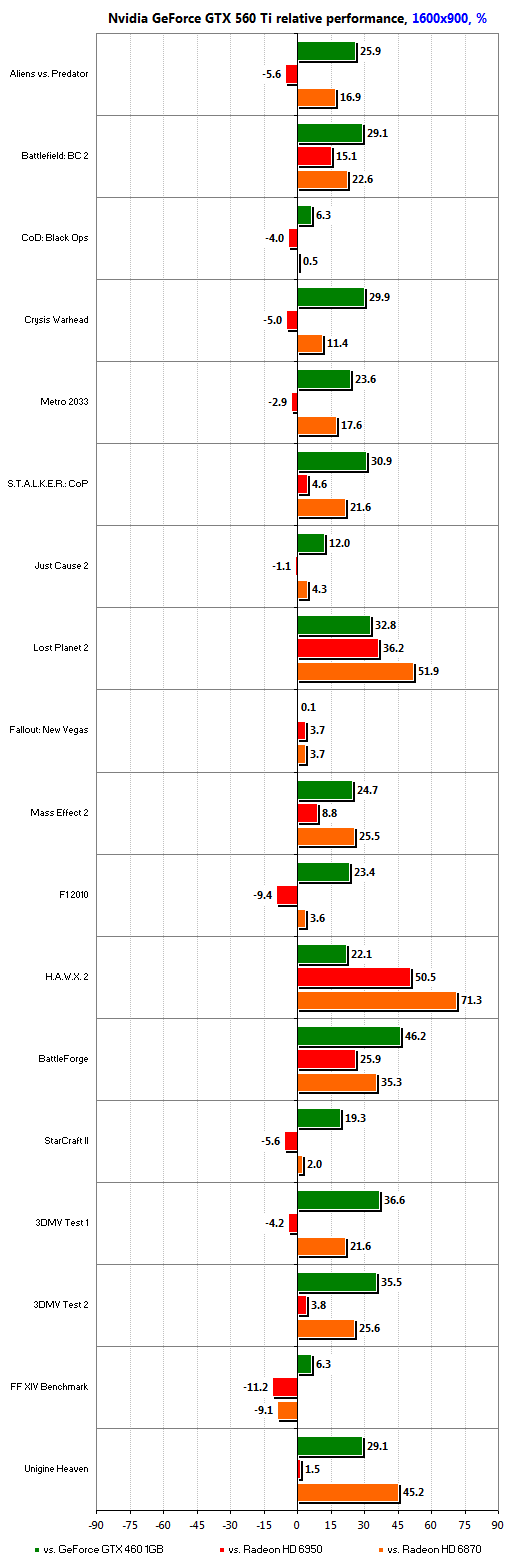

Рассматривая вопрос о производительности новинки детально, нельзя однозначно сказать, что GeForce GTX 560 Ti опережает Radeon HD 6950 во всех тестах: всё же, ядро Cayman изначально предназначено для решений более высокого класса. Однако, полученные результаты весьма и весьма впечатляют:

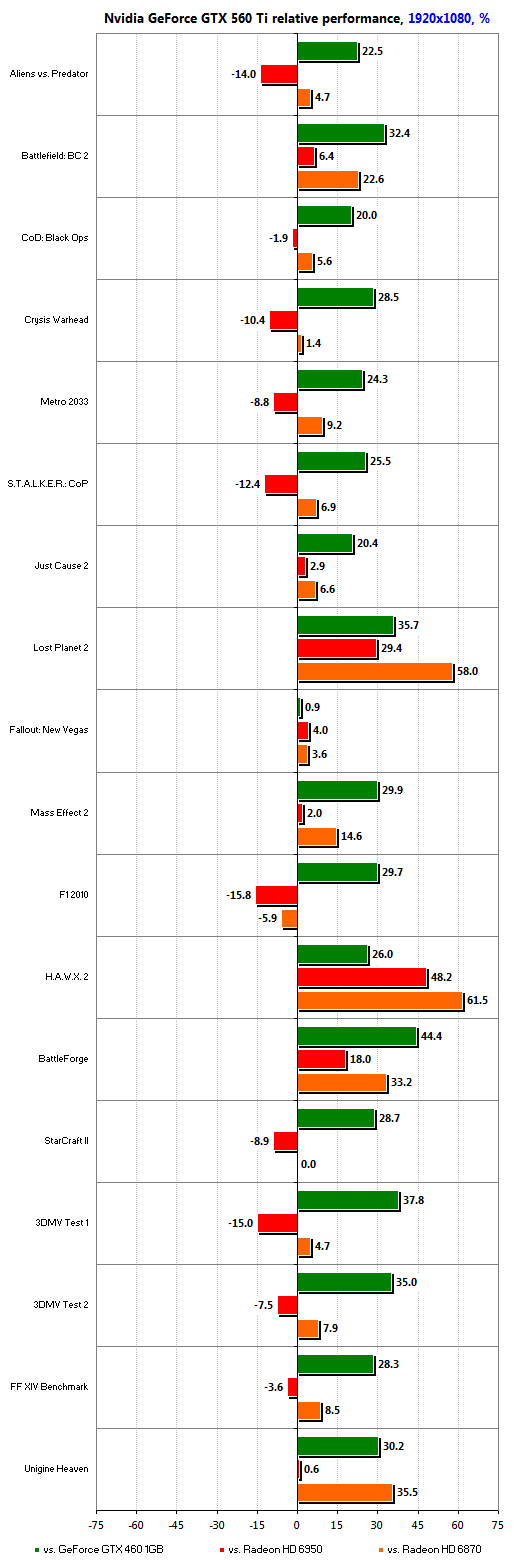

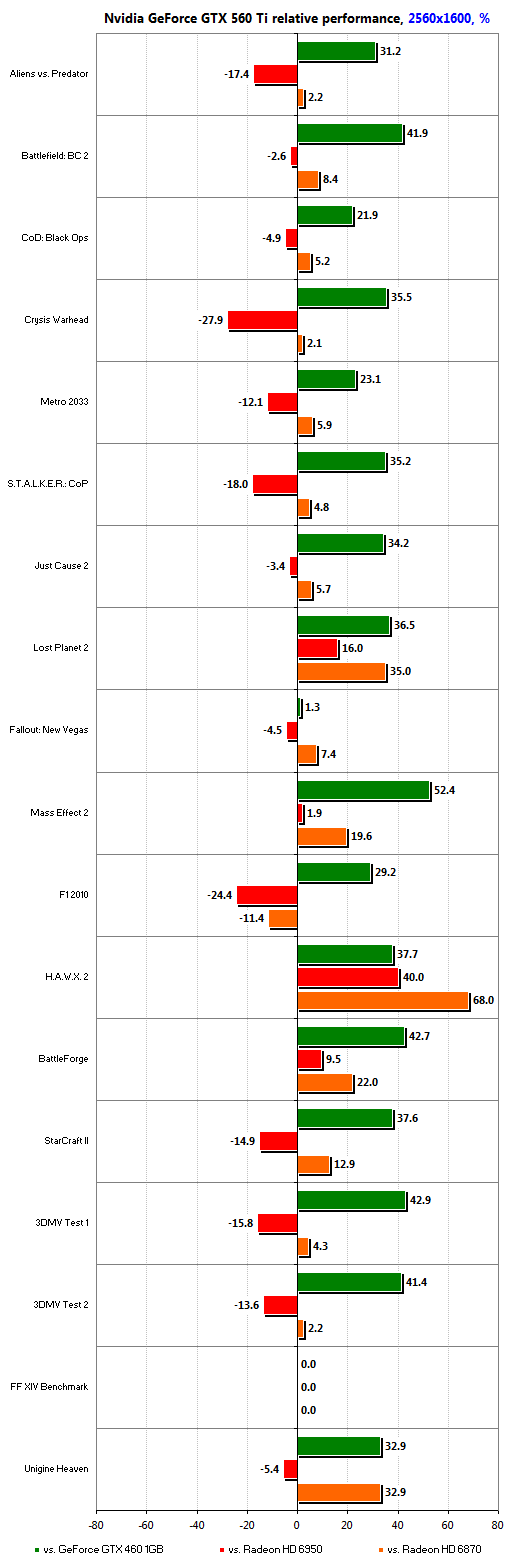

В частности, в разрешении 1600х900 новинке удалось выиграть у соперника из более тяжёлой весовой категории в десяти тестах из восемнадцати, а среднее преимущество над Radeon HD 6870 составило почти 20 %. И хотя карты такого класса, как правило, покупают для использования в более высоких разрешения, это очень хорошее начало.

Разрешение 1920х1080 является на сегодня самым популярным из-за повсеместного торжества формата Full HD. Здесь GeForce GTX 560 Ti тяжелее сражаться с Radeon HD 6950, поскольку последний оснащён более быстрой памятью и располагает 88 текстурными процессорами. Однако, без боя новинка не сдаётся, и ей удаётся сравнять счёт или выйти в лидеры в восьми игровых тестах, а серьёзно проиграть лишь в четырёх: в Alien vs. Predator, S.T.A.L.K.E.R.: Call of Pripyat, Mass Effect 2 и F1 2010. Итоговый список поединков с Radeon HD 6870 и вовсе состоял бы из одних побед и ничьих, если бы не F1 2010. В среднем, своего прямого соперника GeForce GTX 560 Ti опережает на 15 %, а максимальное превосходство может достигать и весьма внушительных 60 %!

В разрешении 2560х1600 карты уровня GeForce GTX 560 Ti или Radeon HD 6870, стоимость которых не превышает 250 долларов, как правило, не используются. Это уже вотчина решений, чья стоимость начинается от 300 долларов. Вполне закономерно, что здесь GeForce GTX 560 Ti в большинстве тестов проигрывает Radeon HD 6950, однако, превосходство над Radeon HD 6870 он сохраняет, хотя в среднем оно и падает до 12-13 %.

Подведя итоги, мы можем сказать, что новое массовое решение NVIDIA получилось очень и очень удачным. При своих скоростных характеристиках и цене, всего на 10 долларов превышающей официальную стоимость Radeon HD 6870, оно не оставляет последнему ни единого шанса. Неудивительно, что графическое подразделение Advanced Micro Devices всерьёз обеспокоено столь агрессивным ходом со стороны NVIDIA, и в качестве ответного удара планирует снизить цены на Radeon HD 6870, а также представить на рынок новый, более дешёвый вариант Radeon HD 6950, оснащённый 1 ГБ локальной видеопамяти. Иными способами бороться с GeForce GTX 560 Ti практически невозможно: он однозначно выигрывает у Radeon HD 6950 2GB в стоимости, но далеко не всегда проигрывает ему в производительности в реальных играх.

На сегодняшний день GeForce GTX 560 Ti вполне можно признать лучшим игровым решением стоимостью до 250 долларов. Свою цену он отрабатывает сполна, и лучшего выбора для тех, кто не желает вкладываться в решения класса GeForce GTX 570 или Radeon HD 6970, в настоящее время не существует. Насколько конкурентоспособной окажется удешевлённая версия Radeon HD 6950, покажет время.

GeForce GTX 560: достоинства и недостатки

Достоинства:

Лучшая производительность в своём классе

В ряде тестов соперничает с Radeon HD 6950 2GB

Высокая производительность при выполнении тесселяции

Широкий выбор режимов FSAA

Минимальное влияние FSAA на производительность

Полноценная аппаратная поддержка декодирования HD-видео

Качественный постпроцессинг и масштабирование HD-видео

Поддержка эксклюзивных технологий NVIDIA PhysX и NVIDIA 3D Vision

Широкий выбор GPGPU приложений, разработанных для NVIDIA CUDA

Низкий уровень шума

Высокая эффективность системы охлаждения

Недостатки:

Серьёзных не обнаружено