Ваш город: Москва

VisionTek Xtasy GeForce4 Ti4400. Модификация и экстремальный разгон.

Введение

Время идет, поколения графических чипов сменяют друг друга, а людское желание "иметь больше за те же деньги" никуда не пропадает. При появлении видеокарт на базе новых чипов от NVIDIA, GeForce4 Titanium вслед за вопросами производительности, цены и качества сразу возникли вопросы относительно их разгонного потенциала и прироста производительности при разгоне.

Итак, вопрос был поставлен - нужен ответ. Когда я увидел видеокарту на базе NVIDIA GeForce4 Ti4400 от VisionTek, мои колебания по поводу выбора видеокарты для экстремального разгона отпали сами собой: VisionTek - то, что надо :).

В этом обзоре, вооружившись методом повышения напряжения питания графического ядра и видеопамяти, я подверг экстремальному разгону видеокарту VisionTek Xtasy GeForce4 Ti4400 и проанализировал зависимость её производительности от частоты графического ядра и видеопамяти в "тяжелых" тестах, способных показать примерный уровень игр ближайшего будущего.

VisionTek Xtasy GeForce4 Ti4400

Видеокарты Xtasy GeForce4 Ti4400 поставляются в стильно оформленных коробках, чей дизайн перекликается с дизайном логотипов графических чипов от NVIDIA:

В комплект поставки входит сама видеокарта, руководство по установке и два компакт диска - с драйверами, утилитами и программным проигрывателем DVD от Cyberlink:

На заднюю сторону коробки вынесено описание возможностей видеокарты:

Возможности видеокарты стандартны, но расписаны они так необычно, что я просто не могу удержаться и приведу этот текст. В моём вольном переводе это звучит так:

Не для слабонервных! Новая плата Xtasy GeForce4 Ti4400 - это мечта геймеров и кошмар их мамаш... 128МБ видеопамяти со 128-битным интерфейсом - такую взрывную смесь лучше и не пытаться протащить через турникет аэропорта. Ядро на 275 мегагерцах обеспечит плавную игру даже с обилием спецэффектов. Этого более, чем достаточно для того, чтобы довольно улыбался и ты, и твоя мамаша. (Ну а мамаша - то с чего будет улыбаться? Неувязочка...)

NVIDIA nfiniteFX II Engine

Два слова: Хардкорные спецэффекты. Два блока вершинных шейдеров, поддержка пиксельных шейдеров и 3D-текстур дают разработчикам возможность создания немыслимого числа невиданных спецэффектов, и ты увидишь настоящих, живых персонажей в сверхреалистичной обстановке. В два раза более быстрая, чем GeForce3 (тут авторы загнули слегка, конечно...), эта плата обеспечит самый реалистичный геймплей.

Lightspeed Memory Architecture II

Держись крепче, чтобы тебя не швырнуло со всей силы об стол. ( Во как.. Вообще, как ни переводи фразу "Get ready to slam your deck at uncharted speeds", неприятные ощущения владельцу видеокарты, похоже, в любом случае гарантируются :). ). С 128-битным DDR-интерфейсом Lightspeed Memory II имеет почти удвоенную пропускную способность видеопамяти против того, что было на GeForce3. Вот это мы называем недетскими скоростями. ("Недетские скорости" - самый мирный вариант, который с исходным текстом имеет мало общего. Я, честно говоря, даже растерялся и не знаю, как правильно можно перевести "bowel-loosening framerates". Lingvo предлагает как вариант перевода для слова "bowel" - кишки, человеческие внутренности, а для "loosening" - послабление, выпускание. Как хотите, так и переводите, но пару минут веселья при переборе вариантов я гарантирую :). )

Accuview Antialiasing Engine

"Ступенек" больше не будет! Это превосходное ( Вообще, не "превосходное", а "balls to the walls", что можно перевести как... А вообще, сленг лучше не переводить буквально :). ) качество изображения на потрясающих скоростях. Приготовься к этому: отдышись и набери в грудь побольше воздуха...

Dual Programmable Pixel Shaders

Захватывающие реалистичные эффекты и анимация персонажей происходят в реальном времени. Они такие, как ты в зеркале, только еще красивее. (Кто на свете всех милее, всех румяней и белее? А вот и не ты, мой благосклонный читатель, а персонажи из игр, в которые ты будешь играть. Я с этим категорически не согласен :). )

Ух... С огоньком написано, для настоящих геймеров! Такого сочного и смачного, приправленного крепким сленгом, описания характеристик видеокарты я еще не встречал. Право, хочется надеть на голову шлем, пристегнуться к креслу, и, набрав побольше воздуха, запустить любимый симулятор... Браво, VisionTek!

Внешний вид платы, к сожалению, не настолько впечатляет. VisionTek Xtasy GeForce4 Ti4400 выполнена по референс - дизайну от NVIDIA и почти неотличима от сэмплов от NVIDIA. Единственный фрагмент, по которому можно определить её производителя - маленькая наклеечка с логотипом VisionTek на кулере:

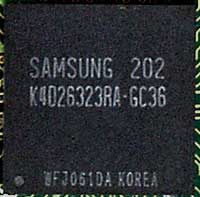

Видеокарта оборудована графическим чипом NVIDIA GeForce4 Ti4400 и 128 МБ видеопамяти DDR SDRAM от Samsung с временем цикла 3.6 нс.:

Тактовые частоты работы ядра и видеопамяти соответствуют рекомендациям NVIDIA - 275/550 (275 DDR) МГц.

За формирование ТВ-сигнала отвечает чип Conexant CX25871-14:

Что ж, с виду плата оказалась скучнее, чем можно было ожидать, начитавшись её характеристик, так сочно расписанных на коробке, но устранить это несоответствие - вполне в наших силах. Приступаем к экстремальному разгону.

Модификация и экстремальный разгон

Для начала стоит рассказать о том, до каких частот плата "разогналась" без применения пыток. При разгоне максимальные частоты VisionTek Xtasy GeForce4 Ti4400 составили 300/660 МГц - средний результат.

Однако, участь середнячка этой видеокарте не светит - мы всё-таки применим пытки каленым паяльником :).

Повышение напряжения питания графического ядра

За формирование напряжения питания графического ядра отвечает чип SC1175CSW. Подробно методика повышения напряжения питания описана в обзоре "Экстремальный разгон GeForce3", а сейчас я приведу только типовую схему включения этой микросхемы:

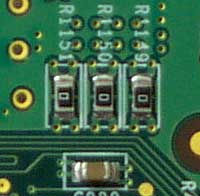

Для повышеения напряжения питания графического ядра можно с помощью шунтирования уменьшить сопротивление резистора R1 (на типовой схеме включения), что и было проделано - к ножкам 18 и 20 микросхемы был припаян дополнительный резистор:

На плате в качестве R1 и R12 (нумерация по типовой схеме) используются резисторы сопротивлением 130 и 390 Ом, в результате напряжение питания чипа по умолчанию составляет 1.66В. При шунтировании R1 дополнительным резистором с сопротивлением 620 Ом напряжение питания графического ядра составило 1.92В.

Повышение напряжения питания видеопамяти

На плате установлены чипы видеопамяти от Samsung с напряжением питания внутренних цепей и буферов ввода-вывода (VDD/VDDQ) 2,8В. Формированием этого напряжения занят чип SC1102CS от Semtech. Этот чип работает по абсолютно такому же пригципу, как и SC1175CSW, только имеет один канал вместо двух независимых каналов у SC1175CSW. Да, еще одно важное отличие - опорное напряжение в SC1102CS составляет 1.265В вместо 1.25В у SC1175CSW. Соответственно, выходное напряжение стабилизатора будет вычисляться по формуле Vout=1.265*(1+R8/R7), где нумерация резисторов взята из типовой схемы включения:

В отличие от видеокарт на базе NVIDIA GeForce3/Ti200/Ti500, на которых используются микросхемы видеопамяти c раздельным питанием внутренних цепей и буферов ввода-вывода (3.3В/2.5В - VDD/VDDQ), на платах на базе NVIDIA GeForce4 цеми питания VDD и VDDQ видеопамяти электрически соединены, причем, буфера ввода-вывода самого чипа NVIDIA GeForce4 питаются тем же напряжением, что и буфера ввода-вывода микросхем видеопамяти. Это серьезно ограничивает возможности повышения напряжения: например, при повышении VDD/VDDQ уже до 3.0В в текстовых режимах появлялась "рябь", чего допускать, естественно, нельзя. В итоге, экстремальный разгон видеопамяти мог и не состояться, если бы не...

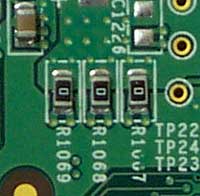

К счастью, референс-дизайн платы рассчитан на установку дополнительного стабилизатора для питания буферов ввода-вывода микросхем видеопамяти в тех случаях, когда это необходимо, то есть, когда напряжения питания внутренних цепей и буферов ввода-вывода микросхем видеопамяти различаются. Для установки дополнительного стабилизатора нужно сначала снять соединение VDD и VDDQ, отпаяв перемычки, расположенные на лицевой стороне видеокарты (показаны на фото)

и на обратной стороне:

Затем необходимо распаять стабилизатор для питания буферов ввода-вывода микросхем видеопамяти (места для установки компонентов отлично видны на фото). Это, конечно, дело несложное для опытного человека, но еще проще, по-моему, использовать обычный диод. Объясняю ход мысли: известно, что при прямом включении на кремниевых диодах присутствует падение напряжения, которое обычно составляет 0.7 - 0.8В, поэтому можно повысить напряжение питания внутренних цепей микросхем видеопамяти (VDD), например, до 3.5В, а питание буферов ввода-вывода подать с VDD через диод.

Так и было сделано: во-первых, я поднял выходное напряжение на стабилизаторе до 3.51В, подпаяв резистор сопротивлением 270 Ом к ножкам 11 и 14 микросхемы SC1102CS:

Таким образом напряжение питания внутренних цепей микросхем видеопамяти было повышено с 2.82В до 3.51В.

Во-вторых, покопавшись на кладбище блоков питания, я добыл мощный кремниевый диод и впаял его на то место, где раньше стояли перемычки:

Теперь напряжение питания буферов ввода-вывода микросхем видеопамяти и графического ядра составило 2.77В - падение напряжения на диоде составило 0.74В.

После повышения напряжения необходимо позаботиться об эффективной системе охлаждения - разгон сам по себе укорачивает жизнь видеокарты, а разгон с повышением напряжения и вовсе заставляет её компоненты работать буквально "на износ". Эффективным отводом тепла можно не только добиться работы графического ядра и видеопамяти на более высоких частотах, но и продлить жизнь видеокарте.

Доработка системы охлаждения

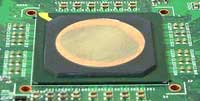

Первым делом я обработал графическое ядро, памятуя о том, что поверхность металлической крышки графического ядра не плоская и для хорошего теплового контакта требует выравнивания шкуркой. Результат - на фото:

Затем позаимствовал с мирно дремлющей в шкафу платы ATI RADEON 8500 кулер, в своё время специально подготовленный к её экстремальному разгону:

Кулер я закрепил за рёбра радиатора нейлоновыми хомутиками, пропустив их через отверстия в плате.

Последний шаг - установка радиаторов на микросхемы видеопамяти. Я использовал радиаторы из комплекта Thermaltake Memory Cooling Kit, закрепив их на липких термопрокладках, входящих в этот комплект.

После доработки системы охлаждения плата VisionTek Xtasy GeForce4 Ti4400 стала выглядеть так:

Максимальные частоты, на которых переделанная плата заработала устойчиво, составили 340/710(355 DDR) МГц, соответственно, у графического ядра и видеопамяти. Пока это является рекордом среди видеокарт на базе NVIDIA GeForce4 Ti4400 - по частотам плата далеко обошла даже GeForce4 Ti4600.

Тестовая система и условия тестирования

Конфигурация тестовой системы:

Процессор - AMD Athlon XP 2000+;

Материнская плата – MSI K7T266 Pro2 v2.0 (VIA KT266A);

Память - 2*256 МБ DDR SDRAM PC 2700 Crucial CL2.5;

Жесткий диск – Fujitsu MPF3153AH.

Программное обеспечение:

Драйвер Detonator 28.32 под Windows XP для видеокарт на базе чипов от NVIDIA;

Windows XP;

Codecult Codecreatures;

3DMark 2001 SE;

Serious Sam: The Second Encounter;

Настройки режимов тестирования:

Serious Sam: The Second Encounter:

Тестирование было произведено в режиме "extreme quality": настройки качества графики - "Quality", графические режимы- 32-битные, перед каждым тестом запускался адд-он "GFX: Extreme Quality".

Тестирование было проведено на стандартной демо-записи "The Grand Cathedral".

3DMark 2001:

Настройки: 32-битный буфер кадра, 32-битные текстуры, 32(24)-битный Z-буфер, D3D Pure Hardware T&L.

Codecult Codecreatures:

При тестировании были использованы настройки по умолчанию.

Анализ производительности

Codecult Codecreatures:

Я думаю, сначала стоит немного рассказать об этом тесте. Codecreatures - тест на основе движка от команды Codecult, который создатели активно продвигают, предлагая его лицензирование. В тесте имитируется живая природа - поляны, горы, озерцо, трава - сейчас это модно :).

Само собой, для сравнения тут же напрашивается тест Nature из пакета 3DMark2001. По моему скромному мнению, Codecreatures, ничуть не уступая детищу MadOnion в техническом плане, проигрывает в визуальном плане: солнца на небе нет, цвета тусклые, трава пригибается ветром неестественно, вода при таком сильном ветре подозрительно тиха... Впрочем, красота - материя тонкая, каждый её воспринимает по-своему, поэтому свою точку зрения я навязывать не буду :).

Для тех, кто еще не видел этот тест, привожу скриншоты:

Чувствуется, что разгон здесь себя оправдает: Codecreatures очень сильно загружает видеокарту, и это хорошо видно даже без измерения количества кадров в секунду. Впрочем, подкрепить визуальные ощущения цифрами будет совсем нелишним:

Большое количество полигонов в сцене (до 500 000 и выше) и высокие требования к скорости их заполнения (Fill Rate) дает о себе знать - разгон графического ядра оказался гораздо более продуктивен, чем разгон видеопамяти.

3DMark 2001 - Nature:

Примечательно: в этом тесте, тоже имитирующем живую природу, разгон видеопамяти, наоборот, оказался более продуктивен, чем разгон ядра. Объяснение лежит на поверхности: в Nature в сцене присутствует меньшее количество полигонов, а полигоны с прозрачными текстурами, имитирующие траву, "растут" из земли не так "густо".

Serious Sam: The Second Encounter:

В Serious Sam: The Second Encounter разгон видеопамяти почти ничего не дает, и это неудивительно: производительность ограничена скоростью графического ядра. Главным образом, из-за того, что в режиме "Extreme quality" в Serious Sam: The Second Encounter включается анизотропная фильтрация текстур высшего уровня (32 сэмпла), которая, как мы знаем, приводит к затратам дополнительных тактов графического ядра (8 тактов вместо одного).

Чтобы точнее оценить прирост производительности при разгоне, я свёл значения прироста при разгоне ядра во всех трех тестах на один график, поместив туда же процент повышения частоты ядра:

Codecreatures и Serious Sam: The Second Encounter - настоящие "пожиратели" ресурсов графического ядра, а вот результат в Nature с разгоном ядра почти никак не изменяется.

Прирост результатов при разгоне видеопамяти:

Ситуация поменялась на противоположную: результат в Nature и Codecreatures при разгоне видеопамяти увеличивается на солидные величины, зато Serious Sam: The Second Encounter отностися к разгону видеопамяти почти совершенно равнодушно.

Прирост производительности при экстремальном разгоне ядра и видеопамяти:

Прирост получился солидный, и теперь совершенно точно можно сказать: тест Codecreatures от Codecult отменно загружает видеокарту VisionTek Xtasy GeForce4 Ti4400, полностью используя её потенциал даже при разгоне - прирост производительности в режиме 1600х1200 составил 27% при условии, что частота графического ядра при экстремальном разгоне была повышена на 23,6%, а частота видеопамяти - на 29,1%.

В Nature и Serious Sam: The Second Encounter прирост производительности при разгоне оказался чуть ниже, и это говорит о том, что результаты в этих тестах ограничиваются уже не только скоростью видеокарты, но и производительностью процессора и системы в целом.

Заключение

Что ж, эксперимент удался: видеокарта VisionTek Xtasy GeForce4 Ti4400 с честью выдержала испытание экстремальным разгоном, порадовав приличным приростом производительности. Да, процентное увеличение частот графического ядра и видеопамяти при экстремальном разгоне оказалось не столь высоким, как в своё время на NVIDIA GeForce3, но не стоит забывать, что и NVIDIA GeForce3, и NVIDIA GeForce4 выпускаются по одной технологии - 0.15 мкм. Неудивительно, что видеокарты поколения GeForce4, изначально работающие на более высоких частотах, имеют низкий разгонный потенциал. Похоже, что появления "хорошо гонящихся" чипов мы дождемся теперь уже только при переходе на более тонкие технологии их изготовления. Пока же приходится довольствоваться увеличением частот на 20-25%.

При том, что экстремальный разгон GeForce4 Ti4400 - занятие весьма хлопотное, увеличение производительности на величину даже в 20-25% не может не радовать, особенно если учесть, какие результаты дают тесты Codecreatures и Nature - ниже предела играбельности. С другой стороны, имея запас производительности видеокарты, можно найти ему применение даже на слабых для этой видеокарты системах или "легких" играх - включить полноэкранное сглаживание, анизотропную фильтрацию, повысить разрешение...

Возвращаясь к плате, послужившей причиной появления этого обзора, подведу итоги:

Плюсы VisionTek Xtasy GeForce4 Ti4400:

Отличное оформление коробки;

Хорошее качество вывода изображения на монитор;

Хорошее качество монтажа;

Хороший разгонный потенциал, отличный - при экстремальном разгоне :).

Минусы:

Скудный комплект поставки

Замечание:

Данный материал – своего рода эксперимент, он не является призывом к экстремальному разгону или перепайке видеокарт;

Подобная модификация платы сокращает срок ее службы;

При любой модификации платы пользователь автоматически лишается гарантии;

В случае выхода из строя видеокарты или других комплектующих в результате её модификации вся ответственность лежит на пользователе;