Ваш город: Москва

Ответный ход: NVIDIA GeForce GTX 680 2 Гбайт на графической архитектуре «Kepler»

Введение

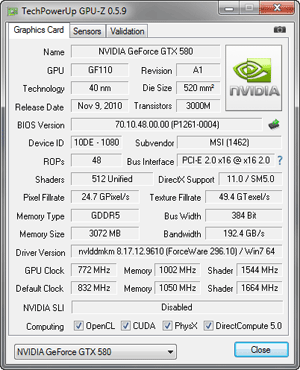

Год и четыре месяца назад была представлена самая мощная однопроцессорная видеокарта на архитектуре «Fermi» – NVIDIA GeForce GTX 580. Срок, как вы понимаете, для графических ускорителей немалый, поэтому выхода нового графического процессора компании NVIDIA на архитектуре «Kepler» с 28-нм техпроцессом и видеокарты на его основе все ждали с большим нетерпением, бесконечно муссируя слухи и чуть ли не попиксельно разбирая каждый кусочек утекшей в сеть информации. Подлил «масла в огонь» и удачный выход в конце прошлого года Hi-End видеокарты конкурента – AMD Radeon HD 7970, ставшей не только самым мощным однопроцессорным решением, но и обладающей превосходным оверклокерским потенциалом вкупе с линейным приростом производительности.

С радостью сообщаем, что мы с вами, наконец-то, дождались! Встречаем графический процессор GK104 и видеокарту NVIDIA GeForce GTX 680:

Что интересно, GK104 не позиционируется, как Hi-End графический процессор, хотя сама NVIDIA и называет GeForce GTX 680 «быстрейшей и наиэффективнейшей видеокартой». В этом же году должны выйти ещё более производительные графические решение NVIDIA, поэтому компания акцентирует внимание на том факте, что при разработке 28-нанометрового GK104 и соответственно GeForce GTX 680 в первую очередь стремились достичь максимум производительности на ватт, используя все ресурсы более тонкого технологического процесса и архитектуры «Kepler». Давайте изучим её особенности.

Графический процессор GK104 на архитектуре «Kepler»

«Быстрее, комфортнее, насыщеннее!» – именно таким лозунгом озаглавила анонс «Kepler» компания NVIDIA. Интрига, как обычно, кроется в тех изменениях, что позволят повысить эффективность работы GPU и получить приросты производительности. А поскольку DirectX 11 по-прежнему является новейшим API для 3D-приложений, то оба производителя видеокарт сосредоточили усилия и пустили транзисторный бюджет не на поддержку новой версии API, а повышение эффективности использования всё того же DirectX 11. AMD, как уже известно, сменила VLIW архитектуру на GCN, более ориентированную на GPGPU. А вот с Fermi ситуация сложнее. Она изначально разрабатывалась для DirectX 11 и GPGPU, и не имела откровенно слабых мест. Так в какую же сторону NVIDIA решила развивать новую графическую архитектуру? Ответ предсказуем – в сторону повышения общей производительности и энергетической эффективности. Итак, встречаем Kepler:

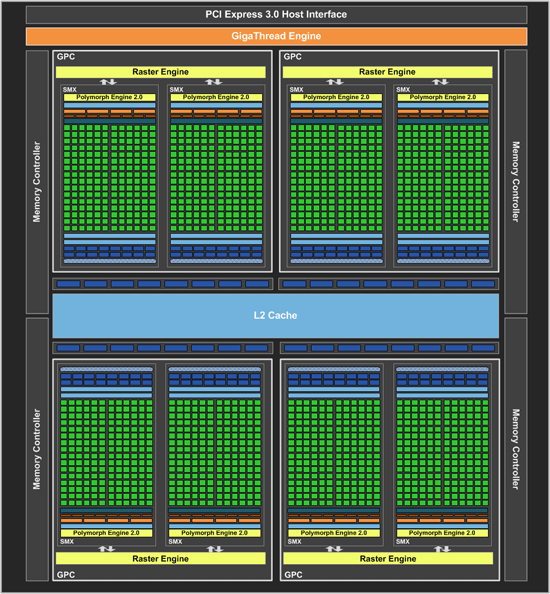

C точки зрения общей топологии и организации, Kepler очень напоминает Fermi, поэтому рассмотрим произошедшие изменения с оглядкой на предыдущую архитектуру NVIDIA.

Также, как и графические процессоры прошлого поколения, NVIDIA GK104 содержит блок управления потоками GigaThread Engine, контроллеры памяти, кэш второго уровня для данных и инструкций, блоки растровых операций, и, разумеется, блоки GPC (Graphics Processing Clusters), отвечающие за вычислительные и текстурные операции. GeForce GTX 680 имеет в своём составе 4 блока GPC, каждый из которых, в свою очередь, состоит из блока растеризации (Raster Engine) и нескольких потоковых мультипроцессоров, которые теперь называют SMX, вместо SM в архитектурах Tesla и Fermi. В GK104, каждый GPC содержит два SMX, в отличие от четырёх SM в Fermi.

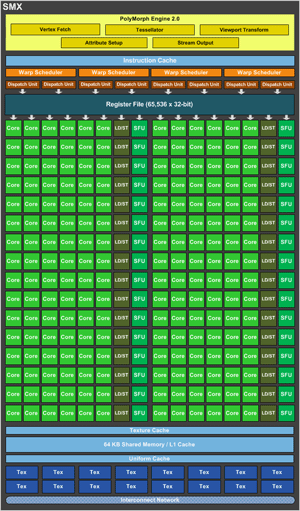

SMX, который теперь является минимальным базовым блоком архитектуры Kepler, содержит:

блок обработки геометрии PolyMorph Engine 2.0, производительность которого вдвое выше, чем у аналогичного блока в архитектуре Fermi;

192 вычислительных ядра (CUDA Cores), 32 блока для сложных математических операций (SFU), 32 блока загрузки и выгрузки данных (LSU), работающих теперь на частоте ядра, а не удвоенной, как в Fermi;

16 блоков текстурных операций (TMU), что также вдвое больше, чем в Fermi;

кэш первого уровня, объёмом 64 Кбайт;

регистровый файл, на 65536 х 32-бит записей, вдвое больше, чем в Fermi;

8 управляющих блоков (Dispatch Unit) и 4 планировщика (Warp Sheduler), опять же, вдвое больше, чем в Fermi.

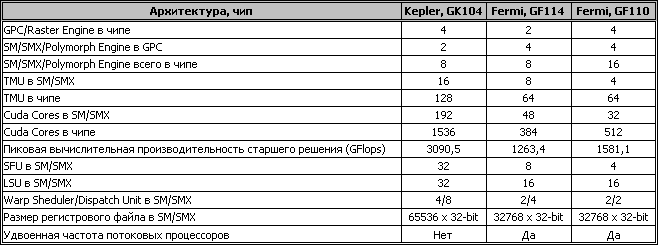

Для удобства восприятия, сведём информацию по архитектурным отличиям GK104, GF114 и GF110 в одну таблицу:

Можно заметить, что GK104 структурно больше похож на GF114, чем на GF110. Видимо это ещё один намёк на то, что GK104 будет старшим чипом линейки лишь временно, и через какое-то время его сменит GK110, в котором будут архитектурные изменения, направленные на повышение GPGPU производительности будущего флагмана NVIDIA.

Благодаря новой организации SMX, GK104 в разы нарастил количество всех исполнительных устройств, практически по всем показателям опередив GeForce GTX 580. А вдвое меньшее количество блоков обработки геометрии было скомпенсировано также двукратным увеличением их производительности. При всём этом, число транзисторов возросло всего лишь на 18%, с 3 млрд. у GeForce GTX 580, до 3,54 млрд. у GeForce GTX 680.

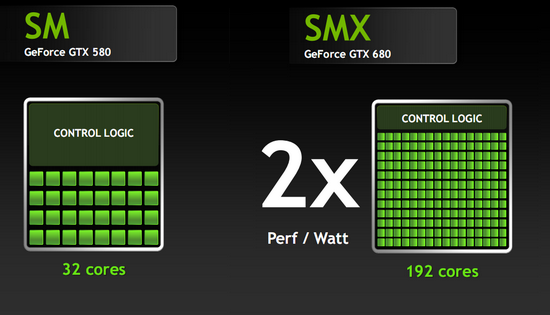

Не стоит забывать и о второй важной задаче, которую поставила перед собой NVIDIA при разработке Kepler – повышении энергоэффективности новой архитектуры. Большинство архитектурных изменений были произведены именно с этой целью. Основные усилия были потрачены на снижение потребления потоковых процессоров и управляющей логики. При проектировании SMX был произведён размен удвоенной частоты потоковых процессоров на их количество. Ведь для синхронизации блоков, работающих на разных тактовых частотах нужны различные буферы и очереди, от которых стало возможным избавиться, вместе с упразднением удвоенной частоты, а высвободившийся транзисторный бюджет был использован для увеличения числа самих исполнительных устройств. А поскольку на меньшей частоте требуется существенно меньше энергии для питания тактовых генераторов и потоковых процессоров, существенно снижается суммарное потребление энергии при той же теоретической пиковой производительности. По заявлениям NVIDIA, новая организация потоковых процессоров позволила повысить энергоэффективность в два раза, по сравнению с Fermi.

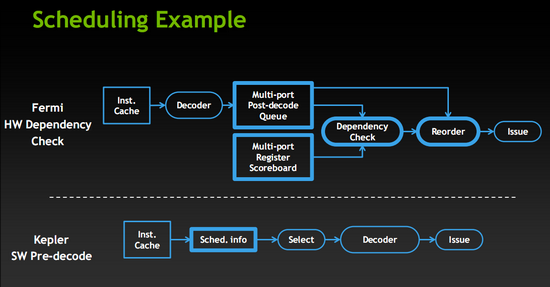

Управляющая логика также подверглась значительным изменениям. Аппаратные механизмы декодирования и переупорядочивания инструкций были заменены на программные, которые хоть и требуют для своей реализации почти вдвое большего числа транзисторов, но в итоге потребляют меньше энергии. Это снова позволило NVIDIA убить двух зайцев одним выстрелом – повысить производительность и снизить энергопотребление. Кроме того, снизилось количество управляющей логики в пересчёте на один потоковый процессор, что также внесло свою лепту в снижение потребления энергии. Учитывая, что на реализацию исполнительных устройств и контрольной логики уходит львиная доля транзисторного бюджета, можно говорить о том, что произведённые изменения привели к существенному повышению энергоэффективности архитектуры Kepler и всех чипов на её основе.

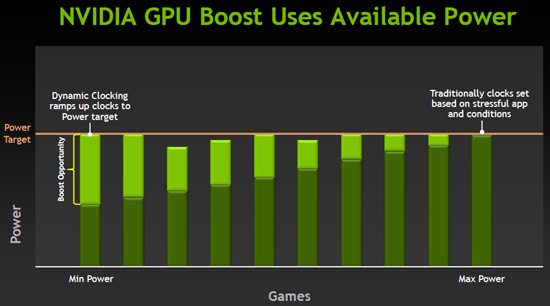

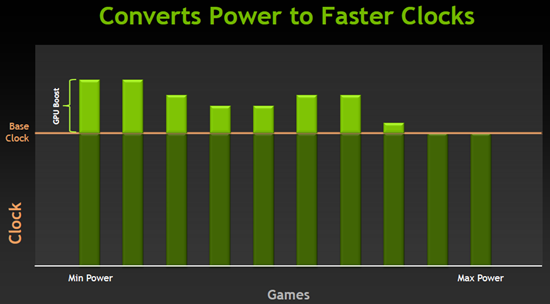

Система GPU Boost

Ещё одно важное нововведение Kepler коснулось управления частотами графического процессора. Классический механизм использования фиксированной частоты, использовавшийся многие годы, ориентируется на худшие, в плане потребления и нагрузки, случаи. Тактовая частота ядра в этом случае выставляется с большим запасом, чтобы при максимально возможной нагрузке, устройство работало в допустимых границах энергопотребления. Такой подход приводит к тому, что в большинстве приложений видеокарта работает с большим запасом по энергопотреблению и тепловыделению. Инженеры NVIDIA справедливо предположили, что этот запас можно конвертировать в повышение тактовой частоты графического процессора, что позволит увеличивать производительность в большинстве приложений. Для этого в Kepler интегрирован специальный блок, который непрерывно отслеживает основные параметры кристалла GPU – тактовую частоту, энергопотребление, температуру, загрузку вычислительных устройств, и на основе этой информации управляет тактовыми частотами, а также напряжением графического процессора и видеопамяти. Данная технология получила название GPU Boost.

Например, штатная частота GeForce GTX 680 составляет 1006 MHz, она же является “базовой” в терминологии NVIDIA, т.е. гарантированной при любой нагрузке. Но в подавляющем большинстве 3D-приложений она будет автоматически повышена до 1058-1100 MHz, т.е. на 5-10%, а в некоторых случаях, ещё выше. И в очередной раз стоит отметить, что данная технология позволяет одновременно эффективно распоряжаться тепловым пакетом видеокарты и поднимать производительность во многих случаях.

Адаптивный V-Sync

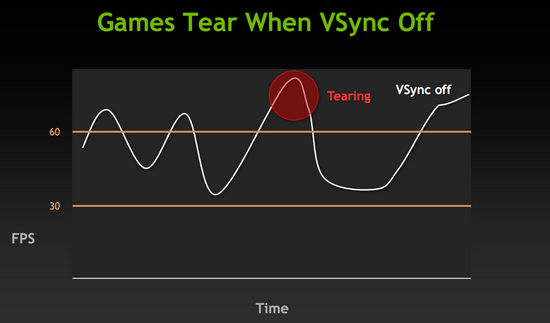

В современных играх, частота смены кадров очень сильно зависит от обстановки и направления взгляда игрока. Очень часто разница между минимальными и максимальным FPS достигает нескольких раз. В тех случаях, когда частота смены кадров значительно превышает частоту вертикальной развёртки монитора, как правило, это 60 Гц, что соответствует 60 FPS, может возникнуть такой неприятный эффект как “tearing” приводящий к разрыву между верхней и нижней частью изображения.

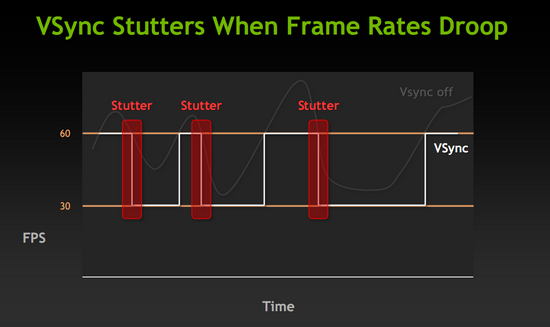

Для борьбы с данным видом артефактов уже много лет существует функция вертикальной синхронизации – V-Sync. Но при её использовании возникает другая проблема. Если частота смены кадров опускается ниже частоты вертикальной развёртки монитора, то включенная вертикальная синхронизация приведёт к падению FPS до значений кратных 60 Гц, т.е. 30, 20 или даже 15 кадрам в секунду, то есть до величин, которые подавляющее большинство игроков называют некомфортными.

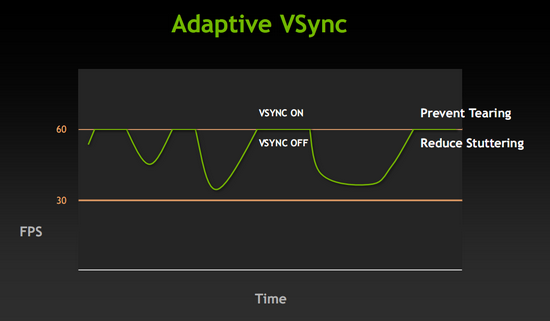

Решить эту проблему призвана технология адаптивной вертикальной синхронизации. Алгоритм её работы весьма прост. Когда частота смены кадров выше частоты развёртки монитора, вертикальная синхронизация включена и не допускает появления разрывов изображения. Если FPS падает ниже частоты развёртки монитора, к примеру до 50 кадров в секунду, вертикальная синхронизация отключается, и падения до значения в 30 FPS не происходит, видеоряд выводится с максимально возможной скоростью, в нашем примере – 50 кадров в секунду.

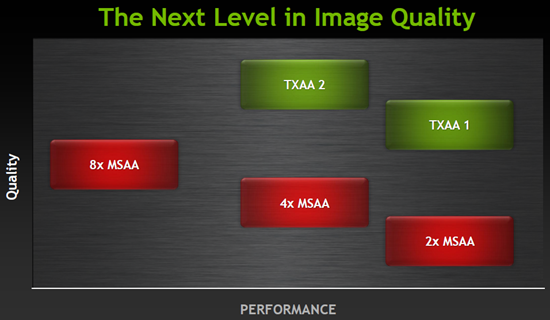

Новые алгоритмы сглаживания – FXAA и TXAA

Аббревиатура FXAA, расшифровывается как Fast approXimate Anti-Aliasing и представляет собой шейдер, работающий с кадром на этапе постобработки. Этот алгоритм известен достаточно давно, он работает значительно быстрее классического MSAA, менее требователен к ресурсам и даёт, в большинстве случаев, более высокое качество обработки краевых пикселей и субпикселей. Единственный его недостаток заключался в том, что его необходимо было интегрировать в движок игры. Но с новым поколением видеокарт NVIDIA, этот алгоритм стал частью драйвера и может быть использован на подавляющем большинстве игр, не требуя от них самостоятельной поддержки данной технологи.

ТXAA, является более сложным алгоритмом. Он базируется на функции аппаратного MSAA и с помощью программно реализованного высококачественного фильтра, а также репроекции сэмплов с учётом движения объектов в кадре, позволяет получить высокое качество сглаживания при небольшом падении производительности.

Пока заявлено только два режима работы данного алгоритма. TXAA1, позволяющий получить качество картинки чуть выше, чем предоставляет 8x MSAA, и потребляющий ресурсов на уровне 2хMSAA. и TXAA2, который обеспечивает качество недоступное MSAA алгоритмам при затратах, сопоставимых с 4x MSAA.

Стоит также отметить, что данные режимы сглаживания будут доступны не только на новых видеокартах, на базе архитектуры Kepler, но и владельцам решений прошлого поколения, Fermi, т.е. на линейках GeForce GTX 4xx и GeForce GTX 5xx.

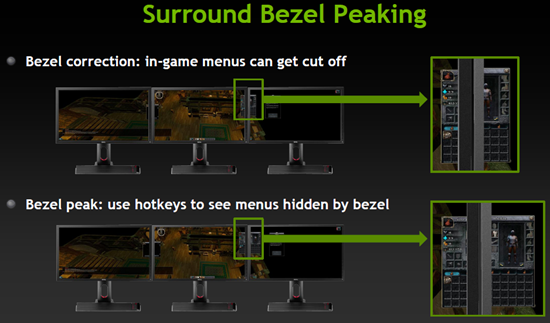

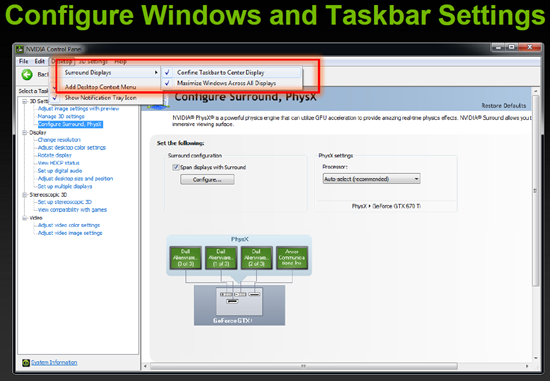

Поддержка нескольких мониторов

Первыми видеокартами NVIDIA, поддерживающими вывод на два источника изображения, стали GeForce2 MX, дебютировавшие более десяти лет назад. Правда, на них это достигалось только с помощью некоторых ухищрений, и, как правило, подключить можно было лишь телевизор по интерфейсу S-Video. Но начиная с видеокарт серии GeForce4, полноценная поддержка двух независимых мониторов стала штатной функцией. К сожалению, никаких подвижек по увеличению количества одновременно работающих устройств у NVIDIA с тех пор не было. А прогресс не стоял на месте, мультимониторные конфигурации становились всё доступнее, и превратились из роскоши во вполне привычную вещь во многих отраслях. Телевизоры также стали всё чаще стали подключать по HDMI интерфейсу к компьютеру и использовать в качестве мониторов. Таким образом, всё чаще появлялась потребность в подключении более, чем двух мониторов. И, по всей видимости, NVIDIA решила наверстать упущенное. Видеокарты на базе архитектуры Kepler поддерживают до четырёх устройств отображения. GeForce GTX 680 штатно оснащается двумя выходами DVI Dual-link, одним разъёмом HDMI и одним DisplayPort.

Любители игр могут использовать до трёх мониторов непосредственно для получения панорамного изображения в играх, а четвёртый подключить для прочих нужд.

Отдельно стоит упомянуть, что NVIDIA потрудилась над программными возможностями драйвера при работе с мульти-мониторными конфигурациями. Приятные мелочи есть как для игроков, так и для пользователей, работающих в среде Windows.

Долгожданные изменения произошли и в механизмах энергосбережения, используемых при подключении двух мониторов и более. Видеокарты прошлого поколения, при подключении двух мониторов, не могли переходить в режим минимального энергопотребления (Idle Pstate), и работали на частотах low3D Pstate, что приводило к повышенному энергопотреблению и нагреву видеокарты в простое. С новым поколением, ограничений стало меньше. Теперь видеокарта уходит в Idle Pstate даже при четырёх подключенных мониторах, при условии, что на всех используется одинаковое разрешение. Если же в конфигурации используется хотя бы один монитор с разрешением, отличным от остальных, то видеокарта будет работать при простое в low3D Pstate, как и раньше.

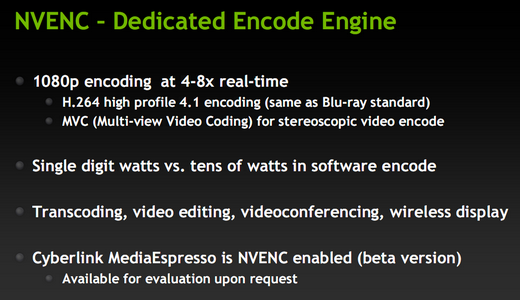

NVENC-энкодер

«Вишенкой на торте» новых возможностей архитектуры Kepler является интегрированный блок аппаратного декодирования видео - NVENC, который поддерживает декодирование с высокой скоростью 1080р видео в форматах h.264 таких актуальных профилей, как Base, Main и High Profile 4.1. Скорость и возможности этого блока, разумеется, ниже, чем у программных решений, использующих CUDA ядра для декодирования, но этих возможностей достаточно для большинства случаев, и это позволяет сэкономить энергию. Таким образом, целевой аудиторией данной технологии, по всей видимости, являются пользователи ноутбуков, которым необходимо редактировать или просматривать видео высокого разрешения.

В завершении теоретической части хочется сказать, что даже краткое знакомство с возможностями Kepler впечатляет. Изменений много, и все они разносторонние, что позволит NVIDIA заинтересовать своим новым продуктом самые разные категории покупателей. Внедрённые алгоритмы сглаживания и адаптивной вертикальной синхронизации позволяют получить более качественную картинку и стабильный видеоряд. Поддержка четырёх мониторов интересна игрокам и в бизнесе. Аппаратный декодер видео и низкое энергопотребление привлекут пользователей ноутбуков. Ну а возросшая производительность и лавры самой быстрой видеокарты в мире придутся по душе многочисленным энтузиастам. А теперь, самое время все эти заявления проверить на практике.

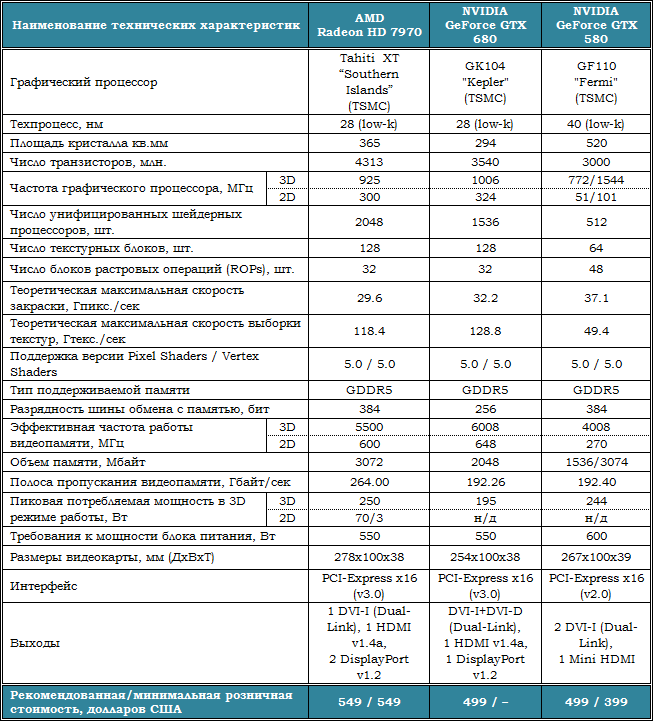

Технические характеристики

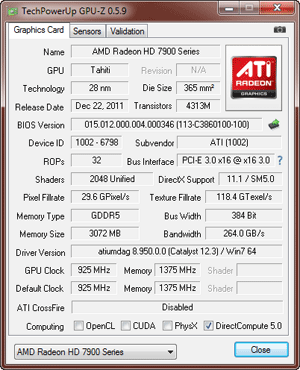

Технические характеристики NVIDIA GeForce GTX 680 приведены в таблице в сравнении с предшественником в лице GeForce GTX 580 и AMD Radeon HD 7970:

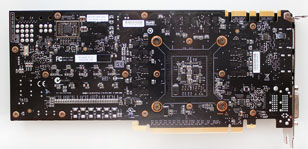

Видеокарта и её особенности

Эталонная NVIDIA GeForce GTX 680 внешне ничем примечательным не выделяется – всё тот же двух-слотовый дизайн с пластиковым кожухом и радиальным вентилятором в задней части с лицевой стороны и ничем не закрытым текстолитом с обратной:

Длина печатной платы составляет 254 мм, и кожух системы охлаждения не выходит за её пределы. Сверху на кожухе крупная надпись «GEFORCE GTX», а логотип компании NVIDIA находится в правом нижнем углу лицевой стороны видеокарты. Первое время после анонса GTX 680 большинство компаний будут выпускать именно такие видеокарты, отличающиеся лишь оформлением, а вот спустя пару месяцев мы, скорее всего, уже сможем изучить нереференсные продукты.

Согласно спецификациям, NVIDIA GeForce GTX 680 оснащается двумя выходами DVI (Dual-Link), одним выходом HDMI версии 1.4a и одним DisplayPort версии 1.2:

Если внимательно присмотреться к верхнему разъёму, то становится очевидно, что это DVI-D, а нижний – DVI-I. Несмотря на джентельменский набор выходов, на задней панели осталось место и для решётки для выброса нагретого видеокартой воздуха за пределы корпуса системного блока. А выбрасывается он во время продолжительных тестов действительно довольно горячий.

В плане оснащения видеокарты двумя разъёмами MIO для SLI-конфигураций изменений нет – их, как и прежде, два, и они по-прежнему расположены в верхней части печатной платы:

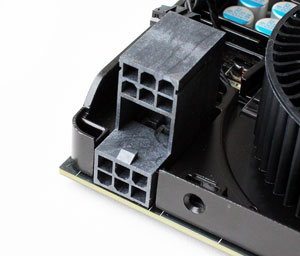

А вот два шестиконтактных разъёма для подключения дополнительного питания установлены весьма оригинально – друг над другом с 12-мм расстоянием. Причём, кабели подключаются к ним таким образом, что фиксирующие защёлки оказываются внутри. Но так как разъёмы установлены со смещением и с приличным расстоянием друг от друга, отсоединять кабели не составляет никакого труда. Максимальное энергопотребление видеокарты заявлено на отметке 195 Вт, что на 55 Вт меньше чем у AMD Radeon HD 7970, и на 49 Вт меньше, чем у GeForce GTX 580.

Пластиковый кожух закрепляется винтами по периметру видеокарты. Под ним – радиатор системы охлаждения GPU и металлическая пластина с радиальным вентилятором, закрывающая практически всю лицевую сторону печатной платы:

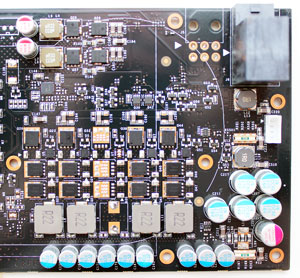

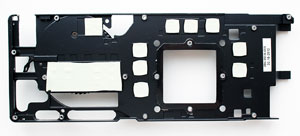

Без неё печатная плата выглядит следующим образом:

Сразу же обращает на себя внимание горизонтально расположенная силовая часть, выполненная по схеме 4+2. Что интересно, пятая фаза оказалась не распаянной, как и ещё один шестиконтактный разъём для дополнительного питания:

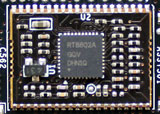

Возможно, NVIDIA разработала эту печатную плату и для более производительной видеокарты. Всё же на одну экономию, да ещё и в момент анонса данный факт списать сложно. PWM-контроллер RT8802A производства Richtek Technology Corporation вынесен на обратную сторону печатной платы:

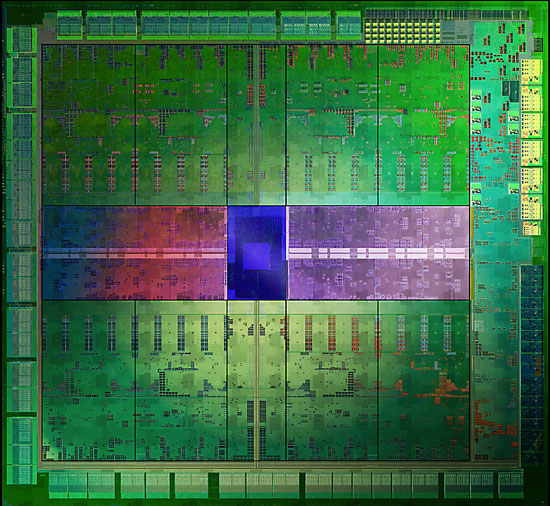

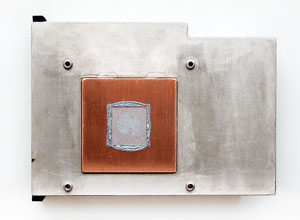

Наконец-то мы видим открытый кристалл 28-нм графического процессора GK104 – его площадь составляет всего 294 кв.мм.:

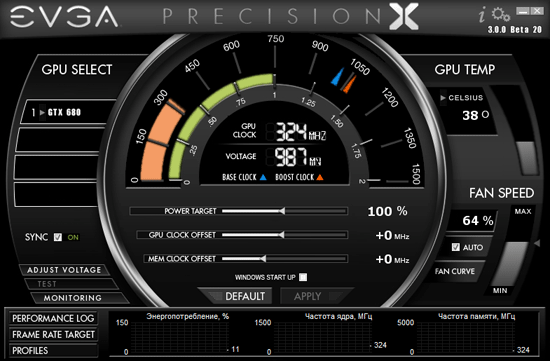

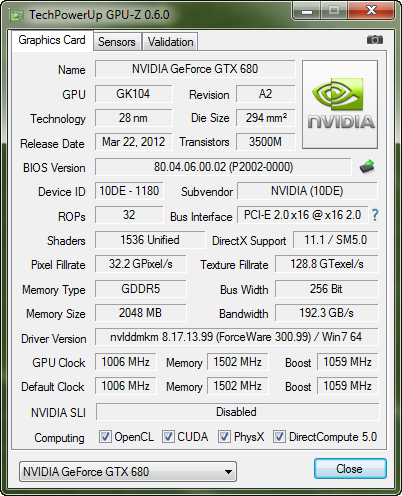

Кристалл нашего экземпляра видеокарты относится к ревизии А2 и выпущен на третьей неделе текущего года. Номинальная частота графического процессора в 3D-режиме составляет 1006 МГц при напряжении 1,15 В, а с учётом динамического повышения (GPU Boost) может достигать 1124 МГц. В 2D-режиме частота графического процессора снижается до 324 МГц при напряжении 0,987 В. Характеристики нового GPU мы уже детально разобрали в теоретической части.

Восемь микросхем видеопамяти стандарта GDDR5 расположены на лицевой стороне печатной платы. Их производителем является компания Hynix Semiconductor Inc., а маркировка H5GQ2H24MFR R0C:

Теоретическая эффективная частота таких микросхем в 3D-режиме составляет 6000 МГц при напряжении 1,6 В, на которых они и функционируют на GeForce GTX 680 (6008 МГц, если быть точным), и это самая быстрая память из серийно выпускаемых видеокарт. Однако, так как ширина шины обмена с памятью видеокарты равна 256 бит, то пропускная способность составляет всего 192,26 Гбайт/сек, что равно пропускной способности памяти GeForce GTX 580 с его 384-битной шиной, и сразу на 71,74 Гбайт/сек меньше пропускной способности памяти AMD Radeon HD 7970 (5500 МГц при 384 бит). В 2D-режиме частота памяти GeForce GTX 680 снижается до 648 эффективных мегагерц.

За три дня до официального анонса GeForce GTX 680 вышла новая версия утилиты GPU-Z 0.6.0, которая уже в полной мере знакома с характеристиками новинки:

Рекомендованная стоимость NVIDIA GeForce GTX 680 заявлена на отметке 499 долларов США, что на 50 долларов США дешевле чем AMD Radeon HD 7970 ($549) и на столько же дороже Radeon HD 7950 ($449). Для российского рынка цена заявлена на отметке 17999 рублей, что по текущему курсу куда больше, чем те же $499, и выше, нежели сегодняшняя минимальная розничная стоимость эталонных Radeon HD 7970, начинающаяся с 16000 рублей.

Система охлаждения и её эффективность

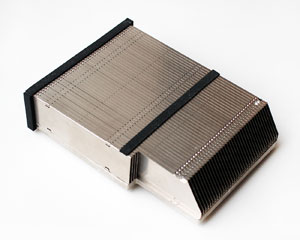

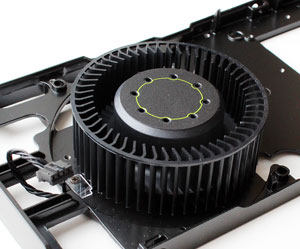

Сразу скажем, что каких-либо оригинальных решений в кулере GeForce GTX 680 нет. В основе системы охлаждения лежит алюминиевый радиатор средних размеров с тонкими рёбрами:

Судя по схеме, приведённой в документации по GeForce GTX 680, в основе радиатора лежат три медные тепловые трубки, распределяющие тепло по его алюминиевому основанию и рёбрам:

С самим же графическим процессором контактирует только медное основание, контактная поверхность которого обработана удовлетворительно:

За охлаждение силовых элементов и микросхем видеопамяти отвечает металлическая пластина с термопрокладками:

В качестве нагнетателя воздушного потока используется классический радиальный вентилятор диаметром 80 мм:

По заверениям NVIDIA, использование высококачественных материалов и индивидуально отбалансированной для каждой видеокарты турбины позволило добиться на 5 дБА более низкого уровня шума, чем у Radeon HD 7970, что мы обязательно проверим. Здесь же добавим, что скорость вращения турбины регулируется автоматически PWM-методом в диапазоне от 1000 до 4200 об/мин, причём последняя величина – это только 85% всей мощности этого радиального вентилятора. При ручной его регулировке вне видеокарты мы выяснили, что верхняя граница скорости равна 5200 об/мин. Однако, в NVIDIA посчитали 4200 об/мин достаточным для охлаждения 28-нанометрового графического процессора GTX 680 и ограничили мощность 85 процентами.

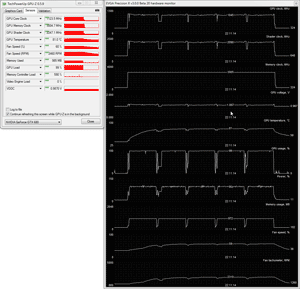

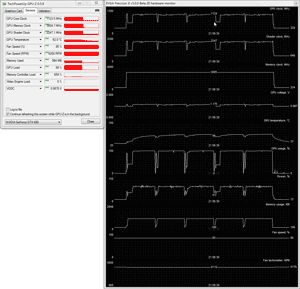

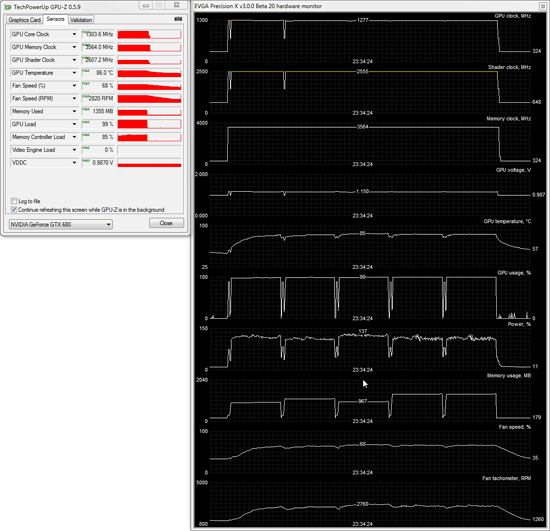

Для проверки температурного режима работы видеокарты в качестве нагрузки мы использовали пять циклов теста игры Aliens vs. Predator (2010) при максимальном качестве графики в разрешении 2560х1600 пикселей с анизотропной фильтрацией уровня 16х и с использованием сглаживания степени 4x. Для мониторинга температур и прочих параметров мы использовали программу EVGA Precision X версии 3.0.0 Beta 20 в паре с утилитой GPU-Z версии 0.5.9, которая пока поддерживает GeForce GTX 680 лишь частично, но температуры и скорость вентилятора уже показывает корректно. Все тесты проводились в закрытом корпусе системного блока, конфигурацию которого вы сможете увидеть в следующем разделе статьи, при комнатной температуре 26 градусов Цельсия. Тестирование эффективности системы охлаждения видеокарты NVIDIA GeForce GTX 680 было проведено с использованием штатного термоинтерфейса.

Посмотрим на результаты температурного теста GeForce GTX 680 в автоматическом режиме работы и при 85% мощности:

Как видим, в автоматическом режиме работы радиального вентилятора графический процессор прогрелся до 81 градуса Цельсия, а скорость турбины увеличилась с 1100 до 2460 об/мин. На 85% мощности при 4200 об/мин температура процессора не поднялась выше 62 градусов Цельсия. Сложно сказать, насколько хороши эти результаты без оценки уровня шума, к которой мы сейчас и перейдём.

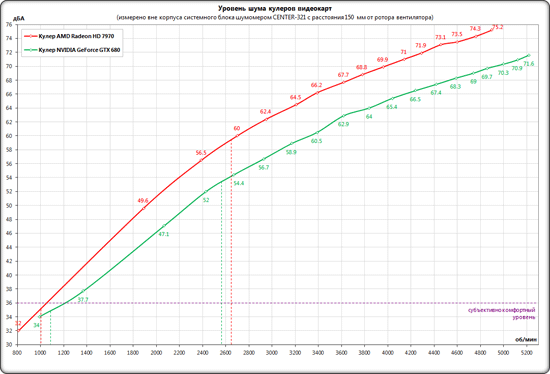

Уровень шума

Измерение уровня шума систем охлаждения осуществлялось с помощью электронного шумомера CENTER-321 после часа ночи в полностью закрытой комнате площадью около 20 м² со стеклопакетами. Уровень шума измерялся вне корпуса системного блока, когда источником шума в комнате являлся только система охлаждения и её вентиляторы. Шумомер, зафиксированный на штативе, всегда располагался строго в одной точке на расстоянии ровно 150 мм от ротора вентилятора/турбины кулера. Материнская плата, в которую была вставлена видеокарта с установленной на неё системой охлаждения, размещалась на самом углу стола на пенополиуретановой подложке. Нижняя граница измерений шумомера составляет 29,8 дБА, а субъективно комфортный (не путать с низким) уровень шума при измерениях с такого расстояния находится около отметки 36 дБА. Скорость вращения вентиляторов изменялась во всём диапазоне их работы с помощью специального точного контроллера путём изменения питающего напряжения с шагом 0,5 В.

Для сравнения мы включили на диаграмму результаты измерений уровня шума эталонной системы охлаждения видеокарты AMD Radeon HD 7970 в идентичных условиях во всём диапазоне её работы. Вертикальными пунктирными линиями соответствующего цвета обозначены границы работы радиальных вентиляторов систем охлаждения видеокарт в их автоматическом режиме. Вот какие результаты мы получили:

Как видим, система охлаждения эталонной NVIDIA GeForce GTX 680 работает действительно тише кулера AMD Radeon HD 7970. Даже несмотря на более высокую максимальную скорость турбины (5200 об/мин у GTX 680 против 4900 об/мин у HD 7970), уровень шума новой видеокарты ниже. Напомним, что верхняя граница работы вентилятора кулера GeForce GTX 680 ограничена 85% мощности, что эквивалентно 4200 об/мин. При продолжительной 3D-нагрузке на обе видеокарты диапазон работы турбин в автоматическом режиме их регулировки составляет 1080-2460 об/мин у GTX 680 и 1000-2640 об/мин у HD 7970 – то есть и в этом плане NVIDIA смогла опередить прямого конкурента. Вместе с этим отметим, что, говоря «тише», мы не имеем ввиду, что «система охлаждения работает тихо», – таковой её можно считать только в 2D-режиме. При запуске любого 3D-приложения кулер GeForce GTX 680 становится слышно на фоне тихого системного блока, и чем продолжительнее нагрузка, тем отчётливее становится слышно видеокарту. Ценителям тихих системных блоков по-прежнему необходимо искать альтернативу эталонному кулеру.

Оверклокерский потенциал

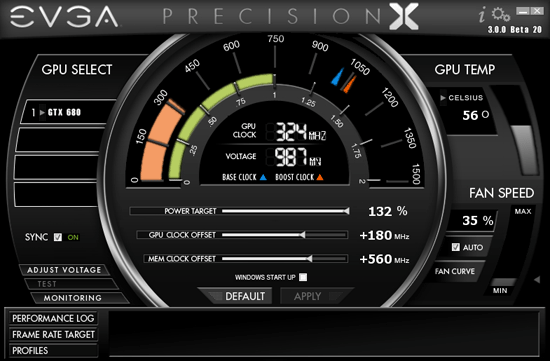

Итак, у нас есть базовая частота графического процессора 1006 МГц и его динамический разгон на 5-10% до 1056/1112 МГц или чуть выше. Разгон мы осуществляли с помощью уже упомянутой здесь утилиты EVGA Precision X версии 3.0.0 Beta 20 путём пошагового увеличения базовой частоты и последующим тестированием в нескольких играх и двух бенчмарках.

Параметр Power Target», регулирующий предел теплового пакета видеокарты был выставлен на максимальные 132%. После нескольких часов непрерывных тестов удалось определить, что базовую частоту ядра можно увеличить на 180 МГц (+17,9%) без потерь в стабильности и качестве картинки, а частоту видеопамяти удалось поднять на 1120 (+18,6%) эффективных мегагерц при итоговых 7128 МГц:

Заметим, что при разгоне система GPU Boost автоматически кратковременно повышала частоту графического процессора вплоть до 1277, а то и до 1304 МГц:

Температура графического процессора разогнанной видеокарты возросла с 81 до 86 градусов Цельсия, а скорость вращения радиального вентилятора повысилась до 2820 об/мин. Добавим, что это лишь первый опыт разгона эталонной GeForce GTX 680 и что при появлении в нашем распоряжении серийных видеокарт мы продолжим изучать оверклокерский потенциал GeForce GTX 680.

Энергопотребление

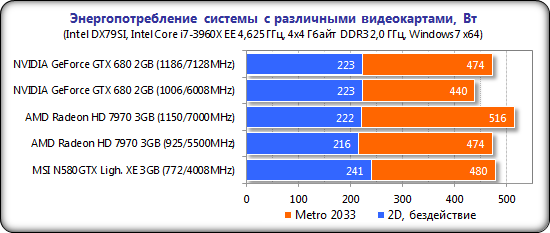

Измерение энергопотребления системы с различными видеокартами осуществлялось с помощью многофункциональной панели Zalman ZM-MFC3, которая показывает потребление системы «от розетки» в целом (без учёта монитора). Измерение было проведено в 2D-режиме, при обычной работе в Microsoft Word или интернет-«серфинге», а также в 3D-режиме, нагрузка в котором создавалась с помощью трёхкратного теста из игры Metro 2033: The Last Refuge в разрешении 1920х1080 при максимальных настройках качества графики. Вот какие результаты были получены:

По энергопотреблению новая GeForce GTX 680 действительно оказалась наиболее экономичной среди конкурентов и на фоне предшественника. Так, Hi-End система с GeForce GTX 680 в пике нагрузки потребляет на 40 Вт меньше электроэнергии, чем система с GeForce GTX 580 и на 34 Вт, чем система с AMD Radeon HD 7970. Да и при разгоне потребление GeForce GTX 680 растёт менее активно, нежели Radeon HD 7970.

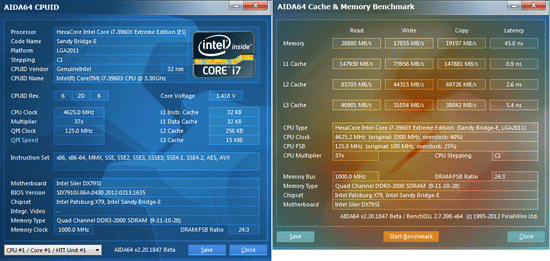

Тестовая конфигурация, инструментарий и методика тестирования

Тестирование видеокарт было проведено на системе следующей конфигурации:

Системная плата: Intel Siler DX79SI (Intel X79 Express, LGA 2011, BIOS 0430 от 13.02.2012);

Центральный процессор: Intel Core i7-3960X Extreme Edition 3,3 ГГц (Sandy Bridge-E, C1, 1,2 В, 6x256 Kбайт L2, 15 Мбайт L3);

Система охлаждения CPU: Phanteks PH-TC14PЕ (2x135 мм, 900 об/мин);

Термоинтерфейс: ARCTIC MX-4;

Оперативная память: DDR3 4x4 Гбайт Mushkin Redline (2133 МГц, 9-11-10-28, 1,65 В);

Видеокарты:

NVIDIA GeForce GTX 680 2 Гбайт/256 бит GDDR5, 1006/6008 МГц;

AMD Radeon HD 7970 3 Гбайт/384 бит GDDR5, 925/5500 МГц и 1150/7000 МГц;

MSI N580GTX Lightning Xtreme Edition 3 Гбайт/384 бит GDDR5, 772/1544/4008 МГц;

Системный диск: SSD 256 Гбайт Crucial m4;

Диск для программ и игр: Western Digital VelociRaptor (SATA-II, 300 Гбайт, 10000 об/мин, 16 Мбайт, NCQ) в коробке Scythe Quiet Drive 3,5";

Архивный диск: Samsung Ecogreen F4 HD204UI (SATA-II, 2 Тбайт, 5400 об/мин, 32 Мбайт, NCQ);

Корпус: Antec Twelve Hundred (передняя стенка – три Noiseblocker NB-Multiframe S-Series MF12-S2 на 1020 об/мин; задняя – два Noiseblocker NB-BlackSilentPRO PL-1 на 1020 об/мин; верхняя – штатный 200-мм вентилятор на 400 об/мин);

Панель управления и мониторинга: Zalman ZM-MFC3;

Блок питания: Xigmatek «No Rules Power» NRP-HC1501 (1500 Вт), 140-мм вентилятор;

Монитор: 30" Samsung 305T Plus.

Логично, что в качестве сегодняшних конкурентов новинке мы выбрали самую быструю видеокарту на графическом процессоре AMD и самую быструю видеокарту на графическом процессоре NVIDIA предыдущего поколения:

MSI N580GTX Lightning Xtreme Edition 3 Гбайт тестировалась только на номинальных частотах, а с AMD Radeon HD 7970 3 Гбайт мы сравнили GeForce GTX 680 и при разгоне первой до частот 1150/7000 МГц.

Для снижения зависимости производительности видеокарт от скорости платформы, 32-нм шестиядерный процессор при множителе 37, опорной частоте 125 МГц и активированной функции «Load-Line Calibration» был разогнан до 4,625 ГГц при повышении напряжения в BIOS материнской платы до 1,45 В:

Технология «Hyper-Threading» активирована. При этом 16 Гбайт оперативной памяти функционировали на частоте 2 ГГц с таймингами 9-11-10-28 при напряжении 1,65 В.

Тестирование, стартовавшее 14 марта 2012 года, было проведено под управлением операционной системы Microsoft Windows 7 Ultimate x64 SP1 со всеми критическими обновлениями на указанную дату и с установкой следующих драйверов:

чипсет материнской платы Intel Chipset Drivers – 9.3.0.1020 WHQL от 26.01.2012;

библиотеки DirectX End-User Runtimes, дата выпуска – 30 ноября 2010 года;

драйверы видеокарт на графических процессорах AMD – Catalyst 12.2 от 07.03.2012 + Catalyst Application Profiles 12.2 (CAP1) от 18.01.2012;

драйверы видеокарт на графических процессорах NVIDIA – GeForce 296.10 WHQL от 13.03.2012 для GTX 580 и GeForce 300.99 beta для GTX 680.

Производительность видеокарт была проверена в двух разрешениях: 1920х1080 и 2560х1600 пикселей. Для тестов были использованы два режима качества графики: «Quality + AF16x» – качество текстур в драйверах по-умолчанию с включением анизотропной фильтрации уровня 16х, и «Quality + AF16x + MSAA 4х(8х)» с включением анизотропной фильтрации уровня 16х и полноэкранного сглаживания степени 4x или 8x, в случаях, когда среднее число кадров в секунду оставалось достаточно высоким для комфортной игры. Включение анизотропной фильтрации и полноэкранного сглаживания выполнялось непосредственно в настройках игр. Если данные настройки в играх отсутствовали, то параметры изменялись в панелях управления драйверов Catalyst и GeForce. Там же была отключена вертикальная синхронизация. Больше никаких изменений в настройки драйверов не вносились.

Cписок тестовых приложений состоит из двух полусинтетических пакетов, одного техно-демо и 15 игр:

3DMark Vantage (DirectX 10) – версия 1.0.2.1, профили настроек «Performance» и «Extreme» (тестировались только основные тесты);

3DMark 2011 (DirectX 11) – версия 1.0.3.0, профили настроек «Performance» и «Extreme»;

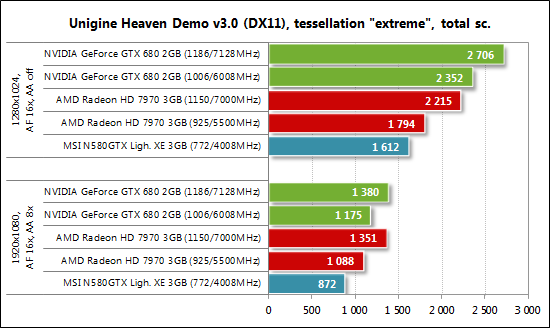

Unigine Heaven Demo (DirectX 11) – версия 3.0, максимальные настройки качества, тесселляция на уровне «extreme», AF16x, разрешение 1280х1024 без MSAA и 1920х1080 с MSAA 8x;

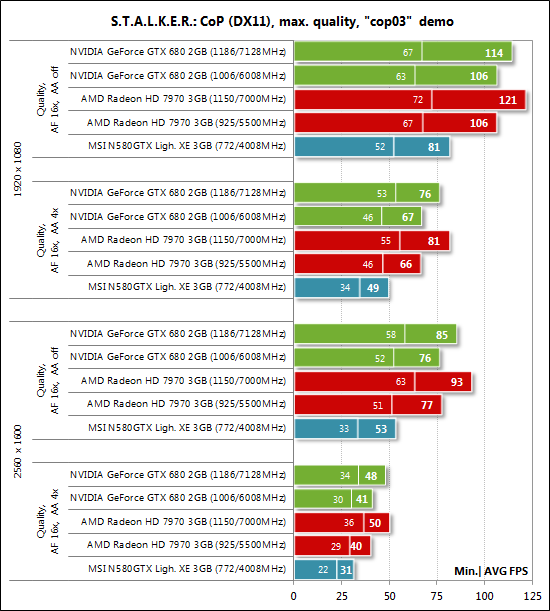

S.T.A.L.K.E.R.: Call of Pripyat (DirectX 11) – версия 1.6.02, профиль настроек «Улучшенное динамическое освещение DX11» с дополнительным выставлением вручную всех параметров на максимум, тестировалась собственная демо-запись «cop03» на уровне «Затон»;

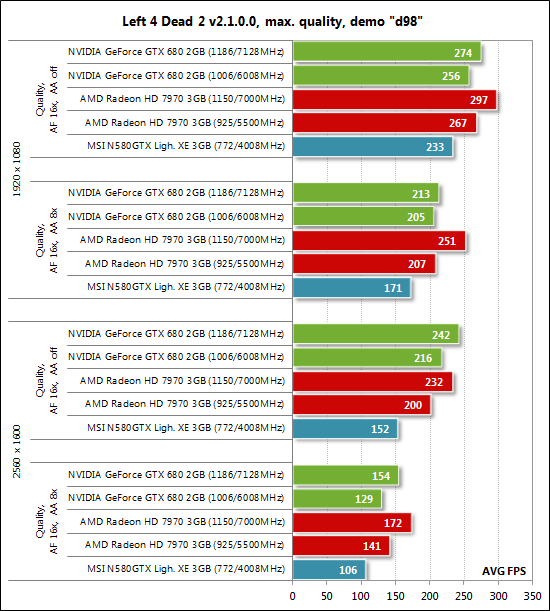

Left 4 Dead 2 (DirectX 9) – версия игры 2.1.0.0, максимальное качество, тестировалась собственная демо-запись «d98» (два цикла) на карте «Death Toll» этапе «Church»;

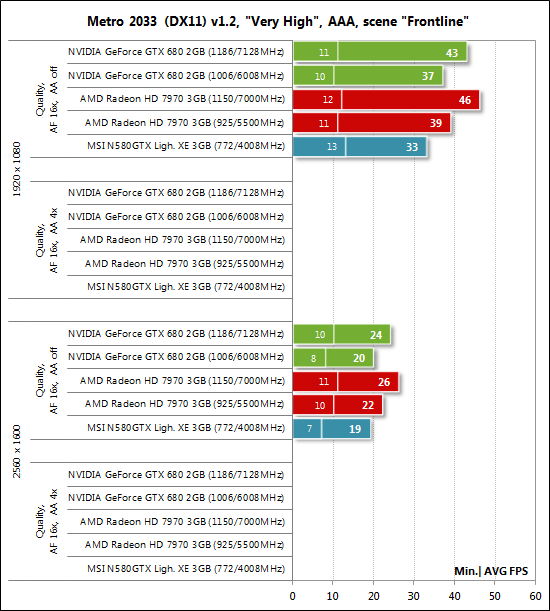

Metro 2033: The Last Refuge (DirectX 10/11) – версия 1.2, использовался официальный тест, настройки качества «Very High», тесселляция, DOF включено, использовалось ААА-сглаживание, двойной последовательный проход сцены «Frontline»;

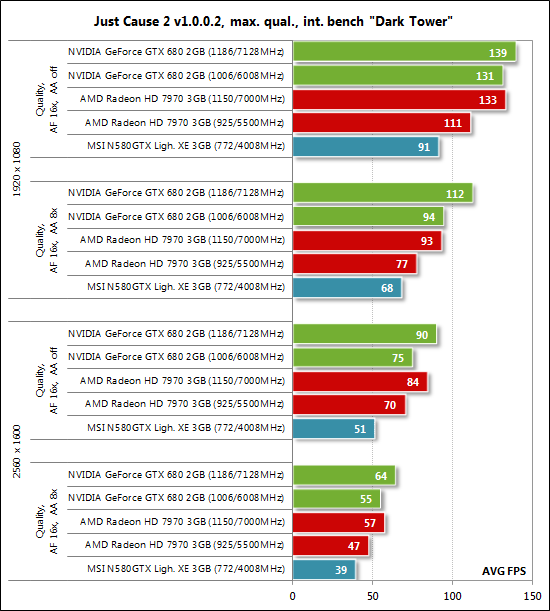

Just Cause 2 (DirectX DX10.1) – версия 1.0.0.2, максимальные настройки качества, методики «Размытие фона» и Симуляция воды GPU» отключены, двойной последовательный проход демо-записи «Тёмная башня»;

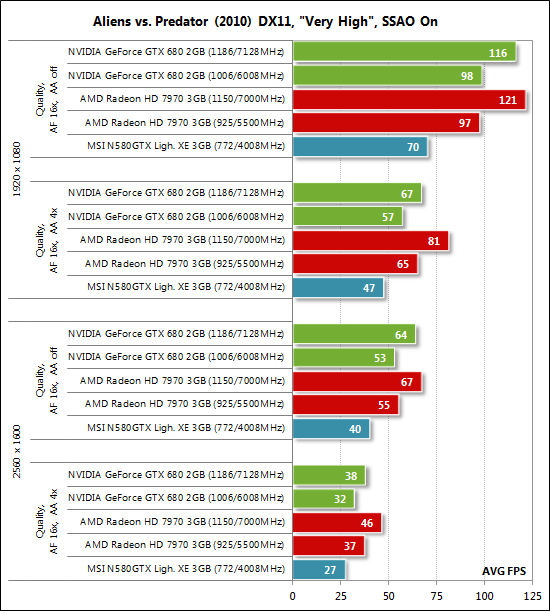

Aliens vs. Predator (2010) (DirectX 11) – «Texture Quality» в режиме «Very High», «Shadow Quality» в режиме «High», технология SSAO включена, два цикла теста в каждом разрешении;

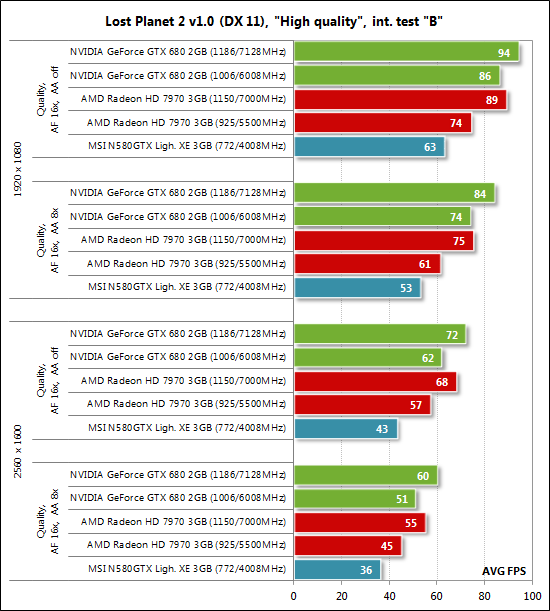

Lost Planet 2 (DirectX 11) – версия игры 1.0, максимальные настройки качества графики, размытие движения включено, использовался тест производительности «В»;

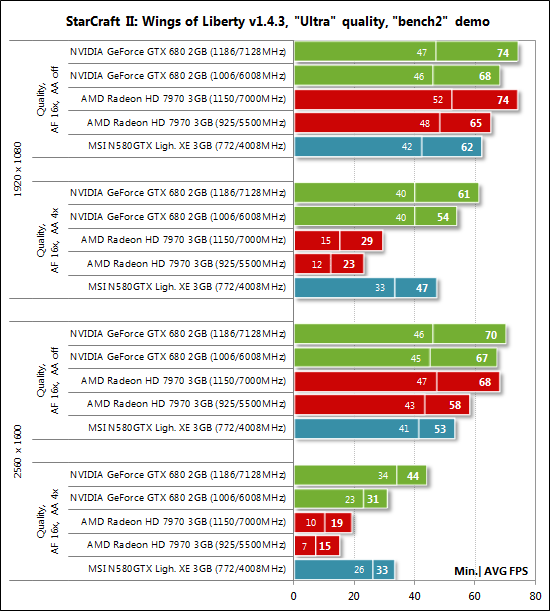

StarCraft II: Wings of Liberty (DirectX 9) – версия игры 1.4.2, все настройки графики на уровень «Extreme», физика «Ультра», отражения включены, двукратный двухминутный тест собственного демо «bench2»;

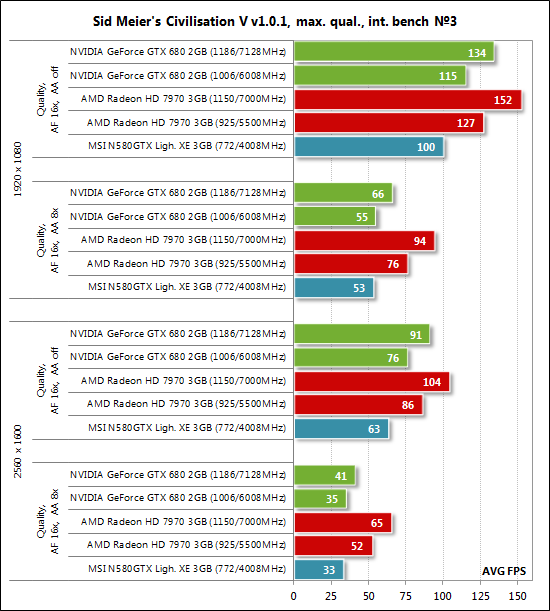

Sid Meier's Civilization V (DirectX 11) – версия игры 1.0.1.348, максимальные настройки качества графики, двойной прогон «дипломатического» теста из пяти самых тяжёлых сцен;

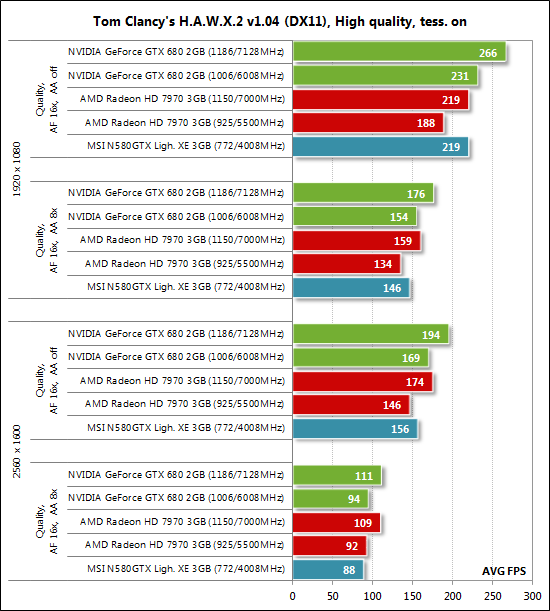

Tom Clancy's H.A.W.X. 2 (DirectX 11) – версия 1.04, максимальные настройки качества графики, тени активированы, тесселляция включена, двойной прогон тестовой сцены;

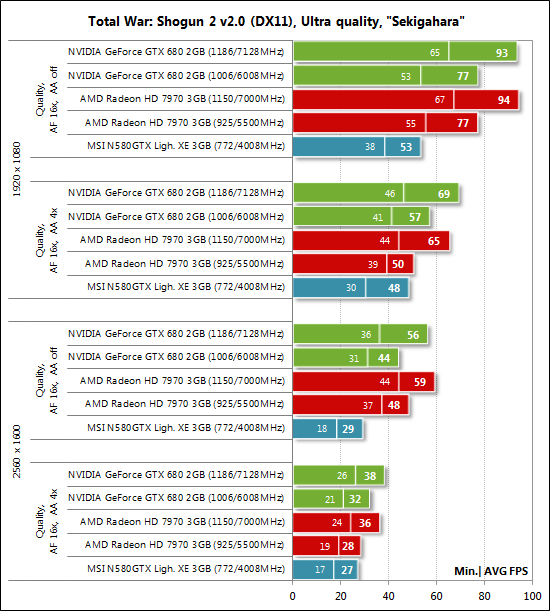

Total War: Shogun 2 (DirectX 11) – версия 2.0, встроенный тест (битва при Sekigahara) на максимальных настройках качества графики и использовании в одном из режимов MSAA 4x;

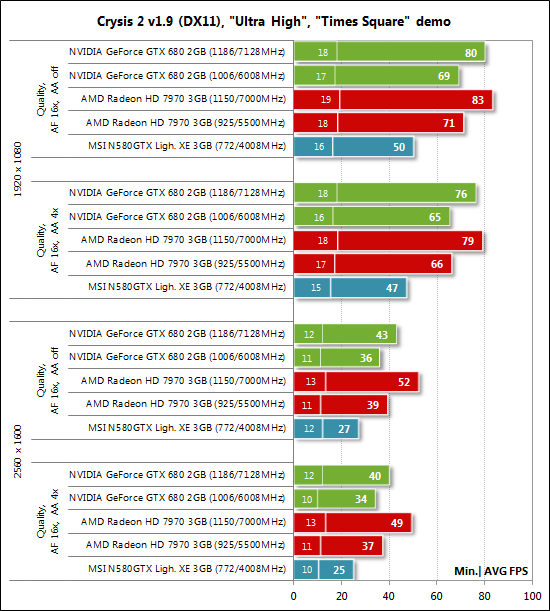

Crysis 2 (DirectX 11) – версия 1.9, использовался Adrenaline Crysis 2 Benchmark Tool v1.0.1.13 BETA, профиль настроек качества графики «Ultra High», текстуры высокого разрешения активированы, двукратный цикл демо-записи на сцене «Times Square»;

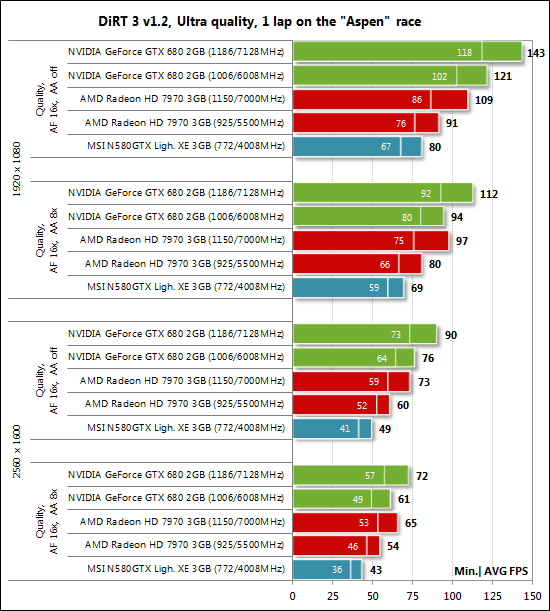

DiRT 3 (DirectX 11) – версия 1.2, встроенный тест на трассе «Aspen» при максимальных настройках качества графики;

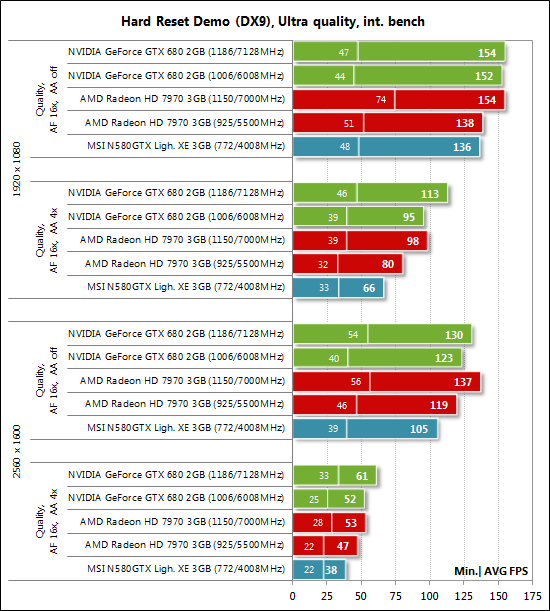

Hard Reset Demo (DirectX 9) – встроенный в демо-версию тест при Ultra-качестве графики, один проход тестовой сцены;

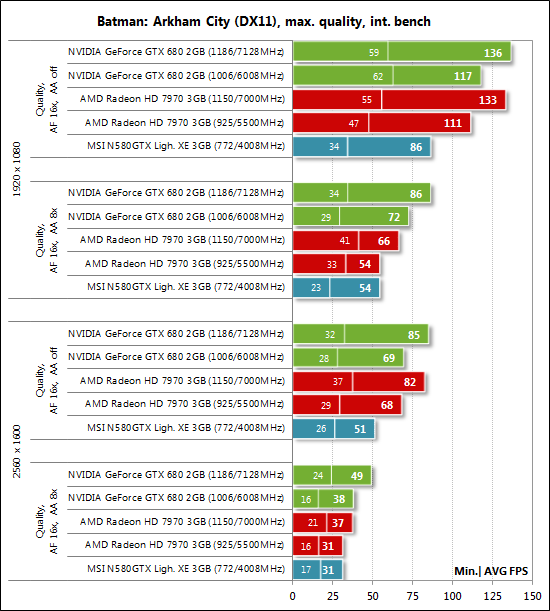

Batman: Arkham City (DirectX 11) – версия 1.2, максимальные настройки качества графики, физика отключена, двойной последовательный проход встроенного в игру теста;

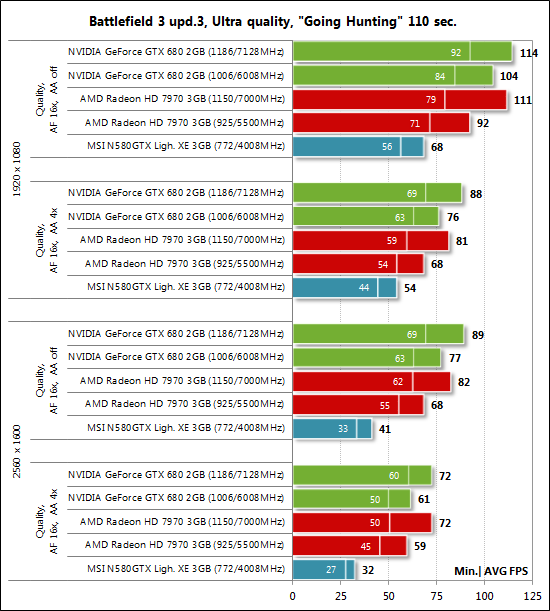

Battlefield 3 (DirectX 11) – версия 1.3, все настройки качества графики на «Ultra», двойной последовательный проход заскриптованной сцены из начала миссии «На охоту» продолжительностью 110 секунд.

Более подробное описание методик тестирования видеокарт и графических настроек в некоторых из перечисленных играх вы можете найти в специально для этого созданной ветке нашей конференции, а также поучаствовать в обсуждении и совершенствовании этих методик.

Если в играх реализована возможность фиксации минимального числа кадров в секунду, то оно также отражалось на диаграммах. Каждый тест проводился дважды, за окончательный результат принималось лучшее из двух полученных значений, но только в случае, если разница между ними не превышала 1%. Если отклонения прогонов тестов превышали 1%, то тестирование повторялось ещё, как минимум, один раз, чтобы получить достоверный результат.

Результаты тестов производительности

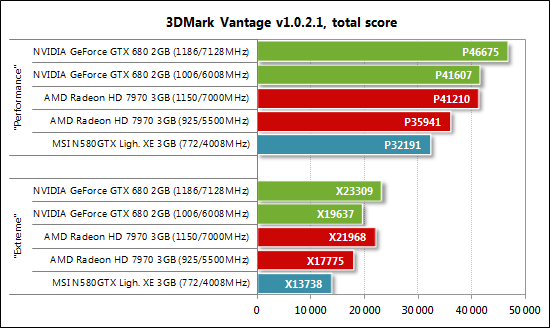

3DMark Vantage

В первом же полусинтетическом тесте новая GeForce GTX 680 2 Гбайт проявила себя во всей красе, продемонстрировав 29-43% преимущество над GeForce GTX 580 3 Гбайт и опередив Radeon HD 7970 на 11-16%, в зависимости от режима качества. Что интересно, при разгоне HD 7970 до частот 1150/7000 МГц в режиме «Performance» она способна сравняться с уровнем производительности номинальной GTX 680, но не превзойти его. А вот в качественном, более ресурсоёмком режиме настроек «Extreme» разгон позволяет видеокарте на AMD «Tahiti» вырваться вперёд, хотя поднятие частот GTX 680 до 1186/7128 МГц и динамический разгон ядра позволяет ей вернуть лидерство. Неплохое начало для «Kepler», посмотрим как всё будет дальше.

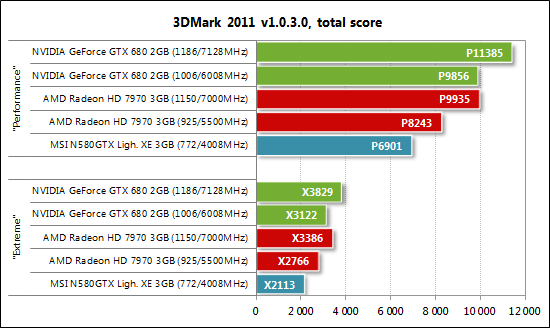

3DMark 2011

Похожим образом складывается ситуация и в 3DMark 2011, но здесь уже преимущество новинки над GeForce GTX 580 достигает 43-48%, а над Radeon HD 7970 – 13-20% в номинальном режиме работы обеих видеокарт. При разгоне также лидирует GTX 680.

Unigine Heaven Demo

Без сюрпризов и Unigine Heaven – GeForce GTX 680 быстрее GTX 580 на 35-46% и выигрывает у HD 7970 от 8 до 31%. Однако нельзя не заметить, что с ресурсоёмким режимом с использованием сглаживания AMD отстаёт совсем немного как в номинальном режиме работы, так и при разгоне. Похоже, 256-битная шина видеопамяти GeForce GTX 680 может сыграть с этой видеокартой злую шутку в наиболее «тяжёлых» графических режимах.

И всё же в целом в синтетических бенчмарках победа осталась за GeForce GTX 680. Теперь посмотрим, подтвердит ли новинка своё преимущество в реальных играх?

S.T.A.L.K.E.R.: Call of Pripyat

Прямо сказать – не убедительно выглядит GeForce GTX 680 в S.T.A.L.K.E.R.: Call of Pripyat, так как производительность новинки всего-лишь равна производительности Radeon HD 7970, а при разгоне последняя и вовсе вырывается вперёд. Справедливости ради, отметим, что GTX 680 всё же опережает GTX 580 на 32-43%, что довольно неплохо.

Left 4 Dead 2

С учётом очень высокого уровня производительности, продемонстрированного видеокартами в игре Left 4 Dead 2, актуальным для сравнения здесь является наиболее ресурсоёмкий режим – 2560х1600 с MSAA8x. А в нём, как мы видим, преимущество на стороне AMD Radeon HD 7970.

Metro 2033: The Last Refuge

Metro 2033: The Last Refuge стала третьей подряд игрой, где GeForce GTX 680 не смогла убедительно опередить Radeon HD 7970 и продемонстрировать с ног сшибающую производительность. Да и преимущество над GTX 580 выливается всего в 5-12%, что откровенно мало при смене поколений графических процессоров. Мда…, пока невесело складывается ситуация с «Kepler» – действующий соперник оказался слишком крепким «орешком».

Just Cause 2

Just Cause 2 оказалась первой игрой тестового списка, где NVIDIA GeForce GTX 680 одерживает победу над AMD Radeon HD 7970. Преимущество новинки колеблется от 7 до 22 % в зависимости от режима качества и разрешения. Что интересно, даже впечатляющий разгон видеокарты на графическом процессоре «Tahiti» не позволяет ей выйти в лидеры в Just Cause 2, –столь уверенно здесь выглядит GeForce GTX 680. Добавим, что от Hi-End видеокарты предыдущего поколения – GeForce GTX 580 – ей удаётся оторваться на 38-47%.

Aliens vs. Predator (2010)

Недолго длился праздник на зелёной улице – красные в лице AMD Radeon HD 7970 возвращают себе лидерство уже в Aliens vs. Predator (2010), опережая GeForce GTX 680 на 4-14%. Особенно явно это можно наблюдать в режиме с использованием сглаживания (вновь сказывается пресловутая ширина шины). Примечательно, что недостаток в пропускной способности памяти можно отследить и по преимуществу GeForce GTX 680 (256 бит) над GeForce GTX 580 (384 бит), которое в режимах без использования MSAA4x составляет неплохие 33-40%, а при его активации снижается до посредственных 19-21%.

Lost Planet 2

Графический движок игры Lost Planet 2 больше подходит к архитектуре чипов NVIDIA, поэтому их победа в этом тесте неудивительна. GeForce GTX 680 оказывается быстрее Radeon HD 7970 на 9-21% в зависимости от режима качества и разрешения. Неплохой прирост производительности новинки и в сравнении с GeForce GTX 580, составляющий 37-44%.

StarCraft II: Wings of Liberty

Побеждает GeForce GTX 680 конкурента и в игре StarCraft II: Wings of Liberty, где с использованием сглаживания разрыв превышает 100-процентную отметку. Но и в этом тесте есть подтверждение того, что 384-битная шина не помешала бы GeForce GTX 680 – посмотрите на результаты новой видеокарты и GeForce GTX 580 в самом ресурсоёмком режиме, где победа остаётся за «старичком» GTX 580.

Sid Meier's Civilization V

Реванш AMD Radeon HD 7970 не заставил себя долго ждать и уже в Sid Meier's Civilization V она оказывается быстрее NVIDIA GeForce GTX 680. Особо удручает проигрыш новинки в режимах с использованием сглаживания, где GTX 680 уступает HD 7970 28-33%. Показательно и преимущество видеокарты на «Kepler» над видеокартой на «Fermi» в этих же режимах – всего 4-6% производительности.

Tom Clancy's H.A.W.X. 2

В Tom Clancy's H.A.W.X. 2 новая GeForce GTX 680 опережает конкурента, но снова «со скрипом», да и отрыв от GeForce GTX 580 минимален (5-8%).

Total War: Shogun 2

А вот тот факт, что и в Total War: Shogun 2 GeForce GTX 680 смогла опередить Radeon HD 7970 можно считать сюрпризом, ведь эта игра больше подходит архитектуре графических процессоров AMD и создана при поддержке этой компании. Тем не менее, GTX 680 здесь немного быстрее HD 7970. В то же время проблемы с недостаточностью пропускной способности памяти GeForce GTX 680 можно увидеть и здесь.

Crysis 2

В Crysis 2 производительность GeForce GTX 680 и Radeon HD 7970 в номинальном режиме работы одинакова, но при разгоне AMD берёт верх, за счёт более высоких достигнутых частот относительно номинальных. Также отметим неплохой прирост производительности новинки в сравнении с GeForce GTX 580.

DiRT 3

Еще большее преимущество GeForce GTX 680 над GTX 580 можно наблюдать в игре DiRT 3, где оно достигает 55%. Да и в противостоянии с AMD Radeon HD 7970 новинка выходит победителем, опередив её на 18-33%.

Hard Reset Demo

Похожую ситуацию можно наблюдать и в ресурсоёмких режимах игры Hard Reset:

Batman: Arkham City

Уверенно побеждает GeForce GTX 680 и в тесте игры Batman: Arkham City…

Battlefield 3

…, а также в Battlefield 3:

Приложим итоговую таблицу с результатами тестов, и перейдём к общей оценке производительности видеокарт по сводным диаграммам.

Сводные диаграммы

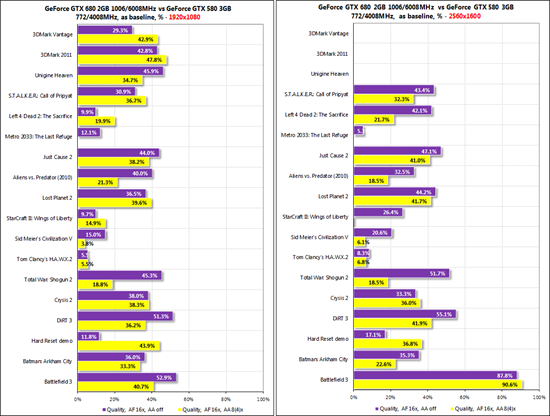

Прежде всего, посмотрим, на сколько NVIDIA GeForce GTX 680 2 Гбайт опережает самую быструю однопроцессорную видеокарту предыдущего поколения GeForce GTX 580 3 Гбайт, производительность которой принята на диаграммах за начальную точку отсчёта, а прирост производительность GTX 680 показан в процентах от неё:

В среднем по всем тестам GeForce GTX 680 опережает предшественницу на 30-31% в разрешении 1920х1080 пикселей и на 29-37% в разрешении 2560х1600 пикселей. Если вспомнить прирост производительности Radeon HD 7970 против HD 6970 по этому же набору тестов, то у AMD он оказался немного выше, чем у NVIDIA, но, как мы с вами помним, GeForce GTX 580 изначально обладала более высокой производительностью, чем Radeon HD 6970. Помимо среднего прироста производительности нельзя ещё раз не упомянуть о недостаточности 256-битной шины видеопамяти GeForce GTX 680, которая хорошо видна по разнице в приростах производительности между режимами со сглаживанием и без него.

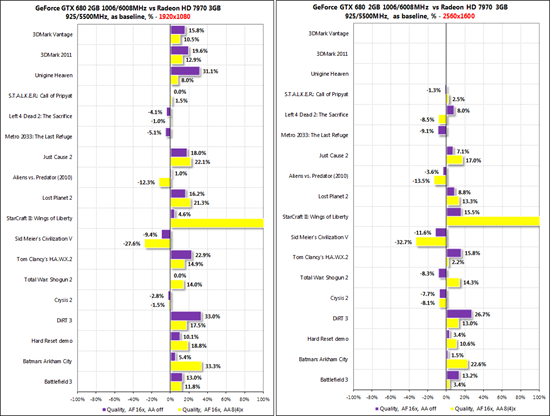

Далее на очереди, пожалуй, самая интересная пара сводных диаграмм, на которых мы сравним производительность NVIDIA GeForce GTX 680 и AMD Radeon HD 7970 на номинальных частотах. За нулевую ось приняты результаты последней видеокарты, а результаты новой карты на графическом процессоре с архитектурой «Kepler» показаны в процентном отношении от неё:

Итак, GeForce GTX 680 одерживает победы во всех трёх синтетических тестах, а также в играх Just Cause 2, Lost Planet 2, StarCraft II: Wings of Liberty, Tom Clancy's H.A.W.X.2, DiRT 3, Hard Reset, Batman: Arkham City и Battlefield 3. В свою очередь, AMD Radeon HD 7970 быстрее конкурента в играх Left 4 Dead 2: The Sacrifice, Metro 2033: The Last Refuge, Aliens vs. Predator (2010), Sid Meier's Civilization V и Crysis 2, а в S.T.A.L.K.E.R.: Call of Pripyat и Total War: Shogun 2 борьба ведётся с переменным успехом. Если же брать среднее арифметическое по всем тестам (что, конечно, не совсем корректно хотя бы из-за результата StarCraft II: Wings of Liberty), то GeForce GTX 680 быстрее Radeon HD 7970 на 9-16% в разрешении 1920х1080 пикселей и на 4-10% в разрешении 2560х1600 пикселей.

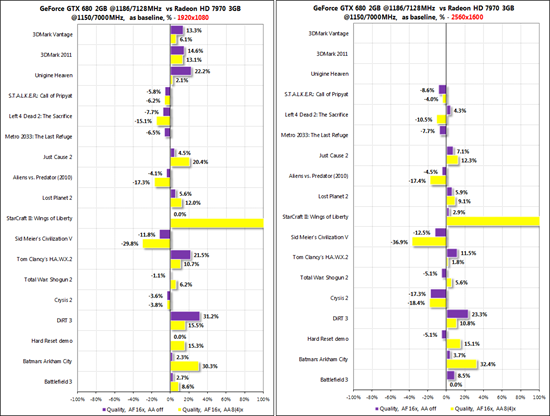

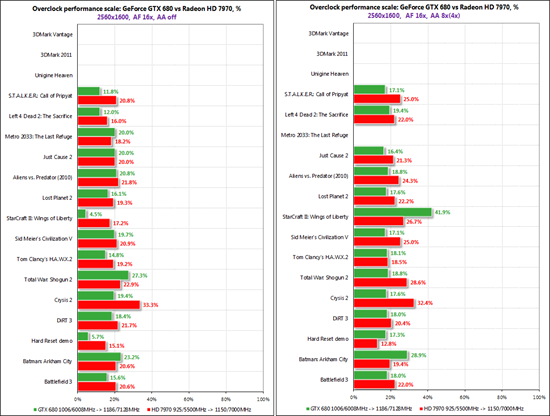

Сравнивая результаты разогнанных видеокарт AMD Radeon HD 7970 и NVIDIA GeForce GTX 680, нужно помнить, что прирост частот на Radeon составил +24,3/27,3% (ядро/память), а на GeForce без учёта динамического разгона он оказался скромнее и был равен +17,3/18,6%, то есть, скорее всего, AMD приблизится к конкуренту в тех тестах, где отставала и ещё более оторвётся от него в тех тестах, где выигрывала. Так и вышло:

В среднем по всем тестам преимущество разогнанной до 1186/7128 МГц NVIDIA GeForce GTX 680 2 Гбайт над разогнанной до 1150/7000 МГц AMD Radeon HD 7970 3 Гбайт сократилось до 4-11% в разрешении 1920х1080 пикселей и до 1-9% в разрешении 2560х1600 пикселей.

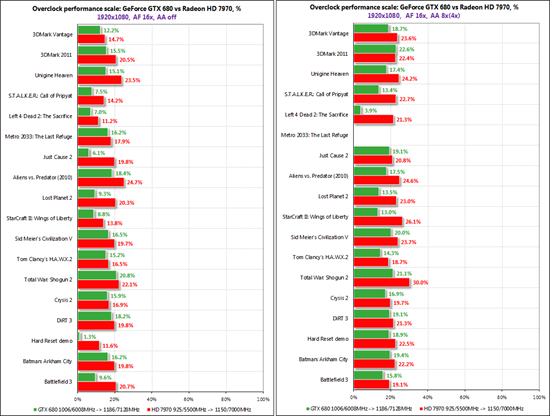

Кстати, напоследок приведём сравнение прироста производительности обеих видеокарт от разгона, где хорошо видно, что AMD Radeon HD 7970 лидирует практически во всех тестах и в разрешении 1920х1080…

… и в 2560х1600 пикселей:

В среднем при приросте частот NVIDIA GeForce GTX 680 на 17,3/18,6% производительность возросла на 12,8-16,8% в разрешении 1920х1080 и на 16,6-20,4% в 2560х1600. В свою очередь, на Radeon HD 7970 при повышении частот графического процессора/видеопамяти на 24,3/27,3% производительность возросла на 18,2-22,7% в 1920х1080 и на 20,5-22,9% в 2560х1600.

Заключение

Можно сказать, что ответный ход NVIDIA в лице GK104 на архитектуре «Kepler» состоялся. По совокупности всех тестов GeForce GTX 680 оказалась немного быстрее AMD Radeon HD 7970, заметно тише, энергоэффективнее, а сама видеокарта и печатная плата компактнее и легче. Кроме того, GeForce GTX 680 поддерживает новые эффективные алгоритмы сглаживания FXAA и TXAA, которые мы планируем изучить в следующих статьях, а также адаптивный V-Sync, способный повысить комфорт в играх. Не будем забывать и про наличие всех актуальных выходов последних версий и поддержку мульти-мониторов. Финальным аккордом к всему вышесказанному звучит рекомендованная стоимость, заявленная на отметке 499 долларов США, что на 50 долларов США ниже рекомендованной стоимости AMD Radeon HD 7970. Однако, у AMD Radeon HD 7970 есть трёхмесячная «фора», благодаря которой уже сегодня количество видеокарт с оригинальными системами охлаждения и повышенными частотами (а, порой, и весьма прилично повышенными) превышает полтора десятка, в то время, как у NVIDIA они ещё даже не анонсированы. Сейчас же однозначно можно сказать, что появление GeForce GTX 680 приведёт к обострению конкуренции в этом ценовом диапазоне и, скорее всего, повлечёт за собой снижение стоимости видеокарт. А от этого мы с вами будем только в выигрыше.

За кадром:

Первые драйверы NVIDIA GeForce версии 300.99 оставили о себе впечатление довольно «сырого» программного продукта – рывки в Metro 2033, редкие дефекты изображения в Crysis 2 и Battlefield 3, а также длинные задержки при загрузке тестов 3DMark Vantage. Будем надеяться, что новые версии не только исправят эти и другие баги, но и поднимут производительность видеокарты.

Замена штатного термоинтерфейса на графическом процессоре на ARCTIC MX-4 позволила снизить температуру GPU на 4 градуса Цельсия в пике нагрузки и уменьшить максимальную скорость радиального вентилятора на 120 об/мин в автоматическом режиме работы.

Иногда система с установленной GeForce GTX 680 просто не запускалась, капитулируя двумя длинными писками. Вероятно это какая-то частичная несовместимость с материнской платой Intel Siler DX79SI, а может и особенность предоставленного на тестирование экземпляра GeForce GTX 680.

Во время проверки оверклокерского потенциала видеокарты прослеживалась высокая зависимость стабильности от эффективности охлаждения. Так, например, если температура графического процессора не превышала 70 градусов Цельсия (на 85% мощности турбины), то можно было выжать ещё 15-20 МГц по ядру.