Ваш город: Москва

VisionTek Xtasy GeForce4 Ti4600. Эпидемия разгона продолжается.

Введение

В этом обзоре мы рассмотрели самое современное и самое дорогое детище компании VisionTek - видеокарту VisionTek Xtasy GeForce4 Ti4600, основанную на базе NVIDIA GeForce4 Ti4600 - на данный момент самого мощного из существующих игровых чипов.

Используя более чем успешный опыт экстремального разгона VisionTek Xtasy GeForce4 Ti4400, мы подвергли жестоким испытаниям и эту видеокарту. Исследовав разгонный потенциал чипов NVIDIA GeForce4 Ti4600, мы попробуем дать ответ на вопрос: а стоит ли овчинка выделки - какой прирост производительности при экстремальном разгоне будет иметь и так уже самая мощная на сегодня видеокарта, и имеет ли смысл рисковать и подвергать такие платы экстремальному разгону?

VisionTek Xtasy GeForce4 Ti4600

Видеокарта VisionTek Xtasy GeForce4 Ti4400 поставляется в Retail-варианте - в такой же картонной коробке, что и VisionTek GeForce4 Ti4400:

Помимо самой платы, в комплект поставки входят компакт-диски с драйверами и утилитами (Cyberlink PowerDVD и PowerDirector), руководство по установке в виде раскладного буклета, а также разветвитель с комбинированного разъема VIVO на 2 S-Video:

По наклейке на крыльчатке кулера можно определить, что это - видеокарта от VisionTek, в остальном же плата выглядит стандартно. VisionTek Xtasy GeForce4 Ti4600 выполнена по референс-дизайну от NVIDIA и укомплектована выходами VGA, DVI-I и Video-In/Video-Out:

Функции поддержки Video-In/Video-Out возложены на применяемый повсеместно чип Philips SAA7108, который установлен на лицевой стороне платы.

"Сердце" видеокарты - самое мощное на сегодня творение NVIDIA: чип GeForce4 Ti4600 с тактовой частотой 300 МГц:

На плате установлено 128 МБ видеопамяти в микросхемах DDR SDRAM от SAMSUNG с временем цикла 2.8нс. Тактовая частота работы видеопамяти - 650 (325DDR) МГц:

Итак, перед нами - настоящий "монстр" игровой 3D-графики. Посмотрим, на что будет способен этот монстр при экстремальном разгоне. Для начала - доработаем систему охлаждения.

Доработка системы охлаждения

Для отвода тепла при экстремальном разгоне требуется что-то помощнее, чем стандартная система охлаждения графического ядра.

Лучше всего подошел кулер Thermaltake Mini Copper Orb, который после разборки уже помогал нам при экстремальном разгоне ATI RADEON 8500 и VisionTek Xtasy GeForce4 Ti4400:

Перед установкой кулера пришлось привести в надлежащее состояние поверхность графического ядра - с помощью мелкой наждачной бумаги сделать её не вогнутой, а идеально плоской:

Очень интересно проявилась вогнутость медной прокладки, прикрывающей кристалл: самое "глубокое" её место оказалось как раз над кристаллом, в результате чего при обработке наждачной бумагой в этом месте с шайбы даже не был стерт слой металла, которым покрыта её поверхность. На фото это отлично видно.

Кулер был установлен на отечественную термопасту КПТ-8 и за ребра надежно прижат к плате нейлоновыми стяжками, пропущенными через отверстия в плате.

Радиаторы на микросхемы видеопамяти я не устанавливал. Точнее, пробовал устанавливать, но, как показал опыт, установка радиаторов на микросхемы видеопамяти не дала никакого выигрыша при разгоне. Впрочем, если плата будет установлена в корпус с плохой вентиляцией, радиаторы, похоже, придется установить - каждая из таких микросхем может выделять до 2 Вт в виде тепла, а это не так уж и мало.

После всех перенесенных издевательств плата VisionTek Xtasy GeForce4 Ti4600 стала выглядеть так:

Максимальные частоты, на которых видеокарта VisionTek GeForce4 Ti4600 заработала устойчиво без повышения напряжения, то есть, при обычном разгоне, составили 315/750(375DDR) МГц.

Повышение напряжения питания и экстремальный разгон

Повышение напряжения питания графического ядра

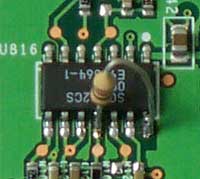

На VisionTek Xtasy GeForce4 Ti4600, как и на всех видеокартах на базе NVIDIA GeForce4 Ti4600, выполненных по референс-дизайну, питание графического ядра обеспечивается с помощью стабилизатора SC1102CS от Semtech. Эта микросхема представляет собой контроллер для импульсных блоков питания и DC/DC преобразователей. Выходное напряжение стабилизатора задается величиной сопротивлений резисторов в делителе R8R7 (на типовой схеме включения) и вычисляется по формуле Vout=Vref*(1+R8/R7), где Vref - опорное напряжение, которое для SC1102CS составляет 1.265В. Нумерация резисторов в формуле взята из типовой схемы включения:

Для повышения напряжения питания графического ядра проще всего уменьшить сопротивление R7 (на типовой схеме включения) зашутнировав его параллельно подключенным резистором. Это и было проделано: к ножкам 11 и 14 микросхемы SC1102CS был припаян резистор сопротивлением 1кОм:

В результате соотношение R8/R7 (на типовой схеме включения) изменилось, и выходное напряжение стабилизатора поднялось с 1.66В до 1.81В.

В процессе издевательств над видеокартой я повышал напряжение на графическом ядре еще сильнее, до 2 В, но никакого дополнительного прироста частоты при разгоне не получал. 340 МГц - максимальная частота, при которой графическое ядро работало при экстремальном разгоне. К слову, максимальная частота чипа NVIDIA GeForce4 Ti4400 при экстремальном разгоне оказалась точно такой же. Видимо, 340-350 МГц - предел, обусловленный внутренней архитектурой и технологией производства NVIDIA GeForce4 Ti4600/Ti4400.

В итоге я решил остановиться на совсем небольшой величине повышения напряжения питания - всего 9% - зачем заставлять графическое ядро работать на износ, когда предельной частоты можно достигнуть при совсем небольшом повышении напряжения питания?

Повышение напряжения питания видеопамяти

Питание микросхем видеопамяти обеспечивается стабилизатором, выполненным на микросхеме SC1175CSW. Это контроллер импульсного стабилизатора, аналогичный SC1102CS, но имеющий два независимых канала. На платах на базе NVIDIA GeForce4 Ti4600 один канал этого стабилизатора обеспечивает питание внутренних цепей и буферов ввода-вывода микросхем видеопамяти (VDD/VDDQ), а второй стабилизирует нагрузочное напряжение (Vtt) для цепей согласования по полному сопротивлению. Схема согласования приведена в документации к микросхемам видеопамяти DDR SDRAM от Samsung, которые применяются на платах с NVIDIA GeForce4 Ti4600:

Интересно, что из всей серии видеокарт на базе NVIDIA GeForce4 Ti/MX такие цепи согласования есть только на видеокартах на базе NVIDIA GeForce4 Ti4600, то есть, только на самых "скоростных".

С величиной Vtt сложилась интересная ситуация: по идее, при повышении напряжения питания микросхем видеопамяти нужно пропорционально повышать и величину Vtt (Vtt должно быть равно 0.5*VDDQ), однако, никаких положительных или отрицательных изменений в устойчивости работы и достижении максимальной частоты при пропорциональном увеличении Vtt я не обнаружил. Поэтому Vtt было решено оставить в покое, не усложняя себе жизнь без лишней надобности. C VREF же проблем и вовсе нет, для каждой из микросхем видеопамяти оно получается из VDDQ прямо "на месте", простыми резисторными делителями.

Напряжения питания внутренних цепей и буферов ввода-вывода у микросхем, применяемых на NVIDIA GeForce4 Ti4600, совпадают, поэтому VDD и VDDQ соединены, а питание микросхем обеспечивается одним каналом стабилизатора SC1175CSW. Выходное напряжение на стабилизаторе задается соотношением сопротивлений резисторов в делителях по формулам Vout1=Vref*(1+R15/R14) и Vout2=Vref*(1+R13/R11), где Vref для SC1175CSW составляет 1.25В, а нумерация резисторов - по типовой схеме включения:

Напряжение питания микросхем видеопамяти по умолчанию - 2.83В.

Vout1 было повышено с помощью шунтирования R14 резистором сопротивлением 720 Ом, который был подпаян к ножкам 18 и 20 микросхемы-контроллера:

При этом напряжение питания микросхем видеопамяти увеличилось до 3.09В. Когда я пытался увеличить напряжение на видеопамяти хотя бы чуть сильнее, видеокарта начинала работать неустойчиво, на экране появлялась рябь и выпадающие пикселы, которые возникали уже на этапе загрузки тестового компьютера. Поэтому было решено остановиться на 3.09В - напряжение питания микросхем видеопамяти было повышено всего лишь на 9.2%.

Максимальная частота видеопамяти, при которой видеокарта VisionTek Xtasy GeForce4 Ti4600 заработала устойчиво, составила 800(400DDR) МГц.

Итак, после модификации максимальные частоты графического ядра и видеопамяти на VisionTek Xtasy GeForce4 Ti4600 составили 340/800(400DDR) МГц - весьма неплохо, особенно если учесть, что напряжения питания графического ядра и видеопамяти были подняты всего лишь на 9%. Прирост частоты графического ядра при этом составил всего 13.3%, в то время, как частота видеопамяти увеличилась на 23.1%.

Условия тестирования

Конфигурация тестовой системы:

Процессор - AMD Athlon XP 2000+;

Материнская плата – MSI K7T266 Pro2 v2.0 (VIA KT266A);

Память - 2*256 МБ DDR SDRAM PC 2700 Crucial CL2.5;

Жесткий диск – Fujitsu MPF3153AH.

Программное обеспечение:

Драйвер Detonator 29.20 под Windows XP для видеокарт на базе чипов от NVIDIA;

Windows XP;

Codecult Codecreatures;

3DMark 2001 SE;

Настройки режимов тестирования:

3DMark 2001:

Настройки: 32-битный буфер кадра, 32-битные текстуры, 32(24)-битный Z-буфер, D3D Pure Hardware T&L.

Codecult Codecreatures:

При тестировании были использованы настройки по умолчанию.

Производительность в 3D

В этом обзоре мы решили лишь ограничиться тестированием лишь в самых "тяжелых" тестах - Codecult Codecreatures и 3DMark 2001 Nature. Более подробно работа чипов на базе NVIDIA GeForce4 при разгоне и зависимость их производительности от частот ядра и видеопамяти рассмотрены в обзоре "VisionTek Xtasy GeForce4 Ti4400. Модификация и экстремальный разгон".

3DMark 2001 - Nature:

Прирост производительности при экстремальном разгоне составил примерно 20%.

Codecult Codecreatures:

В Codecreatures прирост производительности оказался меньше, и это неудивительно: при экстремальном разгоне VisionTek GeForce4 Ti4400 мы уже выяснили, что этот тест отзывается на рост частоты графического ядра гораздо более чутко, чем на разгон видеопамяти, а частота ядра при экстремальном разгоне увеличилась всего лишь на 13.3%.

Тест 3DMark 2001 - Nature более требователен к величине пропускной способности видеопамяти, поэтому и результаты экстремального разгона оказались более высокими, ведь прирост частоты видеопамяти составил 23.1%:

Заключение

Что ж, результаты экстремального разгона VisionTek Xtasy GeForce4 Ti4600 нельзя назвать выдающимися.

Причина состоит в том, что номинальные тактовые частоты графического ядра и видеопамяти находятся очень близко к предельным частотам, обусловленным архитектурой и технологией производства чипов, а в такой ситуации даже надеяться на хороший разгонный потенциал не стоит.

Особенно тяжело дается разгон графического ядра: 13% прироста частоты - это очень мало по сравнению с тем, что было во времена NVIDIA GeForce2/GeForce3. Очевидно, что инженеры компании NVIDIA при создании чипов серии GeForce4 Titanium пытались выжать максимальные частоты из того, что есть: модернизированного ядра NVIDIA GeForce3 и 0.15мкм-технологии производства чипов, а значит, на долю бедного разгонщика осталось не так уж много.

Такая ситуация сильно похожа на то, что происходит на рынке процессоров: среди процессоров на одинаковых версиях ядра младшие модели обладают более высоким разгонным потенциалом, нежели старшие. Развитие линейки в сторону увеличения частот (можно сказать, разгон чипов самим производителем) приводит к тому, что для любителей разгона остаётся всё меньший и меньший запас частоты. И лишь при появлении новых процессорных ядер эпидемия разгона разгорается с новой силой и не угасает до тех пор, пока запас снова не истощается...

Похоже, так будет и с видеокартами: любители "бесплатного сыра" дождутся своего часа только тогда, когда появятся новые чипы от NVIDIA, ATI, Matrox и т.д...

Отдельно хочется отметить высокое качество и надежность платы VisionTek Xtasy GeForce4 Ti4600, стойко перенесшей самые изощренные пытки из тех, которым подвергались видеокарты в нашей тестовой лаборатории :).

Напоследок, как вcегда, Замечание:

Данный материал – своего рода эксперимент, он отнюдь не является призывом к экстремальному разгону или перепайке видеокарт;

Подобная модификация платы сокращает срок ее службы;

При любой модификации платы пользователь автоматически лишается гарантии;

В случае выхода из строя видеокарты или других комплектующих в результате её модификации вся ответственность лежит на пользователе.