Ваш город: Москва

Обзор и тестирование NVIDIA GeForce GTX TITAN 6 Гбайт

Введение

С момента выхода NVIDIA GeForce GTX 680 на архитектуре Kepler прошёл почти год – срок достаточно большой по меркам индустрии графических процессоров, пусть и замедлившейся в своём развитии в последнее время. Многие из нас с вами ждали, что уже этой весной компании AMD и NVIDIA смогут порадовать ценителей быстрой и качественной графики своими новыми процессорами и технологиями. Однако этого не произошло, к сожалению. Более того, судя по новостям, традиционные осенние анонсы пока также туманны. AMD, например, решила и вовсе заняться очередным переименованием видеокарт.

Тем не менее, по крайней мере одну интересную новинку нам всё-таки представили. Ей стала видеокарта NVIDIA GeForce GTX TITAN.

Всего предполагается выпустить 10000 экземпляров GeForce GTX TITAN, то есть речь идёт явно не о массовом продукте, о чём говорит и рекомендованная стоимость новинки – 999 долларов США (или 35 тыс.руб. на российском рынке). Графический процессор GK110, лежащий в основе TITAN, используется в профессиональных графических адаптерах Tesla K20X, устанавливаемых в суперкомпьютеры и высокопроизводительные серверы. А там совершенно иные стандарты стоимости, отсюда и запредельная, по мнению большинства обычных пользователей, для однопроцессорной видеокарты цена.

Давайте узнаем, что нам предлагает NVIDIA за такие немалые деньги.

1. Обзор видеокарты NVIDIA GeForce GTX TITAN 6 Гбайт

технические характеристики и архитектурные изменения

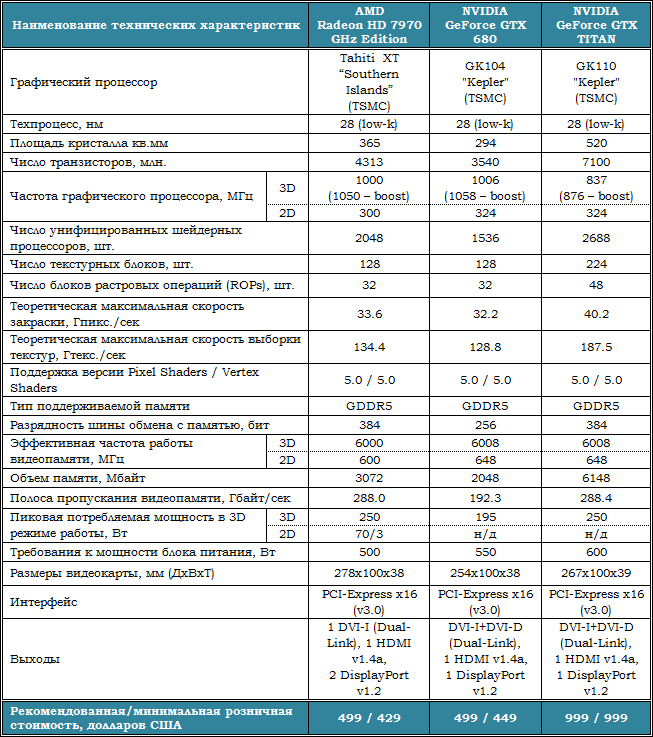

Технические характеристики видеокарты NVIDIA GeForce GTX TITAN приведены в таблице в сравнении с характеристиками AMD Radeon HD 7970 GHz Edition и NVIDIA GeForce GTX 680:

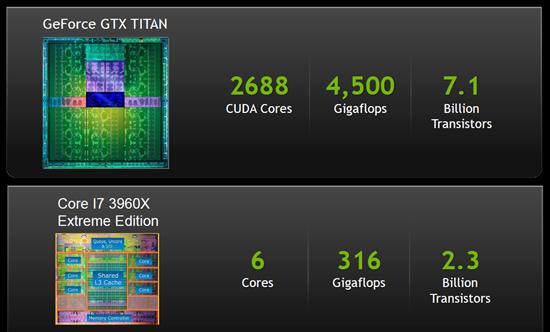

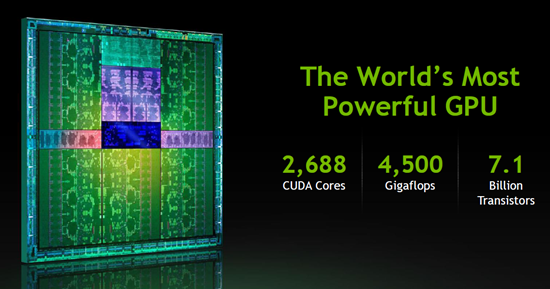

Итак, в графическом процессоре GK110 архитектуры Kepler, выпускаемом по 28-нм технологическому процессу, 7,1 миллиарда транзисторов, 2688 CUDA-ядер, а теоретическая производительность в SP-расчётах может достигать 4,5 терафлопса:

Интересное сравнение приводит NVIDIA с топовым процессором Intel на следующем слайде:

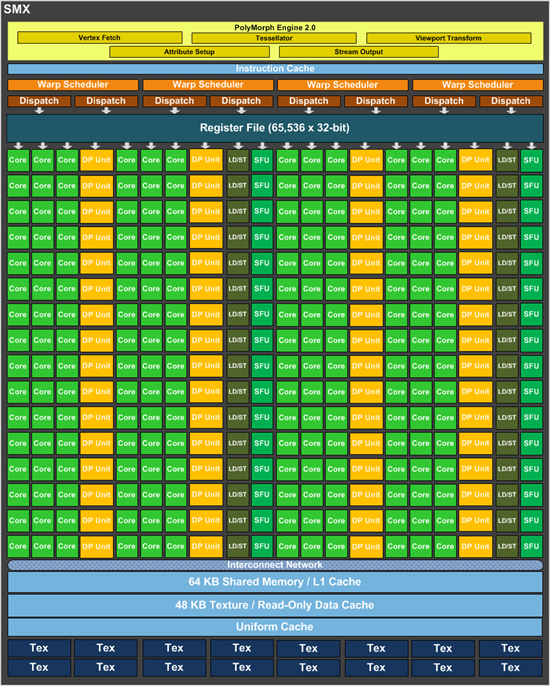

Всего в GK110 15 SMX-блоков, 14 из которых активны. Число текстурных блоков равно 224, блоков растеризации – 48:

В отличие от GK104, на котором базируется, например, GeForce GTX 680, в GK110 есть 64 блока двойной точности (FP64), с предельной теоретической производительностью 1,3 терафлопса. Итого в GK110 896 ядер с поддержкой двойной точности вычислений:

Кроме перечисленных архитектурных изменений, GeForce GTX TITAN базируется на 384-битной шине памяти, в отличие от 256-битной у предыдущего Hi-End продукта NVIDIA – GeForce GTX 680. И, конечно же, не стоит забывать про объём памяти, который составляет впечатляющие 6 Гбайт! Всё это позволит новинке превосходно чувствовать себя в самых ресурсоёмких графических режимах.

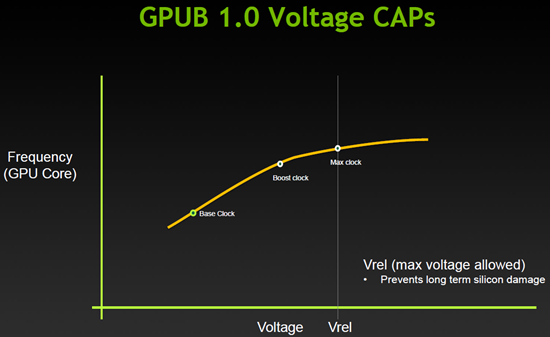

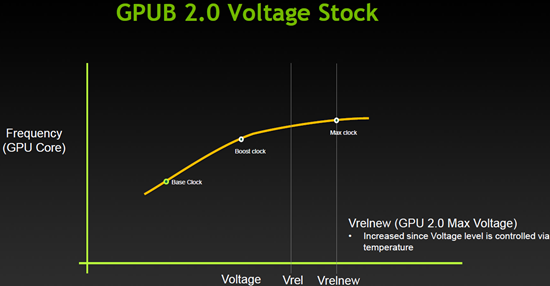

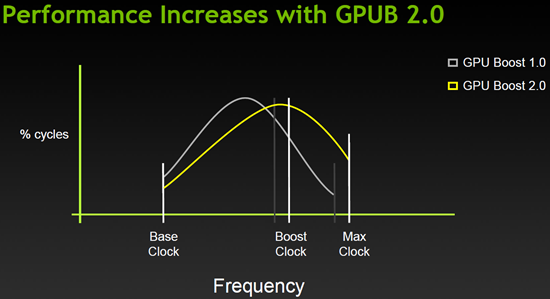

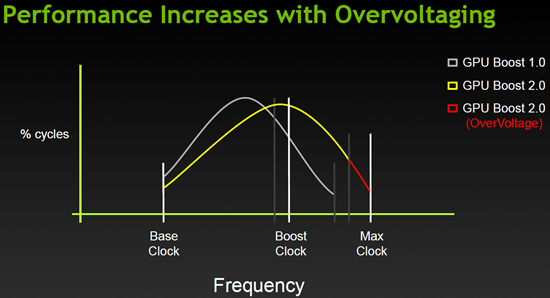

Вслед за архитектурными изменениями, одной из самых интересных особенностей GeForce GTX TITAN стала поддержка второй версии технологии динамического разгона GPU Boost 2.0:

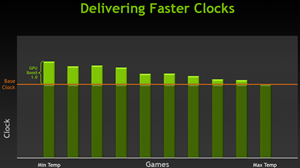

Если раньше увеличение частоты графического процессора зависело только от предела мощности/напряжения…

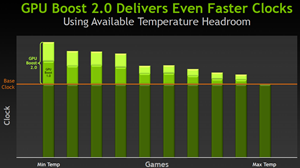

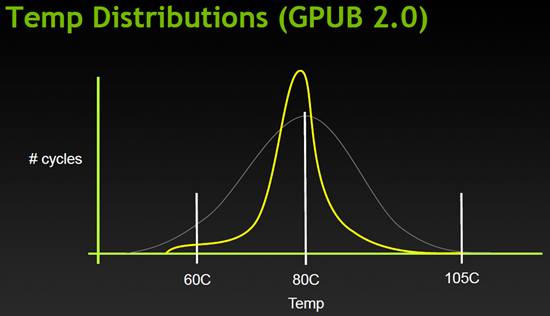

…то в GPU Boost версии 2.0 к ним добавляется предельная температура, на которую GPU и «ориентируется» при разгоне:

Для GK110 данная граница температуры равна 80 градусам Цельсия, но пользователю предоставлена возможность увеличить её до 94 градусов Цельсия, и за счёт этого обеспечить видеокарте работу на более высоких частотах:

Проще говоря, GPU Boost 2.0 является как технологией способной повысить производительность GeForce GTX TITAN в условиях когда это возможно, так и инструментом, осуществляющим автоматический и постоянный контроль за тепловыделением видеокарты, когда температура GPU выходит за допустимые пределы.

Вообще, как покажет наше практическое изучение оверклокерского потенциала GeForce GTX TITAN, именно температура является ключевым фактором для успешного разгона GK110.

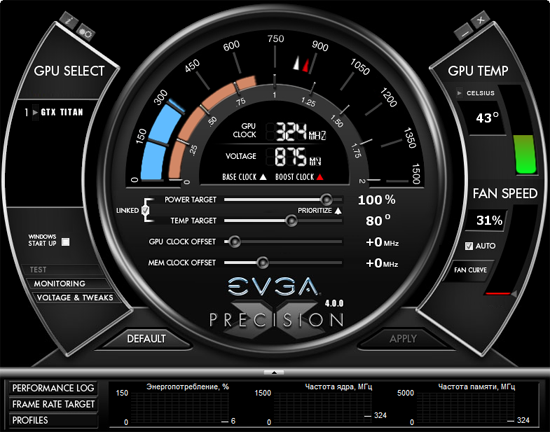

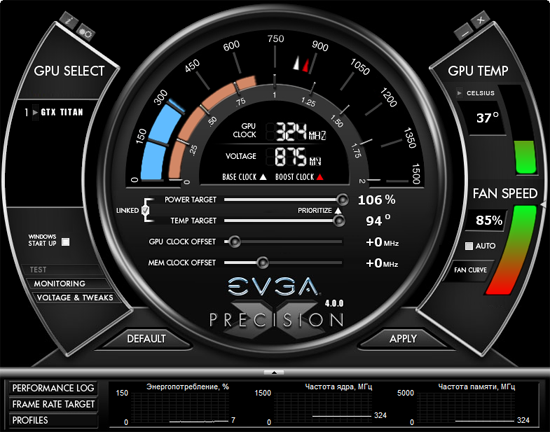

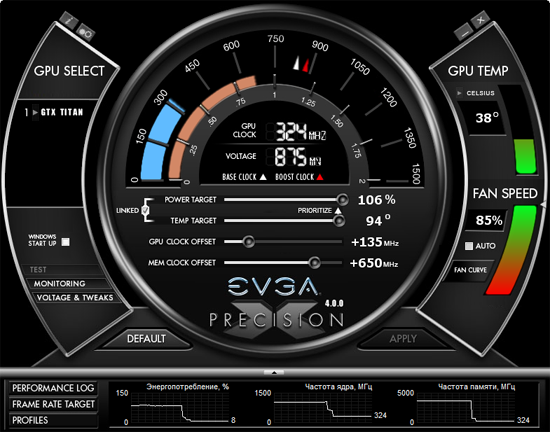

Что касается утилит, то на момент подготовки статьи полная поддержка TITAN была у EVGA Precision X версии 4.0.0:

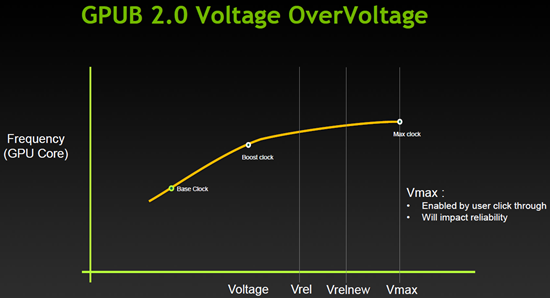

С помощью этой утилиты для разгона ядра TITAN можно не только изменять параметры «Power Target» и «Temp Target», но и увеличивать напряжение:

Познакомимся с видеокартой.

особенности видеокарты

Внешне новая GeForce GTX TITAN напоминает GeForce GTX 690 – тот же цвет металлического кожуха с лицевой стороны, те же вставки, и такое же прозрачное окно из поликарбоната:

Сверху видеокарты – логотип со светодиодной подсветкой:

Длина GTX TITAN составляет 267 мм, что совершенно нормально для современных видеокарт.

В плане выходов нет никаких отличий от GTX 680, здесь DVI-I и DVI-D (оба Dual-Link), один HDMI версии 1.4a и один DisplayPort версии 1.2:

С противоположной стороны можно увидеть открытый торец радиатора и пару винтов крепления кожуха.

GeForce GTX TITAN оснащена двумя разъёмами MIO для создания мультипроцессорных связок из двух, трёх или даже четырёх таких видеокарт:

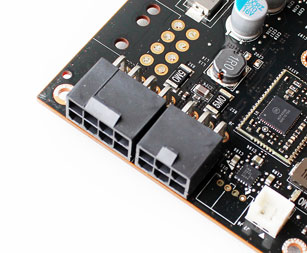

Для дополнительного питания на видеокарте установлены восьми- и шестиконтактные разъёмы, то есть получилось нечто среднее между GTX 690 (2x8) и GTX 680 (2x6). Судя по спецификациям, максимальное энергопотребление TITAN не должно превышать 250 ватт, а мощность рекомендованного блока питания для системы с одной такой видеокартой составляет 600 ватт.

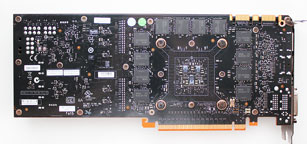

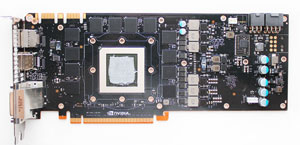

Печатная плата TITAN выполнена по уникальному дизайну с микросхемами памяти на лицевой и обратной стороне:

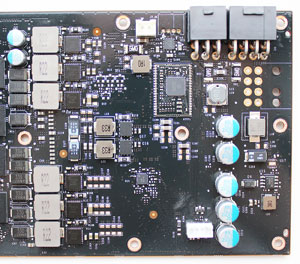

Вопреки нашим ожиданиям и 384-битной шине памяти, для питания графического процессора здесь отведены шесть фаз на элементах Dr.MOS, как и у эталонных GeForce GTX 680:

За управление ими отвечает контроллер ON Semiconductor NCP4206:

Ещё две фазы питания отведены на видеопамять, а одна – на силовые цепи.

Графический процессор GK110, площадь кристалла которого составляет впечатляющие 520 мм2, не закрыт теплораспределителем, что позволило узнать его ревизию – А1, и примерную дату выпуска – 50 неделя 2012 года:

С его конфигурацией и характеристиками вы уже ознакомились выше в разделе с теорией. Частота в 3D-режиме при напряжении 1,162 В составляет 837 МГц, а при высокой нагрузке может достигать 876 МГц (boost-режим). Хотя, на деле всё было немного не так. Но, об этом чуть позже. При переходе в 2D-режим частота снижается до 324 МГц, а напряжение – до 0,875 В.

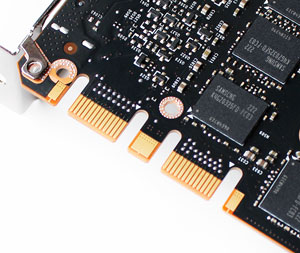

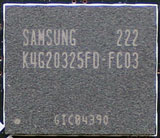

Видеокарта оснащена GDDR5-микросхемами памяти в FCBGA-упаковке общим объёмом 6 Гбайт. Чипы выпущены компанией Samsung Semiconductor и имеют маркировку K4G20325FD-FC03:

Их эффективная частота в 3D-режиме составляет 6008 МГц, что при ширине шины 384-бит даёт теоретическую пропускную способность 288,4 Гбайт/сек. Это на 50% выше пропускной способности памяти GeForce GTX 680, и должно положительно сказаться на производительности видеокарты в самых ресурсоёмких режимах с использованием сглаживания всех типов и степеней.

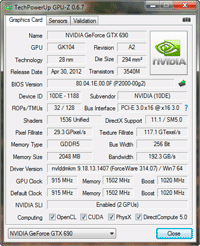

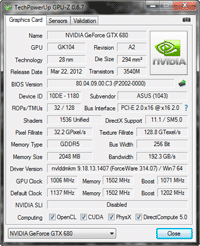

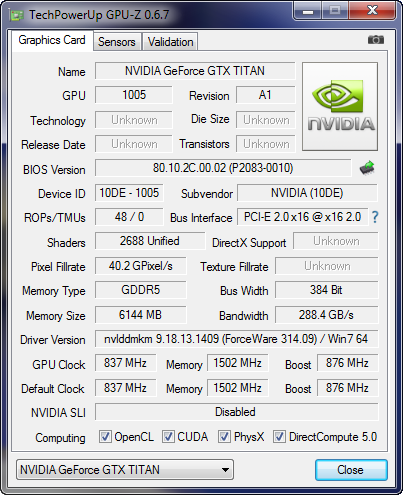

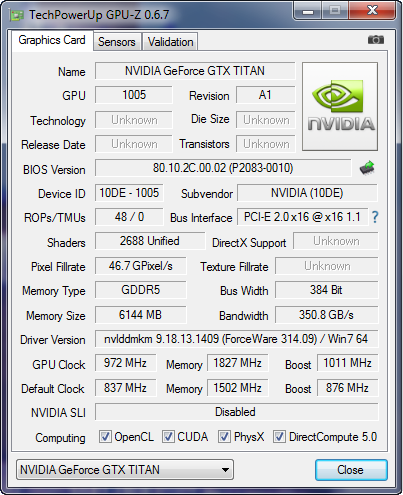

Утилита GPU-Z последней доступной на момент подготовки статьи версии знакома с характеристиками GeForce GTX TITAN лишь частично:

Добавим, что BIOS видеокарты мы можете скачать из нашего файлового архива.

эффективность системы охлаждения и субъективная оценка уровня шума

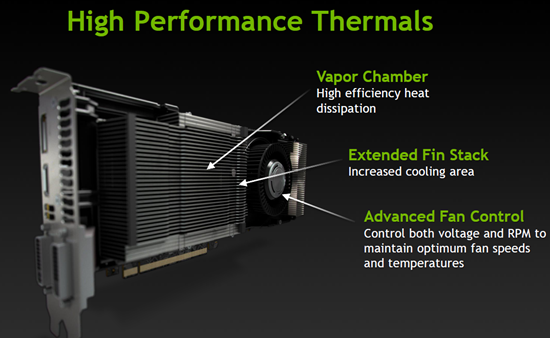

Особое внимание при разработке своего флагмана NVIDIA уделила совершенствованию системы охлаждения. Не удивительно, ведь и кристалл большей площади, и значительно повысившийся уровень тепловыделения ужесточили требования как к аппаратной, так и к программной части системы охлаждения. Схематично NVIDIA выделила три ключевых изменения: радиатор с испарительной камерой и большим числом тонких алюминиевых рёбер, а также специальная система контроля за скоростью вентилятора:

Если вам удастся самостоятельно снять и разобрать кулер GeForce GTX TITAN, то Джедаем становитесь сразу, юный Падаван, ибо винтов разных типов несметное количество преодолеть придётся:

В основе системы охлаждения лежит металлическая пластина с термопрокладками. Она охлаждает микросхемы памяти и отдельные силовые элементы. Внутри – под кожухом – находится алюминиевый радиатор с испарительной камерой:

Он крепится к графическому процессору отдельно и не контактирует с остальными элементами кулера:

Из оставшихся элементов отметим декоративную пластиковую накладку на турбине и, собственно, сам радиальный вентилятор:

Последний нам снять не удалось, поскольку кроме трёх винтов, он, похоже, ещё и приклеен к металлической раме.

Подсветка у кулера не слишком яркая, но достаточно красивая:

Особое внимание стоит уделить режимам работы кулера. В основе его работы лежит та самая технология GPU Boost 2.0 и температурная «отметка» графического процессора 80 градусов Цельсия, от которой напрямую зависит частота и число тактов графического процессора:

При превышении этой температуры Boost-частота GPU постепенно снижается, пока не достигнет номинальной для GK110, а при превышении 105 градусов Цельсия включается режим защиты, нередко называемый «Throttling». Вот почему к эффективности охлаждения графического процессора GeForce GTX TITAN предъявляются столь высокие требования.

Температурную границу срабатывания режимов снижения частот с помощью уже упомянутой здесь утилиты EVGA Precision X можно сдвинуть вверх до 94 градусов Цельсия:

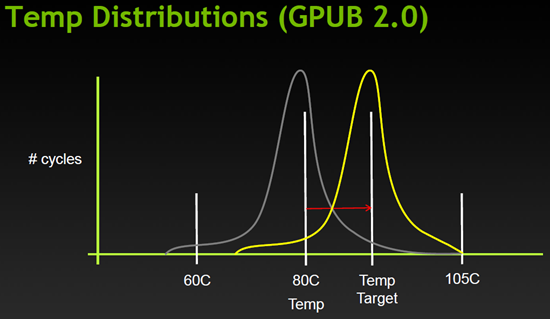

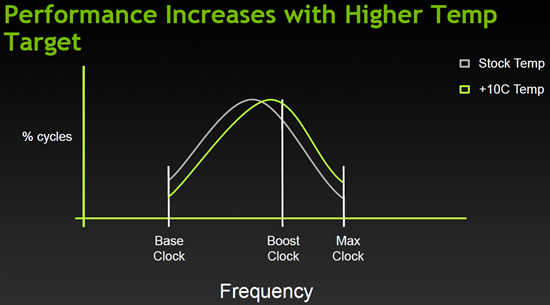

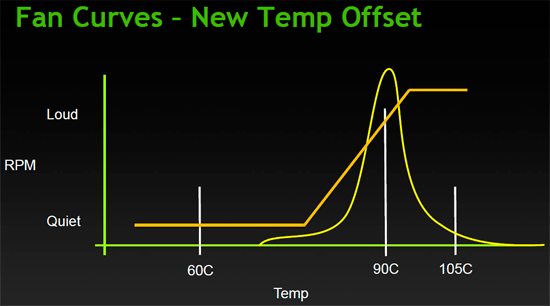

Это позволит TITAN дольше работать на форсированных частотах, однако при превышении этой температурной отметки они снова снизятся до номинальных или опустятся ещё ниже. Зависимость производительности TITAN от температуры графического процессора NVIDIA схематично изобразила следующими кривыми:

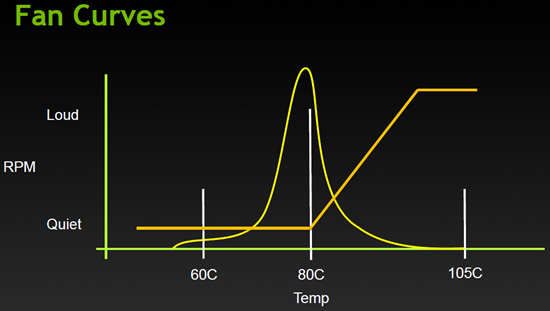

Следовательно и скорость работы радиального вентилятора NVIDIA отрегулировала таким образом, чтобы видеокарта оставалась тихой, пока температура GPU не достигнет 80 градусов Цельсия, а после этого вентилятор начинает наращивать свои обороты:

Как видим, здесь NVIDIA сделала акцент на тишину, а не на эффективность охлаждения, полагаясь на защитные механизмы графического процессора и технологию GPU Boost 2.0.

При сдвиге предельной температуры GPU вверх вентилятор системы охлаждения TITAN будет функционировать при более высоких скоростях, обеспечивая видеокарте запас по форсированной частоте:

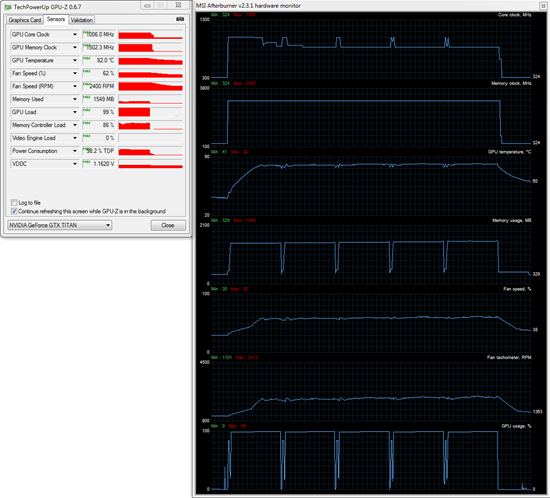

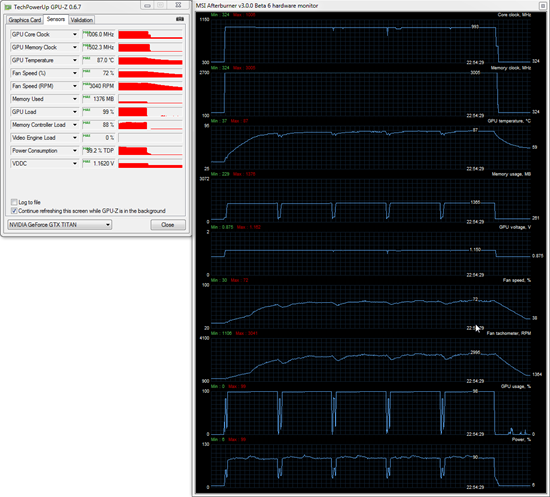

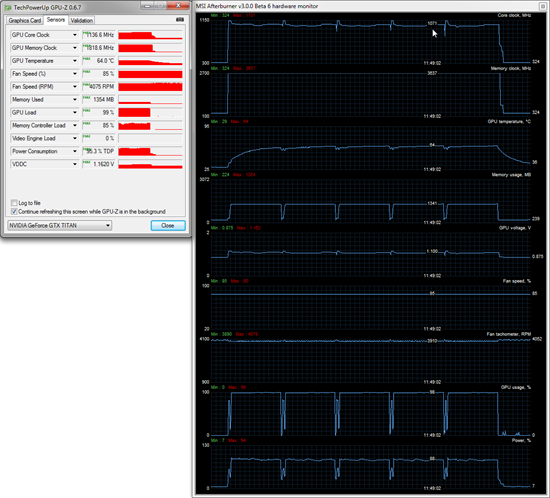

Давайте посмотрим, как это работает на практике. Для проверки температурного режима работы видеокарты в качестве нагрузки мы использовали пять циклов теста весьма ресурсоёмкой игры Aliens vs. Predator (2010) при максимальном качестве графики в разрешении 2560х1440 пикселей с анизотропной фильтрацией уровня 16х и MSAA4x. Для мониторинга температур и прочих параметров применялись программа MSI Afterburner версии 3.0.0 beta 6 и утилита GPU-Z версии 0.6.7. Все тесты проводились в закрытом корпусе системного блока, конфигурацию которого вы сможете увидеть в следующем разделе статьи, при комнатной температуре 25 градусов Цельсия.

Прежде всего посмотрим на температурный режим работы видеокарты при стандартных настройках мощности и температурной границы, а также автоматической регулировке скорости вращения радиального вентилятора:

Как видим, температура графического процессора уже на первом цикле игрового теста быстро превысила отметку 80 градусов Цельсия, и сразу же после этого форсированная частота GPU, которая составляла, 1006 МГц (да-да, 1006, а не 876 МГц!) снизилась сначала до 993 МГц, потом резко до 876 МГц и в конечном итоге опустилась до номинальных 837 МГц. Проще говоря, если температура графического процессора превысит 80 градусов Цельсия, то ни о каком boost-режиме работы TITAN говорить не приходится. Что касается скорости вращения вентилятора, то она с 1100 об/мин повысилась до 2412 об/мин и далее не увеличивалась.

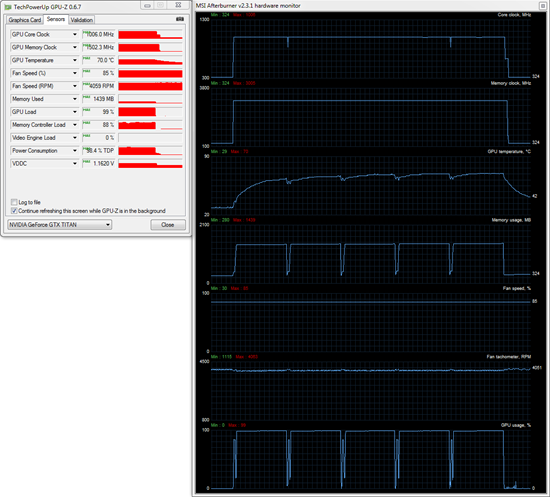

Теперь попробуем повысить температурную границу до 94 градусов Цельсия, одновременно увеличив предельную мощность видеокарты до 106%. Радиальный вентилятор системы охлаждения по-прежнему функционирует в автоматическом режиме:

Совсем другая картина! Достигнув пиковых 1006 МГц, наш экземпляр TITAN в процессе тестирования снизил частоту лишь до 993 МГц и на ней прошёл практически весь тест. Нужно ли говорить, что в данном случае производительность TITAN будет значительно выше, нежели при стандартных настройках температуры и мощности, ориентированных на низкий уровень шума? Пиковая температура GPU во время тестирования составила 87 градусов Цельсия, а скорость вращения вентилятора увеличилась с 2412 до 2995 об/мин.

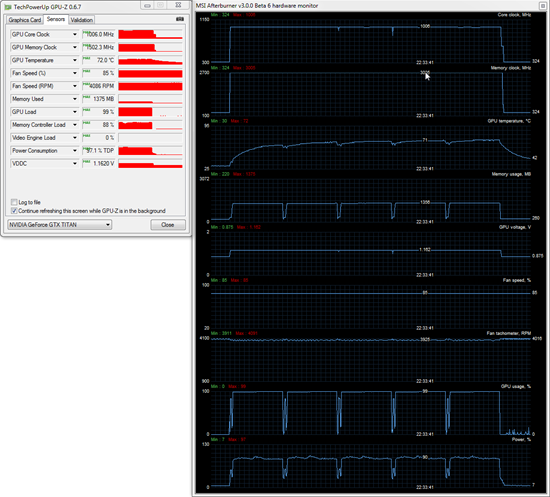

Теперь вновь вернём настройки температурной границы GPU и мощности видеокарты к номинальным (80°С/100%), но выставим скорость вращения вентилятора на максимум, и ещё раз повторим тесты:

«В Багдаде всё спокойно» – максимальная температура графического процессора составила 70 градусов Цельсия, а его частота постоянно находилась в режиме «форсажа» 1006 МГц. А что будет, если при максимальной скорости вентилятора увеличить предельную температуру GPU до 94 градусов Цельсия и мощность до 106%? Смотрим:

В плане частот работы видеокарты ничего не изменилось, однако пиковая температура графического процессора увеличилась на 2 градуса Цельсия при итоговых 72 градусах Цельсия.

Таким образом можно сделать вывод, что эффективное охлаждение графического процессора NVIDIA GeForce GTX TITAN, как никогда прежде, является наивысшим приоритетом для достижения максимальной производительности видеокарты и, самое главное, сохранения достигнутого уровня этой производительности во время продолжительной работы видеокарты в 3D-режиме.

Что касается уровня шума NVIDIA GeForce GTX TITAN, то измерить его по нашей стандартной методике не представляется возможным, поскольку для этого пришлось бы либо снять совсем кожух системы охлаждения и получить имеющие мало чего общего с реальными результатами данные, либо сверлить этот самый корпус, чтобы добраться до разъёма подключения вентилятора. Ни тот, ни другой вариант для нас были неприемлемы, поэтому сегодня мы ограничимся субъективной оценкой уровня шума. В 2D-режиме видеокарту совершенно не слышно, так как её вентилятор функционирует на 1100 об/мин. Это очень тихо. В 3D-режиме без повышения частот и изменения мощностных характеристик TITAN уровень шума видеокарты по-прежнему комфортен. Вентилятор работает «мягко», плавно наращивая или снижая свои обороты. При превышении скорости 2500 об/мин уровень шума GeForce GTX TITAN становится заметен на фоне тихого системного блока, но всё же ниже, чем, например, у двухпроцессорной GeForce GTX 690, или, тем более, эталонной системы охлаждения AMD Radeon HD 7970. В целом для видеокарты с тепловым пакетом 250 ватт система охлаждения оказалась на удивление нешумной.

оверклокерский потенциал

Оверклокерский потенциал нашего экземпляра видеокарты NVIDIA GeForce GTX TITAN мы проверяли с помощью утилиты EVGA Precision X, увеличив предел мощности и температурную границу до максимума:

Кроме того, дабы не ограничивать частотный потенциал видеокарты, боковая стенка корпуса была снята, а скорость вращения радиального вентилятора GeForce GTX TITAN была увеличена до максимального уровня 4000 об/мин.

После нескольких часов такого тестирования нам удалось повысить базовую частоту графического процессора на 135 МГц, а видеопамяти на 1300 эффективных мегагерц:

Итоговые частоты видеокарты составили 972/1011/7308 МГц:

В процессе дальнейшего тестирования частоту видеопамяти нам пришлось снизить на 40 МГц при итоговых 7268 МГц. Пиковая частота графического процессора разогнанной видеокарты кратковременно достигала 1137 МГц, но при высокой нагрузке всё же снижалась до 1071 МГц:

При этом, как можно увидеть, температура GPU в созданных нами условиях была довольно комфортной для GK110 и не превышала 64 градусов Цельсия. Попытки разгона с повышением напряжения до 1,187 В к успеху не привели, поэтому мы решили остановиться на достигнутых частотах.

энергопотребление

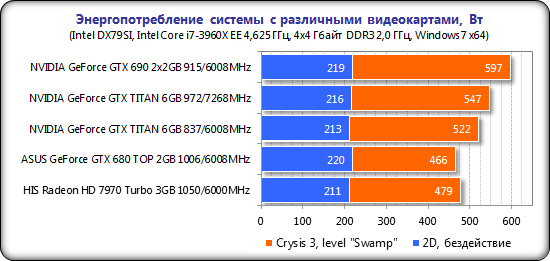

Измерение энергопотребления системы с различными видеокартами осуществлялось с помощью многофункциональной панели Zalman ZM-MFC3, которая показывает потребление системы «от розетки» в целом (без учёта монитора). Измерение было проведено в 2D-режиме, при обычной работе в Microsoft Word или интернет-«сёрфинге», а также в 3D-режиме. Нагрузка создавалась с помощью четырёх циклов вступительной сцены уровня «Swamp» из игры Crysis 3 в разрешении 2560х1440 пикселей при максимальных настройках качества графики, но без использования сглаживания MSAA. Как показали наши тесты, новая игра генерирует на систему более высокую нагрузку, чем ранее использованная нами игра Metro 2033: The Last Refuge, этим и объясняется замена тестового пакета.

Для сравнения мы включили на диаграмму и в дальнейшее тестирование видеокарты NVIDIA GeForce GTX 690, ASUS GeForce GTX 680 DirectCU II TOP (приведённая к эталонным частотам) и HIS 7970 IceQ X² GHz Edition 3 Гбайт. Вот результаты измерения энергопотребления всех тестовых систем:

Выяснилось, что на номинальных частотах видеокарты система с GeForce GTX TITAN потребляет примерно на 55-60 ватт больше, чем система с ASUS GeForce GTX 680 и примерно на 40-45 ватт больше системы с HIS Radeon HD 7970. При разгоне TITAN энергопотребление увеличивается на 25 ватт до 547 ватт, что совсем немного для конфигураций с Hi End видеокартами, и это на 50 ватт ниже потребления системы с двухпроцессорной NVIDIA GeForce GTX 690. В общем-то, неожиданностей в этих измерениях мы не обнаружили сегодня. В простое все конфигурации демонстрируют одинаковый уровень энергопотребления.

2. Тестовая конфигурация, инструментарий и методика тестирования

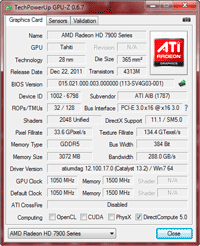

Тестирование видеокарт было проведено на системе следующей конфигурации:

Системная плата: Intel Siler DX79SI (Intel X79 Express, LGA 2011, BIOS 0537 от 23.07.2012);

Центральный процессор: Intel Core i7-3960X Extreme Edition 3,3 ГГц (Sandy Bridge-E, C1, 1,2 В, 6x256 Kбайт L2, 15 Мбайт L3);

Система охлаждения CPU: Phanteks PH-TC14PЕ (2xCorsair AF140, 960 об/мин);

Термоинтерфейс: ARCTIC MX-4;

Видеокарты:

NVIDIA GeForce GTX 690 2x2 Гбайт;

ASUS GeForce GTX 680 DirectCU II TOP 2 Гбайт;

HIS 7970 IceQ X² GHz Edition 3 Гбайт;

Оперативная память: DDR3 4x4 Гбайт Mushkin Redline (2133 МГц, 9-10-10-28, 1,65 В);

Системный диск: SSD 256 Гбайт Crucial m4 (SATA-III, CT256M4SSD2, BIOS v0009);

Диск для программ и игр: Western Digital VelociRaptor (SATA-II, 300 Гбайт, 10000 об/мин, 16 Мбайт, NCQ) в коробке Scythe Quiet Drive 3,5";

Архивный диск: Samsung Ecogreen F4 HD204UI (SATA-II, 2 Тбайт, 5400 об/мин, 32 Мбайт, NCQ);

Корпус: Antec Twelve Hundred (передняя стенка – три Noiseblocker NB-Multiframe S-Series MF12-S2 на 1020 об/мин; задняя – два Noiseblocker NB-BlackSilentPRO PL-1 на 1020 об/мин; верхняя – штатный 200-мм вентилятор на 400 об/мин);

Панель управления и мониторинга: Zalman ZM-MFC3;

Блок питания: Seasonic SS-1000XP Active PFC F3 (1000 Вт), 120-мм вентилятор;

Монитор: 27" Samsung S27A850D (DVI-I, 2560х1440, 60 Гц).

Из указанных в конфигурации видеокарт только продукт ASUS имеет повышенные частоты, поэтому для «чистоты» сравнения мы привели их к эталонным для GeForce GTX 680:

Для снижения зависимости производительности видеокарт от скорости платформы, 32-нм шестиядерный процессор при множителе 37, опорной частоте 125 МГц и активированной функции «Load-Line Calibration» был разогнан до 4,625 ГГц при повышении напряжения в BIOS материнской платы до 1,49 В:

Технология «Hyper-Threading» активирована. При этом 16 Гбайт оперативной памяти функционировали на частоте 2 ГГц с таймингами 9-11-10-28 при напряжении 1,65 В.

Тестирование, начатое 24 февраля 2013 года, было проведено под управлением операционной системы Microsoft Windows 7 Ultimate x64 SP1 со всеми критическими обновлениями на указанную дату и с установкой следующих драйверов:

чипсет материнской платы Intel Chipset Drivers – 9.4.0.1014 WHQL от 07.02.2012;

библиотеки DirectX End-User Runtimes, дата выпуска – 30 ноября 2010 года;

драйверы видеокарт на графических процессорах AMD – Catalyst 13.2 Beta 6 (12.100.17.0) от 18.02.2013 + Catalyst Application Profiles 12.11 (CAP2);

драйверы видеокарт на графических процессорах NVIDIA – GeForce 314.09 WHQL от 21.02.2013 для GeForce TITAN и GeForce 314.07 WHQL от 18.02.2013 для GeForce GTX 690 и GTX 680.

Производительность видеокарт была проверена в двух разрешениях: 1920х1080 и 2560х1440 пикселей. Для тестов использовались два режима качества графики: «Quality + AF16x» – качество текстур в драйверах по-умолчанию с включением анизотропной фильтрации уровня 16х, и «Quality + AF16x + MSAA 4х(8х)» с включением анизотропной фильтрации уровня 16х и полноэкранного сглаживания степени 4x или 8x, в случаях, когда среднее число кадров в секунду оставалось достаточно высоким для комфортной игры. Включение анизотропной фильтрации и полноэкранного сглаживания выполнялось непосредственно в настройках игр. Если же данные настройки в играх отсутствовали, то параметры изменялись в панелях управления драйверов Catalyst и GeForce. Там же была принудительно отключена вертикальная синхронизация. Кроме указанного никаких изменений в настройки драйверов не вносилось.

Список тестовых приложений и игр в очередной раз был обновлен и расширен. В него были включены новый 3DMark (2013), последняя версия теста Heaven и совсем новый, но очень красивый тест Valley. Кроме того, мы дополнили список игровых тестов новинками в виде Resident Evil 6, Crysis 3 и Tomb Raider (2013). Всего в нашем сегодняшнем арсенале значится два полусинтетических бенчмарка, две демо-сцены и четырнадцать наиболее ресурсоёмких игр:

3DMark 2011 (DirectX 11) – версия 1.0.3.0, профили настроек «Performance» и «Extreme»;

3DMark (2013) (DirectX 9/11) – версия 1.0, тестирование в сценах «Cloud Gate», «Fire Strike» и «Fire Strike Extreme»;

Unigine Heaven Bench (DirectX 11) – версия 4.0, максимальные настройки качества, тесселляция на уровне «extreme», AF16x, MSAA 8x, разрешения 1920х1080 и 2560х1440 пикселей;

Unigine Valley Bench (DirectX 11) – версия 1.0, максимальные настройки качества, AF16x, MSAA 8x, разрешения 1920х1080 и 2560х1440 пикселей;

Resident Evil 6 Bench (DirectX 9) – версия 1.0, все настройки выставлены на максимальный уровень качества, сглаживание FXAA3HQ, размытие включено, разрешения 1920х1080 и 2560х1440 пикселей;

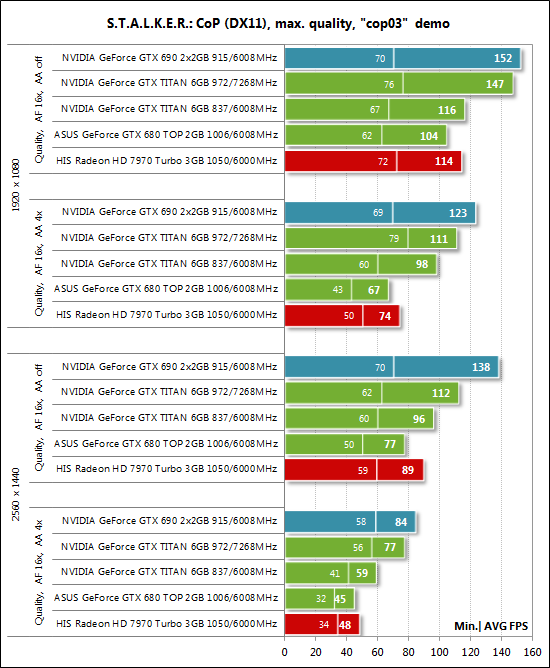

S.T.A.L.K.E.R.: Call of Pripyat (DirectX 11) – версия 1.6.02, профиль настроек «Улучшенное динамическое освещение DX11» с дополнительным выставлением вручную всех параметров на максимум, тестировалась собственная демо-запись «cop03» на уровне «Затон»;

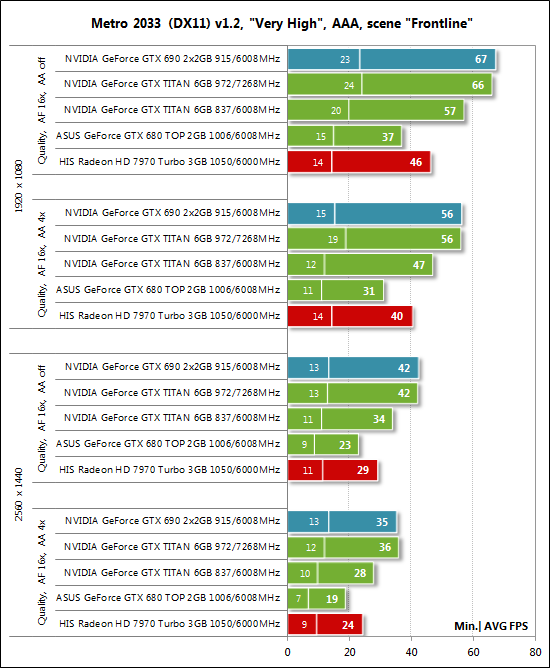

Metro 2033: The Last Refuge (DirectX 10/11) – версия 1.2, использовался официальный тест, настройки качества «Very High», тесселляция, DOF включено, использовалось ААА-сглаживание, двойной последовательный проход сцены «Frontline»;

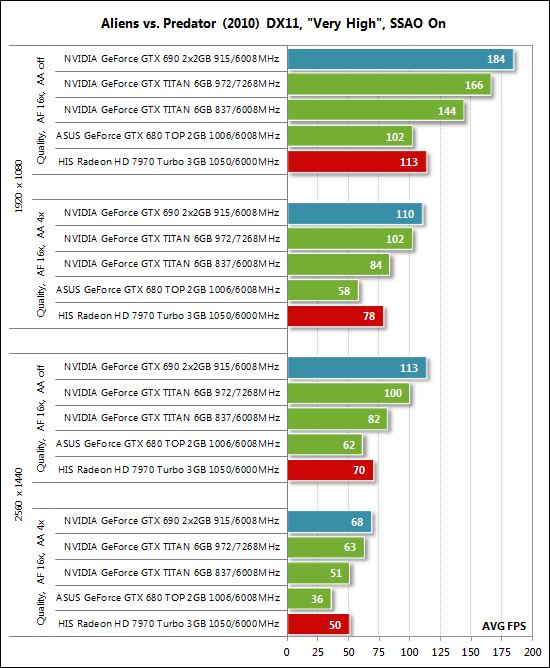

Aliens vs. Predator (2010) (DirectX 11) – «Texture Quality» в режиме «Very High», «Shadow Quality» в режиме «High», технология SSAO включена, два цикла теста в каждом разрешении;

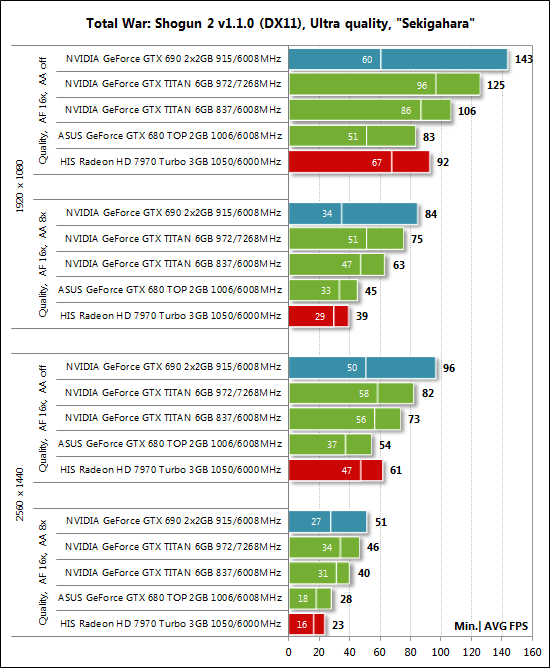

Total War: SHOGUN 2 – Fall of the Samurai (DirectX 11) – версия 1.1.0, встроенный тест (битва при Sekigahara) на максимальных настройках качества графики и использовании в одном из режимов MSAA 8x;

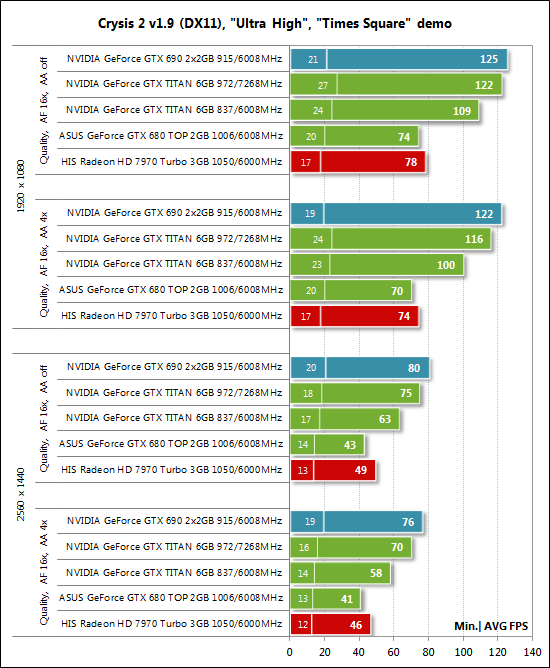

Crysis 2 (DirectX 11) – версия 1.9, использовался Adrenaline Crysis 2 Benchmark Tool v1.0.1.14 BETA, профиль настроек качества графики – «Ultra High», текстуры высокого разрешения активированы, двукратный цикл демо-записи на сцене «Times Square»;

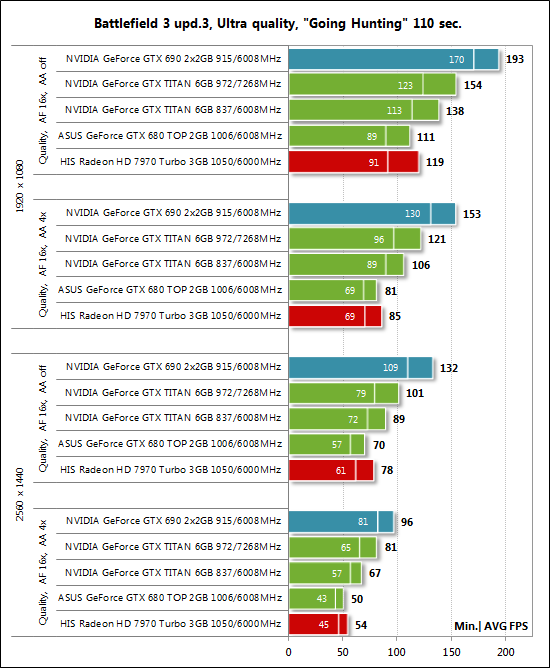

Battlefield 3 (DirectX 11) – версия 1.4, все настройки качества графики на «Ultra», двойной последовательный проход заскриптованной сцены из начала миссии «На охоту» продолжительностью 110 секунд;

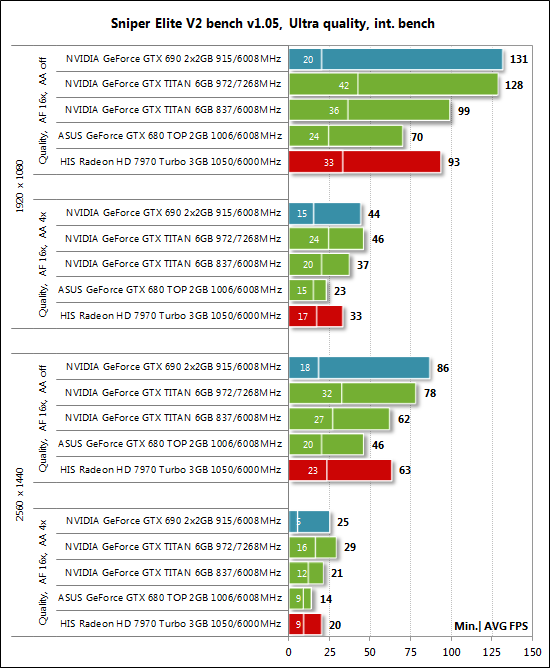

Sniper Elite V2 Benchmark (DirectX 11) – версия 1.05, использовался Adrenaline Sniper Elite V2 Benchmark Tool v1.0.0.2 BETA максимальные настройки качества графики («Ultra»), Advanced Shadows: HIGH, Ambient Occlusion: ON, Stereo 3D: OFF, двойной последовательный прогон теста;

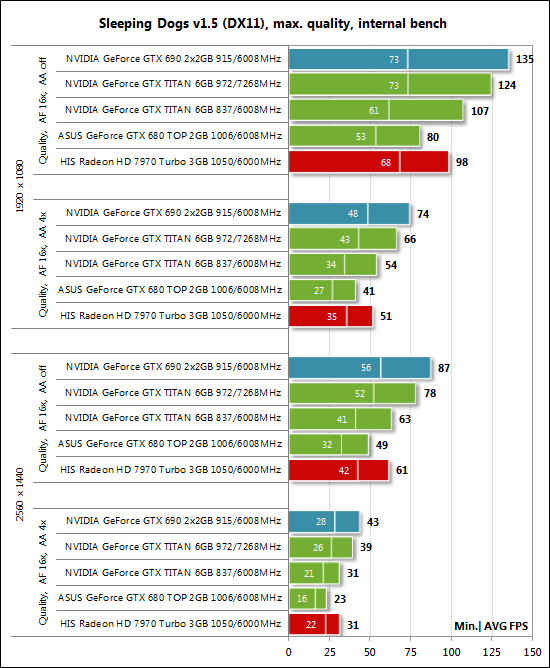

Sleeping Dogs (DirectX 11) – версия 1.5, использовался Adrenaline Sleeping Dogs Benchmark Tool v1.0.0.3 BETA, максимальные настройки качества графики по всем пунктам, Hi-Res Textures pack установлен, FPS Limiter и V-Sync отключены, двойной последовательный прогон теста с суммарным сглаживанием на уровне «Normal» и на уровне «Extreme»;

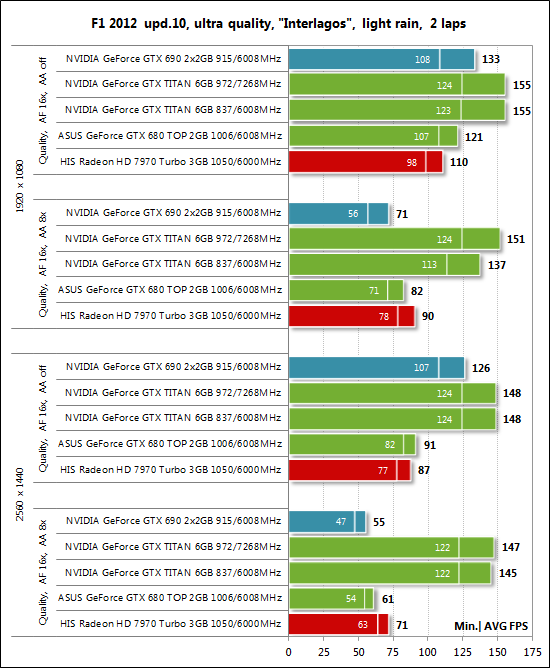

F1 2012 (DirectX 11) – Update 10, использовался Adrenaline Racing Benchmark Tool v1.0.0.13, настройки качества графики на уровне «Ultra», 2 круга на бразильской трассе «Interlagos», 24 машины, лёгкий дождь, режим камеры – «Bonnet»;

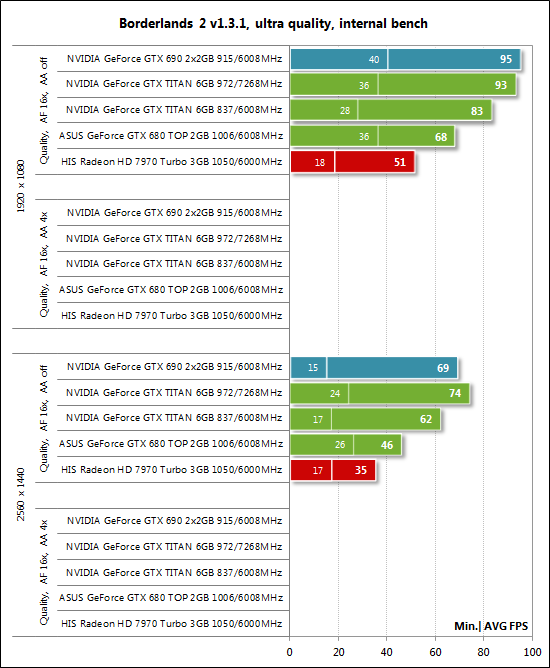

Borderlands 2 (DirectX 9) – версия 1.3.1, встроенный тест при максимальных настройках качества графики и максимальном уровне PhysX, сглаживание FXAA включено.

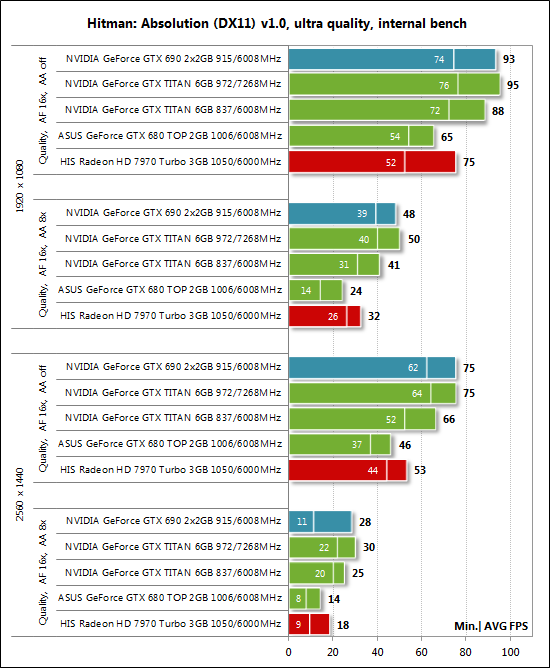

Hitman: Absolution (DirectX 11) – версия 1.0, встроенный тест при настройках качества графики на уровне «Ultra», тесселяция, FXAA и глобальное освещение включены.

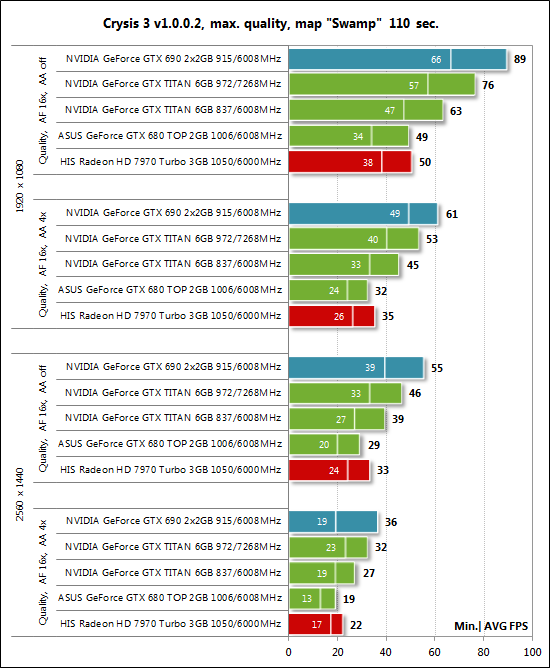

Crysis 3 (DirectX 11) – версия 1.0.0.2, все настройки качества графики на максимум, степень размытости – средняя, блики включены, режимы с FXAA и с MSAA4x сглаживанием, двойной последовательный проход заскриптованной сцены из начала миссии «Swamp» продолжительностью 110 секунд;

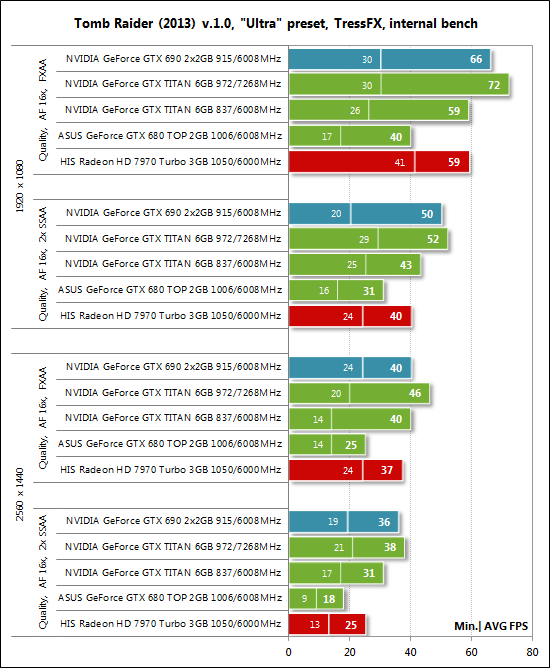

Tomb Raider (2013) (DirectX 11) – версия 1.00.716.5, настройки качества на уровне «Ultra», V-Synс отключён, режимы с FXAA и с 2x SSAA сглаживанием, технология TressFX активирована, двойной последовательный проход встроенного в игру теста.

Если в играх реализована возможность фиксации минимального числа кадров в секунду, то оно также отражалось на диаграммах. Каждый тест проводился дважды, за окончательный результат принималось лучшее из двух полученных значений, но только в случае, если разница между ними не превышала 1%. Если отклонения прогонов тестов превышали 1%, то тестирование повторялось ещё, как минимум, один раз, чтобы получить достоверный результат.

3. Результаты тестов производительности и их анализ

Перед анализом результатов тестирования обращаем ваше внимание на тот факт, что в номинальном режиме работы GeForce GTX TITAN тестировалась в стандартных условиях, как и все остальные видеокарты статьи. То есть внутри корпуса системного блока, без изменений предела мощности, напряжения, увеличения температурной границы и в автоматическом режиме работы вентилятора. В то же время, при разгоне GeForce GTX TITAN корпус был открыт, турбина постоянно функционировала на максимальной скорости, а мощность и предельная температура были выставлены вручную до своих верхних пределов.

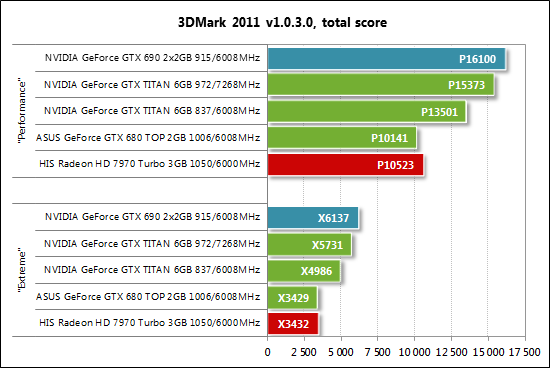

3DMark 2011

Как говорится – с места в карьер. Если GeForce GTX 680 здесь идёт на равных с Radeon HD 7970 GHz Edition, то новый однопроцессорный флагман NVIDIA – GeForce TITAN – превосходит их сразу более чем на 33%, что весьма впечатляет! В то же время, до уровня производительности двухпроцессорной GeForce GTX 690 в номинальном режиме работы TITAN довольно далеко, вопреки предварительным ожиданиям. И даже при разгоне этой сверхбыстрой видеокарты её отставание от GTX 690 составляет около 5%.

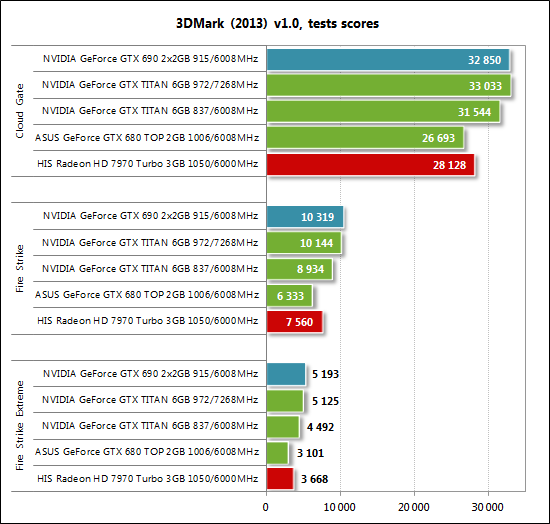

3DMark (2013)

Все три теста новейшего полуситнетического пакета 3DMark (2013) продемонстрировали нам примерно одинаковую картину. GeForce GTX TITAN опережает GeForce GTX 680 на величину вплоть до 44%, отстаёт от GeForce GTX 690 на 4-16%, но сокращает это отставание при разгоне. Также отметим, что Radeon HD 7970 GHz Edition в этом тесте быстрее GeForce GTX 680, поэтому появление TITAN для укрепления позиций NVIDIA в этом бенчмарке как нельзя кстати.

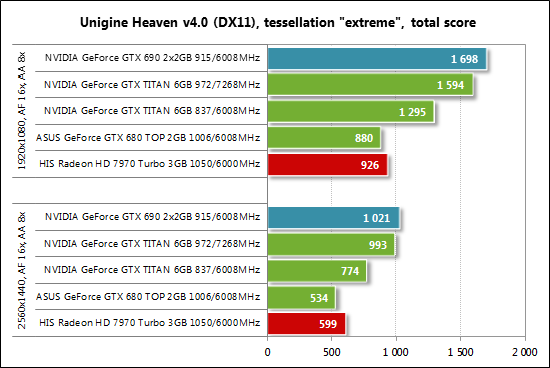

Unigine Heaven Bench

И вновь мы видим близость результатов GeForce GTX 680 и Radeon HD 7970 GHz Edition с небольшим преимуществом последней, а также впечатляющий отрыв от них GeForce GTX TITAN. Шутка ли, но Титан опережает прежнего однопроцессорного флагмана NVIDIA сразу на 45%, а при разгоне не «даёт спуску» двухпроцессорной GeForce GTX 690. В номинальном режиме работы двух самых быстрых видеокарт сегодняшнего теста GTX 690 быстрее TITAN на 32%, что также довольно немало, учитывая одинаковую рекомендованную стоимость этих видеокарт.

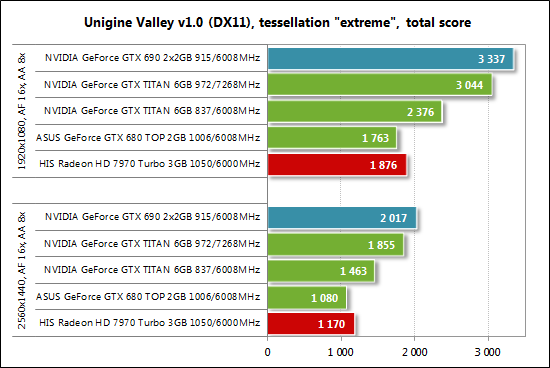

Unigine Valley Bench

В тесте Unigine Valley повторяется картина, которую мы с вами только что видели в Unigine Heaven. Пожалуй, в будущих материалах о видеокартах мы остановимся на одном из двух этих тестовых пакетов Unigine.

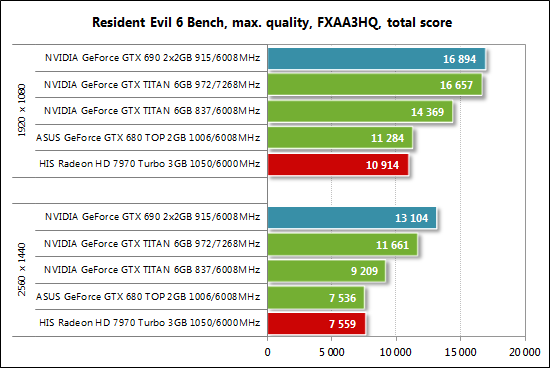

Resident Evil 6 Bench

В баллах измеряется производительность видеокарт и в новом тесте Resident Evil 6:

Здесь мы видим более уверенное выступление GeForce GTX 680 против Radeon HD 7970 GHz Edition и 22-28% преимущество GeForce GTX TITAN над первой видеокартой. В то же время отметим значительную разницу в производительности между TITAN и GTX 690, где лидирует двухпроцессорная видеокарта с преимуществом 18-42% в зависимости от разрешения. Догнать её при разгоне TITAN также не получается, хотя в разрешении 1920х1080 пикселей отставание сокращается до минимума.

Перейдём к результатам в играх.

S.T.A.L.K.E.R.: Call of Pripyat

Что касается режима без использования сглаживания, то производительность GeForce GTX TITAN немногим выше производительности GTX 680 и совсем уж не впечатляет на фоне той прыти Radeon HD 7970 GHz Edition, которую видеокарта на графическом процессоре AMD традиционно демонстрирует в S.T.A.L.K.E.R. Однако при активации MSAA4x «Титан» наращивает своё преимущество, которое в итоге достигает 31-46%. Догнать двухпроцессорную GeForce GTX 690 не удаётся и при повышении частот.

Metro 2033: The Last Refuge

Куда более ресурсоёмкая чем S.T.A.L.K.E.R.: Call of Pripyat игра Metro 2033: The Last Refuge демонстрирует нам несколько иную картину:

GeForce TITAN на 48-54% быстрее GTX 680 – такой разницы в производительности мы с вами давно уже не наблюдали даже при смене поколений графических процессоров, что уж говорить про одну линейку ускорителей? Впечатляющий результат! И пусть до двухпроцессорной GeForce GTX 690 новая TITAN не дотягивает, при разгоне видеокарты этот недостаток компенсируется в полной мере. Конечно, все мы понимаем, что GTX 690 также неплохо разгоняется. Кроме этого, отметим очень уверенное выступление Radeon HD 7970 GHz Edition, которая в Metro 2033: The Last Refuge не оставила ни единого шанса своему прямому конкуренту в лице GeForce GTX 680.

Aliens vs. Predator (2010)

Уверенно чувствует себя Radeon HD 7970 GHz Edition и в игре Aliens vs. Predator (2010):

Особо впечатляет результат этой видеокарты в наиболее ресурсоёмком режиме в разрешении 2560х1440 пикселей с использованием сглаживания, когда производительность Radeon HD 7970 GHz Edition равна вдвое более дорогой GeForce GTX TITAN. Последняя оказывается на 32-45% быстрее GeForce GTX 680 и на 22-27% медленнее GeForce GTX 690. Догнать двухпроцессорную видеокарту не получается даже при разгоне. А ведь стоить они, по замыслу NVIDIA, должны одинаково…

Total War: SHOGUN 2 – Fall of the Samurai

В Total War: SHOGUN 2 – Fall of the Samurai GeForce GTX TITAN быстрее GeForce GTX 680 на 28-43% и медленнее GTX 690 на 22-26%. Разогнав «Титан», можно сократить его отставание до двухпроцессорной видеокарты до 7-12%. Кроме того, минимальное число кадров в секунду на самой быстрой однопроцессорной видеокарте выше, нежели на GTX 690. Radeon HD 7970 GHz Edition быстрее GeForce GTX 680 в режимах без сглаживания и медленнее при активации MSAA8x. В обоих случаях разница невелика.

Crysis 2

Несмотря на выход Crysis 3, результаты в котором мы рассмотрим в конце анализа, Crysis 2 по-прежнему популярен как тест видеокарт, поэтому пока мы не исключаем его из наших тестирований:

NVIDIA GeForce GTX TITAN опережает GeForce GTX 680 на 42-47%, что в очередной раз является превосходным результатом для видеокарт одного поколения графических процессоров. Вместе с тем, TITAN медленнее GeForce GTX 690 на 13-24%, а разгон позволяет сократить это отставание до 2-8%.

Battlefield 3

В Battlefield 3 разница между однопроцессорными видеокартами NVIDIA не такая впечатляющая, как в предыдущих играх и составляет 24-34% в пользу TITAN. Двухпроцессорная GeForce GTX 690 быстрее TITAN на 29-33%, в том числе и по минимальному числу кадров в секунду. Отметим, что при разгоне видеокарты сократить это отставание удаётся, но не так сильно, как мы видели ранее.

Sniper Elite V2 Benchmark

В Sniper Elite V2 хочется выделить не столько 42-61% превосходство TITAN над GeForce GTX 680, сколько то, как блестяще проявляет себя Radeon HD 7970 GHz Edition! В свою очередь, GeForce GTX 690 быстрее разогнанной TITAN в режимах без MSAA-сглаживания и медленнее в режимах при его активации.

Sleeping Dogs

Не менее уверенно чувствует себя Radeon 7970 GHz Edition и в игре Sleeping Dogs:

GeForce GTX TITAN совсем рядом к… Radeon HD 7970 GHz Edition, хотя новый флагман NVIDIA на 29-35% быстрее GeForce GTX 680. Двухпроцессорная GeForce GTX 690 недостижима для TITAN, в том числе и при разгоне последнего.

F1 2012

Необъяснимым образом сложилась ситуация в тесте F1 2012:

Речь не столько о неработоспособности SLI в режимах со сглаживанием, сколько о том, что GeForce GTX TITAN работает так, как будто все результаты получены в одном и том же тестовом режиме, хотя не заметить изменение разрешения или активацию MSAA8x во время тестирования было попросту невозможно. Вероятно, в драйверах видеокарты GeForce закралась какая-то ошибка/оптимизация, которая не позволила получить достоверный результат на GeForce GTX TITAN.

Borderlands 2

В Borderlands 2 всё возвращается «на круги своя»:

NVIDIA безапелляционно опережает здесь AMD, а новая GeForce GTX TITAN на 22-35% быстрее «старой» GeForce GTX 680, уступая GTX 690 порядка 10-12%. После разгона «Титана» ему даже удаётся обойти двухпроцессорную видеокарту в наиболее ресурсоёмком режиме.

Hitman: Absolution

Если в режиме без использования MSAA8x мы можем наблюдать вполне типичное для сегодняшних тестов преимущество GeForce GTX TITAN над GTX 680, выражающееся в 34-44%, то при включении сглаживания оно возрастает до рекордных для статьи 71-79%. Очевидно, что GTX 680 здесь не хватает ни ширины шины обмена с памятью видеокарт, ни самого объёма видеопамяти. Разогнанная TITAN догоняет двухпроцессорную GeForce GTX 690, а по минимальному числу кадров в секунду даже опережает её.

Crysis 3

Наконец, результаты в новейшей игре Crysis 3:

Radeon HD 7970 GHz Edition здесь немного быстрее GeForce GTX 680, но разница некритична, чтобы разбивать пальцы о клавиатуры в фанатских форумах. GeForce GTX TITAN быстрее GTX 680 на 29-42%, что довольно неплохо, и на 25-29% медленнее двухпроцессорной GeForce GTX 690. Догнать последнюю «Титану» не удаётся и при разгоне, хотя отставание сокращается до 11-16%.

Tomb Raider (2013)

В самой свежей игре сегодняшнего тестирования впечатляет производительность Radeon HD 7970 GHz Edition, которая едва отстаёт от новой GeForce GTX TITAN. Впрочем, последняя также выглядит здесь блестяще, опережая в номинальном режиме работы GeForce GTX 680 на 39-72%, а при разгоне превосходя даже двухпроцессорную GeForce GTX 690.

Дополним диаграммы итоговой таблицей с результатами тестов, и переходим к сводным диаграммам.

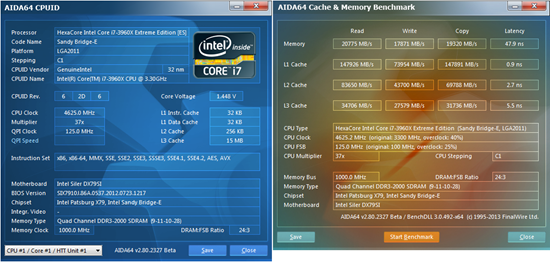

4. Сводные диаграммы

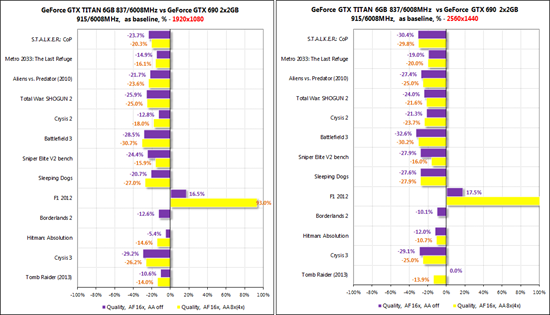

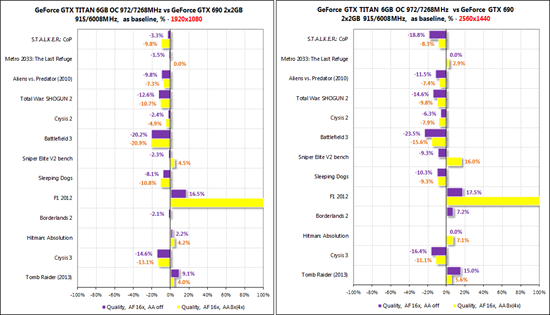

Сводные диаграммы строились только по результатам игровых тестов. Прежде всего, давайте оценим разницу в производительности новой GeForce GTX TITAN и GeForce GTX 680, от результатов которой мы и отталкивались:

В среднем по всем тестам GTX TITAN быстрее GTX 680 на 34-47% в разрешении 1920х1080 пикселей и на 39-55% в разрешении 2560х1440 пикселей. Нетрудно заметить, что наибольшее преимущество достигается в ресурсоёмких режимах с использованием методик улучшения качества изображения, и в частности – сглаживания. Именно в таких режимах и проявляют себя во всей красе 384-битная шина памяти и её увеличенный объём. При этом не будем забывать и про увеличенное число шейдерных процессоров, текстурных блоков и ROPs у GK110.

Далее посмотрим на отставание GeForce GTX TITAN от двухпроцессорной видеокарты GeForce GTX 690. Напомним, что рекомендованная стоимость этих продуктов одинакова и составляет 999 долларов США:

За исключением неадекватных результатов в игре F1 2012, в целом TITAN отстаёт от GTX 690 довольно «кучно». В разрешении 1920х1080 пикселей в среднем по всем игровым тестам «Титан» медленнее на 12-17%, а в разрешении 2560х1440 пикселей медленнее на 7-19%. Кстати, в этом сравнении мы также можем отметить влияние ширины шины обмена с памятью и её объёма на результаты.

При разгоне GeForce GTX TITAN с 837/876/6008 МГц до 973/1011/7268 МГц новый однопроцессорный флагман здорово сокращает своё отставание от GeForce GTX 690, а в некоторых играх даже удаётся вырвать лидерство у тандема GK104:

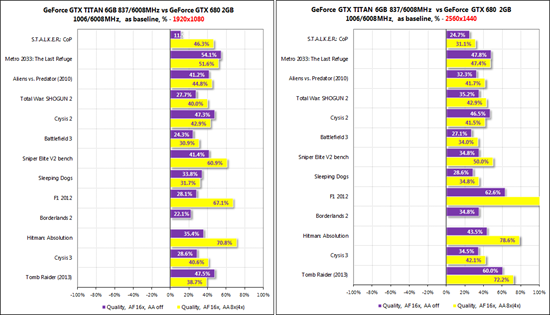

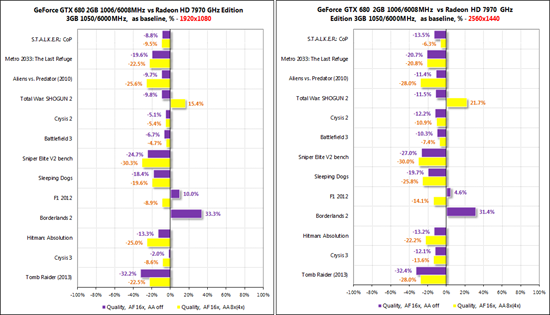

Последняя на сегодня пара сводных диаграмм не вписывается в тематику статьи, но мы решили столкнуть друг с другом GeForce GTX 680 и Radeon HD 7970 GHz Edition. Почти год назад мы уже сравнивали GTX 680 и HD 7970 друг с другом, и тогда в большинстве тестов победу одержала видеокарта на графическом процессоре NVIDIA. Однако с того времени компания AMD не только смогла снизить рекомендованную цену на свой Hi-End продукт, но и повысила частоты с 925/5500 до 1050/6000 МГц, придав видеокарте статус «GHz Edition». Не будем забывать и про перманентно оптимизирующиеся программистами драйверы Catalyst и GeForce, а также про выход новых игр. И вот как теперь складывается ситуация в противостоянии двух этих видеокарт:

Как видим, спустя год после выхода GeForce GTX 680, чаще победу одерживает именно Radeon HD 7970 GHz Edition, и это тревожный звоночек для NVIDIA. Только в Borderlands 2, качественном режиме Total War: SHOGUN 2 – Fall of the Samurai и в F1 2012 (без MSAA) GeForce GTX 680 удаётся одержать победы. Во всех остальных играх быстрее оказывается Radeon HD 7970 GHz Edition.

5. Тестирование в CUDA и OpenCL приложениях

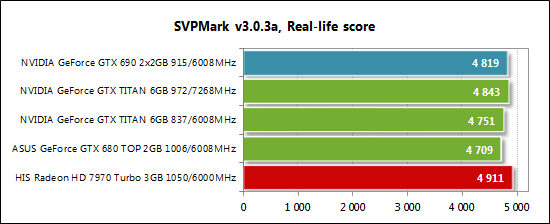

Помимо традиционных тестов в графических приложениях и играх, мы дополнительно провели изучение эффективности работы GK110 в расчётных программах и программах кодирования. Первым на очереди стал тест SmoothVideo Project (SVP) – SVPMark 3.0.3a. За результат мы приняли число баллов, полученных в Real-life тесте:

Как видим, ничего впечатляющего здесь GeForce GTX TITAN не продемонстрировала. Разница с GeForce GTX 680 минимальна, как и прирост производительности при разгоне.

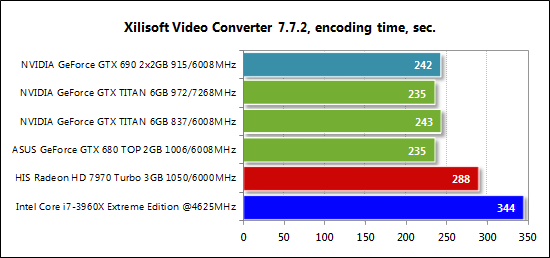

Далее мы измеряли скорость кодирования HD-видео в программе Xilisoft Video Converter версии 7.7.2, поддерживающей как графические процессоры AMD, так и NVIDIA. Для кодирования было взято FullHD-видео размером 2,5 Гбайт, конвертируемое в формат для iPad 4. На выходе получался файл размером около 750 Мбайт. Чем меньше время, тем лучше результат:

Несмотря на заметное преимущество видеокарт на графических процессорах NVIDIA над AMD и над разогнанным шестиядерным процессором Intel, GeForce GTX TITAN здесь не быстрее обычной GeForce GTX 680. Двухпроцессорная GeForce GTX 690 также не даёт ощутимого преимущества. Видимо, Xilisoft Video Converter не поддерживает мультипроцессорность, как и, по всей видимости, не задействует все возможности GK110.

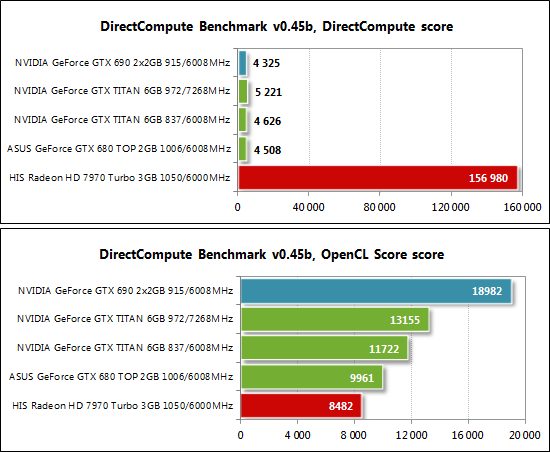

Ещё одним тестом данного раздела стал DirectCompute Benchmark версии 0.45b. На диаграмме мы приводим результаты DirectCompute и OpenCL Score:

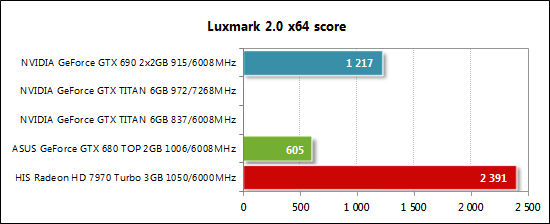

Мы попытались проверить эффективность работы GK110 и в популярном тесте LuxMark, однако нас ждало разочарование, поскольку последняя доступная на момент подготовки статьи версия 2.0 не поддерживала GeForce GTX TITAN и тест «вылетал» с ошибкой. Поэтому доступны лишь результаты старых видеокарт:

По логике, GeForce GTX TITAN должен был показать результат на уровне GeForce GTX 690, но как оно будет на самом деле мы узнаем только после выхода совместимой с GK110 версии LuxMark. Сейчас же мы можем констатировать тот факт, что AMD Radeon здесь значительно быстрее.

Заключение

По итогам всех тестов у нас сложились смешанные впечатления от NVIDIA GeForce GTX TITAN. C одной стороны мы имеем безоговорочного однопроцессорного лидера по производительности, который потребляет некритично больше электроэнергии прежних флагманов AMD и NVIDIA, шумит даже чуть меньше и поддерживает все те технологии, которыми наделили GeForce GTX 680, и даже чуть больше (GPU Boost 2.0, например). Более всего в GeForce GTX TITAN впечатляет именно производительность, – она попросту ошеломительна! Как ещё иначе назвать 50-процентную (а нередко и выше) прибавку в скорости к теперь уже бывшему однопроцессорному флагману NVIDIA – GeForce GTX 680? В последние годы такая разница, к сожалению, недостижима даже при смене поколений графических процессоров, не говоря про линейку видеокарт одного семейства GPU. Выпуском GeForce GTX TITAN компания NVIDIA стремилась продемонстрировать своё технологическое превосходство над конкурентом, и, нужно признать, ей это всецело удалось.

В то же время, неоправданно высокая начальная стоимость GeForce GTX TITAN и примерно 10-20% проигрыш по скорости двухпроцессорной GeForce GTX 690, рекомендованная стоимость которой идентична TITAN, а розничная, скорее всего, пару месяцев будет ниже, не позволяют сделать однозначный выбор в пользу новинки на GK110. Кроме того, для не опасающихся AFR-рендеринга геймеров выгоднее выглядят конкуренты в лице CrossFireX-связки из двух Radeon HD 7970 GHz Edition – по скорости данный тандем будет быстрее в подавляющем большинстве игр, но проиграет по энергопотреблению и тепловыделению. Впрочем, владельцы этого класса видеокарт вряд ли принимают во внимание счета за потреблённое электричество. Так что, как имиджевый продукт GeForce GTX TITAN хорош, вероятно даже безупречен, но с точки зрения цены мы не можем назвать его приобретение выгодным. Впрочем, по утверждениям NVIDIA, три GeForce GTX TITAN быстрее двух GeForce GTX 690 – это так, на заметку «золотой молодёжи».

Неоднозначные впечатления на нас произвела и технология GPU Boost 2.0. Разгон видеокарты теперь стал куда более кропотливым и трудоёмким, а зависимость от температуры существенно возросла. В связи с этим, наибольший интерес должны бы представлять не эталонные TITAN с оригинальными системами охлаждения, но суждено ли появиться таким видеокартам? На наш взгляд, скорее нет, чем да. И раз уж NVIDIA оказалась способна выпустить TITAN, а до выхода новых графических процессоров ещё довольно много времени, то может она порадует поклонников своей продукции какой-нибудь GeForce GTX 685 с 384-битной шиной и 6 Гбайт видеопамяти? Так как сейчас производительность GeForce GTX 680 на фоне значительно окрепшей и подешевевшей Radeon HD 7970 GHz Edition выглядит не слишком выразительно. Время покажет…