Ваш город: Москва

Новый флагман: обзор и тестирование видеокарты NVIDIA GeForce GTX 1080

Предисловие

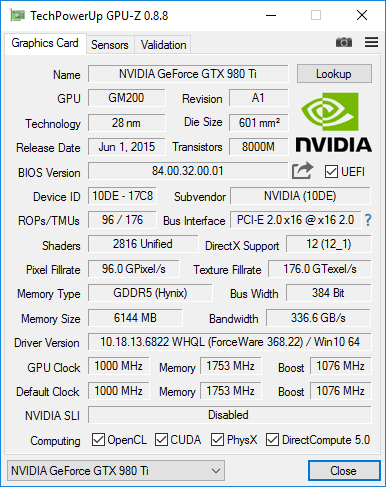

С момента анонса самой быстрой однопроцессорной видеокарты для потребительского рынка – GeForce GTX 980 Ti – прошёл год. В основу этой видеокарты тогда лёг графический процессор GM200 на архитектуре Maxwell 2.0, правда в немного урезанном виде, поскольку стопроцентный флагманский «Максвелл» установили на вышедшую кварталом ранее GeForce GTX TITAN X. Тем не менее, появившиеся спустя несколько недель после анонса оригинальные версии GeForce GTX 980 Ti с серьёзно повышенными частотами и эффективными системами охлаждения не только легко опережали TITAN X в игровых бенчмарках, но и великолепно разгонялись, что делало их беспрецедентными по производительности видеокартами с одним GPU.

И всё же, перманентно повышающиеся требования новых игр, поддержка улучшенного API DirectX 12, а также наступление эры 4K и шлемов виртуальной реальности требовали ещё более высокой производительности и, главное, производительности на ватт, ведь увеличивать тепловой пакет высокопроизводительных видеокарт было уже некуда. Поэтому вполне закономерным и наиболее ожидаемым решением стал переход с техпроцесса 28 нм к более тонкому 16 нм FinFET, который, наконец-то, удалось запустить в массовое производство компании TSMC. Именно под эти нормы компанией NVIDIA была разработана графическая архитектура Pascal, новости о которой являлись основными и наиболее массовыми на сайтах соответствующей тематики.

Первым GPU данной архитектуры стал GP104 в составе новейшей видеокарты NVIDIA GeForce GTX 1080.

Видеокарта сразу же в эталонной версии получила беспрецедентно высокие частоты и GPU Boost 3.0, восемь гигабайт новой памяти GDDR5X с улучшенными алгоритмами сжатия, поддержку большого числа новых технологий, асинхронных вычислений Async Compute, улучшенные возможности с кодированием и декодированием видеоряда, модернизированную поддержку мультипроцессорных технологий и прочее. Обо всём этом мы и расскажем в сегодняшнем материале.

1. Теория и архитектура: Pascal или Maxwell 3.0?

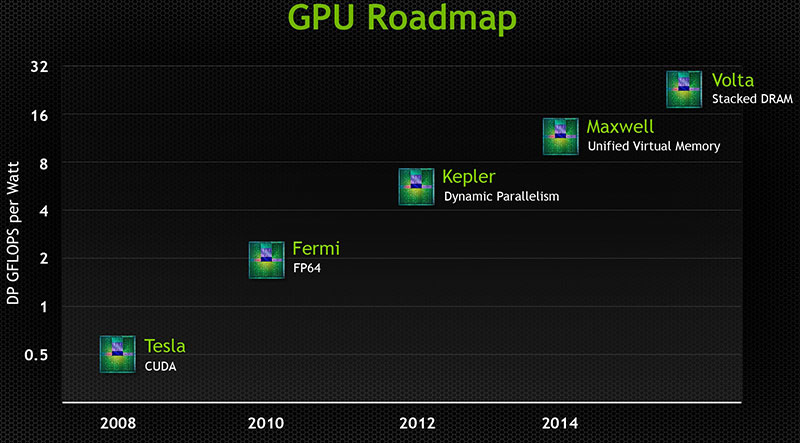

Несколько лет назад, компания NVIDIA, рассказывая о своих планах, продемонстрировала вот такую «дорожную карту».

Судя по этим данным, после «Кеплера» в 2012 году, в 2014 году нас ожидал графический процессор Maxwell, а примерно в 2016 году – Volta. Как видим, никакого Pascal тут нет и в помине. Причиной изменения планов оказалась неспособность TSMC, давнего партнёра NVIDIA по выпуску графических процессоров, справиться с новым 20-нм технологическим процессом. Мы наблюдали уникальную ситуацию, когда NVIDIA более четырёх лет с момента выпуска GeForce GTX 680 в марте 2012 года использовала один и тот же 28-нм техпроцесс, и, пропустив 20 нм, «перепрыгнув» через одну ступень, сразу перешла к использованию 16 нм в GP104 архитектуры Pascal. Иначе говоря, огромный период времени, по меркам IT индустрии, компания была вынуждена как-то выкручиваться и обходиться тем, что есть. И это при том, что в предыдущие 4 года (с 2008 по 2012) NVIDIA успела сменить сразу три техпроцесса – 65 нм, 55 нм и 40 нм.

Восстановим хронологию событий:

в марте 2012 года NVIDIA выпускает первый чип с использованием 28-нм техпроцесса – GK104, который формально принадлежит к чипам среднего уровня и обладает сравнительно небольшой площадью. Спустя некоторое время, руководитель NVIDIA негативно высказывается в адрес TSMC, критикуя их за неспособность выпускать продукцию на техпроцессе 28 нм в срок и с приемлемым уровнем брака;

спустя почти год, в феврале 2013 года, NVIDIA решается представить старший чип линейки – GK110, обладающий вдвое большей сложностью и площадью, чем GK104. По всей видимости, выход годных кристаллов всё ещё не позволял выпускать подобные чипы массово и экономически выгодно, поэтому GeForce GTX Titan вышел с одним отключённым SMX и по цене в $999. Более доступный GeForce GTX 780, с тремя отключёнными SMX-блоками выходит в мае 2013 года, по цене $649;

в ноябре 2013 года в массовый сегмент рынка выходит полноценный GK110 в составе видеокарты GeForce GTX 780 Ti;

наступает 2014 год, когда нас должен был ждать Maxwell на новом 20-нм техпроцессе, но никаких намёков на скорый анонс нет. Напротив, начинают ходить слухи, что TSMC не смогла довести новый техпроцесс до того состояния, чтобы выпускать на нём высокопроизводительные графические процессоры. Ситуация патовая, новая архитектура готова, но выпустить чипы подрядчик не может. NVIDIA решается перенести новую архитектуру на уже освоенный 28 нм техпроцесс. Пробными шагами стали два небольших чипа – GM108 и GM107. Cо старшим из них, мы познакомились в феврале 2014 года – GeForce GTX 750 Ti. Уже тогда новая архитектура и её энергоэффективность произвели очень хорошее впечатление. Ещё теплилась надежда, что обещанные чипы на базе Maxwell 2.0 выйдут на 20-нм техпроцессе. К сожалению, надежды не оправдались. NVIDIA и AMD по ряду причин отказались от выпуска решений по этим нормам. Единственным представителем архитектуры Maxwell на техпроцессе 20 нм, является графический процессор, встроенный в Tegra X1;

в сентябре 2014 года дебютирует первый чип на архитектуре Maxwell 2.0 – GM204, ставший новым флагманом линейки – GeForce GTX 980. Спустя полгода, в марте 2015 года, его сменяет GM200 в основе видеокарты GeForce GTX Titan X, а затем и GeForce GTX 980 Ti.

Резюмируя хронологию событий, скажем, что после выхода Kepler на 28-нм техпроцессе в 2012 году нас ждал Maxwell на 20-нм в 2014 году, а к 2016 году планировалась архитектура Volta, на 16 нм. Как мы уже знаем, в 2014 году мы получили только новую архитектуру, а техпроцесс остался прежним. В этом году мы, наконец, получили новый техпроцесс, а вот получили ли новую архитектуру, нам и предстоит сегодня разобраться.

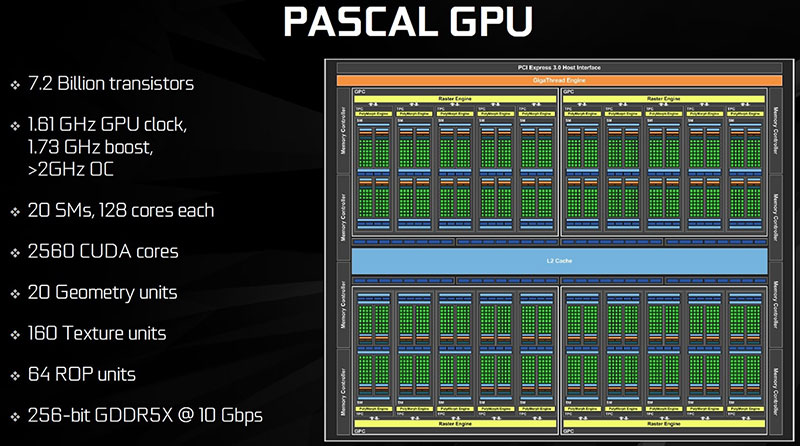

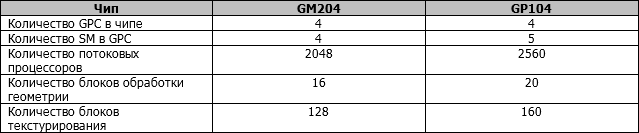

Изменения архитектуры графического процессора в этот раз носят скорее количественный, чем качественный характер. Если во время презентаций Kepler и Maxwell акцент делался на изменениях в архитектуре и энергоэффективности, то в этот раз больше внимания уделено деталям и незначительным улучшениям. Первое, что стоит отметить, это некоторые архитектурные отличия GP104 от недавно представленного чипа GP100, ориентированного на вычисления. Архитектура Pascal в GP104 почти полностью повторяет Maxwell, дебютировавшую два года назад. Для удобства и наглядности сравним новичка с GM204.

Как и предшественник, GP104 содержит 4 блока GPC, 64 блока ROP и 2 Мбайт кэш памяти второго уровня. Небольшие структурные изменения коснулись контроллера памяти. Он по-прежнему остался 256-битным, но теперь он состоит не из четырёх 64-битных каналов, а из восьми 32-битных. Следовательно, к каждому каналу теперь привязано 8 блоков ROP, вместо 16. Но общее их количество осталось неизменным – 64 штуки.

В отличие от GM204, новый графический процессор содержит в каждом GPC не 4 блока SM, а 5. Таким образом, на 25% увеличивается количество исполнительных устройств.

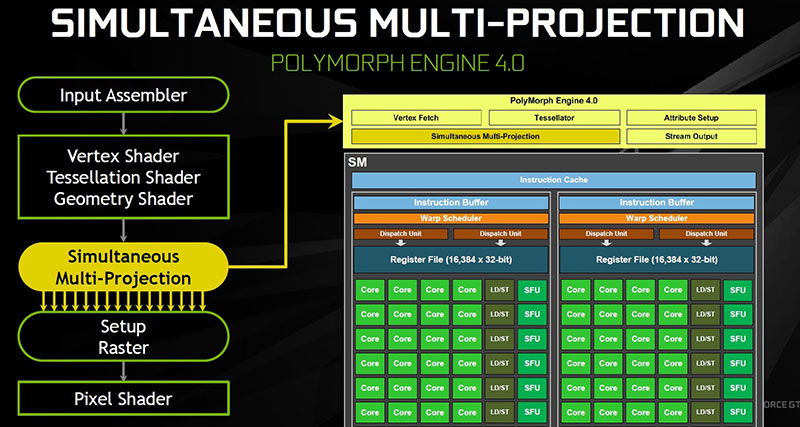

Значительно возросшие частоты GP104 позволяют только усилить это преимущество и довести общее превосходство над GM204 в теоретических показателях текстурирования и математической производительности до величины около 70%. Но в меньшем масштабе архитектура Pascal всё же привнесла некоторые изменения. Если раньше блок обработки геометрии Polymorph Engine был частью SM, то теперь один блок SM и один блок Polymorph Engine образуют новую структурную единицу – TPC (Texture Processor Cluster). Этот термин был впервые использован NVIDIA в 2006 году, при описании архитектуры Tesla и графического процессора G80, но не использовался в последующих архитектурах – Fermi, Kepler и Maxwell.

Важные изменения произошли в блоках Polymorph Engine, которые теперь имеют версию 4.0. Благодаря появлению в их составе нового блока мультипроецирования – SMP (Simultaneous Multi-Projection), решения на базе архитектуры Pascal получат значительный прирост производительности в играх, использующих технологию виртуальной реальности, где видеокарте приходится строить каждый кадр дважды, для разных углов проекции левого глаза и правого. Теперь геометрия сцены не будет пересчитываться для каждого глаза, а будет использоваться в двух разных проекциях, что позволит сэкономить ресурсы и повысить производительность. Это главный козырь новой архитектуры, который позволит в VR играх обойти предшественников в лице GeForce GTX 980/980 Ti и GeForce GTX Titan X примерно в 3 и 2 раза, соответственно. То есть, теоретически, один GeForce GTX 1080 сможет заменить два GeForce GTX Titan X. Экономия налицо.

Кроме игр с использованием шлема виртуальной реальности, данная технология может применяться и с другими устройствами вывода изображения, от уже привычных, до редких и футуристичных.

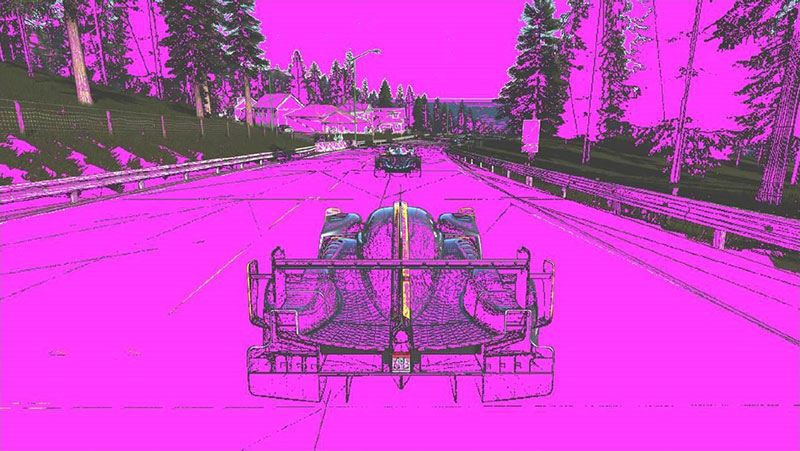

В архитектуре Pascal NVIDIA улучшила технологию сжатия буфера кадра, которые были представлены с архитектурой Maxwell 2.0. Графическому процессору GP104 доступны новые алгоритмы, которые работают, по оценке производителя, примерно на 20% эффективнее, чем у предшественника. В качестве примера приводится набор слайдов. На первом демонстрируется исходный кадр.

На втором фиолетовым цветом закрашены те части кадра, которые сжимал Maxwell 2.0.

Наконец, на третьем закрашены те части, которые способна сжать архитектура Pascal.

Как видим, разница между старыми и новыми алгоритмами заметна невооружённым глазом. Но это не единственное улучшение в подсистеме памяти. NVIDIA GeForce GTX 1080 получила память типа GDDR5X, которая работает на более высоких частотах по сравнению с уже привычной GDDR5. Вместе с новыми алгоритмами сжатия производительность подсистемы памяти выросла примерно на 70%, как и вычислениях. Это означает, что GeForce GTX 1080 обещает быть примерно на 70% быстрее, чем GeForce GTX 980.

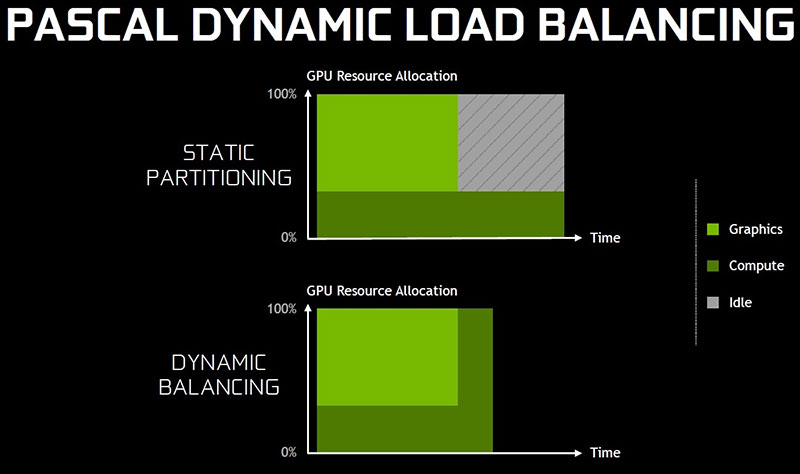

В новой Pascal было уделено внимание асинхронным вычислениям, которые всё чаще встречаются в новых играх и которые стали ахиллесовой пятой архитектуры Kepler, где их использование сильно ударяло по производительности. С приходом архитектуры Maxwell, ситуация изменилась в лучшую сторону, но всё ещё была далека от идеальной. Вычисления могли выполняться параллельно на выделенных для этого блоках, но ресурсы не могли динамически перераспределяться, так что вычисления или рендеринг самой картинки могли стать узким местом, а часть исполнительных устройств простаивала. Архитектура Pascal позволяет динамически перераспределять ресурсы между графическими и вычислительными задачами, а значит исполнительные устройства теперь будут использоваться с большей эффективностью.

Неожиданные изменения произошли в фирменной технологии SLI, позволяющей использовать параллельно несколько видеокарт. Впервые SLI была представлена в 2004 году, с видеокартами GeForce 6800 и переходом на шину PCI Express. Стало возможным объединять две видеокарты. В 2006 году GeForce 8800 GTX обзавёлся вторым разъёмом SLI на плате, что позволило использовать в связке три или четыре видеокарты.

GeForce GTX 1080 сохранила два разъёма для подключения мостиков SLI, как и у решений предшествующих поколений, но теперь использоваться они могут иначе. Можно задействовать оба разъёма одновременно для соединения двух видеокарт. Для реализации этой возможности NVIDIA выпустила новые мостики, которые подключаются к двум разъёмам каждой видеокарты – SLI HB Bridges. Таким образом, пропускная способность между видеокартами становится вдвое больше. Помимо этого, с новыми мостиками интерфейс SLI работает на повышенной частоте – 650 МГц, против 400 МГц у предшествующих решений. Следовательно, двойной мостик и более высокая частота позволяют получить полосу пропускания втрое большую, чем ранее. Старые мостики также можно использовать, но для требовательных режимов NVIDIA рекомендует новые.

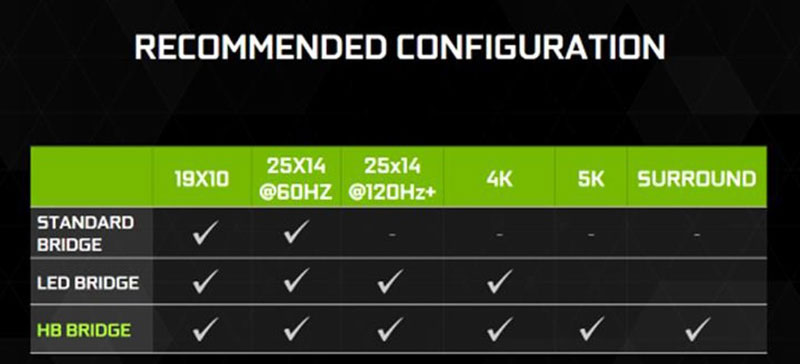

Теперь все мостики и способы соединения видеокарт в SLI можно разделить на три категории:

Standart bridge – обычные SLI мостики, на гибком шлейфе (привычный способ объединения);

LED bridge – жёсткие мостики на текстолите, которые выпускали партнёры, часто оснащались светодиодной подсветкой. Такие мостики хоть и используют один разъём, но могут работать на частоте 650 МГц, что позволит связке видеокарт более эффективно работать в высоких разрешениях, вплоть до 4К;

HB bridge – новые жёсткие мостики, использующие оба разъёма видеокарты на частоте 650 МГц (для максимальной пропускной способности интерфейса SLI и работы в разрешениях 5К или на нескольких мониторах).

Как может заметить внимательный читатель, если использовать новый двойной мостик, то в режим SLI можно объединить только две видеокарты, а не 3 или 4, как раньше. Всё верно. NVIDIA считает, что в современных играх очень сложно получить прирост производительности от третьего и уж тем более от четвёртого GPU. Поэтому компания решила сосредоточить усилия на режиме SLI с использованием двух видеокарт, и именно этот режим теперь является рекомендованным. По-умолчанию, новые видеокарты смогут работать только в нём. Это не означает, что SLI режимы для трёх или четырёх графических процессоров теперь запрещены. Но доступ к ним усложнён. Если вы энтузиаст и хорошо понимаете, зачем вам 3 или 4 GPU в SLI, то для активации этого режима вам потребуется получить «Ключ энтузиаста» (Enthusiast Key), с помощью сайта NVIDIA и специальной утилиты.

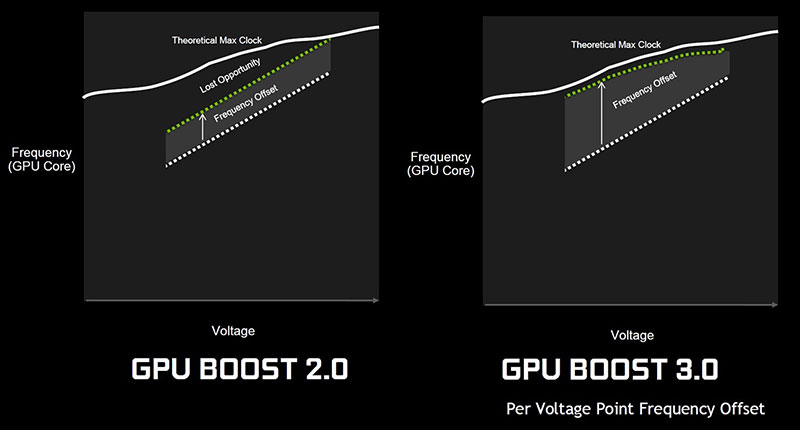

В отличие от неожиданных изменений в работе режима SLI, изменения в работе технологии динамического разгона GPU Boost уже стали почти традицией. Как и раньше, частота графического процессора автоматически увеличивается там, где это возможно, не превышая пороговые значения температуры и энергопотребления. Но теперь появилась возможность более тонкой настройки частот в различных режимах и для разных напряжений графического процессора. С помощью утилит, поддерживающих технологию GPU Boost 3.0, нужно запустить процедуру сканирования, во время которой утилита сама протестирует GPU на предмет нахождения максимальных частот для каждого режима.

На наш взгляд, данная технология сделает разницу между картами более значительной, а тестирование в таком режиме нерепрезентативным. Ведь теперь частота графического процессора будет зависеть не только от температуры GPU, системы охлаждения и характера нагрузки, но и от индивидуальных особенностей каждого конкретного экземпляра GPU.

Вместе с первым решением на архитектуре Pascal, NVIDIA представляет ещё одну собственную технологию для управления вертикальной синхронизацией. Она дополняет уже существующие G-Sync и Adaptive V-sync. Первая предназначена для плавного вывода изображения на мониторы, поддерживающие данную технологию и имеющую дополнительную плату внутри для её поддержки. Вторая технология доступна всем обладателям карт на архитектуре Kepler и новее, и призвана помочь в тех случаях, когда число кадров в секунду, выдаваемых видеокартой, не способно стабильно превышать частоту обновления монитора, и включение обычной вертикальной синхронизации даст сильные просадки производительности. Новая технология – Fast Sync – призвана сделать более плавным вывод картинки на монитор в играх, где современные видеокарты выдают несколько сотен кадров в секунду, не сильно пожертвовав при этом задержками в выводе изображения. Fast Sync обещает избавить от раздражающих разрывов изображения в подобных сценариях, сохранив задержки вывода изображения на величинах близких к режиму выключенной вертикальной синхронизации.

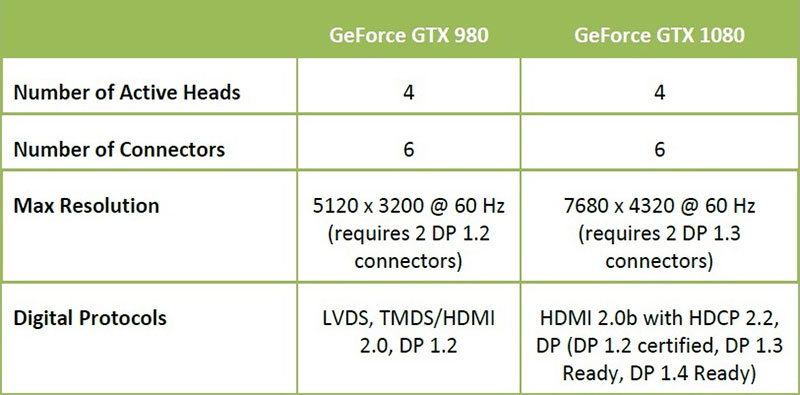

Набор видеовыходов остался тем же, что и у предшественника, но появилась поддержка новых протоколов и более высоких разрешений. Также стоит отметить, что разъём DVI на видеокарте теперь типа DVI-D, а не DVI-I, как ранее. Это означает, что видеокарта лишилась поддержки мониторов с аналоговым входом (D-Sub), и подключить такой монитор к видеокарте с помощью обычного переходника не удастся. Впрочем, самые стойкие любители тёплого лампового и аналогового сигнала смогут подключить монитор с таким входом с помощью активного переходника с DisplayPort на VGA. Но стоят такие переходники недёшево.

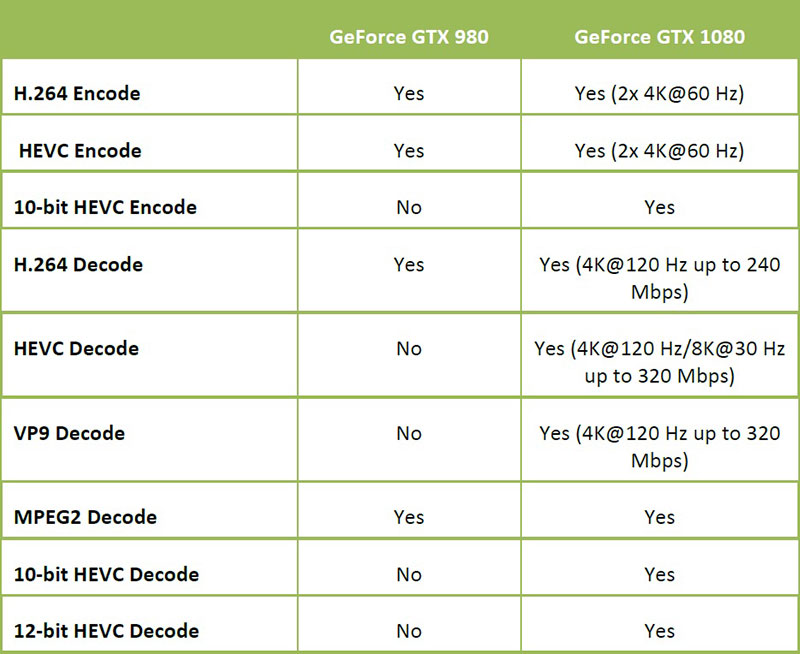

Также, видеокарты на базе GP104 имеют обновлённый блок кодирования и декодирования видео. Добавлена поддержка новых форматов и увеличена производительность в ряде имеющихся.

Итак, какой же ответ можно дать на вопрос, поставленный в начале статьи? С одной стороны, новинка не может похвастать глубокими архитектурными изменениями или отличиями. Pascal отличается от Maxwell гораздо меньше, чем Maxwell отличался от Kepler. Так что, это скорее Maxwell 3.0, чем новая архитектура. С другой стороны, мы получили множество небольших изменений, серьёзный прирост тактовых частот графического процессора, выполненного по 16-нм технологии, а также памяти нового типа – GDDR5X. В совокупности все эти изменения и улучшения должны дать значительный прирост производительности, причём не только в задачах и играх сегодняшнего дня, но и в тех, что появятся в будущем. К сожалению, только время покажет, верные ли ставки на будущее сделала NVIDIA, ну а мы плавно переходим к детальному рассмотрению карты и её тестированию в приложениях дня настоящего.

2. Обзор видеокарты NVIDIA GeForce GTX 1080 8 Гбайт

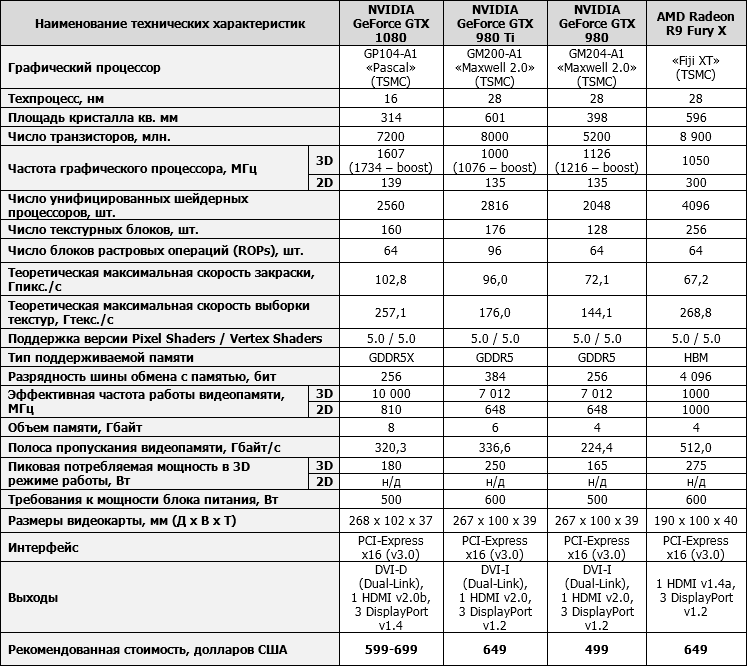

технические характеристики видеокарты и рекомендованная стоимость

Технические характеристики и стоимость видеокарты NVIDIA GeForce GTX 1080 приведены в таблице в сравнении с эталонными версиями NVIDIA GeForce GTX 980 Ti и GTX 980, а также AMD Radeon R9 Fury X.

дизайн и особенности печатной платы

Образцы для прессы предоставлялись на тестирование в небольшой коробке, выполненной из плотного картона и оформленной в привычном NVIDIA-стиле.

Внутри коробки, в самом её центре, находится отсек под видеокарту, где она и зафиксирована. Больше про упаковку эталонного образца рассказывать нечего, поэтому сразу же перейдём к обзору видеокарты.

Дизайн новой NVIDIA GeForce GTX 1080 во многом напоминает дизайн прежних GeForce GTX 980 Ti или GTX 980, но из явных отличий выделим рифлёный кожух с треугольными вставками около вентилятора кулера, а также надпись «GTX 1080» на кожухе в зоне у выходов.

На обратной стороне появились две защитные панели, установленные встык. На них NVIDIA нанесла свой логотип и название модели видеокарты. Сверху на кожухе осталась надпись с зелёной подсветкой.

Длина референсного образца GeForce GTX 1080 составляет 268 мм, высота – 102 мм, а толщина – 37 мм. Весит данный экземпляр 1023 грамма.

На максимально разреженной для пропуска нагретого видеокартой воздуха панели с выходами установлены один DVI-D (переходники на аналоговые видеовыходы теперь не поддерживаются), один HDMI версии 2.0b и три DisplayPort версии 1.4. Одновременно допускается подключение четырёх мониторов.

С противоположного торца платы видны рёбра радиатора системы охлаждения, через которые выходит малая часть воздуха, которая всё же выбрасывается внутрь корпуса системного блока. Впрочем, не думаю, что у покупателей GeForce GTX 1080 корпуса с недостаточно эффективной системой вентиляции, так что здесь никакой проблемы нет.

NVIDIA GeForce GTX 1080 оснащается одним восьмиконтактным разъёмом для подключения дополнительного питания. Поскольку заявленный уровень энергопотребления эталонных версий этой модели видеокарты не должен превышать 180 ватт, то такого питания будет вполне достаточно. Тем не менее, как показывает пока ещё небольшая, но всё же статистика разгона GeForce GTX 1080, для разгона видеокарты нужны куда более усиленные по питанию версии.

Конструктивно разъёмы для создания SLI-конфигураций не изменились, поэтому с ними по-прежнему можно использовать старые мостики. Однако для поддержки мультипроцессорными связками 4К-разрешений и выше потребуются новые двойные мосты SLI, о которых NVIDIA рассказывала в пресс-релизах.

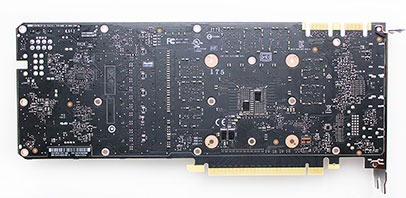

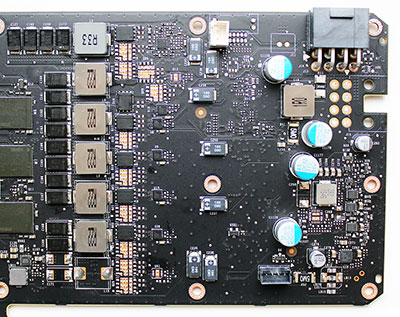

Компоновка печатной платы во многом напоминает платы GeForce GTX 980 Ti, но всё же иная, а по числу элементов и количеству фаз питания попроще.

Всего на питание графического процессора отведено пять фаз. С лицевой стороны платы в зоне питания графического процессора видны пустующие площадки под дополнительные элементы.

Возможно, этот же дизайн печатной платы будет использоваться для более производительных моделей видеокарт NVIDIA.

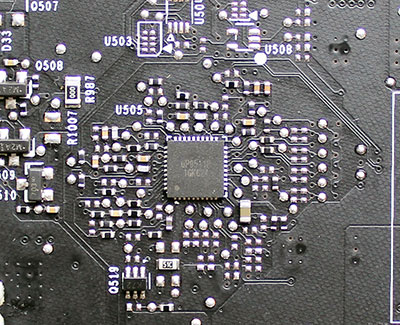

Управление питанием графического процессора осуществляется контроллером uP с нечитаемой маркировкой.

Ранее используемого NCP81174 производства ON Semiconductor на печатной плате найти не удалось. Но, скорее всего, это не важно, поскольку на оригинальных версиях GeForce GTX 1080 будут использоваться другие PCB и контроллеры.

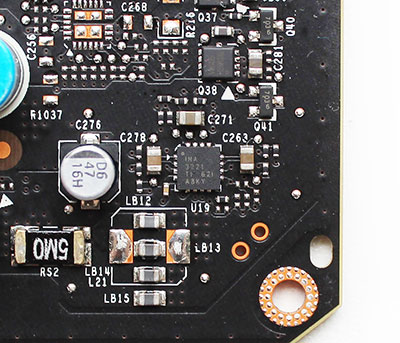

Также отметим, что функции мониторинга видеокарты возложены на микросхему INA3221 производства Texas Instruments.

В сравнении с огромными кристаллами GM200 видеокарт GeForce GTX 980 Ti и Titan X новый GP104 выглядит компактным и едва ли соответствует ценовому классу GeForce GTX 1080. Площадь кристалла графического процессора почти вдвое меньше и составляет 314 мм2. Отметим, что кристалл не имеет защитной рамки, поэтому при снятии или установке систем охлаждения стоит быть предельно осторожным.

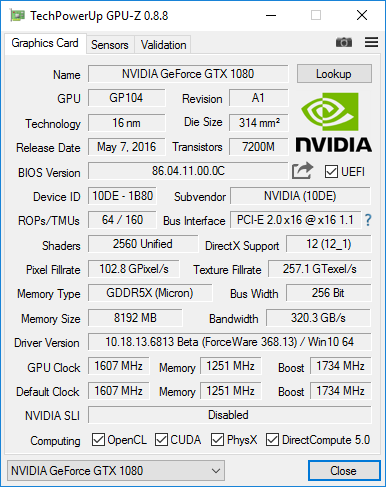

Судя по маркировке, GP104 нашего экземпляра видеокарты выпущен на 15-й неделе 2016 года. О конфигурации GPU и его особенностях мы уже рассказали в разделе с теорией, но в сухих цифрах добавим, что у GP104 2560 унифицированных шейдерных процессоров (на 9% меньше, чем у GTX 980 Ti и на 25% больше, чем у GTX 980), 160 текстурных блоков и 64 ROP. Компенсировать архитектурное отставание от GeForce GTX 980 Ti новой GeForce GTX 1080 поможет рекордно высокая частота графического процессора, составляющая номинальные 1607 МГц, что на 60,7% выше, чем у эталонных GeForce GTX 980 Ti. Более того, в 3D-режиме частота способна автоматически форсироваться до 1734 МГц, а по данным мониторинга и вовсе достигала 1898 МГц! Такие значения прежде были доступны лишь при экстремальных типах охлаждения, а теперь, благодаря новому 16-нм техпроцессу, доступны и на далеко не самом эффективном воздушном охлаждении. Прогресс, как говорится, налицо. Добавим, что при переходе в 2D-режим частота процессора снижается до 139 МГц одновременно со снижением напряжения с 1,062 В до 0,8 В.

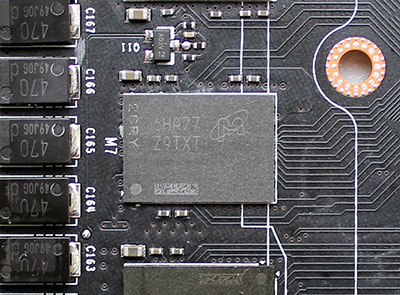

На лицевой стороне печатной платы распаяны восемь микросхем памяти нового типа GDDR5X суммарным объёмом 8 Гбайт. Микросхемы выпущены компанией Micron и имеют номинальную частоту 2,5 ГГц (10,0 ГГц – эффективная).

Такие чипы даже на сравнительно узкой шине 256 бит способны обеспечить пропускную способность 320,3 Гбайт/с, то есть почти на уровне GeForce GTX 980 Ti с её 384-битной шиной. Кроме этого, данные микросхемы работают на напряжении 1,35 В, что позволяет быть им на 20% энергоэффективнее. Напомним мы и про новые алгоритмы сжатия данных, реализованные в архитектуре Pascal, которые дополнительно сэкономят до 20% полосы пропускания. В 2D-режиме частота памяти составляет 810 эффективных мегагерц.

В завершение обзора эталонной NVIDIA GeForce GTX 1080 добавим, что последняя доступная на момент подготовки статьи версия GPU-Z уже знакома с характеристиками этой видеокарты.

А вот BIOS и ASIC GeForce GTX 1080 считывать она пока не умеет.

системы охлаждения – эффективность и уровень шума

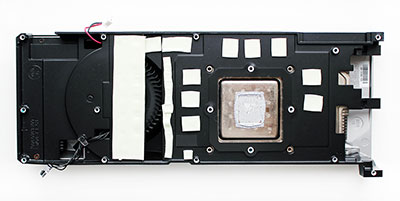

Система охлаждения видеокарты NVIDIA GeForce GTX 1080 претерпела минимальные изменения в сравнении с кулерами эталонных GeForce GTX 980 Ti или GTX 980. И то они касаются лишь особенностей металлической основы кулера, контактирующей с чипами памяти и силовыми элементами печатной платы.

В остальном это всё тот же кулер с массивным радиатором графического процессора, радиальным вентилятором, прокачивающим воздух через этот радиатор, и небольшим радиатором в задней части платы.

В основании основного радиатора – испарительная камера, контактирующая с графическим процессором через термопасту серого цвета (кстати, отметим? наконец-то, аккуратное и не чрезмерное нанесение термопасты на GPU).

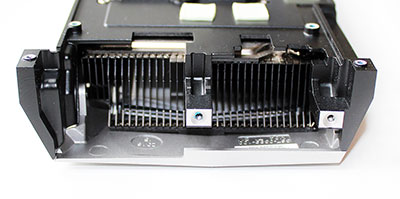

С торца кулера видны рёбра и плоская тепловая трубка, дополнительно снимающая тепловую нагрузку с видеокарты.

Скорость вращения вентилятора регулируется автоматически ШИМ-методом в диапазоне от 1000 до 4100 об/мин.

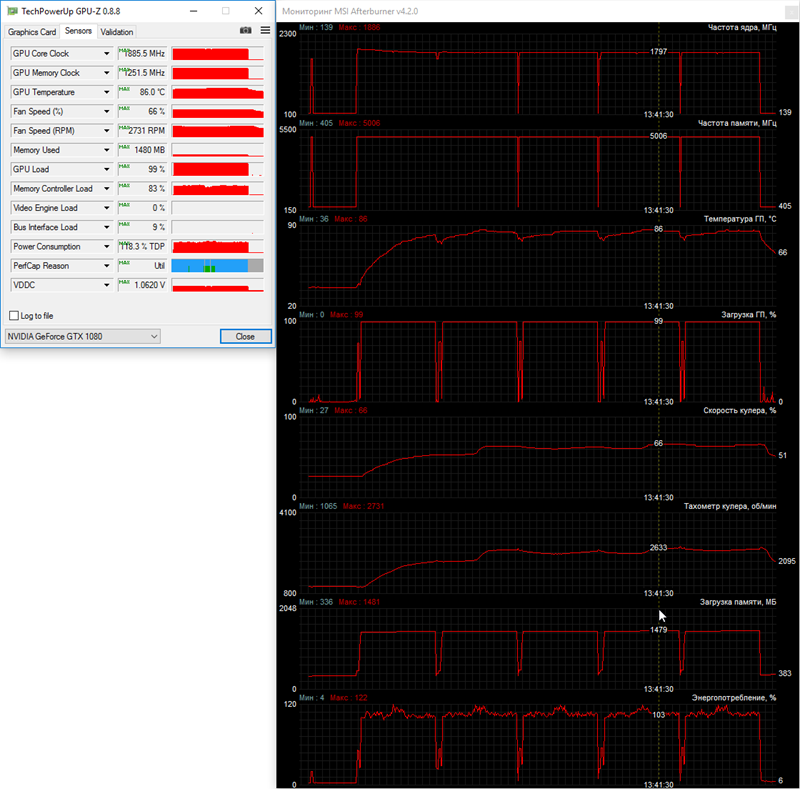

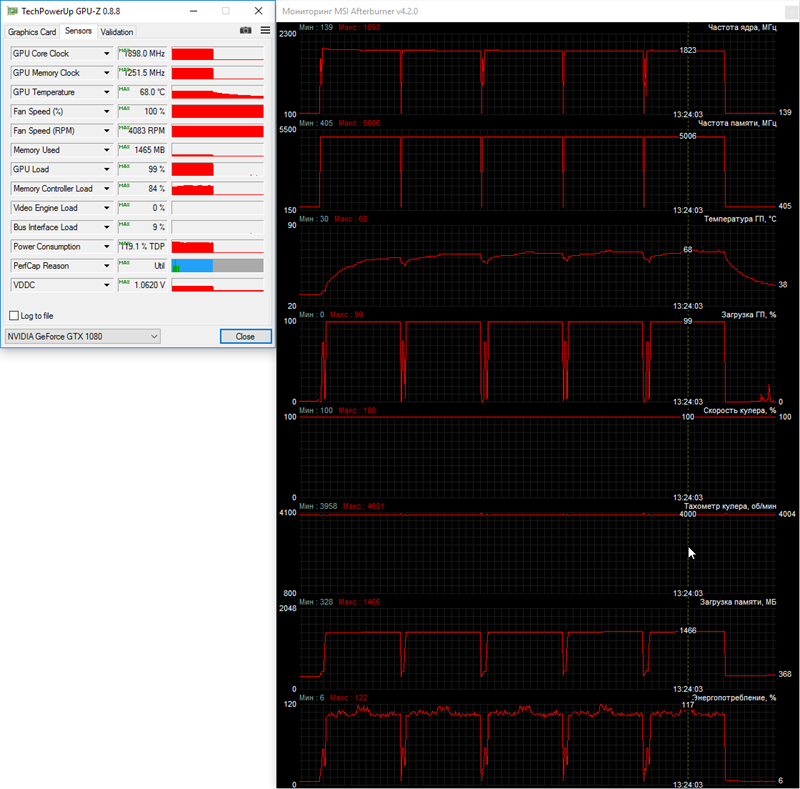

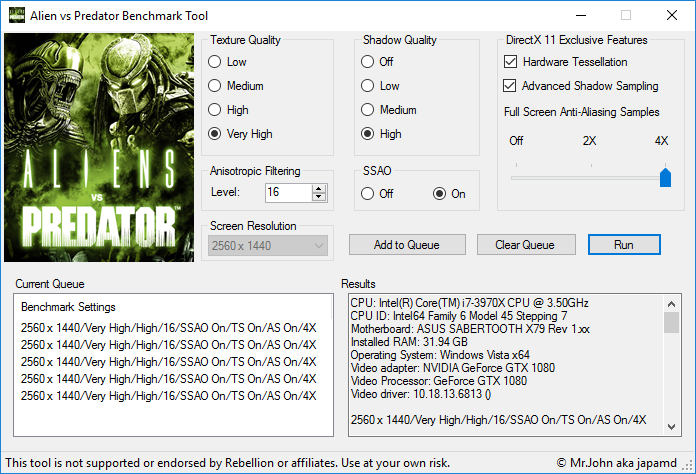

Для проверки температурного режима работы видеокарты NVIDIA GeForce GTX 1080 в качестве нагрузки мы использовали пять циклов теста весьма ресурсоёмкой игры Aliens vs. Predator (2010) при максимальном качестве графики в разрешении 2560 х 1440 пикселей с анизотропной фильтрацией уровня 16х и активацией MSAA-сглаживания степени 4x:

Для мониторинга температур и всех прочих параметров применялись программа MSI Afterburner версии 4.2.0 и утилита GPU-Z версии 0.8.8. Все тесты проводились в закрытом корпусе системного блока, конфигурацию которого вы сможете увидеть в следующем разделе статьи, при средней комнатной температуре 22 градуса Цельсия.

Как обычно, сначала мы проверили температурный режим работы видеокарты при полностью автоматической регулировке скорости вентилятора.

Максимальная температура ядра в таком режиме работы видеокарты уже на втором цикле теста достигла 86 градусов Цельсия, но затем увеличившаяся до 2700 об/мин скорость вращения турбины стабилизировала её. Кроме того, на графике мониторинга интересна частота работы графического процессора, которая на условно холодной видеокарте в 3D–режиме достигала 1886 МГц, а затем постепенно снизилась до 1797 МГц. То есть чем эффективнее будет охлаждаться GeForce GTX 1080, тем более высокую частоту сможет держать её графический процессор.

Подтверждает последнее предположение тестирование температурного режима NVIDIA GeForce GTX 1080 при максимально возможной скорости вентилятора кулера.

Здесь при 4000 об/мин температура графического процессора не превысила отметку 68 градусов Цельсия в пике нагрузки, а его частота держалась у 1823 МГц. По опыту тестирования предыдущих референсных образцов GeForce GTX 980 Ti и GeForce GTX 980 могу сказать, что для основных производителей видеокарт, постоянно совершенствующих свои оригинальные кулеры и печатные платы, создать одновременно условно холодную и тихую GeForce GTX 1080 никаких проблем не составит.

оверклокерский потенциал

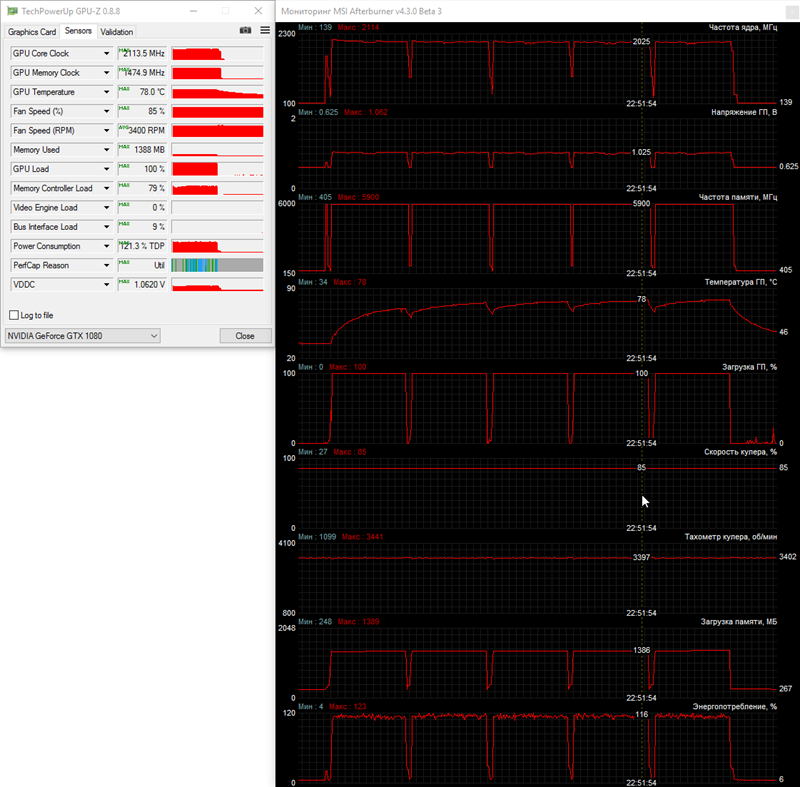

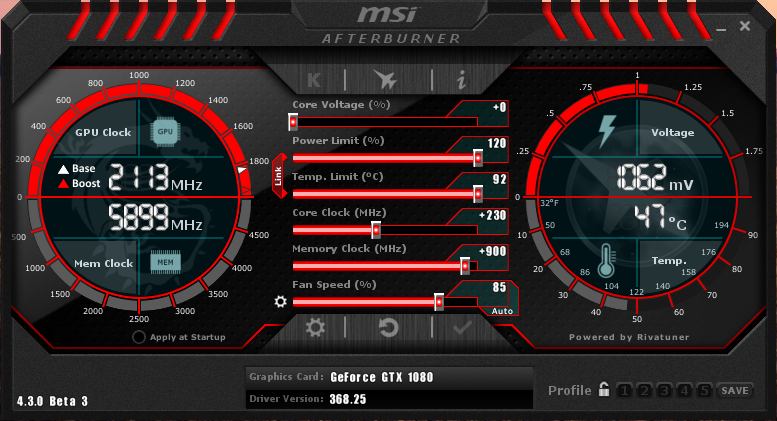

Для проверки оверклокерского потенциала первой GeForce GTX 1080 мы установили на максимум лимит по питанию (120%) и температурный лимит (92 градуса Цельсия), а скорость вентиляторов вручную зафиксировали на 85% мощности или примерно 3400 об/мин. С такими настройками базовую частоту графического процессора без потери стабильности и появления дефектов изображения мы увеличили на 230 МГц (+14,3%), а эффективную частоту видеопамяти GDDR5X – на 1800 МГц (+18%).

Итоговые частоты графического процессора после разгона составили 1837-1964 МГц, но по данным мониторинга при наших настройках частота кратковременно увеличивалась до 2114 МГц, а по ходу тестирования температурного режима GeForce GTX 1080 держалась у отметки 2025 МГц.

Довольно неплохой разгоне для первого эталонного образца. Можно надеяться, что оригинальные версии с усиленными по питанию печатными платами и эффективными системами охлаждения смогут обеспечить ещё более высокие частоты. Отметим, что штатная система охлаждения GeForce GTX 1080 справлялась с охлаждением разогнанной видеокарты, удерживая температуру графического процессора в пределах 78 градусов Цельсия. Разумеется, уровень шума при этом был высоким.

3. Тестовая конфигурация, инструментарий и методика тестирования

Тестирование производительности видеокарт было проведено в закрытом корпусе на системе следующей конфигурации:

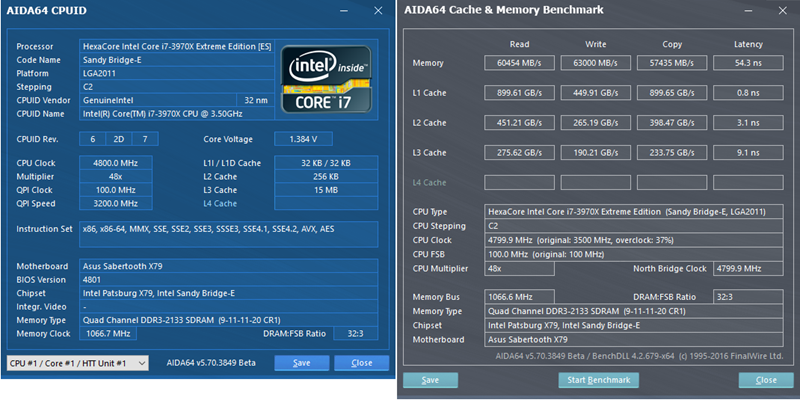

системная плата: ASUS Sabertooth X79 (Intel X79 Express, LGA2011, BIOS 4801 от 28.07.2014);

центральный процессор: Intel Core i7-3970X Extreme Edition 3,5/4,0 ГГц (Sandy Bridge-E, C2, 1,1 В, 6 x 256 Kбайт L2, 15 Мбайт L3);

система охлаждения CPU: ARCTIC Liquid Freezer 240 (4 х 1100 об/мин);

термоинтерфейс: ARCTIC MX-4;

видеокарты:

NVIDIA GeForce GTX 1080 8 Гбайт 1607-1734(1898 пиковая)/10008 МГц и 1837-1964(2025 пиковая)/11808 МГц;

NVIDIA GeForce GTX 980 Ti 6 Гбайт 1000-1076(1189 пиковая)/7012 МГц и 1250-1323(1450 пиковая)/8092 МГц;

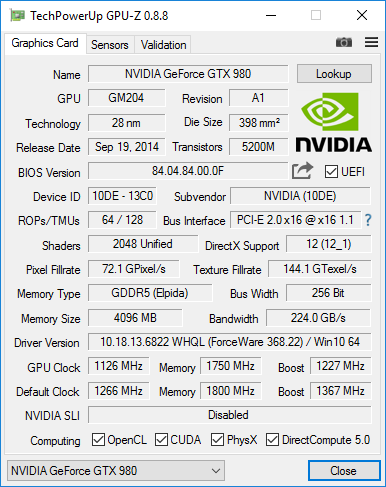

Inno3D iChill GF GTX 980 Ultra HerculeZ X4 Air Boss 4 Гбайт 1126-1227/7000 МГц (частоты снижены до номинальных для GTX 980);

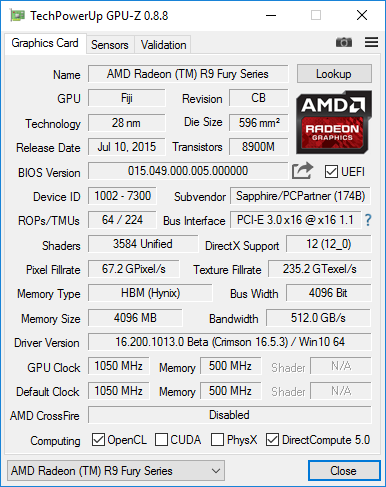

SAPPHIRE NITRO Radeon R9 FURY 4 Гбайт 1050/1000 МГц;

оперативная память: DDR3 4 x 8 Гбайт G.SKILL TridentX F3-2133C9Q-32GTX (X.M.P. 2133 МГц, 9-11-11-31, 1,6 В);

системный и игровой диск: Intel SSD 730 480GB (SATA-III, BIOS vL2010400);

диск для хранения программ и игр: Western Digital VelociRaptor (SATA-II, 300 Гбайт, 10000 об/мин, 16 Мбайт, NCQ);

архивный диск: Samsung Ecogreen F4 HD204UI (SATA-II, 2 Тбайт, 5400 об/мин, 32 Мбайт, NCQ);

звуковая карта: Auzen X-Fi HomeTheater HD;

корпус: Thermaltake Core X71 (четыре be quiet! Silent Wings 2 (BL063) на 900 об/мин);

панель управления и мониторинга: Zalman ZM-MFC3;

блок питания: Corsair AX1500i Digital ATX (1500 Вт, 80 Plus Titanium), 140-мм вентилятор.

монитор: 27-дюймовый Samsung S27A850D (DVI, 2560 х 1440, 60 Гц).

В сегодняшнее тестирование мы включили эталонную версию NVIDIA GeForce GTX 980 Ti в номинальном режиме и при разгоне, а также оригинальную Inno3D iChill GF GTX 980 Ultra HerculeZ X4 Air Boss на приведённых к номинальным для GeForce GTX 980 частотах.

Последнее сделано для объективной оценки преимущества GeForce GTX 1080 в сравнении с предшественницей в лице GeForce GTX 980.

В свою очередь, из видеокарт на графических процессорах AMD в тестирование включена SAPPHIRE NITRO Radeon R9 FURY.

Добавим, что значение Power Limit на всех видеокартах было выставлено на максимум.

Для снижения зависимости производительности видеокарт от скорости платформы 32-нм шестиядерный процессор при множителе 48, опорной частоте 100 МГц и активированной на уровень Ultra High функции Load-Line Calibration был разогнан до 4,8 ГГц при повышении напряжения в BIOS материнской платы до 1,385 В.

Технология Hyper-Threading активирована. При этом 32 гигабайта оперативной памяти функционировали на частоте 2,133 ГГц с таймингами 9-11-11-20_CR1 при напряжении 1,6125 В.

Тестирование, начатое 20 мая 2016 года, было проведено под управлением операционной системы Microsoft Windows 10 Professional со всеми обновлениями на указанную дату и с установкой следующих драйверов:

чипсет материнской платы Intel Chipset Drivers – 10.1.1.18 WHQL от 04.04.2016;

Intel Management Engine Interface (MEI) – 11.0.5.1192 WHQL от 04.05.2016;

драйверы видеокарт на графических процессорах NVIDIA – GeForce 368.13 beta для GTX 1080 и GeForce 368.22 WHQL от 23.05.2016 для остальных NVIDIA-карт;

драйверы видеокарт на графических процессорах AMD – AMD Radeon Software Crimson 16.5.3 WHQL от 24.05.2016.

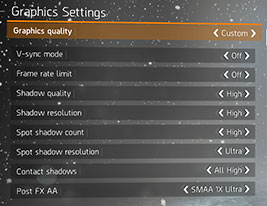

В силу ограничений монитора, производительность видеокарт была проверена в разрешениях 1920 х 1080 и 2560 х 1440 пикселей. Для тестов использовались два режима качества графики: Quality + AF16x – качество текстур в драйверах по умолчанию с включением анизотропной фильтрации уровня 16х и Quality + AF16x + MSAA 4х(8х) с включением анизотропной фильтрации уровня 16х и полноэкранного сглаживания степени 4x или 8x, в случаях, когда среднее число кадров в секунду оставалось достаточно высоким для комфортной игры. В отдельных играх, в силу специфики их игровых движков, были использованы иные алгоритмы сглаживания, что будет указано далее в методике и на диаграммах. Включение анизотропной фильтрации и полноэкранного сглаживания выполнялось непосредственно в настройках игр. Если же данные настройки в играх отсутствовали, то параметры изменялись в панели управления драйверов Crimson или GeForce. Там же была принудительно отключена вертикальная синхронизация (V-Sync). Кроме указанного, никаких дополнительных изменений в настройки драйверов не вносилось.

Видеокарты были протестированы в двух графических тестах и в пятнадцати играх, обновлённых до последних версий на дату начала подготовки материала. Список тестовых приложений выглядит следующим образом (игры и далее результаты тестирования в них расположены в порядке их официального выхода):

3DMark (2013) (DirectX 9/11) – версия 2.0.2067, тестирование в сценах Cloud Gate, Fire Strike, Fire Strike Extreme и Fire Strike Ultra;

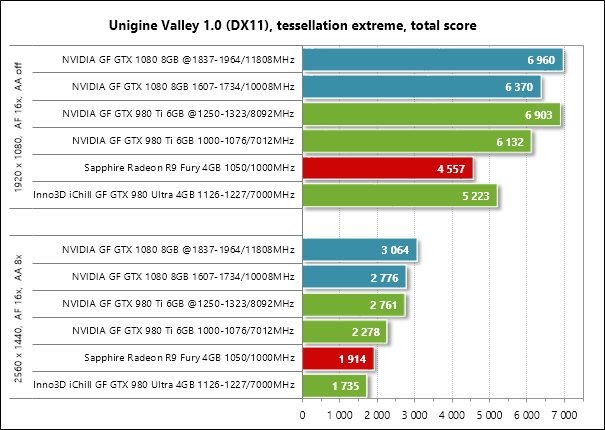

Unigine Valley Bench (DirectX 11) – версия 1.0, максимальные настройки качества, AF16x и (или) MSAA 8x, разрешение 1920 х 1080 и 2560 х 1440 пикселей;

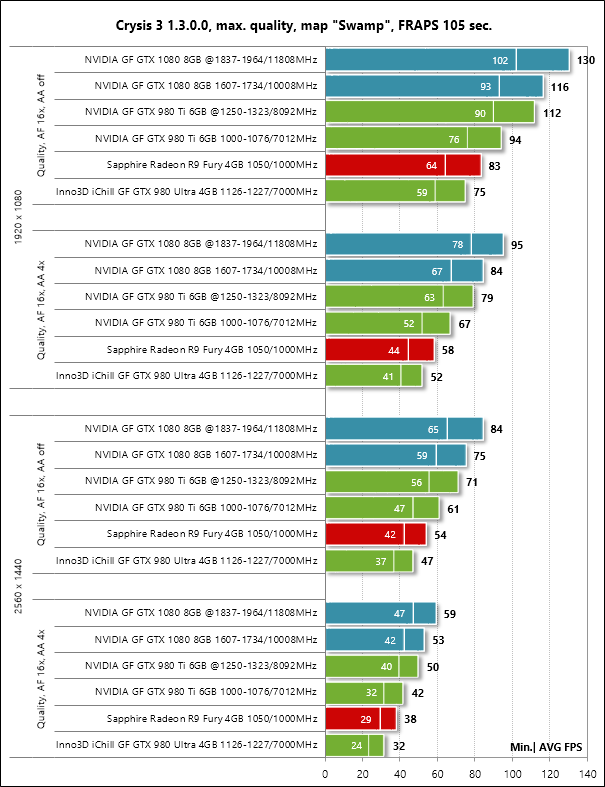

Crysis 3 (DirectX 11) – версия 1.3.0.0, все настройки качества графики на максимум, степень размытости средняя, блики включены, режимы с FXAA и с MSAA 4x, двойной последовательный проход заскриптованной сцены из начала миссии Swamp продолжительностью 105 секунд;

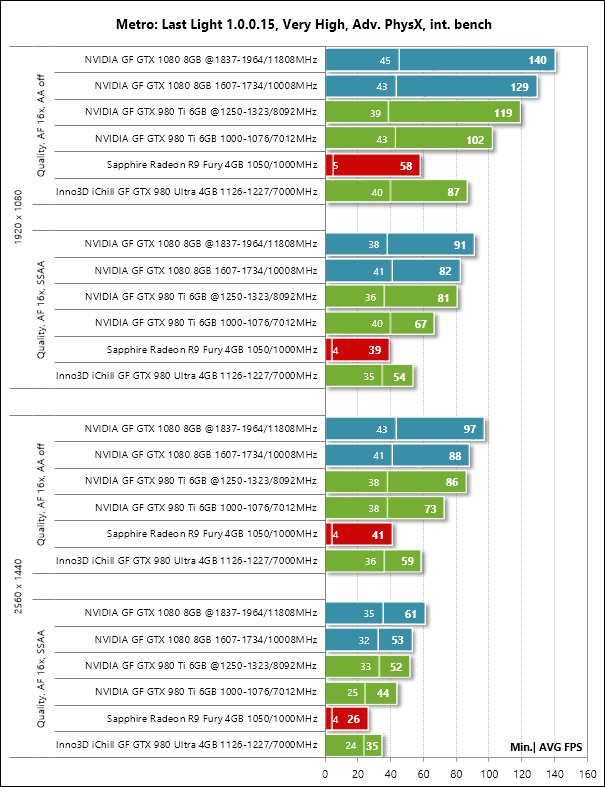

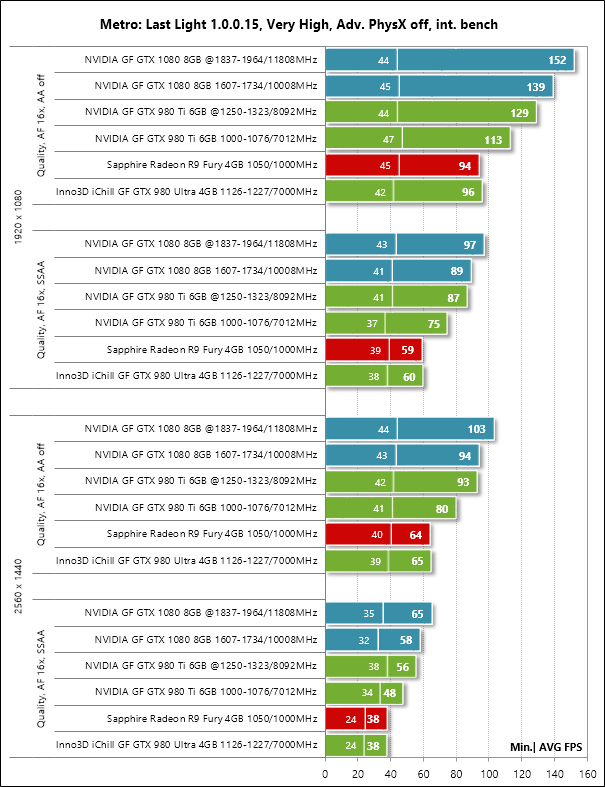

Metro: Last Light (DirectX 11) – версия 1.0.0.15, использовался встроенный в игру тест, настройки качества графики и тесселляция на уровне Very High, технология Advanced PhysX в двух режимах тестирования, тесты с SSAA и без сглаживания, двойной последовательный прогон сцены D6;

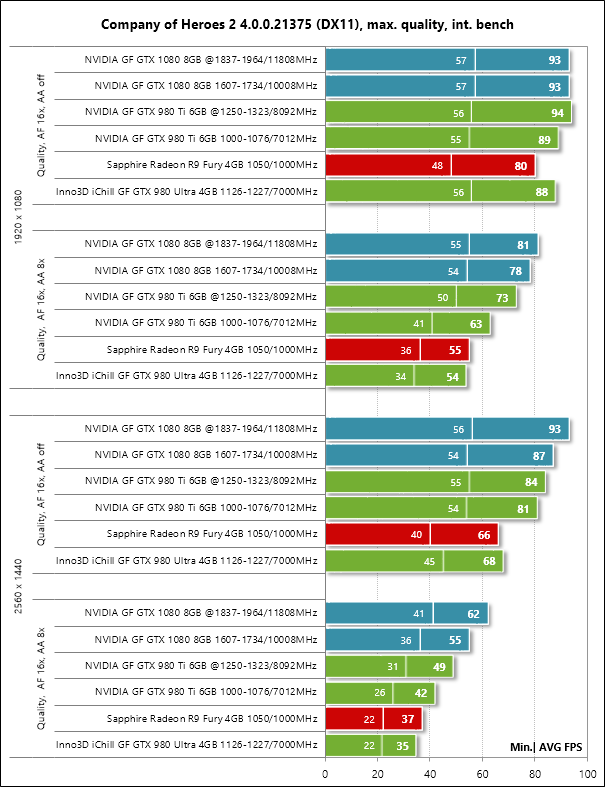

Company of Heroes 2 (DirectX 11) – версия 4.0.0.21375, двойной последовательный прогон встроенного в игру теста при максимальных настройках качества графики и физических эффектов;

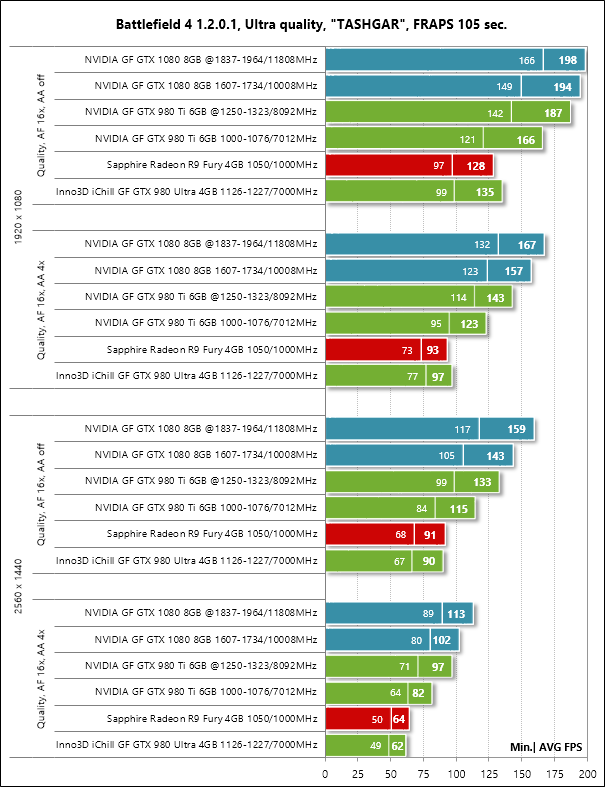

Battlefield 4 (DirectX 11) – версия 1.2.0.1, все настройки качества графики на Ultra, двойной последовательный прогон заскриптованной сцены из начала миссии TASHGAR продолжительностью 105 секунд (для видеокарт на GPU AMD использовался API Mantle);

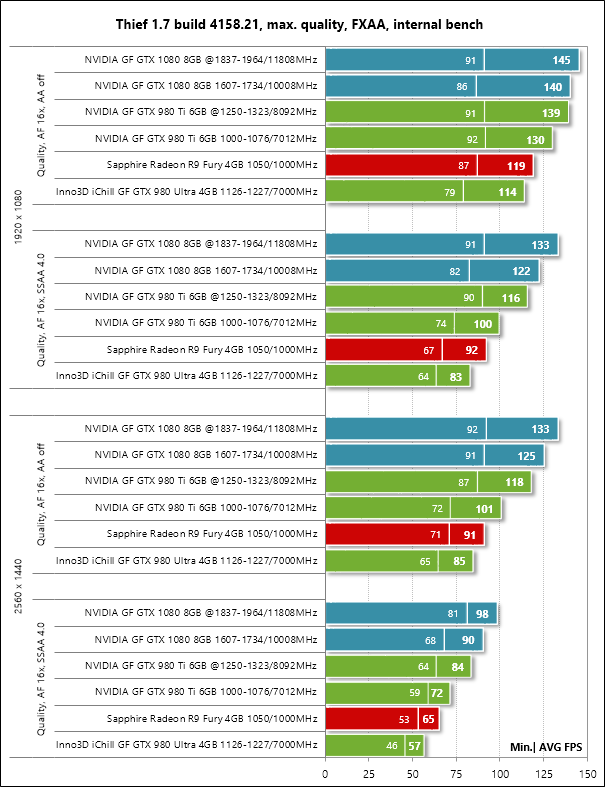

Thief (DirectX 11) – версия 1.7 build 4158.21, настройки качества графики на максимальный уровень, технологии Paralax Occlusion Mapping и Tessellation активированы, двойной последовательный прогон встроенного в игру бенчмарка (для видеокарт на GPU AMD использовался API Mantle);

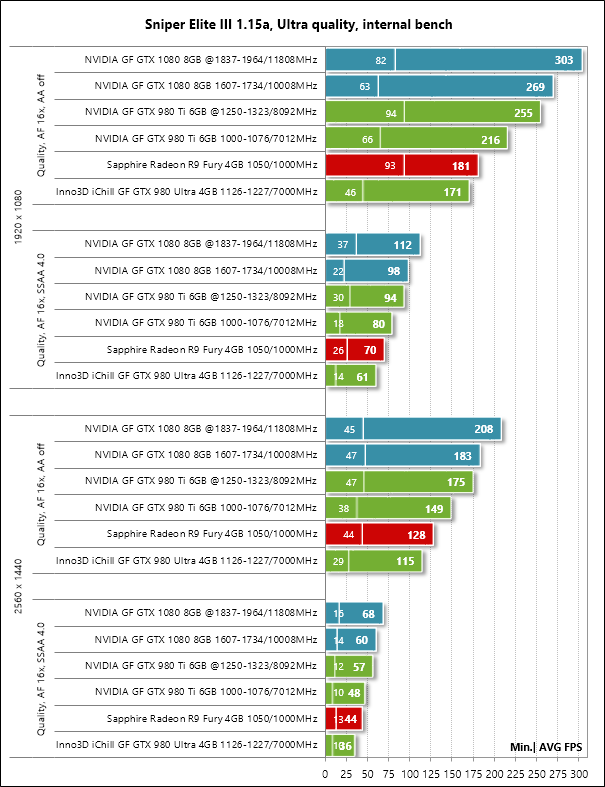

Sniper Elite III (DirectX 11) – версия 1.15a, настройки качества на уровне Ultra, V-Synс отключён, тесселяция и все эффекты активированы, тесты с SSAA 4x и без сглаживания, двойной последовательный прогон встроенного в игру бенчмарка (для видеокарт на GPU AMD использовался API Mantle);

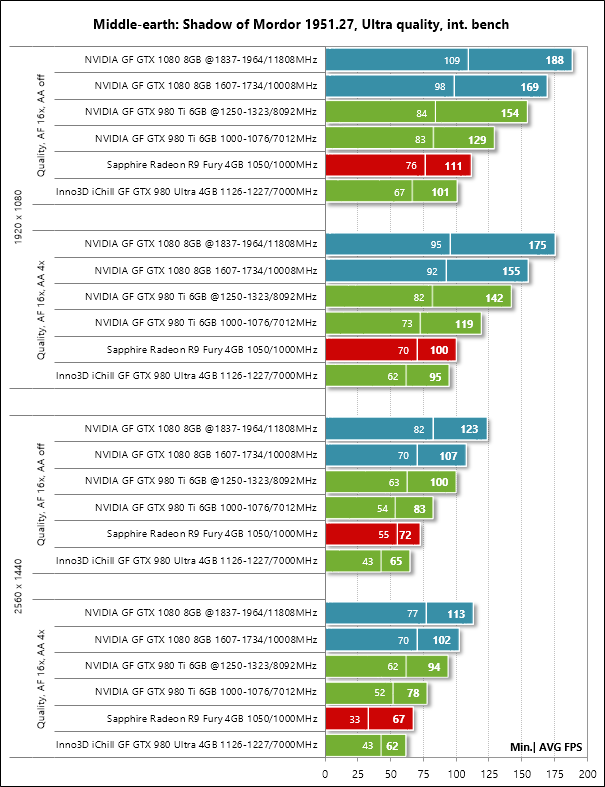

Middle-earth: Shadow of Mordor (DirectX 11) – build 1951.27, все настройки качества вручную выставлены на максимальный и Ultra-уровень, тесселляция и глубина резкости активированы, не менее двух последовательных прогонов встроенного в игру бенчмарка;

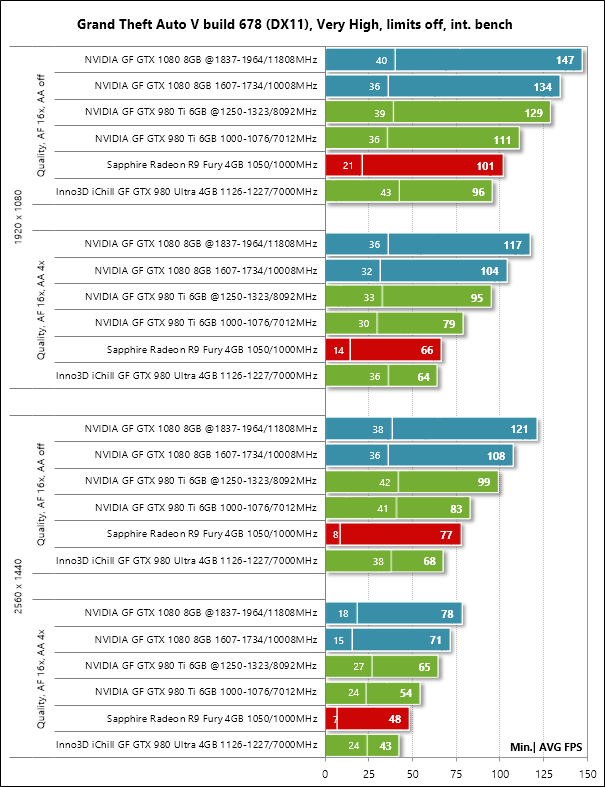

Grand Theft Auto V (DirectX 11) – build 678, настройки качества на уровне Very High, игнорирование предложенных ограничений включено, V-Synс отключена, FXAA активировано, NVIDIA TXAA выключено, MSAA для отражений выключено, мягкие тени NVIDIA/AMD;

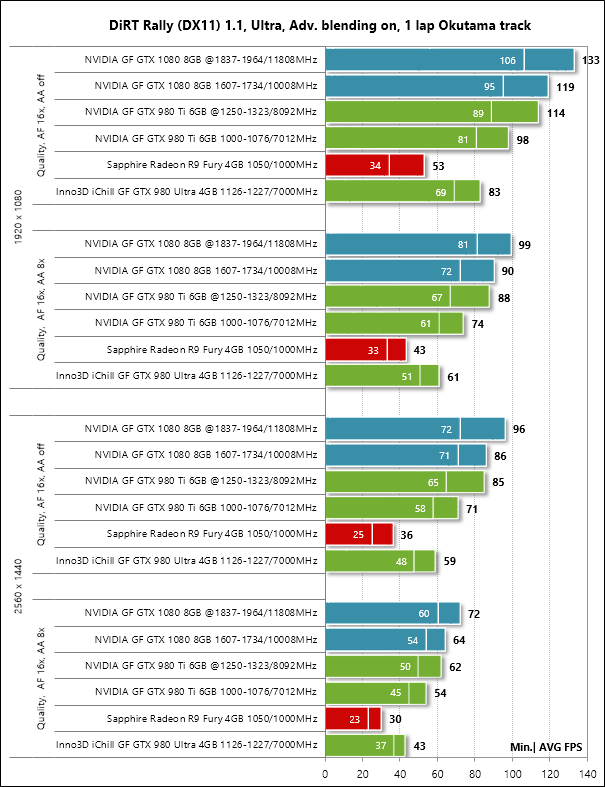

DiRT Rally (DirectX 11) – версия 1.1, использовался встроенный в игру тест на трассе Okutama, настройки качества графики на максимальный уровень по всем пунктам, Advanced Blending – On; тесты с MSAA 8x и без сглаживания;

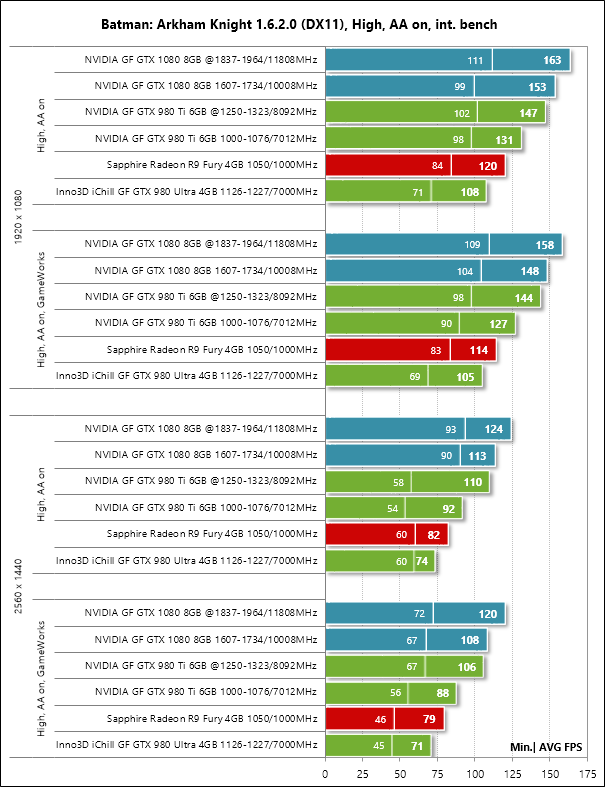

Batman: Arkham Knight (DirectX 11) – версия 1.6.2.0, настройки качества на уровне High, Texture Resolutioin normal, Anti-Аliasing on, V-Synс отключена, тесты в двух режимах – с активацией двух последних опций NVIDIA GameWorks и без них, двойной последовательный прогон встроенного в игру теста;

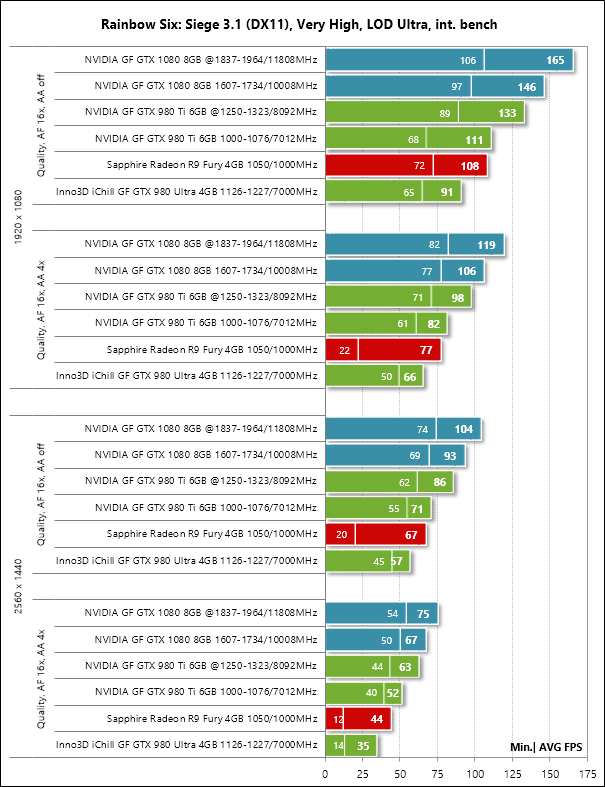

Tom Clancy's Rainbow Six: Siege (DirectX 11) – версия 3.1, настройки качества текстур на уровне Very High, Texture Filtering – Anisotropic 16x, и прочие максимальные настройки качества, тесты с MSAA 4x и без сглаживания, двойной последовательный прогон встроенного в игру теста.

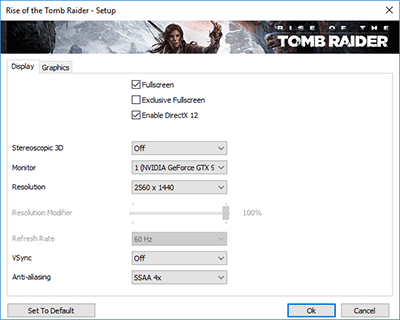

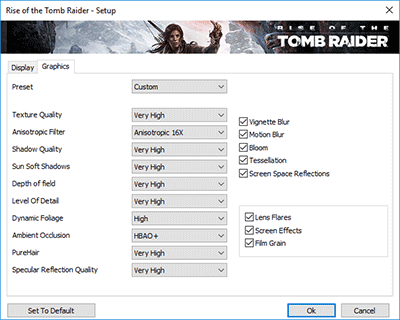

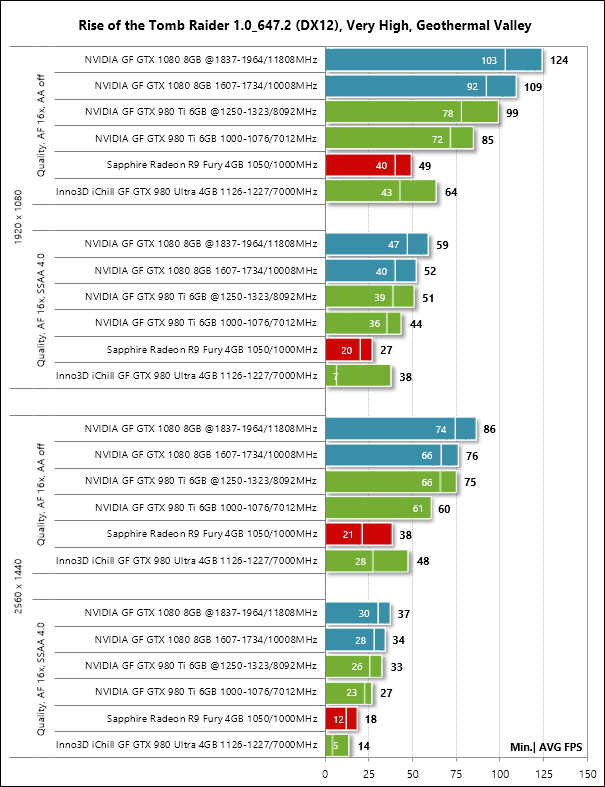

Rise of the Tomb Raider (DirectX 12) – версия 1.0 build 647.2_64, все параметры на уровень Very High, Dynamic Foliage – High, Ambient Occlusion – HBAO+, тесселляция и прочие методики улучшения качества активированы, по два цикла теста встроенного бенчмарка без сглаживания и с активацией SSAA 4.0;

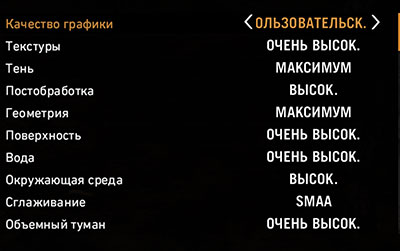

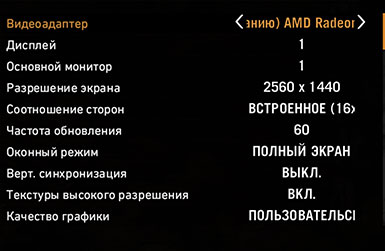

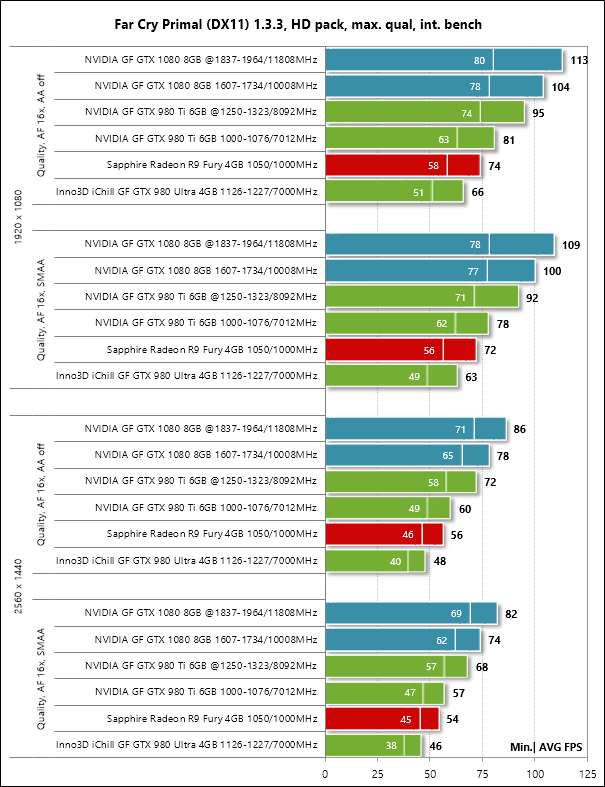

Far Cry Primal (DirectX 11) – версия 1.3.3, максимальный уровень качества, текстуры высокого разрешения, объёмный туман и тени на максимум, встроенный тест производительности без сглаживания и с активацией SMAA;

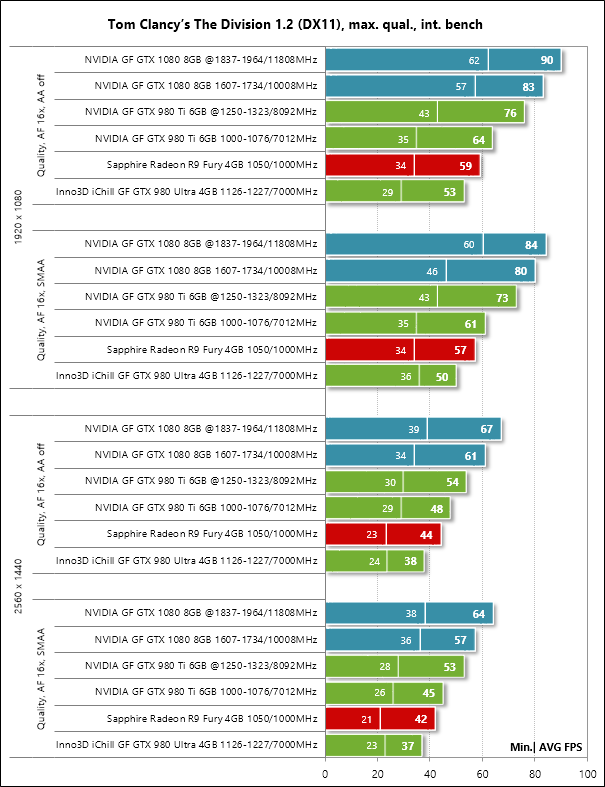

Tom Clancy’s The Division (DirectX 11) – версия 1.2, максимальный уровень качества, все параметры улучшения картинки активированы, Temporal AA – Supersampling, режимы тестирования без сглаживания и с активацией SMAA 1X Ultra, встроенный тест производительности но фиксация результатов FRAPS;

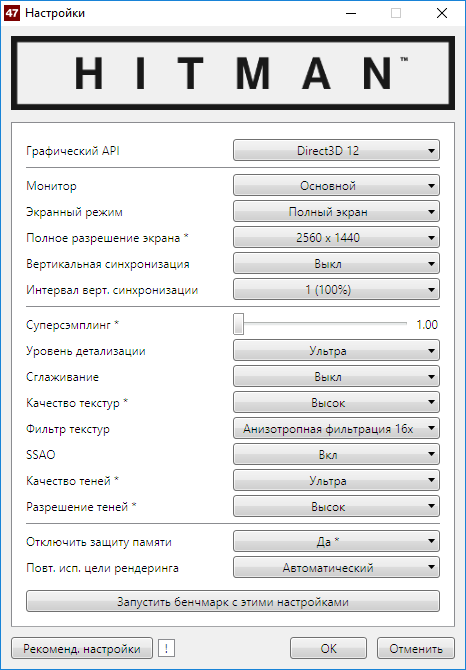

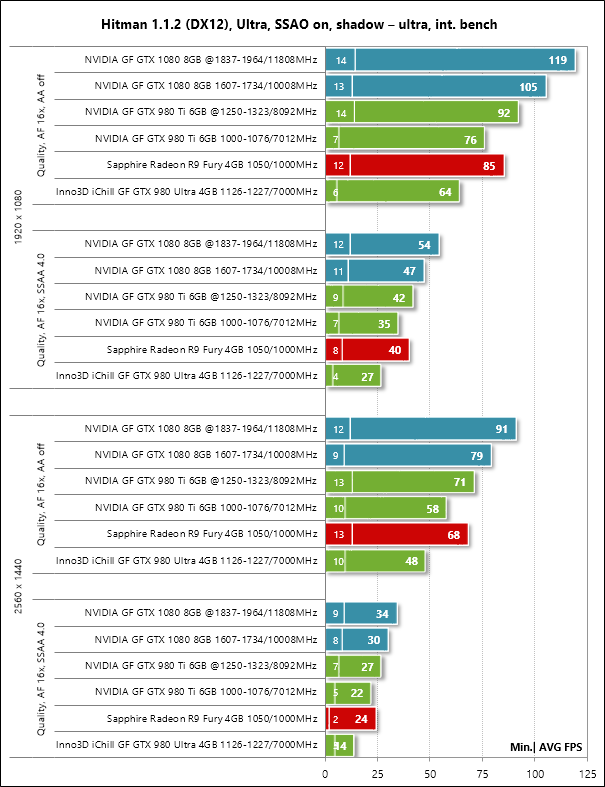

Hitman (DirectX 12) – версия 1.1.2, встроенный тест при настройках качества графики на уровне Ультра, SSAO включено, качество теней Ультра, защита памяти отключена.

Если в играх реализована возможность фиксации минимального числа кадров в секунду, то оно также отражалось на диаграммах. Каждый тест проводился дважды, за окончательный результат принималось лучшее из двух полученных значений, но только в случае, если разница между ними не превышала 1%. Если отклонения прогонов тестов превышали 1%, то тестирование повторялось ещё как минимум один раз, чтобы получить достоверный результат.

4. Результаты тестов производительности

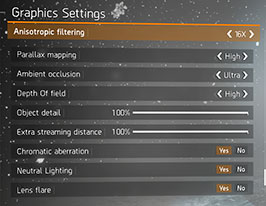

На диаграммах результаты тестирования видеокарт на графических процессорах NVIDIA выделены зелёной заливкой, а на графических процессорах AMD отражены привычной данному производителю красной гаммой. Для выделения показателей NVIDIA GeForce GTX 1080 в номинальном режиме работы и при разгоне мы выбрали тёмно-бирюзовый цвет. Добавим, что на диаграммах в каждом режиме качества результаты тестов отсортированы сверху-вниз в порядке убывания стоимости видеокарт.

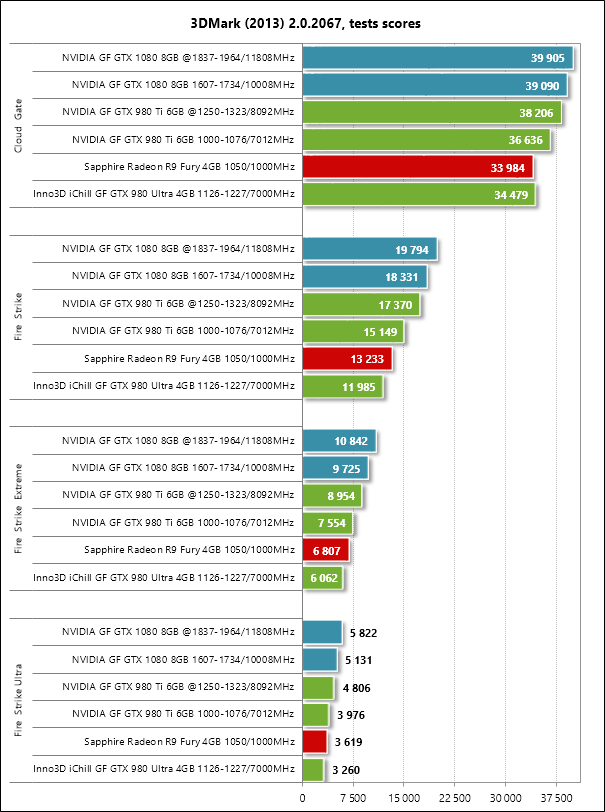

3DMark (2013)

В 3DMark новая NVIDIA GeForce GTX 1080 сумела продемонстрировать свою мощь даже в таком не ресурсоёмком тесте, как Cloud Gate, опередив в номинальном режиме работы всех остальных участников тестирования. Ну а в различных вариациях Fire Strike её преимущество только возрастает. Например, разница в производительности с Inno3D iChill GF GTX 980 Ultra на эталонных для данной модели видеокарты частотах достигает 64% плюсом, а NVIDIA GeForce GTX 980 Ti опережает на 32,5%, причём последняя не догоняет NVIDIA GeForce GTX 1080 даже при разгоне. SAPPHIRE NITRO Radeon R9 FURY способна бороться только с Inno3D iChill GF GTX 980 Ultra, и, учитывая, что разница в производительности между Radeon R9 Fury и Radeon R9 Fury X составляет 7-8%, то серьёзных изменений в расстановке сил включение Fury X в тесты не принесло бы. Весьма уверенный старт GeForce GTX 1080! Посмотрим, что будет дальше.

Unigine Valley Bench

Расстановка сил в бенчмарке Unigine Valley традиционно различается в зависимости от режима качества и разрешения.

Отметим, что в разрешении 1920 х 1080 пикселей без активации MSAA NVIDIA GeForce GTX 1080 едва удаётся опередить прежнего флагмана в лице NVIDIA GeForce GTX 980 Ti, а при разгоне этих видеокарт результаты практически одинаковы. Однако если повысить нагрузку, установив разрешение 2560 х 1440 пикселей и включить MSAA8x, то потенциал NVIDIA GeForce GTX 1080 раскрывается куда лучше, и здесь уже даже разогнанная NVIDIA GeForce GTX 980 Ti не достигает производительности номинальной GeForce GTX 1080. В свою очередь, преимущество нового флагмана над моделью, которую он собой заменяет – GeForce GTX 980 – в этом тесте составляет 37,5%, что также весьма недурно.

На очереди игровые тесты.

Crysis 3

Первые же тесты в уже старой, но по-прежнему ресурсоёмкой Crysis 3 продемонстрировали превосходство новой архитектуры NVIDIA Pascal над старой Maxwell.

NVIDIA GeForce GTX 1080 просто раздавила Inno3D iChill GF GTX 980 Ultra своей мощью, показав на 55-66% более высокие результаты. Это, на наш взгляд, безусловный успех. Не конкурент для новой GeForce GTX 1080 и эталонная GeForce GTX 980 Ti, да что там – и разогнанная до фактических 1450 МГц по ядру GTX 980 Ti не конкурент, что уж говорить про единственного представителя AMD в сегодняшнем тестировании? Отметим, что при разгоне NVIDIA GeForce GTX 1080 производительность в Crysis 3 возрастает на 11-13%, что также очень неплохо для видеокарты референсного дизайна.

Metro: Last Light

Порадовала производительность новинки и в игре Metro: Last Light, которую мы традиционно тестировали как при активации Advanced PhysX, так и без неё.

Очень уверенная победа над всеми сегодняшними оппонентами. Даже разогнанная NVIDIA GeForce GTX 980 Ti немного отстаёт от номинальной NVIDIA GeForce GTX 1080, а на заводских частотах её преимущество составляет от 18 до 27%. Если же говорить о сравнении с GeForce GTX 980, то картина вообще нелицеприятная для былого «топа» – он отстаёт на 45-53%. Кстати, SAPPHIRE NITRO Radeon R9 FURY держится в Metro: Last Light без Advanced PhysX молодцом, идя наравне с Inno3D iChill GF GTX 980 Ultra с приведёнными к номинальным для GeForce GTX 980 частотам. Правда, в среднем Radeon R9 Fury стоят сейчас дороже GeForce GTX 980.

Company of Heroes 2

По большому счёту, производительность нынешних флагманов в игре Company of Heroes 2 можно сравнить только в наиболее ресурсоёмком режиме (четвёртый блок результатов на диаграмме).

И в этом режиме качества NVIDIA GeForce GTX 1080 проявила себя отлично, опередив Inno3D iChill GF GTX 980 Ultra на 57%, обогнав NVIDIA GeForce GTX 980 Ti на 31% и не уступив ей же при разгоне. Повышение частот самой GeForce GTX в этой игре может принести плюсом ещё 13% производительности, что выводит новинку на недостижимый для других графических карт уровень.

Battlefield 4

Сегодня Battlefield 4 уже нельзя отнести к ресурсоёмким играм, но популярности ей по-прежнему не занимать. Поэтому пока мы оставим её в тестовом списке и проанализируем полученные результаты.

Здесь NVIDIA GeForce GTX 1080 быстрее Inno3D iChill GF GTX 980 Ultra на величину вплоть до 65%, также быстрее NVIDIA GeForce GTX 980 Ti на 17-28%, которая не достигает уровня производительности нового флагмана даже при разгоне. Кроме того, повышение частот GeForce GTX 1080 может принести ей дополнительные 11% производительности в наиболее ресурсоёмких режимах. Кстати, как раз в разрешении 2560 х 1440 пикселей с использованием сглаживания хорошо видна разница между Inno3D iChill GF GTX 980 Ultra, выдающей немногим более 60 кадров в секунду (что критично для данного типа игры) и новой NVIDIA GeForce GTX 1080 с её 102 FPS средними и 80 FPS минимальными. Ну а SAPPHIRE NITRO Radeon R9 FURY не помогает даже активация API Mantle в Battlefield 4, соперничать она может только с Inno3D iChill GF GTX 980 Ultra на номинальных частотах.

Thief

На очереди ещё одна не ресурсоёмкая игра.

Но и здесь NVIDIA GeForce GTX 1080 удаётся выступить весьма уверенно, превзойдя Inno3D iChill GF GTX 980 Ultra сразу на 58% в разрешении 2560 х 1440 пикселей со сглаживанием и опередив NVIDIA GeForce GTX 980 Ti на 25% в этом же режиме качества. Разгон последней существенно увеличивает её производительность, но до уровня эталонной GeForce GTX 1080 дотянуться всё равно не получается.

Sniper Elite III

Такую же картину мы можем наблюдать и в Sniper Elite III, с той лишь разницей, что SSAA 4.0 здесь сильно бьёт по производительности всех видеокарт, включая новую GeForce GTX 1080.

Middle-earth: Shadow of Mordor

Куда более уверенно чувствуют себя видеокарты в бенчмарке игры Middle-earth: Shadow of Mordor.

Хотя, в целом расстановка сил здесь такая же, как и в двух предыдущих играх.

Grand Theft Auto V

Не выделяются из общей тенденции и результаты тестирования видеокарт в игре Grand Theft Auto V.

DiRT Rally

Из особенностей теста DiRT Rally выделим максимальное приближение разогнанной NVIDIA GeForce GTX 980 Ti к номинальной NVIDIA GeForce GTX 1080. Очевидно, что владельцам былого флагмана и одновременно любителям таких симуляторов переходить на GeForce GTX 1080 бессмысленно. Результаты единственной видеокарты на графическом процессоре AMD «обрушены» параметром Advanced Blending, который архитектура «Фурий» не переваривает. Но и без него SAPPHIRE NITRO Radeon R9 FURY могла бы работать лишь на уровне номинальной Inno3D iChill GF GTX 980 Ultra, а значит конкурировать с NVIDIA GeForce GTX 980 Ti и, тем более, с NVIDIA GeForce GTX 1080 ей невозможно.

Batman: Arkham Knight

Расстановка сил в игре Batman: Arkham Knight во многом напоминает результаты в DiRT Rally, правда без провала Radeon R9 Fury.

Преимущество NVIDIA GeForce GTX 1080 над Inno3D iChill GF GTX 980 Ultra здесь достигает 53%, а у NVIDIA GeForce GTX 980 Ti новинка выигрывает до 23% в наиболее ресурсоёмких режимах качества.

Tom Clancy's Rainbow Six: Siege

Более существенна разница между видеокартами в игре Rainbow Six: Siege.

Но всё же общая картина не меняется.

Rise of the Tomb Raider

Поскольку в четырёх последних играх, начиная с Rise of the Tomb Raider, мы тестируем видеокарты впервые, то приведём их детальные настройки, при которых тестировались видеокарты.

Здесь интересны результаты тестирования при активации SSAA 4.0 в разрешении 2560 х 1440 пикселей, где недостаток памяти на видеокартах Inno3D iChill GF GTX 980 Ultra и SAPPHIRE NITRO Radeon R9 FURY делает их более чем вдвое медленными, нежели NVIDIA GeForce GTX 980 Ti и NVIDIA GeForce GTX 1080. Последняя, кстати, едва тянет игру при таких настройках, правда здесь стоит отметить, что для тестирования мы выбрали самую сложную в графическом плане сцену, а на других участках игры производительность видеокарт будет выше.

Far Cry Primal

Настройки качества графики в Far Cry Primal также были выставлена на максимально возможный уровень.

Тем не менее, здесь мы получили намного более приемлемый для комфортной игры FPS.

NVIDIA GeForce GTX 1080 опережает Inno3D iChill GF GTX 980 Ultra на 58-63%, а NVIDIA GeForce GTX 980 Ti – на 28-30%. Прирост производительности нового флагмана при разгоне составляет 9-11%.

Tom Clancy’s The Division

При максимально возможных настройках качества тестировалась и Tom Clancy’s The Division.

Однако, тестируя встроенный бенчмарк, мы заметили некорректность получаемых счётчиком кадров результатов, поэтому использовали FRAPS, позволяющий фиксировать не только средний, но и минимальный FPS.

Как видим, расстановка сил между видеокартами в этой игре классическая для сегодняшнего тестирования.

Hitman

Hitman является одной из наиболее ресурсоёмких современных игр, поэтому для тестирования видеокарт уровня NVIDIA GeForce GTX 1080 подходит как нельзя лучше. Эту игру мы тестировали также при максимальных настройках качества.

Из особенностей теста выделим уверенное выступление SAPPHIRE NITRO Radeon R9 FURY, которой удалось опередить даже номинальную NVIDIA GeForce GTX 980 Ti. В остальном всё также, как и в других тестах.

Дополним построенные диаграммы итоговой таблицей с результатами тестов с выведенными средним и минимальным значением числа кадров в секунду по каждой видеокарте…

…и переходим к сводным диаграммам.

5. Сводные диаграммы

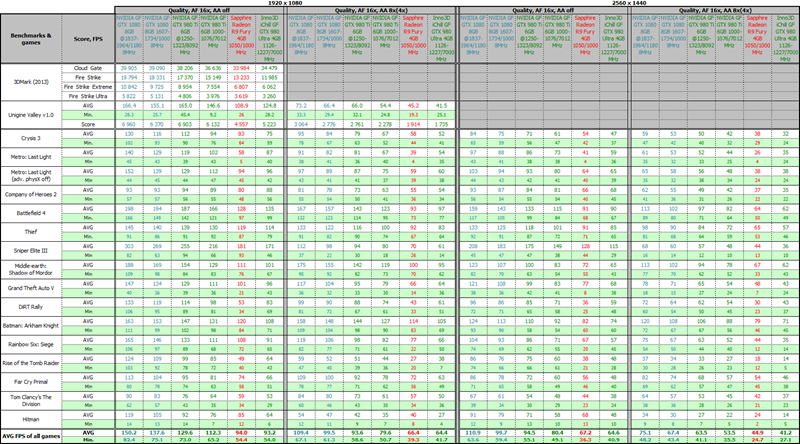

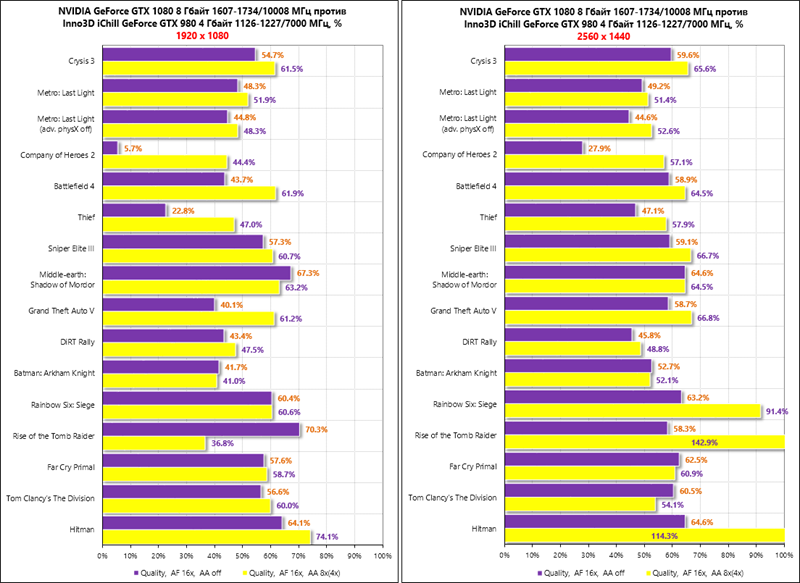

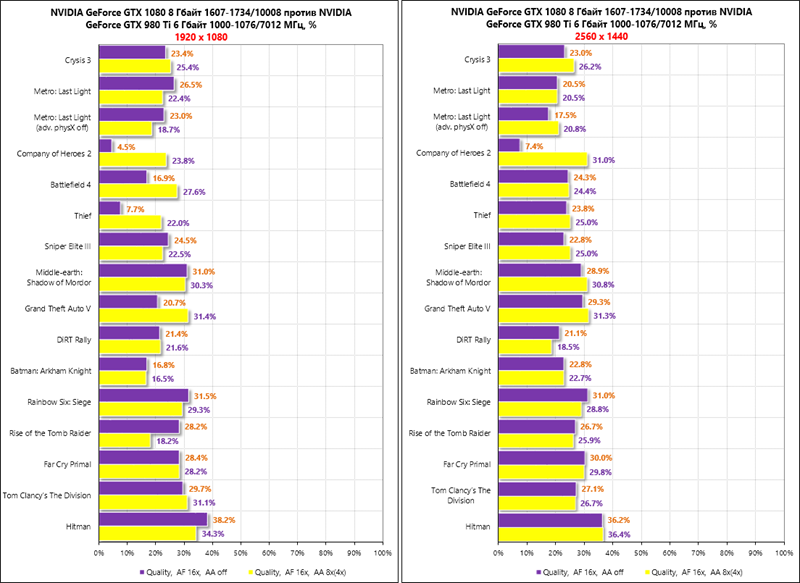

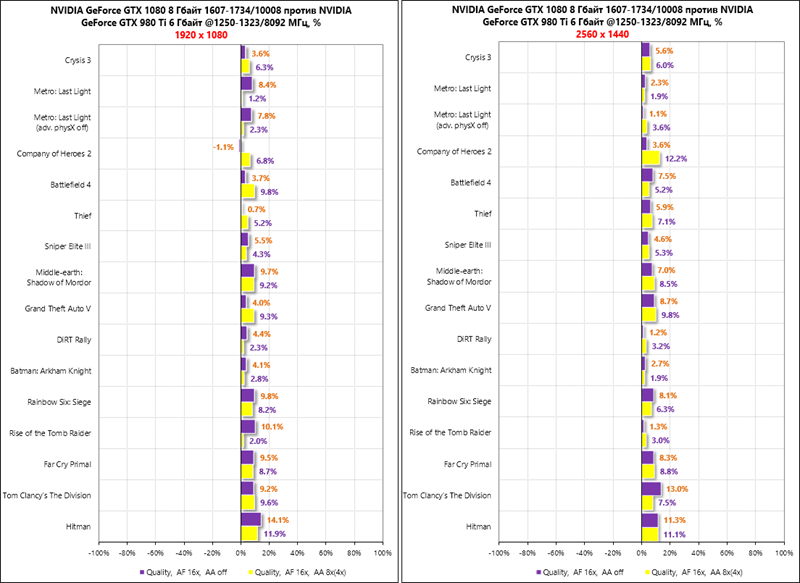

На первой паре сводных диаграмм мы оценим разницу между новой GeForce GTX 1080 и её предшественницей GeForce GTX 980, результаты которой в каждой игре приняты за начальную точку отсчёта, а средний FPS героини сегодняшнего тестирования отложен в процентах от них.

Налицо очень серьёзное преимущество первой видеокарты на новой архитектуре Pascal. В некоторых играх, где NVIDIA GeForce GTX 1080 имеет преимущество по объёму видеопамяти, разница в производительности может быть двукратной, а в среднем по всем игровым тестам новинка опережает заменяемую модель на 48,7-54,9% в разрешении 1920 х 1080 пикселей и на 54,8-69,5% в разрешении 2560 х 1440 пикселей. Превосходный результат! Остаётся только догадываться, какую производительность в (надеемся) недалёком будущем сможет продемонстрировать GeForce GTX 1080 Ti.

Теперь сравним производительность GeForce GTX 1080 с более грозным соперником – эталонной GeForce GTX 980 Ti на номинальных частотах обеих видеокарт.

И здесь уверенное преимущество практически во всех режимах и играх. Максимума оно достигает в наиболее ресурсоёмкой Hitman, а в среднем по всем играм выливается в 23,3-25,2% в разрешении 1920 х 1080 пикселей и в 24,5-26,5% в разрешении 2560 х 1440 пикселей.

Конечно же, многочисленные владельцы оригинальных GeForce GTX 980 Ti будут недовольны сравнением выше, ведь их видеокарты уже с завода разогнаны не менее чем на 10%, да ещё и дополнительно разгоняются. Поэтому на двух следующих сводных диаграммах мы сравним номинальную GeForce GTX 1080 с разогнанной GeForce GTX 980 Ti, частота ядра которой при разгоне увеличивалась до 1450 МГц.

Действительно, всем оверклокерам GeForce GTX 980 Ti не стоит переживать по поводу выхода GeForce GTX 1080, поскольку их разогнанные до 1,5 ГГц варианты видеокарт отстают от нового флагмана на штатных частотах совсем немного, а в некоторых играх даже опередят на пару-тройку процентов.

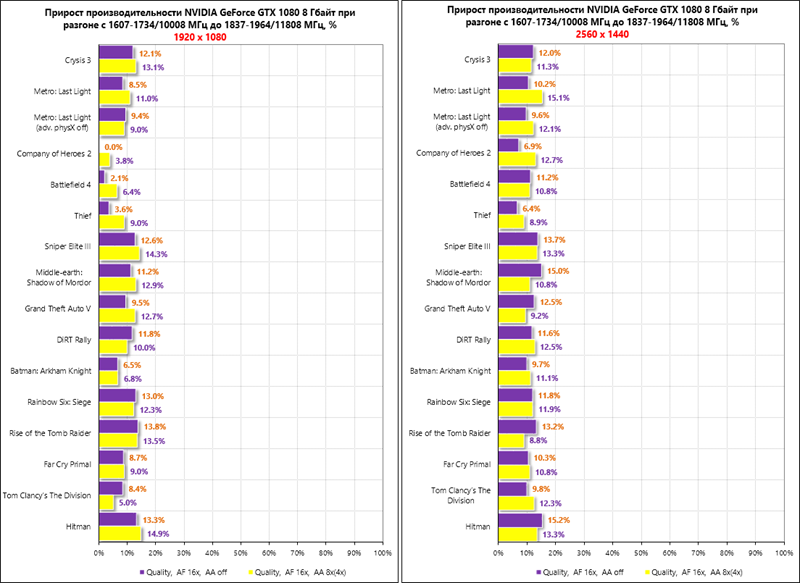

С другой стороны, NVIDIA GeForce GTX 1080 также неплохо разгоняется и способна заметно повысить свою производительность при повышении частот. На сколько именно повысить, мы ответим на двух следующих диаграммах. Напомним, что графический процессор NVIDIA GeForce GTX 1080 мы разогнали на 14,3%, а эффективную частоту видеопамяти GDDR5X смогли увеличить на 18%.

Даже столь сравнительно скромный разгон эталонного образца GeForce GTX 1080 принёс дополнительно 9-10,2% производительности в разрешении 1920 х 1080 пикселей и 11,2-11,6% в разрешении 2560 х 1440 пикселей. Очень неплохо для самого первого семпла, хотя и не столь впечатляюще, как при анонсе GeForce GTX 980 Ti с её 25-процентным разгоном ядра.

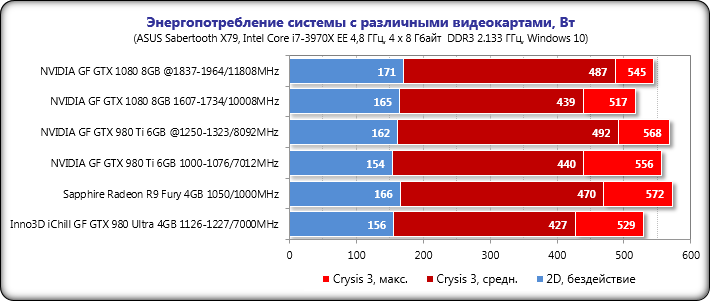

6. Энергопотребление

Измерение уровня энергопотребления проводилось с помощью блока питания Corsair AX1500i через интерфейс Corsair Link и программу мониторинга HWiNFO64 версии 5.25-2875 Beta. Измерялось энергопотребление всей системы в целом без учёта монитора. Измерение было проведено в 2D-режиме при обычной работе в Microsoft Word или интернет-сёрфинге, а также в 3D-режиме. В последнем случае нагрузка создавалась с помощью четырёх последовательных циклов вступительной сцены уровня Swamp из игры Crysis 3 в разрешении 2560 х 1440 пикселей при максимальных настройках качества графики и использованием MSAA 4Х. Добавим, что на диаграмме отражён как пиковый уровень энергопотребления в 3D-режиме, так и среднее значение потребления за весь цикл тестирования.

Сравним уровень энергопотребления систем с протестированными сегодня видеокартами по следующей диаграмме.

Как и в производительности, новая NVIDIA GeForce GTX 1080 выиграла у двух предшественниц по уровню энергопотребления, что, впрочем, не удивительно, учитывая переход на 16-нм нормы. Так, система с номинальной NVIDIA GeForce GTX 1080 является наиболее экономичной в сегодняшнем тестировании, выигрывая в пике нагрузки 12 ватт у конфигурации с Inno3D iChill GF GTX 980 Ultra, 39 ватт у NVIDIA GeForce GTX 980 Ti и 55 ватт у SAPPHIRE NITRO Radeon R9 FURY. Разгон GeForce GTX 1080 увеличивает уровень энергопотребления системы с ней на 28 ватт, что совершенно не критично. В 2D-режиме какой-то особой энергоэффективности новинки мы не увидели, хотя здесь в первую очередь влияет сама тестовая платформа. Подведём итоги.

Заключение

NVIDIA GeForce GTX 1080 – самая производительная однопроцессорная видеокарта на сегодняшний день на новом графическом процессоре GP104 архитектуры Pascal. Что будет после всеми ожидаемого выхода GeForce GTX 1080 Ti, пока точно никто не скажет, но сейчас GeForce GTX 1080 опережает заменяемую собой модель сразу на 50-70%, а в особо требовательных приложениях вдвое! Это, без оговорок, превосходный результат, ведь вышедшая полтора года назад NVIDIA GeForce GTX 980 оказалась быстрее заменяемой GeForce GTX 780 всего на 18-24%, так что в этот раз NVIDIA позволяет своим пользователям получить более существенную разницу при смене флагманской видеокарты. Правда, здесь стоит отметить, что аппетиты компании немного выросли, поскольку за GTX 1080 теперь просят от 599 долларов США, тогда как прежде рекомендованная стоимость GeForce GTX 980 была заявлена на отметке 549 долларов США. Впрочем, если сравнивать с GeForce GTX 780, стартовавшей три года назад с 649 долларов США, то GeForce GTX 1080 выглядит даже выгоднее.

Благодаря переходу на 16-нм техпроцесс, новой архитектуре Pascal, скоростному типу памяти GDDR5X с улучшенными алгоритмами сжатия и её увеличенному объёму, GeForce GTX 1080, превосходящая по скорости даже разогнанную GeForce GTX 980 Ti, укладывается в тепловой пакет 180 Ватт, а значит для системы с одной такой видеокартой не требуется очень мощный блок питания. Тем не менее, как показали наши тесты, для разгона видеокарты нужны не только эффективные оригинальные кулеры, но и усиленные по питанию печатные платы. Впрочем, армада анонсов оригинальный версий GeForce GTX 1080 не вызывает сомнений в скором появлении таких видеокарт. Ну, а нам остаётся только ждать оперативного ответа AMD в этом сегменте, и чем он быстрее произойдёт, тем скорее появится GeForce GTX 1080 Ti, вкупе со снижением цены на GeForce GTX 1080.

Благодарим компанию NVIDIA

и персонально Ирину Шеховцову

за предоставленную на тестирование видеокарту.

и персонально Ирину Шеховцову

за предоставленную на тестирование видеокарту.