Ваш город: Москва

Обзор и тестирование видеокарты NVIDIA GeForce RTX 2080: на пороге будущего 3D-графики

Предисловие

В середине сентября текущего года компания NVIDIA представила на суд публике свои новые графические процессоры на архитектуре Turing и видеокарты в лице GeForce RTX 2080 Ti и RTX 2080. Чуть позднее на рынке к ним примкнула GeForce RTX 2070, окончательно сформировав серию новых графических карт. Поскольку даже к тому времени у уже существовавшей линейки видеокарт NVIDIA (GeForce GTX 1080 Ti/1080/1070) конкурентов в своих классах не было, то ещё более производительным решениям компании приходится соревноваться только друг с другом и впечатлять любителей 3D-графики новыми технологиями. И, нужно признать, удивить действительно удалось, как, впрочем, и ценами.

В сегодняшней статье мы проведём знакомство с новой архитектурой Turing на примере видеокарты NVIDIA GeForce RTX 2080 Founders Edition, сравнив её с предшествующей моделью в лице оригинальной версии GeForce GTX 1080.

Архитектура NVIDIA Turing – немного теории

Ни для кого не секрет, что в последние годы производительность процессоров в типовых домашних задачах и играх топчется на месте. Заметные приросты производительности от каждого нового поколения остались в прошлом. Даже дебют ставших в последствии очень популярными AMD Ryzen не смог что-то качественно изменить в этом вопросе. В отличие от центральных процессоров, производительность видеокарт, которая подчиняется другим законам развития, не стояла на месте и уверенно росла с каждым новым поколением. И при этом всё чаще производительность нового поколения GPU ограничивалась центральным процессором. Поэтому не удивительно, что при тестировании видеокарт наметилась тенденция ухода во всё более высокие разрешения экрана и тяжёлые режимы сглаживания. Только так – уже почти искусственным образом – приходится раскрывать достоинства нового поколения видеокарт и минимизировать риск того, что их производительность будет ограничена центральным процессором.

При этом в статистике Steam видно, что более половины пользователей (~60%) пользуются мониторами с разрешением 1920 × 1080 пикселей, а пользователей с мониторами, разрешение которых составляет 2560 × 1440 пикселей и выше, – всего около 5%. Таким образом, рядовой пользователь, любитель компьютерных игр, оказывается зажат с двух сторон. С одной стороны производительность ограничена процессором, с другой – разрешением монитора. Всё это делает покупку более производительных и дорогих видеокарт бессмысленной для основной массы игроков. Выход из этой ситуации, это классический переход количества в качество. Но что можно придумать, когда всё чаще качество картинки на мониторе обусловлено не производительностью видеокарты, а изобретательностью программистов, которым необходимо описать алгоритмами различные явления мира и уметь их грамотно сочетать и применять? Со всеми этими вызовами и должны справиться видеокарты NVIDIA нового поколения, обладающие новой архитектурой с кодовым названием Turing.

Turing = Volta + RT?

С момента появления видеокарт NVIDIA GeForce GTX 1080 прошло уже почти 2,5 года. Довольно большой срок для индустрии. Однако в этом промежутке времени была представлена новая графическая архитектура – Volta, которая значительно отличается от предшественников – Maxwell и Pascal. Для большинства пользователей этот анонс прошёл незаметно, потому что данная архитектура была представлена только одним чипом – GV100, нацеленным на применение в качестве ускорителя вычислений. Чуть позже были представлены видеокарты семейства Quadro и Titan, использующих этот чип, но и там стоимость решений, начинающаяся от $2999 за Titan V, отпугнула даже весьма обеспеченных энтузиастов. Поэтому с данной видеокартой и архитектурой любители компьютерных игр могли познакомиться в основном только посредством обзоров в сети Интернет.

Turing, в свою очередь, выглядит как развитие, а точнее даже ответвление от Volta. В нём нет такого же числа FP64 исполнительных устройств, но добавлены новые специфические исполнительные устройства и сохранённые тензорные ядра. Обо всём этом мы расскажем подробнее.

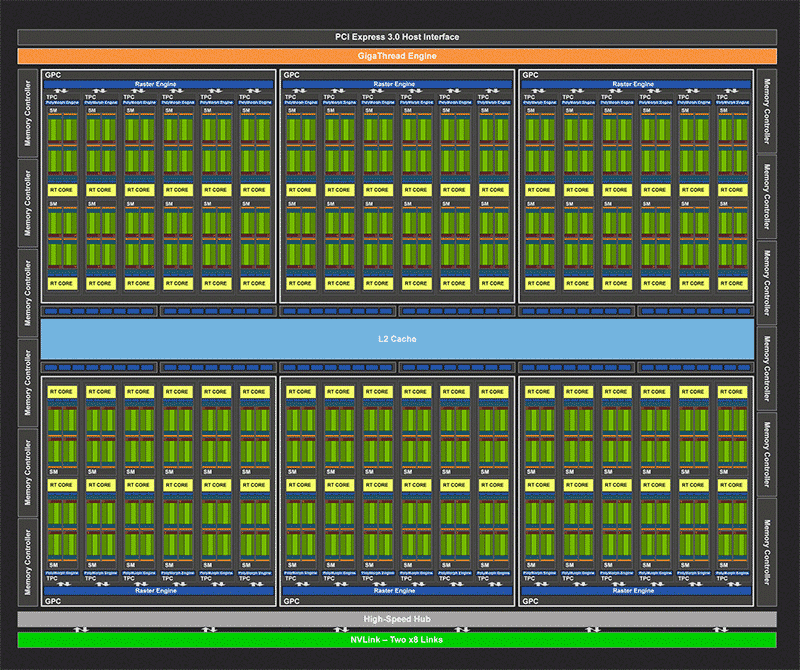

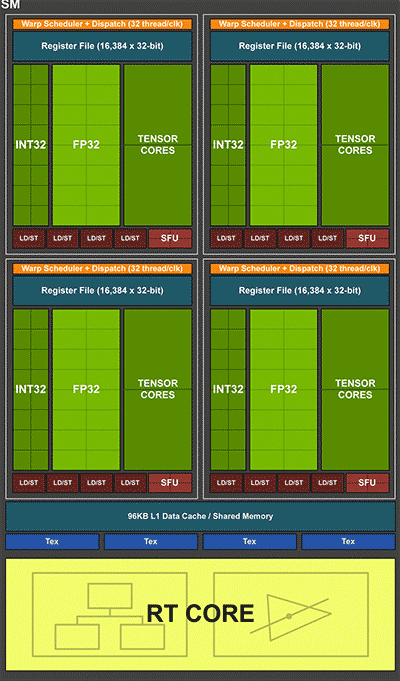

Глобально архитектура Turing похожа на предшественников. Чип состоит из Graphics Processing Cluster (GPC), которые разбиты на Texture Processing Cluster (TPC), а базовой единицей по-прежнему является мультипроцессор SM. И вот именно он претерпел множество изменений:

сохранилась тенденция к уменьшению числа FP32 устройств: в Kepler их было 192 штуки, в Maxwell и Pascal их число сократилось до 128 штук, а Volta и Turing предлагают по 64 штуки. Таким образом, повышается как эффективность работы исполнительных устройств, так и число TPC в чипе, при сопоставимом числе блоков FP32;

важные изменения произошли и на самом базовом уровне. Начиная с G80 (архитектура Tesla), базовой единицей было так называемое ядро CUDA, способное исполнять как операции с плавающей точкой, так и целочисленные. Но только одну операцию в каждый момент времени целочисленная (Int) или с плавающей точкой (FP). Volta и Turing отказываются от унитарного ядра CUDA в пользу отдельных массивов исполнительных устройств для целочисленных вычислений и вычислений с плавающей точкой. Это позволяет одновременно исполнять данные операции параллельно, что по оценке NVIDIA может дать прирост производительности около 35%;

увеличены размеры и производительность кэшей;

также Volta и Turing получили специализированные исполнительные устройства, называемые тензорными ядрами, по 8 штук на один SM. Они предназначены для ускорения производительности набирающих популярность нейронных сетей;

наконец, главная отличительная особенность и гордость архитектуры Turing – блоки RT, позволяющие многократно ускорить работу алгоритмов трассировки лучей. Это ключевое изменение в архитектуре Turing, настолько важное и глобальное, с точки зрения NVIDIA, что компания даже переименовала линейку видеокарт из GTX в RTX.

RayTracing

Итак, очевидно, что много усилий NVIDIA приложила не только ради традиционного роста производительности, но и ради создания задела для качественно новых возможностей, которыми не обладали видеокарты предыдущих поколений. Подобных вех, качественно меняющих 3D-графику, в истории развития видеокарт было не так много. Первым таким изменением, которое упоминает сама NVIDIA, стало появление блока Transform and lighting (T&L) в GeForce 256, что позволило перенести работу по расчёту освещения с центрального процессора на графический. Собственно, именно этот блок и позволил назвать GeForce 256 графическим процессором, а не просто 3D-ускорителем. Следующей вехой стало появление поддержки шейдеров у видеокарт GeForce 3. Дальнейшее развитие этой технологии качественно изменило возможности разработчиков игр в части создания различных эффектов. Современные игры уже просто не могут обходиться без шейдеров. Ещё стоит отметить появление поддержки расчётов на GPU, которая появилась в 2006 году с выходом G80 и первой версии CUDA. Современные игры также взяли на вооружение данную возможность и перекладывают на GPU часть вычислительной нагрузки.

И вот, наконец, мы добрались до дня сегодняшнего. NVIDIA внедрила в архитектуру Turing специальные блоки, позволяющие радикально поднять производительность алгоритмов расчёта освещения методом трассировки лучей до того уровня, чтобы они могли производиться в реальном времени. Веха? Безусловно, и вот почему.

Традиционно, графика в играх развивалась путём добавления алгоритмов, имитирующих явление реального мира. T&L, шейдеры, расчёты…, всё это было подчинено одной цели – приблизить качество картинки к уровню, который мы видим в реальной жизни, достижению фотореализма. Нельзя сказать, что всё это было напрасно, разница в качестве картинки, выдаваемой современными играми и играми 20 летней давности налицо. Но, у многих пользователей сложилось ощущение, что 3D-графика достигла некого порога в качестве, преодолеть который невозможно. Отчасти это действительно так. NVIDIA считает, что ключ к повышению качества и реалистичности изображения, это освещение. Сегодня все эффекты, наблюдаемые в сцене, создаются фактически вручную. Освещение, отражение, рассеивание. Это трудоёмкий процесс, требующий сочетания множества различных алгоритмов, каждый из которых не совершенен сам по себе. Разработчики должны подумать обо всех наблюдаемых игроком эффектах, а затем написать алгоритмы, которые будут отвечать за них. Очевидно, что достичь идеала таким образом, не представляется возможным. Ведь мир состоит из множества различных эффектов, как очевидных, так и неочевидных. Программист априори не может описать все их достоверно и детально. А человеческий мозг способен отличить реальную картинку от той, что выдают игры, опираясь именно на мелочи и детали.

В противовес традиционным технологиям рендеринга изображения в играх, в киноиндустрии и профессиональном применении используется другой способ расчёта освещения – трассировка лучей. Этот способ известен и применяется давно во множестве сфер деятельности, где необходимо получить максимально реалистичное изображение. Суть его заключается в просчёте траектории всех лучей света в сцене. Это позволяет естественным образом формировать все необходимые эффекты – тени, блики, отражения, рассеивание. Программисту не надо писать алгоритм для каждого эффекта, не надо размещать поддельные источники света в сцену, чтобы добиться её реалистичности. Достаточно просто использовать трассировку лучей.

Возникает резонный вопрос: если всё так просто, то почему данный метод не используют в играх? Ответ: недостаточная производительность для расчёта в реальном времени. Трассировка лучей – очень ресурсоёмкий алгоритм, где расчёт одного кадра может занимать десятки секунд, а в играх напротив, требуется получать десятки (если не сотню) кадров в секунду. NVIDIA проделала большую работу, чтобы трассировка лучей стала доступна и в играх. И мы говорим не только о разработке и продвижении видеокарт семейства Turing. Вместе с этим была проведена и масштабная подготовительная работа. Microsoft представила API DirectX Raytracing, позволяющий использовать трассировку лучей в играх, а NVIDIA помогла разработчикам внедрить поддержку этой технологии в игры, которые выходят уже в этом году. Поэтому не понадобится ждать несколько лет, чтобы оценить все достоинства данной, безусловно, перспективной технологии.

К слову, представленный Microsoft API для трассировки лучей позволяет производить трассировку лучей и на существующих видеокартах, с помощью традиционных исполнительных устройств. Блоки RT в Turing позволяют аппаратно ускорить эти вычисления в разы, для достижения производительности, достаточной для проведения этих вычислений в режиме реального времени. Для оценки производительности NVIDIA вводит новые единицы измерений производительности: миллиарды лучей в секунду (GRay/s).

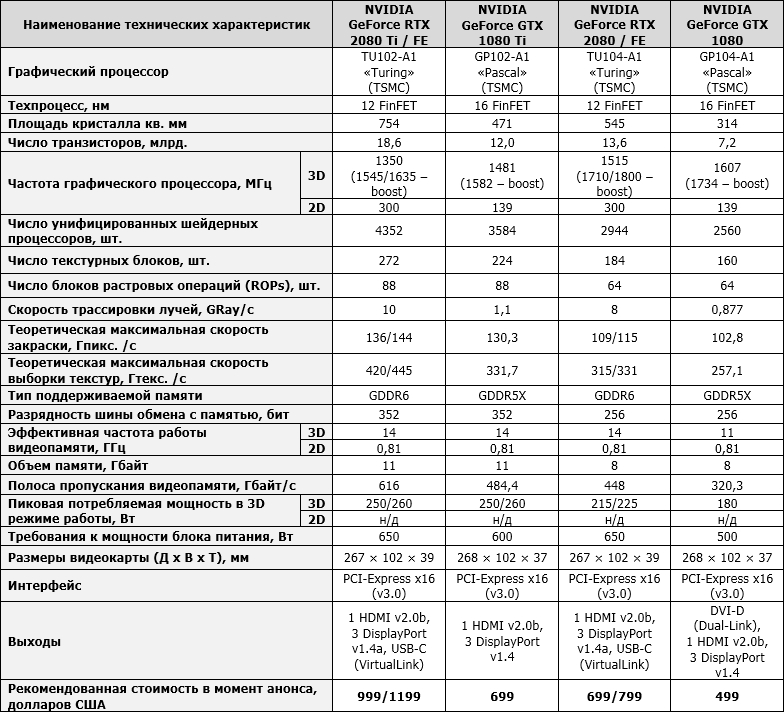

Насколько эффективны блоки RT? Для сравнения, GeForce RTX 2080 Ti обладает производительностью 10 GRay/s. А производительность GeForce GTX 1080 Ti без этих блоков составляет всего 1,1 GRay/s. Разница в 9 с лишним раз. Но в реальности обещается разница в производительности примерно в 5-6 раз. А это уже качественная разница. Таким образом посмотреть и оценить красоту новых алгоритмов расчёта освещения смогут и обладатели текущего поколения видеокарт. А вот играть с комфортом, только обладатели GeForce RTX.

Правда, стоит оговориться, что даже в таком виде производительности современных видеокарт не хватит для полноценной трассировки лучей в реальном времени. Поэтому в данный момент будет применяться гибридный рендеринг, где традиционные технологии и алгоритмы будут дополняться трассировкой лучей. А со временем, если данная технология будет принята рынком и игроками, всё больше будет делаться ставка на неё и всё меньше – на традиционные методы. Для игроков это будет означать повышение качества и реалистичности изображения, а для разработчиков – сокращение затрат на разработку множества алгоритмов, добавляющих картинке реалистичности. Все их заменит трассировка лучей.

Прочие изменения

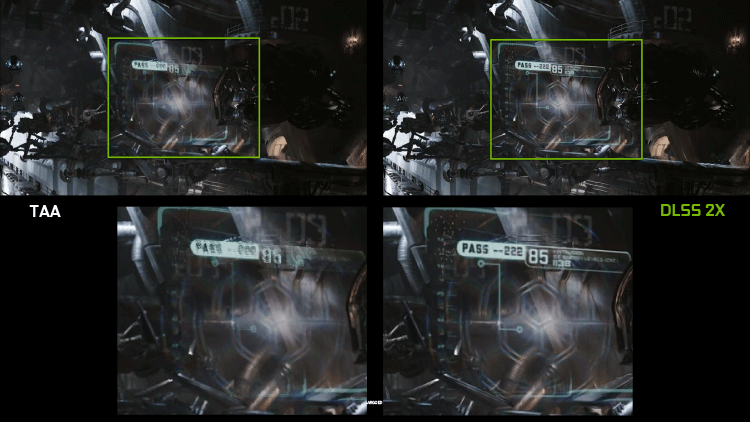

Теперь, когда стало понятно, почему NVIDIA добавила в Turing блоки ускорения лучей, необходимо разобраться, зачем в игровой видеокарте тензорные ядра, которые нужны для ускорения работы нейросетей. Их предполагается использовать для повышения качества изображения и снижения нагрузки на основные исполнительные устройства. NVIDIA называет данную технологию Deep-Learning SuperSampling (DLSS), или сглаживание с помощью нейросетей. Игры с поддержкой данной технологии могут повышать качество изображения, аналогично тому, как это делали бы традиционные методы сглаживания, вот только работу здесь будут выполнять не привычные ROP, а новые тензорные ядра, с помощью которых и будет производиться улучшение качества изображения, аналогичное сглаживанию. Это позволит практически бесплатно получать ещё более качественное изображение, что актуально для любителей дорогих видеокарт и мониторов с высоким разрешением.

Ещё одним интересным нововведением Turing является поддержка Mesh Shaders. Это новый способ работы с геометрией сцены, который заменяет собой вершинные шейдеры и тесселяцию. Важным преимуществом этой технологии является снижение нагрузки на центральный процессор и возможность управлять геометрией более гибко.

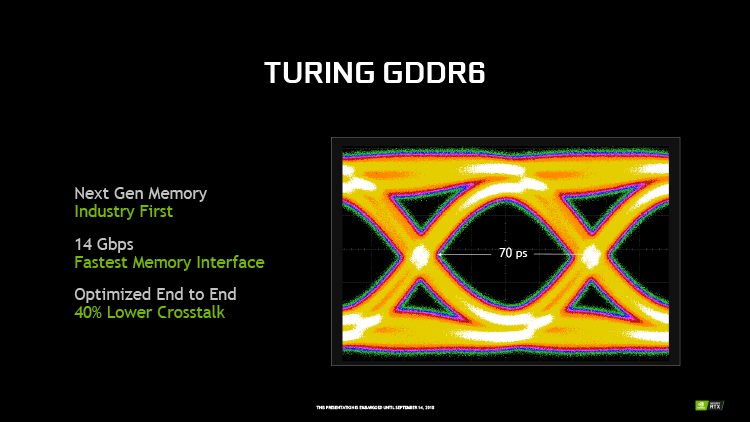

Видеокарты семейства Turing поддерживают работу с памятью GDDR6, которая обладает более высокими частотами работы, чем GDDR5X. Представленные на данный момент видеокарты семейства GeForce RTX укомплектованы памятью с эффективной частотой 14 ГГц.

В совокупности с возросшей частотой памяти, это позволяет новинкам иметь более высокую эффективную пропускную способность памяти, которая составляет 448 Гбайт/с для RTX 2080/2070 при 256-битной ширине шины и впечатляющие 616 Гбайт/с для флагманской RTX 2080 Ti при 352-битной ширине шины обмена. Не забыты и новые алгоритмы компрессии видеопамяти, эффективность которых оценивается на величину до 50% выше, чем у видеокарт предыдущего поколения.

Что касается работы нескольких видеокарт в связке, то и здесь есть несколько интересных изменений. Во-первых, классический SLI фактически мёртв. Идея с двойным мостом высокой пропускной способности, дебютировавшая на GeForce GTX 1080, не получила развития и популяризации. Теперь для объединения видеокарт используется фирменная шина NVLink второго поколения, с высокой пропускной способностью. Её пропускная способность даже не в разы, а в десятки раз выше, чем у классического SLI. Если один стандартный мост предлагал канал связи между видеокартами с производительностью около 1 ГБ в секунду, а представленный в Pascal около 2,5 ГБ в секунду, то один порт NVLink обеспечивает пропускную способность 50 ГБ в секунду, что в 20 раз больше! А старшая видеокарта – GeForce RTX 2080 Ti, обладающая двумя каналами NVLink, – 100 ГБ в секунду. Это намного больше, чем обеспечивает шина PCI Express и сопоставимо с пропускной способностью видеопамяти. Данная возможность используется в видеокартах профессиональной серии – Quadro, позволяя им объединять видеопамять нескольких ускорителей. К сожалению, возможность объединения видеопамяти недоступна видеокартам серии GeForce, но в любом случае, высочайшая пропускная способность NVLink позволяет использовать новые режимы совместной работы нескольких GPU, которые появились в DX12 и обеспечивать эффективное масштабирование производительности для будущих высоких разрешений – 5К и 8К.

Во-вторых, теперь возможность использования нескольких видеокарт стала привилегией только старших чипов и карт семейства. Видеокарты GeForce RTX 2070 и ниже не имеют разъёма NVLink и, следовательно, возможности работы в SLI. Определённая логика в этом есть. Использовать связку из нескольких видеокарт имеет смысл только когда производительности одной недостаточно, а более производительных моделей нет. Наконец, связки из 3 и 4 видеокарт, для которых уже были введены некоторые ограничения в предыдущем поколении, окончательно канули в лету. Видеокарты Turing поддерживают SLI только для двух видеокарт.

Ещё одним, но не последним, интересным новшеством новинок можно назвать появление разъёма USB-C (3.1 Gen2), который обеспечивает четыре линии Display Port, линию USB и подачу питания до 35 Вт. Такое сочетание возможностей нацелено на шлемы виртуальной реальности будущих поколений VirtualLink. Впрочем, ничто не мешает использовать этот порт по прямому назначению, для подключения монитора или USB устройств.

Проведём итог по теоретической части. Архитектура Turing демонстрирует, что NVIDIA не сбавляет оборотов в развитии. Более того, это одновременное «наступление» по нескольким фронтам и попытка заинтересовать разные категории пользователей. Приросты производительности обеспечиваются архитектурными изменениями и некоторым ростом количества исполнительных устройств. Энтузиастов заинтересуют возросшие производительность и возможности, которые открывает NVLink для построения бескомпромиссных игровых ПК, рассчитанных на игры с высокими разрешениями. Возможность ускорения алгоритма трассировки лучей обещает качественное повышение качества изображения, что может подтолкнуть к смене видеокарты даже тех пользователей, которых устраивает производительность имеющегося решения. Даже для «ждунов» сидящих на старых платформах подготовлен сюрприз в виде порта USB-C, который хоть и предназначен для подключения шлемов виртуальной реальности, но может быть использован и как обычный USB порт.

Создан и стратегический задел, также по разным направлениям. Обозначен вектор развития графики в играх с переходом к использованию алгоритма трассировки лучей, который позволит применить возрастающую производительность будущих поколений видеокарт даже в самых распространённых разрешениях мониторов. Дан старт использованию нейронных сетей и машинного обучения в играх, с целью улучшения качества изображения. Внедрены mesh shaders, позволяющие разгрузить центральный процессор.

Однако есть у этой медали и обратная сторона – сложность. 12-нм техпоцесс, по которому выпускаются Turing, это разновидность 16-нм техпроцесса, по которому, как вы помните, выпускались решения Pascal. Следовательно, какого-то заметного увеличения плотности не произошло и все достижения должны быть «оплачены» из транзисторного бюджета, который, увы, не бесконечен. Чипы семейства Turing получились беспрецедентно большими для своих позиций. Так младший, TU106, имеет площадь 445 мм2, что в 2,5 раза больше, чем у GP106 (200 мм2 – GeForce GTX 1060), в 1,5 раза больше, чем у GP104 (314 мм2 – GeForce GTX 1080) и почти сопоставимо с GP102 (471 мм2 – GeForce GTX 1080 Ti/Titan XP). Средний, TU104 – 545 мм2, сопоставим с самыми большими чипами в истории NVIDIA и даже превосходит их (G80 – 484 мм2, GT200 – 576 мм2, GF100 – 529 мм2, GK110 – 561 мм2, GM200 – 601 мм2). Старший чип текущей линейки, TU102 – 754 мм2, на сегодня является самым большим чипом NVIDIA, представленным в линейке GeForce, уступая только GV100 (Titan V). Также надо помнить, что производство каждого квадратного миллиметра площади по новым техпроцессам стоит дороже, чем по старым. Всё это, в совокупности со вполне закономерным стремлением NVIDIA заработать, привело к тому, что цены на новинки способны удивить даже матёрых энтузиастов, привыкших покупать старшие видеокарты в линейке. Стоят ли новые видеокарты и технологии той цены, что за них просят? Это мы и выясним в практической части.

Обзор видеокарты NVIDIA GeForce RTX 2080 Founders Edition 8 Гбайт

Технические характеристики и рекомендованная стоимость

Технические характеристики и стоимость видеокарты NVIDIA GeForce RTX 2080 приведены в таблице в сравнении с эталонными версиями NVIDIA GeForce RTX 2080 Ti, GeForce GTX 1080 Ti и GeForce GTX 1080.

упаковка и комплектация

Официальная версия NVIDIA GeForce RTX 2080 Founders Edition поставляется в компактной, но очень прочной коробке, выполненной из плотного картона. Оформлена упаковка в фирменной цветовой гамме NVIDIA и выглядит довольно привлекательно.

Информации на самой коробке практически нет, не считая название модели видеокарты и компании-производителя. Впрочем, на основании коробки всё же можно найти минимальные системные требования и ссылку на гарантийные обязательства, а также серийный номер и штрих-коды.

Внутри картонной коробки размещена дополнительная оболочка из плотного, но в то же время податливого при нажатии материала, надёжно защищающего видеокарту от повреждений.

В отдельной плоской коробочке находится переходник DisplayPort –> DVI и инструкция по установке видеокарты и драйверов.

Видеокарта выпускается в Китае и обеспечивается фирменной трёхлетней гарантией. Отметим, что далеко не все оригинальные модели компаний-партнёров NVIDIA обеспечиваются таким же гарантийным сроком, который позволит без проблем доиграть на NVIDIA GeForce RTX 2080 Founders Edition до следующего поколения видеокарт. Добавим, что рекомендованная стоимость данной модели на российском рынке составляет 63 990 рублей.

Дизайн и особенности печатной платы

В своих новых эталонных моделях NVIDIA кардинально поменяла дизайн системы охлаждения и видеокарты в целом. Теперь вместо прямоточных радиальных вентиляторов, прогоняющих воздушный поток через радиатор, используется кулер с двумя осевыми вентиляторами, нагнетающими воздух в огромный радиатор. Название модели видеокарты приведено в центре кожуха и на обратной стороне защитной пластины.

Сразу хотелось бы отметить идеальное качество сборки и подгонки всех деталей. Нет, поймите нас правильно, – референсные GeForce GTX 1080(Ti) никогда не страдали в плане качества, но теперь в новых GeForce RTX 2080(Ti) технологический процесс сборки выведен на новый уровень.

Каждый компонент этого дорогого «бруска» выполнен либо из тактильно приятного пластика или алюминия, и безупречно подогнан друг к другу. К сожалению, на фото этого не передать. Размеры видеокарты составляют 267 × 102 × 39 мм, а весит она более килограмма.

На обратной стороне видеокарты в зоне видеовыходов приклеены стикеры со штрих-кодом и серийным номером.

Последний, разумеется, уникален для каждого семпла видеокарты.

Сверху видеокарты можно найти два разъёма питания: шести- и восьмиконтактный.

Заявленный в спецификациях уровень энергопотребления версии Founders Edition составляет 225 ватт, а обычные GeForce RTX 2080 должны потреблять не более 215 ватт. Мощность рекомендованного блока питания для системы с одной такой видеокартой должна составлять не менее 650 ватт.

Обращает на себя внимание и новый разъём скоростного интерфейса NVLink 2.0 для объединения пары видеокарт в SLI-режим.

Ещё раз напомним, что больше двух GeForce RTX 2080(Ti) теперь объединять нельзя, а RTX 2070 и вовсе не поддерживает работу в SLI-связке.

Из видеовыходов исчез DVI. Вместо него пользователям предлагают один HDMI версии 2.0b и три Display Port версии 1.4а.

Кроме того, появился USB 3.1 Gen2, который можно использовать как по прямому назначению, так и для подключения устройств виртуальной реальности. Отметим перфорацию панели видеовыходов, хотя новая конструкция системы охлаждения в этом аспекте уже не так требовательна, как прежняя.

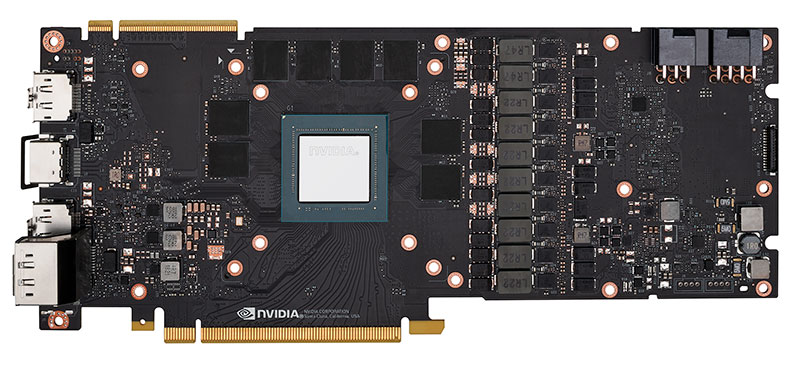

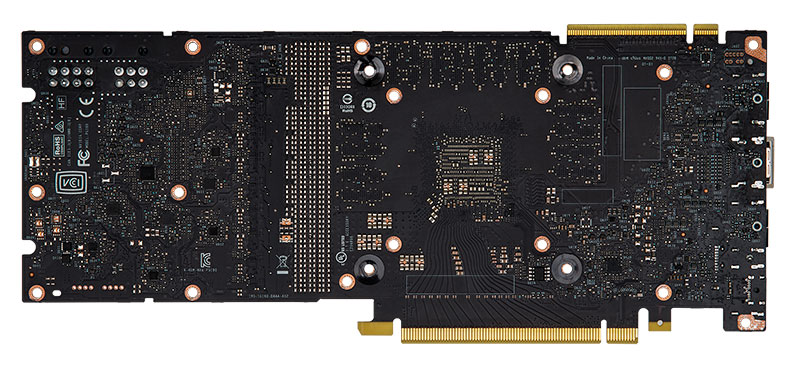

Переходим к плате и сразу же скажем, что далее будем использовать фото с официального сайта NVIDIA, поскольку разбирать видеокарту нам не рекомендовали. Быть может, в следующих материалах мы ещё вернёмся к этому моменту, а пока посмотрим на довольно качественные фото печатной платы NVIDIA GeForce RTX 2080 Founders Edition.

Несмотря на тот факт, что на сайте NVIDIA указано применение в GeForce RTX 2080 Founders Edition двенадцатифазной системы питания, мы насчитали только десять фаз, из которых непосредственно на графический процессор отведено восемь фаз и ещё две – на видеопамять и силовые цепи. Фазы состоят из сборок iMON DrMOS и управляются контроллером uPI uP9512.

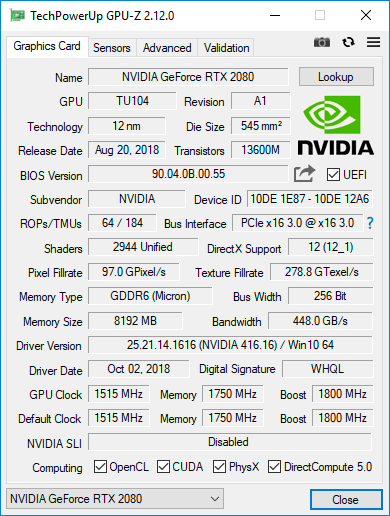

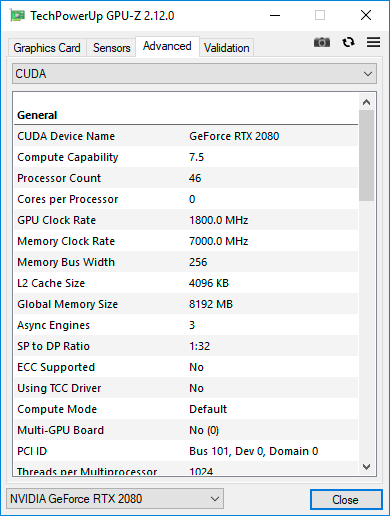

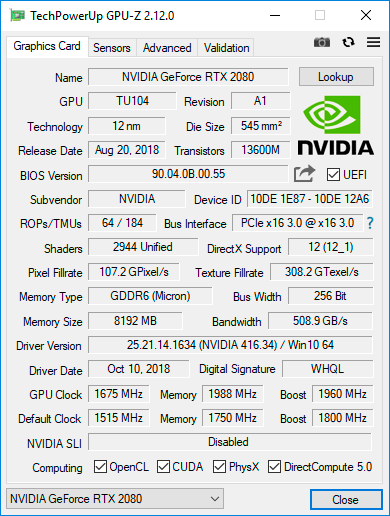

GeForce RTX 2080 базируются на графическом процессоре TU104 архитектуры Turing, выпущенном по нормам 12-нм FinFET-техпроцесса. Площадь кристалла составляет 545 мм2, а примерное число транзисторов равно 13,6 млрд. Базовая частота GPU в 3D-режиме заявлена на отметке 1515 МГц, а в форсированном может повышаться до 1800 МГц. При этом по данным мониторинга частота GPU нашего экземпляра видеокарты кратковременно повышалась до 1965 МГц, а затем стабилизировалась на 1875 МГц и ниже в 3D уже не опускалась. При переходе в 2D-режим частота графического процессора снижается до 300 МГц одновременно со снижением напряжения с 1,043 В до 0,706 В, которое может отличаться на каждой видеокарте.

NVIDIA GeForce RTX 2080 Founders Edition оснащается восемью гигабайтами памяти типа GDDR6, которые на видеокарте набраны микросхемами производства Micron с теоретической эффективной частотой 14 ГГц. При ширине шины обмена 256 бит такая память способна обеспечить рекордную для такой шины пропускную способность до 448,3 Гбайт/с. Добавим, что в 2D-режиме частота памяти снижается до 810 МГц, как и на видеокартах GeForce GTX 1080.

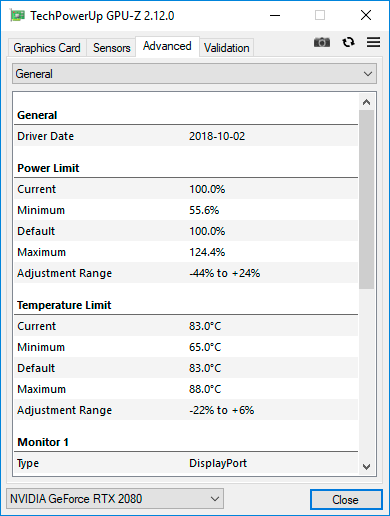

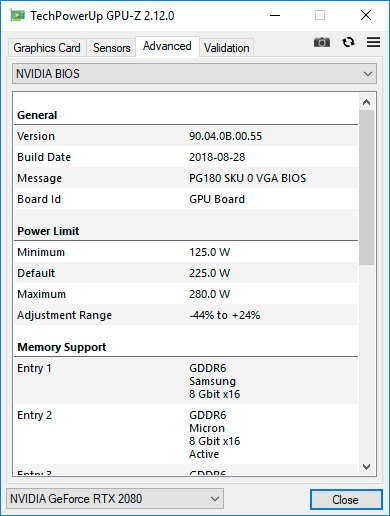

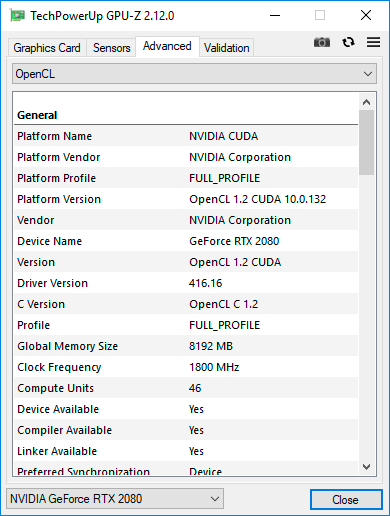

Характеристики NVIDIA GeForce RTX 2080 Founders Edition мы приведём с помощью утилиты GPU-Z.

Судя по данным BIOS видеокарты (версия 90.04.0B.00.55 от 28 августа 2018 года), максимальный лимит по питанию у эталонной версии составляет 280 ватт, а предельная температура графического процессора – 88 градусов Цельсия.

система охлаждения

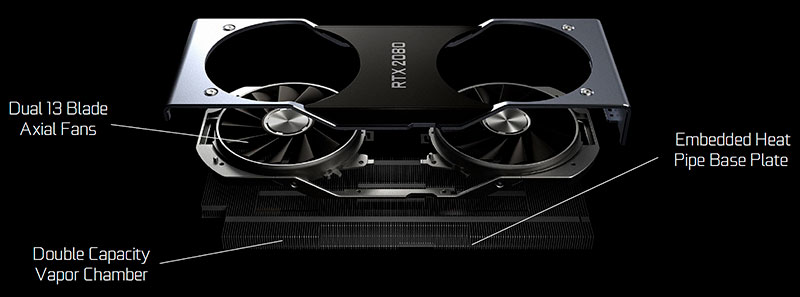

Эталонные версии NVIDIA GeForce RTX 2080 Ti и GeForce RTX 2080 оснащаются совершенно новой системой воздушного охлаждения. Причём, если раньше такие видеокарты не приобретали в том числе и потому, что референсные кулеры были шумными и справлялись со своей задачей довольно посредственно, то теперь партнёрам NVIDIA придётся постараться, чтобы в рамках двухслотового дизайна создать нечто столь же эффективное и не шумное.

Кулер состоит из огромного алюминиевого радиатора, металлической рамки с вентиляторами и накрывающего радиатор кожуха.

В основании радиатора встроена испарительная камера большой площади, а межрёберное расстояние едва превышает 1 мм.

В итоге получился, пожалуй, рекордный радиатор по площади рассеивания, и при этом разработчикам данной системы охлаждения удалось не выйти за рамки двух слотов.

Охлаждают всю конструкцию две тринадцатилопастных крыльчатки вентиляторов диаметром 85 мм.

Воздушный поток от них выбрасывается вверх и вниз видеокарты и, в малой степени, через перфорацию в панели видеовыходов. Скорость вращения вентиляторов регулируется адаптивной широтно-импульсной модуляцией и по данным мониторинга может изменяться в диапазоне от 1490 до 3730 об/мин, но даже при самой серьёзной нагрузке до верхней границы вентиляторы не раскручиваются, в чём мы сейчас и убедимся.

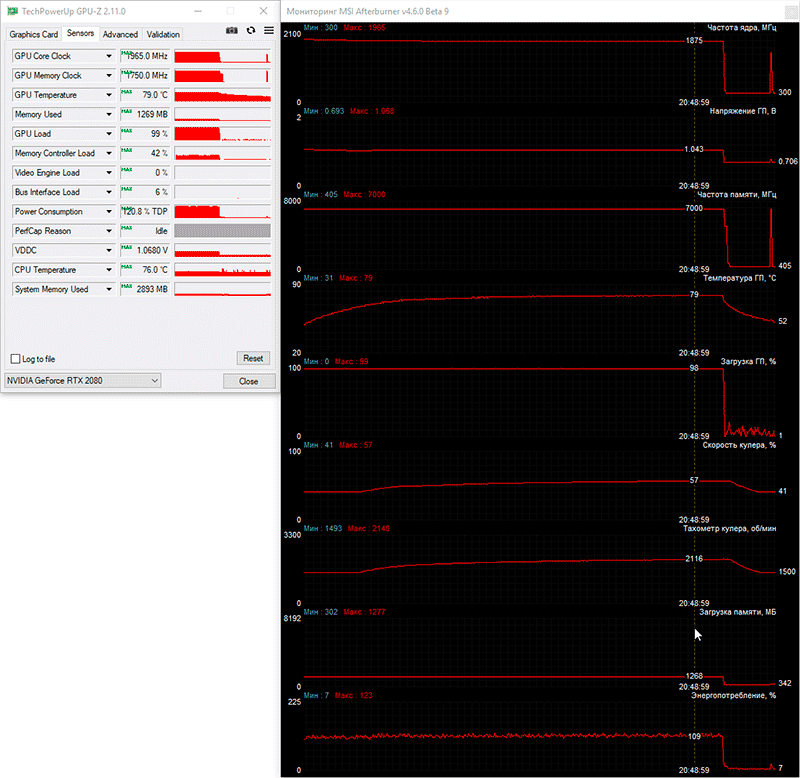

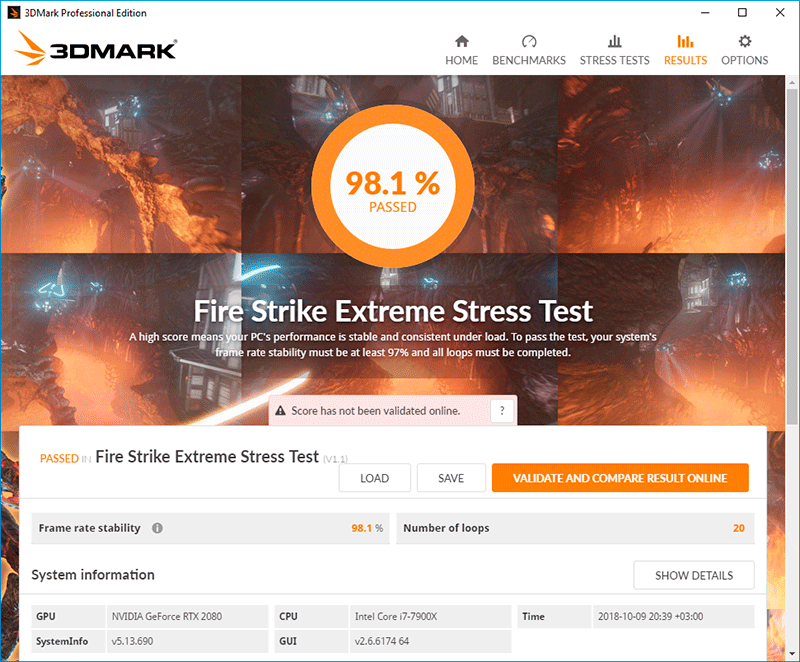

Для проверки температурного режима работы видеокарты в качестве нагрузки мы использовали девятнадцать циклов стресс-теста Fire Strike Extreme из графического пакета 3DMark.

Для мониторинга температур и всех прочих параметров применялась программа MSI Afterburner версии 4.6.0 beta 9 и утилита GPU-Z версии 2.11.0 и новее. Тесты проводились в закрытом корпусе системного блока, конфигурацию которого вы сможете увидеть в следующем разделе статьи, при комнатной температуре около 25 градусов Цельсия.

Посмотрим, как новый кулер NVIDIA GeForce RTX 2080 Founders Edition охлаждает видеокарту в автоматическом режиме работы вентиляторов.

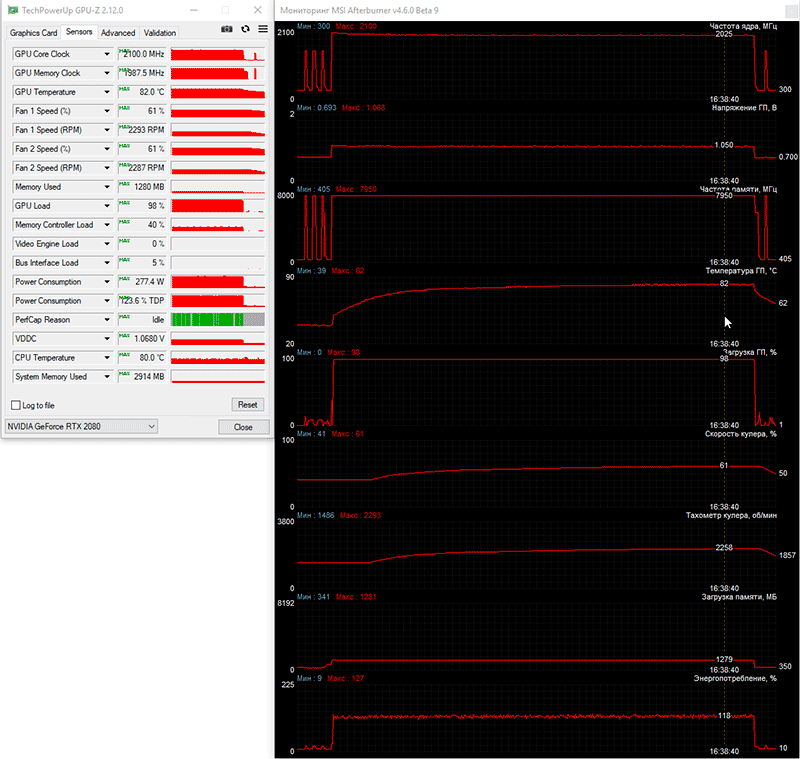

Ну что же, можно сказать, что всё очень здорово для эталонной видеокарты! Температура графического процессора достигла отметки 79 градусов Цельсия и выше не поднималась, а его частота стабилизировалась на 1875 МГц. Но самое главное, что скорость вращения вентиляторов увеличилась только на 650 оборотов, что не вывело GeForce RTX 2080 Founders Edition из режима комфорта по уровню шума. В 2D видеокарту не слышно вообще.

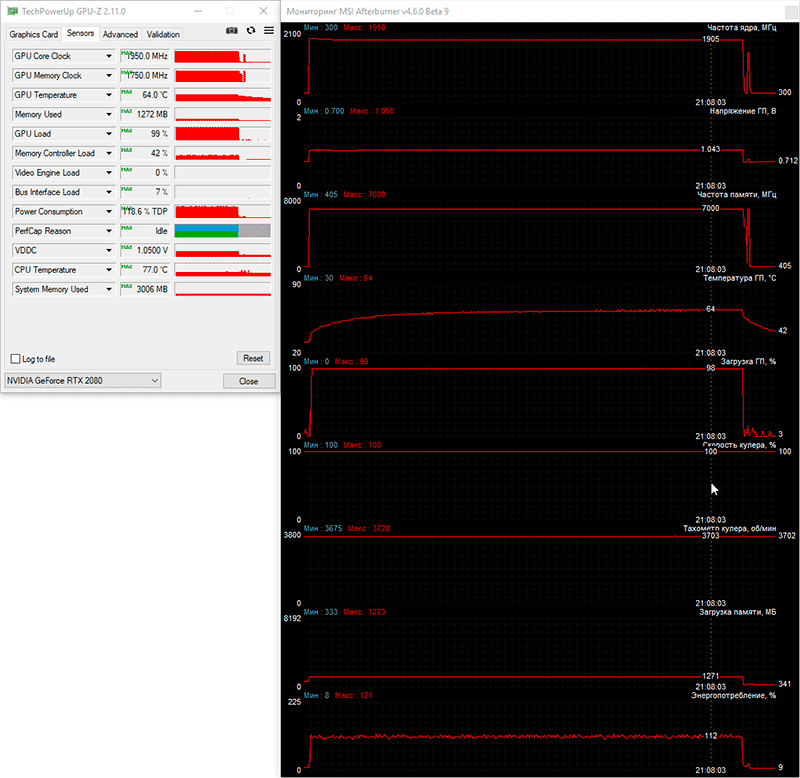

Если же вентиляторы видеокарты вручную установить на максимальные обороты, то максимальная температура графического процессора снижается сразу на 15 градусов Цельсия и ограничивается 64 градусами Цельсия.

Одновременно с этим стабильная частота графического процессора повысилась до 1905 МГц, и это, на минуточку, всего лишь на эталонной видеокарте! Для понимания этого достижения NVIDIA нужно напомнить нашим читателям, что эталонная NVIDIA GeForce GTX 1080 при максимальной скорости турбины (4000 об/мин) при более низкой комнатной температуре прогревалась до 68 градусов Цельсия, а её GPU работал на 1823 МГц. И это без учёта разницы в производительности и технологиях GP104 Pascal и TU104 Turing. Резюмируем, что, на наш взгляд, в плане системы охлаждения NVIDIA сделала очень серьёзный шаг вперёд.

Оверклокерский потенциал

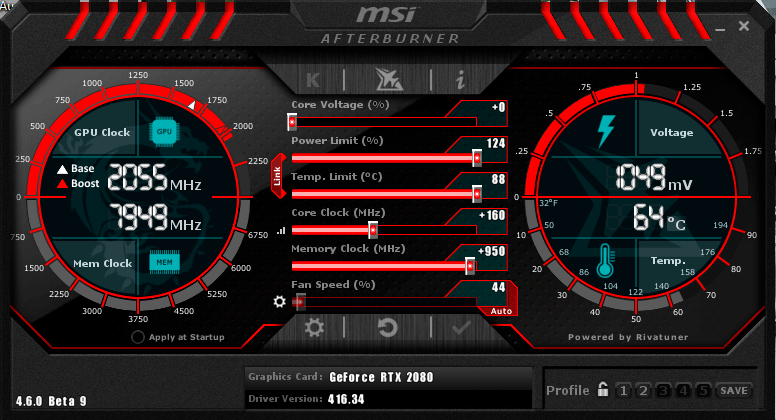

Новые NVIDIA GeForce RTX 2080 Ti и GeForce RTX 2080 поддерживают четвёртую версию технологии динамического управления частотами GPU Boost 4.0, главное, на наш взгляд, нововведение которой – автоматический разгон. Его поддерживают фирменные утилиты производителей оригинальных видеокарт, а также незаменимая MSI Afterburner последней версии. Для этого в программе нужно нажать сочетание клавиш Ctrl+F, выбрать OC сканер и нажать Scan. Сканер в течении примерно 15-20 минут пошагово поднимает частоту графического процессора и тестирует на стабильность и ошибки, а от пользователя никакого участия не требуется. В результате будет определена максимальная частота GPU, при которой видеокарта не теряет стабильность.

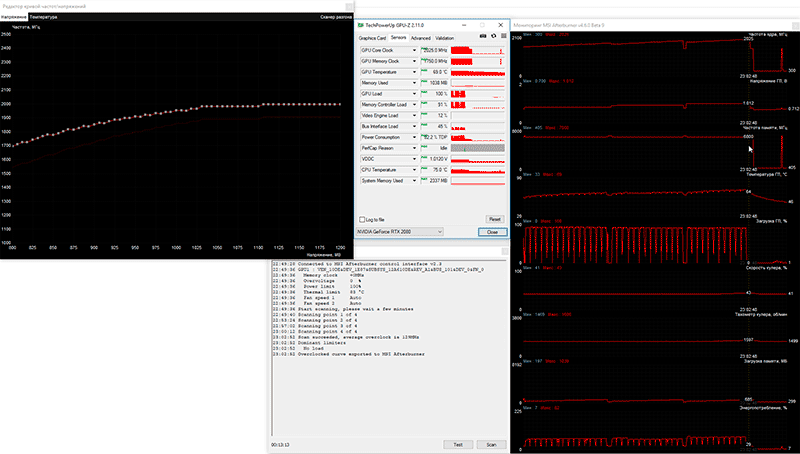

Первый такой тест мы провели на номинальных лимитах питания и температуры нашего экземпляра NVIDIA GeForce RTX 2080 Founders Edition, и вот какие результаты получили.

Как видим, частота графического процессора увеличилась на 129 МГц при итоговых 2025 МГц, неплохо, но всё же нельзя не отметить, что сканер прогревает видеокарту заметно слабее, чем тот же 3DMark.

Теперь попробуем увеличить лимиты питания и температуры до максимальных (124 и 88, соответственно), и запустить сканер ещё раз, и получили даже меньший прирост – всего 114 МГц.

Очевидно, что технологию автоматического разгона на данный момент нельзя назвать идеальной, но всё же большинству простых пользователей она значительно облегчит процесс оверклокинга, хотя видеопамять по-прежнему придётся разгонять самостоятельно. Мы же перешли к ручному поиску предельных частот видеокарты.

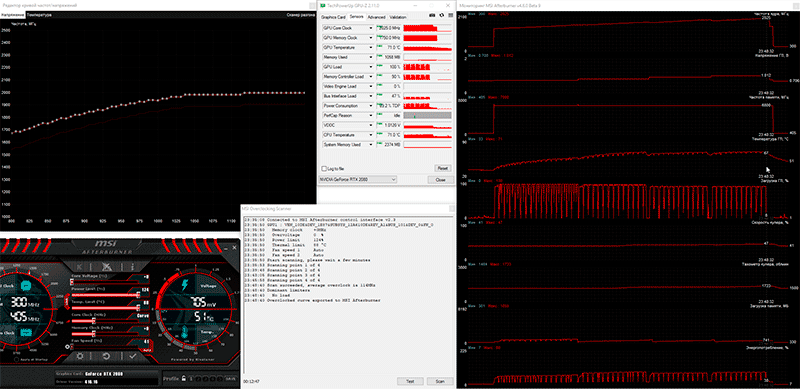

После пары часов тестов удалось определить, что наш экземпляр NVIDIA GeForce RTX 2080 Founders Edition способен разгоняться на 160 МГц (+10,6%) по ядру и на 1900 МГц (+13,6%) по видеопамяти.

Очень неплохой результат разгона для эталонного экземпляра видеокарты, поскольку итоговые частоты составили 1675-1960/15904 МГц.

После разгона пиковая частота графического процессора видеокарты достигала отметки 2100 МГц, но в процессе тестирования стабилизировалась на 2025 МГц.

Температура GPU разогнанной видеокарты увеличилась до 82 градусов Цельсия, а скорость вентиляторов при автоматической регулировке повысилась на 150 об/мин. В процессе тестирования видеокарты в играх нам пришлось немного понизить частоту графического процессора и видеокарты, поэтому окончательным результатом разгона являются частоты 1670-1983/15680 МГц. Переходим к тестовой конфигурации и методике, а следом – к результатам тестирования.

Тестовая конфигурация, инструментарий и методика тестирования

Тестирование видеокарт было проведено в закрытом корпусе системного блока на следующей аппаратной конфигурации:

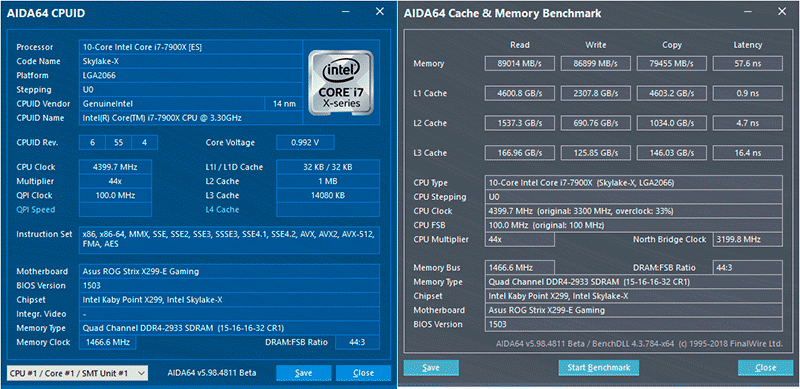

материнская плата: ASUS ROG Strix X299-E Gaming (Intel X299 Express, LGA2066, BIOS 1503 от 31.08.2018);

центральный процессор: Intel Core i9-7900X 3,3-4,5 ГГц (Skylake-X, 14 нм, U0, 10 × 1024 Kбайт L2, 13,75 Мбайт L3, TDP 140 Вт);

система охлаждения CPU: Phanteks PH-TC14PЕ (2 × Corsair AF140, 760~1090 об/мин);

термоинтерфейс: ARCTIC MX-4 (8,5 Вт/(м × К);

оперативная память: DDR4 4 × 4 Гбайт Corsair Vengeance LPX 2800 МГц (CMK16GX4M4A2800C16) (XMP 2800 МГц/16-18-18-36_2T/1,2 В или 3000 МГц/16-18-18-36_2T/1,35 В);

видеокарты:

NVIDIA GeForce RTX 2080 Founders Edition 8 Гбайт/256 бит, 1515-1800(1965)/14000 МГц и в разгоне до 1670-1983(2100)/15680 МГц;

Gigabyte GeForce GTX 1080 G1 Gaming (GV-N1080G1 GAMING-8GD) 8 Гбайт/256 бит, 1696-1835(1936)/10008 МГц и в разгоне до 1786-1925(2025)/11312 МГц;

накопители:

для системы и бенчмарков: Intel SSD 730 480 Гбайт (SATA III, BIOS vL2010400);

для игр и бенчмарков: Western Digital VelociRaptor 300 Гбайт (SATA II, 10000 об/мин, 16 Мбайт, NCQ);

архивный: Samsung Ecogreen F4 HD204UI 2 Тбайт (SATA II, 5400 об/мин, 32 Мбайт, NCQ);

звуковая карта: Auzen X-Fi HomeTheater HD;

корпус: Thermaltake Core X71 (шесть be quiet! Silent Wings 2 (BL063) на 900 об/мин: три – на вдув, три – на выдув);

панель управления и мониторинга: Zalman ZM-MFC3;

блок питания: Corsair AX1500i Digital ATX (1,5 кВт, 80 Plus Titanium), 140-мм вентилятор;

монитор: 27-дюймовый ASUS ROG Swift PG27UQ (DisplayPort, 3840 × 2160, 144 Гц).

Небольшое отступление про используемый в сегодняшних тестах монитор. Вот что пишет о нём производитель:

«ASUS ROG Swift PG27UQ – это 27-дюймовый геймерский монитор формата 4K/Ultra-HD с IPS-матрицей и высокой частотой обновления экрана (до 144 Гц). Благодаря технологии квантовых точек он обладает расширенным цветовым охватом (DCI-P3), а поддержка стандарта HDR означает повышенную контрастность, поэтому данный монитор выдаёт невероятно реалистичную картинку с насыщенными цветами. Для автоматического изменения яркости экрана в соответствии с окружающими условиями имеется встроенный датчик освещённости. Внешний вид устройства можно персонализировать с помощью синхронизируемой подсветки Aura и встроенных проекционных элементов. ASUS ROG Swift PG27UQ – это технологии будущего, доступные уже сейчас!».

Однако никакие официальные описания не заменят личных впечатлений, а они оказались весьма насыщенными и яркими, несмотря на прежде моё довольно нейтральное отношение к 4K. Временная замена тестового Samsung S27A850D (2560 × 1440) на ASUS ROG Swift PG27UQ и переход на разрешение 4K кардинально изменило это самое личное впечатление, как и само восприятие картинки. Изображение стало настолько детализированным и проработанным, то все игры тестового набора в буквальном смысле преобразились. Плавность на частоте 144 Гц запредельная, если хватает производительности видеокарты (а хватает её не везде, нужно признать), то от игрового процесса получаешь огромное удовольствие, в полной мере понимая термин «погружение в игру». И сейчас я не преувеличиваю и ничего не рекламирую, поймите правильно, – это на самом деле описание личных впечатлений, не более того. При этом нужно сказать, что масштабирование отдельных 2D-приложений в разрешении 4K далеко не всегда работает корректно, и шрифты остаются не чёткими. Кроме того, работа технологии HDR всё же бьёт по глазам, и долго играть в таком режиме непросто, нужно привыкать.

Для снижения зависимости производительности видеокарт от скорости платформы 14-нм десятиядерный процессор при множителе 44, опорной частоте 100 МГц и активированной на четвёртый уровень функции Load-Line Calibration был разогнан до 4,4 ГГц при повышении напряжения в BIOS материнской платы до 1,113 В.

При этом 16 гигабайт оперативной памяти DDR4 функционировали в четырёхканальном режиме на частоте 2,933 ГГц с таймингами 15-16-16-32 CR1 при напряжении 1,31 В.

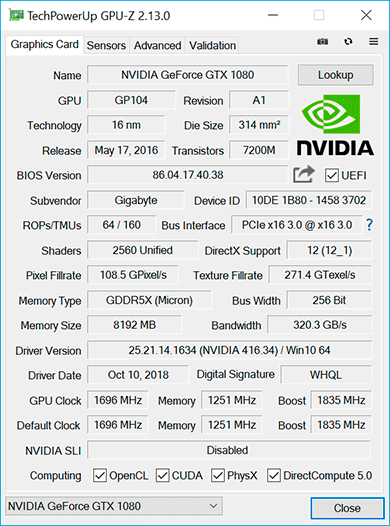

Производительность NVIDIA GeForce RTX 2080 Founders Edition мы сравним с оригинальной версией Gigabyte GeForce GTX 1080 G1 Gaming на её номинальных частотах, которые дают ей 3-5% преимущества над эталонной версией NVIDIA GeForce GTX 1080, и при разгоне.

К сожалению, сравнить новинку в GeForce GTX 1080 Ti у нас нет возможности, ввиду отсутствия такой модели видеокарты. Добавим, что пределы по питанию и температуре на обеих видеокартах были увеличены до максимально возможных, а в драйверах GeForce вместо оптимального энергопотребления был выставлен приоритет максимальной производительности.

Тестирование, начатое 15 октября 2018 года, было проведено под управлением операционной системы Microsoft Windows 10 Pro (1803 17134.345) со всеми обновлениями на указанную дату и с установкой следующих драйверов:

чипсет материнской платы Intel Chipset Drivers – 10.1.17809.8096 WHQL от 12.10.2018;

Intel Management Engine Interface (MEI) – 12.0.1162 WHQL от 15.10.2018;

драйверы видеокарт на графических процессорах NVIDIA – GeForce 416.34 WHQL от 11.10.2018.

В сегодняшнем тестировании мы использовали разрешения 2560 × 1440 и 3840 × 2160 (4K) пикселей. Для тестов были задействованы два режима качества графики: Quality + AF16x – качество текстур в драйверах по умолчанию с включением анизотропной фильтрации уровня 16х и Quality + AF16x + MSAA 4х с включением анизотропной фильтрации уровня 16х и полноэкранного сглаживания по алгоритму MSAA степени 4x. В отдельных играх, в силу специфики их игровых движков, были использованы иные алгоритмы сглаживания, что будет указано далее в методике и непосредственно на диаграммах с результатами. Включение анизотропной фильтрации и полноэкранного сглаживания выполнялось в настройках игр. Если же данные настройки в играх отсутствовали, то параметры изменялись в панели управления драйверов GeForce. Там же была принудительно отключена вертикальная синхронизация (V-Sync). Кроме указанного, никаких дополнительных изменений в настройки драйверов не вносилось.

Видеокарты были протестированы в двух графических тестах и в пятнадцати играх, обновлённых до последних версий на дату начала подготовки материала (на этот раз обновления установились на все без исключения игры). В сравнении с нашей предыдущей статьёй о видеокартах в тестовом наборе произошли серьёзные обновления. Прежде всего мы исключили старые Metro: Last Light, Rise of the Tomb Raider и F1 2017, а также недостаточно ресурсоёмкий для тестируемых сегодня видеокарт тест World of Tanks enCore. Взамен были включены новые F1 2018, Strange Brigade, Shadow of the Tomb Raider и Forza Horizon 4 Demo. Теперь список тестовых приложений выглядит следующим образом (игры и далее результаты тестирования в них расположены в порядке их официального выхода):

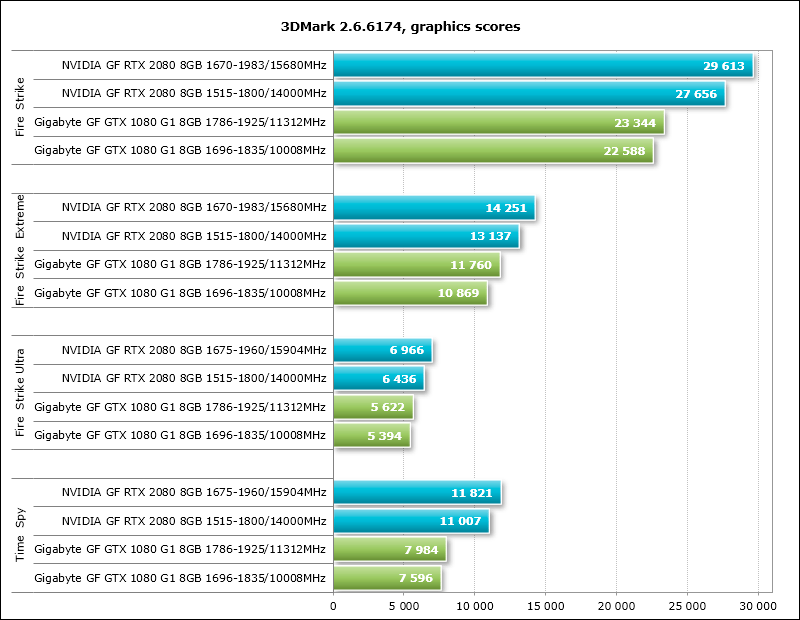

3DMark (DirectX 9/11/12) – версия 2.6.6174, тестирование в сценах Fire Strike, Fire Strike Extreme, Fire Strike Ultra и Time Spy (на диаграмме приведён графический балл);

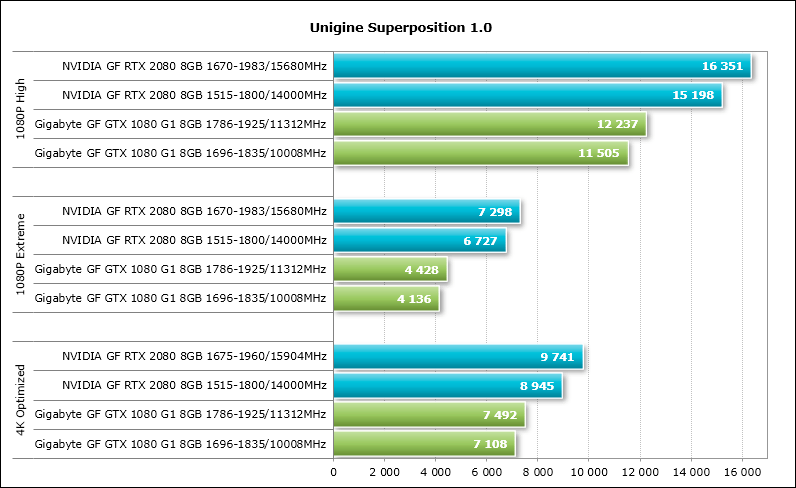

Unigine Superposition (DirectX 11) – версия 1.0, тестирование в наборах настроек 1080P High, 1080P Extreme и 4K Optimized;

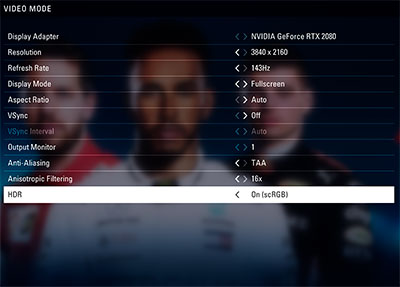

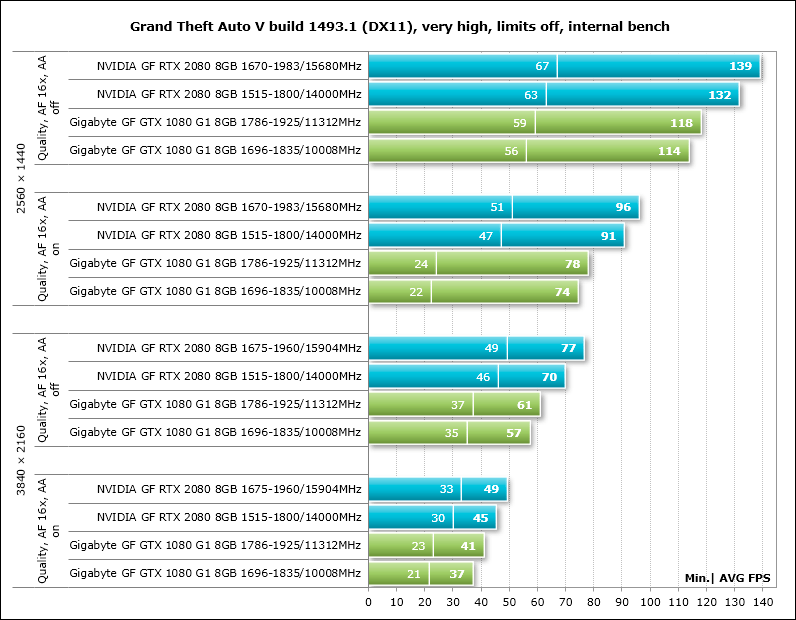

Grand Theft Auto V (DirectX 11) – build 1493.1, настройки качества на уровне Very High, игнорирование предложенных ограничений включено, V-Synс отключена, FXAA активировано, NVIDIA TXAA включено, MSAA для отражений включено, мягкие тени NVIDIA;

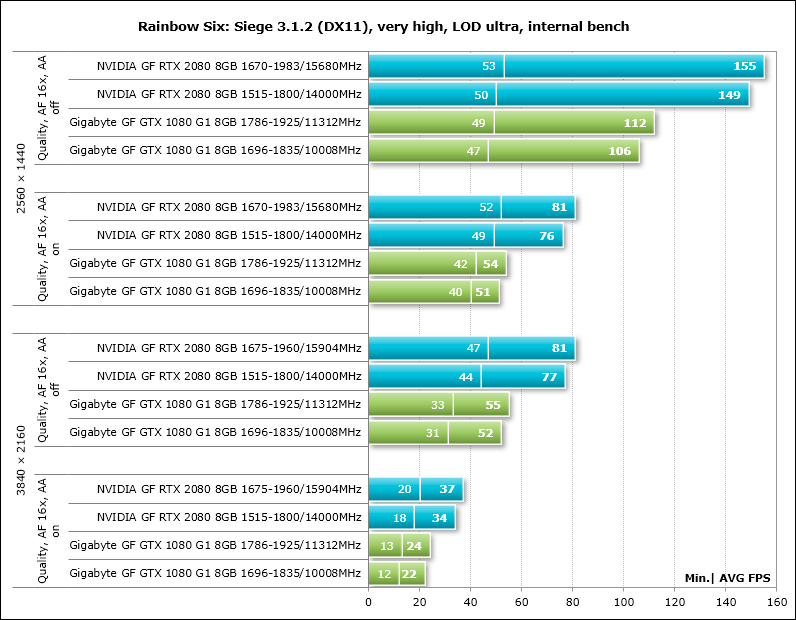

Tom Clancy's Rainbow Six: Siege (DirectX 11) – версия 3.1.2, настройки качества текстур на уровне Very High, Texture Filtering – Anisotropic 16X и прочие максимальные настройки качества, тесты с MSAA 4x и без сглаживания, двойной последовательный прогон встроенного в игру теста;

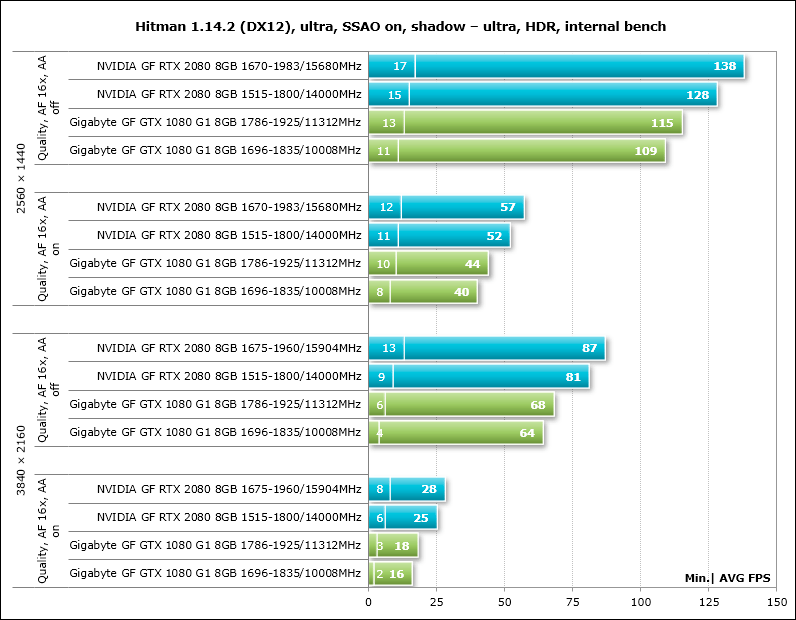

Hitman (DirectX 12) – версия 1.14.2, встроенный тест при настройках качества графики на уровне «Ультра» с HDR, SSAO включено, качество теней «Ультра», защита памяти отключена;

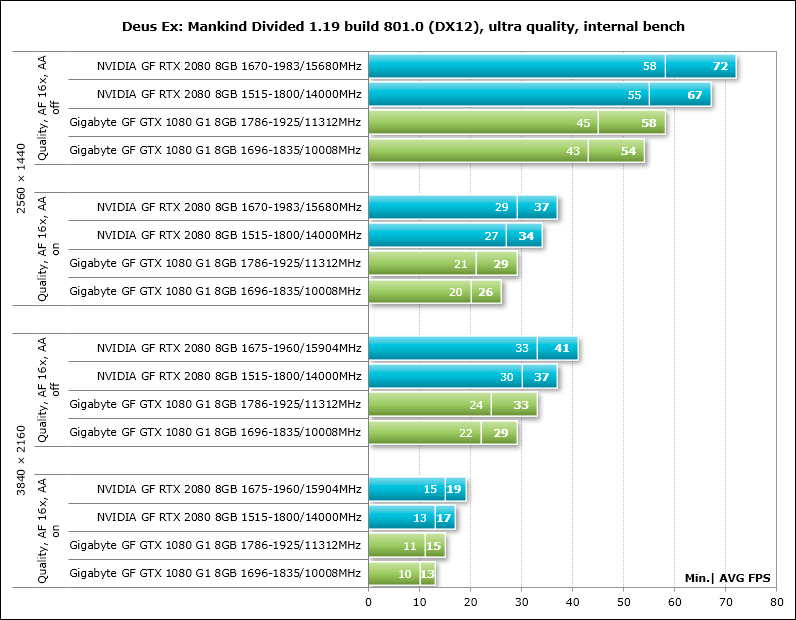

Deus Ex: Mankind Divided (DirectX 12) – версия 1.19 build 801.0, все настройки качества вручную выставлены на максимальный уровень, тесселяция и глубина резкости активированы, не менее двух последовательных прогонов встроенного в игру бенчмарка;

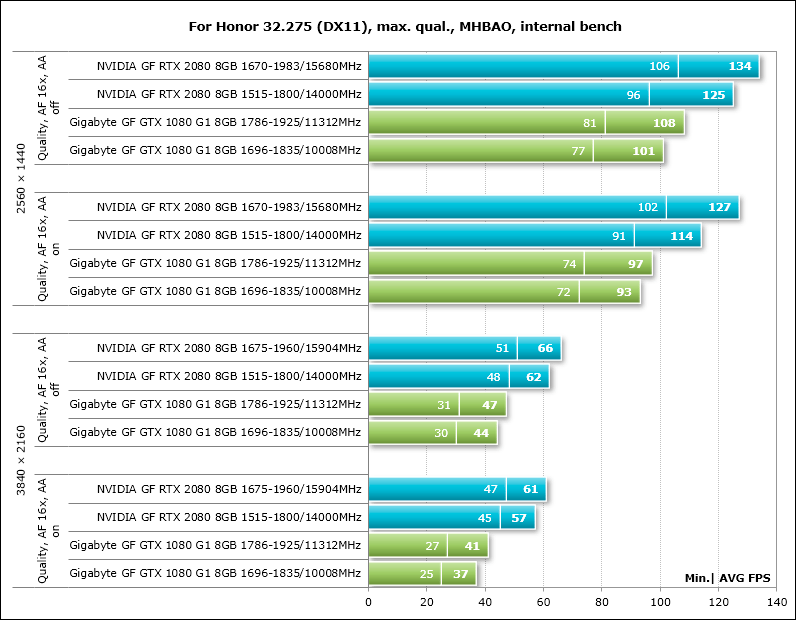

For Honor (DirectX 11) – версия 32.275, максимальные настройки качества графики, объёмное освещение – MHBAO, динамические отражения и эффект размытия включены, избыточная выборка сглаживания отключена, тесты без сглаживания и с TAA, двойной последовательный прогон встроенного в игру бенчмарка;

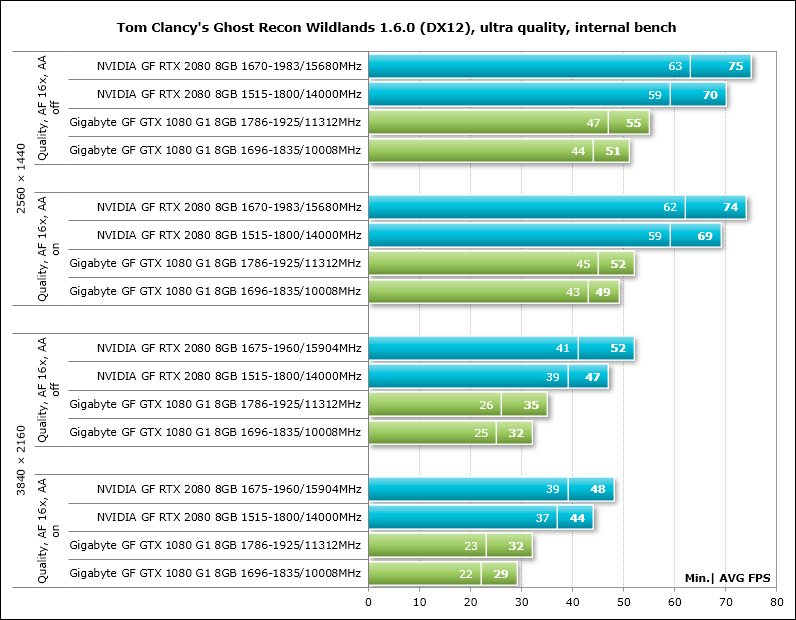

Tom Clancy's Ghost Recon Wildlands (DirectX 12) – версия 1.6.0, настройки качества графики на максимальный или Ultra-уровень, все опции активированы, тесты без сглаживания и с SMAA+FXAA, двойной последовательный прогон встроенного в игру бенчмарка;

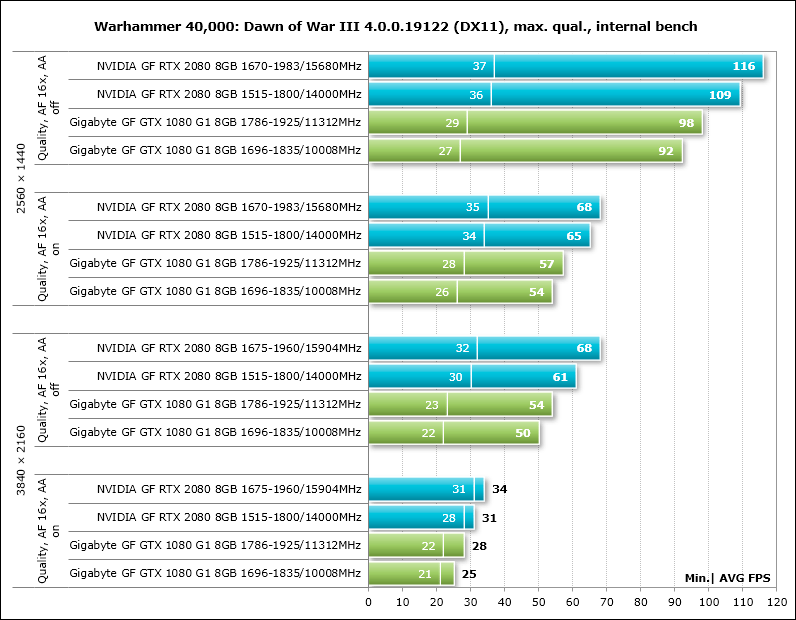

Warhammer 40,000: Dawn of War III (DirectX 11) – версия 4.0.0.19122, все настройки качества графики на максимальный уровень, сглаживание активировано, но в режиме АА использовалось масштабирование разрешения до 150%, двойной последовательный прогон встроенного в игру бенчмарка;

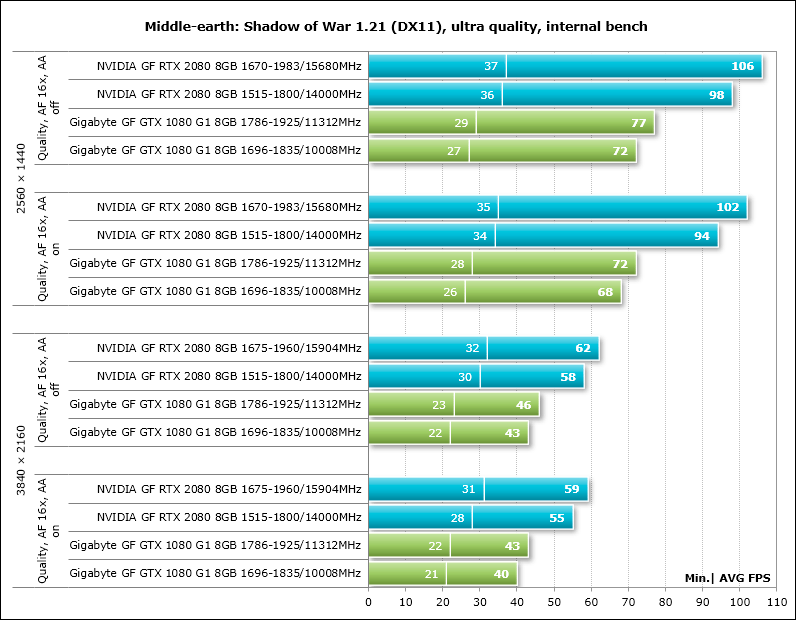

Middle-earth: Shadow of War (DirectX 11.1) – версия 1.21, все настройки качества графики на «Ультра», глубина резкости и тесселяция активированы, двойной последовательный прогон встроенного в игру теста без сглаживания и с TAA;

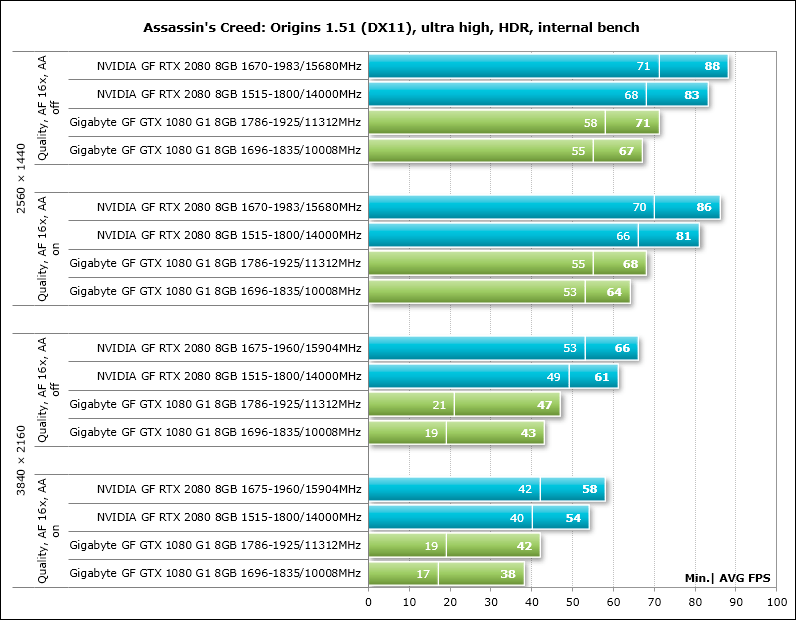

Assassin’s Creed: Origins (DirectX 11) – версия 1.51, использовался встроенный в игру бенчмарк при профиле настроек Ultra High и отключённом динамическом разрешении, HDR активирована, двойной прогон теста без сглаживания и при сглаживании на уровне High;

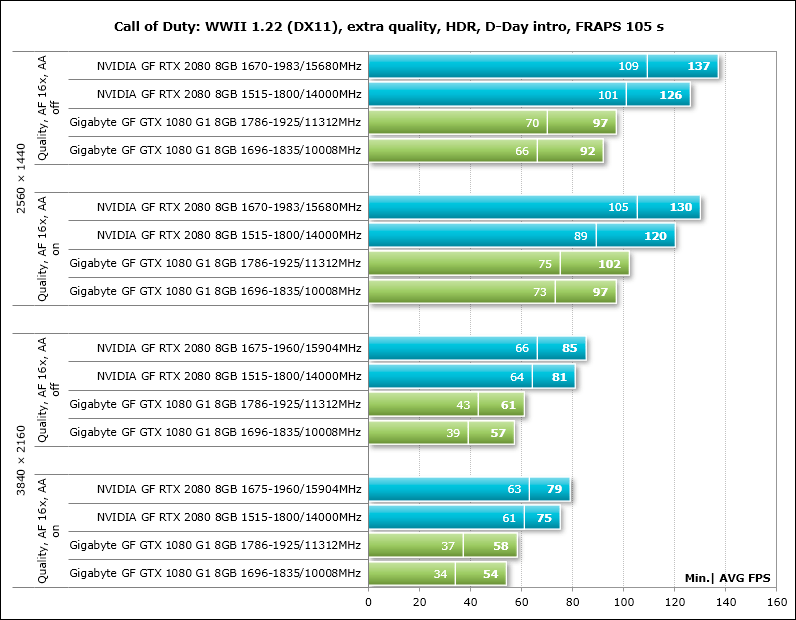

Call of Duty: WWII (DirectX 11) – версия 1.22, все настройки качества графики на экстра-уровне с HDR, тени включены, тестирование без сглаживания и при активации опции SMAA T2X, использовался двойной прогон вступительной сцены первого этапа D-Day, FRAPS 105 секунд;

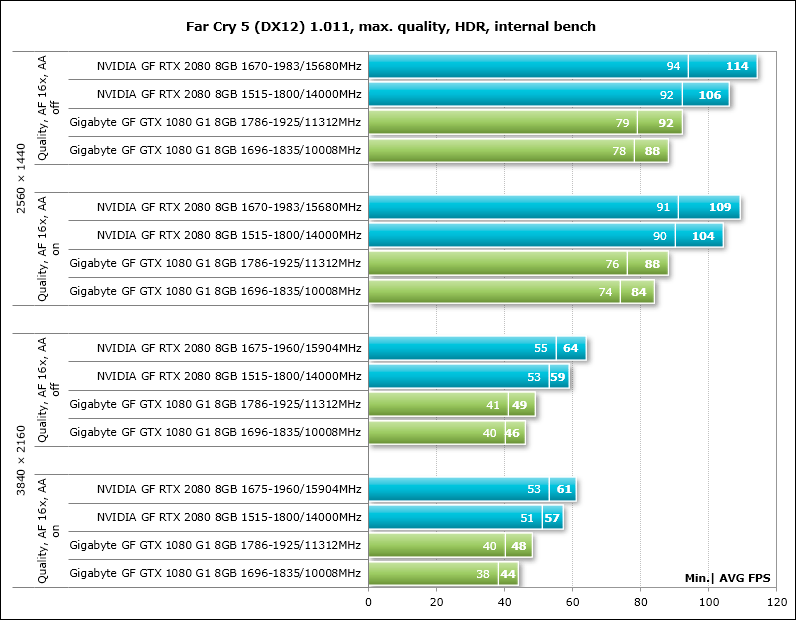

Far Cry 5 (DirectX 12) – версия 1.011, максимальный уровень качества с активированной HDR, объёмный туман и тени на максимум, размытие в движении включено, встроенный тест производительности без сглаживания и с активацией TAA;

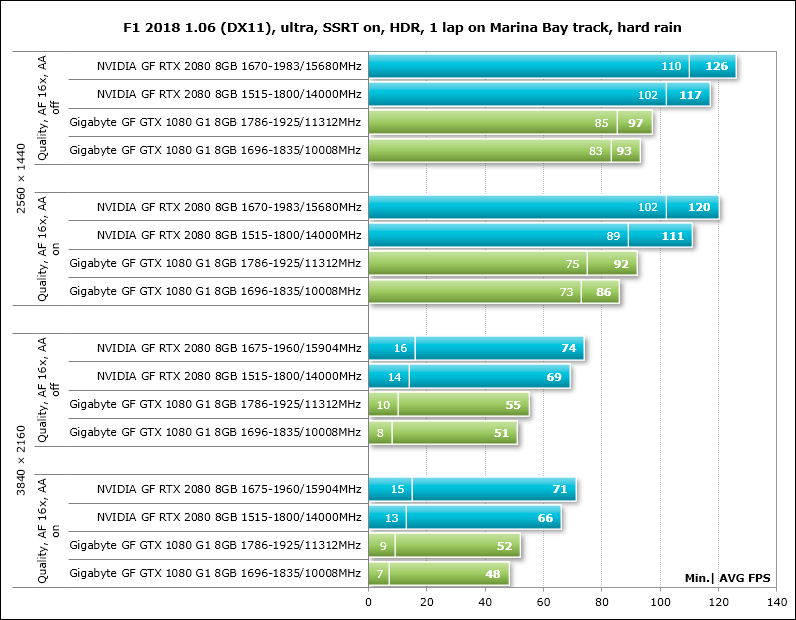

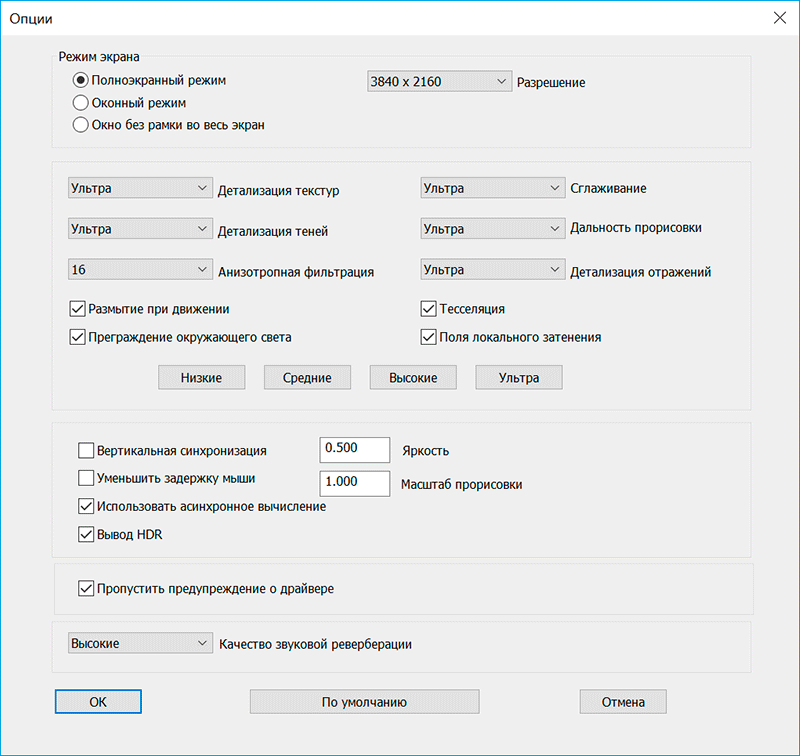

F1 2018 (DirectX 11) – версия 1.06, использовался встроенный в игру тест на трассе Марина-Бей в Сингапуре в сильный ливень, настройки качества графики заданы на максимальный уровень по всем пунктам с активированной HDR, тени SSRT активированы, тесты с TAA и без сглаживания;

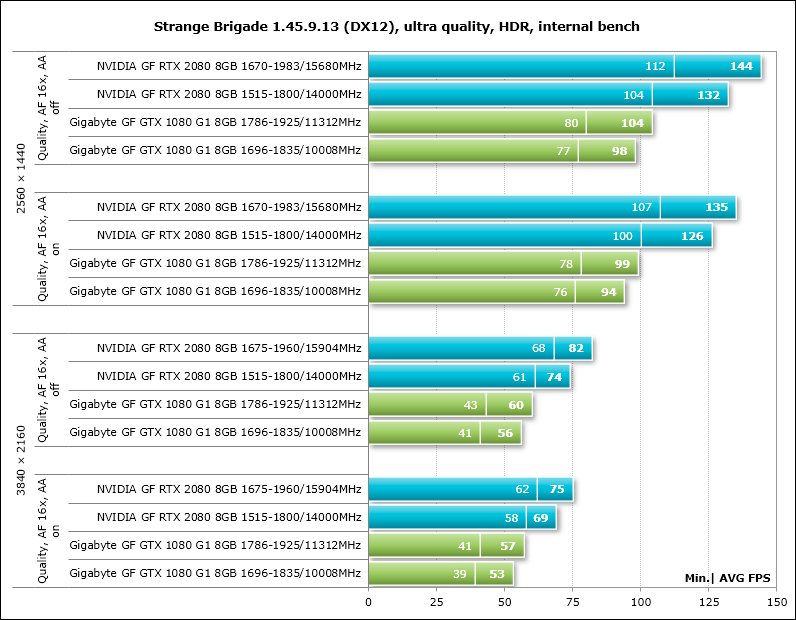

Strange Brigade (DirectX 12) – версия 1.45.9.13, уровень настроек «Ультра», HDR и прочие методики улучшения качества активированы, асинхронное вычисление включено, два последовательных цикла теста встроенного бенчмарка без сглаживания и с его активацией;

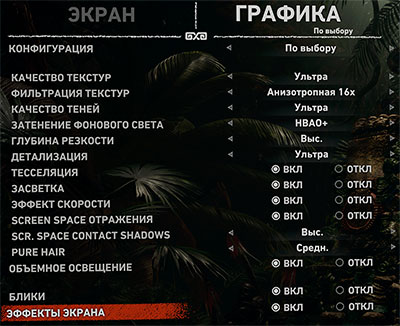

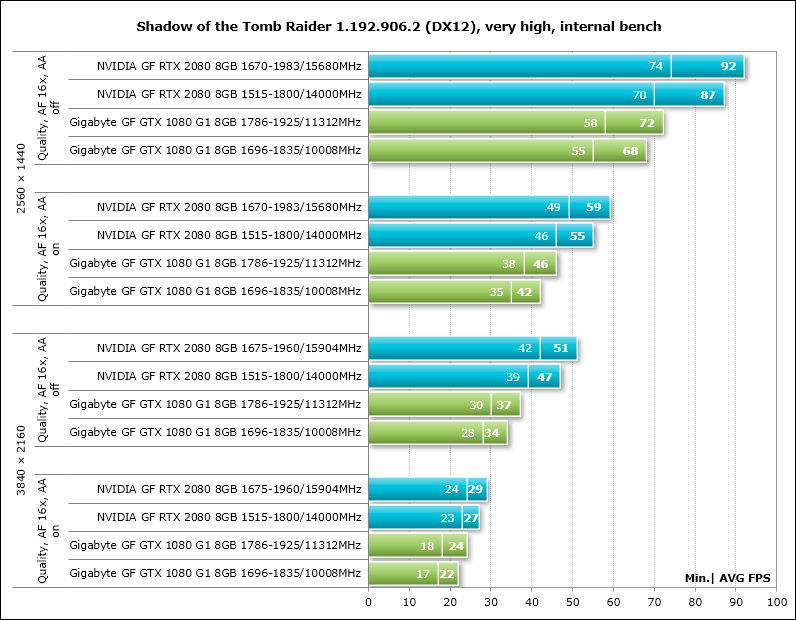

Shadow of the Tomb Raider (DirectX 12) – версия 1.0 build 235.5, все параметры на уровень «Ультра», Ambient Occlusion – HBAO+, тесселяция и прочие методики улучшения качества активированы, по два цикла теста встроенного бенчмарка без сглаживания и с активацией SMAA4x;

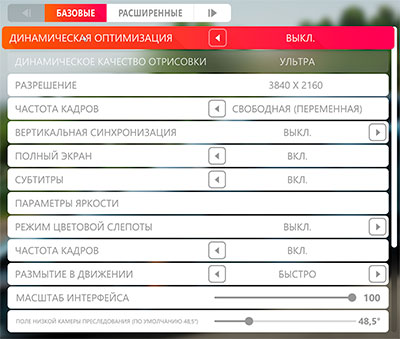

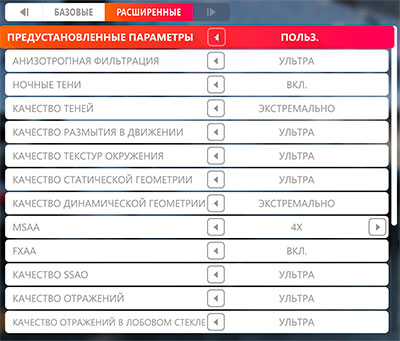

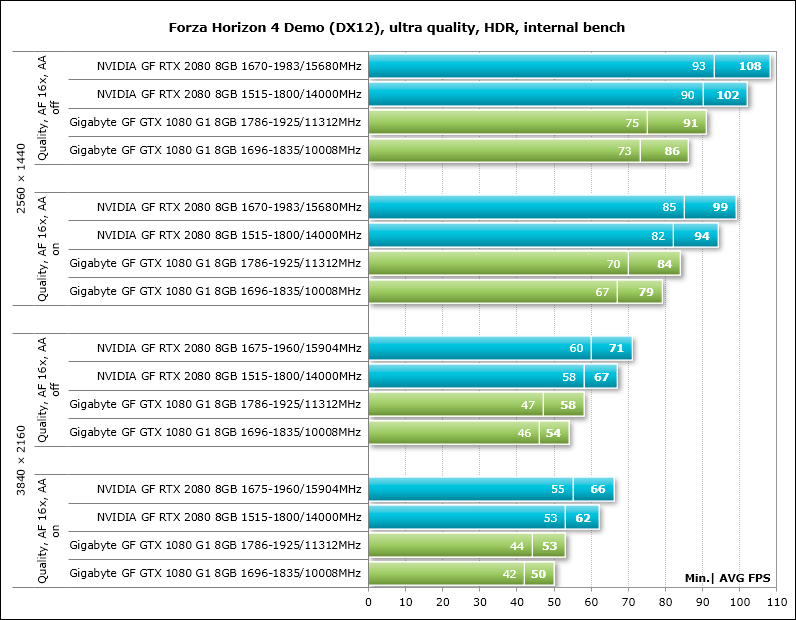

Forza Horizon 4 Demo (DirectX 12) – версия 1.192.906.2, все параметры на уровень «Ультра» или «Экстремально», HDR активирована, встроенный бенчмарк без сглаживания и с активацией MSAA4x.

Добавим, что если в играх реализована возможность фиксации минимального числа кадров в секунду, то оно также приводилось на диаграммах. Каждый тест проводился дважды, за окончательный результат принималось лучшее из двух полученных значений, но только в случае, если разница между ними не превышала 1%. Если отклонения прогонов бенчмарков превышали 1%, то тестирование повторялось ещё как минимум один раз, чтобы получить достоверный результат.

Результаты тестов производительности

3DMark

Unigine Superposition

Grand Theft Auto V

Tom Clancy's Rainbow Six: Siege

Hitman

Deus Ex: Mankind Divided

For Honor

Tom Clancy's Ghost Recon Wildlands

Warhammer 40,000: Dawn of War III

Middle-earth: Shadow of War

Assassin’s Creed: Origins

Call of Duty: WWII

Far Cry 5

F1 2018

Поскольку F1 2018 и следующие три игры мы тестируем впервые, то здесь и далее приведём настройки, при которых мы проводили тест сегодня и будем проводить в следующих статьях.

Теперь диаграмма с результатами тестирования.

Strange Brigade

Shadow of the Tomb Raider

Forza Horizon 4 Demo

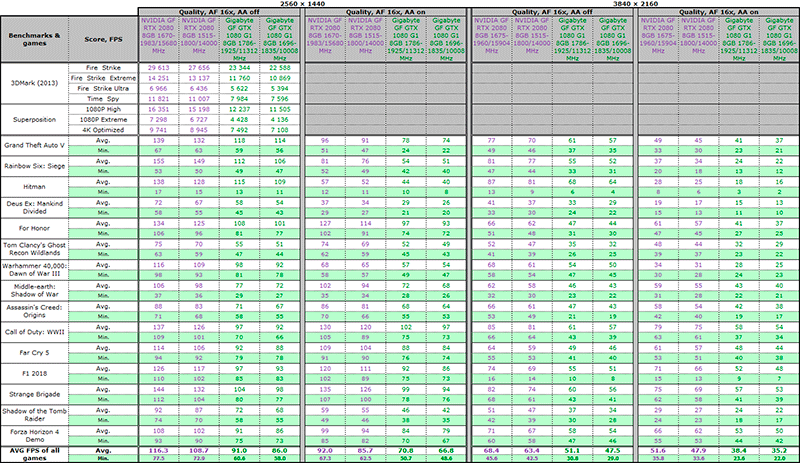

Дополним построенные диаграммы итоговой таблицей с результатами тестов с выведенными средним и минимальным значением числа кадров в секунду по каждой видеокарте.

Анализ результатов проведём по сводным диаграммам.

Сводные диаграммы и анализ результатов

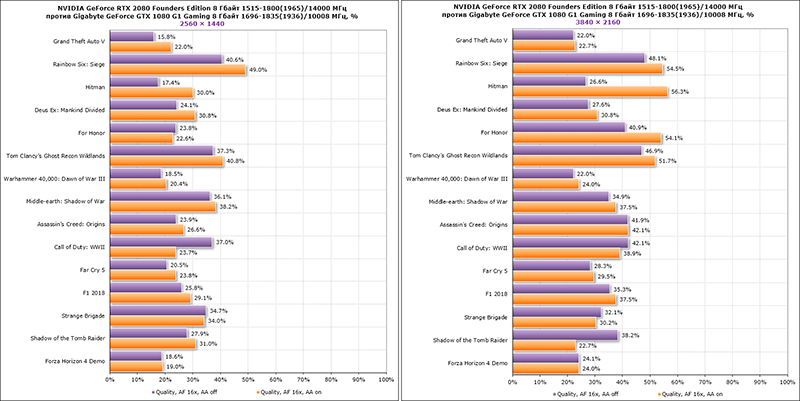

На первой паре сводных диаграмм мы сравним производительность NVIDIA GeForce RTX 2080 Founders Edition с Gigabyte GeForce GTX 1080 G1 Gaming на номинальных частотах обеих видеокарт. За начальную точку отсчёта приняты результаты GeForce GTX 1080, а показатели GeForce RTX 2080 приведены в процентах от неё.

В разрешении 2560 × 1440 пикселей новинка опережает предшественницу в среднем по всем играм на 26,8-29,4%, минимальное преимущество 15,6% можно наблюдать в игре Grand Theft Auto V, а максимальное – в Rainbow Six: Siege, где оно достигает 49%. Однако в полной мере RTX раскрывается в разрешении 3840 × 2160 пикселей или 4K, как его принято называть. Здесь новая NVIDIA GeForce RTX 2080 Founders Edition в среднем по всем играм демонстрирует прирост 34,1-37,1% с пиком в 56,3% в наиболее ресурсоёмком режиме игры Hitman. Поскольку разница в частотах сравниваемых видеокарт невелика, то очевидно, что архитектура Turing куда более эффективна и производительна, нежели Pascal.

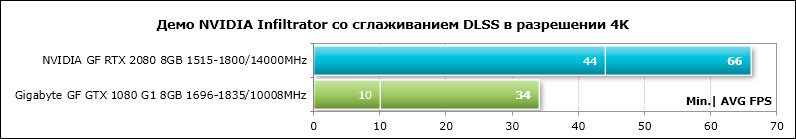

Более того, если говорить об играх недалёкого будущего, то преимущество GeForce RTX 2080 над GeForce GTX 1080 будет двукратным и более. В частности, мы можем привести в пример демо NVIDIA Infiltrator на движке UE4 в 4K, где на RTX работает новая технология сглаживания DLSS, а на GTX используется TAA- сглаживание.

Как видим, новая видеокарта почти вдвое быстрее предшественницы, и при этом в качестве картинки не уступает ни на пиксель.

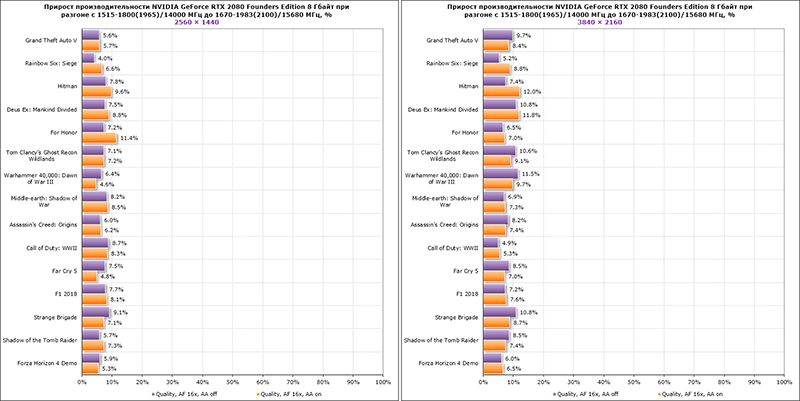

На второй паре сводных диаграмм мы оценим прирост производительности при разгоне графического процессора NVIDIA GeForce RTX 2080 Founders Edition на 10,2% и видеопамяти на 13,6%.

Разогнанная видеокарта оказалась быстрее номинальной на 7,0-7,3% в разрешении 2560 × 1440 пикселей и на 8,2-8,3% в разрешении 3840 × 2160 пикселей.

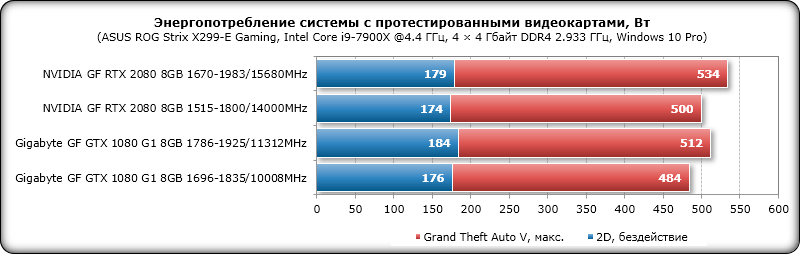

Энергопотребление

Измерение уровня энергопотребления проводилось с помощью блока питания Corsair AX1500i через интерфейс Corsair Link и утилиту мониторинга HWiNFO64 версии 5.90-3550. Измерялось энергопотребление всей системы в целом без учёта монитора. Тестирование было проведено в 2D-режиме при обычной работе в Microsoft Word или интернет-сёрфинге, а также в 3D-режиме. В последнем случае нагрузка создавалась с помощью двух последовательных циклов бенчмарка игры Grand Theft Auto V в разрешении 2560 × 1440 пикселей при максимальных настройках качества графики с использованием MSAA 4Х. Энергосберегающие технологии центрального процессора в BIOS материнской платы отключены.

Сравним уровень энергопотребления систем с протестированными сегодня видеокартами по результатам на диаграмме.

Система с NVIDIA GeForce RTX 2080 Founders Edition удивила совсем небольшим повышением уровня энергопотребления в сравнении с конфигурацией с Gigabyte GeForce GTX 1080 G1 Gaming, поскольку по спецификациям видеокарт разница в максимальном уровне энергопотребления должна быть около 55 ватт, а на практике мы получили не более 20 ватт. Что касается разгона, то здесь прирост составил всего 34 ватта и в максимуме не превысил 550 ватт. Учитывая, что мы тестируем видеокарту на довольно производительной и дорогой конфигурации (да ещё и в разгоне), очевидно, что в NVIDIA перестраховались, рекомендуя для системы с новой GeForce RTX 2080 блок питания мощностью 650 ватт.

Заключение

На наш взгляд, единственной проблемой NVIDIA GeForce RTX 2080 Founders Edition является её заявленная стоимость, которая заметно выше рекомендованной цены на GeForce GTX 1080. Если бы NVIDIA выпустила новую линейку видеокарт по ценам старой, то именно GeForce RTX 2080 оказалась бы безоговорочным хитом и, вполне вероятно, лидером продаж. Но этого не произошло и на это есть свои причины, о которых мы говорили в статье, а также добавим сюда же полное отсутствие конкуренции в сегменте флагманских продуктов. Поэтому, если у геймеров есть желание получить все новые технологии и задел на будущее, то выбора на сегодняшний день попросту нет, и NVIDIA в своём желании компенсировать все вложенные в разработку Turing средства и заработать вполне можно понять.

Отбросив в сторону вопросы ценообразования, нельзя не признать, что NVIDIA GeForce RTX 2080 является прорывной видеокартой, которая уже сегодня и в сегодняшних играх демонстрирует существенный прирост производительности в сравнении с предшественницей в лице GeForce GTX 1080, а в будущих играх это преимущество будет кратно возрастать. Архитектура NVIDIA Turing и видеокарты на её основе принесли в потребительский сегмент графики трассировку лучей и «бесплатную» HDR, тензорные ядра и сглаживание DLSS, Mesh Shaders, GDDR6 и высокоскоростной NVLink, USB 3.1 Gen2 и VirtualLink. Эталонные видеокарты одновременно с повышением частот стали оснащаться более эффективной системой охлаждения, остающейся комфортной по уровню шума даже в 3D-нагрузке. Не будем забывать и полностью автоматический разгон графического процессора, доступный только на GeForce RTX. Подводя итог, можем сказать, что весьма обеспеченные геймеры уже сегодня могут приоткрыть для себя будущее 3D-графики.